En RUBIK, como venimos diciendo desde principios de año, queremos dar una visión completa de la industria audiovisual, acercándonos en detalle y desde un enfoque profesional a las diferentes caras de nuestro poliédrico sector.

Dentro de esa panorámica, la tecnología juega un papel fundamental. En esta edición nos acercamos a esos aspectos, siendo el núcleo de nuestra cobertura un extenso y exhaustivo reportaje con las últimas soluciones y productos presentados en la gran feria tecnológica del sector (el NAB de Las Vegas). Un artículo desglosado por compañías fabricantes con el que saber lo último que se pone a disposición del mercado tanto para el ámbito broadcast como para la producción de cine/series. Para conocer las últimas tendencias tecnológicas que están siendo esenciales en las actualizaciones de las televisiones, publicamos un artículo escrito por Luis Sanz, consultor tecnológico con una dilatada experiencia impulsando

esa clase de modernizaciones. En conjunción con esto, consideramos que una excelente manera para averiguar la aplicación de esas tendencias es revelar, a través de varios reportajes, las renovaciones concretas que han llevado a cabo algunos broadcasters (Canal Sur, Telemadrid e IB3), a partir de la colaboración de sus directores técnicos. Uno de los bloques de esta edición tan tecnológica está dedicado a la Inteligencia Artificial, una de las innovaciones más disruptivas del momento. Más allá de las polémicas y las incertidumbres que suscita la IA, queremos poner el foco en cómo se está utilizando. En primer lugar, hablamos con Pere Vila, Director de Estrategia Tecnológica de RTVE, para que nos cuente, a través de proyectos y usos concretos, las herramientas de este tipo que está implementando el ente público. Además, publicamos también un artículo sobre la evolución de la IA y cómo está influyendo en la industria audiovisual, en un contexto inestable en cuanto a los modelos de producción

y la optimización de la rentabilidad de los proyectos.

Los Juegos Olímpicos de París 2024 son el gran evento del año. Además de lo meramente deportivo, tienen un enorme interés desde el punto de vista de la producción televisiva, con un incomparable despliegue de medios. Para abordar todos los detalles de esta cita desde este punto de vista hemos hablado con Isidoro Moreno, Director de Ingeniería y Operaciones Técnicas de OBS (Olympic Broadcasting Services), la entidad responsable de producir la señal internacional para las televisiones con derechos de emisión. Complementando a esta charla, hemos entrevistado también a Fernando Ruiz, Sports Director de Warner Bros. Discovery, y a Laura Martín, Broadcast Operations Senior Manager de la compañía, para conocer cómo plantearon los JJ.OO. desde Max y Eurosport.

Carlos Aguilar Sambricio y Miguel Varela

LAS COMPAÑÍAS DE RADIODIFUSIÓN SE ENFRENTAN A DOS ELEMENTOS CLAVES EN EL CONTEXTO AUDIOVISUAL. POR UN LADO, LOS ESPECTADORES SE ENCUENTRAN CON LA POSIBILIDAD DE DISPONER DE MÚLTIPLES DISPOSITIVOS Y PANTALLAS PARA RECIBIR TODO TIPO DE CONTENIDOS AUDIOVISUALES Y, POR OTRO, LA FACILIDAD DEL STREAMING POTENCIA LA PROLIFERACIÓN DE PLATAFORMAS DE CONTENIDOS Y LA PRESENCIA DE MULTITUD DE CANALES EN INTERNET. ENTRE TODOS, SE OFRECE TAL CANTIDAD DE CONTENIDOS QUE NO HAY TIEMPO NADA MÁS QUE PARA ELEGIR AQUELLAS FUENTES QUE OFRECEN NO SOLO CONTENIDOS, SINO COMPLEMENTOS QUE LES HACEN MÁS INTERESANTES Y ATRACTIVOS. POR ELLO, LOS BROADCASTERS TIENEN QUE RECURRIR A LA TECNOLOGÍA PARA OFRECER SUS CONTENIDOS CON SUFICIENTE INTERÉS.

POR LUIS SANZ, CONSULTOR AUDIOVISUAL

En este camino, las tendencias actuales de la tecnología de los radiodifusores se concentran en las diferentes etapas de elaboración de sus contenidos. Destacamos las siguientes.

Se está aumentado, cada vez más, el número de cámaras utilizadas, sobre todo, en la producción de eventos en directo y

en deportes en particular, para ofrecer más puntos de vista desde diferentes ángulos del evento y proporcionar más detalles a los espectadores de lo que está ocurriendo.

Últimamente, y también en la producción de eventos y deportes en particular, se está implementado el concepto de ‘broadcast cinematográfico’, con la intención de conjugar la forma habitual de presentar

las imágenes en televisión, con el ‘look cinematográfico’, utilizando ópticas con focales más cortas para resaltar los primeros planos sobre los fondos desenfocados. Ello hace mucho más atractiva la presentación de jugadores o participantes en los eventos.

Cada vez se recurre más a la nube para las actividades radiodifusoras, por la ventaja de evitar la instalación de mucho hardware en los centros locales y reducir

los costes de producción, pero todavía es minoritario el uso de la nube en centros ya establecidos, siendo muy utilizado en los canales de nueva creación.

Más de la mitad de los broadcasters utiliza actualmente redes celulares, básicamente 4G y 5G, para la contribución de vídeo en directo, compitiendo con el uso de Internet. De igual manera, la mayor parte de las emisoras utilizan, o van a utilizar en breve, 5G para la contribución a la emisión de los canales.

También están creciendo las emisiones OTT (Over The Top) como forma de acceder a contenidos a través de Internet, incluso con las plataformas típicas como Facebook.

En cuanto a los métodos de codificación de la señal , para el transporte de vídeo en directo es mayoritario el uso del protocolo SRT (transmisión confiable segura) creado por la compañía canadiense Haivision, desarrollado para enviar vídeos a través de Internet. Por su parte, también para los trabajos de contribución, es prioritario el uso del código de compresión HEVC (High Efficiency Video Coding), también

conocido como H265, que comprime la señal de vídeo con mayor calidad y menor tasa binaria.

El uso de la realidad aumentada está contribuyendo a mejorar la información a suministrar a los espectadores. La posibilidad de integrar en la imagen real en directo elementos gráficos o corpóreos relacionados con ella enriquece la emisión haciéndola más atractiva e interesante. La realidad aumentada ya es imprescindible en la emisión de deportes en directo. Con ella se puede ver la información relativa a cada jugada según se produce, se grafía el movimiento del balón o de una pelota de golf. En algunas ligas en Estados Unidos, la realizada aumentada permite interactuar al espectador con los datos ofrecidos.

La desaparición de las emisiones en definición estándar (SD) y la obligación de que en TDT (Televisión Digital Terrestre) los canales tienen que emitir en HD (Alta Definición) ha provocado dos consecuencias. La primera es la muerte de todos los antiguos receptores de televisión que solo sintonizaban canales en SD y, de ellos, aquellos que

estaban preparados para trabajar en alta definición (HD ready) pero no sintonizaban en HD. Solo pueden usarse adquiriendo un sintonizador externo en HD e introduciendo la señal en el receptor por conexión scart o HDMI.

La segunda consecuencia es la necesidad de los radiodifusores de centrarse en el formato de emisión y aquí aparece el interés de trabajar en mejorar la calidad de la imagen emitida. Por ello, se avanza tecnológicamente en trabajar en HD HDR (Alto rango dinámico). Con el HDR, la HD puede presentar detalles del contenido emitido en escenas brillantes o muy oscuros, que sin él no se apreciarían. Obviamente, es preciso que los receptores tengan implementada la posibilidad de reconocer HDR.

También se está empezando a aplicar la técnica HFR (Alta Tasa de Cuadros) en la producción de contenidos . HFR consiste en añadir más cuadros (fotogramas) a los normales (25/30 por segundo). Con ello se consigue más detalle en la imagen y se mejora la profundidad de campo en planos generales y el desfase temporal en las tomas con mucho movimiento.

También se está generalizando la producción de contenidos en el mal llamado 4K . En informática, 4K es cuatro veces 1K (1024 dígitos), es decir, 4096 dígitos. En producción audiovisual, la HD es una imagen con 1920 x 1080 píxeles. La llamada producción en 4K, denominada también UHD (Ultra Alta Definición) en la emisión de los canales, es el doble horizontal y verticalmente de la HD (2 x 1920, 2 x 1080), es decir, 3840 x 2160 píxeles. En conclusión, el 4K es para la informática y el UHD para la televisión. Por otro lado, en UHD también se está empezando a aplicar la técnica HDR y ya empieza a haber canales en UHD, por ejemplo, en Televisión Española.

En relación con el formato y por la masiva presencia de contenidos en las plataformas de Internet, Instagram y Tiktok se está empezando a producir en formato vertical 9/16 , para adaptarlo al visionado normal en los teléfonos móviles, obteniendo una pantalla completa sin necesidad de girar el teléfono.

Las tendencias tecnológicas actuales en la producción en directo en plató se centran en el uso mayoritario de grandes

pantallas con tecnología LED , en la que se presentan los contenidos a los que se refieren los presentadores presentes en el estudio, que prácticamente siempre están de pie. También está muy extendida la utilización de la realidad aumentada con la presencia corpórea de elementos informativos o simplemente decorativos. Por supuesto, la iluminación del plató con proyectores halógenos se está sustituyendo por pantallas y proyectores de iluminación con tecnología LED.

Una tendencia tecnológica cada vez más presente es la migración de las instalaciones en video digital estándar (SD) a tecnología IP , con la sustitución de todo el cableado tradicional de vídeo y audio por cableado informático y matrices de audio y vídeo por routers. Con esta tecnología se puede generalizar la producción remota, llevando la señal de las cámaras desde el lugar de captación al centro de producción en donde se realizará el programa.

Si hay una tendencia tecnológica actual en la radiodifusión que empieza a primar sobre todas las demás es la aplicación de técnicas de Inteligencia

Artificial (IA) que está empezando a utilizarse en todos los departamentos de las compañías.

Las aplicaciones de IA utilizadas son, entre otras: catalogación y archivados automáticos, subtitulado automático, generación de textos, conversión de voz a texto y de texto a voz, traducción simultánea, generación de gráficos, imágenes y vídeos, asistentes a los periodistas, generación de avatares, seguimiento automático de presentadores de programas, remasterización de formatos de contenidos, control de contenidos emitidos, recomendaciones personalizadas a los espectadores, automatización de jugadas con seguimiento en deportes, generación de trailers automáticos, automatización y optimización de procesos o detección de informaciones falsas.

Sin duda, la Inteligencia Artificial está empezando a cambiar con fuerza el panorama radiodifusor . Esperemos que sea para bien.

EN ESTE EXTENSO REPORTAJE PONEMOS EL FOCO EN ALGUNAS DE LAS MÁS INTERESANTES NOVEDADES QUE SE MOSTRARON EN EL CENTRO DE CONVENCIONES DE LAS VEGAS DURANTE LA EDICIÓN 2024 DEL NAB, LA GRAN FERIA MUNDIAL DE LA TECNOLOGÍA AUDIOVISUAL Y BROADCAST. HACEMOS UN REPASO EMPRESA POR EMPRESA, POR ORDEN ALFABÉTICO, PARA CONOCER QUÉ ES LO QUE ESTÁ LLEGANDO AL MERCADO O ESTÁ A PUNTO DE HACERLO.

Adobe llevaba, como acostumbra, una nutrida cantidad de actualizaciones de sus soluciones. En su software Premiere Pro implementa herramientas de IA para agilizar los flujos de trabajo y ampliar las posibilidades creativas, como la inserción o eliminación de objetos o la ampliación de un clip añadiendo unos segundos al final de un plano.

Estos nuevos flujos de trabajo de edición serán impulsados por un nuevo modelo de vídeo que se unirá a la familia de modelos Firefly, que incluye los modelos de imagen, vector, diseño y efectos de texto. La empresa

también ha anunciado que va a incorporar modelos de IA generativa de terceros directamente en sus aplicaciones.

De entre todas las nuevas funcionalidades destaca especialmente Enhance Speech, que permite mejorar la calidad de los audios para que se acerquen a como si se hubieran grabado en un estudio. La tarea, que se realiza en un segundo plano para permitir trabajar en otras cosas mientras se hace el ajuste, permite ajustar la cantidad de mejora con un regulador.

Por otro lado, también presentó la versión 4 de Frame.io, plataforma de

colaboración creativa flexible, rápida e intuitiva que agiliza y simplifica los flujos de trabajo en la creación y producción de contenidos. La gestión del workflow está ahora enmarcada por un sistema de metadatos dinámico y de carpetas inteligentes, haciendo más personalizable y flexible esta plataforma basada en la nube. También se han ampliado las posibilidades creativas al haber transformado las áreas de transferencia de archivos, la revisión y aprobación de activos multimedia.

La española AEQ acudió a Las Vegas con varios nuevos productos. Uno de ellos fue Solaris, un gateway multicódec de audio que incorpora entre 8 y 64 audiocodecs estéreo en un equipo de una unidad de rack o un servidor dedicado o compartido. Prescinde de entradas y salidas de audio local, por lo que confía en la entrega de audio a una red IP redundante en formatos AES67 o Dante.

La Unidad de Comentarista Olympia 3 permite ahora la conexión a matrices del sistema de comentarista AoIP para eventos grandes, con múltiples sedes y múltiples deportes. Añade la aplicación SW System Planner, que permite al host broadcaster planificar la red AoIP requerida, los dispositivos de red de audio auxiliares o nodos de red, y los conversores de formato. También destacaron los TP9000, paneles de usuario de intercom con teclas de palanca de 4 vías qué están diseñados para sistemas de intercom Crossnet de hasta 190 puertos y Conexia de hasta 1.000 puertos.

Agile Content presentaba en NAB Agile CDN Director, una solución para luchar contra la piratería en las plataformas de contenidos mediante la autorización de las sesiones para evitar el acceso no deseado. El sistema posibilita el bloqueo de hasta 60.000 solicitudes no válidas al día. Basado en la tecnología Edgeware, ofrece un switching muy fluido durante el stream.

AJA introdujo en NAB 2024 algunas actualizaciones de sus productos. Con AJA ColorBox v2.1, su equipo para flujos de trabajo gestionados por color en tiempo real, ahora es posible downconversion 4K/UltraHD y 4K/2K y ofrececompatibilidad con ACES Metadata File (AMF) y ARRI Wireless Video Optimized LogC4 (WVO). Su conversor HDR/WCG, con el firmware FS-HDR v4.3, incluye las últimas BBC HLG LUTs v1.7, así como un nuevo desentrelazador adaptable al movimiento y controles de sincronización HFR de canal a canal.

Ha mejorado el Bridge Live, el transcodificador multicanal de flujo de trabajo de vídeo IP utilizado, para facilitar la producción remota y la transmisión de eventos en directo. La versión V17.1 de AJA Desktop, para los productos AJA Kona, Io y T-TAP, permite pasar metadatos como SCTE-104, Dolby Vision, Closed Captioning y SMPTE Time Code. Destacamos también que la versión 2.1 DEL dispositivo de transmisión y grabación H.264 HELO Plus incluye un nuevo parámetro SRT Stream ID al modo Caller, añade el modo SRT Listener como selección del usuario, y presenta una vista de la configuración de fotogramas B de cada codificador en la página de estado.

Akamai promocionó su plataforma Akamai Connected Cloud y lanza unos servicios cloud basados en la GPU NVIDIA RTX 4000, de forma que logra un procesamiento de vídeo 25 veces más rápido que los métodos tradicionales basados en la CPU. Será útil para la creación de contenidos digitales, el modelado 3D, el renderizado, streaming de vídeo, transcodificación de vídeo, procesamiento de contenidos de realidad virtual y realidad aumentada, inteligencia artificial generativa y aprendizaje automático o el análisis de datos.

Alfalite ha lanzado una solución que mezcla tecnología y arte. Gracias a la colaboración con el artista digital César Yagüe, pone en el mercado AlfaArt, una solución integral llave en mano con pantallas LED de gran formato que convierten paredes en lienzos vivos, con media players de última generación y obras de arte en movimiento perfectamente curadas y preparadas para ser utilizadas. El objetivo es transformar espacios convencionales, de manera sencilla, en espacios de vanguardia y de gran esteticismo.

Amazon Web Services cada vez va aportando más soluciones aplicables al ámbito del audiovisual profesional. En NAB 2024 mostraron sus herramientas nativas y open-source para monitorado integral permitiendo a los operadores con poca experiencia con el cloud que puedan hacer playout de canales y tener una visión en tiempo real como estaban acostumbrados. También hay que subrayar el monitorado de flujo de trabajo para video en directo, accesible a través de la consola y la API de AWS Elemental MediaLive y detecta y visualiza los recursos. Crea mapas de señales que muestran videos en AWS Elemental MediaConnect, MediaLive y MediaPackage, junto con Amazon S3 y Amazon CloudFront para ofrecer una visibilidad integral. Puede crear sus propias plantillas de alarmas o partir de un conjunto de alarmas recomendadas.

Por último, destacamos el AWS Deadline Cloud, que permite crear y gestionar proyectos y trabajos de renderizado por medio de Amazon Elastic Compute Cloud (Amazon EC2) directamente desde estaciones de trabajo y canales de creación de contenido digital.

Arri acudió a la mayor feria de tecnología del mundo con un producto muy broadcast: el sistema Alexa 35 Live – Multicam. El objetivo es poner la calidad de imagen cinematográfica del sello Alexa a disposición de las producciones en vivo. Combina la nueva cámara Alexa 35 Live, el nuevo Sistema de Producción en Vivo LPS-1 (un Adaptador de Fibra para Cámara y una Estación Base de Fibra), el RCP Skaarhoj y varios accesorios. Cuenta con sensor 4K de tamaño Super 35, que permite poca profundidad de campo, y hasta 17 stops de rango dinámico. Además, posee dispone de la tecnología patentada de color REVEAL y permite grabar ProRes de calidad completa en la cámara durante las producciones en directo, para una mayor flexibilidad en postproducción. La montura de lente modular puede cambiarse entre LPL, PL, EF y B4, facilitando una amplia selección de lentes.

Los ARRI Look Files pueden otorgar un aspecto de imagen singular a través de los Multicam Looks especialmente desarrollados. Presionando únicamente un botón, puedes activar uno de los 87 looks prediseñados. La cámara incluye cinco texturas ARRI multicámara y ocho de estilo cine. Las amplias opciones de conectividad de la Estación Base de Fibra incluyen cuatro entradas de retorno y 15 salidas SDI simultáneas para 3G, 6G y 12G en enlace simple, dual o cuádruple, así como SMPTE 2110 IP.

Otra novedad de Arri son sus focos Fresnels LED L-Series Plus, un 90% más brillantes que sus predecesores (los L5 y L7) pero de similar tamaño y peso. Poseen conectividad de red directa con entrada de datos LAN y control de iluminación a través de ArtNet y Streaming ACN, además de control a bordo con el SkyPanel Classic. El L5-C Plus dispone de una lente Fresnel de cinco pulgadas, mientras que la L7-C Plus de siete pulgadas.

Atomos acudía a NAB con una novedad interesante gracias a la colaboración con Editshare que acelera el proceso entre grabación y postproducción. El material rodado con una cámara conectada a un grabador Atomos compatible con procesos cloud vía HDMI o SDI y vinculada a una cuenta de Atomos Cloud Studio, puede añadir MediaSilo como destino, sincronizándose automáticamente, de modo que el contenido llega a MediaSilo mientras se graba, pudiéndose revisar el material para postproducción inmediatamente. La integración de MediaSilo con productos Atomos como Shogun y Ninja permite a los profesionales decidir la cámara adecuada para cada proyecto.

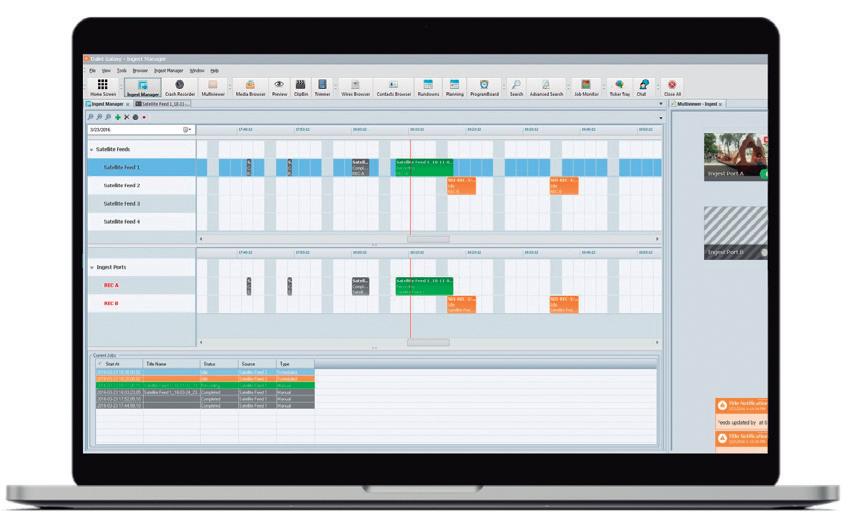

Aveco, empresa especializada en automatización y MAM, promocionaba en Las Vegas su solución Astra Media Factory, que unifica flujos de trabajo a través de una experiencia de usuario única (facilitando el aprendizaje de los técnicos) y que puede operar en entornos on-premise, remota y multi-cloud, permitiendo una transición a la nube gradual y natural a los broadcasters. El sistema permite automatizar la ingesta de archivos / señales en vivo o metadatos, posibilita el uso de inteligencia artificial en la gestión de contenidos y realiza fácilmente playout de canales de recursos on-premise, remoto y cloud en la misma interfaz para un control más eficiente.

Blackmagic volvió a brillar en NAB 2024, primeramente con sus nuevos modelos de cámaras. Por un lado, con la Blackmagic URSA Cine 12K, una cámara con sensor RGBW 36 x 24 mm y rango dinámico de 16 pasos y montura intercambiable para objetivos PL, LPL y EF. Cuenta con un almacenamiento integrado de 8TB y permite sincronización Blackmagic Cloud.

Otra cámara nueva es Blackmagic PYXIS 6K, que posee sensor 6K de 36 x 24 mm que ofrece 13 stops de rango dinámico y grabadores de medios CFexpress duales.

Por otro lado, anunciaron la versión 19 de su software de postproducción DaVinci Resolve, que añade muchas mejoras basadas en IA, el DaVinci Resolve Micro Color Panel, y los mezcladores ATEM 1 M/E Constellation 4K y ATEM 2 M/E Constellation 4K, dos modelos UHD de hasta 20 entradas SDI 12G.

Otros productos nuevos de Blackmagic que se mostraron en NAB fueron Blackmagic 2110 IP Converter, conversores que incluyen modelos compatibles con formatos UHD mediante conexiones Ethernet 10G; el SmartView 4K, un monitor UHD profesional con entradas IP SMPTE-2110 y SDI 12G; y una nueva adición a su línea de matrices de conmutación Videohub 12G: el modelo 120×120 12G.

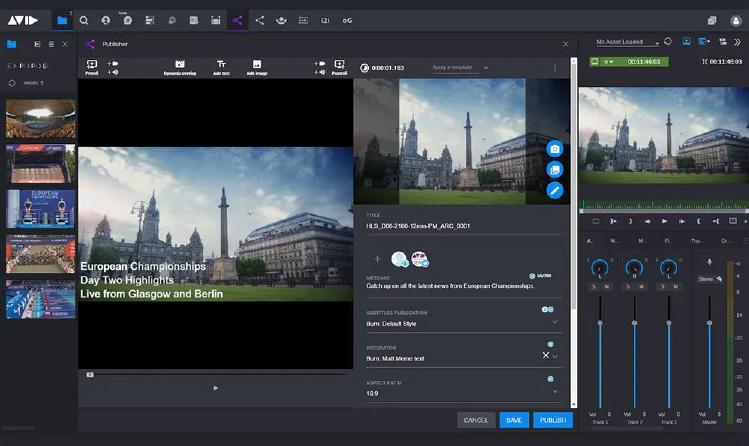

Avid es siempre una compañía con múltiples novedades. En NAB enseñó, en varias soluciones, que la compañía ha implementado Ava, un conjunto de herramientas basadas en inteligencia artificial que buscan automatizar la transcripción de voz a texto, el resumen y la traducción. Además, Media Composer cuenta ahora con una nueva herramienta de colaboración basada en SaaS que permite la colaboración en tiempo real con Microsoft Teams para sesiones de edición virtualizadas desde cualquier lugar, así como nuevas integraciones de flujos de trabajo de soluciones de terceros como Autodesk Flow Capture y Doom Solutions. En ProTools mostró funciones como la integración ARA de plugins de postproducción de audio como iZotope RX, Synchro Arts VocAlign y Sound Radix Auto Align; la integración de Dropbox Replay con ProTools para acelerar los flujos de trabajo de revisión y aprobación; flujos de trabajo de audio inmersivo que incluyen re-renders en directo para Dolby Atmos; mejoras en el flujo de trabajo de diálogos o guardado de sesiones de ProTools como archivos compatibles con Media Composer.

Por último, Avid actualiza MediaCentral, su herramienta integral de producción de noticias con una edición mejorada basada en navegador con formas de onda de audio, herramientas de búsqueda más potentes, Blueprint Builder para la planificación de flujos de trabajo o mejoras en la aplicación Rundown. Además, ha promovido integración de terceros en su como la creación de transcripciones y subtítulos basada en IA; las traducciones de Traco y Digital Nirvana; o los flujos de trabajo con Marquis o X.news para contenido procedente de redes sociales.

Brainstorm estuvo en el evento mostrando su Suite 6, la última versión para eStudio, InfinitySet y Aston. Entre Unreal Engine y el motor de render eStudio trabajan desde una sola estación de trabajo, sostenida por la GPU Nvidia RTX 6000 Ada Generation. Las mejoras principales que trae Suite 6 son LUTs 3D de color coincidente, gráficos en movimiento AR en contexto, teletransporte de talento inmersivo o contenido multifondo.

Suite 6 hace a InfinitySet compatible con estaciones de trabajo Dual-GPU, lo que permite a los usuarios dividir los requisitos de renderizado entre las dos GPU. InfinitySet 6 también ahora admite SMPTE 2110. En cuanto a Aston, gracias a StormLogic, permite nuevas transiciones e interacciones entre plantillas e incorpora herramientas para crear proyectos interativos que pueden usarse con pantalla táctil. Además, se ha simplificado el proceso de diseño y las actualizaciones esenciales pueden aplicarse directamente por los diseñadores principales, sin necesidad del resto del equipo.

Calrec mostró en NAB 2024 una nueva versión de la mesa de mezclas Argo S muy compacta para unidades móviles de espacio reducido. Esta versión combina el puente de medidores y la interfaz de usuario táctil en una única fila de pantallas. Cada sección de 12 faders de ancho es totalmente independiente para procesamiento, acceso de control de ruta, fuentes de alimentación y conectividad, y se incluye una licencia DSP nueva de 128 a 384 canales de entrada.

Cinedeck apostó en NAB 2024 por la presentación de una solución de producción y distribución de vídeo basada en la nube: Cloudflow Hub. Este equipo unifica en una única plataforma las capacidades de ingesta en directo, transcripción embebida y transcodificación de sus soluciones CD2, cineXtools y Connex. Incorpora IA para ofrecer subtítulos y traducciones en directo, permitiendo mayor eficiencia y accesibilidad en la producción.

Clear-Com asistió a la convención del NAB principalmente para la presentación de su nueva intercom Gen-IC Cloud, una solución virtual segura y flexible para integrar fácilmente hardware local con una intercom virtual. Permite escalar rápidamente múltiples clientes virtuales según se necesita, integrándose con el hardware de ClearCom a través de LAN, WAN e Internet. Al poder desplegarse regionalmente, se minimiza la latencia típica de la virtualización. Los sistemas de Gen-IC Cloud Intercom a nivel global pueden conectarse entre sí, para conformar una potente y segura herramienta de comunicación y colaboración.

Cobalt acudió a NAB 2024 con nuevas tarjetas. Una de ellas era la Cobalt Indigo Og-2110-Bidi4-Gateway, una interfaz ST 2110 bidireccional de cuatro canales nativa para E/S SDI disponible en el factor de forma openGear. Admite hasta 4 entradas a resoluciones 3G e inferiores, o una entrada a resolución 4K, con total compatibilidad NMOS. En lo que respecta a Dante, enseñó la Cobalt Aria Aud2Dante y Cobalt Aria Aud4-Dante, que ofrecen unidades de doble y cuádruple canal con funciones de hasta 12G Dante/AES/MADI/ Embed y De-Embed con capacidades Frame Sync.

Dalet se centró en enseñar a los asistentes cómo ha mejorado los flujos de trabajo colaborativos a través de la inteligencia artificial y el cloud para facilitar la producción, distribución, archivo y monetización de noticias, deportes y entretenimiento. Su plataforma unificada para la gestión de activos permite un mayor retorno de la inversión gracias a la automatización y la optimización de la los recursos, evitando el caos habitual de las redacciones.

Así, la aplicación Dalet Pyramid se presenta junto con Dalet Cut, editor basado en navegador, y funciones basadas en IA que incorpora Dalet Media Cortex, lo cual posibilita una planificación centralizada, una producción de noticias multiformato y una gestión de escaleta basada en navegador.

DJI acudió a Las Vegas con varios productos de interés. En primer lugar, destacaban los nuevos estabilizadores RS 4 y RS 4 Pro. El primero, con brazos de los ejes recubiertos de teflón y 3 kg de capacidad de carga útil. El segundo, equipado con brazos de los ejes de fibra de carbono, y una capacidad de carga útil de 4.5 kg. Asimismo, en el stand tenían el DJI Focus Pro, primer sistema independiente de control de objetivos de enfoque manual automatizado.

DJI también enseñó el DJI Mavic 3 Pro, que posee una nueva unidad de cámara estabilizada con gimbal más grande con tres cámaras: una cámara principal MFT Hasselblad de 24 mm (equiv.), una cámara de teleobjetivo medio de 70 mm, y una cámara con teleobjetivo de 166 mm, que ahora tiene una lente mejorada de f/3.4 (hay una versión Cine con SSD incorporado de 1 TB y la capacidad de grabar ProRes 422 desde las tres cámaras). Por último, destacamos el DJI Osmo Pocket 3, de sensor CMOS de 1 pulgada, grabación 4K/120 fps y estabilización mecánica en tres ejes.

Eizo sitúa en el mercado el nuevo monitor de referencia ColorEdge Prominence CG1 HDR. Con un brillo máximo de 1.000 nits, una relación de contraste máxima de 1.000.000:1 y una resolución de 4.096 x 2.160 píxeles (DCI-4K), sus aplicaciones son para masterización final y la corrección de color, o producción en directo de contenidos HLG o PG-HDR. Al ser compatible con el estándar SMPTE ST 2110, puede integrarse en entornos de producción basados en IP. Además, es el primer ColorEdge compatible con la tecnología Fixed Rate Link (FRL), con lo que transmite material 4K de 12 bits sin comprimir a través de HDMI.

Evertz llevaba varias soluciones nuevas al centro de convenciones. Una de ellas tenía que ver con su DreamCatcher Bravo, plataforma de producción colaborativa para ingesta, reproducción, conmutación de vídeo/audio en directo, repeticiones o gráficos, etc. Añadía las funciones Metadata y Highlight Factory, que permiten crear automáticamente clips y listas de reproducción mediante IA con modelos de lenguaje de gran tamaño y tecnología de aprendizaje automático profundo. Asimismo, agregó el formato JPEG XS a su plataforma NEXX. NEXX es una plataforma de enrutamiento y procesamiento en dos opciones de marco (3RU y 5RU) y admite enrutamiento 12G-SDI en el marco 5RU. Admite módulos avanzados que incluyen sincronización de cuadro, conversión up/down/cross, puertas de enlace IP y multipantallas avanzados. Llamó la atención, a su vez, una nueva gama de paneles de control de hardware para Bravo Studio: Bravo-Airfly-Pro, Bravo-Waveboard y BravoWaveboard-Mini.

FilmLight, especialista en soluciones para postproducción, lanza Nara, una herramienta que posibilita la descodificación y reproducción de forma nativa de la media sin necesidad de transcodificar a archivos proxy. Su motor de streaming minimiza el uso de ancho de banda y ofrece un acceso veloz y seguro a los archivos multimedia a través de un navegador web donde cada archivo se presenta con una miniatura y los metadatos asociados. La indexación y su interfaz de usuario permiten encontrar los contenidos rápidamente. Una vez encontrado, prácticamente cualquier formato de archivo puede visualizarse de forma segura en el espacio de color correcto desde un navegador web casi de inmediato. Nara puede instalarse en una red de almacenamiento del estudio o en la nube.

EVS se centró en la flexibilidad en el pasado NAB. Dio a conocer su nuevo modelo de licencias para su servidor de producción en directo XTVIA, permitiendo ajustar la capacidad de producción a la evolución de las necesidades de los clientes, y facilitando la expansión de canales y los cambios de características del servidor sin tener que cambiar el hardware. Los broadcasters pueden ampliar o reducir su capacidad según lo necesiten para una mayor eficacia y rentabilidad.

Hay tres modos distintos: Multicámara, ideal para las producciones en directo más exigentes, con replays a cámara superlenta y highlights con funciones completas para flujos de trabajo complejos; Spotbox: pensado para ingesta y reproducción, con puertos de grabación seguros para ingesta de múltiples fuentes en directo, y reproducción de canales; y Sportlight, adecuado para producciones más pequeñas o con un presupuesto limitado, pero con repeticiones y resúmenes con el sello de calidad EVS.

Fujifilm asistió a la feria del NAB con la lente Fujinon Duvo HZK 14-100mm como estandarte. Esta lente zoom portátil con montura PL es la tercera de la serie de lentes Duvo de Fujinon, complementando a Duvo HZK 25-1000mm F2,8-F5,0 PL Mount Cinema Box Lens y al Duvo HZK 24-300mm Portable PL Mount Zoom Lens. El nuevo producto está dirigido a entornos broadcast y ofrece zoom de 7,1x, cubriendo 14-100mm, un rango focal de uso frecuente en plató. La solución cuenta con T2,9 en el extremo ancho (14mm), lo que también le permite adaptarse a conciertos con poca luz, eventos nocturnos y entornos que busquen una profundidad de campo limitada. Al igual que los anteriores, incorpora un expansor 1,5x integrado.

En el ámbito de las cámaras, su stand destacaba por dos productos. Uno era la Fujifilm GFX100 II, con nuevo sensor de 102 megapíxeles “GFX 102MP CMOS II HS” con una velocidad de lectura aproximadamente dos veces más rápida que GFX100S. Es capaz de grabar internamente en 4K hasta 60p sin recorte y en 8K hasta 30p con un recorte de 1,4x. Lo hace en H.264 y H.265 con muestreo 4:2:2, 10 bits y compresión All-I. El otro era la Fujifilm X100VI, de grabación de vídeo en 6,2K a 30p y 4K a 60p, con grabación interna en color 4:2:2 de 10 bits. Introduce la nueva curva F-Log2 con más de 13 stops de rango dinámico.

Haivision llegaba a Las Vegas con una novedad por encima de las demás, la solución de cloud Haivision Hub 360, que busca la gestión remota de dispositivos, usuarios, fuentes de vídeo y destinos durante la contribución en directo. Los profesionales pueden enrutar vídeo en directo sobre Internet con SRT y redes celulares con SST y permite gestionar transmisores de vídeo móvil Haivision, codificadores Makito, apps MoJoPro y receptores StreamHub para contribución por IP y SDI.

Los usuarios pueden fácilmente hacer ‘arrastrar y soltar’ codificadores y fuentes de vídeo de transmisores de campo que estén conectados y llevarlas a StreamHub para manejar flujos de trabajo broadcast en directo. Haivision Hub 360 simplifica estos flujos para ofrecer coberturas de eventos complejas desde cualquier lugar.

Harmonic destacó en NAB 2024 con VOS360, un sistema de publicidad durante el streaming pensado para producciones deportivas en directo. Ofrece nuevos formatos publicitarios en split-screen que posibilita nuevos modos de monetización. El sistema no perturba la experiencia del visionado de los espectadores, ya que la publicidad aparece simultáneamente al contenido y con una baja latencia en comparación con otras soluciones. Es un producto nativo de la nube y que permite la inserción publicitaria entregada a millones de usuarios concurrentes. Los anuncios pueden colocarse de forma estratégicamente en momentos de baja o alta intensidad en los partidos, tanto de forma manual como automática.

Grass Valley fue de las mayores protagonistas del NAB. En el ámbito de cámaras, mostraron las nuevas LDX 135 RF y 150 RF, para cubrir la demanda de versiones inalámbricas en su serie LDX 100. Poseen tres Xenios Imager, una sensibilidad de hasta F11 @ 2000 lux, un nuevo procesamiento LUT integrado que evita recurrir a conversores externos y la posibilidad de grabar a 6x 1080p con resolución UHD nativa de la salida de señal en directo.

También hubo expectación con Maverik X, nuevo mezclador basado en software. Permite flujos de trabajo UHD HDR de 10 bits, conversión automática ascendente/descendente/cruzada y mapeado HDR LUT. Puede usarse en local, híbrido o en la nube, y se adapta a cada necesidad de producción, dando así la posibilidad de definir el número de entradas/salidas, M/Es, keyers, DVEs y replay wipes. Combinado con AMPP, el sistema puede incluir multiviewer completo, mezcla de audio, grafismo, replay y otras opciones que se controlan desde una sola interfaz.

Además, al gestor de contenidos Framelight X se le ha añadido IA media el AWS Rekognition, posibilitando el análisis de millones de imágenes, incluyendo streaming y vídeos almacenados en pocos segundos. También han mejorado LiveTouch X, solución para replays que ahora permite 2, 3, 6 y más super slow-motions y una mejorada agrupación de cámaras por usuario.

Otras novedades son la nueva generación de tarjetas de E/S IP para sus mezcladores de la serie K-Frame XP, que soportan hasta 100Gbe de conectividad JPEG XS nativa directamente al conmutador por tarjeta, el nuevo Clipstore II a la línea de productos Grass Valley K-Frame, que ofrece hasta 4 canales de reproducción y grabación, hasta UHD 4K 2160P como SDI o ST2110, y GV Orbit, que aumenta su rendimiento de orquestación de enrutamiento híbrido IP y SDI con la integración de AMPP para control y monitorización unificados.

La japonesa Ikegami, que celebraba su 60 aniversario, acudió a las Las Vegas con una novedad que destacaba por encima de las demás: el sistema de cámara portátil HD HDK-X500. Diseñada para operación tanto en estudio como en exteriores y cámara de hombro, posee tres sensores CMOS de obturación global de 2/3 pulgadas de última generación y corrección óptica automática del viñeteado en toda la gama de objetivos zoom con montura de bayoneta B4 compatibles con OVC. Utiliza el mismo sistema de doble filtro de densidad neutra y compensación de color utilizado en sus cámaras de gama alta, mientras que el procesador digital integrado proporciona una corrección del color de 16 ejes que ajusta de forma precisa la escena y crea efectos específicos. También mostraban el panel de control de operaciones OCP-500 de Ikegami permite controlar la HDK-X500 de forma totalmente remota.

Asimismo, destacaban los nuevos monitores HD HLM-2460WA y HLM-1860WR. El primero es de 24 pulgadas y cuenta con un panel LCD IPS con una relación de contraste de 1.800:1 y 400 nits de brillo máximo. El segundo es de 18,5 pulgadas y la pantalla dispone de una relación de contraste de 1.000:1 y 500 nits de brillo máximo.

Imagine Communications llevó a Las Vegas un producto ya presentado unos meses antes, Magellan Connect, una extensión de su Magellan Control System que permite a la plataforma de enrutado broadcast gestionar señales en aplicaciones ground-tocloud. Aprovechando tecnologías de distribución ya testadas en seguridad y codificación, y gracias a la integración con AWS MediaConnect y TechEx MWEdge, Magellan Connect genera un entorno integral de enrutado que permite una conexión sencilla de las señales, independientemente de si está en onpremise o en la nube.

Arri Alexa 35 Live Multicam System

Interra Systems llevó a Las Vegas la versión 9.0 de su sistema Baton, ya anunciado en el último IBC y que es una plataforma de control de calidad impulsada por IA. Posee un nuevo motor mejorado y una aplicación web que permite nuevas comprobaciones, formatos y funciones. Complementando las actualizaciones, el Baton Media Player también ha mejorado en rendimiento y usabilidad, una actualización que beneficia especialmente a aquellos que trabajen con contenido UHD y Dolby Atmos. La plataforma migra de Python 2.x a Python 3.x, lo que redunda en una interfaz más responsive, una escalabilidad mayor y una optimización de los recursos. La mejora de las comprobaciones incluyen la detección y la decodificación de códigos QR, pérdidas de vídeo, barras negras, detección de logos, reconocimiento de subtítulos abiertos, etc.

JVC llevó a NAB 2024 los nuevos mezcladores de estudio Connected Cam vMix de la serie KM-IP12S8: KM-IP12S8 y KM-IP12S8PRO. Están pensados para aplicaciones multicámara, como producciones deportivas y eventos en directo. Incluyen licencia de software vMix 4K o vMix Pro Live Production and Streaming. El KM-IP12S8 admite hasta 12 entradas de vídeo NDI/SRT y ocho SDI, así como múltiples opciones de salida, como 12G-SDI, 3G-SDI, HDMI y DisplayPort. Asimismo, posee tres puertos Ethernet de 2,5 GbE para conectividad NDI, SRT, Dante y RTMPS. El KM-IP12S8PRO tiene las mismas cualidades hardware, pero con la licencia de software vMix Pro para reproducción instantánea de ocho canales.

Pebble, la empresa antes conocida como Pebble Beach, ofreció en NAB novedades en Prima, su plataforma para aplicaciones multimedia integradas en tiempo real y basada en Linux/Kubernetes. Gracias a la colaboración con NVIDIA y su Holoscan for Media, Prima permite que muchas aplicaciones multimedia (playout, workflow y visualización de contenidos) se ejecuten en una plataforma de cálculo compartida en lugar de en un hardware específico.

Sennheiser MKH 8030

Matrox Video presentó en NAB una actualización del kit de desarrollo de software Matrox DSX para tarjetas NIC y E/S DSX y X.mio que permiten una latencia ultrabaja de entrada a salida, con un retardo de 1 frame en vídeo entrelazado y de 2 franes en vídeo progresivo. DSX SDK 10.5 también admite ST 2110-22 con codificación y descodificación JPEG-XS y añade compatibilidad nativa con AWS S3 con Flex Reader y Writer para aplicaciones cloud

Otra novedad es la tarjeta de red ST 2110 de 100 GbE. Está diseñada para entornos multimedia de alto rendimiento, incluida la producción virtual. De sus codificadores y decodificadores Matrox Monarch EDGE enseñó su versión 2.07 con soporte de audio HDR y Dolby, metadatos VANC para subtítulos, SCTE-104 para inserción de anuncios y SRT Stream IDs para hacer más sencillo el enrutamiento de secuencias. Por último, destacamos Matrox ORIGIN, que ofrece a los radiodifusores y proveedores de producción en directo una solución escalable, flexible, basada en la nube y COTS en un modelo OPEX.

Panasonic llamó la atención de los asistentes de esta edición con su nuevo servidor para directos Kairos Core 200 AT-KC200L1 y la versión 1.7 de software, que añade la operatividad de enrutado inteligente. El AT-KC200L1, que es compatible con entradas y salidas SDI de serie, ofrece una calidad de vídeo alta al utilizar Kairos las retransmisiones en directo, eventos, deportes y en los mercados corporativos y educativos. Admite 24 entradas / 12 salidas (FHD) de serie,[2] pero ofrece una producción de vídeo más flexible a los clientes que utilizansistemas de producción de vídeo basados en SDI. Además, se pueden admitir hasta 32 entradas/16 salidas (FHD) instalando de manera adicional la placa E/S SDI AT-KC20M1

Por otro lado, también debutó su nueva cámara PTZ AW-UE30, una solución compacta y silenciosa que es adecuada para reuniones educativas y corporativas por su seguimiento automático incorporado.

Prestigioso software para producción virtual, Pixotope es compatible con la última versión de Unreal Engine (5.4), pudiendo hacer uso de Unreal Motion Design. El objetivo es llevar gráficos de calidad cinematográfica y contenido inmersivo al ámbito de las noticias, deportes y otros workflows de ritmo rápido.

Pixotope aprovecha el controlador gráfico multicanal Erizos Studio, compatible con MOS, para ofrecer una solución basada en plantillas y escaletas, y consolidar la gestión de varios canales gráficos, evitando una sincronización lenta de plataformas de proveedores independientes y reduciendo el tiempo de formación de los operadores. Se cubre todo el flujo de trabajo de producción virtual, desde el tracking de cámaras hasta la realidad aumentada y los gráficos de estudio virtuales y la realidad extendida.

La española Promax destacaba en NAB 2024 su analizador universal de 6 GHz para broadcast Atlas NG, un medidor de campo multipropósito que ahora viene con analizador de señal 4G/5G (opcional), TS y ASI sobre fibra (opcional) y DVB-S2x con soporte de hasta 256-APSK, así como ATSC 3.0, IPTV, medidas de fibra óptica, 3G-SDI, ALP y transport stream, ASI...

El producto pretende ser referencia para el análisis y el diagnóstico de redes de telefonía móvil y es totalmente compatible con HEVC H.265 y descodifica con fluidez vídeos HEVC codificados a resolución de 10 bits.

Quantum acudió al NAB con la solución de almacenamiento ActiveScale z200, que incluye ahora una opción totalmente flash que ayudará a casos de almacenamiento S3 que necesitan una rápida ingesta de datos, análisis de alto rendimiento, recuperación rápida de datos y preservación de datos a largo plazo. El almacenamiento totalmente flash ActiveScale Z200 ofrece hasta cinco veces más rendimiento (gigabytes por segundo) y hasta nueve veces más transacciones que las soluciones tradicionales de almacenamiento de objetos en disco duro, facilitando las funciones como la ingesta de datos de alto rendimiento, la preparación de datos de IA, la formación y la inferencia, las bases de datos NoSQL y el streaming de contenidos.

RED se suma a la tendencia de ofrecer el look cinematográfico al mundo broadcast. Así, en el NAB 2024 mostraba el nuevo módulo RED Cine-Broadcast que es compatible con V-Raptor y que pretende la integración del look cine en producciones de entretenimiento, retransmisiones deportivas y eventos. Permite la emisión en directo de hasta dos canales de 4K 60P (HDR/SDR) a través de 12G-SDI. El sistema, preparado para la emisión IP con SMPTE ST 2110 (TR-08) y hasta una señal 4K 60P JPEG-XS, también incorpora un conector de cable de fibra óptica híbrido LEMO SMPTE 311M/304M, que se conecta a una estación base 2 RU montable en bastidor.

La empresa anunció también, para la gama de cámaras DSMC3, Broadcast Color Pipeline, función que permite corregir en directo el color de las cámaras RED en entornos de emisión o streaming, así como realizar ajustes bajo demanda.

Riedel contó con algunas novedades interesantes en Las Vegas. Una de ellas fue MediorNet HorizoN, que difumina los límites entre las infraestructuras basadas en SDI y las de ST 2110 con una serie de gateways SDI-IP, ofreciendo una gran cantidad de funciones de procesamiento de vídeo como conversión up/down/cross, conversión SDR-HDR y corrección de color. En una única unidad de rack, cuenta con 16 motores de procesamiento independientes y configurables individualmente. Permite hasta 128 canales de SDI-ST 2110, hasta 32 canales de SDR-HDR o hasta 16 conversiones up/down/cross.

Más allá de eso, amplía su gama de soluciones de ingesta RiCapture con la incorporación de RiCapture i8, i44 e i84. Ofrecen una mayor densidad de canales y/o resolución UHD, compatibilidad con 8 y 10 bits y almacenamiento SSD interno ampliado. RiCapture permite en todos los casos grabación de alta calidad en DNxHD o DNxHR junto con codificación H.264 4:2:0 y 4:2:2 al almacenamiento local, así como grabar 16 canales de audio embebido por canal, así como 64 canales Dante o AES67.

Rohde & Schwarz enseñó en el centro de convenciones su nuevo transmisor refrigerado por líquido TE1, su modelo más sostenible y que ofrece un servicio de monitoreo remoto 24 horas al día, 7 días a la semana. Está optimizado para aplicaciones de alta potencia de hasta 98kW. La solución simplifica el mantenimiento y la operación, reduciendo costes hasta un 40%, minimizando la huella de carbono y siendo el primer transmisor nativo ATSC 3.0.Así, la aplicación Dalet Pyramid se presenta junto con Dalet Cut, editor basado en navegador, y funciones basadas en IA que incorpora Dalet Media Cortex, lo cual posibilita una planificación centralizada, una producción de noticias multiformato y una gestión de escaleta basada en navegador.

Ross Video, empresa fundamental en el mundo broadcast, celebró en la feria su 50 aniversario con múltiples productos. En mezcladores de producción, debutaba Carbonite Code, equipo basado en software optimizado para flujos de trabajo NDI y que presenta tres MEs, cada uno con 6 Keyers. En esta gama también se añade Carbonite Ultra 60, mezclador con clip player HD/ UHD y 800GB de SDD interna para almacenamiento. En superficies de control para mezcladores se lanzaron los nuevos paneles TouchDrive TDx4 y TDx3, con opciones de control táctil, por deslizamiento y por gestos. El stand acogió, asimismo, el lanzamiento de la versión 12 de su sistema de gráficos en tiempo real Xpression, ahora con LUTs 3d customizados para HDR y clip ganging para fill/key, y los nuevos motores M9 (en 2RU y 4RU), con 25% más cores que el M8 y cerca de 4 veces más almacenamiento en solo 2RU. En cuanto procesadores de imágenes, enseñó Mosaic Ultra, que ofrece calidad de hasta 50 millones de píxeles en UHD o los 20 millones de píxeles en modo HD, con una muy baja latencia.

Otra novedad fue Artimo (Art In Motion), sistema de cámara para estudio de robótica avanzada que posee la flexibilidad de un pedestal de movimiento libre y que emplea la tecnología LiDAR. También destacó en su stand el Streamline Pro Video Editor, sistema escalable que combina funcionalidades de gestor de contenidos con editor de vídeo que agiliza la creación y entrega audiovisual.

La principal novedad de Sennheiser en NAB 2024 era el micrófono MKH 8030, que cuenta con un transductor pushpull simétrico y acústicamente abierto —para un sonido lo menos restringido y distorsionado posible— y basado en la reconocida tecnología de doble cápsula del micrófono MKH 800 Twin de Sennheiser. En conjunción con un diafragma de baja tensión, proporciona una sensibilidad muy destacada y una amplia respuesta en frecuencia. Son adecuados para entornos húmedos, cálidos y fríos, porque el flujo permanente de corriente de RF en la cápsula del micrófono evapora la humedad de forma natural. Está pensado para exteriores, como retransmisiones deportivas y rodajes en la naturaleza. El patrón polar bidireccional en forma de 8 capta el sonido igualmente por delante y por detrás, además de rechazar el sonido lateral. Su rango de agudos ampliado (hasta 50 kHz) capta el sonido de forma detallada con una respuesta de transitorios precisa, mientras que su pintura antirreflectante Nextel evita reflejos de las luces.

La nueva consola compacta System T S400 era la estrella del stand de Solid State Logic en NAB 2024. Es una superficie de control para la plataforma System T de producción broadcast IP nativa de nueva generación. Disponible en bastidores independientes de 16+1, 32+1 o 48+1 faders, la S400 se sitúa entre la compacta S300 de bastidor fijo y la S500 modular. Como la S500, dispone de faders táctiles premium de 100 mm y una pantalla OLED dedicada para cada fader. Además de la producción de estudio en directo, el S400 es una solución ideal para espacios reducidos: unidades móviles, espacios para eventos y aplicaciones musicales, etc.

Además, también hizo su debut System T Cloud, una solución cloud integral para producir audio broadcast con más flexibilidad y escalabilidad que es perfecta para gestionar producciones en directo desde múltiples lugares.

Sony, como siempre, era una parada obligatoria para los visitantes. En cámaras de cine seguían mostrando la todavía reciente Burano, cámara 8K Full Frame versátil, ligera y compacta con 16 stops de rango dinámico y estabilización de imagen para objetivos con montura en E y PL. En cámaras de estudio tenían la HXC-FZ90, adecuada para producciones HD y, con licencia de software, 4K HDR con sensor CMOS de ⅔ pulgadas. Adopta el espacio de color BT.2020 y es compatible con SR Live para HDR (HLG/S-Log3).

Su gama gama de monitores PVM (PVM-X3200 , PVM-X2400 , PVM-X1800) estaba con la versión 5.0 del firmware, que añade producción simultánea de vídeo HDR y SDR, funciones optimizadas para HDR como ajustes automáticos 4K/HD SDI, ajustes detallados del brillo de los negros y compatibilidad con el modo entrelazado. Además, se contaba con la pantalla Crystal LED VERONA, para aplicaciones VFX en cámara. Cuenta con tecnología Deep Black y antirreflejos, y un diseño de carcasa 1:1 de fácil instalación.

Sound Devices llegó al NAB 2024 para desplegar su A20-SuperNexus, un receptor de 16 canales con tecnología HexVersity (2-, 3-, 4-, 5-, o 6 antenas de diversidad) en una unidad de rack, con lo que permite ahorrar espacio. Mediante licencias de software, puede expandirse a 32 canales, todos con HexVersity. Posee un rango de sintonización de 169 –1525 MHz, lo que le permite operar en cualquier parte del mundo, y cuenta con RF Mirror Mode para trabajar de forma completamente redundante.

Sony promovía su ecosistema Networked Live con herramientas para facilitar la producción remota y distribuida a través de soluciones híbridas en las instalaciones y en la nube. Lanzaban la nueva funcionalidad V1.1 para el dispositivo de transporte de medios LAN/WAN NXL-ME80, que permite que el dispositivo funcione como receptor junto a la unidad de producción remota CBK-RPU7, en un entorno de comunicación 5G privado. En cuanto al conjunto de aplicaciones basadas en la nube, Creators’ Cloud, el servicio de colaboración y gestión de media, Ci Media Cloud, cuenta ahora con integración con Medway de Marquis Broadcast que permite la ingesta automatizada desde Ci a los sistemas Avid. Además, lanza oficialmente Ci Workflow, que permite realizar VFX con un trabajo más automatizado.

Tedial enseñó en NAB las mejores de su sistema de gestión de contenidos SmartWork, utilizado para noticias, postproducción, playout, OTT, deportes, etc. Ofrece nuevas funciones de colaboración y sin código, así como mejoras en la seguridad con la implantación de la norma ISO 27017 y la renovación de las certificaciones ISO 27001 y GPDR. Refuerza su naturaleza cloud sin código con diversos editores gráficos (BPM workflow designer, Form designer, Metadata editor y UI designer), que tienen interfaces intuitivos y facilitan una colaboración más fluida y eficiente.

Vizrt mostró en la feria NDI 6, solución de producción remota con flujo de trabajo en la nube con TriCaster Vectar y que ofrece soporte nativo de HDR y 10 bits de color. Esta nueva versión mejora la compatibilidad y la seguridad de las transmisiones NDI, permitiendo la colaboración segura y en tiempo real entre ubicaciones y dispositivos diferentes.

Por lo demás, debutaba Viz Virtual Studio Go, una solución de escenarios virtuales y gráficos de realidad aumentada que se combina muy bien con TriCaster. Con su software y hardware preconfigurados, gráficos totalmente diseñados y personalizables y plantillas de sets virtuales, se simplifica sensiblemente todo el proceso.

Telestream se desplazó a Las Vegas y enseñó en su stand Live Capture as a Service, una solución para ingesta de contenidos en directo aprovechando la tecnología de la nube y eliminando la necesidad de infraestructura física. Con esto permiten a los radiodifusores tener mayor flexibilidad y escalabilidad, así como reducir gastos generales. Paralelamente, la empresa también disponía GLIM as a Service, plataforma cloud que ofrece acceso y reproducción instantánea de la media, facilitando el control de calidad y la colaboración en tiempo real.

Por lo demás, había bastante más cosas de interés por Telestream: Vantage Cloud, sistema que permite gestionar el contenido desde la ingesta a la distribución con soporte automático e impulsado por IA para diversos procesos; DIVA 9, sistema que simplifica el archivado con almacenamiento inteligente de medios, funciones avanzadas de búsqueda Elasticsearch e integración completa en la nube; y Live Play 2.0 solución que acelera el acceso a los contenidos y agiliza el montaje y la emisión de las noticias, posibilitando la revisión inmediata de las señales de varias cámaras y que añade compatibilidad con el protocolo AMP y una nueva interfaz con funciones multipantalla.

TVU Networks acudió al NAB para mostrar sus tecnologías de vídeo en vivo basadas en la nube e IP. Con el sistema de gestión TVU MediaHub, se proporciona una Escalabilidad híbrida e ilimitada (con recursos locales en centros de datos o en la nube), aceptando varios formatos de entrada que van desde SDI, NDI, SRT, TVU Grid, hasta YouTube, y con una interfaz visual orientada a objetos.

La utilización de la A por la empresa también es pronunciada en flujos de trabajo como TVU MediaMind, TVU Producer y TVU Channel desde la adquisición hasta la distribución. Algunas mejoras en lo que respecta a IA que están aportando son la automatización de los informes de publiciad, las transcripciones o el clipping de contenidos.

Vubiquity llegaba al centro de convenciones de Las Vegas para mostrar las bondades de MetaVU, que fue desarrollado como parte del Vubiquity Media Suite. MetaVU es una solución de software que agrega, enriquece, localiza y entrega metadatos a escala global. La plataforma SaaS y nativa en la nube incluye más de 2.000 OTT y Set-Top-Box existentes. Con detallados géneros, palabras clave, etiquetas y categorías de ánimo, sus metadatos ayudan a un descubrimiento de contenido más accesible, recomendaciones más inteligentes y un mayor engagement.

La empresa VSN, referente en gestión y automatización de contenidos en los últimos lustros, se muestra con la nueva marca So More Media, que reúne también a M&I y Woody. Una plataforma unificada de espíritu holístico para afrontar los retos tecnológicos con mayor facilidad, creatividad y eficiencia, desde la planificación al archivado. Las ya conocidas cualidades de Vsn se combinan con el software para cadenas de radio y broadcasters de M&I y con el software de ingest y outgest de Woody.

Zeiss llegó al NAB 2024 con dos novedades principales. Por un lado, con la versión 2.0 del software Zeiss CinCraft Scenario, que proporciona datos de tracking de cámara para renderizado en tiempo real para producción virtual o AR/XR en directo, así como captura de esos datos para postproducción. Integra un nuevo calibrador de plantillas de objetivos, permitiendo ajusta las plantillas genéricas a las características específicas de cada proyecto. Amplía su compatibilidad a objetivos fuera del ecosistema Zeiss y Arri/ Zeiss, ofreciendo plantillas para más de 90 objetivos de más de 10 gamas, incluidas lentes broadcast.

La compañía del Grupo Mediapro especializada en gráficos, WTVision, presentó en Las Vegas FootballStats CG, solución personalizable para partidos de fútbol. Permite visualización de datos en tiempo real para partidos de fútbol, así como una completa integración con otros productos de wTVision, lo que proporciona a broadcasters soluciones integrales. También muestra en NAB otras soluciones como Studio GC, controlado de vídeo y grafismo, o ChannelMaker, software de automatización de emisión.

EN ESTA EDICIÓN ESPECIAL DE TECNOLOGÍA AUDIOVISUAL Y BROADCAST, EN RUBIK HEMOS QUERIDO COMUNICARNOS CON ALGUNAS TELEVISIONES

AUTONÓMICAS PARA CONOCER CÓMO SE ESTÁN RENOVANDO LOS RADIODIFUSORES EN ESPAÑA Y DE QUÉ FORMAN ESTÁN MEJORANDO SUS

INFRAESTRUCTURAS Y SU EQUIPAMIENTO. EN ESTE PRIMER ARTÍCULO, NOS CENTRAMOS EN LA RADIO Y TELEVISIÓN DE ANDALUCÍA (RTVA), PARA LO QUE HEMOS CONTACTADO A SU DIRECTOR TÉCNICO, PEDRO ESPINA.

Era especialmente interesante comunicarse con Pedro Espina, ya que desde 2023 ocupa la Dirección Técnica de la RTVA , la entidad que lleva a los espectadores Canal Sur.

Espina, que sustituía en el cargo a José Enrique Zamorano, es ingeniero informático, titulado por la Universidad de Sevilla, Máster en Seguridad Informatica por la UOC y Máster en Protección de datos, Transparencia y Acceso a la información por la Universidad San Pablo CEU. Hasta ese momento, era coordinador general de la Dirección General de Comunicación Social de la Junta de Andalucía.

Según nos comenta Espina, ahora mismo están inmersos “en la definición de una estrategia tecnológica para los próximos años que sirva de guía y hoja de ruta tecnológica”.

Al entrar hace muy poco, Espina se encontró con renovaciones tecnológicas que estaban ya en marcha.

Una de ellas era el sistema de gestión de la continuidad de emisiones (playout), basado en servidores de vídeo K2, con mezclador Miranda y sistema de automatización Marina de Pebble Beach, que se está renovando completamente. Se está pasando a una arquitectura de dispositivos de canal integrado también de Pebble Beach que soporte a partir de ahora la gestión de vídeo sobre IP (ST 20226, ST 2110), integrando la inserción de subtítulos en formato OP-47, el sistema de transcodificación, un sistema de control de calidad (QC) automático y la renovación del sistema de tráfico Provys.

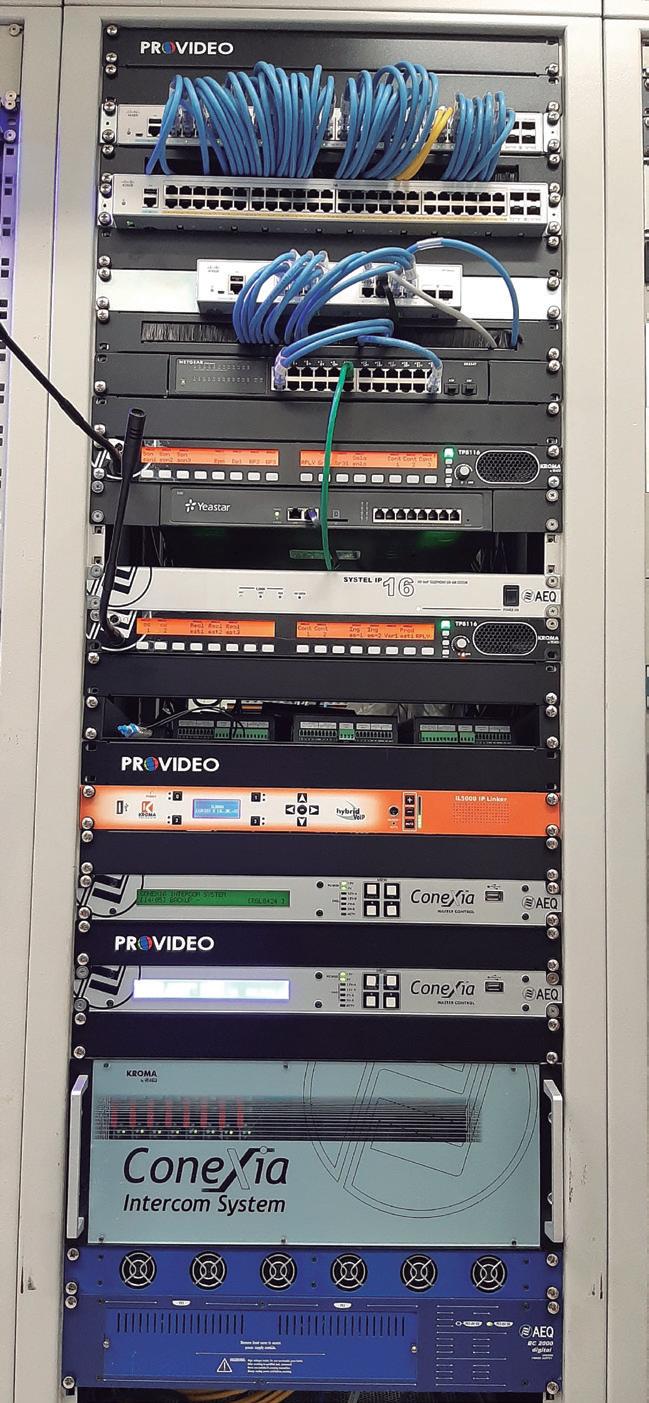

Otra implementación que se encontró era la del sistema de comunicación interna (Intercom), seleccionando el sistema Conexia, con terminales TP8116 de AEQ, con conectividad IP y uso de protocolo Dante.

La tercera y última tiene es la Plataforma digital integrada de edición, emisión y archivo, contratada como servicio a Telefónica y que cubre prácticamente todo el ciclo de producción audiovisual de la televisión.

A partir de la llegada de Espina, se han iniciado diversas renovaciones. Por ejemplo, se ha cambiado el sistema de teletexto, pasando a un sistema redundado Polistream U8100 de BroadStream.

Además, hay novedades en el sistema de generación de señales de sincronismo, tanto en el centro de producción principal como en los centros territoriales, utilizando generadores Telestream SPG8000A redundados en configuración MaestroEsclavo con changeover automático en Sevilla y equipamiento de Albalá Ingenieros (HTG3001C01).

A nivel de grabación, Espina nos indica que se ha producido una renovación de 10 cámaras ENG Panasonic AG-CX350.

Otra actualización relevante es que se han renovado las pantallas LED de gran formato de los estudios de TV 1 y 3, incluyendo una de 13,5 x 2,5m, otra de 7 x 2,5m, y dos de 4,5 x 2,5m, con el correspondiente sistema de gestión de grafismo. Para esto último se ha optado por una solución de Chyron.

Por último, subrayamos que se han adquirido 8 codificadores IP Quantum de

Cámaras ENG

Panasonic AG-CX350

Prodys y 6 mezcladores portátiles para las retransmisiones de la radio.

“No obstante, la principal licitación ha sido la del servicio de redacción del proyecto y dirección de ejecución para la modernización de las infraestructuras y sistemas técnicos para la producción de televisión del centro de San Juan de Aznalfarache”, señala Espina.

“Debe ayudarnos a avanzar en la migración a IP del equipamiento principal de conmutación de señales de vídeo , así como en la renovación de los mezcladores de vídeo de los Estudios de TV”, añade el director técnico de RTVA.

De todas las licitaciones puede obtenerse más información en la plataforma de contratación pública de la RTVA.

Es un servicio de consultoría e ingeniería sobre su principal centro de producción de televisión adjudicado recientemente a Abacanto.

OTRO BROADCASTER ESPAÑOL DEL QUE CONTAMOS CÓMO SE HA RENOVADO ES TELEMADRID Y SU RADIO TELEVISIÓN MADRID (RTVM). NOS HEMOS COMUNICADO CON SU DIRECTOR TÉCNICO, JOSÉ MARÍA CASAOS, PARA CONOCER EN DETALLE SUS PROYECTOS, SU ESTRATEGIA, SUS IMPLEMENTACIONES Y SU NUEVA TECNOLOGÍA.

José María Casaos , ingeniero de Telecomunicaciones por la Universidad Politécnica de Madrid, se incorporó a RTVM en 2019. Tiene un amplio curriculum en el sector TIC, incluyendo experiencias como emprendedor, como fundador de la empresa Createcna. También ha ejercido como director técnico del grupo Atresmedia y como director de negocio de televisión de Ericsson para Iberia.

“El año 2023 ha sido sin duda el año de implementación del proyecto de renovación tecnológica de Telemadrid, el cual incluye muchas iniciativas y donde uno de los principales proyectos ha sido la creación de una infraestructura única y convergente usando la tecnología IP, con todos sus beneficios, en cuanto a mejora de la calidad y ahorro de costes de las producciones, mayor redundancia y fiabilidad de las infraestructuras, que sin duda contribuirán a la sostenibilidad del servicio público”, nos cuenta José María Casaos.

Según indica a RUBIK, en este proyecto, se han elegido los protocolos de tecnología de vídeo SMPTE 2110, el protocolo DANTE de audio (del que ya tenían experiencia

previa en Onda Madrid), y, en paralelo, seguirán usando “otros protocolos IP que actualmente estamos usando en todo tipo de conexiones y videoconferencias, como puede ser el NDI, SRT y demás”.

En la actualidad disponen de dos controles en IP, que han llamado A y B (a diferencia de los anteriores numerados del 1 al 4) para que puedan dar servicio a cualquiera de los cuatro platós de televisión, pero también a la totalidad del centro de producción donde se va a poder conectar cualquier equipo como cámaras o micrófonos, y anticipándose a flujos de trabajo con capacidad de producción remota.

“El IP también hará posible hacer de una manera mucho más sencilla la gestión de los controles de realización, con sus sistemas de orquestación y control, que facilitan enormemente la gestión de señales, los multipantallas, las comunicaciones, así como la automatización de muchos procesos y, sin duda, favorece el trabajo diario, el trabajo en remoto y el soporte y mantenimiento de los sistemas”, explica Casaos sobre la importancia de la transición a IP.

“La introducción de una tecnología prometedora o especialmente interesante no sirve de nada sin un equipo humano preparado para aprovechar al máximo los beneficios de esta, y más cuando lo que está sobre la mesa es una transición a una infraestructura técnica completamente diferente que trae modificaciones sustanciales en la operativa de gran parte de la cadena broadcast”, asegura el director técnico de RTVM.

La nueva etapa de Telemadrid es más flexible para el técnico y permite producir con unos flujos de trabajo internos más sencillos, facilitando mucho la capacidad de innovar en todas las áreas de la televisión.

La sostenibilidad también es clave para el ente, según señala Casaos: “Se siguen incrementando las decisiones encaminadas a la sostenibilidad, con el compromiso de examinar la huella tecnológica de las inversiones con vistas a reducir costes, disminuir la complejidad operativa y reducir la producción de carbono”.

Un ejemplo de ello ha sido las inversiones en iluminación con tecnología LED para los platós de televisión. “Ha reducido el consumo eléctrico en más de una 85% y la renovación de la infraestructura que soporta nuestra capacidad de almacenamiento y procesamiento en los sistemas, que nos ha permitido reducir la huella física hasta un 40% en el CPD, debido al menor consumo eléctrico, ruido, etc.”, recalca el director técnico de Telemadrid.

Otros proyectos de tecnología que se han realizado en RTVM son:

• Ejecución y puesta en marcha del proyecto de sustitución del sistema de Prompter de los estudios, 6 licencias para funcionamiento redundante, 15 monitores de 17”, sistemas de operación tanto fijos como inalámbricos en cualquier de los estudios.

• Mejora de la fiabilidad del sistema intercomunicación técnica mediante la adquisición de una matriz de back-up.

Centralita PBX Redundante. Instalación de un sistema redundante PBX para mejora de la seguridad de las comunicaciones de voz de los programas de Televisión y Radio.

• Adquisición de una mesa de control de iluminación de back-up para aumentar la fiabilidad de los sistemas de iluminación.

Instalación de una pantalla LED de grandes dimensiones en el

Plató 1. Compuesta por 6 pantallas, 1 fija y 4 móviles (motorizadas), y 1 de suelo que permitirá realizar Realidad Extendida (XR).

• Se han licitado y adjudicado los servicios de Cabecera y múltiple TDT para la difusión de los programas de Telemadrid y Onda Madrid. “Son servicios que se han adaptado a la nueva situación tecnológica, marcada por la desaparición de los servicios SD y que RTVM ha aprovechado para la incorporación de una emisión HD HDR destinada a mejorar la calidad de visionado para los usuarios de televisores de última generación”, apunta Casaos.

• Adquisición de un sistema automatizado de producción audiovisual para el Estudio 3. Dotan de tres cámaras robotizadas y un sistema de gestión que detecta qué persona está interviniendo y elige los planos de cámara más adecuados según criterios previamente establecidos. Este sistema permite la generación de contenidos con destino al área digital de una forma fácil y económica. Puesta en marcha de un sistema de codificación y transmisión de video y audio con baja latencia a través de Internet (Tecnología SRT) que permite el envío de señales de retorno y Telepromter a medios de producción en exteriores como unidades móviles, ENG´s y otros.

• Renovación del Locutorio para eventos externos. Es una nueva instalación con tecnología SMTE2110 y HD del Locutorio para eventos de exteriores.

EN TERCER Y ÚLTIMO LUGAR, REPASAMOS LAS NOVEDADES TECNOLÓGICAS QUE SE HAN INCORPORADO EN EL ENTE

PÚBLICO DE RADIOTELEVISIÓN DE LAS ILLES BALEARS (EPRTVIB). PARA ELLO, NOS HAN DESVELADO LOS DETALLES GABRIEL POL, JEFE DE SISTEMAS EN FUNCIONES, Y PABLO MARTÍNEZ, RESPONSABLE DE ESTUDIOS Y UNIDADES MÓVILES.

Entre este artículo y los anteriores acerca de las implementaciones de la temporada 2023-2024 en Canal Sur y Telemadrid, dibujamos en esta edición de RUBIK un retrato sobre las tendencias tecnológicas en las televisiones en España.

“El EPRTVIB que aglutina IB3 Televisión e IB3 Radio ha realizado importantes

transformaciones tecnológicas en los últimos años, como medio de comunicación público esencial, para continuar ofreciendo a la población de las Islas Baleares la mejor calidad de imagen y audio en un mercado broadcast en continuo cambio adaptándose al actual mercado tecnológico”, asegura Gabriel Pol

A nivel de medios audiovisuales en 2023 realizaron la transición definitiva de los

antiguos canales SD a HD potenciando la calidad de imagen y audio para el disfrute del espectador.

Para conseguir este estándar de calidad, durante 2023 finalizo la implementación del sistema de digitalización de contenidos y la renovación del MAM, actualizando el antiguo sistema de gestión Digition para TV y Mar4Suite para radio a un modelo

avanzado y personalizado sobre la plataforma Dalet. “Esta actualización se traduce en una eficiente gestión, edición y reproducción de contenidos centralizados tanto para los servicios de televisión como para los servicios de radio y servicios online”, indican los responsables técnicos de esta radiotelevisión.

Respecto a la renovación tecnológica en la sede central de Calviá, que contienen los estudios principales de producción, nos cuenta que se finalizó la unificación de estos con, entre otras cosas, sistema de captación de imagen Panasonic AK-UC4000, mesas de mezclas Maverik sobre main frame Kahuna 9600 y Kahuna 6400 y sistemas de monitorado multipantalla configurable MV-820”.

Asimismo, en esa sede de Calviá, se añadió un sistema de control de audio vía red Dante con mesas de sonido Yamaha CL5, RSio64-D y Rio3224-D, así como llevó a cabo la renovación de la mesa de sonido de la unidad móvil UM01 por una Yamaha QL5 Por último, se realizó la implementación de la red de audio Dante y la actualización del sistema de intercom a OMNEO de RTS para la unificación de los flujos de trabajo con el centro de producción de Calviá.

ACTUALIDAD ES LA INTELIGENCIA ARTIFICIAL. AUNQUE DESDE HACE AÑOS SE ESTABA UTILIZANDO, EN LOS ÚLTIMOS TIEMPOS HA EXPERIMENTADO UN CRECIMIENTO EXPONENCIAL Y ESTÁ PERMEANDO

EN TODOS LOS ÁMBITOS TECNOLÓGICOS. RTVE ESTÁ SIENDO PIONERA, ASÍ QUE

HEMOS ENTREVISTADO A PERE VILA,

Rubik: Entraste hace muchos años en RTVE, en la parte de Ingeniería como Director Técnico, pero ahora tu cargo es diferente, más enfocado a la innovación, ¿no?

Pere Vila: Yo creo que es un cambio natural, en el sentido de que ha habido muchos cambios en RTVE. En este período han pasado seis presidentes y yo también estoy más mayor, así que se ha ido ajustado. La parte de Ingeniería, y su día a día, la dejé en el año 2015.

En estos últimos seis años he estado más dedicado a introducir innovación dentro de la casa, como por ejemplo la Ultra Alta Definición (UHD). Nosotros empezamos las primeras emisiones en el 2014 y se ha logrado una transformación, hasta el punto de que España es pionera en este tema con los primeros canales en ultra alta definición. Es una cuestión que he llevado hasta hace un año. Al entrar en el Departamento de Producción y dejar de ser innovación, pasa a ser una cuestión de producción normal.

Luego empezamos también con el trabajo con el 5G. El 5G tiene muchos ángulos interesantes desde el punto de vista de producción. Hay un ángulo que es que las cámaras estén permanentemente conectadas y las conexiones que vienen de los equipos, que es lo que se llama slicing, y es la posibilidad de reservar capacidades en determinados sitios a determinadas horas.

Por ejemplo, si tú quieres hacer un directo desde la plaza de la Cibeles, reservas ancho de banda para salir de allí en alguna de las células que hay de 5G. Esto no ha tirado adelante porque las empresas de telefonía han ido desplegando el 5G en los móviles, pero todavía la infraestructura continúa siendo 4G para muchas partes y, por tanto, hay tecnologías como el slicing que no se han desarrollado.

Ha habido cuestiones de 5G en la emisión o en la producción en la cloud, pero es algo que vamos dejando al Departamento de Producción.

Desde el año 2018 abrimos el capítulo de la incorporación de herramientas de inteligencia artificial en diferentes fases de la producción audiovisual. Yo ahora estoy focalizado en esto.

Rubik: Centrándonos ya en la IA, estaríamos ante la tecnología más disruptiva de todas ellas, ¿verdad? ¿Cómo ha cambiado la inteligencia artificial, que era algo que ya existía en cierta manera, a esta nueva etapa tecnológica que está cambiándolo todo?

P. V.: Nosotros llevamos años utilizando IA para según qué procesos. Por ejemplo, tenemos un sistema relacionado con la accesibilidad que analiza los contenidos del canal 24 horas cada minuto para mirar si hay lengua de signos y hace un informe

mensual de las horas en lengua de signos que hay en el canal 24 horas. Tenemos sistemas de subtitulado que subtitulan automáticamente las desconexiones territoriales.

“La IA ha explotado. Lo que antes eran algunos nichos, ahora ya afecta prácticamente todas las áreas, siempre como soporte al trabajo. Sirven para que la gente pueda hacer su trabajo mejor y más rápido”

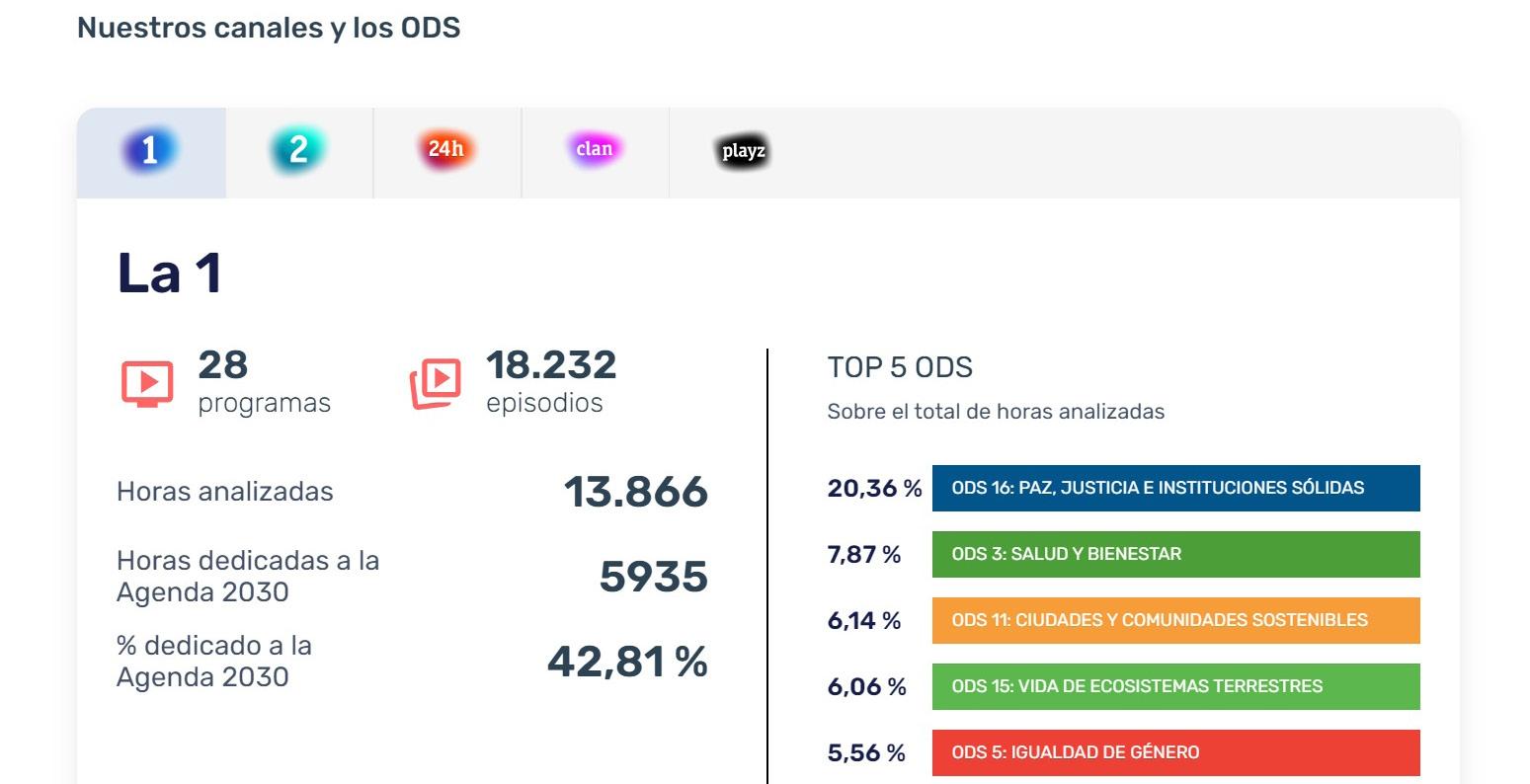

Tenemos también un sistema que analiza los fondos documentales para hacer un metadatado automático. Tenemos un sistema que analiza los contenidos que emitimos para mirar cuántos minutos de tiempo dedicamos a hablar de objetivos de desarrollo sostenible en los programas de actualidad. Tenemos proyectos de redacción automática de texto que hemos usado para las elecciones políticas. Poco a poco, lo hemos ido introduciendo.

Son proyectos pre ChatGPT pero en los últimos años esto ha explotado. Lo que

antes eran algunos nichos, ahora ya afecta prácticamente a toda la empresa y a todas las áreas. Son herramientas que vamos contextualizando, siempre como soporte al trabajo. Sirven para que la gente pueda hacer su trabajo mejor y más rápido, ya sean periodistas de producción, grafistas o gente vinculada a la administración. Están entrando en todas partes.

Empezamos con ello en 2015-2016 y luego un proceso nuevo en 2018 con la Universidad Autónoma de Barcelona. Ahora mismo, tenemos entre diez o doce proyectos relativos a IA funcionando dentro de la casa en diferentes estamentos. Ha sido tal la explosión, que se ha tenido que crear un comité de inteligencia artificial dentro de la casa para ver cómo se va introduciendo.

Rubik: La IA también desemboca en polémicas, aunque sobre todo la generativa que tiene que ver con derechos de autor. Pero en el caso de la producción también hay consideraciones laborales. El enfoque entiendo que no es que haya menos empleados, sino reducir tiempos y que los profesionales puedan hacer más cosas, ¿no?

P. V.: Más cosas o mejor. Por ejemplo, hay herramientas que dan soporte a la verificación de noticias. Te ayudan a que puedas monitorear determinadas redes sociales o que puedas verificar un audio, un video, la viralidad o un bot. Es un conjunto de herramientas que no sustituye al verificador de RTVE, sino que ahora tiene muchas más herramientas y, por tanto, más precisión en temas de gestión.

Otra cuestión que hacemos con IA es elaborar dossieres de prensa personalizados para periodistas. Si tú eres un periodista que estás interesado en, por ejemplo, problemáticas relacionadas con la mujer, pues indicas los medios de comunicación que quieres seguir, te hace un resumen de las piezas que han tocado esa cuestión. Así, ya tienes un briefing para ti, cada día por la mañana, antes de empezar. Son temas que facilitan el trabajo.

Rubik: En ese sentido, implementando la IA en todos los procesos, ¿qué cálculos hacéis en términos de eficiencia y reducción de tiempos?

P.V.: A lo bruto, si lo tuviéramos implantado en todos los procesos y se utilizan adecuadamente las herramientas,

probablemente podríamos disponer de un par de horas o una hora y media por persona al día. De promedio, porque en unos casos se ganará más y en otros menos.

Rubik: ¿En qué áreas de un broadcaster crees que puede ser más beneficiosa?

P. V.: En todas. Hay que plantearlo en el sentido de que tiene que entrar en todas las áreas, también en las áreas administrativas o de relación. En una empresa como esta es una locura la cantidad de reuniones que se hacen. Entonces, por ejemplo, si tú tienes una reunión en Teams, si la tienes en conjunción con el CoPilot, cuando acaba, te hace un resumen con los keypoints y luego te manda un correo con todo lo que se han hablado.

Para los grafistas también es interesante. Pueden tener herramientas que les ayudan a inspirarse, que les ayuden a producir contenidos y luego ellos los acaban de perfeccionar e integrarlos. Los periodistas, como decía antes, pueden tener briefings, herramientas de verificación, pueden tener disponer de más y mejor trabajo de la gente

que está en documentación, pueden tener herramientas para metadatado... Hay herramientas para resúmenes de los informes. La gente que hace informes relacionados con la audiencia puede tener también herramientas que vayan analizando qué es lo que se está viendo. Hay una herramienta que incluso ayuda a la gente que planifica los fastchannels. Es a todos los niveles.

Rubik: Has mencionado 10 o 12 proyectos con IA en los que estáis trabajando ¿Qué destacarías de ellos?

P. V.: Todos son referencia y algunos han recibido premios internacionales. Por ejemplo, los sistemas de subtitulado de los informativos en castellano y en bilingüe. Llevamos años trabajando en esto con los informativos desconectados. De otra manera, sería muy difícil. Tenemos el sistema de metadatos automático, estamos ayudando a introducir contenidos en el archivo. Este año hemos tratado cerca de 40.000 horas que se han podido introducir en un archivo que, de otra manera, no hubiéramos podido hacerlo.

Estamos analizando los programas de actualidad para ver la cantidad de minutos en los que se habla de los objetivos de desarrollo sostenible. Tenemos un sistema que hemos utilizado para hacer las elecciones municipales y generales, generando contenidos para las poblaciones de menos de 1.000 habitantes, para las áreas rurales, que es algo que no hace nadie.

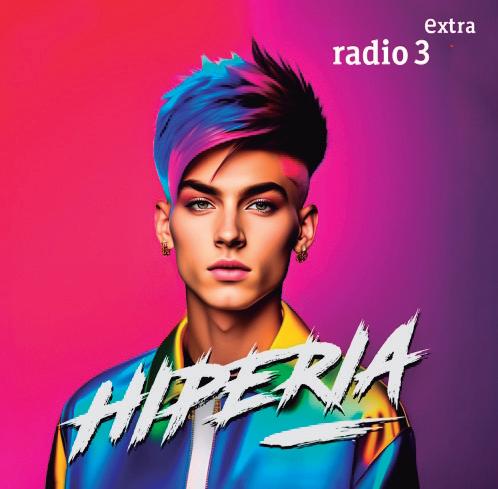

Tenemos una herramienta para verificación de contenidos que se llama IVERES, que está trabajando VerificaRTVE. Tenemos un avatar en Radio 3 (RNE) que se llama Hiperia, que es un experto para hablar de temas de tecnología en la música.

Como te decía antes, tenemos herramientas de ayuda a los periodistas para crear dossieres o crear resúmenes. También para generar voces. Creo que todos son interesantes. Muchos de ellos han estado premiados a nivel nacional e internacional. Por ejemplo, en el último IBC de Ámsterdam obtuvimos premio entre por la redacción, o sea, la preparación de los contenidos para las elecciones municipales, para las poblaciones