David Hedengren

ISBN 978-91-47-16003-7

© 2026 David Hedengren och Liber AB. Text- och datutvinning ej tillåten.

Förläggare: Andreas Persson

Redaktör: Anders Wigzell

Projektledare: Susanna Thulé

Produktionsspecialist: Maria Tholander

Formgivning, och omslag: Typoform

Faktagranskning: Sofia Thunberg, doktor, Institutionen för data- och informationsteknik, Chalmers tekniska högskola och Göteborgs universitet.

Första upplagan 1

Repro: Repro 8 AB, Stockholm Tryck: Livonia Print, Lettland 2025

Detta verk är skyddat av upphovsrättslagen. Kopiering, utöver lärares och elevers begränsade rätt att kopiera för undervisningsbruk enligt BONUS-avtal, är förbjuden. BONUS-avtal tecknas mellan upphovsrättsorganisationer och huvudman för utbildningsanordnare, t.ex. kommuner och universitet. Intrång i upphovsrättshavarens rättigheter enligt upphovsrättslagen kan medföra straff (böter eller fängelse), skadestånd och beslag/förstöring av olovligt framställt material. Såväl analog som digital kopiering regleras i BONUS-avtalet. Läs mer på www.bonuscopyright.se.

Liber AB, 113 98 Stockholm www.liber.se/kundservice www.liber.se

Foton: GettyImages omslag, 4-5, Shutterstock 16, 26, Visual China Group/ GettyImages 35, GettyImage 38-39, Shutterstock 40, 44, 51, 78-79, 100-101, 132-133, 135, Thaspol SangseeSid/Shutterstock 154, Shutterstock 158-159, 161, Yu Chun Christopher/Wong Shutterstock (1)168, The Washington Post/Gettyimages (2)168, Shutterstock 170, 174-175, 181, 186, paparazzza/ Shutterstock 194

Illustrationer: Typoform 11, 18-19, 46, 47, 48, 49, 52, 53, 54, 56, 57, 58, 60, 61, 63, 64, 65, 67, 68, 69, 70, 71, 72, 73, 74, 85, 86, 89, 90, 92, 98, 103, 104, 111, 113, 114, 115, 116, 117, 119, 120, 121, 122, 126, 127, 128, 129, 150, 169

KAPITEL 1

KAPITEL 5

KAPITEL 2

KAPITEL 6

Vad tänker du på när du hör begreppet artificiell intelligens, AI? Kanske dyker bilder av robotar och science fiction-filmer upp i ditt huvud. Eller så tänker du kanske på appar i din mobil som verkar förstå precis vad du vill göra, innan du ens hunnit tänka tanken själv. AI kan kännas både spännande och lite skrämmande, men tekniken finns redan här och påverkar dig varje dag.

AI avgör vad du ser i dina sociala medier, rekommenderar musik och hjälper till när du söker efter information. Men hur går det till egentligen? Hur kan ett datorprogram lära sig vad just du är intresserad av och varför verkar vissa AI-system nästan mänskliga?

I det här kapitlet får du en inblick i vad artificiell intelligens är, var tekniken kommer ifrån och varför det är viktigt att förstå hur den påverkar oss. Du kommer upptäcka varför AI har gått från att vara något bara forskare pratade om, till en teknik som formar hur vi lever, arbetar och interagerar med varandra varje dag.

Att lära sig mer om AI är viktigt. Det handlar om dig, om samhället du lever i och om hur framtiden kommer att se ut.

Genom att förstå AI kan du vara med och påverka hur den används. Du kan också se till att den används på ett sätt som är bra för dig, dina vänner och världen omkring dig.

Artificiell intelligens, är ett brett och komplext begrepp som handlar om att få datorer att bete sig ”intelligent”. Det innebär att datorer eller program utför uppgifter som traditionellt kräver mänsklig intelligens. Det kan exempelvis handla om att lösa problem, lära sig av erfarenheter, förstå språk, känna igen bilder eller fatta beslut.

Till skillnad från vanliga datorprogram, som följer förutbestämda instruktioner, bygger AI-system ofta på principen att de ska kunna anpassa sig till ny information. AI kan till exempel lära sig att känna igen ansikten, översätta text mellan språk och föra en konversation med en människa. Det fungerar utan att någon programmerat exakt hur det ska gå till i varje situation.

En vanlig definition av AI är att det handlar om datorprogram eller maskiner som kan utföra uppgifter som i vanliga fall kräver mänsklig intelligens, till exempel att planera, resonera, förstå sin omgivning eller kommunicera. Inom AI-forskningen talar man ofta om så kallade ”intelligenta agenter”, alltså system som kan observera sin omvärld, dra slutsatser och agera på ett sätt som leder mot ett visst mål på ett så effektivt sätt som möjligt.

Olika sätt att definiera AI

Eftersom intelligens är ett svårt och delvis subjektivt begrepp finns det flera sätt att definiera vad AI är. Här är några exempel:

Funktionell definition: AI är system som kan lösa uppgifter som normalt kräver mänsklig intelligens.

Målstyrd definition: AI består av intelligenta agenter som försöker uppnå mål genom att ta in information och fatta beslut.

Vetenskaplig definition: Vetenskapen och tekniken att skapa intelligenta maskiner. Denna definition togs fram av forskaren John McCarthy

Alla tre definitioner har gemensamt att AI försöker få maskiner att utföra uppgifter på ett sätt som efterliknar mänskligt tänkande eller handlande.

AI kan vara oerhört kraftfull och utföra uppgifter som vi annars förknippar med mänsklig problemlösning och analys. Men vad betyder egentligen intelligens? Och hur skiljer sig intelligensen hos en maskin från intelligensen hos en människa?

Intelligens beskrivs ofta som förmågan att lära sig nya saker, tänka abstrakt och logiskt, lösa problem och anpassa sig till nya situationer.

Ett av de mest kända sätten att mäta detta är IQ (intelligenskvot) som försöker mäta logiskt och analytiskt tänkande genom standardiserade tester. På senare tid har även begreppet EQ (emotionell intelligens) fått stor uppmärksamhet. EQ handlar om förmågan att förstå och hantera både sina egna och andras känslor, något som är avgörande i sociala sammanhang.

Den amerikanske psykologen Howard Gardner har i sin teori om multipla intelligenser argumenterat för att intelligens inte är en enda egenskap, utan flera olika förmågor som samarbetar med varandra.

En person kan till exempel vara särskilt stark i logiskt och matematiskt tänkande, medan en annan har stor språklig eller musikalisk begåvning. Andra former av intelligens som Gardner lyfter fram är visuell-spatial förmåga, social förståelse, självkännedom, kroppslig rörelseförmåga, naturintelligens samt ett mer existentiellt tänkande.

Det som alla dessa intelligenser har gemensamt är att de på olika sätt handlar om att ta in kunskap, förstå information, dra slutsatser och fatta beslut. Det ger en bredare och mer mänsklig bild av vad intelligens egentligen är. När vi pratar om artificiell intelligens handlar det däremot om intelligens hos maskiner. En AI kan vara duktig på vissa uppgifter, men det betyder inte att den är intelligent på samma sätt som en människa. Mänsklig intelligens inkluderar saker som medvetande, känslor, kreativitet och moral, egenskaper som dagens AI saknar.

För att förstå AI:s möjligheter och begränsningar behöver vi tydliggöra vad som skiljer människans sätt att tänka, känna och lära från maskinens.

En grundläggande skillnad handlar om bredd. Människor har det man kallar generell intelligens, vi kan lära oss nya saker, tänka kreativt, fatta beslut i nya situationer och hantera helt olika typer av uppgifter. En människa kan både spela schack, skriva poesi och laga middag och dessutom reflektera över varför någon annan känner sig ledsen. Dagens AI-system kallas ofta smal AI eftersom de nästan alltid är specialiserade. Ett schackprogram kan besegra världsmästaren i schack, men kan varken komponera musik eller föra en meningsfull vardagskonversation. De saknar alltså förmågan att förstå sammanhang utanför det område de tränats för.

Inom forskningen pratar man ofta om ett framtida mål som kallas artificiell generell intelligens, eller AGI. Det är en tänkt typ av AI som, precis som en människa, skulle kunna förstå och lösa olika sorters problem. Den skulle också kunna anpassa sig till nya situationer och till och med lära sig själv hur man löser nya uppgifter den aldrig stött på tidigare. En sådan maskin skulle inte bara kunna känna igen tumörer eller översätta språk, utan även förstå sammanhang, resonera om etik, och kanske föra en konversation om konst eller politik.

Med dagens språkmodeller som exempelvis ChatGPT kan det kanske verka som vi redan är på väg mot AGI. En språkmodell som kan formulera välstrukturerade argument, analysera litterära texter, lösa matematiska problem och diskutera etik kan ge intrycket av att den faktiskt ”förstår” vad den pratar om. Men det är viktigt att vara medveten om vad som gör ett resonemang genuint.

En språkmodell fungerar genom att analysera enorma mängder textdata och lära sig statistiska mönster i hur ord och meningar brukar

kombineras. När en användare ställer en fråga försöker modellen inte förstå den som en människa skulle göra. I stället förutspår den vilket svar som, utifrån träningen, är mest sannolikt att någon skulle ge i samma situation. Det betyder att även om språkmodellen kan ge korrekta, relevanta och väldigt imponerande svar, så saknar den medvetande, intention och inre upplevelse. Den har ingen uppfattning om vad rättvisa är, känner inget obehag inför orättvisor, och vet inte vad det innebär att vara människa. När den diskuterar etik gör den det genom att efterlikna hur människor har diskuterat etik – inte för att den själv har några moraliska övertygelser.

Så även om dagens språkmodeller suddar ut gränsen mellan mänskligt och maskinellt språk, är de inte riktigt i närheten av verklig AGI. En sådan intelligens skulle inte bara förstå språk, utan också världen omkring sig. Den skulle kunna sätta mål, fatta självständiga beslut och ta ansvar för sina handlingar. De flesta AI-forskare menar att vi fortfarande är långt ifrån att nå en sådan nivå av artificiell intelligens och många tror inte ens att det är möjligt.

En av de mest avgörande skillnaderna är att människor har medvetande. Vi har egna tankar, känslor och upplevelser. Vi kan känna sorg och glädje, uppleva kärlek, oro och empati och reflektera över våra handlingar.

AI-systemen bearbetar information, men de upplever inget. När en språkmodell uttrycker sympati eller resonerar kring moral är det inte för att den känner något eller förstår vad som är rätt eller fel. I stället bygger det på en avancerad form av efterlikning som grundar sig i hur människor brukar uttrycka sig i liknande sammanhang. Det är alltså stor skillnad mellan att kunna prata om känslor och att faktiskt känna dem.

AI-system är extremt snabba och exakta när det gäller matematiska beräkningar och hantering av stora datamängder. En dator kan utföra miljarder beräkningar per sekund och hantera datamängder som skulle ta en människa hela livet att bearbeta. Vi människor är däremot bättre på att tolka sammanhang, improvisera och hantera oväntade situationer där det inte finns tydliga regler.

Människor kan lära sig mycket från bara några få exempel och sedan använda den kunskapen i helt nya situationer. Vi kan till exempel se ett djur en gång och känna igen det, även i en annan miljö, eller snabbt fundera ut hur vi ska agera om det plötsligt står på vägen framför oss. AI behöver däremot ofta tusentals eller miljontals exempel för att lära sig samma sak och har svårt att hantera situationer som skiljer sig från den data den tränats på. Om en självkörande bil möter ett djur eller en situation som den inte tidigare har stött på, kan den få svårt att avgöra hur den ska agera och väljer därför att stanna tills hindret försvinner.

Utöver tankeförmåga har människor en kroppslig intelligens. Vi kan gå i trappor, vika tvätt, plocka upp ett glas utan att spilla och anpassa oss till ojämna underlag–uppgifter som kräver samspel mellan muskler, balanssinne och syn.

AI-drivna robotar har gjort stora framsteg, men även avancerade maskiner har svårt med sådant som kräver finmotorik och flexibilitet, som att knäppa en skjorta eller balansera på en vinglig stege. Att efterlikna den mänskliga kroppens smidighet och anpassningsförmåga på samma nivå som människor är fortfarande en av de största utmaningarna inom robotik.

En ofta återkommande reflektion om skillnaderna mellan människa och

AI är det som kallas Moravecs paradox. Den innebär att det som är lätt för människor är svårt för AI, och det som är svårt för människor är lätt för AI. Redan på 1980-talet uppmärksammade Hans Moravec och andra forskare att datorer kunde hantera avancerade intellektuella uppgifter ganska bra, som exempelvis att spela schack eller lösa komplexa ekvationer. Däremot visade det sig vara mycket svårt att lära en dator sådant som barn gör utan att tänka. Att hålla balansen, känna igen ansikten och tolka känslor är exempel på sådana uppgifter.

En förklaring till detta handlar om evolution. Evolutionen har under miljontals år finjusterat våra sinnen och vår motorik. Att kunna gå, tolka synintryck i tre dimensioner, läsa av ansiktsuttryck och förstå andras känslor är resultatet av en lång biologisk anpassning. De här förmågorna har blivit så naturliga att vi ofta inte tänker på hur komplexa de egentligen är.

För en dator är däremot en uppgift som att tolka en rörlig bild eller att inte snubbla på ett barns leksaker på golvet extremt komplex, eftersom den måste räkna ut allt från grunden i siffror och logik. Omvänt har vi människor relativt nyligen (i evolutionens tidsskala) uppfunnit matematik och logiska spel. Vi har därför inte lika specialiserade medfödda mekanismer för sådant. Därför är det inte förvånande att AI-system med stor beräkningskapacitet kan överträffa mänskliga spelare i strategiska spel.

Moravec illustrerade detta i det så kallade Moravecs landskap. Det kan beskrivas som att de uppgifter som är svårast för människor ligger i dalar som är lätta för AI att ta sig genom. Uppgifter som är enkla och naturliga för människor reser sig däremot som höga berg för AI. Liknelsen med landskapet visar att mänsklig och artificiell intelligens är byggda på olika grunder.

Det är intressant att utvecklingen av stora språkmodeller som ChatGPT till viss del utmanar Moravecs förutsägelse. Naturligt språk och vardagliga samtal ansågs länge vara något som bara människor kunde göra bra. Ändå finns det idag AI-system som kan prata om många olika ämnen, svara på frågor och förklara saker på ett sätt som kan kännas mänskligt.

Konst

Management

Investeringar

Bokskrivande Filmskapande

Social interaktion

Vetenskap AI-design Programmering

Bevisa satser

Verifiering av satser

Figur 1.1 Moravecs landskap

När vi ser hur skickliga dagens språkmodeller är på att skriva texter, översätta språk och svara på frågor kan det vara lätt att tro att datorer verkligen förstår språk precis som människor gör.

År 1980 formulerade den amerikanske filosofen John Searle ett berömt tankeexperiment som han kallade det kinesiska rummet

Syftet var att visa att även om en maskin kan bete sig som att den förstår ett språk, betyder det inte att den faktiskt förstår något.

Föreställ dig att du sitter i ett stängt rum. Utanför finns en person som bara pratar kinesiska. Hen skickar in lappar med kinesiska tecken under dörren. Du själv kan inte ett ord kinesiska, men du har en bok med regler som säger exempelvis: ”Om du får in detta tecken, skicka tillbaka detta tecken”. Genom att följa regelboken lyckas du svara så pass bra att personen utanför tror att du förstår kinesiska.

Men du förstår egentligen ingenting, du hanterar bara symboler enligt regler.

Searles poäng var att en dator, precis som personen i rummet, inte förstår meningar bara för att den bearbetar text enligt regler. Den saknar medvetande, tankar och förståelse. Den simulerar språkförståelse, men upplever den inte på riktigt.

1. Vad är skillnaden mellan smal och generell AI?

2. Vad säger Moravecs paradox om AI:s styrkor och svagheter?

3. Ge tre exempel på saker där människor fortfarande är bättre än AI.

4. Förklara tankeexperimentet det kinesiska rummet.

1. Kan du tänka dig några situationer där AI alltid kommer vara bättre än människor? Varför är det så?

2. Varför tror du att saker som känns lätta för oss människor, till exempel att känna igen ansikten, kan vara svåra för datorer?

3. Tror du att AI någonsin kommer kunna ha känslor?

4. Vad tror du skulle krävas för att en AI skulle bli ”medveten”? Hur skulle det påverka samhället?

5. Var går gränsen mellan att simulera intelligens och att verkligen vara intelligent, enligt dig?

6. Om en robot skulle klara alla tester vi människor kan komma på för intelligens – ska vi då betrakta den som intelligent på samma sätt som en människa? Var går gränsen, enligt dig, för att vi skulle kalla en maskin intelligent och inte bara ett väldigt avancerat verktyg?

Utvecklingen av AI tar sin början under 1950-talet och har gått i vågor. Ibland har det varit stora förväntningar, genombrott och framsteg.

Andra gånger har det varit besvikelse och tvivel och utvecklingen har nästan stannat av. Trots detta har forskningen hela tiden gått framåt, ofta i nya riktningar. Många av de idéer som en gång övergavs har senare återuppstått i modernare form. Det här avsnittet ger en översikt över några av de viktigaste milstolparna i AI:s historia, från de första tankarna om maskinintelligens till dagens avancerade språkmodeller och bildgenererande system. Genom att förstå historien kan vi också bättre förstå hur dagens AI fungerar och varför vissa frågor fortfarande är aktuella.

När datorerna utvecklades under 1940- och 50-talen började forskare fundera på om de inte bara kunde räkna utan kanske även resonera. Den brittiske matematikern Alan Turing skrev 1950 en artikel som hette ”Kan maskiner tänka?” där han föreslog ett test för att avgöra om en maskin kan uppfattas som intelligent. I det så kallade Turingtestet (eller the imitation game, som han själv kallade det) kommunicerar en människa med både en annan människa och en dator, utan att veta vem som är vem. Om en person inte kan avgöra vem som är människa och vem som är maskin i ett samtal, menade Turing att datorn kan sägas vara intelligent. Testet är dock omdiskuterat, bland annat eftersom det inte mäter intelligens i egentlig mening utan bara hur väl en maskin kan efterlikna mänsklig konversation. Trots det används Turingtestet fortfarande i vissa sammanhang, men ingen dator har ännu klarat det enligt de ursprungliga kriterierna.

Ett av de första AI-programmen var Logic Theorist, som utvecklades 1955. Det kunde bevisa matematiska satser inom logik, och anses vara det första riktiga AI-systemet. Logic Theorist visade att datorer inte bara kunde räkna, utan också kunde resonera i steg.

Året därpå, 1956, samlades en grupp forskare till en konferens på Dartmouth College i USA. Mötet kom att kallas Dartmouthkonferensen. Forskarna som ordnade konferensen menade att det borde vara möjligt att låta datorer efterlikna mänskligt tänkande. Det var under denna konferens som termen artificiell intelligens föreslogs, ett begrepp som sedan dess kommit att beskriva hela forskningsfältet.

Deltagarna på konferensen menade att intelligens i grunden handlar om att manipulera symboler, dra slutsatser och följa logiska regler. Om man kunde programmera datorer att tänka steg för steg skulle de kunna lösa problem som tidigare bara människor klarat av. Den här synen på intelligens – som något som kan beskrivas med logik och tydliga instruktioner – låg till grund för den tidiga AI-forskningen och påverkade hur området utvecklades under många år.

Under 1960- och 70-talen dominerades AI-forskningen av något som idag kallas symbolisk AI. Det innebär att man bygger datorprogram som använder symboler och tydliga regler för att resonera logiskt, dra slutsatser och lösa problem, ungefär som människor gör när de följer instruktioner eller regler. Under denna period utvecklades flera AI-program som kunde spela schack, föra enkla dialoger eller tolka logiska resonemang.

En viktig inriktning var utvecklingen av så kallade expertsystem. Ett expertsystem är ett datorprogram som försöker efterlikna hur en mänsklig expert resonerar inom ett visst ämnesområde, till exempel medicin och kemi. Dessa system bygger på att man i förväg matar in expertkunskap i form av regler, så kallad regelbaserad logik. Datorn kan sedan använda reglerna för att dra slutsatser i nya situationer, ungefär som en expert skulle ha gjort.

Ett annat uppmärksammat AI-program från denna tid var ELIZA, som räknas som den första chatboten. En chatbot, ibland kallad dialogrobot, är ett datorprogram som kan föra en konversation med en människa.

ELIZA var ett textbaserat program som simulerade en terapeut genom att omformulera användarens påståenden till frågor. Även om programmet saknade verklig förståelse skapade det en illusion av samtal.

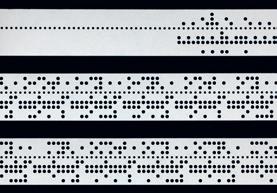

Vid sidan av utvecklingen av expertsystem utforskades även andra idéer inom AI. Exempelvis väckte modellen Perceptron, som presenterades 1958, stora förhoppningar. Den var inspirerad av hur nervceller i hjärnan fungerar och kunde lära sig att känna igen enkla mönster i data. De första experimenten gjordes med hålkort. Ett hålkort är ett styvt kort av kartong där information lagras som mönster av små hål. När ett kort matades in i datorn kunde maskinen läsa av hålens placering och tolka det som ett mönster, ungefär som en mycket enkel svartvit bild. Efter cirka 50 försök kunde perceptronen skilja mellan kort som var markerade till vänster och kort som var markerade till höger. Men Perceptron klarade bara enkla mönster där skillnaden var tydlig. Om

mönstren blev mer komplicerade fungerade modellen sämre. När det blev tydligt att modellen hade den här begränsningen, minskade intresset snabbt. Idén skulle dock komma tillbaka långt senare när tekniken utvecklats till det vi idag kallar neurala nätverk. Neurala nätverk är en central del i dagens AI. Hur de fungerar och varför de är så användbara förklaras i kapitel 3.

På bilden syns hålkort som användes i tidiga datorsystem för att mata in information. Perceptron-modellen tränades med hjälp av sådana kort för att känna igen enkla mönster.

Vid samma tid utvecklades också DENDRAL. Det var ett expertsystem för att analysera kemiska ämnens struktur. Programmet tolkade resultat från masspektrometri – en metod som visar vilka delar en molekyl består av – och föreslog hur molekylen kunde vara uppbyggd. Det var ett av de första tydliga exemplen på att AI kunde användas till något konkret och vetenskapligt. Det visade också att experters tysta kunskap, det vill säga kunskap som är svår att förklara i ord, kunde omvandlas till datorprogram.

Trots de tidiga framgångarna stötte AI-forskningen på betydande utmaningar under slutet av 1960-talet och 1970-talet, vilket ledde till en första så kallad AI-vinter. De symboliska metoderna, som länge dominerade AI-forskningen, fungerade bra i tydliga och välordnade miljöer. Men de hade svårt att hantera den komplexitet och osäkerhet som finns i verkliga situationer. Det visade sig vara mycket svårare än man först trodde att få systemen att förstå naturligt språk eller att anpassa sig till nya och oväntade händelser.

En viktig faktor under denna period var också den inflytelserika Lighthill-rapporten som publicerades i Storbritannien 1973. Rapporten kritiserade bristen på konkreta resultat inom AI-forskningen och ifrågasatte dess långsiktiga potential. Detta ledde till minskat statligt stöd för AI-projekt i Storbritannien och hade en negativ inverkan på forskningsklimatet globalt. Även om forskningen fortsatte skedde det i en betydligt långsammare takt och med mindre resurser.

Under 1980-talet upplevde AI en ny period av optimism och ökat intresse, framför allt drivet av framgångarna med expertsystem. Nu började expertsystemen att användas inom fler områden, som exempelvis juridik, teknik och ekonomi. Ett viktigt exempel var MYCIN, ett system som kunde ge förslag på antibiotikabehandlingar.

Expertsystemen visade sig däremot ha stora begränsningar. De var dyra att utveckla och krävde mycket underhåll. Det var också svårt att uppdatera dem när expertkunskapen förändrades och framför allt hade de svårt att hantera situationer som låg utanför deras strikt definierade regler. Förhoppningarna om att systemen skulle revolutionera industrier och skapa intelligenta assistenter infriades inte i den utsträckning man hade hoppats. När de kommersiella framgångarna uteblev och investeringarna inte gav den avkastning man hoppats på, minskade intresset för AI. Finansieringen drogs ner och en ny AI-vinter tog sin början och sträckte sig fram till 2010.

Även om intresset för AI minskade fanns det enstaka genombrott som visade att utvecklingen inte helt hade stannat av. År 1997 besegrade IBM:s system Deep Blue den regerande världsmästaren Garry Kasparov i schack. Det var en viktig milstolpe, inte bara för AI:s image i samhället, utan också som symbol för hur beräkning och strategi kunde kombineras. Deep Blue visade att AI kunde överträffa mänskliga experter i mycket strukturerade spelmiljöer där det går att beräkna stora mängder möjliga drag.

Efter framgången med Deep Blue ville IBM anta en ny utmaning och satsade på frågesporten Jeopardy. Resultatet blev systemet Watson, som hade tränats på omkring 200 miljoner sidor text, inklusive hela Wikipedia. Watson kunde analysera och tolka frågor ställda i naturligt språk och ge svar i realtid. År 2011 vann Watson över de bästa mänskliga mästarna i Jeopardy och tog hem en miljon dollar i prispengar. Vinsten väckte stor uppmärksamhet och blev ett exempel på hur AI kunde hantera språk och stora datamängder – även om tekniken bakom fortfarande byggde på äldre principer.

Figur 1.2

Tidslinje över

AI:s utveckling.

Det stora genombrottet för modern AI kom 2012 när ett system vid namn AlexNet vann bildigenkänningstävlingen ImageNet. AlexNet byggde på en teknik som kallas neurala nätverk, där datorn lär sig genom att steg för steg justera hur den tolkar olika mönster i data. Det innebär att den tränas att känna igen vad som kännetecknar till exempel en bil, en hund eller ett ansikte. Det fungerar inte genom fasta regler, utan genom att systemet själv upptäcker vad som skiljer olika saker åt genom att öva på tusentals exempel.

AlexNet använde en särskild typ av neuralt nätverk med många lager och tränades på enorma mängder bilddata med hjälp av kraftfulla grafikprocessorer (GPU:er). Det gjorde det möjligt att hantera och bearbeta stora datamängder mycket snabbt. Genom att kombinera mycket data, stor datorkraft och djupare nätverk visade AlexNet att det gick att skapa AI-system som kunde lösa uppgifter som tidigare hade verkat omöjliga. Denna metod kom att kallas djupinlärning och markerade starten på en ny era för AI.

Nästan två decennier efter Deep Blues seger i schack kom ett ännu mer uppmärksammat genombrott. År 2016 besegrade Googles program AlphaGo världsmästaren i brädspelet go. Det är ett spel som länge ansetts för svårt för datorer. Go har ett mycket större strategiskt djup än schack. Antalet positioner på spelbrädet uppskattas vara fler än antalet atomer i hela universum. AlphaGo kombinerade avancerade neurala nätverk med smarta sätt att utforska möjliga drag. Det visade att olika AI-tekniker kunde samarbeta för att lösa problem som tidigare ansetts vara omöjliga.

Symboliska Al-eran

Första Al-vintern (ca 1966-1980)

framgång

Efter genombrottet med AlexNet började neurala nätverk användas för allt mer komplex information, inte bara bilder. Ett viktigt område var naturlig språkbehandling (NLP), som handlar om hur datorer kan förstå, tolka och skapa mänskligt språk. Redan före djupinlärningseran hade AI gjort framsteg här. Exempel på detta är Google Translate som lanserades 2006 och kunde översätta mellan flera olika språk och röstassistenter som Siri (Apple, 2010), Alexa (Amazon, 2014) och Google Assistant (2016) som kombinerade taligenkänning med NLP för att förstå frågor och utföra uppgifter via röststyrning.

Med djupinlärning började forskare utveckla mer avancerade språkmodeller som kunde förstå både sammanhang och nyanser i text. Den första modellen i GPT-serien, GPT-1, lanserades 2018 och markerade starten för en ny generation av stora språkmodeller(LLM). Dessa modeller tränas på enorma textmängder och kan skapa sammanhängande, varierad och kreativ text – en typ av AI som kallas generativ AI, eftersom den inte bara analyserar tidigare information utan faktiskt skapar nytt innehåll.

Runt år 2020 tog utvecklingen fart på allvar och några av dagens mest kända LLMar som ChatGPT (OpenAI), Claude (Anthropic), Gemini (Google) och Copilot (Microsoft), kan idag skriva texter, föra samtal, svara på frågor, analysera dokument och till och med generera fungerande programmeringskod. Samtidigt har bildgenererande modeller som DALL-E och Midjourney lärt sig att skapa detaljerade och fotorealistiska bilder enbart utifrån textbeskrivningar. ChatGPT:sgenomslag

Deep Learning-eran

Andra Al-vintern (ca 1990-2010)

Artificiell intelligens, AI, finns i sociala medier, kartor, sökningar och översättningar. Den sorterar information, ger förslag och fattar beslut. Men hur fungerar tekniken – och vilka konsekvenser får den?

Den här boken ger en introduktion till AI ur både tekniskt och samhälleligt perspektiv. Du får förklaringar av centrala begrepp som algoritmer, maskininlärning, neurala nätverk, språkbehandling, bias, etik och lagstiftning. Genom exempel och diskussionsfrågor får du verktyg att förstå, analysera och granska AI kritiskt.

Boken täcker innehållet i gymnasiekursen Artificiell intelligens nivå 1. Den kräver inga förkunskaper i programmering och är skriven för gymnasieelever, men passar även andra som vill få en introduktion till AI.