4 minute read

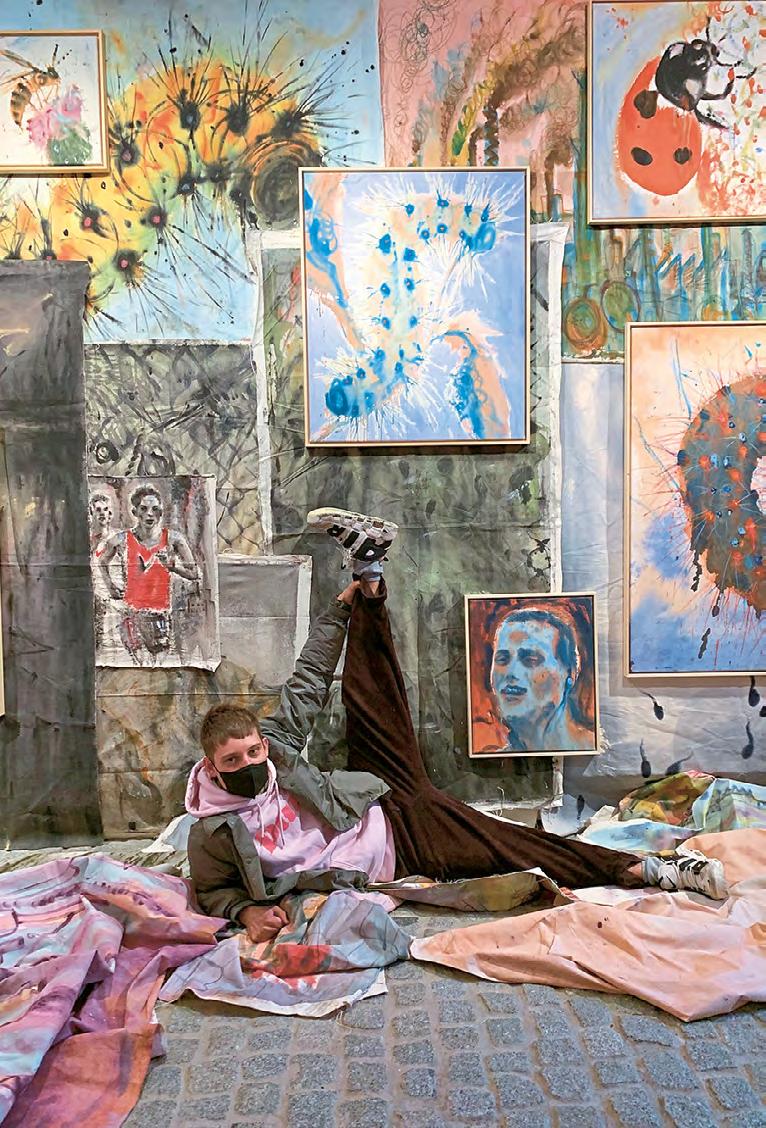

Kunst & Performance Rhein-Main 60

Advertisement

4

»Wir als demokratische Gesellschaft müssen entscheiden«

Wissen schafft in Darmstadt, Folge 8: das Forschungsprojekt „DeTox“ gegen Hate Speech im Netz, im Interview erklärt von Melanie Siegel (Professorin für Informationswissenschaft an der Hochschule Darmstadt)

INTERVIEW: PIT STEINERT | FOTO: NOUKI EHLERS, NOUKI.CO

Hass und Hetze im Internet erleben wir jeden Tag und oft kommen wir uns dabei hilflos vor. Wie uns die Wissenschaft gegen dieses Gefühl der Hilflosigkeit ganz konkret helfen kann, das erforscht Melanie Siegel. Sie ist Professorin für Informationswissenschaft an der Hochschule Darmstadt und leitet gemeinsam mit Professor Dirk Labudde vom Fraunhofer SIT das Forschungsprojekt „DeTox – Detektion von Toxizität und Aggressionen in Postings und Kommentaren im Netz“. Gemeinsam mit dem Hessischen Innenministerium will man mithilfe von Künstlicher Intelligenz in Zukunft „Hate Speech“ im Netz effektiver bekämpfen. Wie das gehen soll, erklärt Melanie Siegel uns im Interview.

Frau Siegel, was genau ist Hate Speech?

Unter Hate Speech verstehen wir auf der einen Seite so etwas wie gruppenbezogene Diskriminierung. Das können zum Beispiel sexistische oder antisemitische Beleidigungen sein oder solche aufgrund der Herkunft oder der sexuellen Orientierung. Auf der anderen Seite sind es eben Bedrohungen.

Das Forschungsprojekt „DeTox“ hat sich zum Ziel gemacht, Hass im Netz automatisiert zu identifizieren und zu bewerten. Was soll damit erreicht werden?

Es ist ein klares Anwendungsprojekt. Wir arbeiten dabei mit dem Hessischen Innenministerium zusammen, die eine Meldestelle für Hasskommentare haben. Allerdings gehen dort so viele Meldungen ein, dass sie es eigentlich gar nicht schaffen, alle schnell genug zu bearbeiten. Deswegen stellen wir ein Werkzeug zur Verfügung.

Und wie sieht das konkret aus?

Die Meldungen kommen meistens als Screenshots rein. Diese werden dann in Text umgewandelt, außerdem werden Metadaten bearbeitet. So muss sich also niemand hinsetzen und das alles händisch eintippen. Außerdem wird unser Tool auch eine Vorklassifizierung geben. Zum Beispiel erkennt es, welche Fälle dringender sind als andere und priorisiert diese dann. Oder aber es erkennt Gefahren, auf die man sofort reagieren muss. Zum Beispiel, wenn jemand schreiben würde, dass er gleich einen Anschlag verübt.

Und das entscheidet quasi eine Künstliche Intelligenz, die gelernt hat, dies zu erkennen?

[Lacht.] Ja, das stellt man sich immer so magisch vor. Um diese Methoden zu entwickeln, sammeln wir erst einmal ganz viele Texte zu ähnlichen Themen – in Hate Speech, aber auch in normaler Sprache. Diese werden dann anschließend von Hand klassifiziert und zwar nach verschiedenen Kriterien. Also nicht nur, ob es sich um Hate Speech handelt oder nicht, sondern eben auch, ob etwa eine akute Gefahr droht oder der Kommentar vielleicht strafrechtlich relevant ist und wenn ja, nach welchem Paragrafen. Bis Ende März hatten wir da sechs Studierende dransitzen, die 12.000 Texte von Hand bearbeitet haben. Jeder Text ist dabei von drei unterschiedlichen Personen klassifiziert worden. Wir messen auch regelmäßig, inwieweit die miteinander übereinstimmen. Einmal die Woche treffen sie sich und diskutieren zusammen die Kommentare, bei denen sie sich nicht einigen konnte, um langfristig eine bessere Übereinstimmung zu erhalten. So entsteht ein Datensatz mit hochwertig annotierten Daten, den wir eben brauchen, wenn wir maschinelles Lernen anwenden wollen. Das ist quasi die Haupt-KI-Methode: Wir trainieren Modelle, die dann wiederum in der Lage sind, neue Texte von alleine zu klassifizieren. Das Wichtigste dabei ist, dass man der Maschine eine große Menge an hochwertigen Daten zur Verfügung stellt. Erst dann kann sie das automatisch machen.

In welchem Stadium befindet sich das Projekt denn aktuell? Wird es schon angewendet?

Das Forschungsprojekt dauert noch bis Juni dieses Jahres. Dann wollen wir dem Hessen Cyber Competence Center (Hessen3C), der Meldestelle des Hessischen Innenministeriums, eine Software zur Verfügung stellen. Die Modelle haben wir bereits gebaut. Jetzt, wo alle Daten da sind, werden diese dann noch mal neu trainiert.

Wer ist alles an dem Projekt beteiligt?

Wir arbeiten mit dem Fraunhofer SIT zusammen, von dem neben einem Mitarbeiter auch Professor Dirk Labudde kommt, mit dem ich gemeinsam das Projekt leite. Von der Hochschule Darmstadt gibt es außerdem noch eine Doktorandin, einen weiteren Vollzeit-Mitarbeiter sowie neben den annotierenden Studierenden auch noch eine studentische Hilfskraft, die inhaltlich mitarbeitet.

Woher weiß die Maschine denn, dass es sich bei den Kommentaren nicht um einen Witz oder Ironie handelt? Oder Satire?

Satire ist natürlich ganz schwierig. Auf der anderen Seite gucken wir hier ja wirklich nach schlimmen Sachen. Also Antisemitismus ist auch nicht mehr lustig. Oder wirklich übel sexistische Beleidigungen – das verpackt vielleicht jemand als Witz, aber witzig ist das nicht.

Das zieht auch eine gewisse Verantwortung mit sich – wenn die Kommentare zum Beispiel strafrechtliche Relevanz haben.

Ja, natürlich. Zuerst einmal ist ganz klar, dass wir nicht automatisch Strafverfahren einleiten oder so etwas. Wir machen eine Vorklassifikation, damit das Hessische Innenministerium in seiner Arbeit unterstützt wird, damit sie also besser, schneller und effektiver arbeiten können. Jede Meldung, die da reinkommt, wird am Ende von einem Menschen angeschaut. Wir unterstützen diese Menschen dabei: Ein Werkzeug arbeitet 24/7, wenn man das möchte. Es macht keine Pausen, es wird nicht krank. Das heißt, gerade wenn es um ein Warnsystem geht, hieße das ja, dass man da einen Menschen ununterbrochen dransitzen haben müsste. So kann aber ein automatisches Werkzeug Alarm schlagen. Das ist ein erheblicher Vorteil. Und diese Daten und KI-Methoden, die wir entwickeln, diskutieren wir auch mit anderen Wissenschaftlerinnen und Wissenschaftlern. Wir nehmen an Programmierwettbewerben teil und tauschen uns mit anderen aus, mit welchen Methoden man >