Bibliogra fi

1. Wstęp do hakowania systemów uczących się

1.1. Wprowadzenie

1.2. Systemy ucz ą ce si

1.2.1. De finicja i rodzaje systemów ucz ących się

1.2.2. Zadanie klasy fikacji i uczenie nadzorowane

1.2.3. Ocena jakości klasy fikatora

1.2.4. Problemy budowania systemów ucz ą cych si ę

1.2.5. Potencjalne cele atakującego .

1.3. Taksonomia ataków na systemy ucz ące się

1.3.1. Kryteria jakości ochrony informacji

1.3.2. Atak na integralność systemów nadzorowanych

1.3.2.1. Formalizacja ataku na integralność

1.3.2.2. Atak na proces budowania systemu

1.3.2.3. Atak na funkcjonujący system

1.3.3. Atak na integralność innych rodzajów systemów ucz ących si ę

2. Przegląd reprezentatywnych ataków

2.1. Wprowadzenie .

2.2. Zagrożenia dla systemów uwierzytelniania

2.3. Zagrożenia w systemach autonomicznych

2.4. Zagrożenia w systemach medycznych

2.5. Wnioski ko ń cowe

3. Wymiar biznesowy ataków na systemy ucz ące się

3.1. Wprowadzenie

3.2. Robotyzacja i automatyzacja procesów biznesowych

3.2.1. Robotyzacja procesów

3.2.2 Sztuczna inteligencja w robotyzacji procesów

3.3. Ryzyko operacyjne w procesach biznesowych

3.3.1. Problematyka ryzyka .

3.3.2. Zarz ą dzanie ryzykiem

3.3.3. Ryzyko w RPA działających z wykorzystaniem systemów uczących się

3.4. Zagrożenia zwi ą zane z wykorzystaniem systemów ucz ą cych si ę w RPA

3.4.1. Wprowadzenie . . . . . . .

3.4.2. Geneza ataków na systemy ucz ące się

3.4.3. Przykłady realnych zagrożeń

3.4.3.1. Uwagi wstępne

3.4.3.2. Przykład ataku infekcyjnego . . . . . . .

3.4.3.3. Atak na automatyczny systemy w transakcji fi nansowych

3.4.3.4. Ataki na systemy rekomendacyjne

3.4.3.5. Inne zagrożenia

3.5. Zako ńczenie

Bibliogra fi a .

4. Studia przypadków

4.1. Atakowanie filtru antyspamowego wykorzystującego system ucz ą cy si ę

4.1.1. Charakterystyka problemu

4.1.1.1. Wprowadzenie

4.1.1.2. De fi nicja filtra antyspamowego

4.1.1.3. Problem filtrowania poczty elektronicznej w działalności biznesowej .

4.1.1.4. Przegląd bada ń naukowych

4.1.2. Opis eksperymentu .

4.1.2.1. Cel badania .

4.1.2.2. Dostępne dane empiryczne

4.1.2.3. Problem hakowania systemów ucz ących się

4.1.3. Wnioski i rekomendacje

Bibliogra fi a

4.2. Atak na system detekcji naduż yć w bankowości elektronicznej

4.2.1. Problem naduż yć w bankowości elektronicznej

4.2.1.1. Wprowadzenie

4.2.1.2. De finicja naduż ycia w transakcjach bankowych

4.2.1.3. Wykrywanie nadu ż yć i przeciwdzia łanie im

4.2.1.4. Standardowy system wykrywania i przeciwdziałania naduż yciom

4.2.2. Opis eksperymentu .

4.2.2.1. Cel badania

4.2.2.2. Dostępne dane empiryczne

4.2.2.3. Generatywne sieci współzawodniczące (GANs)

4.2.2.4. Scenariusze przebiegu ataku

4.2.3. Modele generatora i dyskryminatora

4.2.3.1. Budowa modeli

4.2.3.2. Ewaluacja modeli

4.2.4. Wnioski końcowe i rekomendacje

Bibliogra fi a

5. Bezpieczeństwo aplikacji systemów ucz ących się

5.1. Wprowadzenie

5.2. Wybrane problemy niezawodności oprogramowania

5.2.1. Problem z łożoności kodu

5.2.2. Przepełnienie bufora oraz odczyt poza nim

5.2.3. Dostęp po zwolnieniu pami ęci

5.2.4. Niew ła ściwa deserializacja i wstrzykiwanie danych

5.3. Ataki na środowiska programistyczne i sprzęt dla systemów uczących się

5.3.1. Atak na platformę programistyczną

5.3.2. Atak na sprzęt na przykładzie Deep Hammer

80

80

84

85

88

89

122

138

139

141

142

143

145

5.4. Ataki na biblioteki z wykorzystaniem automatycznych metod testowania oprogramowania

5.4.1. Wprowadzenie

5.4.2. Atak na bibliotekę OpenCV

5.4.3. Atak na bibliotekę dlib

5.4.4. Podsumowanie podatności znalezionych za pomoc ą automatycznych metod testowania oprogramowania

5.5. Wnioski i kierunki dalszego dzia

ania

Bibliogra fi a

Zako ń czenie

Bibliogra fia

potrzeby wyłudzenia mogą one zostać dalej przekazane organom nadzoru, co będzie skutkować konsekwencjami dla pacjenta w sferze społecznej, gdy zastosowane będą w systemach automatycznej autoryzacji.

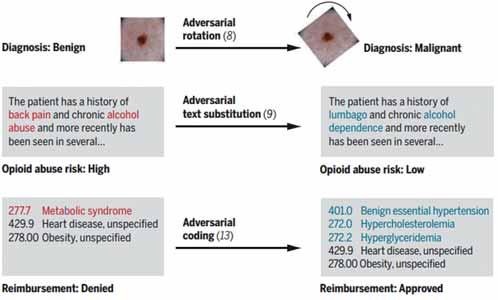

Diagnozy medyczne są często niejednoznaczne, co oznacza, że w wielu przypadkach rozstrzygane są na granicy prawa. Przypisanie do rekordu pacjenta informacji na temat jego zdrowia często zależy od sposobu leczenia oraz dostępu do danych usług czy leków. W USA poważnym problemem jest dostęp do substancji opioidowych, takich jak np.: kodeina, morfina i heroina. Na rysunku 2.15 przedstawiono zakłócające zmiany mające na celu wpływ na ostateczny przebieg leczenia. Na uwagę zasługuje również „gra słów”, wpływająca na określenie wskazania niskiego ryzyka zagrożenia wyłudzenia leków opioidowych.

Rysunek 2.15. Rodzaje ataków zak ócaj cych na rekord pacjenta ród o: Finlayson, S.G. i in. (2019). Adversarial attacks on medical machine learning. https:// science.sciencemag.org/content/363/6433/1287.full (dost p: 4.05.2020 r.).

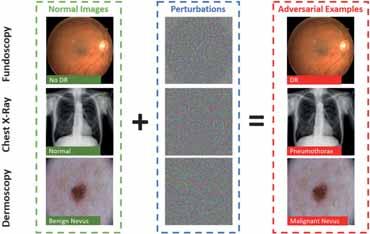

Systemy głębokiego uczenia się (ang deep learning) stały się popularne w przypadku medycznych analiz obrazu, takich jak diagnoza raka. Jednak ostatnie badania pokazują, że medyczne systemy głębokiego uczenia się mogą zostać oszukane przez starannie zaprojektowane ataki z niewielkimi niedostrzegalnymi zaburzeniami. Powoduje to obawy dotyczące bezpieczeństwa związanego z wdrażaniem tych systemów w warunkach klinicznych.

Na rysunku 2.16 przedstawiono modyfikację znamienia na skórze o łagodnym przebiegu w celu jego identyfikacji jako zmiany rakowej.

2. Przegląd reprezentaty wnych ataków

Rysunek 2.16. Zmiana wyniku klasy kacji przez dodanie szumu opracowanego antagonistycznym systemem ucz cym si ród o: Finlayson, S.G. i in. (2019). Adversarial attacks on medical machine learning. https:// science.sciencemag.org/content/363/6433/1287.full (dost p: 4.05.2020 r.).

Automatyczna diagnostyka może wskazać retinopatię cukrzycową, choroby płuc czy raka skóry przy rzeczywistym braku tych chorób, co istotnie wskazuje na podatność medycznych modeli opartych na głębokim uczeniu się na zakłócenia (rys. 2.17).

Rysunek 2.17. Zak ócenia wprowadzane do obrazów medycznych ród o: Ma, X. i in. (2020). Understanding Adversarial Attacks on Deep Learning Based Medical Image Analysis Systems, https://arXiv.org/pdf/1907.10456.pdf (dost p: 4.05.2020 r.).

Zagrożenia w systemach medycznych

ale także w atakach na systemy analizy sentymentu czy podczas oceny ryzyka kredytowego. Fikcyjne osobowości mogą zostać uwiarygodnione przez generowanie fikcyjnych działań czy przez publikowanie zdjęć, zawierających nieistniejące osoby (rys. 3.7). Podejście to, zwłaszcza połączone z atakiem typu shilling, jest szczególnie trudne do wykrycia (Bhaumik i in., 2006).

Rysunek 3.7. Sztucznie wygenerowane, kcyjne fotogra e ludzi, przy zastosowaniu techniki GAN. Utworzone w ten sposób dane s praktycznie nieodró nialne od rzeczywistych

ród o: https://thispersondoesnotexist.com/ (dost p: 27.05.2020 r.).

3.4.3.5. Inne zagro enia

Dotychczasowe klasyfikacje zagrożeń wynikających z antagonistycznego uczenia maszynowego opierają się głównie na dwóch kategoriach: na czasie, w którym atak został wykonany (infekcyjny, inwazyjny lub atak na klasyfikator), lub na poziomie wiedzy dostępnej dla atakującego (black box lub white box). Można także dokonać klasyfikacji wybranych zagrożeń na podstawie procesów biznesowych, będących celem, ataku lub według stosowanych w nich technikach AI (tab. 3.2).

3. Wymia r biznesow y ataków na systemy uczące się

Tabela 3.2. Zagro enia wynikaj ce z antagonistycznego uczenia maszynowego

Biznesowe zastosowanie AI

Identy kacja nadu y

Bezpiecze stwo danych

Zarz dzanie portfelem inwestycyjnym

Symulacje nansowe

Zarz dzanie ryzykiem kredytowym

Przyk ady zagro e

Manipulowanie danymi, aby ukry nielegaln dzia alno , zwi zan przyk adowo z nadu yciami nansowymi lub praniem brudnych pieni dzy. Generowanie próbek antagonistycznych s u y w tym przypadku dwóm celom: zast pieniu podejrzanej transakcji inn transakcj (wygenerowan sztucznie) lub obudowaniu nadu ycia innymi transakcjami (tak e sztucznymi), aby nadu ycie nie by o traktowane jak anomalia (Schreyer i in., 2019).

Ukrywanie faktu kradzie y danych z systemów informatycznych. Systemy identy kacji nadu y wykrywaj dzia ania pracowników, które odbiegaj od normy (np. uruchamianie kilkadziesi t razy tego samego raportu, zawieraj cego dane klientów, podczas gdy inni pracownicy uruchamiaj go rednio raz w tygodniu). Atak polega na przygotowaniu robota programowego, aby wykonywa on dzia ania symuluj ce pracownika, jednak prowadz ce do pozyskania jak najwi kszej ilo ci danych.

Wprowadzenie w b d systemów realizuj cych automatyczne transakcje nansowe, przez wykorzystanie luk w regu ach dzia ania tych systemów. Generowanie du ej liczby transakcji powoduj ce, e systemy zaczynaj je intepretowa wed ug zaimplementowanych regu , co mo e prowadzi do zmian w kursach akcji lub walut. Przyk adowo, w 2015 r. rosyjscy hakerzy dokonali ataku na sektor nansowy, wykorzystuj c t w a ciwo robotów. Hakerzy wykorzystali z o liwe oprogramowanie, aby na krótko zdestabilizowa kurs wymiany rubla do dolara (Hacker News, 2016).

Wprowadzenie fa szywych danych transakcyjnych do ucz cego zbioru danych, aby wprowadzi w b d systemy symulacyjne. Atakuj cy mo e w ten sposób wp yn na parametry opracowanego modelu symulacyjnego. Modele te s regularnie szkolone, aby uwzgl dni nowsze dane, co czyni je podatnymi na tego typu ataki (Cantos, 2019).

Wprowadzenie w b d systemu oceny ryzyka kredytowego, przez prezentowanie spreparowanych lub zmody kowanych danych. Taki system mo e b dnie oszacowa ryzyko kredytowe i sprawi , e bank podejmie niepo dane dzia ania i np. udzieli kredytu podmiotowi niewyp acalnemu.

ród o: opracowanie w asne.

3.4. Zagrożenia związane z w ykorzystaniem systemów uczących się w RPA

Jedna z sieci, generator (G), próbuje sprawić, żeby druga, dyskryminator (D), błędnie zaklasyfikowała syntetycznie wygenerowane dane jako prawdziwe. Na gruncie teorii gier można określić więc, że etap uczenia GANs polega na poszukiwaniu równowagi Nasha dla dwuosobowej gry ściśle konkurencyjnej (Nash, 1951; Salimans i in., 2016).

W pracy przyjęto następującą konwencję oznaczania zmiennych:

■ z – dane wygenerowane pseudolosowo z rozkładu normalnego;

■ x – dane pochodzące z rozkładu, którego imitowanie jest celem działania generatora, wymiar wektora x jest równy wymiarowi z;

■ G(z) – funkcja generatora przyjmująca z;

■ D(próbka rozkładu) – funkcja dyskryminatora przyjmująca x albo G(z).

Równanie 1 zostało zapisane na podstawie Goodfellow (2016):

min G max, D (1)(2)

([[)]] D log() D G vx x~pdanelog())) 1 z G(( D x~prozkładnormalny –

Generator jest graczem 1 próbującym imitować rozkład, z którego pochodzi x. Dyskryminator, gracz 2, ma za zadanie klasyfikację, czy dane mu przekazane są wynikiem funkcji G(z), czy pochodzą z rozkładu, którego reprezentantem jest x. Jego celem jest maksymalizacja równania 1. Natomiast generator dąży do jego minimalizacji (ponieważ chce maksymalizować D(G(z)), a więc pomyłki dyskryminatora) Składnik 1 równania 1 odnosi się do lepszego rozpoznawania przez dyskryminator danych prawdziwych, natomiast składnik 2 odwołuje się do umiejętności dyskryminatora do wykrywania danych wytworzonych przez generator.

Rysunek 4.20. Uproszczona wizualizacja dzia ania GAN

ród o: opracowanie w asne na podstawie Goodfellow, I. i in. (2014). Generative adversarial nets. w: Advances in neural information processing systems. Neural Information Processing Systems Conference, s. 2672–2680.

dyskryminator x

Czy dyskryminator miał rację?

wysyła x albo z aktualizacja wag z

generator

4. Stud ia przy pad ków

Rysunek 4.20 przedstawia schemat opisanej interakcji. Optymalną funkcję wypłat v można zbiorczo zapisać, na podstawie Goodfellow (2016), jako rozwiązanie równania:

min G max, D ( [[ ] ) G log() D D v x x~pdane , () GD v* min G max, D () GD v )].log()) 1 z G(( D z~prozkładnormalny –

Rysunek 4.21 przedstawia przebieg dostosowania się rozkładu danych wytwarzanych przez generator do szukanego rozkładu. GANs są trenowane przez równoczesne dostosowywanie rozkładu dyskryminującego (linia przerywana) dane pochodzące z prawdziwego rozkładu x (linia kropkowana) od danych wygenerowanych G(z) (linia ciągła). Pozioma linia bezpośrednio pod wykresem oznacza fragment dziedziny x. Natomiast poniżej niej oznaczono dziedzinę, z której próbkowane jest z (rozkład normalny). Strzałki pomiędzy liniami symb olizują, jak mapowanie x = G(z) w yk lucza rozkład normalny danych generowanych przez generator. G „ kurczy się” w obszarach wysokiej gęstości i „rozszerza” w tych o niskiej rozkładu pmodel(z). Fragment oznaczony literą a przedstawia sytuację, w której pmodel(z) jest już podobny do pdane(x), a D jest chociaż częściowo skutecznym klasyfikatorem Kolejny fragment rysunku (b) odnosi się do stanu, w którym we fragmencie D(x) zbiegł do D(x) Gradient D(x) ukierunkował G(z) na poprawę jakości generowanych danych, więc zwiększenie prawdopodobieństwa na ich błędną klasyfikację przez D (c). Celem jest wystąpienie sytuacji, w której pdane(x) = pmodel(z), czyli zarówno generator, jak i dyskryminator nie mogą się już poprawić. Dodatkowo, dyskryminator na tym etapie nie jest w stanie rozróżnić danych pochodzących z obu rozkładów, tj. D(x) = –1 2 (d).

Rysunek 4.21. Przebieg dostosowania do szukanego rozk adu przez GAN ród o: Goodfellow, I. i in. (2014). Generative adversarial nets. w: Advances in neural information processing systems, s. 2672–2680.

Rysunek 4.22 przedstawia uproszony algorytm działania GAN.

4.2. Atak na system detekcji nadużyć w bankowości elek tronicznej