b Megatrend Generative KI

b Nachhaltigkeit neu gedacht

b KI-Assistenten in Unternehmen

b Industrial Data Platforms

b Megatrend Generative KI

b Nachhaltigkeit neu gedacht

b KI-Assistenten in Unternehmen

b Industrial Data Platforms

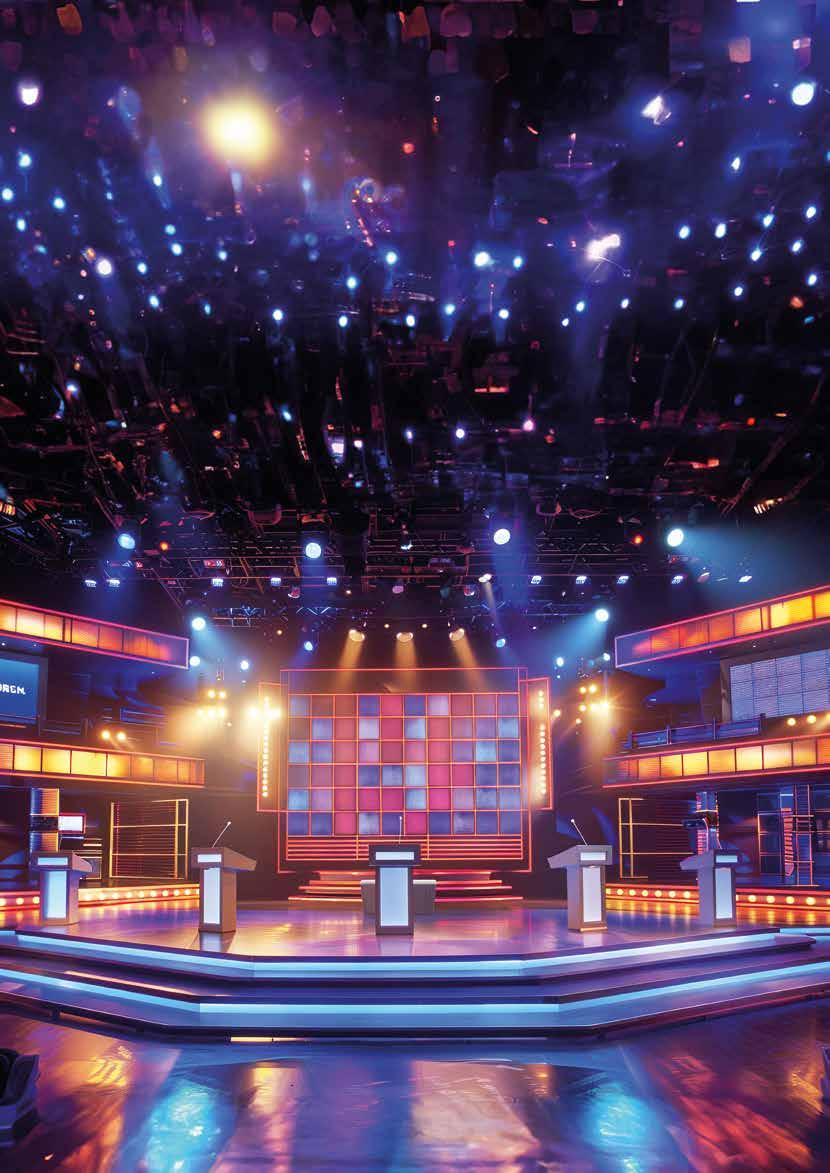

2011 besiegte der Supercomputer „Watson“ von IBM seine menschlichen Gegenspieler Ken Jennings und Brad Rutter im US-amerikanischen Spielshow-Klassiker Jeopardy! – eines der inzwischen zahlreichen Duelle zwischen Mensch und Künstlicher Intelligenz. Zu Beginn waren die Kandidaten noch gleichauf, doch am Ende siegte die Maschine. Wären wir heute Kandidaten bei Jeopardy! und stünde auf der Tafel: „Ich bin der Gamechanger der Geschäftswelt“, gäbe es nur eine passende Antwort: „Was ist Generative KI?“ In diesem Jahr widmet der AWS Channel Guide dem GenAI-Portfolio von Amazon Web Services besondere Aufmerksamkeit. Ebenso spannend wird es sein, zu beobachten, wie der Megatrend Generative Künstliche Intelligenz die Geschäftsmodelle der Zukunft prägen wird.

Nicht nur das AWS-Portfolio entwickelt sich rasant, auch der AWS-Channel passt sich an und wächst mit den Cloud-Angeboten mit. Klar ist: Generative KI hat die Bühne im Sturm erobert und wird nicht so schnell weichen. Cloud-Giganten wie AWS und ihr breites Partnernetzwerk tragen besondere Verantwortung für die Entwicklung und Verbreitung dieser Technologie. Zudem stellen sich neue Herausforderungen in Bereichen wie Cybersecurity, Datenmanagement und Nachhaltigkeit. Wie diese gemeinsam mit dem Hyperscaler gemeistert werden sollen, erfahren Sie auf den folgenden Seiten.

Ich wünsche Ihnen

alexander.siegert@vogel.de

Mit KI auf Wolke 7

Die Produktpalette von Amazon Web Services befindet sich in einem dynamischen Wandel. Da KI-Anwendungen zu großen Teilen in Zukunft über die Cloud bereitgestellt werden, verändert sich auch die Partnerlandschaft mit dem Megatrend, und wächst dabei. 6

Was ist eigentlich „Digitale Souveränität“?

Mit dem Digital Sovereignty Pledge verpflichtet sich

AWS zu Souveränitätskontrollen und -funktionen. 16

KI-Kompetenzen für den Arbeitsmarkt

AWS unterstützt mit Initiativen den Aufbau von KI-Kompetenzen. 38

Umsetzung einer Industrial Data Platform

Daten sind der Schlüsselfaktor für die Digitale Transformation und Industrie 4.0. 54

Die Zukunft mit Cloud und KI

Die Produktpalette von Amazon Web Services befindet sich in einem dynamischen Wandel.

6

Zum Business Case mit der Cloud 10

Niclas Otte von AWS berichtet über die KI-Strategie und die Möglichkeiten, mit der AWS-Cloud zu wachsen.

KI braucht leistungsfähige Infrastrukturen

Eine Studie zeigt, dass der Erfolg KI-basierter Geschäftsmodelle von leistungsfähigen Rechenzentren abhängt.

Was ist eigentlich „Digitale Souveränität“?

Mit dem AWS Digital Sovereignty Pledge verpflichtet sich AWS zu Souveränitätskontrollen und -funktionen.

Amazon Q: Der KI-Assistent für Unternehmen

Daten sind einer der Schlüsselfaktoren für die Digitale Transformation.

Generative KI als Werkzeug für Nachhaltigkeit

Der Ruf nach Lösungen für mehr Nachhaltigkeit wird immer lauter. KI und die Cloud können hier helfen.

Ethik trifft Innovation

Mit „Responsible AI“ integriert AWS verantwortungsvolle

KI-Praktiken in den Lebenszyklus von KI-Anwendungen.

Eine neue Ära der Datenintegration

In Zeiten ständig wachsender Datenmengen werden herkömmliche ETL-Pipelines zunehmend zum Bremsklotz.

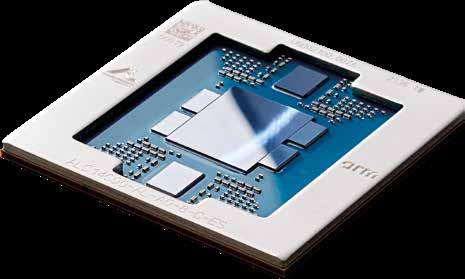

Eigene Prozessoren für KI und Infrastruktur

AWS ist nicht nur Kunde von Nvidia, AMD und Intel, die Cloud-Company entwickelt auch selbst Prozessoren.

KI-Kompetenzen für den Arbeitsmarkt

KI-Expertise gewinnt für die Karriereentwicklung und das Gehaltsniveau rasant an Bedeutung.

Neue Features für den AWS Marketplace

Mit dem Marketplace hat AWS einen effizienten Marktplatz geschaffen.

VDI in der Cloud mit Thin Client

Die Amazon WorkSpaces sind verwaltete virtuelle Desktops, für ein leichteres Leben von IT-Admins.

Mit dem richtigen LLM zum KI-Erfolg

Large Language Models und eine Datenstrategie sind entscheidende Faktoren, um KI erfolgreich einzusetzen.

14

16

22

24

26

30

34

38

42

46

50

Umsetzung einer Industrial Data Platform 54

Daten sind der Schlüsselfaktor für die Digitale Transformation und Industrie 4.0

Dennis Vogel, Director Partner Sales Cloud & GSI bei NetApp, erläutert im Interview mit dem AWS Channel Guide, wie NetApp gemeinsam mit AWS und dem Channel GenAI-Innovationen vorantreibt und wie sich Datenherausforderungen in AI-Projekten erfolgreich meistern lassen.

Bei der Beratung und dem Vertrieb von Cloud-Lösungen setzt NetApp auf die Power of Three. Wie sieht dieser gemeinschaftliche Ansatz von NetApp, AWS und dem Channel in der Praxis aus?

Dennis Vogel: Partner stehen bei NetApp in Deutschland seit über 25 Jahren im Mittelpunkt der Vertriebsstrategie. Dieser Strategie bleiben wir auch im Cloud-Geschäft treu. Mit AWS arbeiten wir nicht nur bei der Technologieintegration eng zusammen, sondern auch bei der Betreuung unserer gemeinsamen Partner. Dadurch ist mittlerweile ein PartnerEcosystem entstanden, in dem Partner ihre jeweiligen Stärken einbringen können. Die „Power of Three“ als gemeinschaftlicher Vertriebsansatz von AWS, NetApp und dem Channel entsteht durch die Kombination aus den AWS Cloud Services, den Public Cloud Services von NetApp und den individuellen Kompetenzen der einzelnen Partner. Dadurch können wir unseren Kunden gemeinsam optimierte maßgeschneiderte Cloud-Lösungen anbieten. Es gibt viele wertbringende Use Cases für Kunden, die wir in dieser bewährten Dreierkonstellation am besten adressieren können. Das können etwa Datenbank-, VMware- oder SAP HANA-Lösungen, Kubernetes- oder KI-Plattformen, Multi-/Hybrid-CloudLösungen oder Migrationen sein.

Das Thema Generative AI gewinnt rasant an Bedeutung. Um welche Mehrwerte kann NetApp die AWS-Angebote für GenAI ergänzen?

D. Vogel: Daten sind die Grundlage von AI – und Daten liegen seit über 32 Jahren erfolgreich im Fokus von NetApp: Wie kann man Daten effizient und sicher speichern, managen, schützen, optimieren und transportieren? Kunden können AI nur dann gewinnbringend einsetzen und einen signifikanten Wettbewerbsvorteil generieren, wenn sie ihre eigenen, spezifischen Unternehmensdaten integrieren. Diese Daten liegen aber noch immer nahezu vollständig On-Premises und sind damit nicht zugänglich für AI-Anwendungen in der Cloud. Gleichzeitig starten

über 90% der GenAI-Projekte in der Cloud. An dieser Stelle kann NetApp seine klassischen Mehrwerte wie effizientes Datenmanagement und Datentransport einbringen und mit Hilfe einer intelligenten Dateninfrastruktur die notwendige Brücke zwischen On-Premises und der Cloud bauen. Wenn es darum geht, On-Premises-Daten für AI-Anwendungen nutzbar zu machen, ist der auf NetApp-Technologie basierende AWS-Service „Amazon FSx for NetApp ONTAP“ (kurz FSx for ONTAP) der Service der Wahl. FSx for ONTAP gewährleistet genau diesen schnellen und sicheren Datentransfer zwischen On-Premises Data Sets und der Cloud. Auch das Thema Sicherheit, das in diesem Umfeld für viele Kunden besonders relevant ist, können wir mit vielfältigen Mehrwerten adressieren. Zudem liegt ein großer Anteil der weltweiten unstrukturierten Daten auf NetApp-Speichersystemen – und diese Daten können wir mit FSx for ONTAP einfach und sicher für AWS GenAI-Services wie Amazon Bedrock zugänglich machen. Wenn die Daten bereits bei AWS liegen, ist FSx for ONTAP ebenfalls der passende Service für die AI-Journey unserer Kunden. Durch klassische NetApp-Mehrwerte wie Snapshots und Storage Efficiencies helfen wir den Kunden dabei, ihre Data Sets zu versionieren und die Datenmenge signifikant zu reduzieren.

GenAI bietet auch für den Channel enorme Umsatzchancen. Wie kann ein NetApp-/ AWS-Partner seine Kunden dabei unterstützen, die Datenherausforderungen in einem AI-Projekt zu meistern?

D. Vogel: Die Integration der spezifischen Daten ist der Schlüssel zu einem erfolgreichen GenAI-Projekt. Auch für einen Partner ist es eine Herausforderung, wenn in einem AIProjekt diese wichtigen Daten nur On-Premises verfügbar sind. Deswegen haben wir in enger Zusammenarbeit mit AWS die „NetApp BlueXP Workload Factory“ entwickelt. Dieser Service nutzt FSx for ONTAP als zugrunde liegenden Datenspeicher und ermöglicht es, die unterschiedlichsten Application Stacks optimal und kosteneffizient zu deployen

und stellt damit eine komplette Umgebung schlüsselfertig zur Verfügung. Durch die nahtlose Integration von On-Premises-Daten in die Cloud-basierten Workloads lassen sich alle Unternehmensdaten effektiv in AI-Projekte einbinden. Partner können ihre Kunden auf diese Weise dabei unterstützen, das volle Potenzial ihrer Daten für AI-Anwendungen zu nutzen und sofort mit GenAI-Projekten zu starten. Somit können die Partner mit der kostenfreien NetApp BlueXP Workload Factory konkrete GenAI POCs bei den Kunden in kürzester Zeit realisieren und die Mehrwerte von GenAI unter Beweis stellen. Wir haben bereits viele Partner mit dem Tool vertraut gemacht und deren Reaktionen sind durchweg positiv.

Welche Mehrwerte können Partner als Mitglied der Power of Three in gemeinsame GenAI-Projekte mit AWS und NetApp einbringen?

D. Vogel: GenAI-Projekte sind sehr beratungsintensiv und das KnowHow der Partner ist essentiell für die erfolgreiche Realisierung dieser Projekte. Partner haben viele Möglichkeiten, durch kundenindividuelle Services und Consulting AI-Lösungen für die spezifischen Kundenanforderungen zu entwickeln. Mit der neuen AWS-Spezialisierung „Generative AI Services Competency” können sich Partner mit hoher AI-Expertise und nachgewiesener Kundenerfahrung als AI-Spezialisten im Markt positionieren. Indem Partner die Cloud Services von AWS und die Speicher- und Datenmanagement-Lösungen von NetApp um eigene Leistungen wie Beratung, Integration und Support ergänzen, entstehen maßgeschneiderte Partner-Offerings, die konkrete Kundenprobleme adressieren. Im Rahmen der Power of Three haben wir dies bereits erfolgreich mit Partnern umgesetzt. Weitere Informationen unter:

Die Produktpalette von Amazon Web Services befindet sich in einem dynamischen Wandel. Da KI-Anwendungen zu großen Teilen in Zukunft über die Cloud bereitgestellt werden, wächst und verändert sich auch die Partnerlandschaft mit dem Megatrend.

Während sich GenAI nach und nach in den Unternehmen etabliert, wächst das Ökosystem von Amazon Web Services beständig weiter. Der Hyperscaler hilft Unternehmen dabei, sich komplett neu für die Cloud aufzustellen oder aus langjährigen Geschäftsbeziehungen zwischen Partnern die nächsten Schritte bei der Digitalisierung zu gehen. Unverzichtbar für AWS bleibt das AWS Partner Network. Mit seiner Hilfe sollen sowohl die Innovationen in der Cloud geboren, als auch bestehende Prozesse optimiert werden. Das AWSPortfolio wurde durch den Megatrend KI kräftig

aufgewirbelt und gerade im Umfeld der Generativen KI ist eine spannende Dynamik zu beobachten. Mit der Ausweitung des Portfolios ging auch eine Expansion der Geschäftsfelder und eine Internationalisierung des AWS-Channels einher. Die Partnerlandschaft wird breiter und spezialisierter.

Doch Künstliche Intelligenz verändert nicht nur die Technologiebranche, sondern auch zahlreiche Geschäftsmodelle. Die Nachfrage nach KI-Lösungen wächst beständig und „der Erfolg KI-basierter

Geschäftsmodelle hängt von der Verfügbarkeit und Leistungsfähigkeit der Rechenzentrums- und insbesondere der CloudInfrastruktur ab“, wie Carsten Kestermann, Director Public Policy DACH bei AWS, weiß. Unternehmen haben mit AWS Zugang zu einem umfassenden Set an Werkzeugen, das von der Entwicklung eigener KI-Modelle über die Nutzung anpassbarer Sprachmodelle bis hin zur schnellen und sicheren Datenverarbeitung reicht. Cloudbasierte KI ist Realität und bringt Unternehmen weltweit Innovationsvorsprung. Der AWS-Channel hat hierbei auch ein besonderes Auge auf den Mittelstand geworfen, der hierzulande als Rückgrat der deutschen Wirtschaft gilt und nach Digitalisierungspartnern ruft. Eine tolle Gelegenheit für Systemhäuser und etablierte Partner, die sich nun verstärkt KMU zuwenden.

Die Wahl eines geeigneten LLM (Large Language Model) ist entscheidend für den Erfolg von KI-Anwendungen. Unternehmen setzen LLMs für Anwendungsbereiche wie Textgenerierung, Codeerstellung oder personalisierte Kundeninteraktionen ein. AWS bietet mit Amazon Bedrock und Amazon SageMaker Plattformen, auf der Unternehmen das für ihre Zwecke passende LLM auswählen und anpassen können. Gleichzeitig betont AWS, dass eine fundierte Datenstrategie essenziell ist, um präzise Ergebnisse aus den Modellen zu erhalten. Die Auswahl an LLMs wird kontinuierlich erweitert und spezialisierte Modelle sind zunehmend gefragt: Gartner prognostiziert, dass bis 2027 mehr als 50 Prozent der eingesetzten Modelle branchenspezifisch sein werden. Und doch „stehen wir erst am Anfang, diese Technologie voll auszuschöpfen, und sie entwickelt sich kontinuierlich weiter. Wir unterstützen unsere Partner sowohl mit Self-Service-Möglichkeiten als auch durch Dialog, enge Zusammenarbeit und gemeinsame Projekte, um Use Cases in erfolgreiche Business Cases zu verwandeln“, gibt Deutschland-Channelchef Niclas Otte die Maßgabe von AWS vor (S. 10).

Mit wachsender Verbreitung und Leistungsfähigkeit von KI-Technologien steigen auch die Anforderungen an deren

ethische Nutzung und die Frage: Was ist eigentlich Digitale Souveränität? Mit einer geplanten Investition von 7,8 Milliarden Euro in die neue AWS European Sovereign Cloud in Brandenburg zeigt AWS, dass man es mit dem Thema ernst meint. Die Investition soll das europäische Bedürfnis nach digitaler Souveränität adressieren (S. 16). Vertrauen gleichermaßen zu fördern und Risiken wie Fehlinformationen oder Datenschutzverletzungen zu minimieren, wird eine Aufgabe sein, an der sich der Hyperscaler zukünftig messen lassen muss. Gleiches gilt für das Thema Nachhaltigkeit (S. 24).

Auch wenn zukünftig viele Prozesse durch KI vereinfacht werden, bleibt aufgrund des anhaltenden Fachkräftemangels weiterhin Personal gefragt. Dieses sollte idealerweise über umfangreiche Kompetenzen in Cloud und KI verfügen. AWS hatte sich das Ziel gesetzt, bis 2025 insgesamt 29 Millionen Lernende mit entsprechenden Angeboten zu erreichen – ein Ziel, das nun vorzeitig erreicht wurde. Lernende aus über 200 Ländern haben bereits an AWS-Trainings teilgenommen, die weiter ausgebaut werden sollen. Zusätzlich wurde der AWS Skill Builder, der mittlerweile über 600 Kurse umfasst, entwickelt. AWS kombiniert digitale Selbstlernangebote mit interaktiven, Spiel-basierten Methoden. Ziel sei es, die Ausbildung in Cloud und KI zu fördern und so die Chancen auf höhere Gehälter und bessere Beschäftigungsmöglichkeiten zu erhöhen (S. 38).

AWS und das Partnernetzwerk stehen also vor einem Kraftakt: Die Cloud soll nicht nur mehr leisten, sondern auch verantwortungsbewusster werden. Gemeinsam mit seiner gut verdrahteten Partner-Community will man die Stellung als Business-Enabler behaupten und gleichzeitig als Motor für Innovation agieren. Während die temporeiche KI-Revolution mit ihrer Fülle an Use Cases voranschreitet, kann die Devise nur lauten: The sky's the limit.

Cloud-Security findet häufig noch immer von der restlichen Cybersecurity isoliert statt. Das stellt jedoch ein Risiko dar, da Cyberangriffe nicht auf die Cloud beschränkt sind. Unternehmen setzen daher zunehmend auf ganzheitliche Cybersecurity-Plattformen, die auch die Cloud umfassen, um die gesamte Angriffsoberfläche abzudecken. Dies bietet neue Geschäftspotentiale für Partner, die neben Sicherheitstechnologie auch ergänzende Services anbieten. Auch auf Cloud-Services spezialisierte Partner sollten ihre Angebote um Security erweitern und auf den richtigen Technologieanbieter setzen. Trend Micro konsolidiert sein Cloud-Security-Angebot in der KI-gestützten Cybersecurity-Plattform Trend Vision OneTM, die zentrale Sichtbarkeit, proaktives Risikomanagement sowie schnelle Erkennung und Reaktion auf Angriffe ermöglicht –in der Cloud und darüber hinaus.

Umfassende Sicherheit für die Cloud

Trend Vision OneTM - Cloud Security bietet alle Funktionen, die Partner benötigen, um die Cloud-Infrastrukturen und -Workloads ihrer Kunden umfassend abzusichern. Dazu zählen unter anderem:

• Attack Surface Risk Management for Cloud (ASRM for Cloud) ermöglicht eine kontinuierliche Erkennung der Angriffsflächen von Workloads, Containern, APIs und Cloud-Ressourcen. Deren Risiken werden in Echtzeit bewertet und priorisiert.

Cloud Security Posture Management (CSPM) überprüft mehr als 900 AWS-Regeln, um Cloud-Fehlkonfigurationen zu erkennen und die Ergebnisse mit Dutzenden von Best-Practice- und Compliance-Frameworks abzugleichen.

Cloud Infrastructure Entitlement Management (CIEM) überwacht Anwender, Identitäten und Zugriffsberechtigungen in Hybrid- und Multi-Cloud-Umgebungen, um unbefugte Zugriffe und Datenlecks zu verhindern.

• Mit Internet Facing Attack Surface Management sehen Sicherheitsverantwortliche über den Tellerrand der internen Umgebung hinaus und behalten auch den Sicherheitsstatus von externen Assets im Blick.

• Die Cloud-Native Application Protection Platform (CNAPP) bietet vollständige Transparenz und Kontrolle über die Sicherheit von Cloud-Anwendungen. Indem sie Informationen aus Artefakt-Scans, Laufzeitüberwachung, Cloud-Konfigurationsprüfungen und mehr korreliert, bildet sie ein Gesamtbild der Sicherheitslage ab.

• Das Schwachstellen-Management ermöglicht es, nötige Sicherheitsmaßnahmen zu priorisieren. Es bietet eine Übersicht über ausnutzbare CVEs, die Mean Time to Patch und weitere Parameter. Virtual Patching schützt Kunden zudem durchschnittlich bereits 96 Tage vor der Ausnutzung von Schwachstellen, bevor ein Anbieter einen Patch veröffentlicht.

Die marktführende Cloud Workload Protection Platform (CWPP) wurde speziell für Server- und Cloud-Workloads entwickelt. Dank der integrierten Advanced Threat Protection, Detection and Response sowie Threat Intelligence lassen sich IT- und Sicherheitsabläufe rationalisieren. So wird die Komplexität reduziert und optimale Sicherheitsergebnisse für Cloud-, On-Premises- und hybride Umgebungen erzielt.

• Mit File Security können Dateien jeder Art und Größe in allen File-Storage-Services auf Malware gescannt werden.

• Container Security verbindet Image-Scanning, Zugangskontrolle und Laufzeit-Schutz, um den gesamten Container-Lebenszyklus abzudecken.

Cloud Detection & Response (CDR) / Extended Detection & Response (XDR) nutzt über 700 Erkennungsmodelle und globale Bedrohungsinformationen, um Bedrohungssignale zu korrelieren, zu priorisieren und die Reaktion in der gesamten Umgebung zu automatisieren. Die Integration in AWS CloudTrail-Logs sorgt für ausführliche Erkenntnisse zu allen Anwender-, Service- und Ressourcenaktivitäten.

• Threat Intelligence: Dank der tiefen Verankerung in der Plattform können SOC-Analysten beobachtete TTPs von Angreifern dem MITRE ATT&CK-Framework zuordnen.

Der Companion KI-Assistent basiert auf GenAI. So können sich auch weniger erfahrene SOC-Analysten schnell in der Plattform zurechtfinden.

Plattformvorteil

Alle Telemetriedaten aus der Cloud werden in der Trend Vision One-Plattform mit Informationen aus Netzwerken, Servern, Endpunkten, E-Mails und Identitäten korreliert. Diese Integration ermöglicht umfassende Sichtbarkeit, auch in komplexen IT-Architekturen. Davon profitieren Security-Dienstleister, die ihre Kunden so noch effektiver schützen können.

Trend Vision One nutzt die XDR-Technologie, um die Korrelation von Daten automatisch zu automatisieren. Dadurch können SOC-Teams Bedrohungen schneller erkennen und darauf reagieren, ohne wertvolle Zeit mit manuellem Zusammenführen von Daten aus verschiedenen Produkten zu verschwenden. Darüber hinaus ermöglicht die Plattform mit ASRM kontinuierliche und kontextbezogene Risikobewertungen. Anhand von Faktoren wie der Wahrscheinlichkeit eines Angriffs, der möglichen Auswirkungen eines Ausfalls und der Kritikalität von Assets können Risiken priorisiert und proaktiv mitigiert werden.

Trend Vision One vereint verschiedene Tools in einer zentralen Plattform, um Silos abzubauen und die Zusammenarbeit von Teams zu verbessern. Die intuitive Oberfläche bietet anpassbare Dashboards und konsistente Richtlinien und Sicherheitsmaßnahmen, unabhängig davon, wo die Workloads ausgeführt werden.

Dabei profitieren Partner und Kunden von jahrelanger, tiefgehender Expertise: Trend Micro wird von IDC schon das sechste Jahr in Folge als weltweit marktführender Anbieter* von Cloud-Native Application Protection Platforms geführt. Die Lösungen sind für AWS-Umgebungen optimiert und Trend zählt mit zahlreichen Auszeichnungen und Kompetenzen zu den führenden Sicherheitsanbietern für die AWS-Cloud.

Weitere Informationen:

Eure Ansprechpartner:

Nicholas Pook

Head of Parter Management & Alliances, Trend Micro, DACH nicholas_pook@trendmicro.com +49 151 40455044

Thino Ullmann Senior Partner Development Manager, Trend Micro, DACH thino_ullmann@trendmicro.com +49 151 5 12 81 691

Das Portfolio von AWS befindet sich in einem dynamischen Wandel. Da KIAnwendungen zu großen Teilen in Zukunft über die Cloud bereitgestellt werden, wächst und verändert sich auch die Partnerlandschaft mit dem Megatrend.

Amazon Bedrock und die Titan-Sprachmodelle bilden einen wesentlichen Bestandteil des AWSGenAI-Portfolios und sind seit Herbst 2023 verfügbar. Wie wurden die Neuheiten im IT-Channel aufgenommen und welche Rolle spielen sie inzwischen im Tagesgeschäft der Partner?

Niclas Otte: Zunächst ist es wichtig zu erläutern, wie sich unsere GenAI-Strategie entwickelt hat. Im Kern geht es darum, sicheren Zugang zu führenden Large Language Models zu bieten, die orchestriert und skalierbar eingesetzt werden können. Dabei stellen wir sowohl Open-Source- als auch Closed-Modelle zur Verfügung, wie etwa Claude von Anthropic, einem strategischen Partner, dessen Sprachmodelle in vielen Tests als führend abschneiden, oder unsere Amazoneigenen Titan Modelle. Partner und Kunden können je nach Use Case die für sie passenden Modelle wählen. Unsere 3-Layer-Strategie (siehe Kasten S. 11) geht über Amazon Bedrock und das Titan-Sprachmodell hinaus und orientiert sich am Prinzip „the right tool for the right job“. So haben wir mit Amazon Q einen spannenden generativen KI-Assistenten, der bereits bei Partnern und Kunden im Einsatz ist. Die dynamische Entwicklung unseres Portfolios ist eng mit Enablement verknüpft, das unsere Partner intensiv nutzen – das Feedback dazu ist äußerst positiv. Ein Beispiel ist die AWS Generative AI Competency, die im März eingeführt wurde: 127 Partner, darunter beispielsweise Adastra, Slalom, Bytesource und Rackspace,

wurden für ihre robuste Projekterfahrung im Bereich generative KI belohnt.

Vom Foundation Model bis zur konkreten KIAnwendung, die einen bestimmten Zweck erfüllt, ist Entwicklungsarbeit erforderlich. Wie unterstützt AWS die Partner dabei in technologischer und finanzieller Hinsicht?

Niclas Otte: Wir bieten dedizierte Programme für generative KI, die von technischer Ausbildung über Co-Selling bis hin zu Go-to-Market-Strategien und Funding-Möglichkeiten reichen. Sie sind, wie alle unsere APN-Programme, systematisch aufgebaut. Als Partnerorganisation freuen wir uns natürlich, wenn Partner diese Programme gezielt nutzen. Dafür bieten wir ein strukturiertes Curriculum und spezifische Trainings, die Partner bei ihrer Ausbildung in Generativer KI umfassend unterstützen. Unsere Trainingsumgebung ist der AWS Skill Builder, und wir stellen zudem unseren GenAI Use Case Explorer zur Verfügung, der Erfahrungswerte aus Kundenprojekten zusammenfasst.

Wir setzen auch selbst Generative-KI-Komponenten ein: So konnte Amazon Q Upgrades von einigen Java-Applikationen, die normalerweise 100 Tage dauern, auf nur zwei Tage verkürzen. Wir stehen erst am Anfang, diese Technologie voll auszuschöpfen, und sie entwickelt sich kontinuierlich weiter. Wir unterstützen unsere Partner sowohl mit Self-Service-Möglichkeiten als auch

durch Dialog, enge Zusammenarbeit und gemeinsame Projekte dabei, Use Cases in erfolgreiche Business Cases zu verwandeln.“

Wesentliche Benefits von KI sind mehr Effizienz und Produktivität. Dazu müssen Anwendungen die spezifischen Prozesse von Unternehmen unterstützen. Inwiefern wird KI die Vertikalisierung des AWS-Geschäfts, die bereits seit einigen Jahren zu beobachten ist, weiter vorantreiben?

Niclas Otte: Wir erleben eine starke Dynamik im Bereich Generativer KI, die sich sowohl in horizontalen als auch in vertikalen Use Cases widerspiegelt. Ein Beispiel für einen horizontalen Use Case ist das Intelligent Document Processing, das durch Anwendung und im Dialog branchenspezifische Nuancen annehmen kann. Unser Goto MarketAnsatz ist branchenspezifisch ausgerichtet, und viele Partner bringen ihre Industrieexpertise ein, um echten Mehrwert zu schaffen. Immer mehr Kunden überlegen, wie sie Generative KI einsetzen können, um ihre branchenspezifischen Geschäftsprozesse zu verbessern. Schon jetzt ist absehbar, dass es nicht nur einen einzigen Weg zu einer Architektur geben wird. Generative KI ist dabei ein echter Beschleuniger und Mehrwert, den wir gemeinsam mit unserer Community realisieren.

2023 hast du die kontinuierliche Cloud-Transformation bei Kunden und Partnern, die Internationalisierung des AWS-Channels und die engere Zusammenarbeit von Partnern unterschiedlichen Typs als wesentliche Trends genannt. Welche neuen Entwicklungen beobachtest du in diesem Jahr? Niclas Otte: Uns freut, dass diese Dynamik weiterbesteht. Sie ist nicht mit dem Interview 2023 zu Ende gegangen. Die Devise lautet „neue Geschäftsfelder mit AWS erschließen“. Damit ist auch das geografische Erklimmen gemeint. Durch die Portfolioerweiterung besteht eine Expansion der Geschäftsfelder in den Offerings. Partner wie zum Beispiel Slalom expandieren international hierher. Wir beobachten aber auch aus Deutschland heraus eine starke Entwicklung. Das betrifft nicht nur Borninthe Cloud Partner wie zum Beispiel die Ankercloud aus Berlin, sondern auch Systemhäuser wie Bechtle, die international agieren.

Wie bereits erwähnt, sind GenAI und Data Analytics sicherlich große Treiber in unserer Partnercommunity. Besonders hervorheben möchte ich die Dynamik im Mittelstand. Hier in Deutschland gibt es zahlreiche kleinere Unternehmen, soge

Niclas Otte, Head of Partner Management SI & Distribution; DE & ALPS bei AWS

Der GenAI-Stack von AWS ist in drei Schichten aufgebaut. Der untere Layer richtet sich an Entwickler und Unternehmen, die Foundation Models (FM) entwickeln wollen. Diese Modelle werden auf Chips von GPUs führender Hersteller oder AWS-eigenen Chips trainiert und gehostet. Kunden, die ihr bestehendes FM nutzen und modifizieren wollen, landen im mittleren Layer. Diese Schicht fällt Amazon Bedrock zu. Hier sollen mithilfe der gängigsten Modelle von Providern wie zum Beispiel Anthropic, Meta, Mistral AI, AI21 Labs, Cohere oder Amazon GenAI-Applikationen unter dem Schutz der Security Features des Cloud Providers genutzt werden. Auf dem obersten Layer werden Dienste für Kunden bereitgestellt, die sich nicht mit KI oder den Modellen auseinandersetzen wollen. Hierzu gehören die Assistenten Amazon Q Business und Amazon Q Developer, mit denen KI sicher mit Unternehmensdaten und in der Softwareentwicklung genutzt werden können.

nannte Hidden Champions, die international tätige Großkunden bedienen. Die Fertigungsbranche steht vor einer umfassenden Transformation, bei der auch Generative KI eine entscheidende Rolle spielt. Ebenso zeigt sich im Gesundheitswesen großes Potenzial für diese Technologien. Viele unserer Partner pflegen seit Jahren erfolgreiche Geschäftsbeziehungen mit uns oder streben danach, sich mithilfe von AWS neu aufzustellen. Die Customer Obsession ist fest in unserer DNA verankert, und diesen Anspruch teilen auch unsere Partner.

Amazon Web Services entwickelt die Möglichkeiten, den AWS Marketplace zu nutzen, beständig weiter. Was sind aus deiner Sicht die wesentlichen neuen Features und wie können sowohl ISVs als auch Beratungs- und Integrationspartner davon profitieren?

Niclas Otte: Der AWS Marketplace gehört zu den am schnellsten wachsenden Bereichen im Part

Amazon Web Services kündigte 2024 milliardenschwere Investitionen an. So plant das Unternehmen zwischen 2024 und 2040 insgesamt 7,8 Milliarden Euro in seine AWS European Sovereign Cloud zu investieren, deren erste Region bis Ende 2025 in Brandenburg verfügbar sein soll. Außerdem ließ der Anbieter verlauten, zwischen 2024 und 2026 weitere 8,8 Milliarden Euro in seine bestehende Cloud-Infrastruktur in der AWS Europe (Frankfurt) Region zu investieren, um die wachsende Kundennachfrage nach Cloud-Diensten in Deutschland zu erfüllen.

nergeschäft. Die Power of Three aus AWS, Systemintegratoren und Partnern, die sich darauf fokussieren, marktführende oder branchenspezifische ISVLösungen zu vertreiben, entfaltet weiter ihre Wirkung. Dabei geht es mittlerweile nicht nur um den reinen Wiederverkauf von Software, sondern auch um die zielgerichtete Umsetzung. Über die Power of Three hinaus gibt es jedoch eine interessante Nuance: Partner können über den Marketplace auch eigene paketierte Ansätze in Form von Managed Services anbieten. Das ist besonders spannend, wenn eigene Intellectual Property dazu beiträgt, die Sichtbarkeit zu erhöhen und im Co Sale mit AWS aufzutreten. Im Marketplace ermöglichen wir auch über APIs die Integration der Angebote unserer Partner. Zudem haben wir unsere ListingPreise gesenkt. Das Marketplace Geschäft hat strategisch stark an Bedeutung für unsere ConsultingPartner gewonnen.

Um Unternehmen vor Cyber-Angriffen zu schützen, reichen präventive Maßnahmen allein nicht aus. Erforderlich sind eine kontinuierliche Überwachung des Netzwerkverkehrs und die Fähigkeit, schnell auf Vorkommnisse zu reagieren. AWS hat daher die Partnerkompetenz für Managed Security eingeführt. Wie ist die bisherige Resonanz im APN auf dieses Qualifizierungsangebot?

Niclas Otte: Security ist und bleibt unsere oberste Priorität. Dabei setzen wir auf verschiedene Bausteine. Neben der Partnerkompetenz im Bereich Managed Security Services, die Partner wie Ankercloud, Kreuzwerker (inzwischen Teil von PCG) oder NTT Data erhalten haben, adressieren wir mit der European Sovereign Cloud (siehe Kasten S. 12) eine weitere wichtige Komponente. TSystems hat zudem einen eigenen Managed Service für External Key Management aufgebaut, um ihre SecurityExpertise gezielt einzubringen. Wir

verfolgen einen breit angelegten Ansatz, der mit unseren AWS Kompetenzen untermauert wird. Unsere Partner arbeiten auf vielfältige Weise mit uns zusammen, um das umfassende SecurityKonzept von AWS für Kunden je nach Branche und Schwerpunkt weiter anzureichern. Unser SharedResponsibilityModell wird dabei klar von AWS, Partnern und Kunden gelebt.

Vor einem Jahr haben wir über die Bedeutung der Distribution für das APN gesprochen. Gibt es in dieser Hinsicht neue Programme von AWS oder nennenswerte neue Leistungsangebote der Distributoren für Partner?

Niclas Otte: Die Distribution ist ein strategischer Eckpfeiler unserer Partnerstrategie. Wir sehen eine hohe Dynamik in unserer Partner Community, wie sie die Distribution nutzt und mit ihr zusammenarbeitet. TD Synnex und Ingram Micro haben beispielsweise in DACH und Osteuropa ihr Angebot an AWS Kampagnen massiv ausgebaut, wobei sie stark auf Workload und Branchenebene agieren. Dies bietet unserer Partner Community hervorragende Möglichkeiten zur Skalierung und unterstützt sie beim Aufbau von Neukundengeschäft. Es handelt sich dabei nicht nur um MarketingKampagnen, sondern auch um eigene ManagedServices Angebote. Wir freuen uns sehr, dass diese Dynamik nicht nur durch AWS und eigene Weiterentwicklungen unterstützt wird, sondern dass die Distributoren selbst das Heft in die Hand nehmen. Ingram Micro und TD Synnex sind heute wesentlich mehr als reine Reseller. Die Distribution erfindet sich gerade neu.

Mehr unter: https://voge.ly/vglDloC/

Autor: Alexander Siegert

Bauen Sie mit Amazon Web Services ein zukunftssicheres und flexibles Geschäftsmodell

Egal, wo Sie sich auf Ihrer Cloud-Reise befinden, die Experten von Devoteam entwickeln gemeinsam mit Ihnen eine Cloud-Strategie, die zu Ihrem Unternehmen passt.

Und das ist noch nicht alles. Devoteam unterstützt Sie auch nach dem Start Ihrer neuen Cloud-Projekte. Mit AWS Managed Services holen Sie das Beste aus Ihrer Cloud heraus, heute und in Zukunft.

Buchen Sie einen Termin mit Ihrem Ansprechpartner

Hans Wagner | Tech Lead

KI birgt großes Potenzial, die Produktivität der deutschen Wirtschaft zu steigern. Eine Studie von IW Consult zeigt, dass der Erfolg KI-basierter Geschäftsmodelle von leistungsfähigen Rechenzentren abhängt. Ein zügiger Ausbau der digitalen Infrastruktur in Deutschland ist daher erforderlich.

Künstliche Intelligenz könnte der Wirtschaft in Deutschland einen spürbaren Schub verleihen. Die Technologie besitzt das Potenzial, das Produktivitätswachstum „in der Spitze um rund 1,3 Prozent pro Jahr zu erhöhen“, wie IW Consult, eine Tochtergesellschaft des Kölner Instituts der Deutschen Wirtschaft, ermittelt hat. Nach dieser Berechnung würde sich in Deutschland durch KI eine zusätzliche Bruttowertschöpfung von 330 Milliarden Euro ergeben. Die Zahl geht aus der aktuellen Studie „Spillover-Effekte von Rechenzentren: Rückgrat der KI-Revolution in Deutschland“ hervor, die durch AWS unterstützt wurde. IW Consult hat den Bericht im Auftrag der „Allianz zur Stärkung digitaler Infrastrukturen“ erstellt, einer Initiative, in der sich der Cloud Provider und weitere Unternehmen der Digitalwirtschaft unter dem Dach des Eco – Verband der Internetwirtschaft zusammengeschlossen haben (siehe Kasten).

Die positiven Auswirkungen auf die Produktivität resultieren aus effizienteren Prozessen und einer gesteigerten Innovationskraft, die Unternehmen durch KI-Tools erzielen. Der Einsatz der Technologie setzt allerdings enorm viel Rechenleistung voraus. Sie wird nicht nur benötigt, um KI-Modelle zu trainieren. Noch weit mehr Ressourcen sind erforderlich, damit Millionen von Nutzenden ihre Daten mithilfe von KI-Anwendungen verarbeiten können.

Viele Unternehmen stellen diese Ressourcen nicht in eigenen IT-Umgebungen bereit, sondern beziehen sie aus externen Rechenzentren, meist aus einer Public oder einer Private Cloud. Dabei verzeichnen Anwender, die eine Public Cloud nutzen, laut der IW-Consult-Studie höhere Produktivitätssteigerungen. „Der Erfolg KI-basierter Geschäftsmodelle hängt von der Verfügbarkeit und Leistungsfähigkeit der Rechenzentrums- und insbesondere der Cloud-Infrastruktur ab“, betont Carsten Kestermann, Director Public Policy DACH bei AWS.

Eine wesentliche Erkenntnis der Studie lautet daher, dass „Rechenzentren das Rückgrat der KITransformation in Deutschland bilden und somit elementar für die Digitale Transformation der deutschen Wirtschaft sind“. Für die zu erwartende Nachfrage reichen die vorhandenen Ressourcen aber bei Weitem nicht aus. Der Bedarf an Rechenleistung durch Generative KI wird sich McKinsey zufolge von 2024 bis 2030 weltweit um den Faktor 125 erhöhen.

Auf diesen Bedarf reagiert AWS und investiert Milliardenbeträge in den Bau von Rechenzentren – auch hierzulande. Im Zeitraum von 2024 bis 2026 sollen 8,8 Milliarden Euro in die Infrastruktur der AWS-Region Frankfurt fließen. Zwischen 2014 und 2023 wurden dort bereits 9,6 Milliarden Euro investiert. Weitere 7,8 Milliarden Euro will

der Cloud Provider bis 2040 für den Auf- und Ausbau der European Sovereign Cloud in Brandenburg aufwenden. Wie die Studie zeigt, ist 45 Prozent der deutschen Unternehmen wichtig, dass die Rechenzentren, deren Ressourcen sie nutzen, hierzulande betrieben werden. „Bei AWS sind wir customer-obsessed: Wir hören auf die Wünsche unserer Kunden und bauen unsere Infrastruktur deshalb auch in Deutschland aus“, so Kestermann.

Über die Bedeutung von Rechenzentren für die KI-Transformation hinaus hat IW Consult untersucht, wie sich die externe IT-Bereitstellung in Cloud und Colocation generell auf Resilienz, Datensicherheit, Kosten- und Energieeffizienz auswirkt. Vor allem die Cloud spielt dabei laut Kestermann ihre Vorzüge in puncto Agilität, Flexibilität und Skalierbarkeit aus. Die Studie bestätigt, dass diese Eigenschaften die Innovationsfähigkeit von Unternehmen fördern: 55 Prozent der Befragten geben an, dass die Cloud-Nutzung positiv zur Entwicklung neuer Produkte und Dienstleistungen beiträgt. Zudem berichten 72 Prozent dieser Unternehmen, dass sie dank verbesserter Prozesse zusätzliche Umsätze erzielen.

Tatsächlich würde das Geschäftsmodell bei 27 Prozent der Unternehmen ohne Cloud nicht mehr funktionieren. Dieser Wert betrug vor zwei Jahren noch 17 Prozent. Insgesamt sind 2024 etwa 5,9 Millionen Erwerbstätige in solchen Unternehmen tätig. 2022 lag dieser Wert bei gut 2,8 Millionen Erwerbstätigen. Das bedeutet einen monatlichen Zuwachs von 126.000 Erwerbstätigen in Unternehmen, deren Geschäftsmodell von der Cloud abhängt. 2023 lag die zusätzliche Bruttowertschöpfung durch Cloud hierzulande bei 250 Milliarden Euro.

BILD: AWS

Carsten Kestermann, Director Public Policy DACH bei AWS

Alexander Rabe, Geschäftsführer des Eco – Verbands der Internetwirtschaft e. V.

„Ohne Cloud und Rechenzentren geht nicht mehr viel in Sachen wirtschaftlichem Erfolg“, resümiert Alexander Rabe, Geschäftsführer bei Eco. Der Bedarf an zusätzlichen Rechenzentren werde in Deutschland zwar erkannt. Dass vom Plan bis zur Inbetriebnahme bis zu sechs Jahre vergehen, sei aber deutlich zu lang.

„Wir brauchen mehr Tempo bei Planungs- und Genehmigungsverfahren, um die Produktivitätseinbußen der Anwenderindustrie zu minimieren“, sieht Rabe die Politik in der Pflicht. Auch in puncto Energieversorgung und Regulierung müsse gehandelt werden. „Wir brauchen wettbewerbsfähige Strompreise und ausreichend erneuerbare Energie. Nicht zuletzt fordern wir einen europäischen digitalen Binnenmarkt mit einheitlichen Standards und Regeln für die Datacenter-Branche.“

Mehr unter: https://voge.ly/eco-Studie/

Autor: Michael Hase

Die Allianz zur Stärkung digitaler Infrastrukturen wurde 2018 unter dem Dach des Eco – Verband der Internetwirtschaft ins Leben gerufen. An der Initiative beteiligen sich führende Unternehmen der Digitalwirtschaft, zu denen Rechenzentrumsbetreiber, Colocation-Anbieter, Carrier sowie Internet und Cloud Service Provider zählen. Aktuelle Mitglieder sind AWS, DE-CIX, Digital Realty, NTT, Plusserver, Telehouse, Gasline, Green Mountain, NetCologne, Noris Network und Telemaxx.

Zweck der Allianz ist es, das Bewusstsein für die Bedeutung digitaler Infrastrukturen in der deutschen Öffentlichkeit zu schärfen und einen konstruktiven Dialog mit der Politik zu führen. Damit verbunden ist das Ziel, Deutschland als Rechenzentrumsstandort im internationalen Wettbewerb zu stärken. Ein weiteres Kernziel der Initiative besteht darin, die Energieversorgung digitaler Infrastrukturen sicherzustellen – unter Gesichtspunkten der Wirtschaftlichkeit ebenso wie der Nachhaltigkeit.

„Digitale

Mit dem 2022 angekündigten AWS Digital Sovereignty Pledge verpflichtet sich AWS, die fortschrittlichsten Souveränitätskontrollen und -funktionen zu bieten, die in der Cloud verfügbar sind. Aber was genau bedeutet das, und wie lassen sich auch hochsensible Systeme in der AWS Cloud sicher und performant betreiben?

Aktuell gibt es keine einheitliche Definition, was „Digitale Souveränität“ eigentlich genau beinhaltet. Jedes Land, jede Region und teilweise sogar jedes Unternehmen hat seine eigenen Anforderungen an Digitale Souveränität, und es gibt keine einheitlichen Leitlinien für die Arten von ITSystemen, Branchen und Sektoren gibt, die solche Anforderungen erfüllen müssen.

Nach der Beratung mit Kunden, Partnern und Regulierungsbehörden hat AWS die Themenfelder Datenresidenz, Ausschluss von Betreiberzugriffen, Ausfallsicherheit und Transparenz als die wichtigsten gemeinsamen Schlüsselthemen identifiziert.

Wie im letzten Jahr angekündigt, plant AWS bis Ende 2025 die AWS European Sovereign Cloud zu errichten, zusätzlich zu den schon bestehenden acht europäischen AWS-Regionen in Frankfurt, Irland, London, Mailand, Paris, Stockholm, Spanien und Zürich. Technisch bietet die European Sovereign Cloud den Kunden die vertraute AWS-

Benutzererfahrung, nutzt dafür aber eine neue, separierte Infrastruktur und ein anderes Betriebsund Support-Modell. Darüber hinaus wird das operative Design der AWS European Sovereign Cloud helfen, zusätzliche Kundenanforderungen an Datenspeicherung, operative Autonomie und Ausfallsicherheit zu erfüllen.

Der Unterschied: Diese Cloud wird ausschließlich von AWS-Mitarbeitern betrieben, die in der EU ansässig sind. Dies gilt auch für den technischen Support und Kundendienst für die AWS European Sovereign Cloud, der rund um die Uhr, 7 Tage die Woche, 365 Tage im Jahr verfügbar sein wird. Die AWS European Sovereign Cloud wird betrieblich unabhängig von den anderen Regionen sein, mit separatem Abrechnungssystem und eigenem Identity- und Access-Management (IAM) innerhalb der Region.

Die AWS European Sovereign Cloud ist so gestaltet, dass nicht nur alle Kundendaten, sondern auch alle Metadaten, die durch Kunden angelegt

AWS NITRO ENCLAVES

AWS definiert Confidential Computing als den Einsatz spezieller Hardware und zugehöriger Firmware, um Kundencode und -daten während der Verarbeitung vor Zugriffen von außen zu schützen. Hierzu bietet AWS mit Nitro Enclaves isolierte, gehärtete und stark eingeschränkte Umgebungen zum Hosten sicherheitskritischer Anwendungen. Dabei verwenden AWS Nitro Enclaves dieselbe Nitro-Hypervisor-Technologie, die auch für Standard- EC2-Instanzen genutzt wird.

1. Schutz vor Cloud-Betreibern: Das AWS Nitro-System ist so konzipiert, dass es keinen Operator-Zugriff hat. Wenn ein AWSOperator, auch mit höchsten Berechtigungen, Wartungsarbeiten an einem EC2-Server durchführen muss, kann er dies nur mithilfe eines streng begrenzten Satzes authentifizierter, autorisierter und geprüfter Management-APIs tun. Keine dieser APIs hat die Möglichkeit, auf Kundendaten auf dem EC2-Server zuzugreifen, kein AWS-Operator kann diese Kontrollen und Schutzmaßnahmen umgehen.

2. Schutz vor AWS-Systemsoftware: Das Design des Nitro-Systems nutzt eine Hardware-basierte Speicherisolierung auf unterster Ebene, um generell den direkten Zugriff auf den Kundenspeicher durch AWS-Systeme und AWS-Personal zu verhindern. Netzwerk-, Speicher- und GPU-Beschleunigerzugriff nutzen SR-IOV, eine Technologie, die es Instanzen ermöglicht, über eine vom Hypervisor sicher erstellte Pass-Through-Verbindung direkt mit Hardware-Geräten zu interagieren.

3. Schutz sensibler Computer- und Datenelemente vor den Betreibern und der Software des Kunden: AWS Nitro Enclaves bieten ein Mittel zum Schutz besonders sensibler Elemente von Kunden-Code und Daten nicht nur vor AWS-Operatoren, sondern auch vor denen des Kunden und anderer Software. Mithilfe von kryptografischen Zertifizierungsfunktionen wird zusätzlich die Integrität der bereitgestellten Software validiert. Darüber hinaus teilt eine Nitro Enclave keinen Arbeitsspeicher oder CPU-Kerne mit der zugehörigen EC2-Instanz und verfügt über keine IP-Konnektivität oder dauerhaften Speicher, so dass externe Manipulationen ausgeschlossen werden können. AWS

Kundencodes und -daten müssen während der Verarbeitung vor Zugriffen von außen geschützt werden.

Die erste AWS European Sovereign Cloud wird in Brandenburg angesiedelt sein.

werden (zum Beispiel Rollen, Zugriffsrechte, Labels für Ressourcen und Konfigurationsinformationen), innerhalb der EU verbleiben. Die AWS European Sovereign Cloud verfügt über unabhängige Systeme für das Rechnungswesen und zur Nutzungsmessung.

Die erste Region ist für Deutschland – genauer: in der Region Brandenburg – angekündigt. Sie wird mit mehreren Verfügbarkeitszonen (Availability Zones – AZ) starten, die sich an separaten geografischen Standorten befinden. Zwischen den Verfügbarkeitszonen wird ausreichender Abstand gewährleistet, um das Risiko zu minimieren, dass ein einzelnes Ereignis sich auf mehr als eine Verfügbarkeitszone auswirken kann.

Wie schon bei den bestehenden AWS Regionen wird die AWS European Sovereign Cloud für Hochverfügbarkeit und Ausfallsicherheit ausgelegt sein und auf dem AWS Nitro System basieren, um die Vertraulichkeit und Integrität von Kundendaten sicherzustellen. Das Nitro System wurde im Rahmen einer unabhängigen Untersuchung in einem öffentlichen Bericht validiert, und stellt Sicherheit und Leistung in den Mittelpunkt. Seine spezielle Hardware und die zugehörige Firmware sind darauf ausgelegt, dass niemand, auch kein AWS Mitarbeitender, auf KundenWorkloads oder Daten zugreifen kann, die auf Amazon Elastic Compute Cloud (Amazon EC2) Nitro-basierten Instanzen ausgeführt werden. Das Design des Nitro Systems wurde von der NCC Group, einem unabhängigen Cybersicherheitsunternehmen, validiert. Die Kontrollen, die den Bedienerzugriff verhindern, sind für das Nitro System so grundlegend, dass AWS sie in die Servicebedingungen aufgenommen hat, um allen

Mit dem Inkrafttreten des EU AI Act im August 2024 hat eine neue Ära der KI-Regulierung begonnen. Umfassende Transparenzpflichten betreffen insbesondere Unternehmen, die KI-Systeme in sensiblen Bereichen einsetzen. Sie müssen beispielsweise detaillierte Informationen über die Funktionsweise ihrer KI bereitstellen und damit deren Nachvollziehbarkeit gewährleisten. Schon jetzt sollten sich Unternehmen an Methoden der „Explainable AI“ orientieren, um den regulatorischen Anforderungen gerecht zu werden und das Vertrauen in ihre KI-Lösungen zu sichern.

Viele moderne KI-Systeme, insbesondere Deep-LearningModelle, gelten als „Black Boxes“, da ihre komplexen Entscheidungsprozesse schwer nachvollziehbar sind. Dies birgt Risiken: Mangelnde Transparenz kann in kritischen Anwendungen zu Vertrauensverlust oder gar rechtlichen Problemen führen. Um diese Intransparenz zu überwinden, werden Methoden der Explainable AI (XAI) eingesetzt. Mit Techniken wie LIME (Local Interpretable Model-agnostic Explanations) und SHAP (SHapley Additive exPlanations) ist es möglich, die oft verborgenen Mechanismen von KI-Systemen offenzulegen. Diese Werkzeuge schaffen Transparenz und Vertrauen durch nachvollziehbare Erklärungen – eine unverzichtbare Grundlage für den ethischen und verantwortungsvollen Einsatz von KI.

Verlässlichkeit von KI: Vorsicht vor halluzinierten Erklärungen

Ein weiteres Problem in der KI sind sogenannte „Halluzinationen“. Systeme, insbesondere im Bereich der Sprachverarbeitung, liefern Erklärungen, die zwar plausibel erscheinen, jedoch nicht auf Tatsachen basieren. Erhebliche Fehlinter-

pretationen sind möglich. Eine vielversprechende Lösung bietet hier RetrievalAugmented Generation (RAG) – eine Technik, bei der KI-Modelle nicht nur ihr gelerntes Wissen aus Trainingsdaten nutzen, sondern auch auf definierte Quellen zugreifen, z. B. Datenbanken oder Datei-

„Die Zusammenarbeit mit Skaylink ist entscheidend für unseren Unternehmenserfolg. Die Expert*innen von Skaylink verstehen unser Geschäftsmodell. “

Carola Klaus, Geschäftsführerin der IMWF GmbH

ablagen, bevor sie Antworten generieren. Die Zuverlässigkeit der Erklärungen wird erhöht und irreführende Inhalte können vermieden werden.

Kontext zählt: Erklärungen für alle verständlich gestalten Erklärungen von KI-Systemen müssen nicht nur korrekt, sondern auch an den jeweiligen Kontext und die Zielgruppe angepasst sein. Während technische Expert*innen detaillierte und tiefgehende

Analysen erwarten, reichen nicht-technischen Anwender*innen oft einfache und intuitive Erklärungen. Barrierefreie Erklärungen ermöglichen allen Nutzer*innen, von den Vorteilen der KI zu profitieren, ohne durch die Komplexität der Systeme ausgeschlossen zu werden.

Der Weg zur vertrauenswürdigen KI Unternehmen sollten den AI Act nicht als notwendiges Übel, sondern vielmehr als Chance betrachten, um verantwortungsbewusste und transparente KI-Lösungen zu entwickeln und einzusetzen. Mit dem AI Acceleration Program unterstützt Skaylink Sie, KI zu entmystifizieren und sinnvolle Anwendungskontexte zu identifizieren, die kurzfristig als PoC umsetzbar sind. Diese orientieren sich sowohl an den gesetzlichen Compliance-Vorgaben als auch an praxisnahen Erfolgskonzepten. So können Sie das Potenzial der KI voll ausschöpfen und gleichzeitig das Vertrauen Ihrer Kunden und Partner stärken.

Bereiten Sie sich jetzt auf den EU AI Act vor! Kontaktieren Sie uns für eine unverbindliche Beratung zum effizienten und verantwortungsvollen Einsatz von KI. awspartner@skaylink.com

In hochregulierten Umgebungen kann es in Einzelfällen gesetzliche Anforderungen geben, die Keys zur Verschlüsselung von Kundendaten zwingend außerhalb der AWS Cloud zu speichern. Exakt für diesen Anwendungsfall wurde der External Key Store des AWS Key Management Service (AWS KMS) entwickelt. Wenn ein AWS-Service Daten verschlüsseln will, fordert der Service einen eindeutigen Data Encryption Key von AWS KMS an. Dieser Data-Key wird ebenfalls mit einem bestimmten vom KMSKunden verwalteten Schlüssel verschlüsselt, der als Root-Key bezeichnet wird. Das Schlüsselmaterial wird sicher generiert und in einem NIST 140-2-zertifizierten Hardware-Sicherheitsmodul (HSM) gespeichert, das so konzipiert ist, dass das Schlüsselmaterial das HSM niemals im Klartext verlässt. Beim Abrufen der verschlüsselten Daten werden dann zunächst der Data-Key mithilfe des Root-Keys entschlüsselt, und anschließend dann die Daten selbst decodiert.

Bei Verwendung eines AWS KMS External Key Stores (XKS) ersetzt man diesen AWS-gehosteten Root-Key durch einen neuen, externen Root-Key. Wenn AWS KMS einen Data-Key verschlüsseln oder entschlüsseln muss, leitet es die Anfrage an das extern gehostete HSM weiter. Ein XKS-Proxy übersetzt die generische AWS-KMSAnfrage in das passende Format für die externen HSMs und entschlüsselt den Data-Key, sodass der anfordernde AWS-Dienst die Daten schließlich final entschlüsseln und weiterverarbeiten kann.

AWS empfiehlt allerdings, den AWS KMS External Key Stores (XKS) nur zu verwenden, wenn es aufgrund gesetzlicher Vorschriften oder Compliance-Anforderungen zwingend erforderlich ist. Für den Großteil der AWS-Kunden sind die AWS-gehosteten KMSOptionen absolut ausreichend für ein sicheres und datenschutzkonformes Key-Management, ohne die höheren Betriebskosten eines On-Premises-HSM-Clusters.

Wenn ein AWS-Service Daten verschlüsseln will, fordert der Service einen eindeutigen Data Encryption Key von AWS KMS an.

Kunden eine zusätzliche vertragliche Sicherheit zu bieten.

Sollten Kunden darüber hinaus weitere Optionen wünschen, um selbst die physische Sicherheit ihrer AWS-Infrastruktur zu verwalten oder weitergehende Anforderungen an den Ort der Datenverarbeitung in einem bestimmten Land zu erfüllen,

können sie alternativ auf AWS Dedicated Local Zones oder AWS Outposts zurückgreifen. AWS arbeitet mit Kunden und Partnern kontinuierlich daran, die AWS European Sovereign Cloud so zu gestalten, dass sie den sich wandelnden Anforderungen entspricht. Dabei nutzt AWS auch Feedback aus den direkten Gesprächen mit europäischen Aufsichtsbehörden und nationalen Cybersicherheitsbehörden.

Bereits jetzt ergibt es Sinn, direkt in die ersten Kundengespräche zu starten. Die AWS European Sovereign Cloud wird vor allem für Unternehmen, Behörden und Institutionen mit hohem Regulierungsgrad und erweiterten Datenschutzanforderungen interessant sein, die typischerweise einen längeren Vorlauf für konzeptionelle und rechtliche Prüfungen benötigen. Viele dieser Unternehmen und Institutionen suchen dabei Unterstützung durch kompetente Consulting- und Software-Partner: sei es beim Design der BasisInfrastruktur, in der Umsetzung der ComplianceAnforderungen oder beim finalen Aufbauen oder Migrieren von IT-Systemen auf AWS.

Parallel dazu können Kunden bereits Proof-ofConcepts durchführen und praktische Erfahrungen sammeln, die ihnen beim Start der AWS European Sovereign Cloud Ende 2025 helfen. So lassen sich mit AWS CloudFormation fertige Templates als Infrastructure-as-Code erstellen, welche dank der identischen Services und API-Schnittstellen schon heute in den bestehenden AWSRegionen wie beispielsweise in Frankfurt getestet werden können. Sobald die AWS European Sovereign Cloud verfügbar ist, können diese als readyto-deploy Blueprints genutzt werden. Eine Liste der initial verfügbaren Services der AWS European Sovereign Cloud ist online verfügbar, so dass AWSPartner ihre Lösungen und Templates schon heute darauf ausrichten können. Den Link dazu finden Sie unten im Kasten.

Mit der Einführung der European Sovereign Cloud bietet AWS Kunden und Partnern die notwendigen Werkzeuge, um operative Autonomie innerhalb der EU zu erreichen, besonders sensible Daten zu schützen und gleichzeitig die Vorteile der Cloud voll auszuschöpfen.

Hier geht´s zur ESC-Liste von AWS: https://voge.ly/AWS-ESC-Liste/ Autor: Rainer Möller

Dein Unternehmen

Kompetent & gelassen

Als AWS Advanced Partner mit 20 Jahren Erfahrung reist Du mit uns leicht und entspannt – keine lästigen Zwischenstopps, kein unnötiger Ballast.

auch Deine Datenreise in der AWS-Cloud. Egal, ob Du Dich noch am Anfang befindest oder schon mitten in Deiner Daten-Journey steckst: Die erfahrenen Datenprofis von b.telligent navigieren Dich und Dein Unternehmen sicher und effizient ans Ziel. Versprochen!

Optimal & souverän

Wir nehmen Dir die Komplexität ab und sorgen dafür, dass Du Deine Daten geschickt durch die AWS-Cloud steuerst und optimal nutzt.

Wertvoll & smart

Kluges Navigieren heißt nicht, den erstbesten Weg zu wählen, sondern den strategisch wertvollsten. Wir planen Deine Route maßgeschneidert und für Deine spezifischen Anforderungen.

Du willst erleben, wie der Wert Deiner Daten wächst und wie sie die Leistung Deines Unternehmens nachhaltig verbessern? Dann pack Deine Datenkoffer und nimm unsere Expertise in Data & Analytics, Machine Learning und CloudOps einfach mit an Bord!

Ready for Take-off?

Quick Contact: Vereinbare hier Dein unverbindliches Beratungsgespräch!

Lass Dich überzeugen: Erfolgreiche Partnerschaft & Success Stories!

Die rapide technologische Entwicklung und die zunehmende Verbreitung Generativer Künstlicher Intelligenz haben in den letzten Jahren einen tiefgreifenden Wandel eingeleitet. Dabei sind Daten einer der Schlüsselfaktoren für die Digitale Transformation.

Unternehmen nutzen Daten-Insights, um ihre Produktionsqualität zu verbessern, Echtzeitprognosen zu erstellen oder auf Sicherheitsvorfälle zu reagieren. Gleichzeitig arbeiten Unternehmen daran, ihre Daten und Generative-KI-Technologie möglichst effizient und gewinnbringend in bestehende Prozesse zu integrieren, miteinander zu verknüpfen und damit neue Geschäftsfelder zu erschließen.

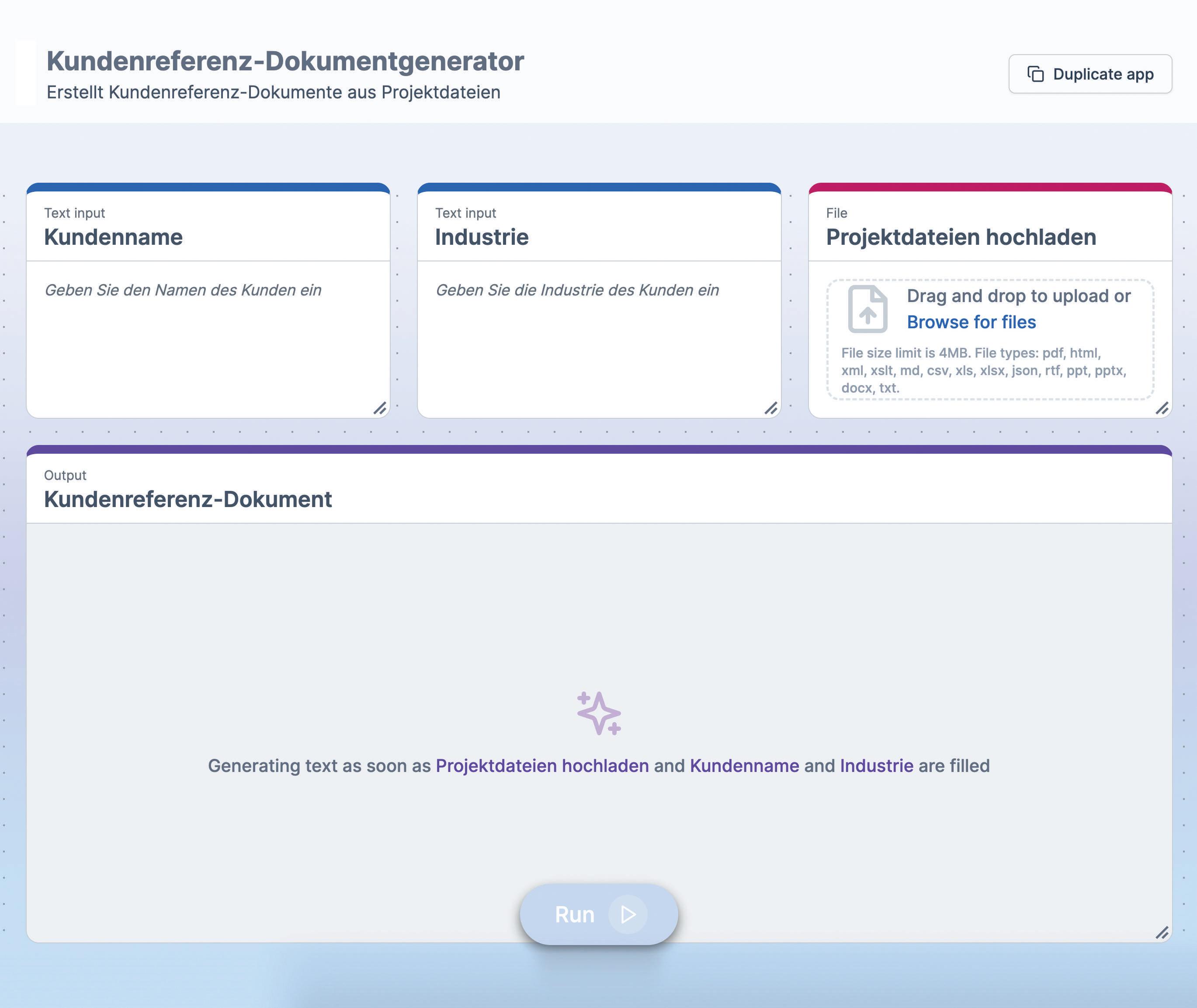

Mit der Markteinführung von Amazon Q im April 2024 stellte AWS einen leistungsfähigen, Generativen-KI-Assistenten vor. Dabei dient Q als Schnittstelle, die Mitarbeitende dabei unterstützt, auf unternehmensweite Informationen zuzugreifen, diese einzuordnen, zu kontextualisieren und daraus Erkenntnisse abzuleiten beziehungsweise anderweitig Mehrwerte zu generieren. Anwender formulieren ihre Fragen in natürlicher Sprache und erhalten relevante Informationen, Analysen und Handlungsempfehlungen.

Die Produktfamilie Amazon Q vereint mehrere Dienste: neben Amazon Q Developer, das Entwickler und auch andere IT-Professionals bei ihrer Arbeit unterstützt, hilft Amazon Q Business Unternehmen dabei, ihre Daten und Ressourcen mithilfe von Generativer KI für alle Mitarbeitenden im Unternehmen nutzbar zu machen. Ob es um Vertriebsberichte, Produktinformationen oder Kundendaten geht – Amazon Q Business stellt sicher, dass relevante Informationen einfach und sicher abgerufen werden können. „Durch die Implementierung von Amazon Q Business innerhalb unserer Organisation erwarten wir eine 70 Prozent schnellere Einarbeitungszeit neuer Mitarbeitender und eine 30 Prozent höhere Produktivität unserer Entwicklerinnen und Entwickler“, erklärt Will McQueen, Head of Global Data Assets bei Bayer AG.

Mit Hilfe von Amazon Q Apps, einer Funktion von Amazon Q Business, können Unternehmen und

deren Mitarbeitende Generative-KI-gestützte Mini-Anwendungen, so genannte Apps, umsetzen. Q-Apps werden einfach per Mausklick von Endnutzern erstellt und mit dem Team geteilt und können für eine Vielzahl von verschiedenen Aufgaben eingesetzt werden. So reicht das Spektrum von einfachen Experimenten über Prototypen bis zur komplexen Automatisierung von Arbeitsabläufen

Amazon Q bietet durch sein Plugin-System und bereits vorgefertigte Module Integrationsmöglichkeiten in bestehende Lösungen von zum Beispiel Salesforce, ServiceNow oder Microsoft und integriert sich nahtlos in bestehende Abläufe. Darüber hinaus erlaubt das System die Möglichkeit der Eigenentwicklung und ermöglicht dadurch eine Integration in eine Vielzahl von bestehenden Prozessen und Arbeitsabläufen. Amazon Q ist Teil des AWS-Ökosystems und integriert sich beispielsweise mit Amazon QuickSight Q oder Amazon Connect Q in bestehende Services, was Analysen und Kundenservice-Funktionen vereinfacht So kann Amazon Connect Q als Plattform für einen KI-gesteuerten Kundenservice dienen, bei dem Amazon Q als intelligenter Assistent fungiert, um Kunden schnell und effizient bei ihren Anliegen zu unterstützen.

Auch anderweitig integriert sich Q nahtlos in die AWS-Plattform – so profitieren Unternehmen von einer einheitlichen Benutzeroberfläche und Verwaltung. Bestehende Sicherheits- und Compliance-Konzepte können erhalten bleiben. Q versteht Governance-Identitäten, Rollen und Berechtigungen und stellt mit Hilfevon unternehmensweiten Zugriffskontrollen und Richtlinien

sicher, dass Mitarbeitende nur auf die Daten zugreifen können, fürdie sie berechtigt sind. Zudem wird gewährleistet, dass sensible Daten nur für autorisierte Zwecke verwendet werden, und so Compliance-Richtlinien eingehalten werden.

Die rapide Entwicklung und die zunehmende Verbreitung Generativer-KI-Technologie haben einen tiefgreifenden Wandel der digitalen Landschaft eingeläutet Daten sind dabei ein Schlüsselfaktor, da Erkenntnisse aus DatenInsights für Unternehmen immer wichtiger werden, um am Markt wettbewerbsfähig zu bleiben

Mit Amazon Q präsentiert AWS einen leistungsfähigen Generativen-KI-Assistenten, der Mitarbeitende dabei unterstützt, auf verteilte, unternehmensweite Daten und Informationen zuzugreifen, diese einzuordnen und daraus Mehrwerte zu generieren.

Durch die nahtlose Integration in bestehende Anwendungen und Services sowie das Plugin-System können Unternehmen Q flexibel in bestehende Prozesse einbinden

Amazon Q ist ein Beispiel dafür, wie GenerativeKI-Technologie dabei helfen kann, die Digitale Transformation zu beschleunigen und datengetriebene Entscheidungsfindungen zu vereinfachen, indem es Unternehmen dabei unterstützt, ihre eigenen Daten und Wissensressourcen zu integrieren und effektiver zu nutzen

Autor: Timo Runge

Die Erderwärmung schreitet voran, Wetterextreme häufen sich, die Artenvielfalt schwindet. Angesichts dieser Entwicklungen wird der Ruf nach innovativen Lösungen für mehr Nachhaltigkeit immer lauter. Künstliche Intelligenz (KI) und Cloud Computing werden dabei regelmäßig als Schlüsseltechnologien einer grünen Transformation gehandelt. Doch wie realistisch sind die Erwartungen an diese beiden Zukunftsfelder und wie sieht es in der Praxis aus?

Wie werden KI und Generative KI im Bereich Nachhaltigkeit erfolgreich angewendet? Eine Antwort darauf geben erste Praxisbeispiele. So nutzt das kanadische Startup BrainBox AI generative KI, um die Energieeffizienz von Gewerbe-Immobilien zu steigern. Die selbstlernenden Algorithmen analysieren große Datenmengen zu Wetter, Belegung sowie Gebäudestruktur und optimieren auf Basis dieser Informationen den Betrieb von Heizungs-, Lüftungs- und Klimaanlagen. Durch die intelligente Steuerung konnten die Energiekosten der Anlagen so um bis zu 25 Prozent gesenkt werden. Die CO2-Emissionen sanken um bis zu 40 Prozent. Werden neue Gebäude zu dem System hinzugefügt, werden mit Hilfe generativer KI aus unstrukturierten technischen Dokumenten automatisch Konfigurationsdateien erstellt. Diese Automatisierung verkürzt die Einrichtung neuer Gebäude um über 90 Prozent.

Im Energiesektor wird KI eingesetzt, um den Energieverbrauch in Echtzeit vorherzusagen und zu optimieren. Dafür prognostiziert die KI den Leistungsverlauf von Windkraft und Solaranlagen sowie den erwarteten Energiebedarf.

Ein Beispiel dafür ist REO, ein von Amazon entwickeltes System, das zur Optimierung der eige -

nen Erneuerbare-Energie-Anlagen eingesetzt wird. Das REO-Team überwacht die Betriebsleistung von hunderten weltweit verteilten Windkraft- und Solar-Anlagen in nahezu Echtzeit mit Amazon Managed Grafana Dashboards und den von AWS-IoT-Diensten gelieferten Daten. Durch den Einsatz von Amazon SageMaker für prädiktive Zustandsanalysen werden Warnungen für Anlagen generiert, die unterdurchschnittliche Ergebnisse liefern, und Anomalien erkannt, um Ausfälle durch präventive Wartungen zu vermeiden.

Die zunehmende Anwendung von KI führt jedoch auch zu einem rasant wachsenden Bedarf an Ressourcen, etwa um die erforderliche IT-Infrastruktur zu errichten und zu betreiben. Die Nutzung von Cloud-Infrastrukturen kann hier entgegenwirken. So zeigt eine von AWS in Auftrag gegebene Studie von Accenture aus 2024, dass die Infrastruktur von AWS bis zu 3,3-mal effizienter ist als eigene Rechenzentren in Europa. Wenn KI-Anwendungen auf AWS optimiert werden, kann der damit verbundene CO2-Fußabdruck um bis zu 99 Prozent reduziert werden.

Amazon hat sich zum Ziel gesetzt, bis 2040 – und damit 10 Jahre vor dem Pariser Abkommen – in all

seinen Betriebsabläufen, die Rechenzentren, Firmengebäude, Lebensmittelgeschäfte und Logistikzentren umfassen, CO2-neutral zu arbeiten. Weltweit ist Amazon laut Bloomberg New Energy Finance (2023) mit einer Gesamtkapazität von 33,6 GW der größte private Abnehmer erneuerbarer Energien. Amazon hat in über 500 Solarund Windprojekte weltweit investiert, die zusammen genug Energie erzeugen können, um mehr als 21,9 Millionen europäische Haushalte mit Strom zu versorgen.

Zudem hat AWS weitere Maßnahmen ergriffen, um die Nachhaltigkeit seiner Rechenzentren zu steigern. Dazu gehören beispielsweise ein effizientes Energie- und Wassermanagement und der Einsatz eigener effizienter Prozessoren. Um dieses Engagement weiter zu unterstreichen, hat sich AWS zum Ziel gesetzt, bis 2030 wasserpositiv zu werden und mehr Wasser an Kommunen zurückgeben, als es für den direkten Betrieb seiner Rechenzentren verbraucht.

Nicht nur Anbieter wie AWS, auch Kunden können bei der Nutzung von Systemen mit Künstlicher Intelligenz erhebliche Effizienzreserven heben. Ein zentraler Hebel liegt in der Wahl des am besten geeigneten Modells für die jeweilige Anwendung. Denn je größer und komplexer die Rechenmodelle, desto mehr Ressourcen werden benötigt. Wer generative KI nachhaltig nutzen möchte, sollte daher stets die kleinste mögliche Modell-Variante wählen und nur bei Bedarf ein größeres Modell einsetzen. Mit Amazon Bedrock können Kunden auf eine Vielzahl von Sprachmodellen zugreifen, um diese flexibel und regelmäßig an ihre Anforderungen anzupassen. Einige Modelle können in Bedrock direkt mit eigenen Daten nachtrainiert werden.

Mit KI und Cloud Computing kann die Nachhaltigkeit gesteigert werden.

In vielen Fällen lassen sich die Anforderungen mit spezialisierten Modellen effizienter erfüllen als mit generischen Universalmodellen. Der Dienst Amazon SageMaker unterstützt Unternehmen dabei, eigene maßgeschneiderte Lösungen zu trainieren und bereitzustellen – etwa für Chatbots, Zeitreihenvorhersagen oder die prädiktive Wartung.

In Anwendungsbereichen wie Betrugserkennung, Risikobewertung oder vorausschauender Wartung haben sich Dienste für Maschinelles Lernen (ML) bewährt, die weniger ressourcenintensiv als LLMs sind. Beispiele sind Amazon Rekognition für die Bilderkennung oder Amazon Transcribe für die Audiotranskription.

Außerdem können Kunden Richtlinien und Frameworks von AWS nutzen, um ihre Nachhaltigkeitsziele zu erreichen, wie das „AWS Cloud Adoption Framework for Artificial Intelligence, Machine Learning, and Generative AI“ zum Optimieren von KI-Anwendungen oder das „AWS generative AI best practices framework v2“ mit dem Fokus auf Sicherheit und verantwortungsvolle KI.

Mehr unter: https://voge.ly/AWS-Nachhaltigkeit/

Autor: Heidi Schuster

Künstliche Intelligenz und Cloud Computing eröffnen zweifellos Möglichkeiten, die Nachhaltigkeit zu steigern. Praxisbeispiele aus verschiedenen Branchen zeigen, wie generative KI-Systeme den Ressourcenverbrauch senken und Emissionen reduzieren können. Doch die Technologien sind auch ressourcenintensiv. Unternehmen müssen daher abwägen, welche KI-Lösung den spezifischen Anforderungen am besten gerecht wird und am effizientesten arbeitet. Dabei ist generative KI nur eines von

vielen verfügbaren KI-Werkzeugen. Viele Anforderungen können mit herkömmlichen KI-Diensten effizienter umgesetzt werden. Der Einsatz von generativer KI empfiehlt sich für Anwendungen, die die Fähigkeit erfordern, riesige Datenmengen zu analysieren, Muster zu erkennen, Dokumente zusammenzufassen oder Fragen zu beantworten. Frameworks und Guidelines unterstützen Kunden, die richtigen Dienste für den jeweiligen Anwendungsfall zu wählen und Architekturen nachhaltig umzusetzen.

Mit seinem Konzept der „Responsible AI“ integriert AWS verantwortungsvolle KIPraktiken in den gesamten Lebenszyklus von KI-Anwendungen. Der klare Fokus auf Bildung, Wissenschaft und die Bedürfnisse der Kunden fördert nicht nur Innovationen, sondern stellt auch sicher, dass ethische Standards eingehalten werden.

Künstliche Intelligenz hat das Potenzial, unsere Arbeits- und Lebensweise grundlegend zu verändern. Mit der zunehmenden Verbreitung und Leistungsfähigkeit von KI-Technologien wächst jedoch auch das Bewusstsein für mögliche Risiken. Die Gefahr falscher, unangemessener oder voreingenommener Inhalte, eine potenzielle Preisgabe vertraulicher Informationen oder mangelnde Transparenz bei der Generierung von Informationen sorgen für Diskussionen. Bedenken hinsichtlich Datenschutz, Fehlinformationen und mangelnder Vertrauenswürdigkeit von Daten halten einige Unternehmen davon ab, ihre Geschäftsmodelle mit KI weiterzuentwickeln.

Mit über 100.000 Kunden im KI-Bereich zählt AWS zu einem der führenden Anbieter von KI-Lösungen. Die Entwicklung ethisch vertretbarer KI-Modelle und der verantwortungsvolle Umgang mit KI-Lösungen gehört zu den Kernelementen der Strategie. AWS verfolgt einen „menschenzentrierten Ansatz“. Der Fokus liegt auf der Schaffung vertrauenswürdiger, sicherer und inklusiver KI-Lösungen, die technologische Innovation und ethische Prinzipien gleichberechtigt nebeneinanderstellen. Das Konzept der „Responsible AI“ von AWS umfasst acht Kerndimensionen (siehe Kasten S. 28).

AWS hat in den vergangenen Jahren eine Reihe von Tools und Ressourcen entwickelt, die beim Verständnis und der verantwortungsvollen Implementierung von KI in Unternehmen helfen:

• „Responsible AI Policy“: Das Dokument bietet einen Rahmen für die verantwortungsvolle Entwicklung von KI-Anwendungen. Es enthält Richtlinien zur Verhinderung von KI-Missbrauch wie die Verbreitung von Desinformation oder die Schädigung von Personen sowie zur Einhaltung ethischer Standards. Die Policy verbietet unter anderem die Nutzung von AI/MLDiensten für absichtliche Täuschung, Verletzung der Privatsphäre oder eine unautorisierte Darstellung von Personen.

• „Responsible Use of Machine Learning Guide“: Der Leitfaden gibt detaillierte Empfehlungen für die verantwortungsvolle Entwicklung und Nutzung von ML-Systemen. AWS betont, dass die Nutzung von ML-Systemen stets im Einklang mit Gesetzen, Menschenrechten und Werten wie Gleichberechtigung, Datenschutz und Fairness stehen muss. Darüber hinaus bietet der Leitfaden praktische Anleitungen für die Entwicklungs-, Bereitstellungs- und Nutzungsphase innerhalb des ML-Lebenszyklus.

Im digitalen Zeitalter ist eine leistungsstarke und moderne IT-Infrastruktur unerlässlich für den Erfolg von Unternehmen. Um wettbewerbsfähig zu bleiben und Prozesse kontinuierlich zu optimieren, investieren Unternehmen stetig in neue Technologien. Doch was geschieht mit der „alten“ Hardware, wenn sie durch neue Lösungen ersetzt wird? Hier setzt das IT-Remarketing von Bechtle an und bietet eine nachhaltige Lösung, die sowohl ökologisch als auch ökonomisch überzeugt.

Bechtle bereitet gebrauchte Server und IT-Komponenten professionell auf und vermarktet sie erneut. Dadurch wird der Lebenszyklus der Hardware verlängert und die Umwelt geschont. Diese nachhaltige Initiative reduziert den Bedarf an neuen Geräten, senkt den Verbrauch seltener Rohstoffe und verringert den Energieverbrauch bei Produktion und Entsorgung. Gleichzeitig garantiert Bechtle IT-Remarketing höchste Datensicherheit durch eine BSI-konforme Datenlöschung. Damit können Unternehmen sicher sein, dass ihre sensiblen Informationen geschützt und gesetzeskonform behandelt werden.

Nachhaltigkeit in der IT bedeutet jedoch nicht nur den verantwortungsvollen Umgang mit vorhandener Hardware, sondern auch die Modernisierung der digitalen InLösungen ins Spiel. Bechtle verbindet die Verlängerung des Hardware-Lebenszyklus mit der Einführung moderdabei, ihre IT-Landschaft zukunftsfähig zu gestalten –insbesondere mit Amazon Web Services (AWS)

Bechtle

Ihr Partner für IT-Remarketing und professionelle Unterstüt-

AWS bietet für jedes Szenario den optimalen Service, moderner Unternehmen. Ob klassische virtuelle Ma-

Anwendungen mit AWS Lambda: Jede dieser Lösungen ermöglicht eine , die gleich den Verwaltungsaufwand minimiert.

Moderne Applikationsbereitstellung erfordert heute mehr als nur eine robuste Infrastruktur. Mit DevOps-

. Bechtle setzt auf Automatisierung mit AWS-basierten Tools, um den Entwicklungszyklus zu beschleunigen und die Bereitstellung schnellere Markteinführung, reduzierte manuelle Fehler und optimierte Ressourcennutzung.

legt Bechtle Clouds volle Kostenkontrolle und intuitive Verwaltung sind zentrale Bestandteile des Angebots im Bechtle

das Bechtle Competence Center AWS Professional Services angeboten, die eine präzise Planung und zielgerichtete Implementierung der Infrastruktur ermöglichen und Kunden optimal auf zukünftige Herausforderungen vorbereiten. Abgerundet wird die ganzheitliche Kundenbetreuung vom Managed

Das AWS-Portfolio bietet zudem Services, die bei der verantwortungsvollen Entwicklung und Implementierung von KI-Modellen unterstützen.

• „Guardrails for Amazon Bedrock“: Der Service ermöglicht Unternehmen, maßgeschneiderte Regeln zur Vermeidung unerwünschter Themen zu definieren. Der Dienst erkennt und blockiert automatisch Abfragen und Antworten, die in eingeschränkte Kategorien fallen, hilft Halluzinationen zu erkennen und kann auch für Modelle außerhalb von AWS genutzt werden.

• „Model Evaluation for Amazon Bedrock“: Der Service bietet Unterstützung bei der Auswahl des für einen spezifischen Einsatzzweck am besten geeigneten KI-Modells.

• „Amazon Titan Image Generator“: Das KI-Bildgenerierungsmodell integriert mehrere Maßnahmen, die einen ethischen und sicheren Einsatz gewährleisten sollen. Um problematische oder einseitige Bildinhalte zu vermeiden, wurde der Generator mit hochwertigen und vielfältigen Datensätzen trainiert. Das System entfernt schädliche Inhalte in den Trainingsdaten und lehnt unangemessene Benutzereingaben automatisch ab. Alle von Amazon Titan generierten Bilder enthalten zudem standardmäßig ein unsichtbares Wasserzeichen, um die Verbreitung von Desinformationen einzudämmen.

• „Amazon SageMaker Clarify“: Indem der Service dabei hilft, Verzerrungen sowohl in den Trainingsdaten und als auch im Modell selbst zu erkennen, kann er ML-Modelle transparenter machen. Denn nur ML-Modelle, die als fair und unvoreingenommen wahrgenommen werden,

genießen das Vertrauen von Entwicklern und Endanwendern. Der Service liefert Erklärungen für die Entscheidungen und Vorhersagen von ML-Modellen.

Für viel Transparenz sorgt AWS mit elf verschiedenen „AI Service Cards“, die Kunden dabei unterstützen sollen, die AI-Services von AWS besser zu verstehen. Die Karten bieten Informationen über spezifische KI-Services und erklären geeignete Anwendungsfälle sowie mögliche Einschränkungen. Unternehmen erhalten detaillierte Informationen, in welchen Situationen der Service am besten funktioniert oder nicht geeignet ist. Zudem geben die Service Cards konkrete Hinweise, wie die Services verantwortungsvoll eingesetzt werden können und stellen Best Practices für die Implementierung und den Betrieb zur Verfügung.

AWS engagiert sich darüber hinaus in Organisationen wie den KI-Arbeitsgruppen der OECD, der Partnership on AI und dem Responsible AI Institute. Durch Forschungsstipendien und Programme fördert AWS aktiv die Forschung von verantwortungsvoller KI-Nutzung. Programme wie das „AI & ML Scholarship Program“ fördern die Ausbildung einer vielfältigen nächsten Generation von KI-Führungskräften. Die „AI Ready“Initiative, die das Ziel verfolgt, bis 2025 zwei Millionen Menschen weltweit kostenlose Schulungen für eine verantwortungsvolle und sichere Nutzung von KI anzubieten, wurde zudem um neue Trainingsangebote erweitert.

Autor: Ulrike Garlet

• Fairness – Berücksichtigen der Auswirkungen auf verschiedene Stakeholder

• Erklärbarkeit – Verstehen und Bewerten von Systemausgaben

• Sicherheit – Verhindern von schädlichen Systemausgaben und Missbrauch

• Datenschutz – Daten und Modelle auf angemessene Weise beschaffen, nutzen und schützen

• Steuerbarkeit – Mechanismen zur Über wachung und Steuerung des KI-Verhaltens

• Richtigkeit und Robustheit – Erzielen korrekter Systemausgaben, auch bei unerwarteten oder widersprüchlichen Eingaben

• Governance – Prozesse zur Definition, Umsetzung und Durchsetzung verantwortungsvoller KI-Praktiken innerhalb einer Organisation

• Transparenz – Interessensvertretern ermöglichen, fundierte Entscheidungen über ihre Zusammenarbeit mit einem KI-System zu treffen

Nahezu 70 % der Unternehmen schöpfen das Potenzial ihrer Daten nicht au s Mit KI , AW S Bedrock und SageMaker s teigern Sie Ihre Produk tivit ät und las sen die Konkurrenz hinter sich. Unsere Lösungen helfen Ihnen, datenbasier te Ent scheidungen zu tref fen, Kos ten zu senken und neue Mark tchancen zu erschließen. Nut zen Sie die Kraf t von KI , GenAI und Cloud -Technologien, um Ihre Prozes se zu optimieren und innovative Geschäf t smodelle zu ent wickeln. So bleibt Ihr Unternehmen wet tbewerbs fähig und zukunf t s sicher Jet z t Kontak t aufnehmen und Ihre Datens trategie auf das nächs te Level bringen!

In Zeiten ständig wachsender Datenmengen und datengetriebener Entscheidungsprozesse werden herkömmliche ETL-Pipelines zunehmend zum teuren Bremsklotz. Angekündigt zur re:Invent 2022, werden AWS-Dienste zunehmend mit „Zero-ETL“-Fähigkeiten erweitert. Was steckt hinter dem Konzept, in welchen Services ist es schon heute integriert und wem hilft es?

ETL – Extract, Transform, Load ist das traditionelle und nach wie vor weit verbreitete Konzept zur Überführung von Daten aus verschiedenen operativen Datastores, häufig relationalen Datenbanken, in ein Data Warehouse. Die Daten werden hierbei meist in nächtlichen Batch-Läufen aus den Quellsystemen gelesen, in ein einheitliches und analysefreundliches Schema transformiert und schließlich in das Data Warehouse geladen, wo sie in einem abfrageoptimierten Format abgelegt werden. Doch mit wachsenden Datenmengen und dem Wunsch nach Echtzeitanalysen stoßen diese Prozesse an ihre Grenzen. Unternehmen sind dabei mit drei Hauptproblemen konfrontiert: der Komplexität der Einrichtung und Pflege von ETLPipelines, der Latenz durch Batch-Verarbeitung und den hohen Kosten, die durch die notwendige Infrastruktur entstehen.

Bereits seit 2017 stellt AWS mit Amazon Athena verschiedene Konnektoren wie JDBC und dem AWS Glue Data Catalog einen ETL-freien Ansatz zur Datenanalyse mittels SQL über mehrere Datastores wie Amazon S3 und relationale Datenbanken hinweg bereit. Während diese „Federated Query“-Methode für weniger komplexe Analysen oder für Datenexploration gut geeignet ist, stößt sie hinsichtlich Performance und Kosten schnell an gewisse Grenzen, sobald die Datenquellen nicht für analytische Abfragen optimiert sind.

Und hier kommt Zero-ETL ins Spiel: Das Prinzip besteht in einer kontinuierlichen Replikation von Daten aus operativen Datastores in analytische Datastores mit minimalem Konfigurations- und Wartungsaufwand. Die Replikation erfolgt in der

Regel binnen weniger Sekunden, so dass die Daten Anwendern nahezu in Echtzeit für Analysezwecke zur Verfügung stehen. Dieses sogenannte Change-Data-Capture-Pattern ist für sich genommen nicht neu, benötigte in der Vergangenheit aber üblicherweise spezialisierte Tools oder Streaming-ETL-Plattformen. Die Batch-Charakteristik herkömmlicher ETL-Prozesse konnte so zwar eliminiert werden, Nachteile wie der hohe Konfigurations- und Betriebsaufwand sowie Infrastruktur- und Lizenzkosten blieben jedoch bestehen.

Die genannten Nachteile adressiert AWS mit der Idee von Zero-ETL zwischen verschiedenen AWSDatendiensten. Dieses Ziel wurde auf der AWS re:Invent 2022 öffentlich gemacht und mit der nahtlosen Integration zwischen zwei gemanagten Services vorgestellt: Daten aus Amazon Aurora, einem relationalen Datenbank-Service, werden direkt zu Amazon Redshift, dem gemanagten Data Warehouse Service, repliziert. Seitdem werden mehr und mehr Services um Zero-ETL-Integrationen erweitert – so waren es zuletzt die Integration von Amazon DocumentDB mit Amazon OpenSearch Service im Mai 2024 und Amazon RDS for MySQL mit Redshift im September 2024. Benötigt man mehr Kontrolle zur Sicherstellung der Datenqualität (Konsistenz, Vollständigkeit, Korrektheit) oder zur Transformation der Daten, kann es sinnvoll sein, Zero-ETL und klassische ETL-Pipelines etwa mit AWS Glue zu kombinieren, um alle Anforderungen zu erfüllen.

Amazon Redshift ist ein gemanagter Cloud Data Warehouse Service für Analysen großer Datenmengen und hat in Sachen Zero-ETL den Anfang

KÄRCHER CASE