Your Agilent Cell Imaging Just Got Brainy

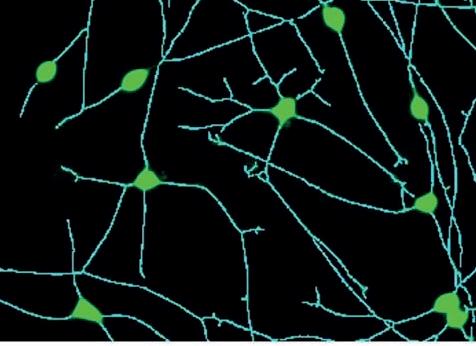

New Neurite Outgrowth Analysis for Agilent BioTek Imagers

Agilent BioTek Gen5 Neurite Outgrowth Module for Agilent BioTek Cytation and Lionhear t Imagers

The new Agilent BioTek Gen5 neurite outgrowth module delivers the ability to analyze neuronal cell dynamics from fluorescently-labeled or label-free cell images captured in end point or kinetic workflows.

New Oppor tunities for Neuroscience Researchers

The Gen5 neurite outgrowth module suppor ts research in neuropathology, developmental biology, neurotoxicity screening, and regenerative medicine. The module is compatible with Gen5 Image Prime software for use with BioTek Lionhear t automated microscopes, Cytation C10 confocal imaging reader, and Cytation cell imaging multimode readers.

Learn more at https://aglt.co/maFH

Key Metrics Provided by the Gen5 Neruite Outgrowth Module

• Soma count

• Total neurite length (μm)

• Average neurite length (μm)

• Total neurite branches

• Average neurite branches

• Total neurite area (μm2)

• Neurite thickness (μm)

• Neurite count

• Average neurite count

Agilent BioTek Cytation C10 confocal imaging reader

Agilent BioTek Cytation 7 cell imaging multimode reader

Agilent BioTek Lionhear t FX automated microscope

Neurite images are skeletonized to calculate impor tant metrics.

IMAGEN PORTADA

Número 222

DICIEMBRE 2024

SEBBM es una publicación periódica de la Sociedad Española de Bioquímica y Biología Molecular © SEBBM. Los artículos y colaboraciones reflejan la opinión de sus autores y no necesariamente la opinión de la SEBBM. Se autoriza la reproducción del contenido, siempre que se cite la procedencia.

Sociedad Española de Bioquímica y Biología Molecular C/ Ramiro de Maeztu, 9 28040 Madrid

Telf.: +34 681 916 770 e-mail: sebbm@sebbm.es http://www.sebbm.es

Directora: Inmaculada Yruela Guerrero

Director honorario: Joan J. Guinovart

Directora adjunta: Ana Mª Mata

Consejo editorial: Antonio Ferrer Montiel, Isabel Varela Nieto, Vicente Rubio, Federico MayorMenéndez, Miguel Ángel de la Rosa.

SECCIONES:

Entrevista y Política

científica: Ismael Gaona Pérez

Investigación: Joaquim Ros

Educación universitaria: Ángel

Herráez

Reseñas de libros: Juli Peretó

Sociedad: Carmen Aragón

Empresas: María Monsalve

Coordinación del número 222: Ana María Rojas Mendoza

Diseño: Filoestudio

Depósito legal: M-13490-2016

ISSN: 1696-4837

TRIBUNA

El próximo cuatrienio

Antonio Ferrer

EDITORIAL

Nueva etapa de la mano de la IA

Inmaculada Yruela Guerrero

DOSIER CIENTÍFICO

La Inteligencia artificial en Biociencias

Ana María Rojas Mendoza

La Inteligencia artificial como motor de la medicina de precisión: predecir y explicar para simular

Lucía Sánchez García, Inés Rivero, Fátima Sánchez-Cabo

La revolución de la Inteligencia artificial en la biología estructural de proteínas

Pablo Chacón Montes

Inteligencia Artificial Generativa (GenAI) para diseñar genomas de organismos digitales

Francisco J. Borrallo-Vázquez y Miguel A. Fortuna

Anotación de función en proteínas usando modelos de lenguaje

Ana M. Rojas Mendoza, Ildefonso Cases, Gemma MartinezRedondo, Rosa Fernández

ENTREVISTA

Izaskun Lacunza. Directora general de la FECYT

Ismael Gaona

POLÍTICA CIENTÍFICA

Vocaciones: la crisis silenciosa

Ismael Gaona

A FONDO

Los Premios Nobel de Física y de Química de 2024

Javier Sancho

EDUCACIÓN UNIVERSITARIA

¿Podemos mejorar nuestros pósteres? ¡Sí, podemos!

Carlos Gancedo

Resumen y consideraciones finales extraídas del simposio de educación en el marco del 46º congreso de la SEBBM

Marina Lasa

INVESTIGACIÓN

Joaquim Ros

IN MEMORIAM

Antonio Sillero (1938-2024)

Carlos Gancedo

Claudio Fernández de Heredia

SOCIEDAD

Noticias de actualidad de la SEBBM

RESEÑA DE LIBROS

Hay biología (y mucha) más allá del ADN

Víctor de Lorenzo

PUBLIRREPORTAJES

Agilent

Controltécnica

Condalab

Ecogen Kühner

Aplitech

Proquinorte

Antonio Ferrer

Presidente SEBBM

El próximo cuatrienio...

Comienzo mi primera tribuna desde la presidencia de la SEBBM con el empeño de asentar la labor realizada por Isabel Varela que ha promovido una plétora de acciones en la gestión, así como en la visibilidad nacional e internacional de la SEBBM, y en su influencia social. Por destacar algunos logros, el primero sería la modernización de la web, complementada este año con la publicación del blog, una herramienta de divulgación de los socios y para los socios y al que todos debiéramos contribuir. Otra acción destacable ha sido el establecimiento de acuerdos con las Reales Academias Nacionales de Farmacia (RANF), Ciencias Naturales y Exactas (RAC) y de Medicina (RANM) para la realización de conferencias y actos conjuntos. En 2024, hemos disfrutado de las conferencias impartidas por Vicente Rubio en la RANF y de Isabel Fariñas en la RAC, así como de la semana Severo Ochoa en la RANM, co-organizada por la Fundación Carmen y Severo Ochoa (FCySO) y la Universidad de Nebrija, con las conferencias de Vicente Rubio, Federico Mayor y María Blasco. Además, y también junto con la FCySO se realizó la 2ª Conferencia Severo Ochoa en Bilbao coordinada por María Ángeles Serrano, y organizada por Rosa Barrio, Alicia Alonso y Nerea Osinalde. Por último, quiero destacar la excelencia del 46º Congreso SEBBM organizado por María Mayán en Coruña. Hemos disfrutado de una agenda intensa e interesantísima fruto de la amplia labor de la anterior junta directiva. No menos importante ha sido la excelente gestión en la tesorería que ha potenciado la salud económica de la SEBBM que permitirá abordar, con cierta tranquilidad, los objetivos y acciones del próximo cuatrienio.

En la nueva junta, que tomó posesión el pasado septiembre, me acompañan Irene Díaz Moreno como vicepresidenta, Lluís Montoliu como secretario, María Monsalve como tesorera, Lourdes Ruiz como secretaria-electa, y en las vocalías, Guadalupe Sabio en cónsules y mujer y ciencia, Raúl Estévez en mentoría y comunicación, Sara García en jóvenes y educación, Patricia González en congresos y talleres, Patricia Aspichueta en grupos, y Marina García en socios protectores y

patrocinadores. Además, como co-optados tenemos a Isabel Varela (expresidenta), Inmaculada Yruela (directora de la Revista SEBBM), y Marina Tapias (coordinadora de la sección junior). Marina García sustituye a María Ángeles Almeida que ha sido nombrada coordinadora de programas del ISCIII y a la que le damos todo nuestro apoyo para una gestión exitosa.

La nueva junta entra con la energía y la ilusión de impulsar en el próximo cuatrienio un incremento del número de socios en todas sus categorías, la consolidación y la expansión de las relaciones Institucionales e Internacionales, y el fortalecimiento e internacionalización de los congresos SEBBM. Además, también nos marcamos como meta promover una participación más activa de los jóvenes en los congresos a través del apoyo a las iniciativas de la sección junior, fortalecer las acciones y reuniones de los grupos científicos, consolidar la conferencia Severo Ochoa para la excelencia científica, facilitar la formación transversal de nuestros jóvenes investigadores, y fomentar estrategias y herramientas de apoyo para la transferencia y/o traslación de los resultados de los socios SEBBM.

Un logro por destacar, y para el que vamos a trabajar intensamente los próximos años, es la organización del Congreso FEBS-IUBMB-SEBBM en el año 2030 al haber sido mayoritariamente apoyada la propuesta presentada por Isabel Varela e Irene Díaz en el congreso IUBMB 2024 en Melbourne. Cabe recordar que este congreso lo organizó la SEBBM en Sevilla en 2012 bajo la presidencia de Miguel Ángel de la Rosa y fue todo un éxito en la proyección y reconocimiento internacional de nuestra sociedad. Confiamos en cosechar un éxito similar en 2030. En cuanto a la sede, existen dos candidaturas Madrid y Sevilla cuya decisión final está condicionada a una auditoria de las infraestructuras locales por parte de IUBMB y FEBS en 2025.

Una de las primeras acciones que ha tomado la nueva junta directiva ha sido promover la constitución de la Fundación SEBBM (FSEBBM) con el objetivo de acercar la SEBBM a la sociedad, impulsando proyectos de mayor ámbito social, tanto a nivel de divulgación social de la ciencia como de formación e información del público en general. Además, la creación de una Fundación facilita la canalización y gestión de donaciones de nuestros socios, de entidades privadas y, de la gente en general. Esta iniciativa ha surgido debido a que la SEBBM no es reconocida como una asociación de interés público lo que limita su capacidad para obtener donaciones fiscalmente deducibles. Los objetivos fundacionales establecidos son: (i) favorecer el contacto y la interacción científica en el ámbito de la bioquímica y la biología molecular, así como una interacción interdisciplinar; (ii) potenciar la investigación y mejorar la docencia y la cultura científica en el campo de las biociencias; e, (iii) impulsar la divulgación más amplia y profunda sobre aquellos aspectos sociales y científicos de las biociencias a la sociedad. Para alcanzar estos objetivos se establecerán diversas acciones que permitirán acercar el progreso en el ámbito de la bioquímica y la biología molecular y, en general, de las biociencias al público. A su vez, se establecerán programas para fomentar el interés de los jóvenes por esta rama del conocimiento.

Iniciamos esta etapa con la intención de impulsar el crecimiento de la SEBBM. Una acción esencial para alcanzar este objetivo es nuestro congreso anual. Quiero recordar que en 2025 el congreso será en Cáceres del 2 al 5 de septiembre bajo la presidencia de Guadalupe Sabio, en una magnífica sede como es el Complejo Cultural San Francisco y la ciudad de Cáceres, y con un programa de excelencia que se está elaborando gracias a las propuestas de simposios que ha recibido el comité organizador. Además, siendo conscientes de la importancia de las reuniones de grupo, vamos a priorizar que todos los grupos tengan su espacio y tiempo durante el congreso. ¡Os esperamos en Cáceres!

Inmaculada

Yruela Guerrero

Directora Revista SEBBM

Nueva etapa de la mano de la IA

Con el número de diciembre de 2024 inicio, con ilusión, mi etapa como directora de la Revista SEBBM. Agradezco a Antonio Ferrer, ahora presidente de la Sociedad, a Ana Mª Mata, directora adjunta y al comité editorial, la confianza que han depositado en mí para continuar esta empresa. El camino, primero emprendido y luego continuado con empeño, ingenio y maestría, por los que me precedieron -Carlos Gancedo, Joan Guinovart, Miguel Ángel de la Rosa, Antonio Ferrer-, invita a proseguirlo con renovado empeño. También agradezco el apoyo y colaboración de los responsables de las diferentes secciones de la revista que continúan al frente: Carmen Aragón, Ángel Herráez, María Monsalve, Juli Peretó, Joaquim Ros, Ismael Gaona.

Tal como mostraba la exposición Revista SEBBM: un observatorio de la actividad y política científicas en España, presentada el pasado año con motivo del sexagésimo aniversario de la SEBBM en el Congreso de Zaragoza, la revista ha tenido diferentes etapas desde que empezó a rodar en 1963 –circulares, boletines, revista-. Cada una de ellas vino acompañada de un cambio en el diseño y en los contenidos. Hoy, la renovada Revista SEBBM también incorpora novedades –cambio en el diseño de la portada, rotulación, maquetación y publicación-. A partir de ahora la revista se publica sólo en formato digital, accesible a través de nuestra web https://sebbm.es/revista/. Terminamos el año conociendo los galardonados con los Premios Nobel en Fisiología o Medicina, en Física y en Química. Tres premios que reconocen investigaciones de gran impacto científico y social, muy ligadas a la actividad que realizan grupos de socias y socios SEBBM. Y dos de ellos especialmente conectados con este número de diciembre, dedicado a la ‘Inteligencia artificial en Biociencias’ cuyo dosier ha coordinado Ana Mª Rojas, investigadora del CSIC en el Centro Andaluz de Biología del Desarrollo (CABD). Al encargar el dosier, por cierto, no se conocía el fallo de los premios, pero éramos muy conscientes de la actualidad e importancia del tema. Los premios Nobel 2024 en Física y en Química reconocen trabajos que sientan las bases para el

aprendizaje de las computadoras, necesarias para el desarrollo de la ‘Inteligencia artificial’ (IA), y que han conducido al diseño computacional de proteínas, y a la predicción de estructuras proteicas con su ayuda. Os invito a leer el análisis de Javier Sancho sobre este tema en la sección ‘A Fondo’.

Los trabajos de los galardonados han demandado grandes dosis de creatividad, ingenio y audacia, a la vez que profundos conocimientos básicos. Y también importantes dotes para la comunicación de los resultados y de los logros que han ido consiguiendo. Este es un aspecto fundamental para captar los recursos necesarios para la investigación y para atraer el interés de la comunidad científica. La comunicación de calidad es una herramienta esencial para aumentar el impacto de las investigaciones, establecer redes de colaboración y, en el caso del desarrollo de aplicaciones, conseguir fieles usuarios de las mismas. El artículo de Carlos Gancedo en la sección ‘Educación’ da un toque de atención sobre algunas cuestiones prácticas relacionadas con ello.

Todo esto me lleva a reflexionar sobre la importancia de la interdisciplinariedad, la comunicación y la divulgación en la actividad científica, dado que también estas tienen un aspecto social. La comunicación científica es cultura. El modo de relacionarnos ha cambiado vertiginosamente en la última década. No somos sólo individuos sociales, sino individuos socio-tecnológicos, estrechamente vinculados a las tecnologías digitales, de las que dependemos quizá demasiado. Ya se ha acuñado la expresión Homo digitalis. Nuestra realidad, actividad, comportamiento e interacciones se están transformando en información cuantificable (datos) que pueden ser medidos, analizados y explotados. La ‘Inteligencia artificial’ ha comenzado a alterar esa interdependencia. Los cambios nos están obligando a rediseñar las estrategias de comunicación y divulgación, y nos hacen reflexionar sobre si realmente nuestros mensajes llegan de forma fiable a los destinatarios finales y cumplen su objetivo.

¿Hay sobresaturación de canales y mensajes? Es patente que el trabajo científico y la transferencia de resultados se están viendo beneficiados de la era digital y de la IA. Pero también hay incertidumbres y cuestiones éticas que resolver. ¿Se ve afectada la autoría, la creatividad, la responsabilidad o la veracidad de los resultados y mensajes?

La proliferación de bulos y noticias falsas es una amenaza importante para la sociedad. También se cuestiona la neutralidad de los productos basados en IA y sus sesgos. Los gobiernos europeos no son ajenos a estas cuestiones. Para regular su uso, en abril de 2021, la Comisión Europea propuso el primer marco regulador de la UE para la IA, y el 12 de julio de 2024 se publicó la “Ley de Inteligencia Artificial” que entró en vigor el 1 de agosto. La Ley está diseñada para garantizar que el desarrollo de la IA y utilización en la UE sea fiable y proteja los derechos fundamentales de las personas.

La comunidad científica, así como las academias, fundaciones y sociedades científicas, incluida la SEBBM, realizan un gran esfuerzo para canalizar actividades fiables de difusión de la ciencia y del conocimiento científico actual que lleguen a todo tipo de público, tanto especializado como público general. Es todo un reto adaptarse a estos nuevos tiempos.

No puedo terminar esta editorial sin expresar mi dolor y tristeza por las consecuencias y personas fallecidas a causa de la DANA que tan trágicamente ha afectado a la Comunitat Valenciana, y a otras comunidades, los últimos días del pasado octubre. Mucho ánimo a los que os habéis visto afectados.

LA INTELIGENCIA ARTIFICIAL EN BIOCIENCIAS

Ana María Rojas Mendoza

Centro Andaluz de Biología del Desarrollo (CABD), CSIC, Sevilla. Grupo de Biología Computacional y Bioinformática. (Conexión BCB.Hub)

Biología e Inteligencia artificial (IA) han sido socios reticentes: cada uno va a lo suyo. Como en un mal baile, han interactuado sin coordinación y a ritmos diferentes. La Biología es sutil, subjetiva y cambiante, moviéndose en un contexto donde la excepción es quizá la regla. En contraste, la IA es una máquina insaciable que requiere grandes volúmenes de datos, homogéneos y estructurados. Con datos tan escasos y variables… ¡es difícil que la danza funcione!

Sin embargo, existen esos espacios de encuentro donde ambas pueden alinearse. En el campo de la biología computacional, de hecho, la IA ha estado presente desde hace décadas. La IA se ha empleado en tareas como la clasificación de secuencias biológicas (proteínas, ADN), destacando en la predicción de estructuras secundarias de proteínas. Desde su incepción en la década de los 80, C. Sander junto a B. Rost la re-implementó en redes neuronales para el mismo propósito. Desde entonces estas metodologías forman parte del arsenal metodológico de la bioinformática.

La IA incluye tanto las técnicas

tradicionales de aprendizaje automático (Machine Learning, ML) como las más avanzadas de aprendizaje profundo (Deep Learning, DL). La aplicación más común y recomendada de estas técnicas es en su modalidad “tradicional”, es decir, sin el uso de redes neuronales, para construir clasificadores supervisados (como la detección de “cáncer/no-cáncer”) o identificar patrones en conjuntos de datos no supervisados (como los genes sobre-expresados). Estas aplicaciones han tenido éxito y han contribuido al desarrollo de herramientas analíticas útiles.

Las técnicas de DL, por otro lado, requieren grandes volúmenes de datos (millones de puntos de datos, con miles de descriptores para cada punto) y requieren infraestructura de hardware especializada, como unidades de procesamiento gráfico (GPU), para realizar los cálculos necesarios. Un ejemplo típico de aplicación de DL es el análisis de imágenes, donde esta tecnología prospera.

En comparación con otros sectores (como el financiero), la IA ha llegado tarde al campo de la Biología, principalmente debido a la falta de infraestructura

tecnológica y personal especializado fuera de la industria. La formación de estos expertos requiere supervisión de personal competente, lo que se ha convertido en un cuello de botella en el desarrollo de la IA en este ámbito. Incluso si contáramos con la infraestructura y el conocimiento necesarios, la disponibilidad de datos seguiría siendo un factor limitante.

No todas las áreas de la Biología pueden beneficiarse igualmente de los avances en estas técnicas. La disparidad en la disponibilidad de datos es significativa. Por ejemplo, en UniprotKB hay disponibles unos 280 millones de secuencias de proteínas, pero sólo se han curado unas 848.000 interacciones en ~143.000 proteínas, según IntAct. Esto convierte a UniprotKB en un buen escenario para usar IA, gracias a las técnicas de secuenciación masiva, mientras que IntAct no es tan adecuado.

Es innegable que la IA ha demostrado un potencial transformador único, como lo demuestra la concesión del Premio Nobel de Química 2024 al diseño de proteínas artificiales funcionales y a los algoritmos de IA para la

predicción de estructuras terciarias de proteínas. Estos métodos avanzados han llegado para quedarse y evolucionan a un ritmo exponencial. Cada semana se publican nuevos modelos, incluidos modelos fundacionales y modificados. Entre ellos, los modelos de lenguaje para proteínas, derivados del procesamiento del lenguaje natural (NLP), han demostrado ser especialmente poderosos, como hemos presenciado en el último ejercicio de evaluación de métodos de predicción de función (CAFA5) presentados en ISMB2024. De entre los 10 mejores, 9 se basan en modelos de lenguaje.

Sin embargo, estos métodos presentan desafíos importantes. La escalabilidad de la producción de datos para entrenar modelos fundacionales sigue siendo un problema, y la interpretabilidad de estos modelos —auténticas “cajas negras”— ha dado origen a un campo emergente: la Inteligencia Artificial Explicativa (XAI, por sus siglas en inglés).

En conclusión, la IA está aquí para quedarse y su poder transformador será cada vez más evidente. No obstante, ¿Podremos aprovechar estos avances generados en la industria tecnológica de manera libre y transparente? ¿Queremos repetir situaciones como la de AlphaFold, cuyo código no ha sido liberado para el uso de la comunidad y el beneficio de la sociedad con uso restringido hasta meses después de su publicación?

En este número de la Revista SEBBM, hemos seleccionado cuatro artículos que creemos transmiten el mensaje que queremos compartir.

La Dra. Fátima Sánchez Cabo y sus colaboradoras Lucía Sánchez García e Inés Rivero, del CNIC, presentan aplicaciones de la IA en biomedicina, particularmente en medicina de precisión, e

introducen conceptos de inferencia causal y los avances de la IA generativa y explicativa.

El Dr. Pablo Chacón Montes (coordinador de la conexión CSIC de Biología computacional y Bioinformática, BCB.Hub) del IQF ‘Blas Cabrera’, CSIC, explica cómo la IA ha transformado el ámbito de la bioinformática estructural y describe el desarrollo de los modelos de lenguaje en la predicción de estructuras.

El Dr. Miguel A. Fortuna (BCB. Hub) y su colaborador Francisco J. Borrallo-Vázquez, ambos en EBD, CSIC, describen aplicaciones

de IA generativa en la genómica sintética, en particular para la creación de gemelos digitales usando Redes Generativas Antagónicas (GANs).

Los Drs. Ildefonso Cases (BCB.Hub), Ana Rojas (BCB.Hub), ambos en CABD (CSIC), la Dra. Rosa Fernández (BCB.Hub) y su colaboradora Gemma Martínez Redondo, ambas en IBE, CSIC, describen el problema de la anotación funcional de proteínas y la aplicación de modelos de lenguaje aplicados a proteínas para anotar funciones de genes desconocidos en millones de secuencias.

LA INTELIGENCIA

ARTIFICIAL COMO MOTOR

DE LA MEDICINA DE PRECISIÓN: PREDECIR Y EXPLICAR PARA SIMULAR

Lucía Sánchez García, Inés Rivero, Fátima Sánchez-Cabo

Centro Nacional de Investigaciones Cardiovasculares (CNIC), Madrid

https://doi.org/10.18567/sebbmrev_222.202412.dc1

La curiosidad científica anhela entender cómo funcionan las cosas. La pura predicción, si no somos capaces de entender los mecanismos subyacentes, nos suele dejar insatisfechos. En biomedicina, entender cómo funcionan los organismos es la base para poder proponer nuevas dianas terapéuticas y mejorar los tratamientos, la base para poder prevenir y curar. Los últimos avances en Inteligencia artificial (IA) demuestran cómo precisamente esta metodología puede ser clave para explicar los procesos que subyacen a la transición de la salud a la enfermedad a partir de las grandes cantidades de datos que se están generando, acelerando el conocimiento biomédico hasta cotas antes impensables.

La IA se utilizó inicialmente en biomedicina como elemento técnico para procesar desde imágenes hasta datos de electrocardiogramas. En este año, el premio Nobel a Hassabis y a Jumper (DeepMind) y a Baker ha demostrado que la aplicación de la IA a la biomedicina trasciende a la de ser una mera técnica. Además, el uso de técnicas de IA como agentes inteligentes que ayuden en la toma de decisiones en la práctica clínica es ya una realidad, aunque sigue siendo tomado con cautela, dada la suspicacia que generan las predicciones que no podemos explicar.

En este artículo mostraremos algunos de los últimos avances que demuestran cómo la IA, y en concreto la IA explicativa, se está convirtiendo en uno de los principales motores de la investigación biomédica, haciendo que la medicina de precisión pase de promesa a realidad.

Comenzamos un poco tarde…

Aunque la Inteligencia artificial lleva años utilizándose en banca, marketing o logística, su uso generalizado en biomedicina se retrasó hasta comienzos del siglo XXI. Las razones de este retraso han sido varias:

• En primer lugar, la disponibilidad de las grandes cantidades de datos cuantitativos y exhaustivos a nivel molecular, celular y de organismo en grandes poblaciones, necesarios para entrenar estos sistemas, era una quimera hasta hace poco más de una década. El abaratamiento de las técnicas ómicas, unido a la filosofía de compartición de datos potenciada por las agencias financiadoras, con el fin de maximizar los recursos, ha sido esencial en este cambio. Iniciativas pioneras como The Cancer Genome Atlas (TCGA), the Gene Expression Omnibus (GEO) o el

UK Biobank, por nombrar sólo algunas, han sentado las bases para poder utilizar millones de datos estandarizados en el entrenamiento de algoritmos de aprendizaje máquina en biomedicina.

• La dificultad de acceso a sistemas de computación de alto rendimiento en el entorno de la investigación pública, así como el coste inasumible del personal de administración de estos sistemas, normalmente muy escasos por su alta demanda en otros sectores que ofrecen más estabilidad y mejores condiciones económicas. En este sentido, la gran mayoría de los países ofrecen redes públicas de computación científica, como es el caso de la RES (Red Española de Supercomputación) en nuestro país. Sin embargo, el monopolio y la altísima demanda de los componentes necesarios en

supercomputación, como por ejemplo las graphical processing units (GPU), genera una gran incertidumbre acerca de cómo de realista será el uso de la supercomputación basada en recursos propios en la investigación biomédica pública, con las grandes corporaciones intentando copar este mercado.

• Finalmente, ha existido tradicionalmente una gran desconfianza hacia estas técnicas por parte de la comunidad científica biomédica, tachándolas de “caja-negra” o de “moda”. Esta desconfianza es algo normal, e incluso positiva para garantizar el rigor y la validez de los hallazgos que propicia. Descubrimientos que a menudo son difíciles de evaluar utilizando los controles tradicionales de revisión científica, debido al grado de abstracción que representan y la imposibilidad de revisar todos los desarrollos

en los que se basa de manera exhaustiva y su complejidad técnica. Y a la falta de personal formado en la materia trabajando en investigación biomédica, sobre todo en el sector público. Como en otros ámbitos, su aplicación generalizada tiene que ir de la mano de la definición de un marco ético y legal que está comenzando a clarificarse. Pese a todos estos problemas iniciales, el uso generalizado de la IA en Biomedicina es ya una realidad. Y el futuro es aún más prometedor.

Modelos predictivos para la medicina de precisión: De Mammaprint© a los scores poligénicos

Estratificar a los pacientes y a la población sana en función de su riesgo para mejorar su tratamiento, es uno de los objetivos de la medicina personalizada. La inferencia estadística clásica ha sido la herramienta utilizada para resolver

este problema durante casi un siglo, utilizando distintos tipos de regresión tanto univariante como multivariante. Estos métodos, sin embargo, tienen dificultades en la selección de predictores si existe un gran número de ellos a considerar, sobre todo en situaciones de interdependencia. La "maldición de la dimensionalidad" es un término a menudo utilizado para los modelos predictivos con datos ómicos, en los que el número de predictores (expresión génica o proteica, variantes genéticas, etc.) excede con mucho al número de individuos sobre los que realizar la inferencia. En este contexto, Laura Van´t Veer definió en 2003 en un artículo seminal en el campo la primera firma predictiva de recaída en 117 pacientes con cáncer de mama utilizando datos de expresión génica medida por microarrays. El tamaño muestral, que hoy parece ridículo, fue un hito en aquel momento. La firma estaba compuesta por 70 genes. Poco después, diversos bioinformáticos criticaron la metodología utilizada, dado que era posible encontrar muchos otros conjuntos de 70 genes diferentes con el mismo poder predictivo. Pese a ello, el estudio de Van´t Veer se validó en numerosos contextos clínicos y con un número de pacientes mucho mayor, llegando a convertirse en uno de los primeros casos de diagnóstico genético aprobados por la FDA. Hubo otros trabajos similares en aquella época, como la definición del Immunoscore© para la estratificación de los pacientes con cáncer de colón en base al tipo, la densidad y la localización de los linfocitos T infiltrados en los tumores.

El reducido número de participantes utilizado en estos y otros estudios similares a principios del siglo XX, cuando técnica y económicamente realizar test moleculares a gran escala resultaba muy costoso, demostraron el poder

predictivo de estas herramientas, aunque se necesitaron muchos estudios más para validarlos. Hoy en día, la disponibilidad de grandes cantidades de datos moleculares para grandes cohortes de individuos hace posible definir scores de riesgo de forma mucho más precisa, utilizando metodologías de aprendizaje máquina más robustas. Frente a la estadística clásica, los métodos de aprendizaje máquina como las redes elásticas, las redes neuronales, el gradient boosting o los random forest, ofrecen un marco conceptual más adecuado para la selección automática de los mejores predictores en situaciones de colinealidad. Pese a su potencia, es importante recalcar que estos métodos no pueden aplicarse a cualquier conjunto de datos, y que el “optimismo” en sus predicciones debido al sobreajuste, depende del número de predictores disponibles por cada caso a predecir. En un gran artículo de recomendada lectura, van der Ploeg y colegas utilizaron datos simulados para cuantificar el grado de optimismo en las predicciones de los diferentes algoritmos en base al número de casos por predictor. Actualmente, el uso de los algoritmos de aprendizaje automático utilizando los datos moleculares generados en grandes cohortes potenciados por los gobiernos de todo el mundo (UK Biobank, All of Us, IMPACT, entre otros) está permitiendo mejorar nuestra comprensión de enfermedades complejas, del cáncer a las enfermedades cardiovasculares y neurodegenerativas, siendo una pieza esencial en la medicina de precisión. Como ejemplo, los scores poligénicos (PGS) utilizan modelos de aprendizaje máquina para resumir el fondo genético heredado que contribuye a distintas condiciones fisiológicas y patológicas complejas. El catálogo de PGS recoge más de 5.000

PGS asociados con 655 rasgos. Utilizando metodologías similares, el grupo de Mike Inouye en la Universidad de Cambridge ha desarrollado modelos que predicen la expresión de cualquier gen o proteína en base a los SNPs de un individuo (https://www.omicspred.org/). Estos modelos han sido controvertidos, al dejar fuera la componente ambiental. Son, sin embargo, un esfuerzo valiente y en muchos casos útil, que abre la puerta a ser capaces de cuantificar el multi-oma de los individuos mediante modelos in silico, lo que permitiría abaratar los costes. En la misma línea se están desarrollando relojes epigenéticos mediante la aplicación de algoritmos de aprendizaje máquina que predicen la edad cronológica o la supervivencia (dependiendo de los modelos) a partir de los datos de metilación de una persona. Una vez más, al escepticismo general con los primeros relojes inferidos por Horvath le siguió una ola de curiosidad. Es cierto que aún no se ha demostrado por qué las CpGs que constituyen los relojes son las predictivas de la supervivencia y no otras, o por qué cada reloj contiene unas distintas. Más trabajo es necesario en esta línea para convencer realmente a la comunidad acerca de su validez.

Inferencia Causal e IA generativa: De la predicción a la explicación

La causalidad y la predicción se perciben a menudo como términos opuestos. Sin embargo, ambos se ocupan de la estimación de la misma probabilidad P(Y|X), con una diferencia que parece sutil pero que tiene grandes implicaciones a nivel técnico y de generalización: Los modelos predictivos predicen un resultado en base a observaciones, mientras que en inferencia causal el escenario en el que se realiza la predicción puede ser hipotético y no haber sido observado. Por esa

Figura 1

Esquema de la arquitectura de las redes neuronales generales y de los modelos generativos más utilizados actualmente

razón, la inferencia causal está ganando cada vez más atención y ayuda a la IA con la generalización de sus resultados. A su vez, algunos de los algoritmos computacionales desarrollados para resolver el problema de predicción pueden adaptarse para aproximar la probabilidad posterior de los datos a problemas complejos en los que los enfoques tradicionales no son capaces de encontrar una forma analíticamente cerrada.

Los modelos generativos profundos (Deep Generative Models, DGM) son marcos estadísticos que simulan nuevas observaciones de una variable de interés X, utilizando su función de verosimilitud Pθ(X), cuyo conjunto de parámetros θ se infiere de los datos observados. En problemas complejos, con gran cantidad de variables de confusión y de alta dimensionalidad, esto se vuelve cada vez más difícil, siendo la

inferencia un problema computacional "duro", denominado NP-hard Los modelos generativos, inspirados en la estadística bayesiana, obtienen muestras de una distribución latente Z Pθ(z) más sencilla y de menor dimensionalidad que X, y relacionan ambas variables mediante la distribución condicional Pθ(X|Z). Utilizando este marco, la probabilidad de los valores particulares de X se pueden estimar como Pθ(x) =∫ Pθ(x|z)Pθ(z)dz. Inferir esas distribuciones con técnicas de estadística tradicional como Expectation Maximitation (EM) es sumamente complicado e incluso imposible en el contexto biomédico, en el que hay un altísimo número de variables inter-relacionadas, algunas de ellas no conocidas y con una jerarquía predefinida, lo que da lugar a relaciones no lineales entre los predictores y las variables a predecir. Las redes neuronales

se han utilizado tradicionalmente como aproximadores naturales de funciones complejas, como las funciones de probabilidad que nos ocupan.

Los codificadores automáticos variacionales (VAE) y las redes generativas adversarias (GAN) se han vuelto cada vez más importantes en la inferencia variacional como habilitadores de la inferencia causal. Estos modelos están siendo muy utilizados para el análisis de datos a nivel de célula única, con aplicaciones desde el clustering automático de las células a la inferencia de redes de regulación. Un resumen de los principales algoritmos basados en DGMs para datos de scRNA-Seq se puede consultar en: https:// bioinfo.cnic.es/scDGMs/. La Figura 1 resume la arquitectura de las redes neuronales generales y de los modelos generativos más utilizados actualmente.

DOSIER CIENTÍFICO

Y de la predicción a la simulación

El uso de los DGM como forma de aproximar las complejas distribuciones posteriores que modelan las redes de causalidad subyacentes a la transición de la salud a la enfermedad, abre la puerta realmente a la comprensión global y no sesgada de los sistemas biológicos a través del análisis integrativo de datos multi-modales de alta dimensionalidad, no solo de datos moleculares (ómicos).

En un trabajo seminal, BIMMER trata de inferir las redes causales entre 405 fenotipos utilizando datos de los participantes del UK Biobank. Aunque la algorítmica utilizada se basa en Randomización Mendeliana, la aproximación a las funciones y la computación requeridas hacen necesaria la inferencia mediante técnicas de IA. Sólo así es resoluble un problema tan complejo como relevante.

Herramientas como BIMMER aplicadas sobre datos de grandes cohortes de población sana o de pacientes de distintas enfermedades, abren la puerta a la posibilidad de modelar los sistemas biológicos a gran escala, incluso a nivel de organismo completo. Con estas redes subyacentes modeladas gracias a la potencia de las nuevas metodologías de IA para resolver problemas de Inferencia Causal, se plantea un marco formal muy prometedor para simular el efecto de intervenciones en salud, mediante perturbaciones concretas del sistema por medio de gemelos digitales de cada individuo (Figura 2). Estos marcos in silico, si están suficientemente validados, permitirán a medio plazo optimizar la experimentación animal, así como reducir los tiempos en los ensayos clínicos.

Los retos que vienen

Con un panorama tan prometedor, parece que nada puede detener el imparable impacto de la IA en biomedicina. Sin embargo, las razones que impidieron un despliegue más rápido de estas metodologías a principios de siglo siguen estando ahí, algunas de ellas incluso más acentuadas. En primer lugar, la computación que se requiere para ejecutar estos algoritmos depende de tecnología copada por grandes empresas tecnológicas. La demanda es desproporcionada y corremos el riesgo de no poder hacernos con esta computación, no por falta de recursos económicos, sino por decisiones estratégicas de las empresas productoras. En este sentido, es esencial seguir apoyando las redes de colaboración computacionales para compartir los recursos. Por otro lado, los recursos humanos especializados son

Figura

cada vez más escasos. Los programas de financiación tanto nacional como internacional para captar talento están en marcha, pero sigue siendo complicado atraer al sector de la investigación pública a los especialistas. Es necesario que la sociedad perciba la ciencia como algo prioritario a lo que tenemos que contribuir entre todos. Además, tenemos que seguir avanzando en las políticas de compartición de datos que mantengan la integridad y privacidad de los mismos. Distintas infraestructuras europeas como ELIXIR, GDI, EHDEN o EUCAIM están contribuyendo a realizar de manera ordenada ese proceso esencial para el avance de la IA en biomedicina, que tantos frutos está dando. Finalmente, es esencial trabajar en formas de validar estos sistemas automáticos, una tarea que a menudo es mas compleja que la definición del propio modelo, pero que es esencial para mejorar la confianza en el uso de la IA en biomedicina y su posterior traslación a la práctica clínica.

Para saber más

Brown BC, Knowles DA. “Phenome-scale causal network discovery with bidirectional mediated Mendelian randomization”. bioRxiv 2020.06.18.160176. https://doi.org/10.1101/2020.06.18.160176

Ein-Dor L, et al. “Outcome signature genes in breast cancer: is there a unique set?”. Bioinformatics 21 (2005) 171–178. https://doi. org/10.1093/bioinformatics/bth469

Galon J, et al. “Type, Density, and Location of Immune Cells Within Human Colorectal Tumors Predict Clinical Outcome”. Science 313 (2006) 1960-1964. DOI: 10.1126/science.1129139

Rivero-García I, et al. “Deep generative models in single-cell omics”. Computers in Biology and Medicine 176 (2024) 108561. https://doi. org/10.1016/j.compbiomed.2024.108561

van der Ploeg T, et al. “Modern modelling techniques are data hungry: a simulation study for predicting dichotomous endpoints”. BMC Medical Research Methodology 14 (2014) 137. https://doi. org/10.1186/1471-2288-14-137

van ‘t Veer L, et al. “Gene expression profiling predicts clinical outcome of breast cancer”. Nature 415 (2002) 530–536. https://doi. org/10.1038/415530a

LA REVOLUCIÓN DE LA

INTELIGENCIA ARTIFICIAL EN LA BIOLOGÍA ESTRUCTURAL DE PROTEÍNAS

Pablo Chacón Montes

Instituto de Química Física Blas Cabrera (IQF ‘Blas Cabrera’), CSIC, Madrid

Dpto. Química Física Biológica Grupo de Bioinformática Estructural

https://doi.org/10.18567/sebbmrev_222.202412.dc2

La Inteligencia artificial (IA) ha revolucionado la biología estructural en tiempo récord. La capacidad de predecir con cierta precisión la disposición espacial de una proteína a partir de su secuencia nos permite explorar el espacio estructural de formas antes inimaginables, acelerar su caracterización experimental, y abrir nuevas ventanas para el desarrollo de herramientas computacionales capaces de diseñar proteínas que van más allá de lo explorado por la evolución natural. Las IA generativas, como los modelos de lenguaje y los procesos de difusión, han demostrado su capacidad para generar nuevas proteínas con propiedades específicas, alcanzando un éxito experimental notable. En este momento disruptivo y dinámico, en el que surgen a diario nuevas herramientas y aplicaciones, este artículo se centra en la estructura de proteínas, y excluye otros campos relacionados como el diseño de fármacos y ácidos nucleicos, donde la IA también es uno de los principales motores de avance.

AlphaFold es un ejemplo más de cómo la IA está transformado nuestro modo de vida, en este caso, revolucionando la biología estructural, un campo clave en el avance de la biología, la biotecnología y la investigación biomédica durante las últimas cinco décadas. En diciembre de 2020, AlphaFold 2 (AF2), desarrollado por Google-DeepMind, resolvió uno de los mayores desafíos de la biología: la predicción de la estructura tridimensional de las proteínas a partir de su secuencia de aminoácidos con una precisión comparable, en muchos casos, a la de las técnicas experimentales. Utilizando redes neuronales profundas, esta herramienta emplea la información de las estructuras conocidas y la co-evolución recogida en sus secuencias homólogas para predecir la estructura 3D de las proteínas. Seis meses después, la herramienta fue publicada en código abierto y permitió a la comunidad científica validar su eficacia (y limitaciones), provocando un impacto general y profundo (p. ej. la publicación original acumula más de 18.000 referencias) que ha culminado con la concesión en tiempo récord del Nobel en química para sus principales autores Demis Hassabis y John M. Jumper, junto a David Baker el gran pionero en modelado y diseño de proteínas que también tiene su propio desarrollo similar a AF2, RoseTTAFold. El uso de estas herramientas ha permitido expandir tres órdenes de magnitud la información estructural que disponemos. La base de datos AlphaFold DB (https://alphafold. ebi.ac.uk) ya almacena más de 214 millones de estructuras predichas por AF2, incluyendo el proteoma humano y de otras 47 especies, en contraposición con las 200.000 estructuras resueltas experimentalmente almacenadas en el Protein Data Bank (PDB). Al tiempo que intentamos

racionalizar esta ingente información estructural, su potencial es evidente como también que se nos presentan grandes retos que afrontar. Por ejemplo, para la identificación de proteínas estructuralmente similares en una base de datos de estas dimensiones se ha tenido que desarrollar una herramienta de búsqueda ultra-rápida (Foldseek) de nuevo con elementos de IA ante la imposibilidad de aplicar métodos tradicionales. Es importante resaltar que la capacidad de generar buenas predicciones permite acelerar la propia determinación experimental de estructuras. Podemos utilizar las predicciones para generar construcciones más estables eliminado zonas potencialmente desestructuradas, para resolver la estructura más rápidamente por reemplazo molecular en cristalografía de rayos-X, y, de forma similar, en crio-microscopía electrónica su

localización dentro de los mapas de densidad facilita su interpretación a resolución atómica. Como pescadilla que se muerde la cola, la capacidad de aprendizaje de las herramientas de IA y su precisión, aumentará al disponer de más estructuras experimentales. Sin duda, AF2 y RF se han convertido en herramientas muy populares al permitir el acceso a información estructural de las proteínas en minutos a partir de su secuencia. Si no lo ha hecho ya, el lector puede comprobar lo fácil que es obtener una predicción, bien buscándola directamente en AlphaFold DB o bien en la nube donde podrá encontrar implementaciones optimizadas de AF2 como Colabfold, o RoseTTAFold. Además de la predicción 3D de la estructura, por cada amino ácido se obtiene una estimación de la fiabilidad en su predicción, llamada pLDDT, que nos indica qué partes

de la estructura pueden ser fiables y cuáles no. Valores de pLDDT>90 corresponden a regiones predichas con precisión, valores entre 90 y 70 suelen corresponder a una predicción donde la cadena principal está bien modelada pero las cadenas laterales pueden contener algún error, y valores pLDDT<50 caracterizan zonas cuya predicción no es fiable, y suelen corresponder con regiones desordenadas. Cuando visualizamos una de estas predicciones, solemos ver que la mayoría son regiones con alta fiabilidad, más o menos salpicada con regiones de menor precisión muchas veces localizadas en la superficie en regiones flexibles como bucles. También son frecuentes zonas de baja precisión en el N y C terminales en forma de espagueti, que son particularmente extensas en organismos eucariotas más evolucionados. En general, los modelos de AlphaFold o RoseTTAFold son muy buenos, pero no siempre lo son, e incluso las regiones de alta fiabilidad pueden contener errores. En la red se pueden encontrar

un gran número de predicciones erróneas, que no invalidan la bondad y el carácter generalista de estas aproximaciones, pero que deben encender una luz amarilla de precaución sobre todo cuando queramos utilizar esas predicciones, por ejemplo en simulaciones atomísticas.

Aunque la entrada principal para la red neuronal de AlphaFold2 es una secuencia, en el primer paso se genera un alineamiento múltiple (MSA) buscando en distintas bases de datos secuencias similares a la de entrada. Precisamente, la calidad del alineamiento es uno de los factores determinantes para obtener una predicción más o menos precisa de la estructura. Un MSA diverso y profundo, con cientos o miles de secuencias alineadas, ayudará a identificar señales coevolutivas y utilizarlas para averiguar la correcta estructura 3D de la proteína. Por el contrario, un MSA poco profundo con pocas secuencias y baja variabilidad entre ellas, aumentará la posibilidad de errores en la predicción por la pobre señal coevolutiva.

Otras limitaciones incluyen la dificultad de modelar cambios conformacionales e interacciones proteína-proteína.

Potentes modelos de IA han cambiado el panorama de la comprensión del lenguaje, la maravillosa generación de lenguaje de ChatGPT no deja de asombrarnos. Precisamente, el éxito de los modelos de lenguaje de gran tamaño (LLM por sus siglas en inglés) en procesamiento del lenguaje natural (PLN) y la similitud entre nuestro lenguaje y el «lenguaje de las proteínas» motivaron el desarrollo de los modelos del lenguaje de las proteínas (PLM). Estos modelos, en lugar de aprender de las distribuciones de palabras/frase/textos, aprenden de las distribuciones de aminoácidos/secuencias/funciones. Los modelos PLM tratan las secuencias como datos de entrada de forma similar a como se trata el texto en modelos de PLN como GPT (Generative Pre-trained Transformer) o BERT (Bidirectional Encoder Representations from Transformers). El modelo de lenguaje ESM-2 desarrollado por

Meta y basado en BERT, entrenado con 250 millones de secuencias de proteínas, fue capaz de aglutinar y codificar a distintos niveles jerárquicos sus distintas propiedades (relaciones coevolutivas, propiedades bioquímicas y biofísicas de los aminoácidos, etc.) captando las complejas reglas que rigen la “gramática” de las proteínas. Tras el entrenamiento, este modelo de lenguaje puede transformar cualquier secuencia de proteínas en un vector que encapsula estas propiedades denominado embeddings

Los embeddings son una forma de representar la información de un texto en vectores para que los modelos de aprendizaje automático puedan medir la similitud de distintos textos y documentos en función de su significado, y así poder establecer relaciones que faciliten búsquedas, clasificaciones, etc. En este caso, los embeddings de ESM-2 son vectores que contienen información relevante de la secuencia como la conservación evolutiva, relaciones funcionales, motivos estructurales, etc. Utilizando modelos de aprendizaje profundo sobre estos embeddings de proteínas, se han logrado resultados espectaculares en la predicción de contactos de largo alcance, efectos mutacionales, de función e incluso también en la predicción de la estructura tridimensional. Esta última aplicación, denominada ESMFold, aunque no llega a los niveles de precisión de AF2, es muchísimo más rápida, lo que permite predecir eficazmente un ingente número de proteínas sin grandes recursos y puede ser una alternativa a AF2 en casos donde el MSA sea limitado. Hace pocos meses se ha presentado una nueva versión, ESM3, que es el primer modelo generativo que razona simultáneamente sobre la secuencia, la estructura y la función de las proteínas. Mejora a su antecesor en muchos aspectos:

su capacidad de predicción rivaliza con AF2, permite cierta especialización ya que está entrenado con diversos organismos y biomas, y permite diseñar proteínas con funcionalidades específicas. Como ejemplo ilustrativo de diseño con ESM3, han presentado una nueva proteína verde fluorescente (GFP) a partir de las estructuras y de los residuos críticos que definen su función. De los miles de diseños generados, se identificó uno con una similitud del 58% con la proteína fluorescente conocida más cercana con una fluorescencia similar a la observada en medusas y corales (Figura 1). Este resultado muestra la capacidad de ESM3 para explorar espacios proteicos que la naturaleza necesitaría millones de años de evolución en descubrirlos, y su potencial en la generación de nuevas proteínas funcionales.

En lugar de predecir cómo una secuencia se pliega, el aspecto crucial en el diseño de novo es resolver el problema inverso: diseñar una secuencia que, cuando se sintetice y pliegue, adopte la estructura específica con la función que deseamos. De los enfoques iniciales que estaban basados en modelos físicos (p. ej. Rossetta) hemos pasado al desarrollo de herramientas más potentes de aprendizaje profundo basadas en grafos (GNNs por sus siglas inglés). En este tipo de redes neuronales cada átomo o residuo del esqueleto proteico queda definido por un nodo que está conectado con los nodos cercanos a una distancia dada, que forman las aristas del grafo. En cada nodo de la red podemos añadir información como el tipo de aminoácido o las coordenadas tridimensionales, mientras que

Figura 1

DOSIER CIENTÍFICO

en las aristas se pueden incluir vectores que describen la distancia, dirección y orientación entre nodos conectados. Mediante el paso de mensajes, en el que cada nodo envía y recibe mensajes basados en las características de sus nodos y aristas vecinos, la red va agregando la información local y aprendiendo patrones complejos entre estructura y secuencia. ProteinMPNN es el paradigma de este tipo de redes, y su capacidad para predecir secuencias de aminoácidos compatibles con una determinada estructura ha sido validada experimentalmente en multitud de escenarios como el diseño de proteínas solubles, de nuevas proteínas, rediseño de estructuras y la generación de complejos simétricos. En su nueva versión, LigandMPNN, añade pequeños ligandos y ácidos nucleicos al proceso de diseño, y añade casos de éxito al diseño de proteínas que interaccionan con gran afinidad y especificidad con moléculas no proteicas. Es importante resaltar que las validaciones experimentales de este tipo de métodos tienen un alto grado de éxito, entre el 1020% de las secuencias predichas se obtiene la estructura deseada. Por esa razón no es de extrañar que el número y variedad de aplicaciones de diseño de proteínas crezca a pasos agigantados. Sin embargo, para su aplicación necesitamos una estructura de entrada. En un paso previo necesitamos definir un esqueleto o boceto estructural inicial y asegurarnos que sea “diseñable”, i.e. que al menos una secuencia se pliegue en esa estructura. Aunque siempre podemos partir de una estructura conocida intentando mejorar sus propiedades (p. ej. estabilidad o solubilidad), o reciclarla para otros propósitos, de nuevo, la IA nos ofrece una solución con los modelos de difusión. Durante el entrenamiento

de estos modelos generativos de aprendizaje profundo, primero se añade ruido gaussiano a las estructuras de proteínas conocidas para luego entrenar la red para recuperar las estructuras originales mediante un proceso iterativo de eliminación de ruido. Así, el modelo aprende las distribuciones de probabilidad del espacio de estructuras proteicas, lo que le permite, en el momento de la generación, recibir ruido gaussiano y transformarlo de forma iterativa en nuevos esqueletos proteicos cuya secuencia tendremos que diseñar.

RFDiffusion, aprovechando los pesos preentrenados de RoseTTAFold y las capacidades de ProteinMPNN para resolver el problema inverso, obtiene resultados realmente espectaculares. Con esta herramienta se han generado nuevas arquitecturas de barriles alfa-beta visibles mediante CryoEM que superan las variaciones estructurales del clásico pliegue de barril TIM –un diseño de proteínas para cinco dianas proteicas terapéuticas, con una tasa de éxito del 18% con 95 diseños con especificidad picomolar-. La nueva versión RFdiffusionAA, que utiliza RoseTTAFold All-Atom, la versión mejorada de RF, expande el rango de aplicabilidad al diseño de proteínas que unen pequeños ligandos. Por ejemplo, ha diseñado proteínas que se unen a bilina, hemo y digoxigenina con estructuras muy diferentes a las proteínas que unen estos compuestos que se encuentran en el PDB. Además, los modelos de difusión pueden incorporar restricciones en generación que nos permiten incorporar propiedades y funciones deseadas en el diseño.

Chroma, otro modelo de difusión, también puede condicionarse con texto lo que abre la posibilidad de que en algún futuro tengamos una herramienta a la

que podamos decirle «Diseña una proteína pequeña, soluble y que se una a la proteína X». A pesar de estos increíbles avances queda mucho camino por recorrer, en particular, poder incorporar en el diseño la exploración del espacio conformacional y de interacciones, lo que nos permitiría crear proteínas que respondan a determinados estímulos o incluso generar nuevos mecanismos enzimáticos.

El impacto y el rango de aplicación de las herramientas basadas en IA (Figura 2) es impresionante. Muy recientemente, Google DeepMind ha publicado AlphaFold3 (AF3), que extiende su capacidad más allá de proteínas individuales con la predicción de sus interacciones con ácidos nucleicos, iones y pequeñas moléculas. A pesar de que reportan resultados muy prometedores que mejoran la capacidad y el rango predictivo de la versión anterior, de momento, AF3 sólo está accesible de forma limitada en un servidor web junto con unas draconianas licencias de uso. De igual forma ESM3, aunque el código sea accesible, prácticamente solo sus desarrolladores disponen de los recursos computacionales necesarios para su entrenamiento, e incluye una oscura licencia no comercial. Aunque estamos acostumbrados a que estas compañías controlen nuestra vida digital sabiendo donde estamos, lo que buscamos, compramos, etc., parece excesivo que vayan a controlar nuestra capacidad de investigación. Esperemos que la comunidad científica logre que recapaciten y vuelvan a la senda del código abierto, donde el Prof. D. Baker ha demostrado su activismo a lo largo de los años al permitir el acceso a sus herramientas de predicción y el diseño de proteínas, que desde aquí agradecemos.

2

Para leer más

Abramson J, et al. “Accurate structure prediction of biomolecular interactions with AlphaFold3”. Nature 630 (2024) 493–500. https://doi.org/10.1038/s41586-024-07487-w

Krishna R, et al. “Generalized biomolecular modeling and design with RoseTTAFold AllAtom”. Science 384 (2024) 2528. DOI: 10.1126/science.adl2528

Varadi M, et al. “AlphaFold Protein Structure Database in 2024: Providing structure coverage for over 214 million protein sequences”. Nucleic Acids Research 52 (2024) D368–D375. https://doi.org/10.1093/nar/ gkad1011

Watson JL, et al. “De novo design of protein structure and function with RFdiffusion”. Nature 620 (2023) 1089–1100. https://doi.org/10.1038/s41586-023-06415-8

Winnifrith A, et al. “Generative artificial intelligence for de novo protein design”. Current Opinion in Structural Biology 86 (2024) 102794. https://doi.org/10.1016/j.sbi.2024.102794

Figura

INTELIGENCIA ARTIFICIAL GENERATIVA (GENAI) PARA DISEÑAR GENOMAS DE ORGANISMOS DIGITALES

Francisco J. Borrallo-Vázquez y Miguel A. Fortuna

Laboratorio de Biología Computacional

Estación Biológica de Doñana (EBD), CSIC, Sevilla

https://doi.org/10.18567/sebbmrev_222.202412.dc3

La Inteligencia Artificial

Generativa (GenAI por sus siglas en inglés) es una rama de la Inteligencia artificial (IA) que se enfoca en la creación de nuevos contenidos, como imágenes, texto, música y otros datos, a partir de patrones y datos preexistentes. En lugar de simplemente analizar o clasificar información, los modelos de GenAI, como ChatGPT, aprenden a replicar y crear datos a partir de los que han usado durante su entrenamiento. Este tipo de algoritmos es particularmente útil en áreas creativas y de diseño, como la creación de arte digital, la generación de contenido en videojuegos, la composición musical y la simulación de conversaciones humanas. Pero además, la GenAI también tiene aplicaciones en ámbitos

científicos, como el diseño de moléculas activas novedosas en farmacología, la predicción de patrones de coexistencia entre especies en comunidades ecológicas, y la generación de secuencias genómicas en la investigación biomédica.

La genómica sintética busca diseñar y construir genomas completos para encontrar los principios fundamentales responsables de la función del genoma. Los avances recientes en ensamblaje, edición, y síntesis de ADN junto con las innovaciones computacionales en la GenAI han impulsado este campo. El objetivo de la investigación que llevamos a cabo con genomas digitales es, precisamente, guiar el diseño y construcción de genomas sintéticos de organismos naturales. Sin

embargo, trasladar lo aprendido in silico a los proyectos de genómica sintética sigue siendo un proceso altamente complejo. Nuestros esfuerzos en la aplicación de la GenAI a genomas de organismos digitales se centran en optimizar este proceso para intentar, en una segunda fase, trasladar lo aprendido al diseño, construcción, entrega, ajuste y aplicación de genomas sintéticos de organismos naturales.

Evolución digital

La evolución digital es una forma de computación evolutiva en la que programas informáticos autorreplicantes —organismos digitales— mutan y evolucionan dentro de un entorno computacional definido por el usuario. Avida es la plataforma de software más

utilizada para la investigación en evolución digital y se ha consolidado como el nexo de unión entre la simplicidad y abstracción de los modelos matemáticos, por un lado, y la complejidad y realismo de los experimentos en el laboratorio y en condiciones naturales, por el otro. Avida cumple con los tres requisitos esenciales para que tenga lugar el proceso evolutivo: replicación, variación heredable y eficacia biológica diferencial —fitnes-. Este último requisito emerge de la competencia por los recursos limitados de espacio en memoria (RAM) —donde “viven” los organismos digitales— y tiempo de la unidad central de procesamiento (CPU) que usan los organismos digitales para replicarse. Un organismo digital en Avida consiste en una secuencia de instrucciones —su genoma— y una CPU virtual que ejecuta esas instrucciones.

El espacio de secuencias que pueden codificar organismos digitales con genomas de longitud —número de instrucciones— L extraído de un alfabeto de instrucciones disponible A, comprende AL genomas diferentes. Si consideramos genomas con L = 100 instrucciones tomadas de un alfabeto de A = 26 instrucciones (el lenguaje genético de Avida; Figura 1), el espacio de secuencias es enorme: 26100 = 3,14 × 10141. Cualquier genoma en este espacio codificará un organismo viable si éste es capaz de autorreplicarse. Encontrar genomas viables en este gigantesco espacio mediante la generación de secuencias aleatorias es como buscar una aguja en un pajar. El coste computacional es muy alto. Por ejemplo, se necesitan más de un millón de secuencias aleatorias para encontrar un solo genoma viable de 100 instrucciones. Por tanto, necesitamos

métodos mucho más eficientes en la búsqueda de genomas que codifiquen organismos viables que puedan usarse como ancestros— wild type— a partir de los cuales iniciamos nuestros experimentos evolutivos destinados a desvelar los mecanismos responsables de la biodiversidad del planeta. Y es en este punto donde la GenAI entra en juego.

Redes generativas antagónicas

Las Redes Generativas Antagónicas (GANs por sus siglas en inglés) son una clase de algoritmos de GenAI que imitan la “carreras de armamentos” evolutivas que tienen lugar, por ejemplo, entre los depredadores y sus presas (donde el depredador evoluciona para ser más eficiente en la búsqueda y captura de su presa, y su presa evoluciona para evadir más fácilmente a su depredador). Una GAN consiste en dos

El lenguaje genético del genoma de los organismos digitales está formado por 26 códigos de instrucciones. Es decir, a diferencia de los cuatro nucleótidos que constituyen el ADN del genoma de los organismos naturales o de los 20 aminoácidos a partir de los cuales se forman las proteínas, cada posición del genoma de un organismo digital puede estar ocupada por una de las 26 “letras” posibles.

Figura 1

DOSIER CIENTÍFICO

Figura 2 avidaDB es una base de datos que contiene más de un millón de genomas de organismos digitales disponibles para ser usados en experimentos evolutivos. Con el fin de facilitar el acceso a avidaDB hemos desarrollado una librería para el lenguaje de programación R (avidaR) que permite hacer descargas y búsquedas selectivas de genomas.

redes neuronales artificiales con múltiples capas que se entrenan de manera concurrente: una red generativa y una red discriminativa. Dentro de nuestro propósito de encontrar genomas que codifiquen organismos digitales viables, la red generativa (generador) usa ruido aleatorio gaussiano para producir genomas tan reales (es decir, genomas que codifican organismos viables) como sea posible, de modo que se entrena para generar genomas falsos (es decir, que no codifican organismos viables). La red discriminativa (discriminador) recibe genomas aleatorios del generador y genomas reales de la base de datos avidaDB (Figura 2), y decide si el genoma es real o no. Tanto la red generativa como la discriminativa se entrenan a la vez, jugando una contra la otra para maximizar sus objetivos: el del generador es proporcionar genomas aleatorios lo suficientemente reales como para engañar al discriminador (que los clasificaría como reales aunque no lo sean), y el del discriminador es obligar al generador a producir genomas ni tan reales ni tan aleatorios como

para clasificarlos acertadamente como reales o falsos, respectivamente. Cuando este aprendizaje recíproco se equilibra, el generador proporciona genomas aleatorios con alta probabilidad de que codifiquen organismos digitales viables (Figura 3)

Una de las ventajas de usar esta aproximación computacional como gemelo digital del diseño de genomas de organismos naturales es que podemos validar el éxito del entrenamiento de las GANs inmediatamente y sin coste alguno. Es decir, a diferencia del diseño de secuencias genómicas mejoradas para la industria y la biomedicina que requieren posteriormente su síntesis química para corroborar que se ha implementado con éxito la funcionalidad biológica deseada, la comprobación de la viabilidad de los genomas de organismos digitales generados con las GANs se comprueba directamente en Avida. Sólo necesitamos ejecutar el código del organismo digital que contiene el genoma que proporciona el generador de la GAN y, en cuestión de milisegundos, observar si es o no capaz de replicarse.

Y esta validación retroalimenta a su vez el sistema de entrenamiento de la GAN porque los genomas generados que codifiquen organismos viables formarán parte de la base de datos de genomas reales —avidaDB— con la que se entrenan tanto el generador como el discriminador.

No sólo evolución sino también coevolución digital

En Avida, los organismos digitales necesitan consumir recursos del entorno computacional para replicarse, de forma análoga al consumo de nutrientes por parte de las bacterias. Los recursos computacionales definidos en Avida se consumen sólo si el organismo es capaz de realizar funciones matemáticas sencillas con números binarios mientras ejecuta las instrucciones que constituyen su genoma. Y de manera análoga a como la bacteria E. coli metaboliza glucosa o citrato como fuente de carbono, un organismo digital puede consumir el recurso asociado a realizar una suma (operación booleana OR) o una multiplicación (operación booleana AND). Esta

Figura 3

Una Red Generativa Antagónica (GAN) para el diseño de genomas consta de dos redes neuronales que se entrenan simultáneamente: una red generativa (generador), que usa ruido aleatorio para producir genomas aleatorios y se entrena para generar genomas falsos pero no tan aleatorios, y una red discriminativa (discriminador), que recibe genomas del generador y de la base de datos avidaDB, clasificándolos como reales o falsos. Ambas redes se entrenan una contra la otra para mejorar su precisión. Al equilibrarse este proceso, el generador produce genomas con alta probabilidad de codificar organismos digitales viables que, de serlo, pasarán a formar parte de la base de datos.

capacidad que tiene un organismo digital de realizar operaciones booleanas para consumir recursos define su fenotipo o funcionalidad. Esta propiedad funcional de los organismos digitales ha permitido implementar interacciones hospedador-parásito, en donde algunos organismos —parásitos— son capaces de “robar” la energía que necesitan (ciclos de CPU) para ejecutar las instrucciones de sus genomas a otros organismos digitales —sus hospedadores. Un parásito podrá infectar a un hospedador si realiza el menos una de las funciones booleanas que lleva a cabo éste. Es el equivalente digital al acoplamiento entre las fibras de la cola de un virus bacteriófago y los receptores de membrana de la bacteria. La presión selectiva que imponen los parásitos beneficiará a aquellos hospedadores que acumulen mutaciones en el

genoma que cambien la función booleana que realizan —el receptor de membrana bacteriano. De esta forma el hospedador podría escapar de los parásitos. Por tanto, si pensamos en el creciente interés que ha adquirido el uso de virus bacteriófagos como agentes terapéuticos en la lucha contra las infecciones bacterianas resistentes a los antibióticos, se requiere un método de generación de secuencias genómicas que posean la funcionalidad necesaria para infectar variantes genómicas que puedan emerger durante la evolución bacteriana (Figura 4)

De los genomas de organismos digitales a los genomas de organismos naturales El objetivo fundamental del uso de gemelos digitales, como Avida, es complementar los estudios llevados a cabo en el laboratorio. El

paso crucial es comprobar si lo que aprendemos estudiando organismos digitales en un ordenador es útil para entender los mecanismos y procesos que suceden en los organismos naturales. Y en este punto se puede ver el vaso medio vacío o medio lleno, es decir, fijarse únicamente en las diferencias entre organismos digitales y naturales (que las hay) o profundizar en las características comunes (que también las hay, y muchas). Para nosotros, el proceso evolutivo es independiente del substrato material que contiene y transmite la información, sea la química molecular basada en el carbono o el estado de los electrones en un semiconductor. Lo verdaderamente importante es que haya entidades replicantes (células o programas informáticos) que contengan información heredable (genoma) y que las variaciones en la información

Figura 4

Un parásito digital podrá infectar a un hospedador digital si realiza el menos una de las funciones booleanas que lleva a cabo el hospedador. Es el equivalente digital al acoplamiento entre las fibras de la cola de un virus bacteriófago (fago) y los receptores de membrana de sus hospedadores bacterianos. Una vez se produce ese acoplamiento, el parásito infectará a su hospedador. Este proceso impone una presión selectiva que beneficiará a aquellos hospedadores que adquieran mutaciones que les permitan realizar nuevas funciones booleanas, de manera análoga a cambios en los receptores de membrana de las bacterias. De esta forma, el hospedador podrá escapar de los parásitos. Por tanto, se require un método de generación de genomas de parásitos digitales que posean la funcionalidad necesaria para infectar a la variante genética específica que pueda emerger durante la evolución del hospedador.

que contienen les otorguen mayor o menor eficacia en la transmisión de esa información durante su proceso de replicación.

¿Hasta qué punto este enfoque digital puede ayudar a diseñar nuevos genomas de organismos naturales? Si nos centramos en el uso de fagos como agentes terapéuticos, podemos entrenar las GANs con los genomas de los fagos y los de sus hospedadores bacterianos para ayudar a los investigadores a identificar nuevos hospedadores susceptibles de ser infectados. De hecho, el grupo de Jim Collins en el MIT ha desarrollado recientemente una herramienta llamada BioAutoMATED, que utiliza modelos de lenguaje entrenados en secuencias genómicas biológicas para interpretar y diseñar genomas que posean una funcionalidad específica, análoga a las funciones booleanas que son capaces de llevar a cabo los parásitos digitales en Avida.

Para leer más

Eugene L, et al. “Relevant applications of generative adversarial networks in drug design and discovery: molecular de novo design, dimensionality reduction, and de novo peptide and protein design”. Molecules 25 (2020) 3250. https://doi.org/10.3390/ molecules25143250

Fortuna MA, et al. “The genotype-phenotype map of an evolving digital organism”. PLoS Computational Biology 13 (2017) e1005414. https://doi.org/10.1371/journal.pcbi.1005414

James JS, et al. “The design and engineering of synthetic genomes”. Nature Review Genetics (2024) https://doi.org/10.1038/ s41576-024-00786-y

Valeri JA, et al. “BioAutoMATED: an end-to-end automated machine learning tool for explanation and design of biological sequences”. Cell Systems 14 (2023) 525-542. https://doi.org/10.1016/j. cels.2023.05.007

Yelmen B, et al. “Creating artificial human genomes using generative neural networks”. PLoS Genetics 17 (2021) e1009303. https:// doi.org/10.1371/journal.pgen.1009303

BIOANALIZADORES

Máxima resolución y sensibilidad

Última tecnología en electroforesis capilar con detección por fluorescencia al alcance de todos

Genotipado

Producto de PCR (DNA/RNA)

Control de calidad NGS

CRISPR

Purificación de plásmidos

RFLP

Análisis SSR

Oligonucleótidos cfDNA gDNA

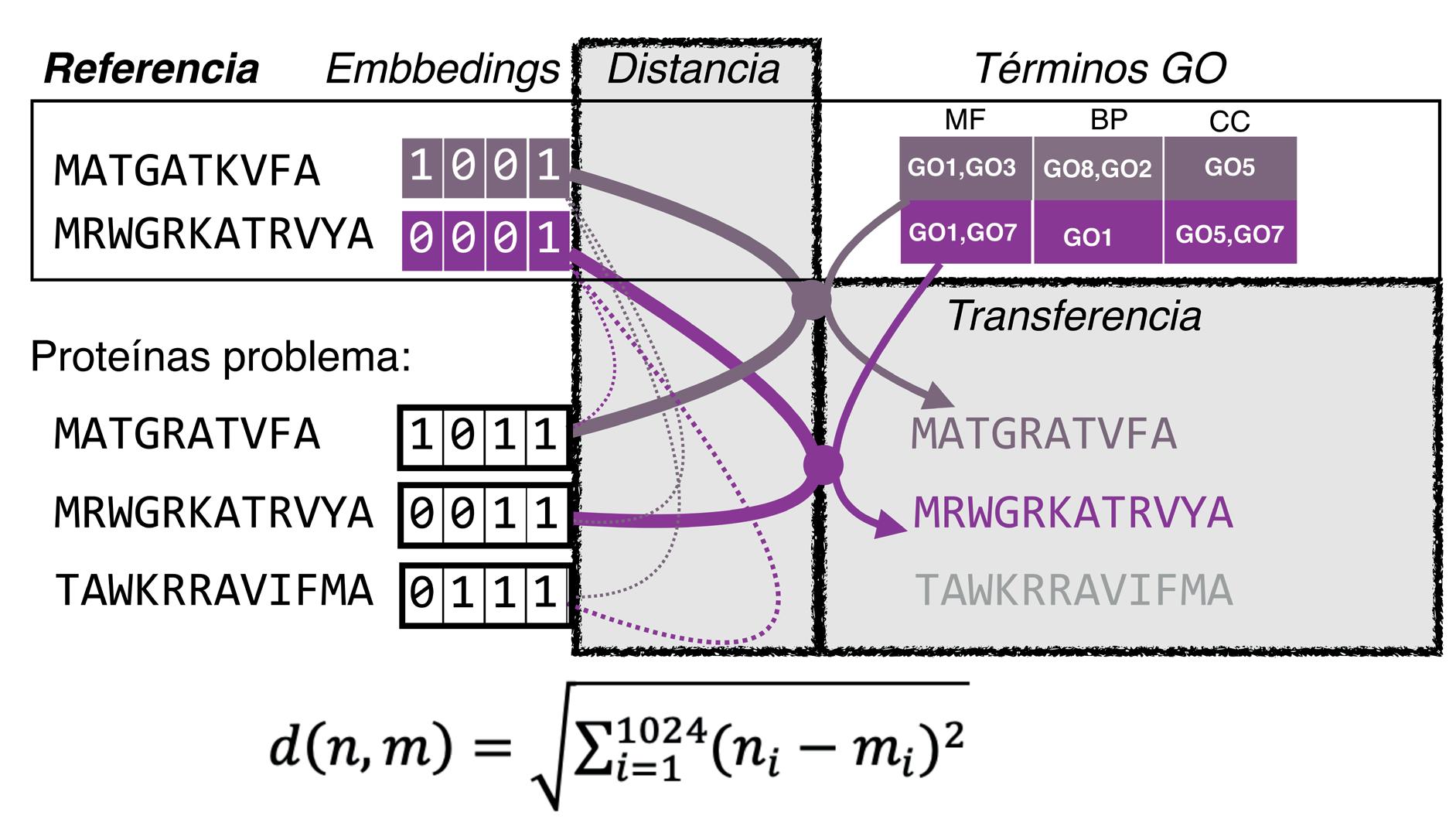

ANOTACIÓN DE FUNCIÓN EN PROTEÍNAS USANDO MODELOS DE LENGUAJE

Ana M Rojas Mendoza*e Ildefonso Cases

Centro Andaluz de Biología del Desarrollo (CABD), CSIC, Sevilla. Grupo de Biología Computacional y Bioinformática

Gemma Martinez-Redondo y Rosa Fernández

Instituto de Biología Evolutiva (IBE), CSIC, Barcelona. Metazoa Phylogenomics lab

https://doi.org/10.18567/sebbmrev_222.202412.dc4

El poder transformador de la Inteligencia artificial (IA) ha irrumpido en la biología estructural, mediante desarrollos relacionados con la predicción de la estructura terciaria (ahora de complejos de proteínas y ligandos tras meses de espera), y con el diseño de proteínas a la carta. Dado que la IA ha llegado tarde a la biología, uno esperaría que el impacto sobre todas las disciplinas del dominio biológico sea gradual. Lo que es evidente es que la IA ha llegado para quedarse, y es cuestión de tiempo que llegue a todas las áreas en las que pueda florecer.

La predicción de función es un problema bien conocido, persistente, y que sigue sin resolverse, pese a décadas de desarrollo y esfuerzos los métodos no progresan, representando un reto enorme de la Biología computacional, así que demos un repaso histórico y conceptual a la problemática.

¿Qué es función? Es un concepto subjetivo, muy dependiente de contexto, que normalmente extraemos de la literatura científica. Para organizar la información, hemos generado ontologías de genes (Gene Ontology), que incluyen términos GO (por sus siglas en inglés), que no son más que vocabularios controlados relacionando términos asociados a funciones. Estos términos se representan en una estructura de grafo donde los nodos del mismo son los términos, conectados por flechas que indican las relaciones entre los mismos. La raíz del grafo representa los términos más generales (por ejemplo, Proceso Biológico, etc.) y va progresando con términos más específicos si avanzamos de nodo en nodo. La profundidad en el grafo es variable denotando la especificidad del término, y no todas las ramas del grafo tienen la misma profundidad, ni todos los organismos tienen los mismos

grafos. Por ejemplo, los términos relacionados con desarrollo de ala en mosca no se encuentran en el grafo de la levadura.

Lo que anotamos en realidad es el producto codificante de los genes, las proteínas, y esas anotaciones se asocian de nuevo a los genes correspondientes. Por otro lado, “función” también es un concepto bioquímico, y en estructura de proteínas se asocia a sitios de unión o sitios catalíticos. Hay que decir que existe un sesgo en cuanto a los genes que se estudian, puesto que Stoeger et al., en 2018, publicaron un trabajo en el cual demuestran que estudiamos los mismos genes de manera circular, y que incluso en humanos, el foco cae en unos 2.000 genes de los 19.000 posibles. Atribuyeron causas multifactoriales, pero el mensaje es que no estamos progresando. En otras palabras: la información funcional de la que disponemos

es muy parcial y está muy sesgada por intereses específicos.

¿Cómo se asigna la función a una secuencia nueva? Pues usamos la similitud de secuencia (concepto matemático, cuantitativo) para identificar homología de secuencia (concepto cualitativo). Esta aproximación está basada en dos premisas, la primera se fundamenta en la evolución molecular y las relaciones evolutivas entre las secuencias de las especies, en particular los ortólogos y los parálogos (ver Ohno, 1970 y Zuckerkandl y Pauling, 1965). Recordamos que un ortólogo es un gen que estaba presente en el ancestro común de dos especies, y que cuando ocurrió el evento de especiación cada especie nueva adquirió una copia del gen, mientras que un parálogo es un gen que se duplica a partir del ortólogo tras el proceso de especiación (Figura 1A)

Y ¿cómo relacionamos esto con la función? Pues a través de la conjetura del ortólogo propuesta por Nehrt et al., en 2011, que sugiere que los ortólogos retienen la función, mientras que los parálogos (duplicaciones de un gen tras especiación) la diversifican, aunque estas nociones las introdujo E. Koonin en los 90. Es decir, asumimos que las secuencias ortólogas “realizan” la misma función. Sin embargo, uno de los errores conceptuales más profundos y persistentes en disciplinas como la biología del desarrollo o la genómica, es utilizar la similitud funcional entre dos genes para definir ortología, como ya discutió G. Theißen en 2002. La analogía funcional no implica ortología, ni la ortología implica necesariamente la analogía funcional.

Desde un punto de vista termodinámico, los estudios seminales de C. Anfinsen en los 60, llevaron a concluir que la estructura más

Figura 1

Premisas en las que basamos la asignación de función. A) Relaciones evolutivas a nivel molecular respecto a eventos de especiación. El ancestro común posee un gen (círculo negro) que se transfiere a cada especie tras un evento de especiación. En un caso, se duplica y en otro no. B) El paradigma de secuencia/estructura/función entre la estructura tridimensional y la secuencia, a mayor similitud de secuencia, mayor la de su estructura (el eje Y es rmsd, la distancia entre carbonos alfa de la estructura, mientras que el eje X es el % de identidad de la secuencia de aminoácidos). Siguiendo con la hipótesis de Anfinsen, el estado de energía más bajo es el más estable y el que se asocia a la función de la proteína. Hoy sabemos que esto no es así.

DOSIER CIENTÍFICO

Figura 2

Asignación de función. A) Transferencia de “función” basada en la similitud de la secuencia de aminoácidos. B) Problemas de asignación automática de función por trasferencia errónea (función azul). C) Problemas de asignación masiva a miembros de subfamilias de proteínas. D) Caso de metamorfismo en proteínas, que implica cambio radical de estructura cuando la proteína adopta diferentes funciones.

estable asociada a una secuencia se asociaba a una función fisiológica determinada (Figura 1B). Estas dos premisas han originado el siguiente paradigma: “una secuencia, una función, una estructura”, que es central a todos los métodos computacionales de predicción de función y predicción de estructura. Entonces, si dos secuencias de proteínas muestran una identidad mayor a un umbral (normalmente un 40%), que puede obtenerse usando métodos que estiman cómo de idénticas son dos secuencias en su composición (p. ej. BLAST), se transfiere toda la anotación simultáneamente de una a otra (Figura 2A). Esta transferencia es ruidosa, puesto que a veces se transfieren funciones que no están en la secuencia a identificar porque la región responsable de la función (imaginemos un dominio kinasa) no está presente en la secuencia que