W numerze:

3 Od Redakcji

5

11

21

37

45

53

Zbigniew Świder Nastawy regulatora kursu dla autopilota statku

Tomasz Winiarski, Jan Kaniuka, Jakub Ostrysz

Metodyka projektowania systemów robotycznych w oparciu o metamodele

EARL i MeROS

Sandra Śmigiel, Tomasz Topoliński, Damian Ledziński, Tomasz Andrysiak

The ECG Monitoring System Using Machine Learning Methods and LoRa Technology

Adam Idźkowski, Mateusz Sumorek

Zastosowanie metod uczenia maszynowego do predykcji generowanej energii w małym systemie PV

Karol Erd

Analiza porównawcza wybranych metod kalibracji kamery termowizyjnej z chłodzonym detektorem pracującym w zakresie MWIR

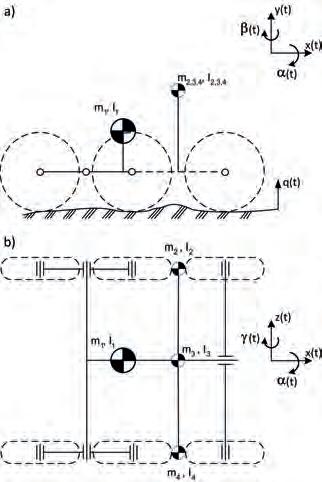

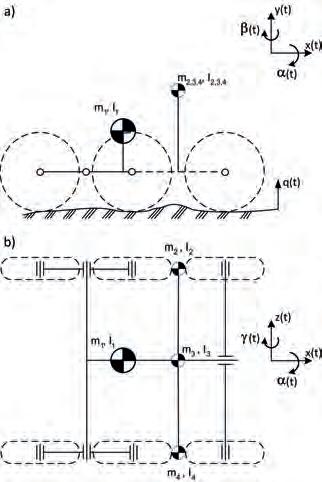

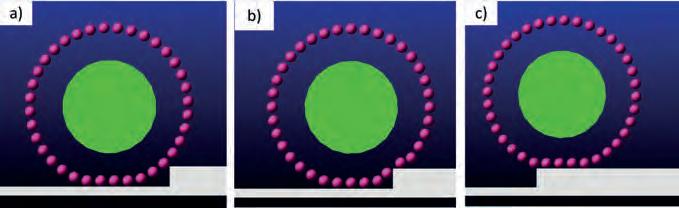

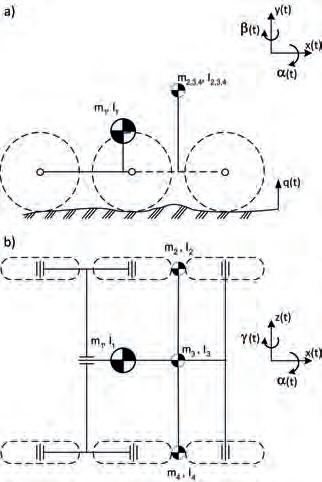

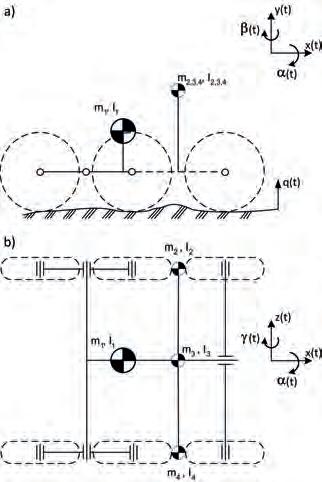

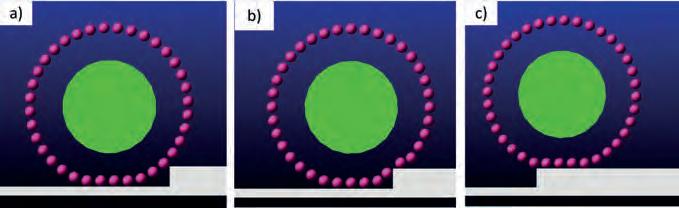

Arkadiusz Rubiec, Mirosław Przybysz, Marian J. Łopatka, Łukasz Rykała, Piotr Krogul, Karol Cieślik, Rafał Typiak Study on the Influence of an UGV Suspension System on Camera Motion of the Teleoperation System

2/2024 ISSN 1427-9126 Indeks 339512 Cena 30,00 zł w tym 8% VAT

Technical

Quarterly

9 77142791240 52 0 Informacje dla Autorów – 125 | Nasze wydawnictwa – 127 | Repozytorium Robotyki – 128 | Symulatory Kolejowe ACM – III okładka kwartalnik

kwiecień–czerwiec www.par.pl

Sciences

| Measurements Automation Robotics Ponadto: PAR

naukowo-techniczny

Rok 28 (2024) Nr 2(252)

ISSN 1427-9126, Indeks 339512

Redaktor naczelny

prof. Cezary Zieliński

Zastępca redaktora naczelnego dr inż. Małgorzata Kaliczyńska

Zespół redakcyjny dr inż. Jerzy Borzymiński

prof. Wojciech Grega – automatyka prof. Krzysztof Janiszowski dr inż. Małgorzata Kaliczyńska – redaktor merytoryczny/statystyczny dr inż. Michał Nowicki – mechatronika prof. Mateusz Turkowski – metrologia prof. Cezary Zieliński – robotyka

Korekta

dr inż. Janusz Madejski

Skład i redakcja techniczna

Ewa Markowska

Druk

Drukarnia „PAPER & TINTA” Barbara Tokłowska Sp. K. Nakład 500 egz.

Wydawca

Sieć Badawcza Łukasiewicz –Przemysłowy Instytut Automatyki i Pomiarów PIAP Al. Jerozolimskie 202, 02-486 Warszawa

Kontakt

Redakcja kwartalnika naukowo-technicznego Pomiary Automatyka Robotyka Al. Jerozolimskie 202, 02-486 Warszawa tel. 22 874 01 46, nauka@par.pl www.par.pl

Pomiary Automatyka Robotyka jest czasopismem naukowo-technicznym obecnym na rynku od 1997 r. Przez 18 lat ukazywało się jako miesięcznik. Aktualnie wydawany kwartalnik zawiera artykuły recenzowane, prezentujące wyniki teoretyczne i praktyczne prowadzonych prac naukowo-badawczych w zakresie szeroko rozumianej automatyki, robotyki i metrologii. Kwartalnik naukowo-techniczny Pomiary Automatyka Robotyka jest indeksowany w bazach BAZTECH, Google Scholar oraz INDEX COPERNICUS (ICV 2022: 91,28), a także w bazie naukowych i branżowych polskich czasopism elektronicznych ARIANTA. Przyłączając się do realizacji idei Otwartej Nauki, udostępniamy bezpłatnie wszystkie artykuły naukowe publikowane w kwartalniku naukowo-technicznym Pomiary Automatyka Robotyka. Wersją pierwotną (referencyjną) jest wersja papierowa.

Punktacja Ministerstwa Edukacji i Nauki za publikacje naukowe w kwartalniku Pomiary Automatyka Robotyka wynosi obecnie 70 pkt. (wykaz czasopism naukowych i recenzowanych materiałów z konferencji międzynarodowych z dnia 5 stycznia 2024 r., poz. 29984). Przypisane dyscypliny naukowe – automatyka, elektronika, elektrotechnika i technologie kosmiczne.

Kwartalnik jest organem wydawniczym Polskiego Stowarzyszenia Pomiarów, Automatyki i Robotyki POLSPAR – organizacji prowadzącej działalność naukowo-techniczną w obszarze metrologii, automatyki, robotyki i pomiarów, reprezentującej Polskę w międzynarodowych organizacjach IFAC, IFR, IMEKO.

Rada Naukowa

prof. Jan Awrejcewicz

Katedra Automatyki, Biomechaniki i Mechatroniki, Politechnika Łódzka

prof. Milan Dado University of Žilina (Słowacja)

prof. Ignacy Dulęba Wydział Elektroniki, Fotoniki i Mikrosystemów, Politechnika Wrocławska

prof. Tadeusz Glinka Instytut Elektrotechniki i Informatyki, Politechnika Śląska

prof. Evangelos V. Hristoforou National Technical University of Athens (Grecja)

dr Oleg Ivlev University of Bremen (Niemcy)

prof. Larysa A. Koshevaja Narodowy Uniwersytet Lotnictwa, Kiev (Ukraina)

prof. Igor P. Kurytnik

Małopolska Uczelnia Państwowa im. rot. W. Pileckiego

prof. J. Tenreiro Machado Polytechnic Institute of Porto (Portugalia)

prof. Jacek Malec

Lund University (Szwecja)

prof. Andrzej Masłowski Sieć Badawcza Łukasiewicz –Przemysłowy Instytut Automatyki i Pomiarów PIAP, Warszawa

prof. Maciej Michałek

Wydział Automatyki, Robotyki i Elektrotechniki, Politechnika Poznańska

dr Vassilis C. Moulianitis University of Patras (Grecja)

prof. Joanicjusz Nazarko

Wydział Inżynierii Zarządzania, Politechnika Białostocka

prof. Serhiy Prokhorenko

„Lviv Polytechnic” National University (Ukraina)

prof. Eugeniusz Ratajczyk

Wydział Inżynierii i Zarządzania, Wyższa Szkoła Ekologii i Zarządzania w Warszawie

prof. Jerzy Sąsiadek Carleton University (Kanada)

prof. Rossi Setchi

Cardiff University (Wielka Brytania)

prof. Waldemar Skomudek

Wydział Elektrotechniki, Automatyki, Informatyki i Inżynierii Biomedycznej, Akademia Górniczo-Hutnicza

dr Dragan Stokic

ATB – Institute for Applied Systems Technology Bremen GmbH (Niemcy)

prof. Eugeniusz Świtoński

Wydział Mechaniczny Technologiczny, Politechnika Śląska

prof. Peter Švec Slovak Academy of Sciences (Słowacja)

prof. Wojciech Włodarski

RMIT University, Melbourne (Australia)

prof. Eugenij T. Volodarsky

„Kyiv Polytechnic” National University (Ukraina)

Wydawanie kwartalnika Pomiary Automatyka Robotyka – zadanie finansowane w ramach umowy 907/P-DUN/2019 ze środków Ministra Nauki i Szkolnictwa Wyższego przeznaczonych na działalność upowszechniającą naukę.

Spis treści

3 Od Redakcji

5 Zbigniew Świder

Nastawy regulatora kursu dla autopilota statku

Tuning the Heading Controller for the Ship’s Autopilot

11 Tomasz Winiarski, Jan Kaniuka, Jakub Ostrysz

Metodyka projektowania systemów robotycznych w oparciu o metamodele

EARL i MeROS

Robotic Systems Development Method Based on EARL and MeROS Metamodels

21 Sandra Śmigiel, Tomasz Topoliński, Damian Ledziński, Tomasz Andrysiak

The ECG Monitoring System Using Machine Learning Methods and LoRa Technology System do monitorowania sygnału EKG z wykorzystaniem metod uczenia maszynowego i technologii LoRa

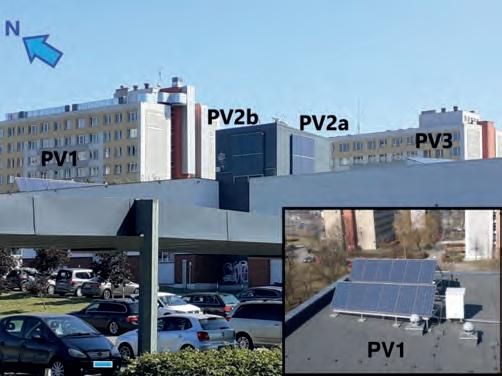

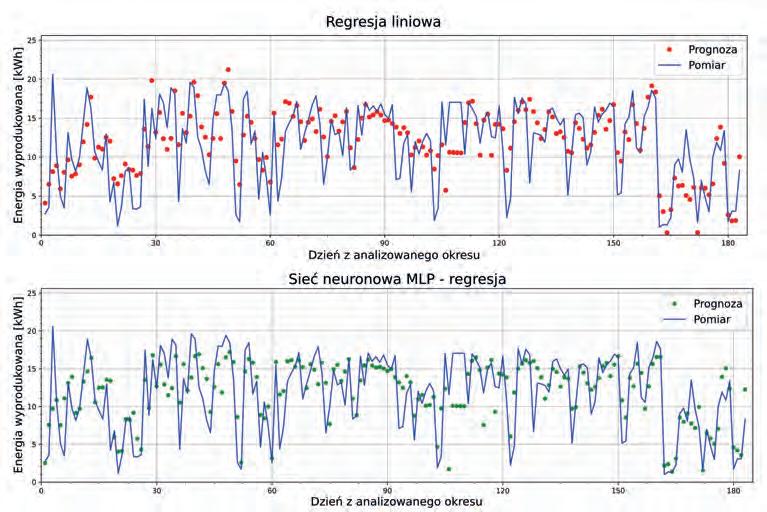

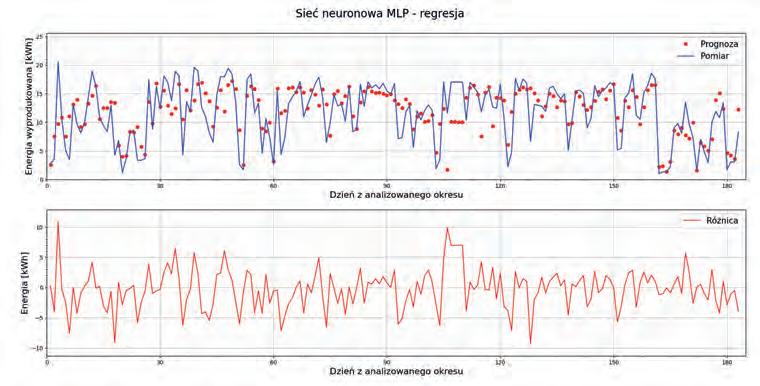

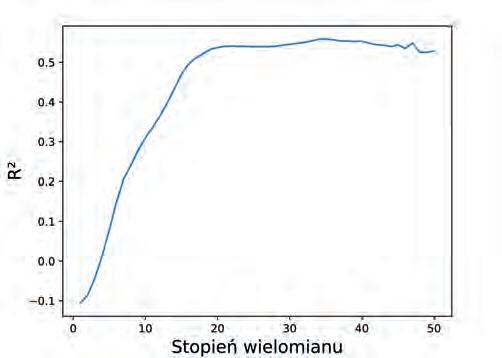

37 Adam Idźkowski, Mateusz Sumorek

Zastosowanie metod uczenia maszynowego do predykcji generowanej energii w małym systemie PV

The Use of Machine Learning Algorithms to Forecast Energy Production in a Small PV System

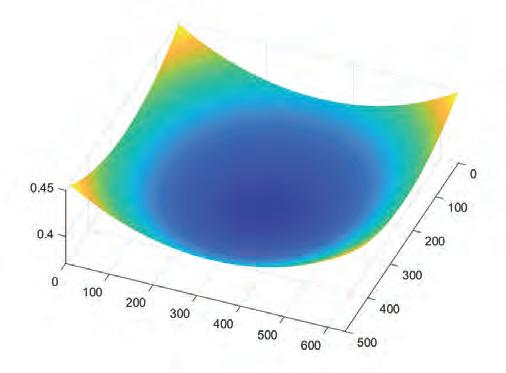

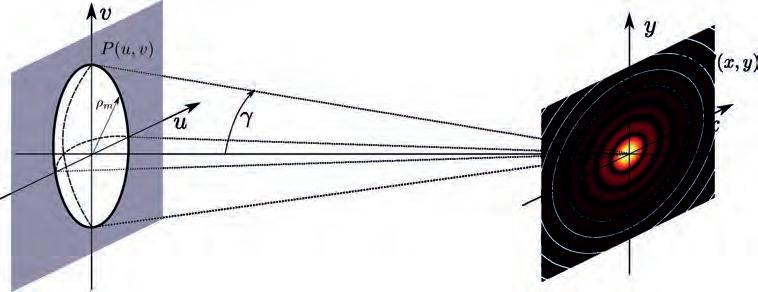

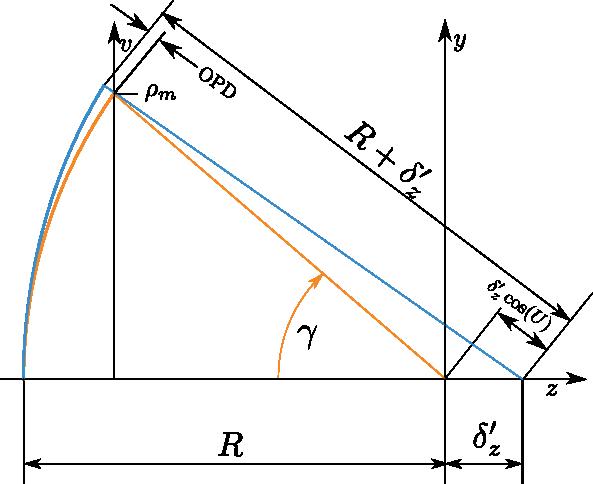

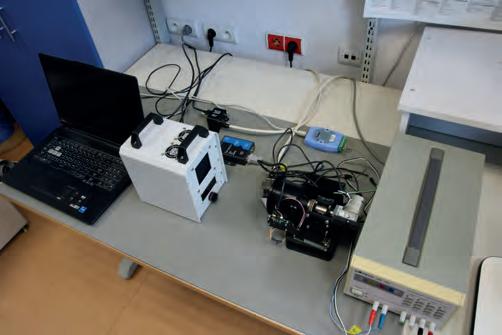

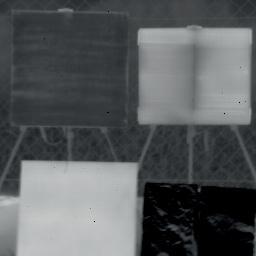

45 Karol Erd

Analiza porównawcza wybranych metod kalibracji kamery termowizyjnej z chłodzonym detektorem pracującym w zakresie MWIR

Comparative Analysis of Selected Calibration Methods for a Thermal Imaging Camera with a Cooled Detector Operating in the MWIR Range

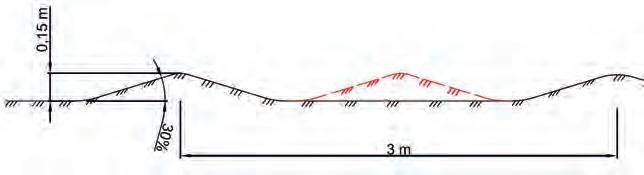

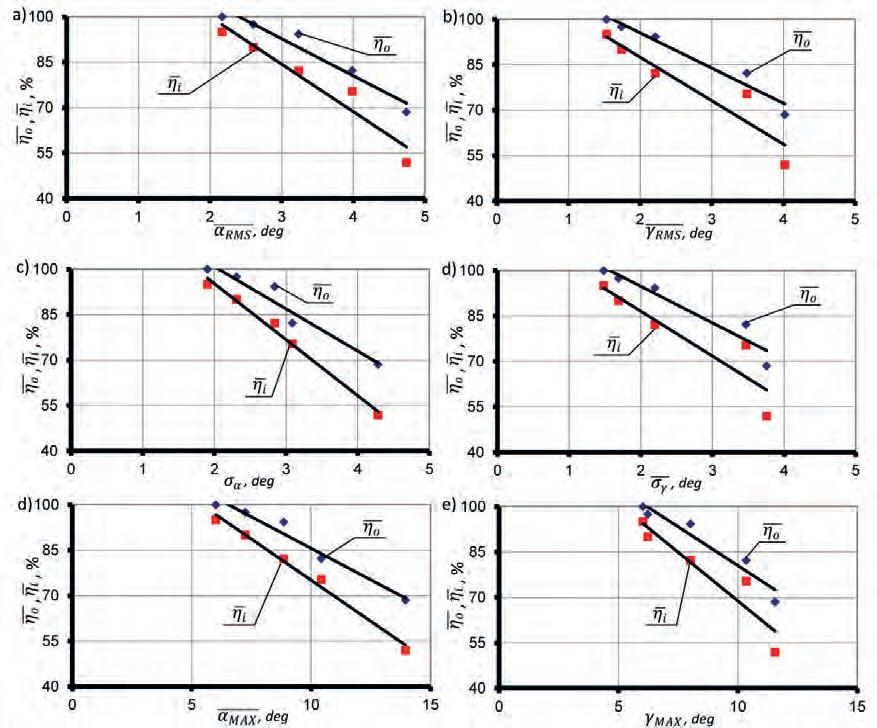

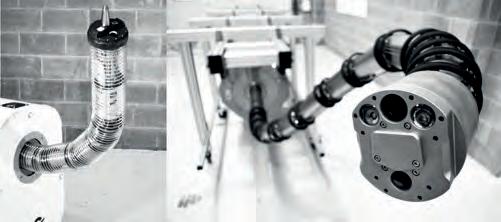

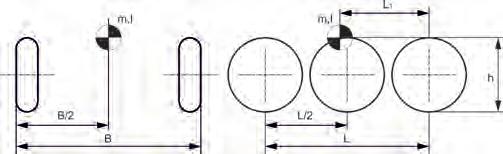

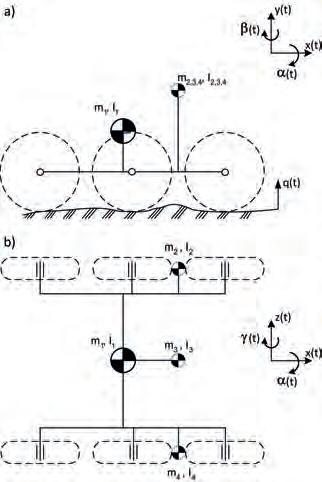

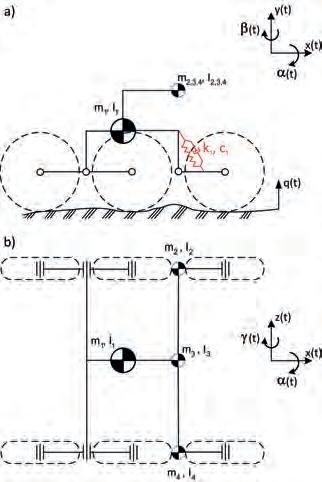

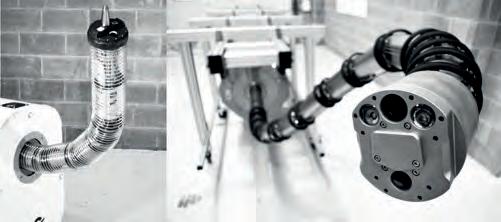

53 Arkadiusz Rubiec, Mirosław Przybysz, Marian J. Łopatka, Łukasz Rykała, Piotr Krogul, Karol Cieślik, Rafał Typiak

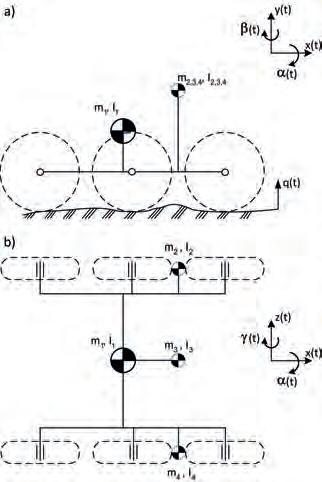

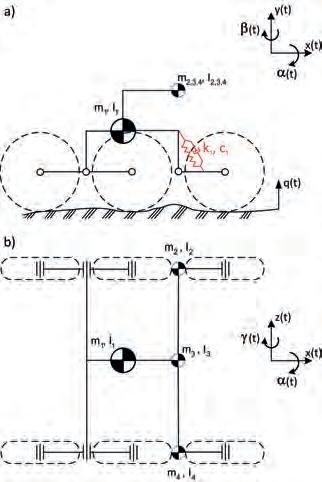

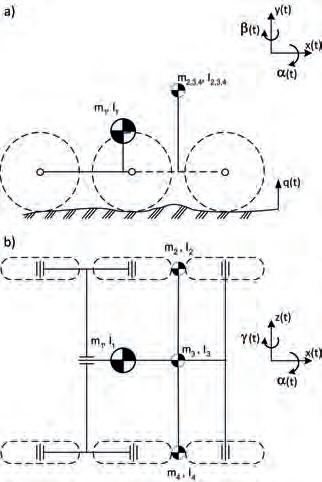

Study on the Influence of an UGV Suspension System on Camera Motion of the Teleoperation System

Badanie wpływu układu zawieszenia bezzałogowej platformy lądowej na ruch kamery układu teleoperacji

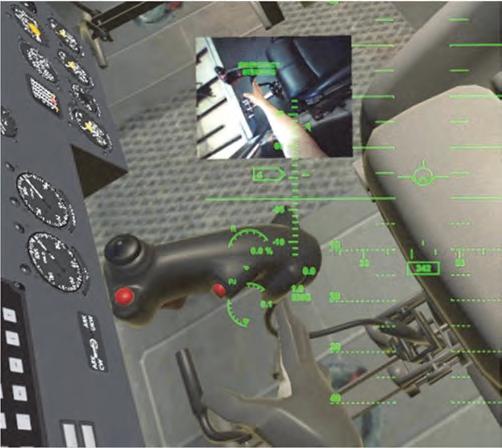

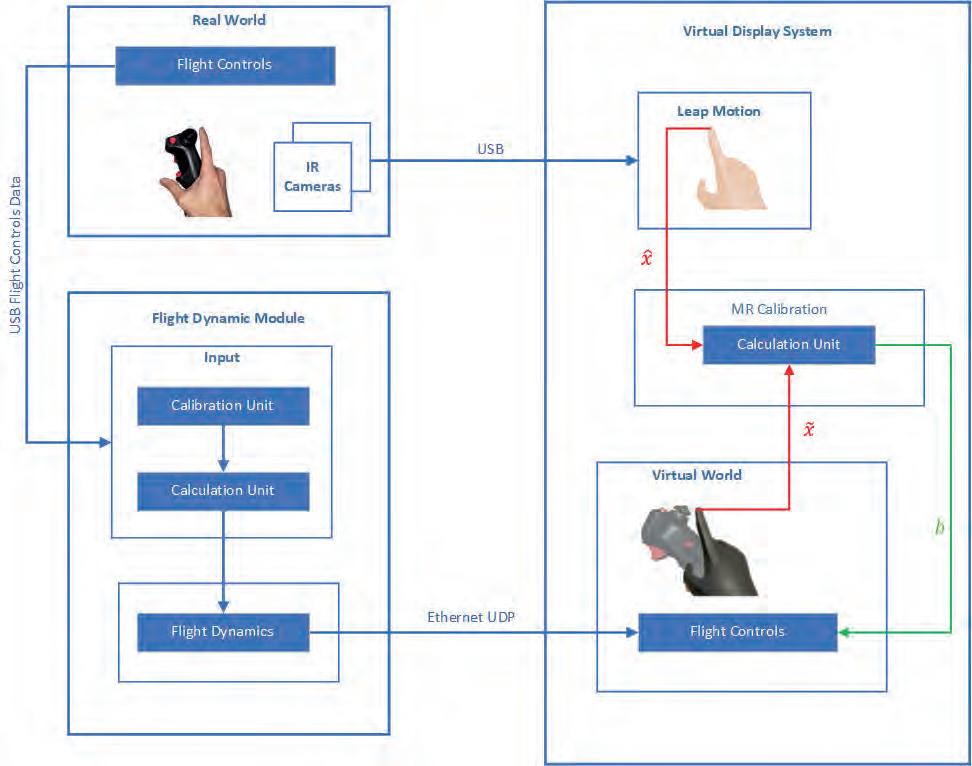

67 Piotr Golański, Marek Szczekala

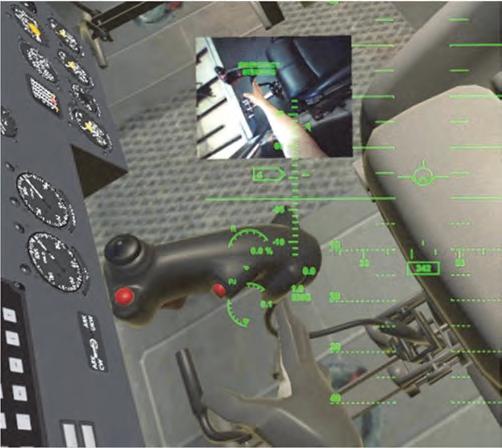

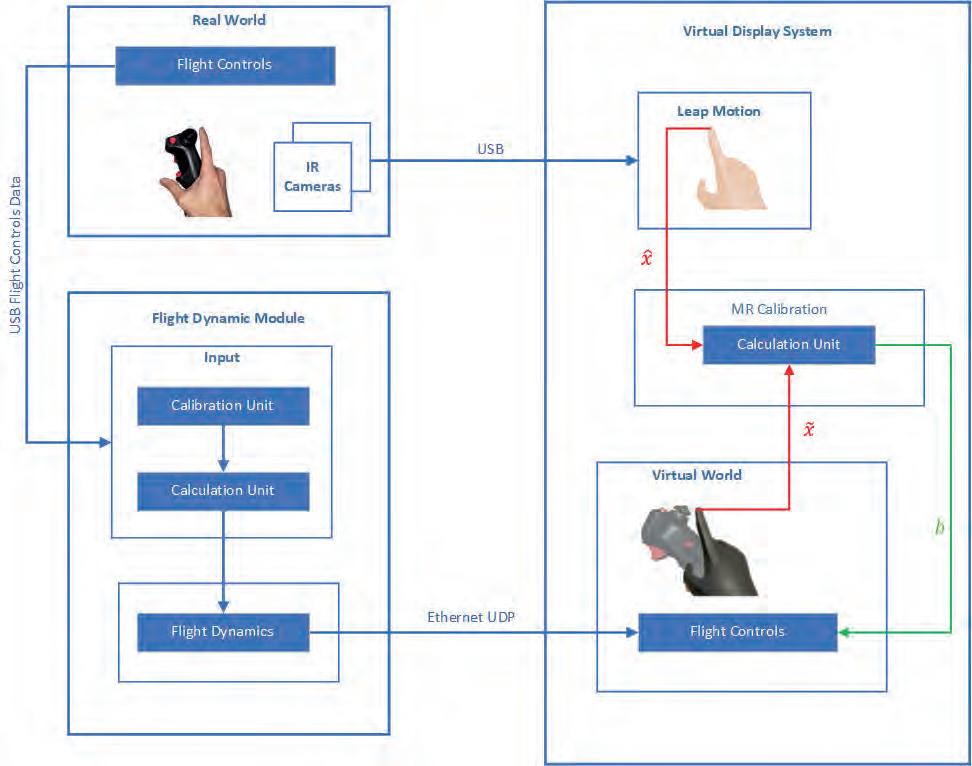

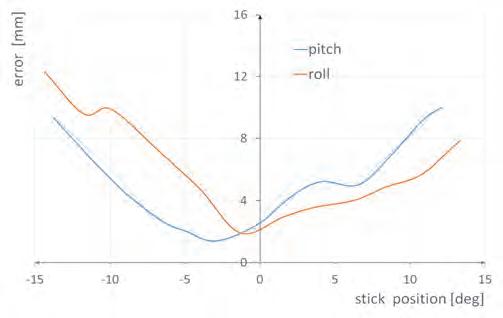

Using the Digital-Twin Technology in the Mi-17 Mixed Reality Simulator Zastosowanie technologii cyfrowych bliźniaków w symulatorze mieszanej rzeczywistości śmigłowca Mi-17

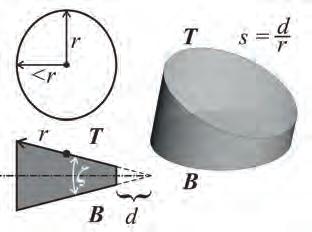

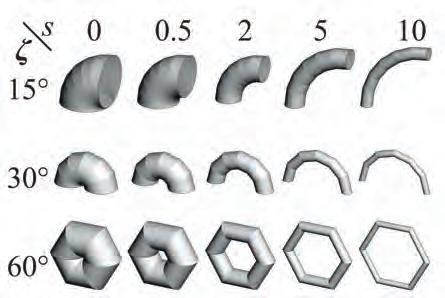

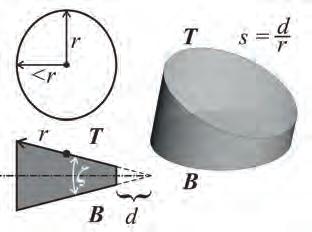

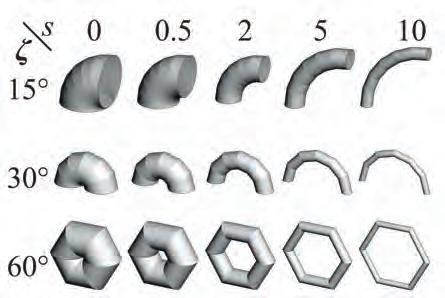

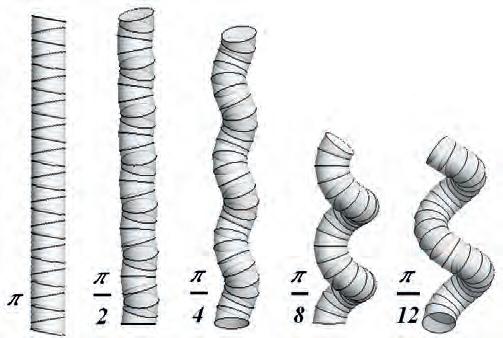

73 Ela Zawidzka, Jacek Szklarski, Janusz Kobaka, Machi Zawidzki Przykłady Małej Architektury w oparciu o System Arm-Z

Examples of Urban Furniture Based on Arm-Z System

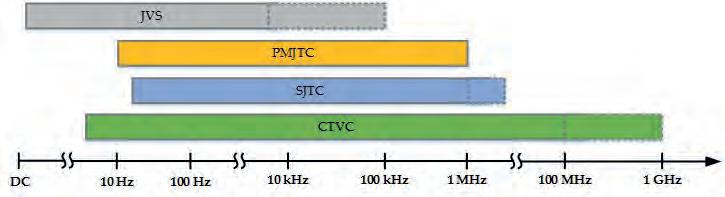

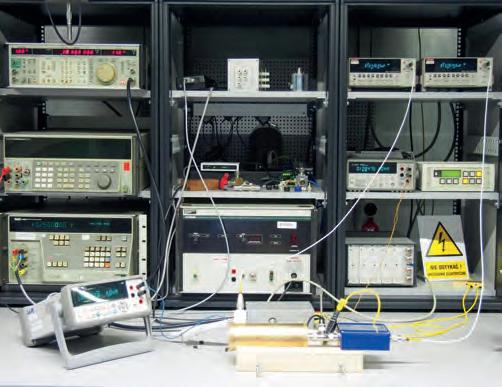

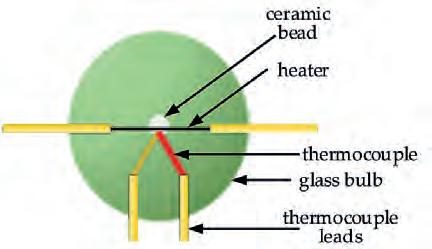

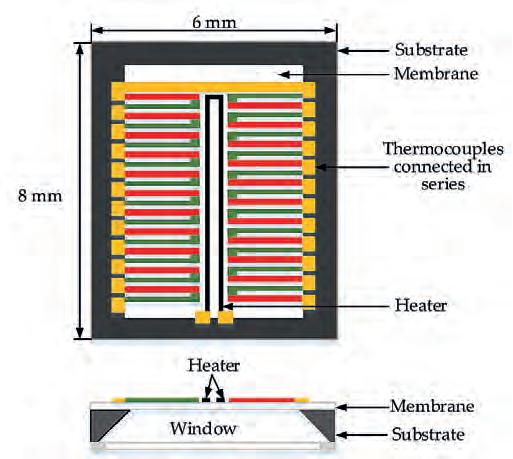

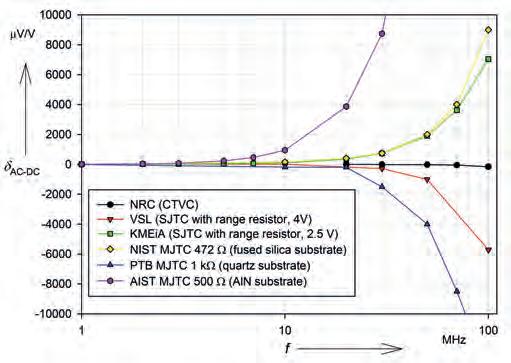

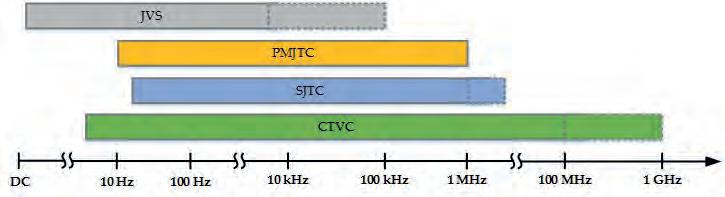

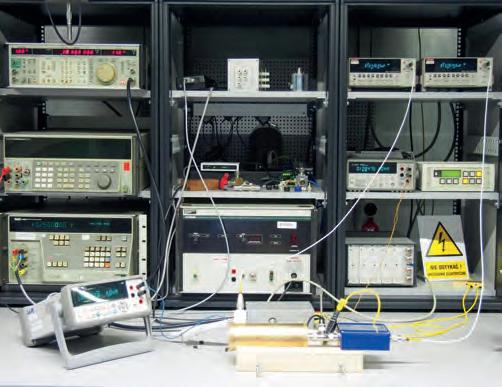

81 Krzysztof Kubiczek, Marian Kampik, Michał Grzenik, Krzysztof Musioł, Anna Piaskowy

Wideband AC Voltage Standards

Wzorce napięcia przemiennego o szerokim paśmie częstotliwości

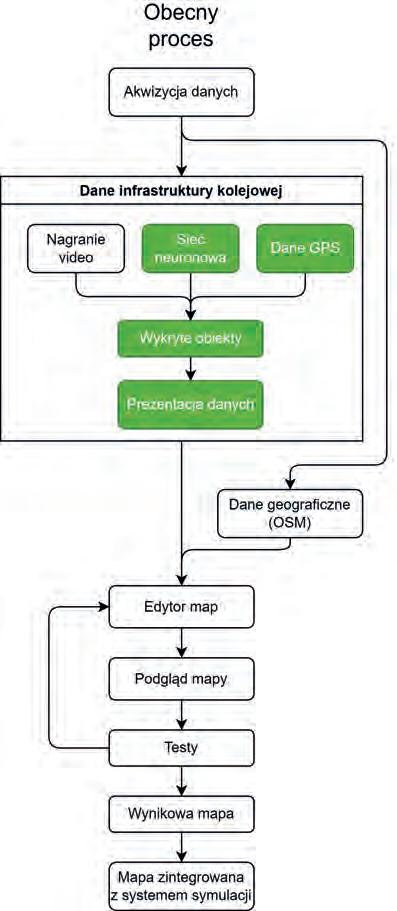

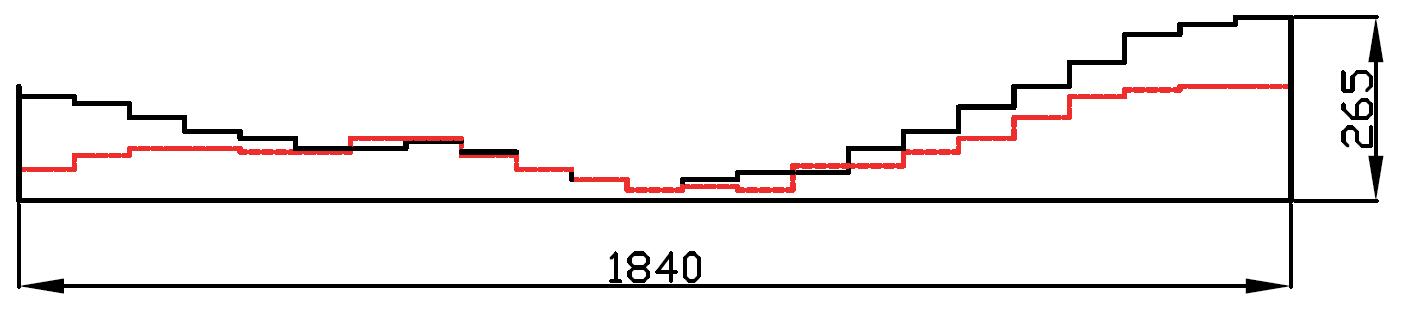

1 Pomiary Automatyka Robotyka, ISSN 1427-9126, R. 28, Nr 2/2024

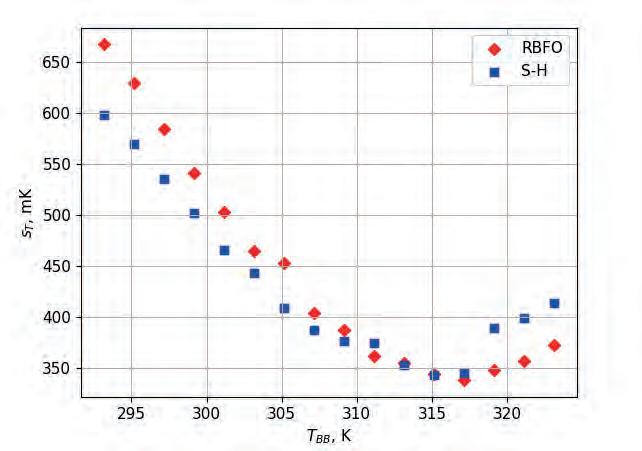

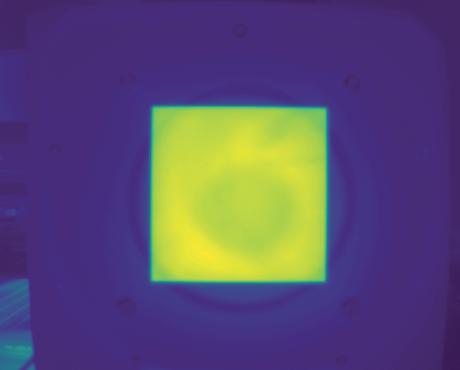

89 Tomasz Sosnowski, Mariusz Kastek, Krzysztof Sawicki, Grzegorz Bieszczad, Sławomir Gogler, Tadeusz Piątkowski

Metoda pomiaru temperatury ciała człowieka za pomocą kamery termowizyjnej

The Method of Measuring Human Body Temperature Using a Thermal Imaging Camera

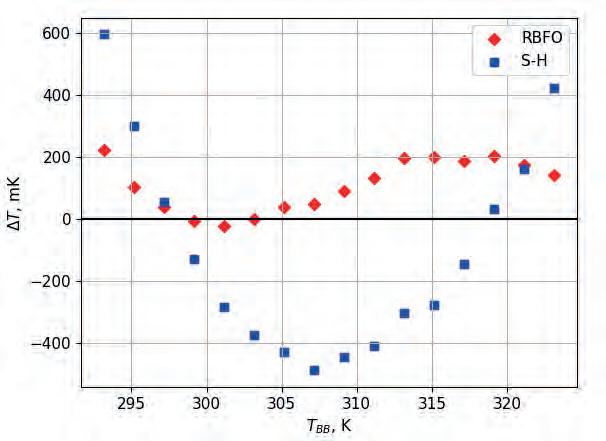

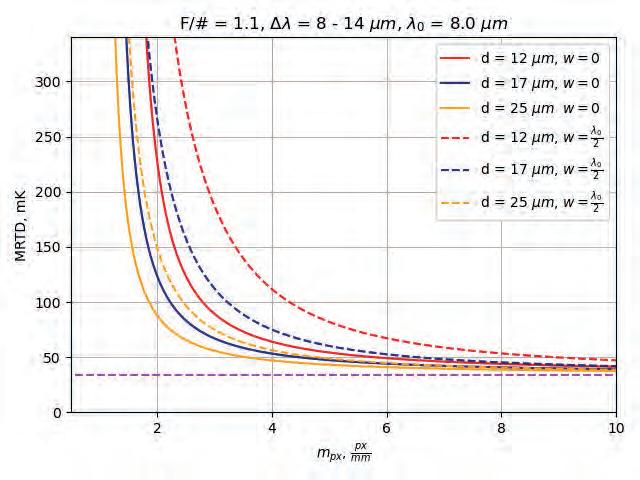

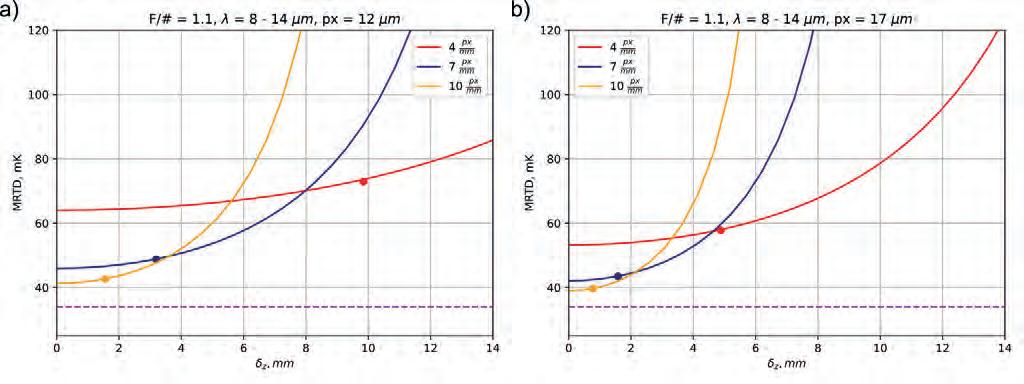

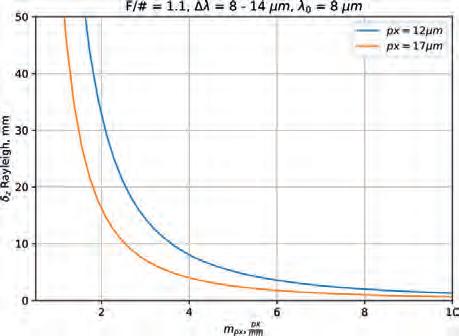

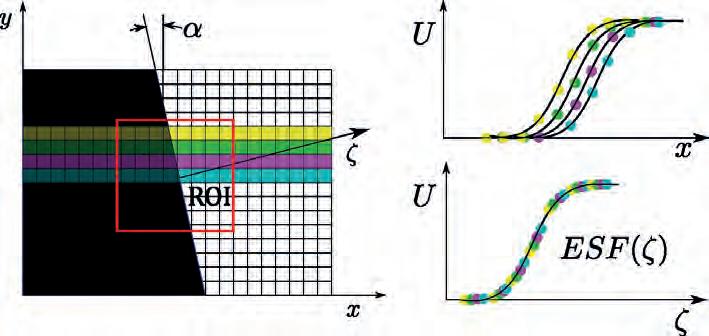

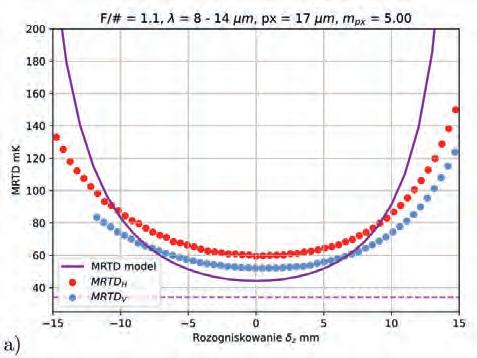

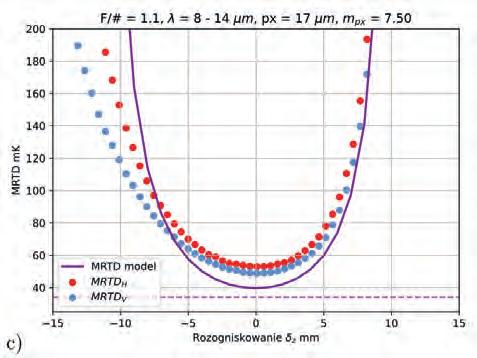

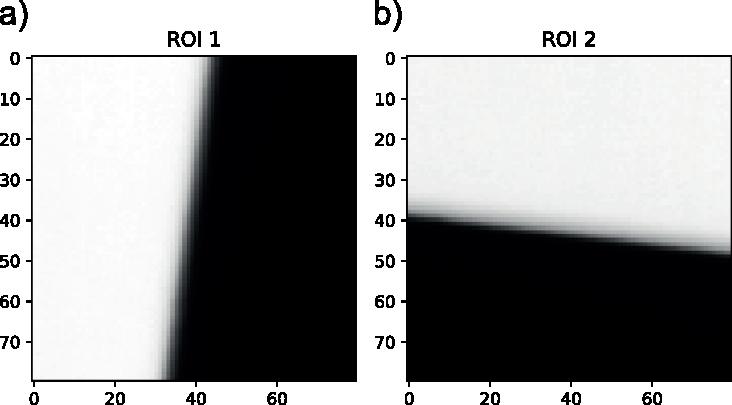

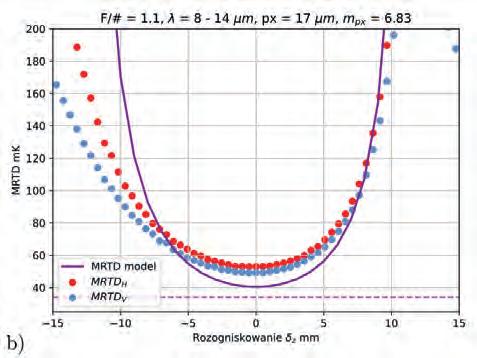

99 Sławomir Gogler, Krzysztof Sawicki, Andrzej Ligienza, Mariusz Mścichowski

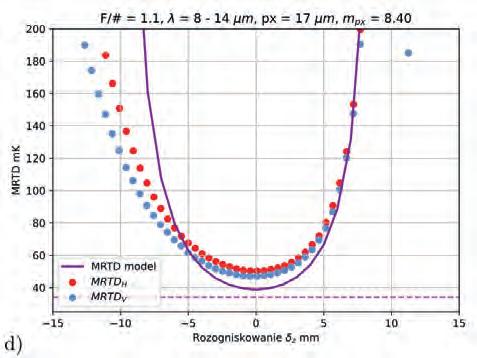

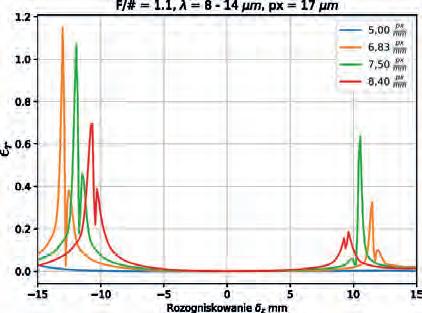

Metoda pomiaru minimalnej rozróżnialnej różnicy temperatury w funkcji powiększenia i rozogniskowania kamery termowizyjnej

A Method of Measurement of Minimum Resolvable Temperature Difference as a Function of Magnification and Defocusing of a Thermal Camera

107 Andrzej Ligienza, Mariusz Kastek, Tomasz Sosnowski, Krzysztof Firmanty

Nieselektywne powierzchnie referencyjne w teledetekcji hiperspektralnej w zakresie dalekiej podczerwieni

Non-selective Reference Surfaces for Hyperspectral Remote Sensing in the Long-Wave Infrared Range

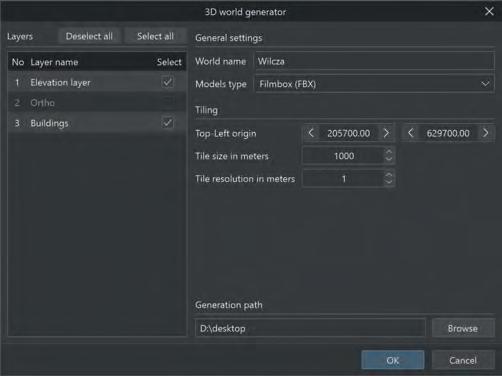

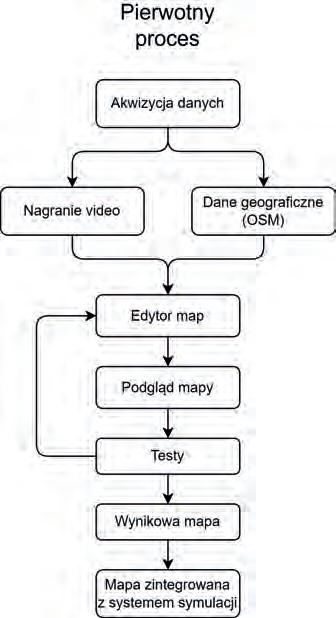

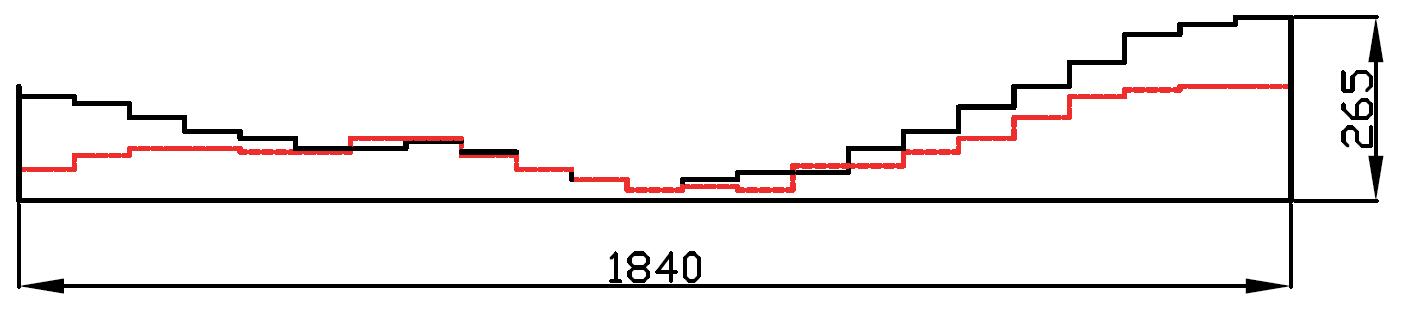

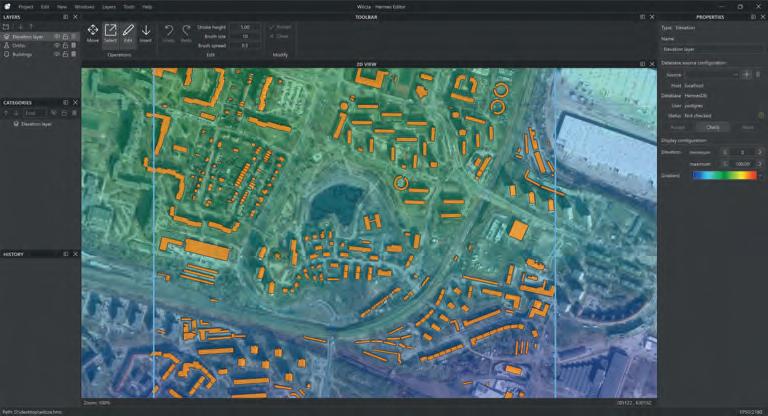

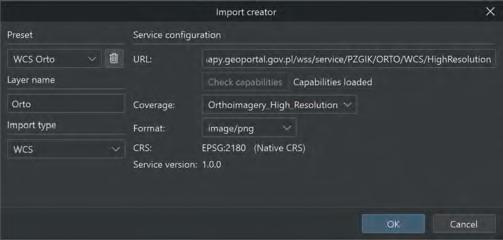

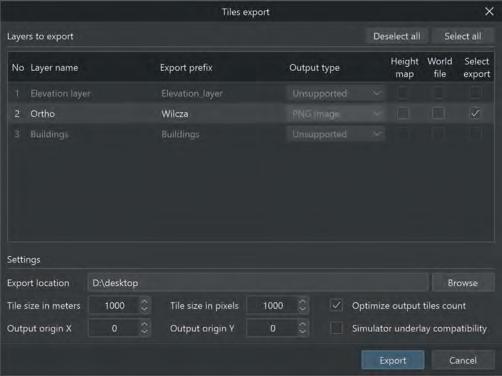

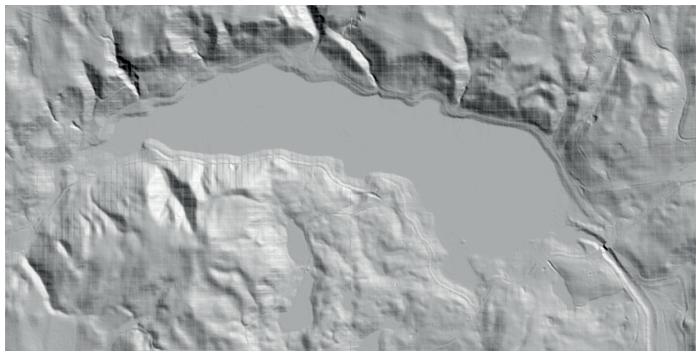

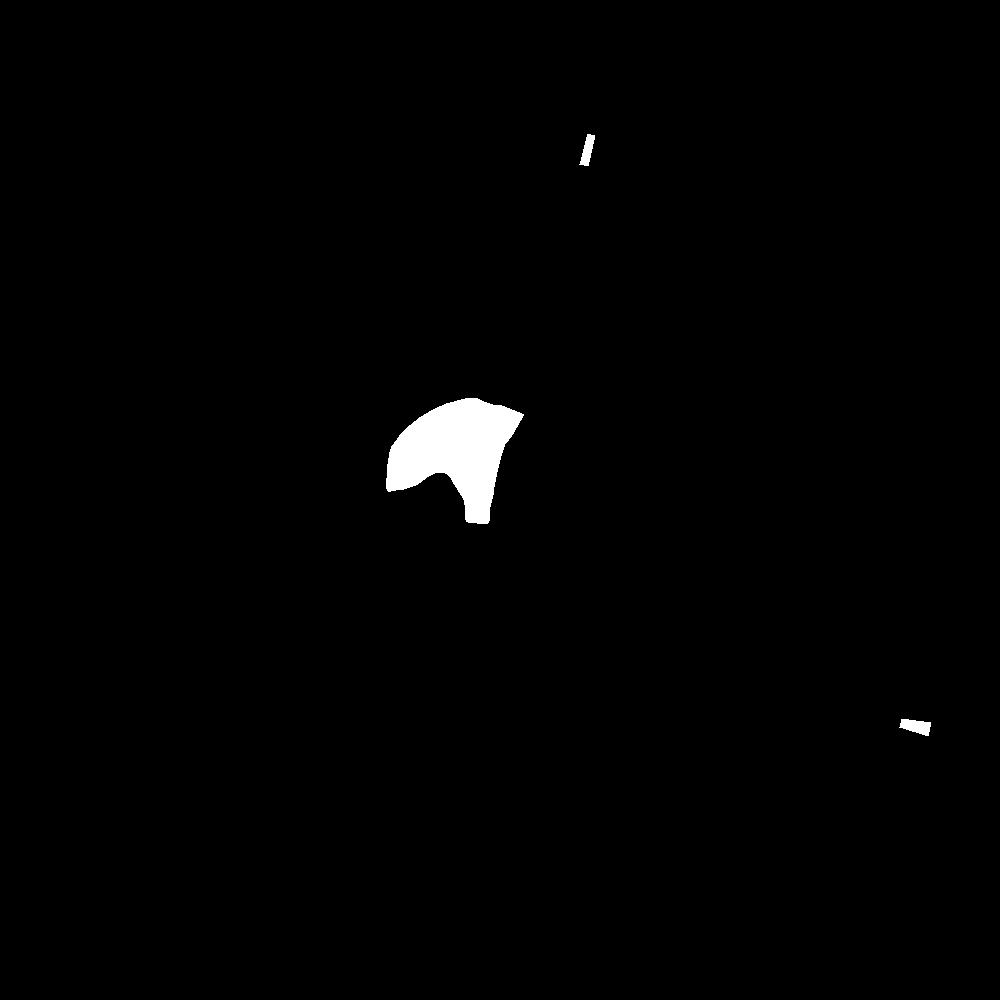

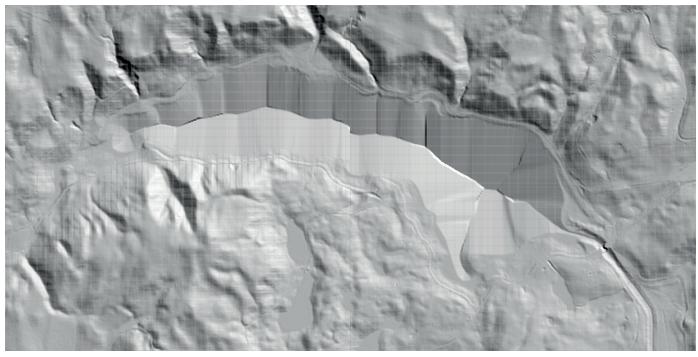

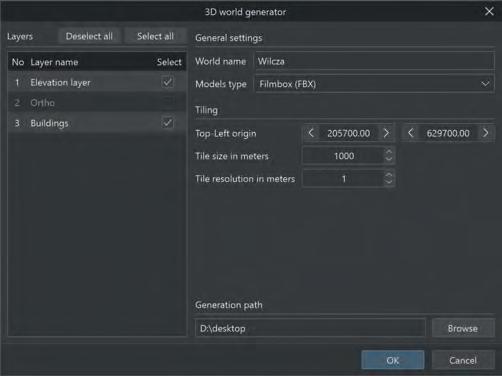

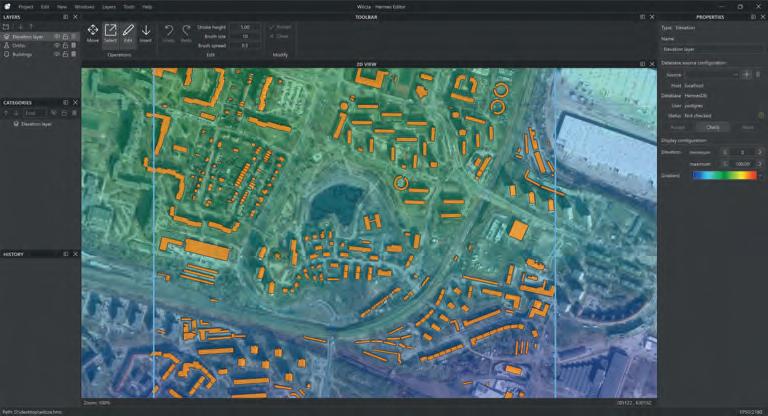

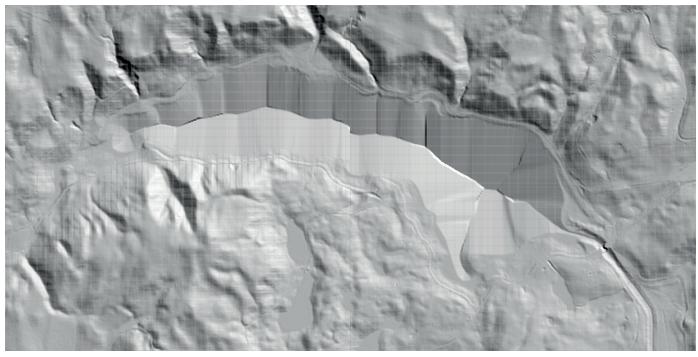

113 Mateusz Tecław, Maciej Szłapczyński

Generacja terenu przestrzennego za pomocą edytora Hermes

Generation of Spatial Terrain Using the Hermes Editor

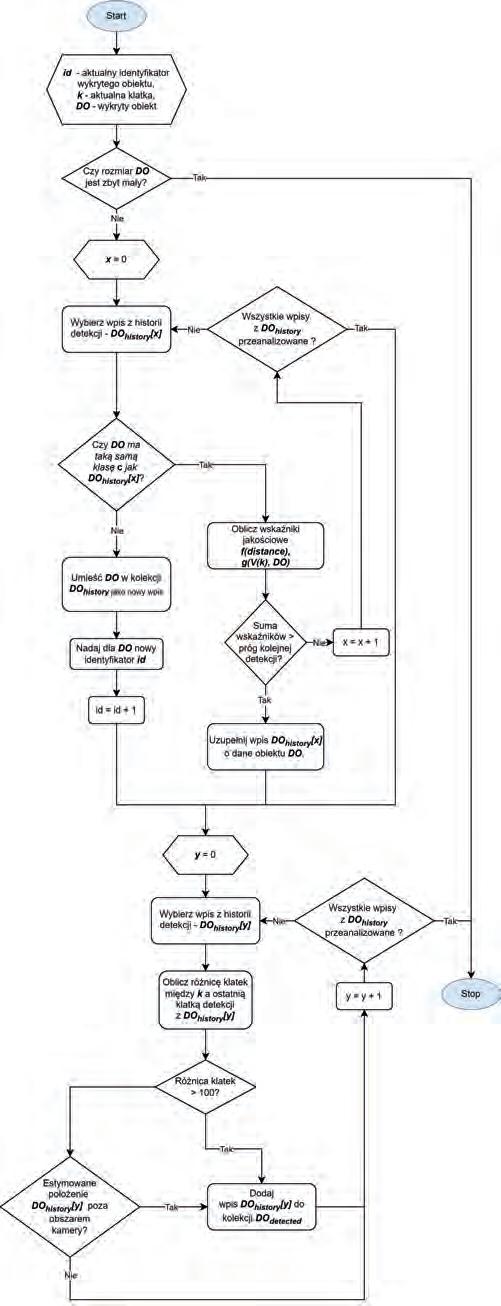

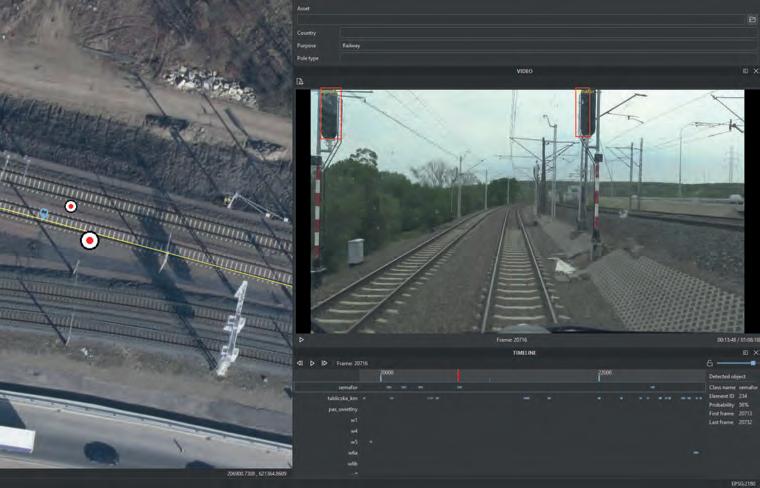

119 Paweł Lisiecki, Maciej Szłapczyński, Ewelina Chołodowicz

Automatyczna generacja wirtualnych elementów infrastruktury kolejowej

Automatic Generation of Virtual Railway Infrastructure Elements

125 Informacje dla Autorów

127 Nasze wydawnictwa

128 Repozytorium Robotyki

2 SPIS TREŚCI POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

Drodzy Czytelnicy,

bieżący numer naszego kwartalnika, podobnie jak poprzednie, przedstawia szeroką gamę zagadnień dotyczących pomiarów, automatyki, robotyki i informatyki. Cieszy nas szczególnie, że od wielu kwartałów znaczna liczba autorów wybiera nasze czasopismo do prezentacji wyników swoich badań. Ten numer przynosi czternaście artykułów, które pozytywnie przeszły proces recenzji. Mamy nadzieję, że zaobserwowany trend utrzyma się w przyszłości.

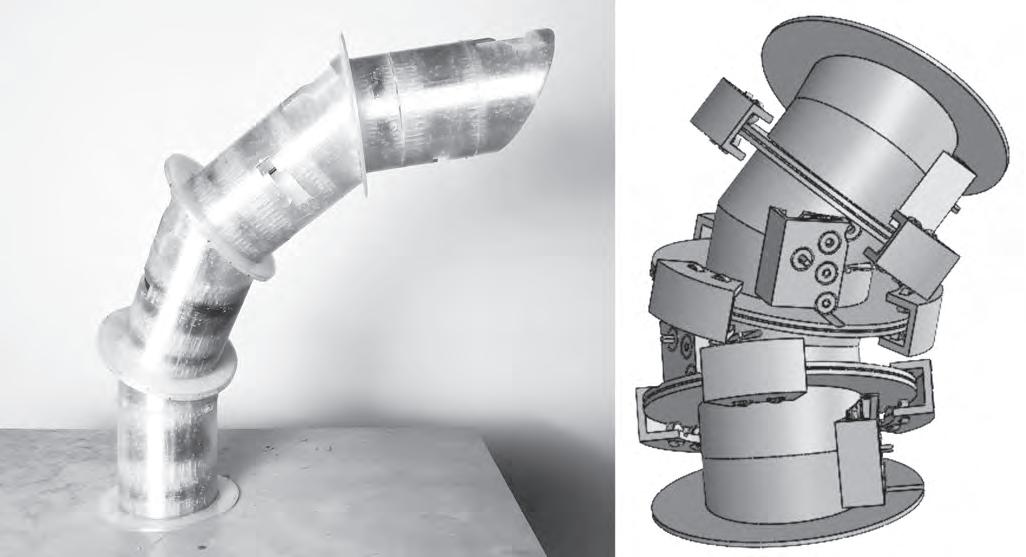

Zagadnienia związane z robotyką poruszane są w czterech artykułach. Jeden poświęcony jest opisowi pewnej metody projektowania systemów robotycznych. Proponuje zastosowanie graficznego opisu systemów złożonych z agentów upostaciowionych realizowanych za pomocą oprogramowania ROS/ROS 2 do stworzenia specyfikacji, na podstawie której można zaimplementować docelowy system. Kolejny artykuł prezentuje wytyczne projektowe dotyczące uwzględnienia wpływu zawieszenia teleoperowanego pojazdu bezzałogowego, na obraz uzyskiwany z kamery zamocowanej na nim. Następny artykuł z tej grupy dotyczy tworzenia obrazów, w których łączone są zdjęcia rzeczywistych obiektów z graficznymi reprezentacjami sztucznych obiektów, w celu użycia ich w symulatorach helikopterów. Ostatni artykuł z cyklu poświęconego robotyce dotyczy konstrukcji redundantnego łańcucha kinematycznego manipulatora o specyficznych złączach.

W tym numerze kwartalnika jedynie dwa artykuły poświęcone są automatyce. Pierwszy z nich zajmuje się doborem nastaw regulatora PID zastosowanego w autopilocie statku. Natomiast drugi dotyczy prognozowania ilości generowanej energii elektrycznej w sieciach fotowoltaicznych z wykorzystaniem uczenia maszynowego.

Sześć artykułów poświęconych jest pomiarom. Pierwszy zajmuje się analizą sygnałów uzyskiwanych z encefalografu, do której wykorzystano techniki uczenia maszynowego w celu wykrywania kategorii schorzeń serca. Drugi poświęcony jest metrologicznym właściwościom oraz sposobom konstrukcji szerokopasmowych wzorców napięcia przemiennego. Trzeci ogniskuje uwagę Czytelnika na konstrukcji powierzchni referencyjnych służących do kalibracji kamer hiperspektralnych, jakie stosowane są do teledetekcji w zakresie podczerwieni. Kolejne trzy artykuły związane są z różnymi aspektami wykorzystania kamer termowizyjnych. Pierwszy dotyczy pomiaru temperatury człowieka. Drugi kalibracji tego typu kamer. A ostatni zajmuje się detekcją odczynów alergicznych skóry za pomocą pomiaru niewielkich różnic temperatury między nieodległymi obszarami.

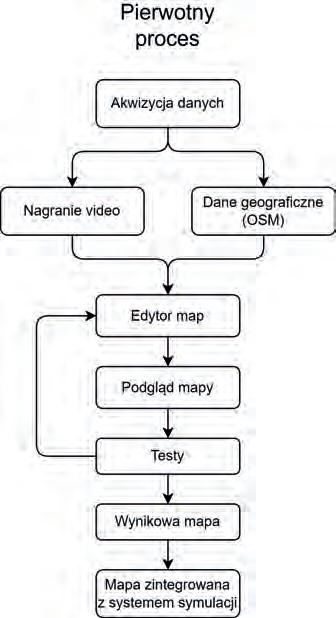

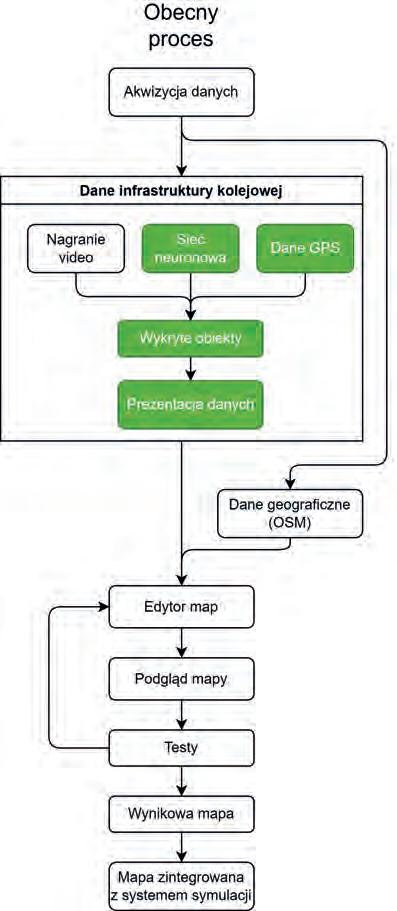

Dwa artykuły dotyczące informatyki technicznej koncentrują się na automatycznym tworzeniu trójwymiarowych modeli otoczenia. Jeden zajmuje się generowaniem modeli graficznych budynków i terenów, a drugi wirtualnej infrastruktury kolejowej.

Mamy nadzieję, że wybór artykułów opublikowanych w tym numerze wzbudzi Państwa ciekawość.

Redakcja życzy intersującej lektury.

Redaktor naczelny kwartalnika Pomiary Automatyka Robotyka prof. dr hab. inż. Cezary Zieliński

3 OD REDAKCJI

4 POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

Nastawy regulatora kursu dla autopilota statku

Zbigniew Świder

Politechnika Rzeszowska, Katedra Informatyki i Automatyki, al. Powstańców Warszawy 12, 35-959 Rzeszów

Streszczenie: Przedstawiono wybrane metody doboru nastaw PID dla regulatora kursu w autopilocie statku. Spójność projektowania jest możliwa dzięki temu, że zastosowano model Nomoto dla statku oraz dzięki eliminacji przez regulator stałej czasowej obiektu, przez co układ zamknięty staje się układem 2-go rzędu. W dwóch przypadkach założono dodatkowo, że układ ten ma mieć podwójną stałą czasową, różniącą się w zadanym stosunku r od stałej czasowej obiektu. Pokazano, że tak zaprojektowany regulator kursu zapewnia przebiegi aperiodyczne krytyczne przy skokowej zmianie wartości zadanej oraz lepiej tłumi zakłócenia środowiskowe niż standardowo nastrojone regulatory.

Słowa kluczowe: regulator PID, autopilot statku, dobór nastaw, odpowiedź skokowa

1. Wprowadzenie

Powszechnie stosowanym w praktyce algorytmem sterowania kursem statku jest PID z nastawami wyznaczonymi dla prostego opisu dynamiki statku, znanego w literaturze jako model Nomoto [1–3]. Ma on postać integratora ze stałą czasową i jego współczynniki są określane na podstawie prób morskich (zwykle na otwartych wodach). Dodatkowo, śledzenie prostoliniowego fragmentu trasy, inaczej ścieżki pomiędzy dwoma zadanymi punktami na mapie, można realizować w układzie kaskadowym [4, 5] z regulatorem nadrzędnym (także PID) wyznaczającym zadany kurs dla regulatora podrzędnego (również PID).

Parametry modelu Nomoto, a więc i nastawy PID, można uzależnić od prędkości statku otrzymując adaptacyjny regulator kursu (utrzymujący zadany kurs magnetyczny). Trudnością jest jednak uzależnienie ich od stopnia załadowania, zmiennego dla wielu typów statków, oraz innych czynników. Rozwiązaniem może być tutaj rozmyty regulator PID, w którym na podstawie odchyłki kursu i prędkości jej zmiany co pewien czas koryguje się nastawy według wcześniej przygotowanych reguł [6, 7].

Wzorcowe nastawy regulatora PID sterującego kursem statku podane są m.in. w książkach Fossena [2, 3], fundamentalnych dla automatyki okrętowej. Zakłada się tam, że układ zamknięty, na razie tylko z regulatorem PD, ma mieć transmitancję 2-go rzędu o częstotliwości naturalnej n ω i współczynniku tłumienia ξ zawartego w przedziale [0,8; 1]. Składową I, dołączaną następnie do PD, określa wzór heurystyczny (pocho-

Autor korespondujący:

Zbigniew Świder, swiderzb@prz.edu.pl Artykuł recenzowany nadesłany 18.02.2024 r., przyjęty do druku 10.04.2024 r.

dzący od Balchena). Z takich nastaw wzorcowych korzysta obecnie wielu autorów, np. [7, 8].

Alternatywą dla tych nastaw mogą być nastawy podane w [8, 9] (obliczone metodą lokacji biegunów), sformułowane przy założeniu podwójnej stałej czasowej układu zamkniętego (tłumienie krytyczne), która w zadanym stosunku ma różnić się od stałej czasowej statku. Dzięki eliminacji przez regulator tej stałej czasowej, układ zamknięty staje się układem 2-go rzędu, ale bez sięgania po zależność heurystyczną.

Wśród komercyjnych autopilotów statków wykorzystujących regulatory PID pierwszą grupę stanowią proste regulatory kursu, których nastawy dobierane są ręcznie, np. [12]. Do drugiej grupy należą autopiloty wyposażone w GPS [13], które mogą kierować statek do wybranego punktu (ang. Goto Waypoint) lub przechwytywać założoną ścieżkę między dwoma punktami na mapie (ang. Goto Track). Trzecią grupę stanowią zaawansowane rozwiązania z wbudowanym trybem śledzenia ścieżki oraz możliwością planowania optymalnej trasy podróży na urządzeniu ECDIS (ang. Electronic Chart Display Information System). Producenci autopilotów nie podają jednak, według jakich zależności dobierane są nastawy regulatorów.

2. Układy regulacji kursu statku

2.1. Model statku i regulator PID

Dla celów projektowania układów regulacji prostym opisem dynamiki statku dla sterowania kursem φ za pomocą wychylenia steru δ jest model Nomoto [1–3] w postaci transmitancji trzeciego rzędu

() ()() 1 , 11 c ab skTs ssTsTs

(1)

gdzie k jest wzmocnieniem statycznym a T a, Tb, T c stałymi czasowymi. Na podstawie prób na otwartym morzu można wyznaczyć wartości wszystkich współczynników modelu [2, 10], a także uprościć go do postaci transmitancji drugiego rzędu w postaci

Zezwala

licencji Creative Commons Uznanie autorstwa

się na korzystanie z artykułu na warunkach

3.0

() ()

ϕ

δ + = ++

5 Pomiary Automatyka Robotyka, ISSN 1427-9126, R. 28, Nr 2/2024, 5–10, DOI: 10.14313/PAR_252/5

, 1 s k ssTs

= + T = Ta + Tb – Tc, (2)

czyli jako integrator o wzmocnieniu k i stałej czasowej T. Dodatkowo współczynnik wzmocnienia k jest wprost proporcjonalny do aktualnej prędkości statku V, a stała czasowa T odwrotnie proporcjonalna, czyli k = k0 · V/V0 oraz T = T0 · V0/V, gdzie początkowe wartości k0, T0 są określane na podstawie wyników prób morskich wykonywanych przy nominalnej prędkości V0

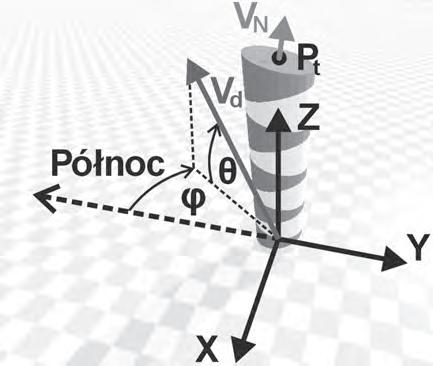

W dalszej części rozważany będzie układ regulacji kursu pokazany na rys. 1, w którym φref reprezentuje wartość zadaną (kurs magnetyczny), δ sterowanie (wychylenie steru), d łączne zakłócenia środowiskowe (wiatr, fale lub prąd morski) a φ aktualny kurs statku (magnetyczny). Standardowy regulator PID ma postać

ustalone, z których należy odczytać amplitudę A cr i okres T cr, a następnie korzystając z funkcji opisującej przekaźnika, albo reguł Zieglera-Nicholsa, bądź ich modyfikacji, obliczyć nastawy. Niech R, I określają wartości bezwzględne części rzeczywistej i urojonej transmitancji obiektu dla częstotliwości 2/, cr cr T ωπ = tzn.

Go(jω cr) = – R – jI (6)

Z warunku Nyquista określającego cykl graniczny przy sterowaniu przekaźnikowym otrzymuje się zależności

22 , 4 cr RAH U π =− , 4 H I U π = 22 , MRI =+ (7)

Niestety daje to tylko jeden punkt charakterystyki amplitudowo-fazowej obiektu, co pokazano na rys. 3a, więc na dobre nastrojenie regulatora nie ma raczej co liczyć.

Rys. 1. Ogólny schemat układu regulacji kursu Fig. 1. General diagram of the heading control system

W praktycznej realizacji algorytmu PID składowa różniczkująca jest dodatkowo uzupełniana filtrem o stałej czasowej Td/D, czyli ma postać

() , /11/1 dd d TsTs TDsNs = ++ . d D N T = (4)

Łatwo można sprawdzić, że dla 4 D ≥ odpowiedź skokowa układu z filtrem różniczkowania praktycznie nie różni się od odpowiedzi bez tego filtru.

2.2. Nastawy PID według Åströma-Hägglunda

W 1943 r. Ziegler i Nichols przedstawili metodę cyklu granicznego dla eksperymentalnego doboru nastaw regulatorów polegającą na doprowadzeniu układu z regulatorem P do granicy stabilności. Należy wtedy odczytać wzmocnienie krytyczne k cr i okres drgań T cr, a następnie obliczyć nastawy regulatora. Dla regulatora PID wzory mają postać:

k p = 0,6 k cr, Ti = 0,5 T cr, Td = 0,125 T cr (5)

Klasyczny eksperyment Zieglera-Nicholsa nie jest jednak wygodny ze względu na konieczność ręcznego ustawianie wzmocnienia. Stąd zainteresowanie, jakie wzbudził oryginalny pomysł Åströma i Hägglunda [11], w którym zaproponowano automatyzację eksperymentu Zieglera-Nicholsa poprzez sterowanie przekaźnikowe w układzie z rys. 2a. Po przełączeniu na T (ang. Tune) obiekt jest sterowany przez przekaźnik dwupołożeniowy z histerezą. Amplituda zmian sterowania wynosi U, natomiast histereza H (rys. 2b). W układzie powstają drgania

Rys. 2. Strojenie przekaźnikowe: (a) układ; (b) typowe przebiegi Fig. 2. Relay tuning: (a) circuit; (b) typical waveforms (a) (b)

W pracy Åströma i Hägglunda [11] do wyznaczenia nastaw stosowany jest warunek

()() 3 4 0,5 j ocrPIDcr GjGje π ωω = (8)

stanowiący kombinację 2-krotnego zapasu modułu i zapasu fazy równego 45°. Czułość regulatora będzie więc mniejsza, niż w przypadku nastawienia wg reguł Zieglera-Nicholsa. Na rys. 3b pokazano, jaki skutek wywiera warunek (4) na transmitancję układu otwartego (open) dla częstotliwości ω cr Ponieważ warunek (8) pozwoli określić tylko dwa związki między trzema nastawami k p, Ti, Td regulatora PID, więc potrzebny jest trzeci warunek, aby jednoznacznie wyznaczyć nastawy. Może nim być np. /4 di TT = (jak w regułach Zieglera-Nicholsa). Łatwo sprawdzić, że wstawiając

1 1 pd i kTs Ts ++ oraz /4 di TT = do (8), a także uwzględniając (6) i (7), otrzymamy nastawy

() ()

()

ϕ δ

() ()()

TsTs RskTsk Ts TTs ++ =++= + (3) Ti = T1 + T2, 12 12 , 4 i d T TT T TT =≤ + PID )1( + Ts s k δ refϕ

ϕ

() 12 1 11 1 1,pdp i

d

()

6 Nastawy regulatora kursu dla autopilota statku POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

Jeżeli zachodzi warunek 2,AH > a tak zwykle jest przy znacznej amplitudzie U, to R > I, czyli 0,75π Φ> (czyli 145°).

Realne proporcje są więc mniej więcej takie, jak na rys. 3b. Zatem dla częstotliwości ω cr regulator PID zwiększa fazę o 0,75, π Φ− zaś moduł jego transmitancji wynosi 0,5/M

(a) (b) 21 tan, 24 i cr T

Rys. 3. Charakterystyka amplitudowo-fazowa: (a) obiekt; (b) układ otwarty dla warunku Åströma-Hägglunda

Fig. 3. Amplitude-phase characteristics: (a) object; (b) an open system for the Åström-Hägglund condition

2.3. Nastawy PID według Fossena

W fundamentalnych książkach Fossena [2, 3] jako transmitancję układu zamkniętego przyjęto () 2 22 , 2 n cl nn Gs ss ω ξωω = ++ 0,81 ξ ∈ (10)

z dwoma parametrami projektowymi ω n, ξ. Projektowany jest tam najpierw regulator PD, do którego następnie składową I dobiera się heurystycznie. Podane w [2, 3] nastawy, nazywane dalej wzorcowymi, mają postać

2 , n p T k k ω = 2 21 , n d n T T T ξω ω = 10 i n T ω = (11)

Przyjmijmy teraz dodatkowy parametr projektowy – dzielnik redukcyjny r. Jeżeli r > 1, to stała czasowa Tcl układu zamkniętego ma być r-krotnie mniejsza od stałej czasowej statku T (układu otwartego). Stała czasowa Tcl odpowiada więc odwrotności modułu części rzeczywistej pierwiastka mianownika, czyli

1 cl n T ξω = (12)

Ponieważ Tcl = T/r, więc ω n = r/(ξT) po podstawieniu do (11) daje nastawy Fossena z nowymi dwoma parametrami projektowymi r oraz ξ:

2 2 , p r k kTξ = 10, i T T r ξ = (13)

2.4. Nastawy

obliczone metodą lokacji biegunów

Tryb projektowania polega na takim doborze nastaw regulatora PID (3), aby transmitancja układu zamkniętego miała postać (z podwójnym biegunem w mianowniku, [8, 9])

(14)

Również tu dzielnik redukcyjny r jest parametrem projektowym. Eliminacja stałej czasowej T przez podstawienie T2 = T w regulatorze (3) daje transmitancję układu otwartego w postaci

po

Przebieg linii pierwiastkowej dla transmitancji (15) przedstawiono na rys. 5. Poszukujemy teraz takiego punktu na linii pierwiastkowej, aby w transmitancji układu zamkniętego wystąpił podwójny biegun w punkcie (–1/Tcl, j0), czyli punktu rozwidlenia linii pierwiastkowej.

Rys. 4. Linia pierwiastkowa dla transmitancji (15)

Fig. 4. Root locus for transfer function (15)

Transmitancję układu zamkniętego Gcl(s) = G op(s)/(1 + G op(s)) przekształcamy tak, aby ostatnim elementem mianownika było 1. Mianownik ten powinien być taki sam, jak mianownik w (14), czemu odpowiada równanie

()2 2 1 1 11. cl p TT sTsTs kk + ++=+ (16)

Wynikają stad wprost wzory na T1 i k p w zależności od Tcl, czyli

1 2,TTcl = 1 2 1 p cl TT k k T + = (17)

Ponieważ Tcl = T/r, według (14), więc przy warunku T2 = T otrzymuje się finalne nastawy regulatora k p, Ti, Td

() 1 2, p krr kT =+ 2 , i r TT r + = 2 . 2 d TT r = + (18)

Układ zamknięty będzie miał postać Gcl,F(s) = 1/(Tcls + 1)2, jeśli układ z rys. 1 uzupełnimy o filtr F wartości zadanej o transmitancji GF(s) = 1/(TFs + 1), gdzie TF = T1 = 2T/r. Można go również uzupełnić o ogranicznik prędkości nara -

()

() 1 2 1 , 1 cl cl Ts Gs Ts + = + cl T T r =

()

11 22 1 11

op kk TsTs Gs K TT ss ++ =⋅=⋅ + (15)

π

=Φ− 4

ω

i d T T = (9)

7 Zbigniew Świder

stania wartości zadanej (przy jej skokowej zmianie), jak to pokazano na rys. 5.

3. Badania symulacyjne

Do testów porównawczych przyjęto znormalizowaną transmitancję statku (model Nomoto) w postaci

() () () 1 , 11 s k ssTsss ϕ δ == ++ czyli k = 1, T = 1. (19)

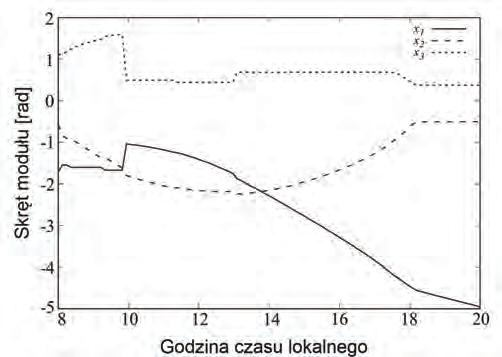

Na wstępie układ regulacji przełączono w tryb T (Tune) jak na rys. 2a, gdzie obiekt (statek) jest sterowany przez przekaźnik dwupołożeniowy z histerezą. Amplituda zmian sterowania wynosiła U = 1, natomiast histereza H = 0,01. Odczytano amplitudę drgań krytycznych A cr = 0,4874 oraz okres oscylacji równy T cr = 1,258, a następnie obliczono k cr = (4U)/(πA cr) = 0,2612 oraz T cr = T osc = 1,258. Korzystając z podanych wcześniej wzorów obliczono nastawy regulatora PID dla wybranych metod strojenia, a wyniki przedstawiono w tab. 1.

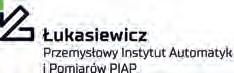

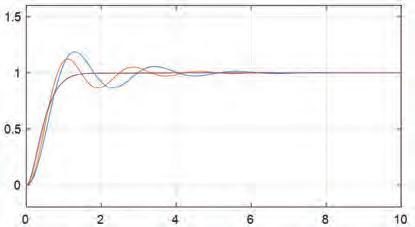

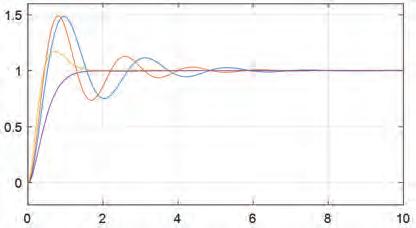

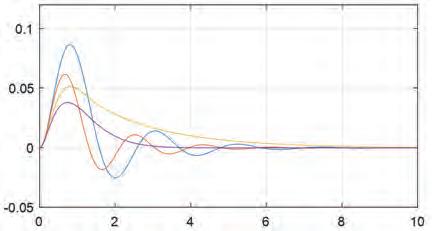

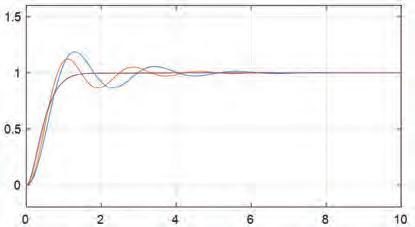

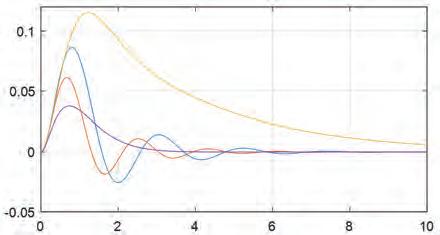

Na rys. 6 przedstawiono odpowiedzi skokowe i zakłóceniowe dla tych czterech zestawów nastaw z tab. 1. Warto zauważyć, że stosując standardowe metody inżynierskie strojenia regulatorów (cyklu granicznego Zieglera-Nicholsa oraz zmodyfiko-

Rys. 5. Układ sterowania dla regulatora kursu z ogranicznikiem i filtrem

Fig. 5. Control system for heading regulator with rate limiter and prefilter

waną Åströma-Hägglunda) otrzymujemy przebiegi oscylacyjne ze stosunkowo dużym przeregulowaniem (rzędu 50 %) oraz długim czasem regulacji t r. Najlepsze wyniki daje tu strojenie metodą lokacji biegunów (opisaną m.in. w [8, 9]), gdzie otrzymujemy stosunkowo krótki czas regulacji przy przebiegach aperiodycznych krytycznych (odpowiedź skokowa).

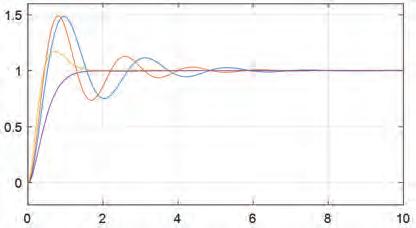

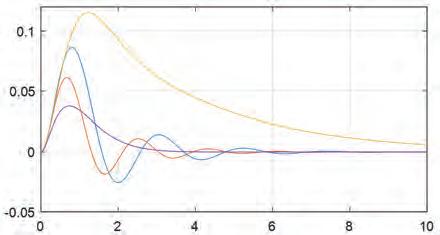

Na rys. 7 przedstawiono ponownie odpowiedzi skokowe i zakłóceniowe, ale dla parametru projektowego r zmniejszonego do wartości 2 (czyli stała czasowa układu zamkniętego ma być dwukrotnie mniejsza od stałej czasowej układu otwartego).

Odpowiedź skokowa i zakłóceniowa dla strojenia metodą Zieglera Nicholsa oczywiście się nie zmieniła (nie zależy od parametru r), natomiast nastąpiło znaczne pogorszenie odpowiedzi zakłóceniowej dla nastrojenia regulatora metodą Fossena. Dla pozostałych metod pogorszenie odpowiedzi było nieznaczne.

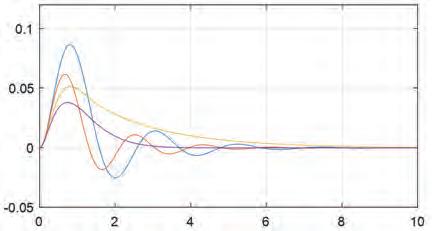

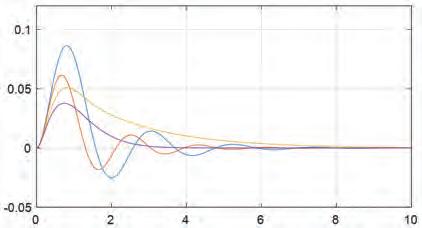

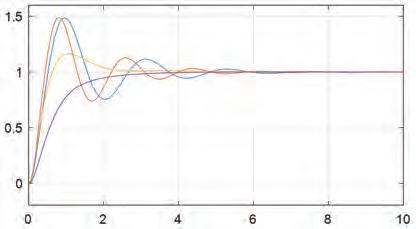

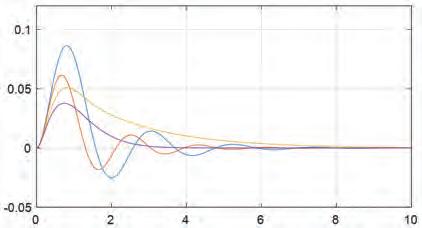

Porównano również odpowiedzi dla parametru r = 3 w sytuacji, gdy do wszystkich układów regulacji dodano filtr wstępny F wartości zadanej (zgodnie z rys. 5) oraz ogranicznik prędkości narastania sygnału. Wyniki przedstawiono na rys. 8.

Można zauważyć, że w dwóch pierwszych przypadkach przeregulowanie zmniejszyło się, a dla nastaw Fossena przebiegi stały się aperiodyczne krytyczne. Odpowiedzi na skokowe zakłócenie oczywiście nie zmieniły się (gdyż nie zależą od filtru F). Tutaj również, zarówno odpowiedź skokowa jak i zakłóceniowa, jest najkorzystniejsza dla projektowania metodą lokacji biegunów.

Tab. 1. Nastawy regulatora PID kursu statku dla wybranych metod

Tab. 1. Setting of the ship heading PID controller for selected methods

Metoda Parametry projektowe Wzory

()

p Ti Td p % Zieglera-Nicholsa (brak) (5) 10,9 0,74 0,18 48 % 6,5 Åströma-Hägglunda ξ = 0,7 r = 3 (9) 15,7 0,63 0,16 49 % 5,5 Fossena r = 3 (13) 18,4 2,33 0,27 17 % 1,5 Lokacji biegunów r = 3 (18) 15,0 1,67 0,40 0 % 1,5 a) b)

k

r

Rys. 6. Odpowiedzi skokowe (a) i zakłóceniowe (b) z regulatorem PID (dla

= 3)

Fig. 6. Step (a) and disturbance (b) responses with PID controller (for r = 3)

8 Nastawy regulatora kursu dla autopilota statku POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

Rys. 7. Odpowiedzi skokowe (a) i zakłóceniowe (b) z regulatorem PID (dla r = 2) Fig. 7. Step (a) and disturbance (b) responses with PID controller (for r = 2)

a)

Rys. 8. Odpowiedzi skokowe (a) i zakłóceniowe (b) z regulatorem PID i filtrowaniem wartości zadanej Fig. 8. Step (a) and disturbance (b) responses with PID controller and setpoint filtering

4. Podsumowanie

W artykule przedstawiono i porównano kilka wybranych metod doboru nastaw PID dla regulatora kursu w autopilocie statku. Spójność projektowania jest możliwa dzięki temu, że przyjęto ogólnie znany model Nomoto oraz dzięki eliminacji przez regulator stałej czasowej obiektu, gdyż wtedy układ zamknięty staje się układem 2-go rzędu. W dwóch przypadkach założono dodatkowo, że stała czasowa odpowiedniego układu zamkniętego r-krotnie różni się od stałej czasowej modelu statku. W podanej tabeli nastaw PID występują jedynie parametry modelu Nomoto oraz parametr projektowy r. Pokazano również, że w takim przypadku regulator lepiej tłumi zakłócenia środowiskowe niż standardowo nastrojone regulatory.

Bibliografia

1. Nomoto K., Taguchi T., Honda K., Hirano S., On the steering Qualities of Ships, Technical Report, International Shipbuilding Progress, Vol. 4, 1957, 354–370.

2. Fossen T.I., Guidance and Control of Ocean Vehicles (4th ed.), Wiley, Chichester, 1999.

3. Fossen T.I., Marine Control Systems, Marine Cybernetics, Trondheim, 2002.

4. Morawski L., Pomirski J., Rak A., A cascade control system for trajectory tracking, 4th International Congress on Maritime Technological Innovations and Research, 2004, 265–276.

5. Chen C.Y., Ruiz M.T., Delefortrie G., Vantorre M., Lataire E., An Energy-Efficient Adaptive Course Control System for Ocean Surface Ships, 11th International Workshop on Ship and Marine Hydrodynamics, Hamburg, 2019, DOI: 10.15480/882.3349.

6. van Amerongen J., van Nauta Lemke H.R., van der Veen J.C.T., An autopilot for ships designed with fuzzy sets, “IFAC Proceedings Volumes”, Vol. 10, No. 16, 1977, 479–487, DOI: 10.1016/S1474-6670(17)69559-4

7. Tomera M., Fuzzy Self-tuning PID controller for a Ship Autopilot, Proceedings of the 12th International Conference on Marine Navigation and Safety of see transportation, TransNav, Gdynia, 2017, DOI: 10.1201/9781315099132-15.

8. Trybus L., Świder Z., Stec A., Tuning Rules of Conventional and Advanced Ship Autopilot Controllers, Automation 2015, 303–311, DOI: 10.1007/978-3-319-15796-2_31.

9. Świder Z., Trybus L., Consistent design of PID controllers for an autopilot, “Polish Maritime Research”, Gdańsk, Vol. 30, No. 1, 2023, 78–85, DOI: 10.2478/p omr-2023-0008.

10. Saari H., Djemai M., Ship motion control using multi-controller structure. “Ocean Engineering”, Vol. 55, 2012, 184–190, DOI: 10.1016/j.oceaneng.2012.07.028.

11. Åström K.J., Hägglund T., Automatic tuning of simple regulators with specifications on phase and amplitude margins “Automatica”, Vol. 20, No. 5, 1984, 645–651, DOI: 10.1016/0005-1098(84)90014-1.

Inne źródła

12. ALPHASEAPILOT MFC Autopilot Operating Manual, Alphatron, https://www.alphatronmarine.com

13. FAP-2000 Autopilot Operator Manual, Furuno, https://www.furuno.com.

a)

b)

b)

9 Zbigniew Świder

Tuning the Heading Controller for the Ship’s Autopilot

Streszczenie: Selected methods of PID settings for the heading controller in the ship’s autopilot are presented. The consistency of the design is possible due to the fact that the Nomoto model was used for the ship and thanks to the elimination of the time constant of the object by the controller, so that the closed system becomes a 2nd order system. In two cases, it was additionally assumed that the system is to have a double time constant, differing in a given ratio r from the time constant of the object. It has been shown that the heading controller designed in this way provides critical aperiodic waveforms at a step change in the setpoint value and suppresses environmental disturbances better than standardly tuned controllers.

Słowa kluczowe: PID controller, ship autopilot, tunings methods, step response

dr hab. inż. Zbigniew Świder swiderzb@prz.edu.pl

ORCID: 0000-0003-3504-5340

Absolwent Wydziału Elektrotechniki i Informatyki Politechniki Rzeszowskiej (1984). Na Wydziale Automatyki, Elektroniki i Informatyki Politechniki Śląskiej w Gliwicach uzyskał stopień doktora nauk technicznych (1992) oraz doktora habilitowanego nauk technicznych (2004). Od początku pracy zawodowej zajmuje się sterownikami mikroprocesorowymi, a ostatnio metodami samostrojenia i adaptacji nastaw regulatorów, komputerowymi systemami automatyki oraz środowiskami inżynierskimi do programowania przemysłowych układów sterowania.

10 Nastawy regulatora kursu dla autopilota statku POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

Metodyka projektowania systemów robotycznych w oparciu o metamodele EARL i MeROS

Tomasz Winiarski, Jan Kaniuka, Jakub Ostrysz

Politechnika Warszawska, Instytut Automatyki i Informatyki Stosowanej

Streszczenie: Inżynieria systemów odgrywa obecnie kluczową rolę w procesie wytwarzania, wdrażania oraz utrzymania systemów cyberfizycznych. Coraz częściej staje się ona nieodłącznym narzędziem podczas projektowania, chociażby systemów robotycznych. W artykule zaproponowano metodykę projektowania systemów robotycznych w oparciu o dwa metamodele: EARL na poziomie niezależnym od platformy implementacji oraz MeROS dedykowany dla ROS/ROS 2. Procedura została zaprezentowana poprzez analizę reprezentatywnego zastosowania aplikacyjnego: heteregonicznego systemu wielorobotowego z centralnym koordynatorem.

Słowa kluczowe: robot, inżynieria systemów, ROS 2, EARL, MeROS

1. Wprowadzenie

Podobnie jak w innych dziedzinach inżynierii, w robotyce podstawowym problemem jest jak opracowywać systemy w warunkach różnorodnych wyzwań i ryzyk projektowych. Procedura powinna być możliwie niezawodna i minimalizować ryzyko błędów czy też niepowodzenia projektu. Tradycyjną odpowiedzią jest inżynieria systemów oparta na modelu MBSE (ang. Model-Based Systems Engineering) [16]. Pytaniem, na jakie odpowiada ten artykuł, jest postać i sposób realizacji procedury projektowej nawiązującej do powyższej problematyki. Procedura opiera się współczesnych narzędziach, a do jej ilustracji wybrano przykład nawiązujący do robotyki przemysłowej.

Charakter systemów przemysłowych powoduje, że w wielu zastosowaniach uzasadnione jest użycie centralnej koordynacji [26–28]. Choć tego typu rozwiązania znane są od wielu lat, obecnie coraz częściej roboty wdrażane w zakładach przemysłowych zgodnie z koncepcją Przemysłu 4.0 są silnie zróżnicowane i obok robotów manipulacyjnych pojawią się roboty mobilne autonomicznie przewożące towary w ramach procesów intralogistycznych.

Przemysłowe systemy robotyczne cechowała znaczna rozmaitość języków programowania [29]. Ponadto frameworki usprawniające proces programowania robotów tworzone były pierwotnie głównie w środowisku akademickim [30]. Wśród frameworków na pierwszy plan wysunął się ROS (ang. Robot Operating System), obecnie rozwijany i zalecany do użycia w wersji drugiej [10]. Naturalną koleją rzeczy jest postępująca próba standaryza-

Autor korespondujący:

Tomasz Winiarski, tomasz.winiarski@pw.edu.pl

Artykuł recenzowany nadesłany 01.11.2023 r., przyjęty do druku 16.04.2024 r.

Zezwala się na korzystanie z artykułu na warunkach licencji Creative Commons Uznanie autorstwa 3.0

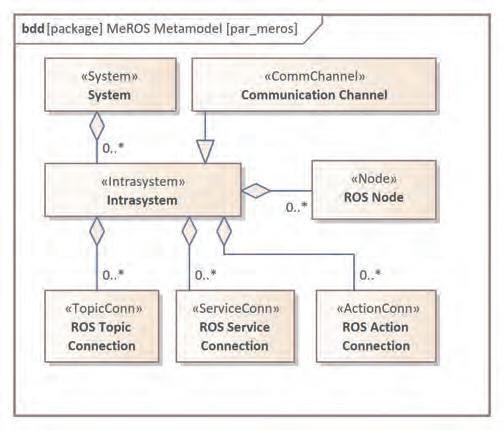

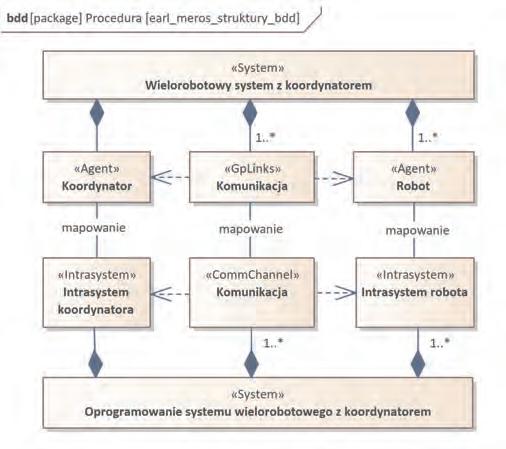

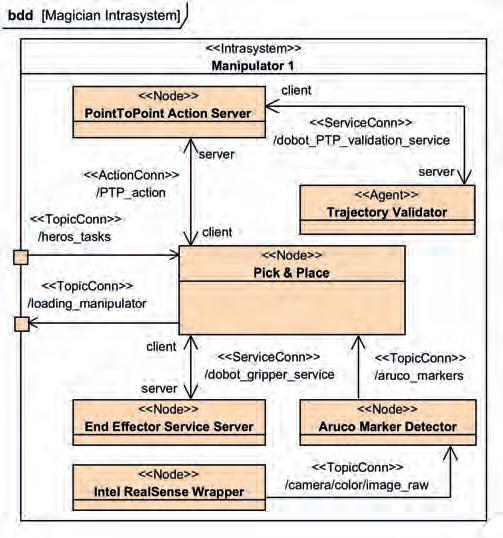

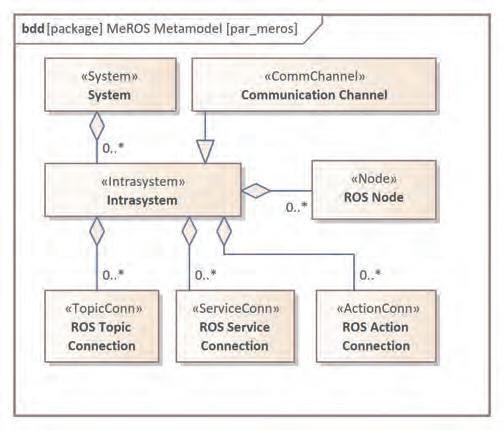

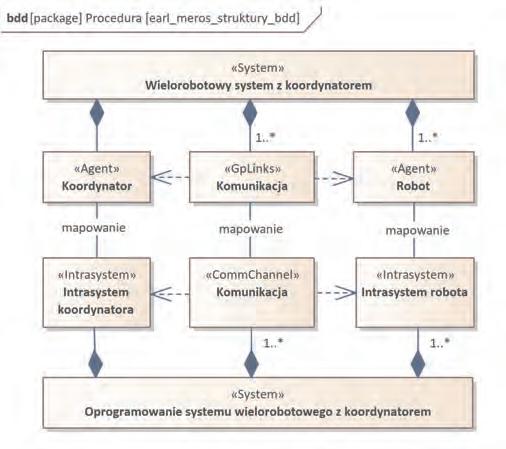

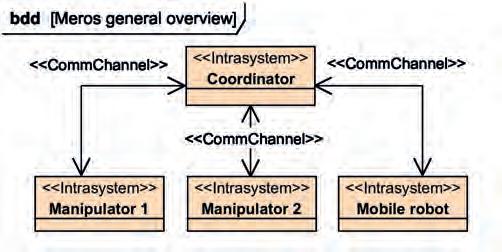

cji sposobu programowania robotów przemysłowych w oparciu o ROS 2 i społeczność ROS Industrial [4]. Efektywny opis systemów wspierany jest przez graficzny język SysML [11]. Do tego wskazane są metamodele dziedzinowe [1], stąd w ostatnim czasie dla ROS powstał metamodel bazujący na SysML o nazwie MeROS. Artykuł [18] zawiera szczegółowe omówienie sensu i znaczenia stosowania podobnych metamodeli, natomiast bieżąca wersja MeROS wraz z dodatkowymi materiałami instruktażowymi umieszczona jest na stronie tego projektu1. Rysunek 1 przedstawia kluczowe dla dalszej prezentacji bloki MeROS. Odnoszą się one do poziomu abstrakcyjnego opisu systemu poprzez Intrasystemy i Kanały Komunikacyjne oraz konkretne aspekty implementacji jak Węzły i metody komunikacji ROS.

1 https://github.com/twiniars/MeROS

Rys. 1. Kompozycja systemu MeROS: Intrasystem i związane z nim bloki

Fig. 1. MeROS System Composition: Intrasystem and associated blocks

11 Pomiary Automatyka Robotyka, ISSN 1427-9126, R. 28, Nr 2/2024, 11–20, DOI: 10.14313/PAR_252/11

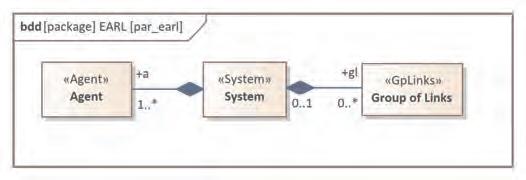

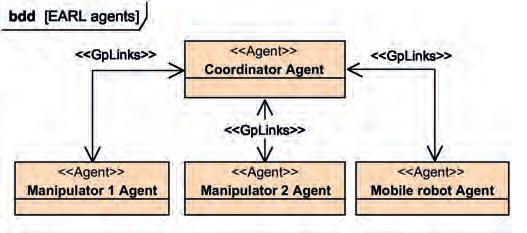

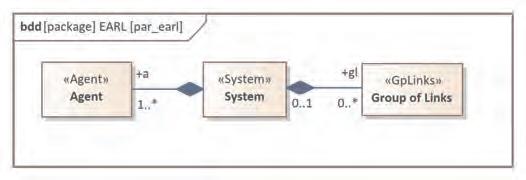

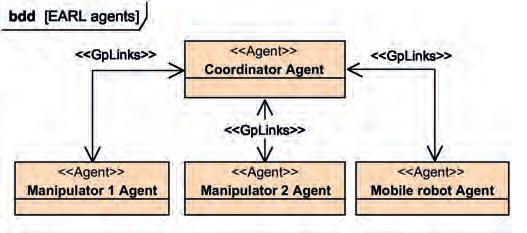

Sam proces opracowywania systemu cyberfizycznego, jakim jest system robotyczny, wymaga osadzenia logiki działania w sprzęcie, stąd obok logicznej koncepcji działania potrzebne jest upostaciowienie [9]. Taką możliwość daje EARL [22, 23]. Podobnie jak MeROS, EARL oparty jest na SysML, co ułatwia ich wspólne wykorzystanie, będące przedmiotem tego artykułu. Mimo tego że EARL jest nowym rozwiązaniem, był już szeroko stosowany m.in. dla robotów manipulacyjnych i mobilnych [2]. EARL wywodzi się z Teorii Agentowej Szkoły Warszawskiej [7, 9, 25], podejścia ugruntowanego od lat i stosowanego współcześnie w wyjściowej postaci m.in. w tak rozbudowanych frameworkach jak TaskER [3]. W artykule korzystamy z EARL i MeROS, kontynuując i rozszerzając wcześniejsze prace nad metodami projektowania sterowników systemów robotycznych [17, 31] przez synergiczne stosowanie metamodeli zależnych i niezależnych od platformy implementacyjnej. W tym celu koncentrujemy się na blokach EARL wskazanych na diagramie 2, które z jednej strony odnoszą się do ogólnej struktury systemu, ale co jest kluczowe dla znaczenia EARL w proponowanym podejściu, mają upostaciowiony charakter.

Rys. 2. Kompozycja systemu EARL: Agenty i Grupy Połączeń Fig. 2. EARL System Composition: Agents and Groups of Links

Postać dalszej części artykułu jest następująca. Rozdział 2 prezentuje procedurę projektową. Rozdział 3 opisuje jej przykładową realizację. Artykuł kończy podsumowanie w rozdziale 4.

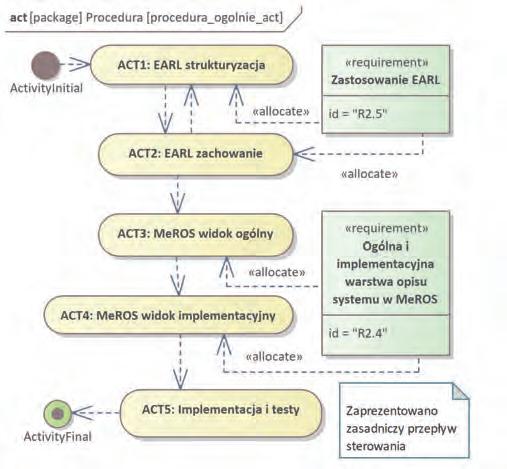

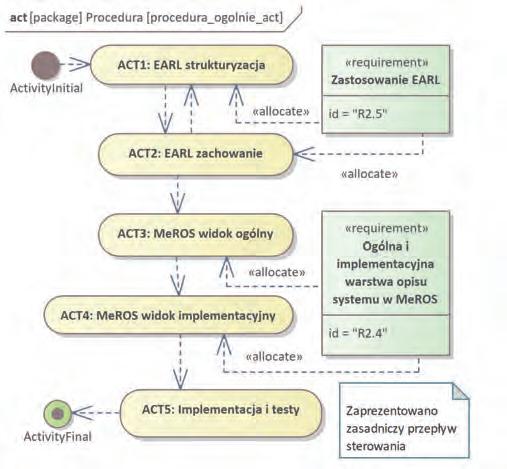

2. Procedura projektowa

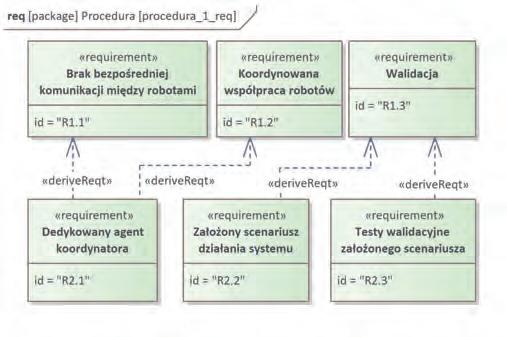

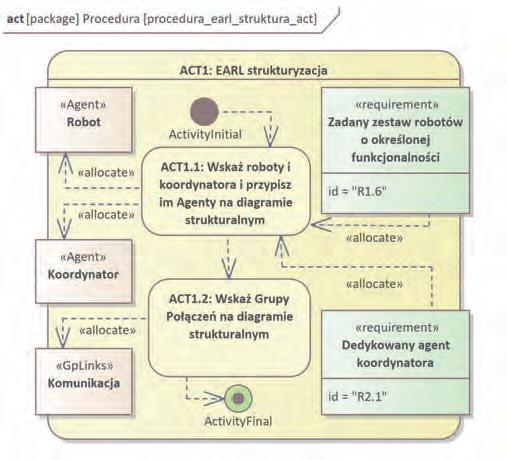

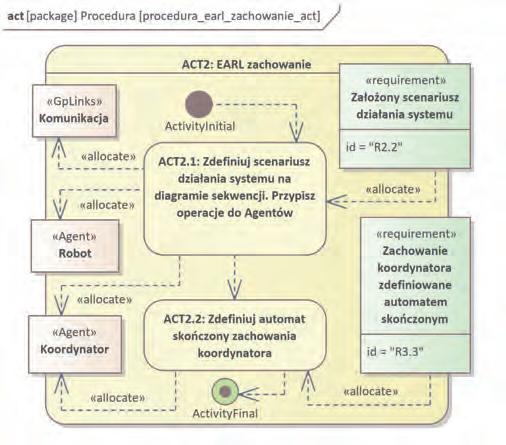

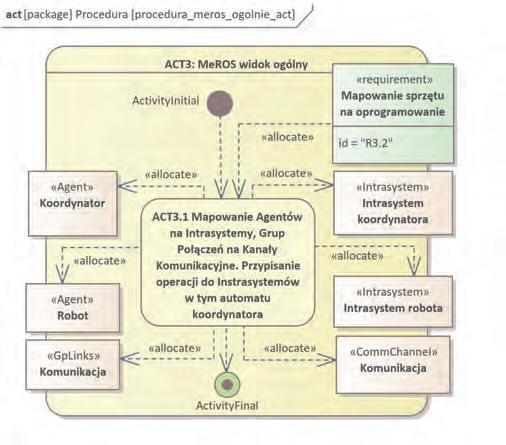

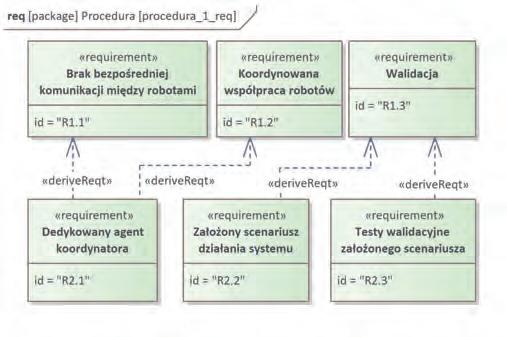

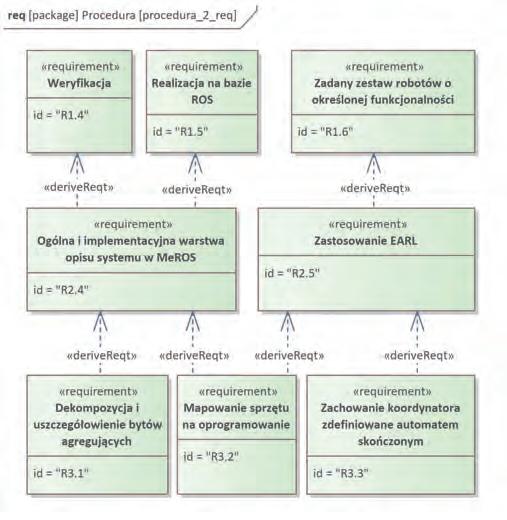

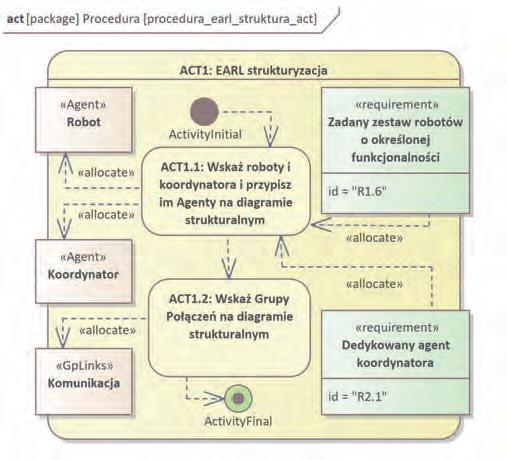

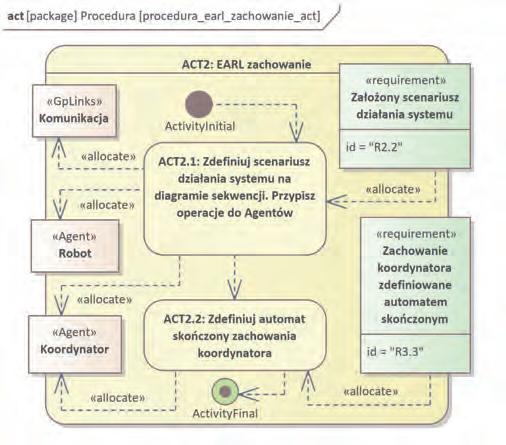

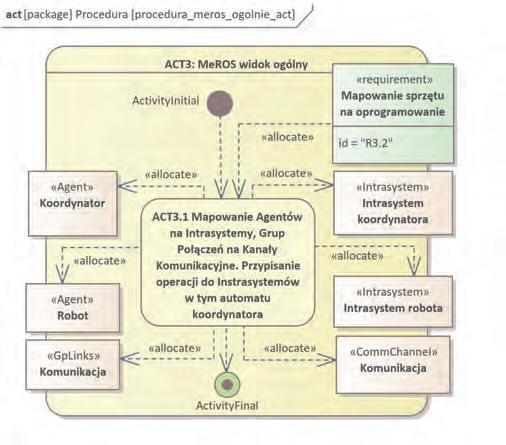

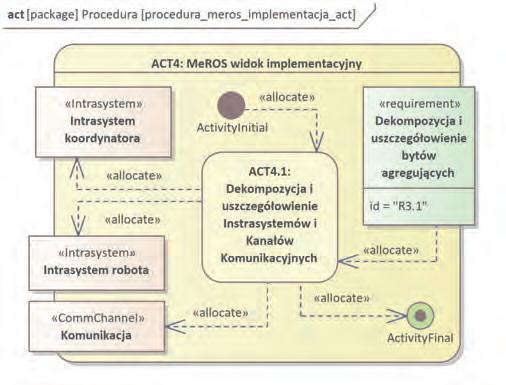

Kluczowe wymagania dla procedury projektowej przedstawiono na rys. 3 i 4. Diagramy te, podobnie jak inne części procedury, zostały zdefiniowane w SysML [13]. Wymagania zaetykietowano według wzorca [RX.Y], gdzie X oznacza poziom wymagań, a Y numer wymagania na określonym poziomie. Poziom pierwszy odnosi się do wyjściowych wymagań, natomiast kolejne poziomy są wywiedzione i wiążą się z decyzjami projektowymi. Kluczowa w procesie opracowywania procedury projektowej jest alokacja wymagań, co uwidocznione jest na kolejnych diagramach, tym razem aktywności. Poczynając od rys. 3. Założono, że procedura będzie dotyczyła pewnej podklasy systemów robotycznych, gdzie brak jest bezpośredniej komunikacji między robotami [R1.1], ale i ich działania są koordynowane [R1.2]. Wynika z tego dedykowany Agent koordynatora [R2.1]. Walidacja [R1.3] jest jednym z kluczowych elementów przebiegu projektu w inżynierii systemów [6]. W rozważanej klasie systemów robotycznych założono, że system ma realizować scenariusz określony na wstępie [R2.2] i podlegający walidacji podczas testów systemu [R2.3]. Kolejny zestaw wymagań przedstawiono na rys. 4. Weryfikacja [R1.4] jest newralgicznym elementem procesu projektowego [6] i wspiera jego poprawny przebieg. Zanim do niej przejdziemy, należy wspomnieć o wymaganiu [R1.5], gdyż w tej pracy zajmujemy się systemami na bazie ROS 2. Weryfikacja wiąże się w praktyce z zapewnieniem czytelnych przejść pomiędzy różnymi sposobami/poziomami definicji projektowanego systemu. Stąd zdecydowano o zastosowaniu MeROS w wersji 1.2.7, który to zapewnia, i, co również było wymagane, odnosi się do ROS. Przejście od ogólniejszych do bliższych imple-

Rys. 3. Wymagania dla procedury projektowej – część 1

Fig. 3. Design procedure requirements – part 1

Rys. 4. Wymagania dla procedury projektowej – część 2

Fig. 4. Design procedure requirements – part 2

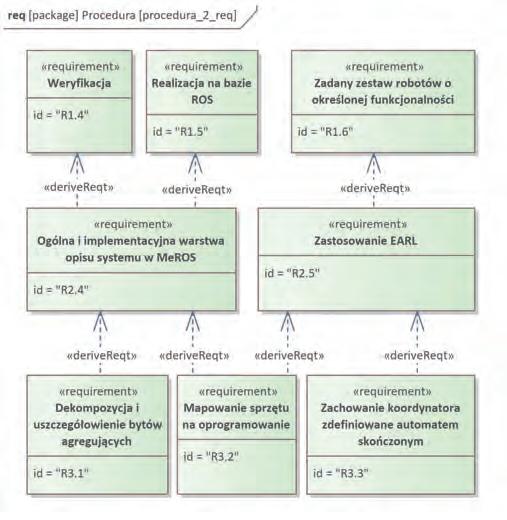

Rys. 5. Procedura projektowa – widok ogólny

Fig. 5. Design procedure – general view

12 Metodyka projektowania systemów robotycznych w oparciu o metamodele EARL i MeROS POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

Rys. 6. Struktura systemu wyrażona w EARL i MeROS

Fig. 6. System structure expressed in EARL and MeROS

Rys. 7. Procedura projektowa – ACT1: EARL strukturyzacja

Fig. 7. Design procedure – ACT1: Structurisation with EARL

Rys. 8. Procedura projektowa – EARL zachowanie

Fig. 8. Design procedure – Behaviour with EARL

mentacji opisów systemu w MeROS wymaga dekompozycji i uszczegóławiania bytów agregujących [R3.1].

Powracając do wymagań wyjściowych, zakładamy pewien zadany zestaw robotów o określonej funkcjonalności [R1.6], z którego zostanie skomponowany system. Roboty mają w naturalny sposób fizyczną naturę, co skłania do zastosowania EARL2 [R2.5] (wybrano jego najnowszą wersję 1.3) do modelowania systemu o fizycznej naturze, podczas gdy MeROS dotyczy konkretnej platformy programistycznej. W EARL zachowanie Agentów definiowane jest na ogólnym poziomie poprzez automat skończony i tak też zdefiniowany jest koordynator [R3.3], który w przeciwieństwie do robotów nie ma z góry określonej funkcjonalności. Połączenie EARL z MeROS w jednym procesie projektowym wymaga mapowania sprzętu na oprogramowanie [R3.2]. Procedura projektowa została przedstawiona w ogólnej postaci poprzez diagram aktywności na rys. 5. Wyróżniono pięć głównych aktywności oznaczonych etykietami [ACTX.Y], gdzie X to numer aktywności głównej, a Y to numer podaktywności. Na diagramie 5 nakreślono zasadniczy przepływ sterowania oraz alokację wymagań. Każda z aktywności głównych została szczegółowo omówiona na dedykowanym dla siebie diagramie aktywności w dalszej części tej sekcji. Zastosowanie EARL [R2.5] pociąga za sobą aktywności: [ACT1] – gdzie należy nakreślić strukturę systemu w EARL, a następnie [ACT2] – gdzie definiowane jest zachowanie systemu w EARL. Kolejny etap procedury zachodzi w MeROS [R2.4], w którym najpierw definiowany jest widok ogólny [ACT3] a następnie implementacyjny [ACT4]. Projekt kończą implementacja i testy [ACT5]. Naturalnie w praktyce możliwe, a nawet niekiedy wskazane, są powroty do poprzednich faz procedury, stąd mowa jest o zasadniczym przepływie sterowania. Dodatkowe dwie aktywności: ActivityInitial oraz ActivityFinal są standardowymi aktywnościami, którymi oznacza się początek i koniec procedury.

Dla dalszych, szczegółowych rozważań kluczowe jest sformułowanie struktury opracowywanego systemu poprzez diagram definicji bloków na rys. 6.

Diagram przedstawia obraz systemu z dwóch perspektyw: EARL (u góry) i MeROS w widoku ogólnym (u dołu). Obie części podlegają mapowaniu. Aktywność [ACT1] przedstawiona jest na diagramie 7. W pierwszej kolejności należy zaproponować diagram strukturalny w EARL, składający się z Agentów robotów i koordynatora [ACT1.1] oraz połączeń między nimi [ACT1.2].

2 https://www.robotyka.ia.pw.edu.pl/projects/earl/

Rys. 9. Procedura projektowa – ACT3: MeROS widok ogólny

Fig. 9. Design procedure – ACT3: MeROS general view

13

Tomasz Winiarski, Jan Kaniuka, Jakub Ostrysz

W kolejnym etapie (rys. 8) następuje w pierwszej kolejności sformułowanie scenariusza działania systemu na diagramie sekwencji [ACT2.1], gdzie podmiotami są komponenty z diagramu strukturalnego opracowanego w etapie pierwszym [ACT1]. W oparciu o scenariusz oraz założoną na wstępie funkcjonalność robotów należy opracować automat skończony dla koordynatora [ACT2.2].

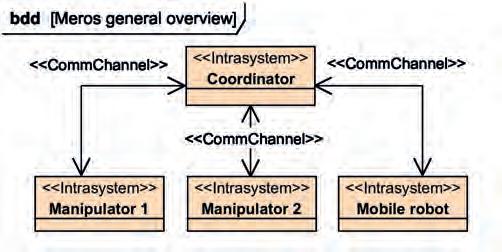

Po definicji systemu w EARL, przychodzi czas na specyfikację w MeROS. W pierwszej kolejności opracowywany jest widok ogólny (rys. 9). Jest to stosunkowo proste [ACT3.1] i sprowadza się do mapowania bloków EARL na ich odpowiedniki w MeROS. W ogólności ROS i MeROS mogą być zastąpione przez inne specyficzne rozwiązania, co jest kolejną zaletą wykorzystania modelowania niezależnego od platformy, jakie zapewnia EARL.

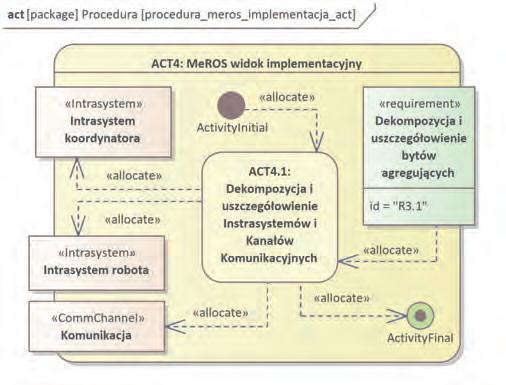

W kolejnej fazie (rys. 10) realizowana jest dekompozycja i uszczegółowienie komponentów [ACT4.1] określonych uprzednio w widoku ogólnym MeROS. Choć to pojedyncza aktywność, to jest to jeden z najbardziej czasochłonnych i złożonych etapów projektowania systemu.

Rys. 10. Procedura projektowa – ACT4: MeROS widok implementacyjny

Fig. 10. Design procedure – ACT4: MeROS implementation view

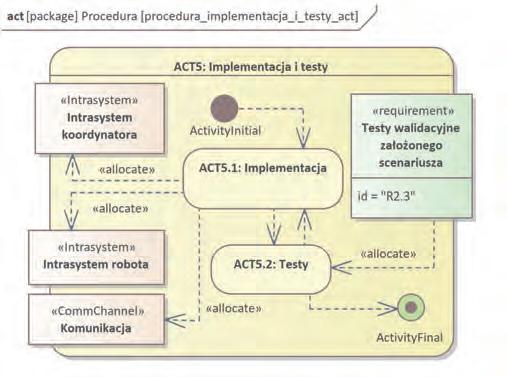

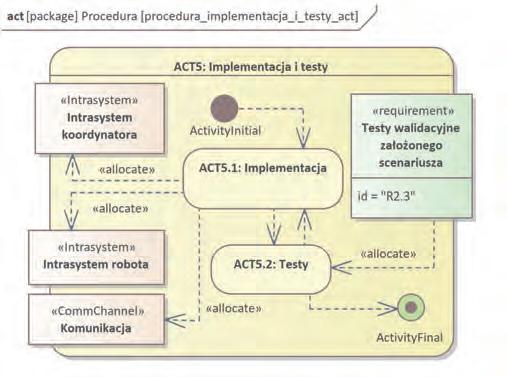

Na koniec (rys. 11) następują implementacja [ACT5.1] i testy [ACT5.2]. Naturalnie ich przebieg może wpływać na poprzednie aktywności. Wskazana jest też wspomagana generacja kodu w celu ułatwienia zapewnienia jego zgodności ze specyfikacją. W [ACT5.2] domykana jest procedura tworzenia systemu poprzez walidację pierwotnie założonego scenariusza jego działania.

Rys. 11. Procedura projektowa – ACT5: Implementacja i testy

Fig. 11. Design procedure – ACT5: Implementation and tests

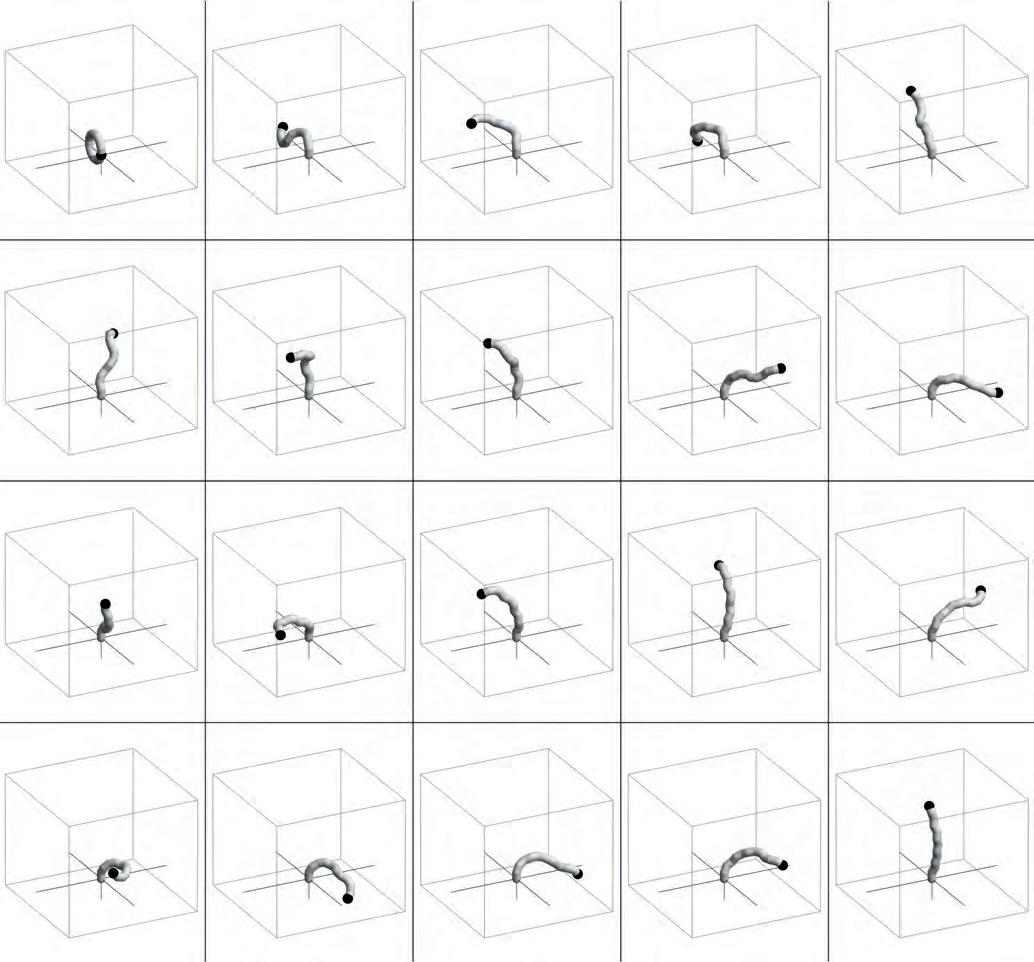

3. Realizacja przykładowego systemu

3.1. Założenia

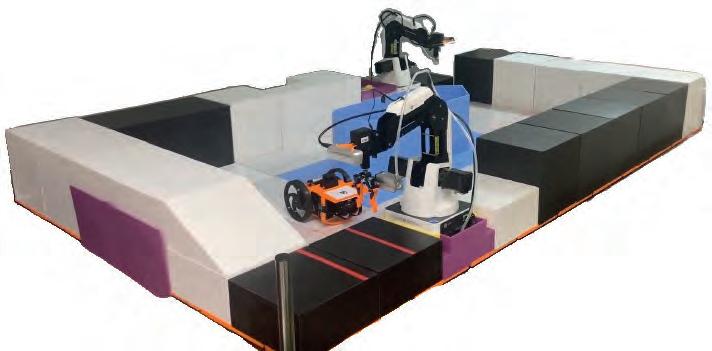

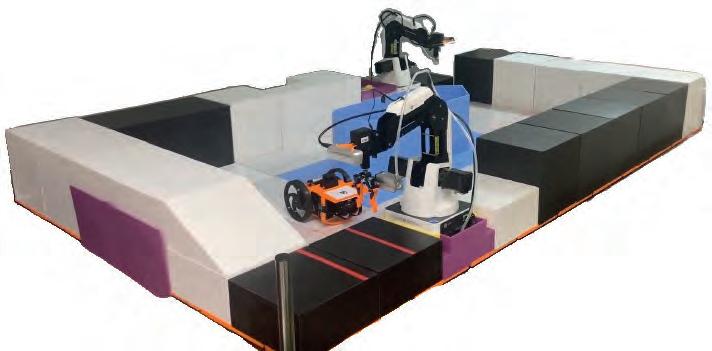

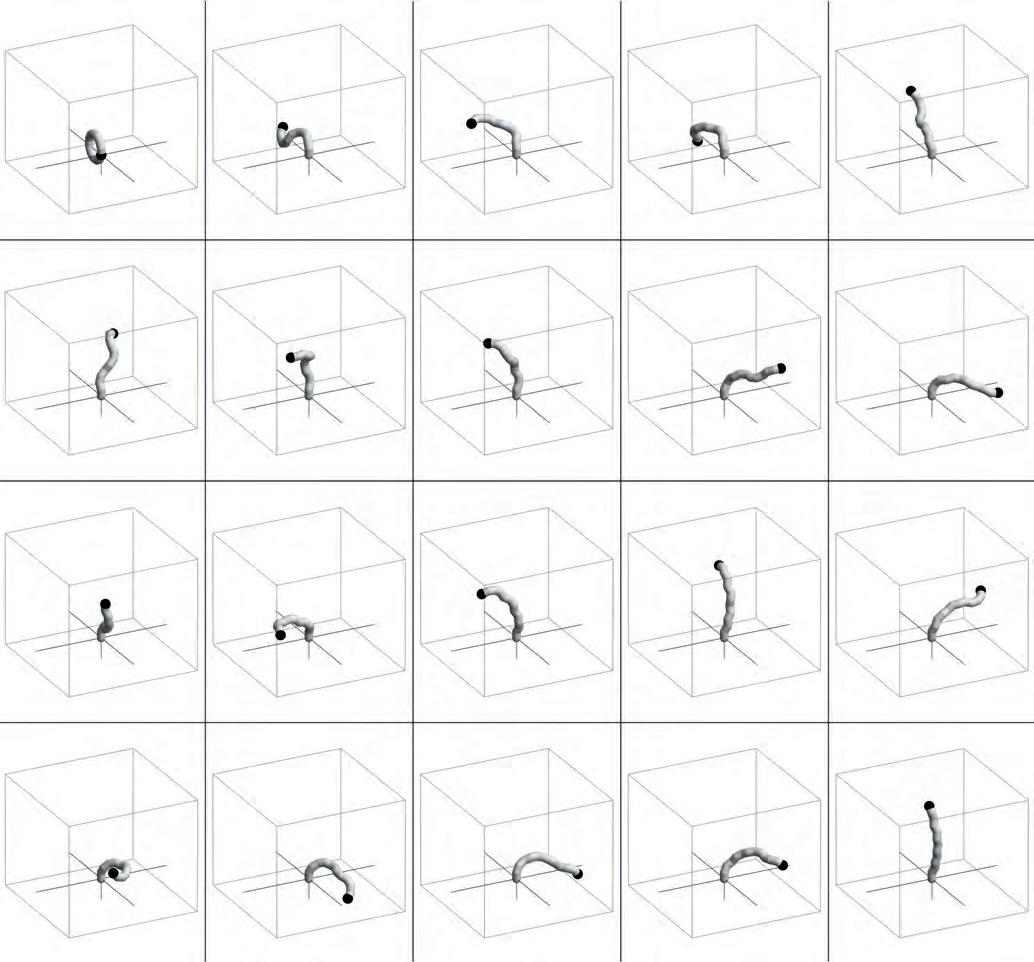

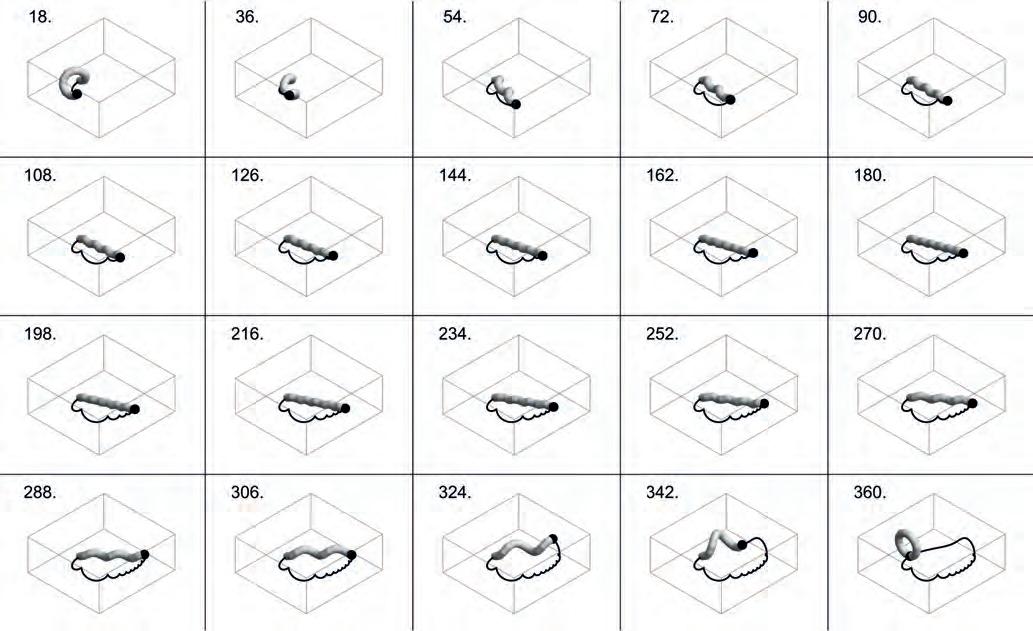

Podstawowym wymaganiem odnośnie realizacji systemu jest [R1.2] z diagramu 3. Współpraca wymaga współdziałania co najmniej dwóch robotów. Postanowiono wykorzystać roboty dostępne w Laboratorium Robotyki Instytutu Automatyki i Informatyki Stosowanej WEiTI PW, tzn. dwa manipulatory Dobot Magician i robota mobilnego MiniRyś. Opisom wspomnianych platform robotycznych poświęcono osobne sekcje w dalszej części tego artykułu. Drugą istotną kwestią było zdefiniowanie zadania, którą mają wspólnie wykonywać roboty. Zdecydowano się na realizację zadania transportu detalu przez robota mobilnego pomiędzy dwoma robotami manipulacyjnymi.

3.2. Opis środowiska testowego

Środowiskiem operacyjnym dla robotów jest modularna plansza o wymiarach 2 m × 1,2 m [20] (rys. 12).

Konfiguracja tej planszy może być modyfikowana przez zmianę położenia poszczególnych elementów oraz dodanie ruchomych przeszkód. Podczas budowy planszy wykorzystano elementy modularnego środowiska do rywalizacji robotów sportowych śledzących linię [24]. Wszystkie kable zasilające, sygnałowe i sieciowe poprowadzono pod planszą. Roboty manipulacyjne Dobot Magician zostały rozmieszczone w dwóch przeciwległych rogach planszy. Natomiast robot mobilny MiniRyś może swobodnie poruszać się po całej planszy. 3.3. Robot manipulacyjny Dobot Magician Robot manipulacyjny wykorzystany podczas testów opracowanego systemu to Dobot Magician – wielofunkcyjny, szeregowy manipulator dydaktyczny o czterech stopniach swobody (rys. 13) produkowany przez firmę Dobot.

Zasięg manipulatora wynosi 320 mm, a maksymalny udźwig to 0,5 kg. Robota Dobot Magician można łatwo rekonfigurować i dodawać nowy osprzęt np. przyssawkę pneumatyczną lub dwupalczasty chwytak równoległy, dostosowując go pod konkretne

environment

Rys. 12. Środowisko testowe

Fig. 12. Test

Rys. 13. Manipulator Dobot Magician – wizualizacja [20]

Fig. 13. Dobot Magician manipulator – visualization [20]

Rys. 12. Środowisko testowe

Fig. 12. Test

Rys. 13. Manipulator Dobot Magician – wizualizacja [20]

Fig. 13. Dobot Magician manipulator – visualization [20]

14 Metodyka projektowania systemów robotycznych w oparciu o metamodele EARL i MeROS POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

zastosowanie aplikacyjne. Manipulator jest sterowany pozycyjnie. Przy komunikacji z manipulatorem korzysta się z portu szeregowego i interfejsu USB.

Robot został wyposażony w system sterowania opracowany w ramach pracy inżynierskiej ”System sterowania robota manipulacyjnego Dobot Magician na bazie frameworka ROS 2” [8]. System sterowania daje możliwość interakcji z robotem z wykorzystaniem mechanizmu akcji (ruch manipulatora), usług (sterowanie efektorami) i tematów (odczyt pozycji). Użytkownik ma również możliwość wizualizacji stanu robota, sterowania z poziomu GUI oraz diagnostyki. Struktura kinematyczna tego robota sprawia, że przystaje on do realizacji zadań typu podnieś i umieść. Robot wykorzystany podczas testów posiada dodatkowe komponenty wykonane w technologii druku 3D – nakładki na chwytak oraz uchwyt do kamery głębi Intel RealSense D435i.

3.4. Robot mobilny MiniRyś

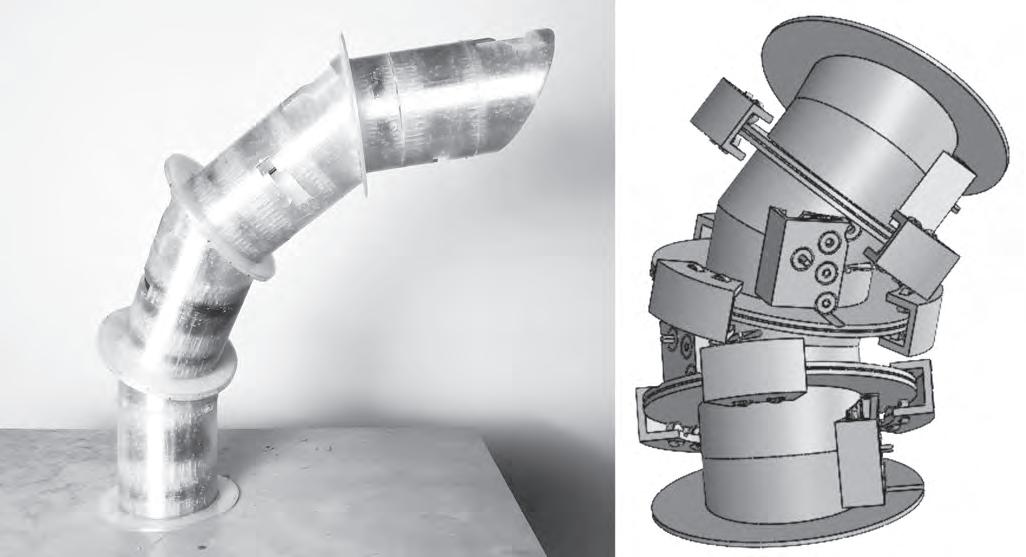

MiniRyś to dwukołowy mobilny robot o zmiennym sposobie lokomocji, który rozwijany jest w ramach działalności Koła Naukowego Robotyki ”Bionik” od 2013 r. (rys. 14).

Rys. 14. Robot mobilny MiniRyś (model CAD)

Fig. 14. MiniRyś mobile robot (CAD model)

Pierwsze prototypy [19] powstały na podstawie badań nad platformą robota o zmiennym trybie lokomocji [14, 15, 21]. W kolejnych wersjach rozwojowych robota badano jego poszczególne komponenty sprzętowe, rozwiązania programowe jak również systemy operacyjne. Aktualnie robot posiada system sterowania oparty o ROS 2 stworzony w ramach prac nad platformą sprzętowo-programową czasu rzeczywistego [5]. W ramach ostatnich prac nad najnowszą wersją robota skupiono się na diagnostyce, testach i wizualizacji działania [12]. Platforma sprzętowa robota została wyposażona w obrotowy skaner LiDAR, a system sterowania został zintegrowany ze stosem nawigacyjnym Nav2. Oprócz poruszania się w trybie poziomym, w którym trzecim punktem podparcia jest zderzak, ma on również możliwość przemieszczania się w trybie pionowym, w którym robot balansuje na dwóch kołach. Robot jest platformą dydaktyczno-badawczą, umożliwiającą szkolenie z zakresu sterowania robotami mobilnymi, systemów wizyjnych, systemów czasu rzeczywistego, a także prowadzenie badań z zakresu zarządzania systemami wielorobotowymi i zachowania roju robotów.

3.5. Konfiguracja sprzętowo-sieciowa systemu podczas testów

Elementy systemu (m.in. roboty i ich sensory) wraz z interfejsami do ich wzajemnej komunikacji zobrazowano na diagramie 15.

Celem zachowania zgodności językowej modelu systemu z wytworzonym oprogramowaniem, na diagramach prezentują-

Rys. 15. Diagram konfiguracji sprzętowo-sieciowej

Fig. 15. Hardware and network configuration diagram

cych realizację systemu zastosowano anglojęzyczne oznaczenia. Manipulatory komunikują się z kamerami RGBD oraz z jednostką sterująco-koordynującą z wykorzystaniem interfejsu USB. Komunikacja z robotem mobilnym odbywa się poprzez interfejs WLAN, a jego eksteroreceptor tzn. LiDAR, komunikuje się z komputerem robota z wykorzystaniem interfejsu UART.

3.6. Przykład zastosowania procedury projektowej

Pierwszym krokiem procedury projektowej jest strukturyzacja z wykorzystaniem dziedzinowego języka opisu systemów cyberfizycznych, którym jest EARL [ACT1]. Należy wskazać roboty i koordynatora oraz przypisać im Agenty [ACT1.1]. W naszym systemie występują cztery Agenty, których typy oraz zadania podano poniżej.

1) Agent koordynatora (CT): koordynacja.

2) Agent manipulatora pierwszego (CERT): stawianie kostki na robocie mobilnym.

3) Agent manipulatora drugiego (CERT): podnoszenie kostki z robota mobilnego.

4) Agent robota mobilnego (CERT): transport kostki między manipulatorami.

Po wskazaniu Agentów można przejść do wskazania Grup Połączeń <GpLinks> między nimi [ACT1.2], pamiętając przy tym o założeniu [R1.1] mówiącym o braku bezpośredniej komunikacji między robotami. Na diagramie 16 zobrazowano grupy połączeń między Agentami. Agent koordynatora wymienia informacje z Agentami każdego z robotów, pośrednicząc tym samym w komunikacji między poszczególnymi robotami.

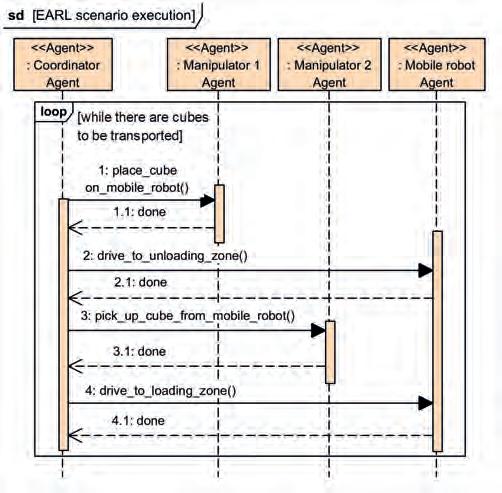

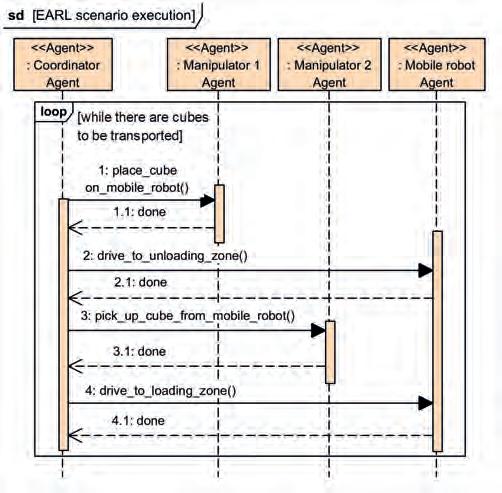

W drugim etapie opracowanej procedury projektowej również wykorzystywany jest język EARL. Ten etap rozpoczęto od sformułowania scenariusza działania systemu w formie diagramu sekwencji [ACT2.1], który widoczny jest na rysunku 17. Bloki występujące na tymże diagramie to Agenty z diagramu strukturalnego z rysunku 16.

Rys. 16. Ogólna struktura omawianego systemu wielorobotowego

Fig. 16. Overall structure of considered multi-robot system

15

Tomasz Winiarski, Jan Kaniuka, Jakub Ostrysz

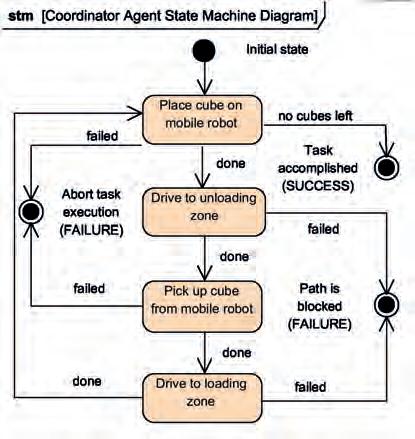

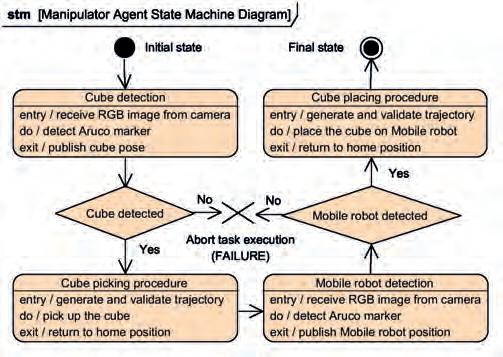

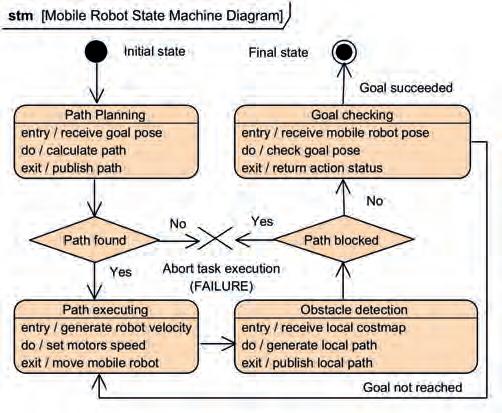

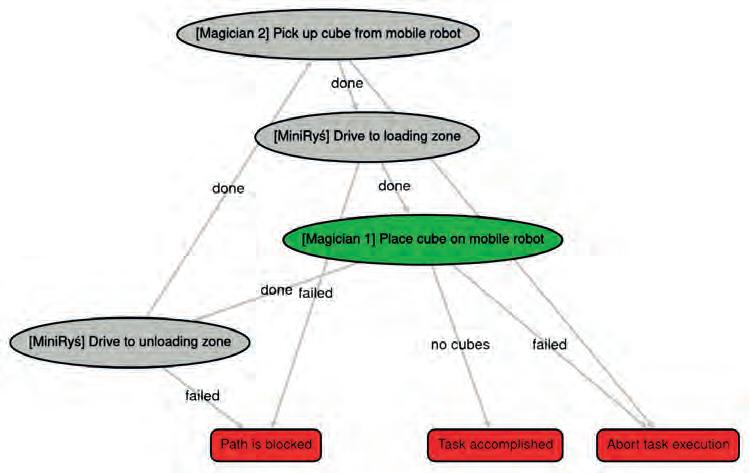

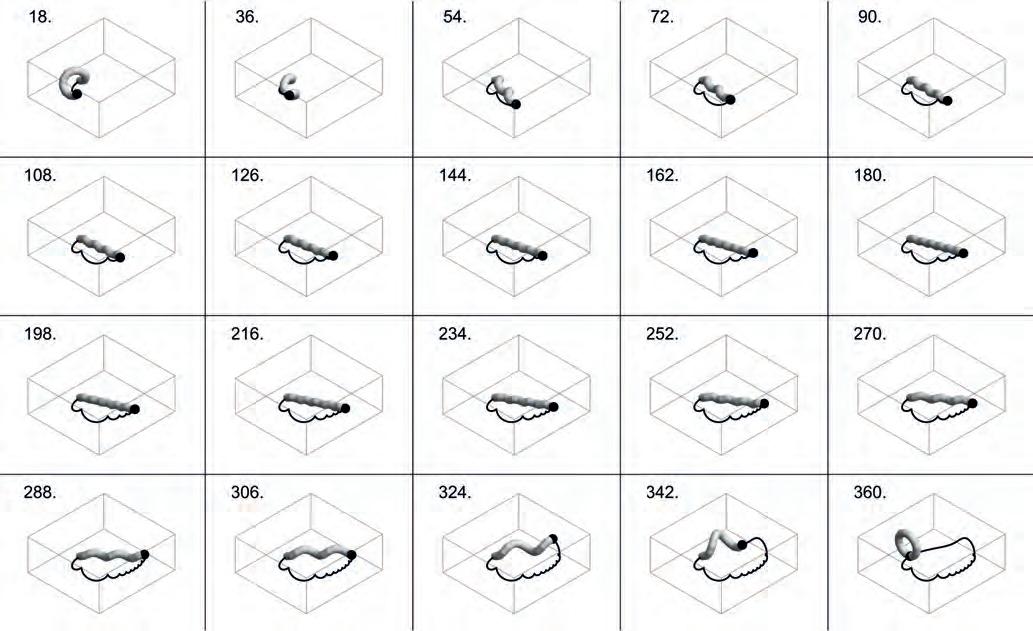

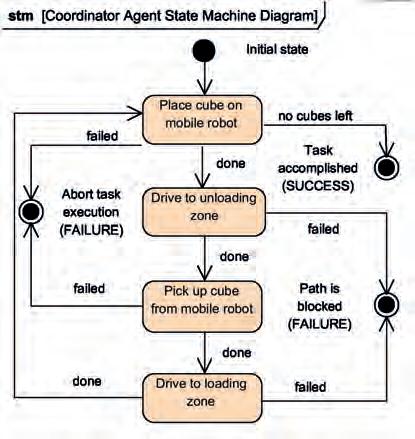

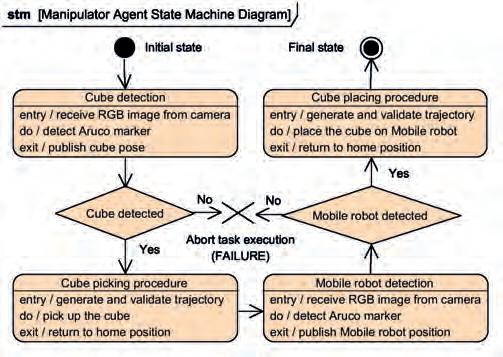

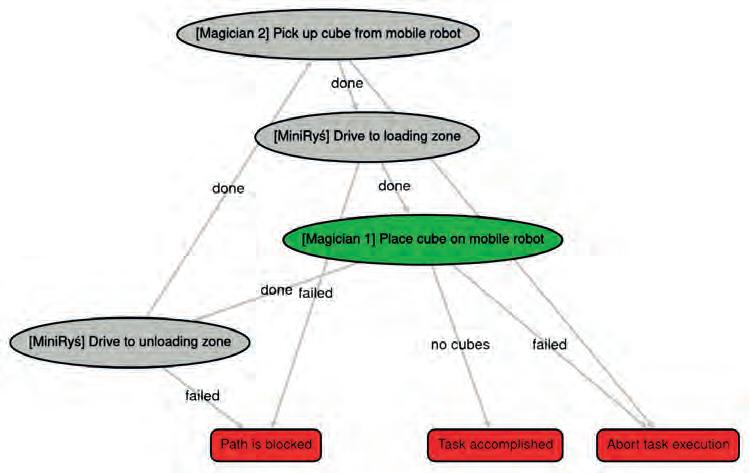

Diagram sekwencji reprezentuje jedynie konkretny scenariusz realizacji danego zadania. Jest on przejrzysty i czytelny dlatego, że nie są na nim rozpatrywane wszystkie sytuacje, które potencjalnie mogą zachodzić w trakcie działania systemu. Do zilustrowania wszystkich stanów systemu i tranzycji pomiędzy nimi wykorzystywany jest diagram automatu stanów (ang. State Machine Diagram), którego utworzenie jest częścią drugiego etapu procedury projektowej [ACT2.2]. Automat skończony zdefiniowany dla naszego scenariusza testowego widoczny jest na rysunku 18.

Na diagramie automatu skończonego znajdują się także stany terminalne, które są osiągane w momencie niepowodzenia na etapie wykonywania danego podzadania przez robota. W tym miejscu warto także wspomnieć o założeniu dotyczącym stanu początkowego systemu. Zakładamy, że robot mobilny nie ma na sobie kostki i znajduje się on w zasięgu manipulatora, który ma nim tę kostkę położyć.

Kolejny krok procedury to specyfikacja systemu z wykorzystaniem metamodelu MeROS [ACT3.1]. Rezultatem realizacji tego etapu procedury projektowej jest diagram strukturalny

Rys. 17. Scenariusz działania systemu Fig. 17. System operation scenario

Rys. 18. Automat skończony zachowania koordynatora

Fig. 18. Finite state automata of coordinator behaviour

Rys. 19. Specyfikacja systemu z wykorzystaniem metamodelu MeROS

Fig. 19. System specification using MeROS metamodel

Rys. 20. Interfejsy do komunikacji pomiędzy Intrasystemami

Fig. 20. Communication interfaces between Intrasystems

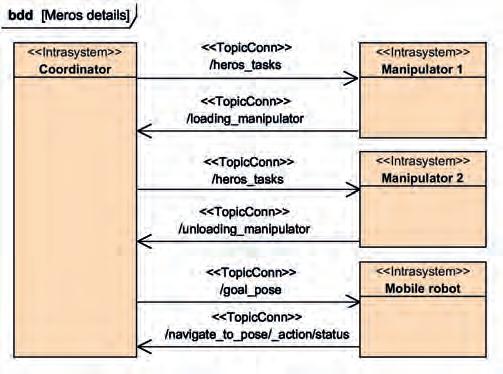

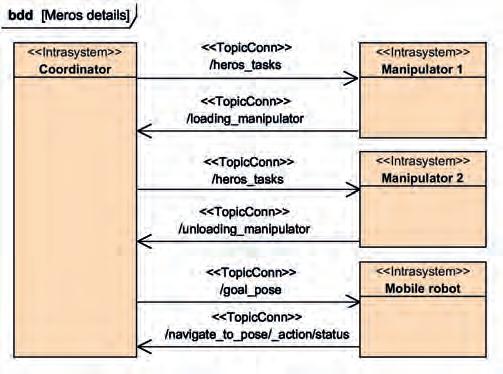

o ogólnym charakterze widoczny na rysunku 19. Powstał on przez mapowanie bloków EARL na ich odpowiedniki w MeROS. Najbardziej rozbudowanym krokiem procedury projektowej jest etap czwarty, w którym następuje dekompozycja i uszczegółowienie komponentów [ACT4.1] określonych na diagramie MeROS z widokiem ogólnym. Na diagramie bloków wewnętrznych (rys. 20) opisano, jakie mechanizmy komunikacji dostarczane przez ROS 2 zostały wykorzystane do wymiany informacji między Intrasystemami.

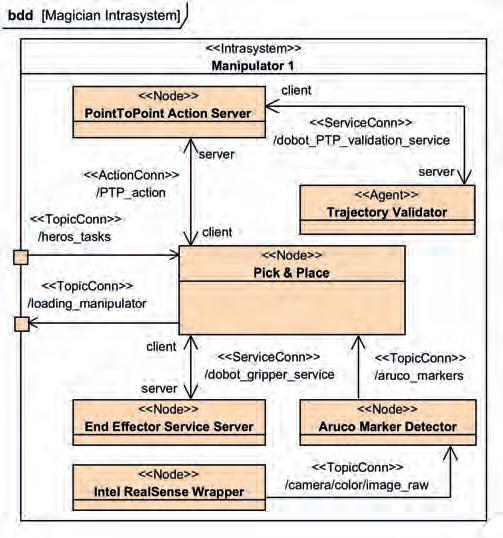

Intrasystemy obydwu manipulatorów otrzymują zadania od koordynatora poprzez odebranie wiadomości typu std_msgs.String na temacie /heros_task (nazwa heros to skrót od ”Heterogenous robots in ROS”). Manipulatory otrzymują komendy wysokopoziomowe (load lub unload), które odpowiadają sekwencji akcji wykonywanych w ramach Intrasystemu danego manipulatora. Informacja zwrotna mówiąca o zakończeniu wykonywania zadania lub wystąpieniu błędu jest przesyłana do koordynatora odpowiednio na tematach /loading_manipulator i /unloading_manipulator Robot mobilny otrzymuje od koordynatora zadania przez przesłanie na temacie /goal_pose współrzędnych punktu, do którego ma dojechać. Koordynator oczekuje na odpowiedź zwrotną na temacie /navigate_to_pose/_action/status Zadanie dla robota mobilnego MiniRyś może zakończyć się sukcesem, tzn. robot dojechał do celu lub niepowodzeniem – na drodze robota pojawiła się przeszkoda, której nie może ominąć. Intrasystem koordynatora został już opisany w formie automatu skończonego na diagramie 18. Wykorzystywane podczas testów manipulatory różnią się jedynie narzędziem roboczym oraz zadaniem, które wykonują. Manipulator 1 ma chwytak dwupalczasty równoległy i odpowiada za odkładanie kostki na robota mobilnego, z kolei Manipulator 2 ma przyssawkę pneumatyczną i zdejmuje nią kostki z robota. Struktura Intrasystemu Manipulator 1 została przedstawiona na diagramie 21.

16 Metodyka projektowania systemów robotycznych w oparciu o metamodele EARL i MeROS POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

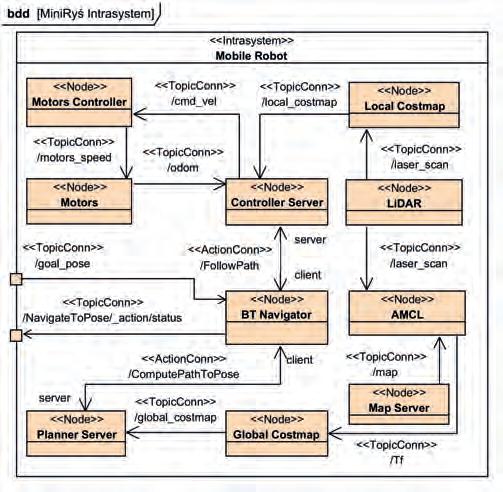

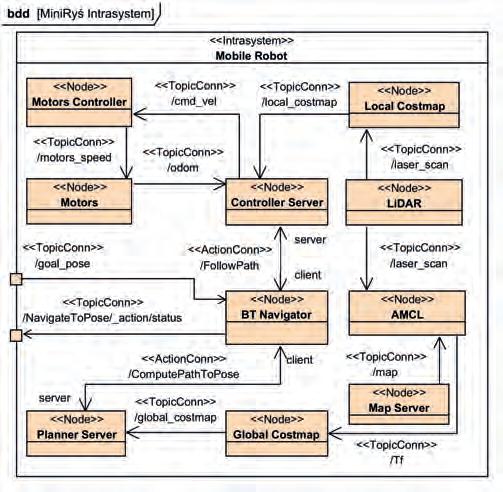

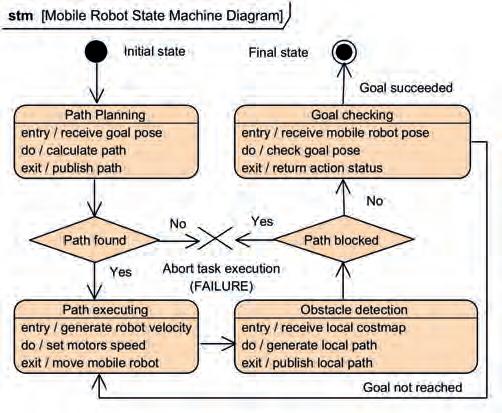

Węzeł Pick&Place odbiera polecenia od Węzła Koordynatora, wykonuje sekwencję operacji pozwalających podnieść kostkę, a następnie przesyła informację zwrotną o statusie wykonania zadania. Węzeł Intel RealSense Wrapper przesyła obraz z kamery RGBD do Węzła Aruco Marker Detector, który lokalizuje kostkę i przesyła informację o jej pozycji do Węzła Pick&Place. Na podstawie tej informacji wykonywana jest sekwencja operacji otwarcia/zamknięcia chwytaka oraz ruchu manipulatora, które pozwalają na podjęcie obiektu. Opisane powyżej operacje przedstawiono również w formie diagramu behawioralnego widocznego na rysunku 22. Na diagramie 23 przedstawiono strukturę Intrasystemu robota mobilnego. Głównym elementem jest Węzeł BT Navigator, pełniący rolę interfejsu między Węzłem koordynatora a robotem mobilnym. Węzeł ten otrzymuje od koordynatora informację dotyczące punktu na mapie modularnej planszy, do którego dotrzeć ma robot mobilny. Po otrzymaniu wiadomości, BT Navigator przekazuje informację zwrotną o statusie wykonania zadania. Węzeł AMCL odbiera odczyt z dwuwymiarowego skanu laserowego od Węzła Lidar. Dodatkowo otrzymuje mapę środowiska testowego od Węzła Map Server Dzięki tym danym możliwe jest zlokalizowanie robota przez

Rys. 21. Struktura Intrasystemu manipulatora

Fig. 21. Diagram of manipulator’s Intrasystem

Rys. 22. Diagram behawioralny Intrasystemu manipulatora

Fig. 22. Behavioural diagram of manipulator Intrasystem

Tomasz Winiarski, Jan Kaniuka, Jakub Ostrysz

określenie układu współrzędnych bazy robota w układzie współrzędnych mapy. Następnie Węzeł Global Costmap, wykorzystuje te dane podczas tworzenia globalnej mapy kosztu. Ta mapa jest następnie przekazywana do Węzła Planner Server, na podstawie której wyznaczany jest globalny plan i ścieżka, którą robot powinien podążać. Następnie na podstawie akcji ścieżka ta przetwarzana jest na pozycje na mapie i przekazywana do Węzła BT Navigator. Informacja o skanie laserowym 2D wykorzystywana jest również do tworzenia lokalnej mapy kosztu w Węźle Local Costmap, która następnie przesyłana jest do Węzła Controller Server. Węzeł ten wykorzystuje również dane odometryczne z Węzła silników robota, oraz informację o ścieżce przesyłane za pomocą akcji z Węzła BT Navigator w celu wyznaczenia prędkości, z którą powinien poruszać się robot mobilny, aby pokonać skorygowaną ścieżkę uwzględniającą informację o potencjalnych przeszkodach wykrywanych przez lokalną mapę kosztu. Ostatecznie wiadomość dotycząca zadanej prędkości przetwarzana jest przez Węzeł Motors Controller, który wyznacza sterowania na poszczególne silniki robota i przekazuje je do Węzła efektorów. Opisane powyżej operacje przedstawiono również w formie diagramu behawioralnego widocznego na rysunku 24.

Rys. 23. Struktura Intrasystemu robota mobilnego

Fig. 23. Diagram of mobile robot Intrasystem

Rys. 24. Diagram behawioralny Intrasystemu robota mobilnego

Fig. 24. Behavioural diagram of mobile robot Intrasystem

17

4. Podsumowanie

4.1. Ocena działania systemu

Ostatni etap procedury projektowej to implementacja [ACT5.1] i testy [ACT5.2]. Zaplanowany scenariusz testowy wykonano wielokrotnie. We wszystkich przypadkach koordynator w odpowiednich chwilach czasu przydzielał zadania właściwym robotom. Celowo wykorzystano roboty heterogeniczne podczas weryfikacji, aby pokazać, że opracowana procedura projektowa nie zakłada homogeniczności systemu robotycznego. Podczas jednej z prób manipulatorowi z przyssawką pneumatyczną nie udało się pobrać kostki z robota mobilnego. Test ten przeprowadzany był już późną porą i na skutek niedostatecznego oświetlenia sceny system wizyjny miał problem z detekcją obiektu do podjęcia. Wymóg zapewnienia dostatecznego oświetlenia nie został uwzględniony na etapie specyfikacji wymagań.

Film dokumentujący jeden z testów wraz z jednoczesną wizualizacją automatu stanu koordynatora dostępny jest pod linkiem3

Podczas implementacji automatu stanów koordynatora wykorzystano otwartoźródłową bibliotekę YASMIN (ang. Yet Another State MachINe). Dostarcza ona klasy oraz metody, które pozwalają w prosty i przejrzysty sposób skojarzyć zachowania (akcje) z poszczególnymi stanami. Dodatkowym atutem tej biblioteki jest możliwość bieżącej wizualizacji stanu automatu (rys. 25) przez program YasminViewer, co ułatwia identyfikację ewentualnych błędów poczynionych na etapie implementacji.

4.2. Perspektywy

rozwoju

Opracowana procedura projektowa dla systemów opartych o ROS 2 charakteryzuje się dużym potencjałem rozwojowym. Przykładowo możliwe jest jej rozbudowa przez wykorzystanie innych diagramów behawioralnych, np. diagramów przypadków użycia (ang. Use case diagram [uc]).

Etap implementacji systemu opracowanego z wykorzystaniem zaproponowanej procedury projektowej można także usprawnić poprzez dodanie wspomaganej generacji kodu w [ACT5.1]. Przyspieszy to proces tworzenia oprogramowania oraz pozwoli na wyeliminowanie części błędów na początkowym etapie implementacji. Do testów walidacyjnych systemu można także przygotować bardziej skomplikowany scenariusz. Warte rozważenia

3 https://vimeo.com/865928183

Rys. 25. Widok automatu skończonego koordynatora z poziomu YasminViewer

Fig. 25. View of coordinator’s finite state automaton from YasminViewer

wydaje się rozbudowanie modularnej planszy, aby umożliwić współdziałanie kilku robotów mobilnych. Istotnym rozszerzeniem etapu projektowania systemu może być także uwzględnienie współbieżności wykonywania zadań przez roboty.

Podziękowania

Projekt został zrealizowany w ramach grantu Koła Naukowego Robotyki Bionik ”Rozwój metod współdziałania robotów manipulacyjnych i mobilnych wykorzystujących framework ROS 2”. Sprzęt potrzebny do realizacji projektu współfinansowano ze środków programu IDUB – Inicjatywa Doskonałości: Uczelnia Badawcza.

Autorzy pragną podziękować Danielowi Giełdowskiemu i Jakubowi Sadowskiemu za udział w tworzeniu modularnego środowiska testowego dla heterogeniczego systemu robotycznego.

Bibliografia

1. de Araújo Silva E., Valentin E., Carvalho J.R.H., da Silva Barreto R., A survey of model driven engineering in robotics. “Journal of Computer Languages”, Vol. 62, 2021, DOI: 10.1016/j.cola.2020.101021.

2. Dudek W., Miguel N., Winiarski T., SPSysML: A metamodel for quantitative evaluation of Simulation-Physical Systems. arXiv preprint arXiv:2303.09565, 2023, DOI: 10.48550/arXiv.2303.09565.

3. Dudek W., Winiarski T., Scheduling of a Robot’s Tasks With the TaskER Framework. “IEEE Access”, Vol. 8, 2020, 161449–161471, DOI: 10.1109/ACCESS.2020.3020265.

4. D’Avella S., Avizzano C.A., Tripicchio P., ROS-Industrial based robotic cell for industry 4.0: Eye-in-hand stereo camera and visual servoing for flexible, fast, and accurate picking and hooking in the production line. “Robotics and Computer-Integrated Manufacturing”, Vol. 80, 2023, DOI: 10.1016/j.rcim.2022.102453.

5. Giełdowski D., Struktura i implementacja systemu robotycznego zawierającego robota MiniRyś. Master’s thesis, WEiTI, 2021.

6. Grady J.O., System validation and verification, CRC Press, 1997.

7. Janiak M., Zieliński C., Control system architecture for the investigation of motion control algorithms on an example of the mobile platform Rex. “Bulletin of the Polish Academy

18 Metodyka projektowania systemów robotycznych w oparciu o metamodele EARL i MeROS POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

of Sciences – Technical Sciences”, Vol. 63, No. 3, 2015, 667–678, DOI: 10.1515/bpasts-2015-0078.

8. Kaniuka J., System sterowania robota manipulacyjnego Dobot Magician na bazie frameworka ROS 2. Bachelor’s thesis, WEiTI, 2023.

9. Kornuta T., Zieliński C., Winiarski T., A universal architectural pattern and specification method for robot control system design. “Bulletin of the Polish Academy of Sciences – Technical Sciences”, Vol. 68, No. 1, 2020, 3–29, DOI: 10.24425/bpasts.2020.131827.

10. Macenski S., Foote T., Gerkey B., Lalancette C., Woodall W., Robot operating system 2: Design, architecture, and uses in the wild, “Science Robotics”, Vol. 7, No. 66, 2022, DOI: 10.1126/scirobotics.abm6074.

11. Op en Management Group. OMG Systems Modeling Language – Version 1.7, December 2022. https://www.omg. org/spec/SysML/1.7/Beta1/PDF (dostęp: 2024-03-23).

12. Ostrysz J., Badania, modernizacja oraz wizualizacja robota mobilnego MiniRyś. Bachelor’s thesis, WEiTI, 2023.

13. Salado A., Wach P., Constructing True Model-Based Requirements in SysML. “Systems”, Vol. 7, No. 2, 2019, DOI: 10.3390/systems7020019.

14. Seredyński D., Winiarski T., Robot mobilny o zmiennym sposobie lokomocji – wyniki badań. „Pomiary Automatyka Robotyka”, R. 17, Nr 7–82013, 107–115.

15. Seredyński D., Winiarski T., Banachowicz K., Walęcki M., Stefańczyk M., Majcher P., Robot mobilny o zmiennym sposobie lokomocji – konstrukcja mechaniczna i elektroniczna. „Pomiary Automatyka Robotyka”, R. 17, Nr 1, 2013, 162–167.

16. The International Council on Systems Engineering. INCOSE systems engineering handbook: a guide for system life cycle processes and activities. John Wiley & Sons, 2023.

17. Trojanek P., Zieliński C., Kornuta T., Winiarski T., Metoda projektowania układów sterowania autonomicznych robotów mobilnych. Część 2. Przykład zastosowania. „Pomiary Automatyka Robotyka”, R. 15, Nr 10, 2011, 84–90.

18. Winiarski T., MeROS: SysML-Based Metamodel for ROSBased Systems. “IEEE Access”, Vol. 11, 2023, 82802–82815, DOI: 10.1109/access.2023.3301727.

19. Winiarski T., Bogusz M., Giełdowski D., Foryszewski K., Miniaturowy robot mobilny o zmiennym sposobie lokomocji MiniRyś. XV Krajowa Konferencja Robotyki – Postępy robotyki, Vol. 1, 2018, 251–260.

20. Winiarski T., Giełdowski D., Kaniuka J., Ostrysz J., Sadowski J., HeROS: a miniaturised platform for research

and development on Heterogeneous RObotic Systems arXiv:2403.04384, 2024, DOI: 10.48550/arXiv.2403.04384.

21. Winiarski T., Seredyński D., Robot mobilny o zmiennym sposobie lokomocji – system sterowania. „Pomiary Automatyka Robotyka”, R. 17, Nr 5, 2013, 93–99, 2013.

22. Winiarski T., Seredyński D., EARL – dziedzinowy język opisu systemów cyberfizycznych. XVI Krajowa Konferencja Robotyki – Postępy robotyki, Vol. 1, 2022, 223–232.

23. Winiarski T., Węgierek M., Seredyński D., Dudek W., Banachowicz K., Zieliński C., EARL – Embodied Agent-Based Robot Control Systems Modelling Language. „Electronics”, Vol. 9, No. 2, 2020, DOI: 10.3390/electronics9020379.

24. Węgierek M., Świstak B., Winiarski T., Modularne środowisko do rywalizacji robotów sportowych śledzących linię „Pomiary Automatyka Robotyka”, R. 19, Nr 3, 2015, 61–66, DOI: 10.14313/PAR_217/61.

25. Zieliński C., Transition-function based approach to structuring robot control software. K. Kozłowski, redaktor, Robot Motion and Control, Vol. 335 serii Lecture Notes in Control and Information Sciences, 2006, 265–286. Springer-Verlag, DOI: 10.1007/978-1-84628-405-2_17.

26. Zieliński C., Robotyka: techniki, funkcje, rola społeczna Cz. 1. Techniczne podstawy inteligencji i bezpieczeństwa robotów. „Pomiary Automatyka Robotyka”, R. 26, Nr 4, 2022, 5–26, DOI: : 10.14313/PAR_246/5.

27. Zieliński C., Robotyka: techniki, funkcje, rola społeczna Cz. 2. Aktualne możliwości robotów. „Pomiary Automatyka Robotyka”, R. 27, Nr 1, 2023, 5–18, 1 DOI: 10.14313/PAR_247/5.

28. Zieliński C., Robotyka: techniki, funkcje, rola społeczna. Cz. 3. Roboty a problemy społeczne. „Pomiary Automatyka Robotyka”, R. 27, Nr 2, 2023, 5–20, 10.14313/PAR_248/5.

29. Zieliński C., Kornuta T., Programowe struktury ramowe do tworzenia sterowników robotów. „Pomiary Automatyka Robotyka”, R. 19, Nr 1, 2015, 5–14, DOI: 10.14313/PAR_215/5.

30. Zieliński C., Kornuta T., Stefańczyk M., Szynkiewicz W., Trojanek P., Walęcki M.. Języki programowania robotów przemysłowych. „Pomiary Automatyka Robotyka”, R. 16, Nr 112012, 10–19.

31. Zieliński C., Kornuta T., Trojanek P., Winiarski T., Metoda projektowania układów sterowania autonomicznych robotów mobilnych. Część 1. Wprowadzenie teoretyczne. „Pomiary Automatyka Robotyka”, R. 15, Nr 9, 2011, 84–87.

Robotic Systems Development Method Based on EARL and MeROS Metamodels

Abstract: Systems engineering is currently playing a key role in the manufacture, implementation and maintenance of cyber-physical systems. Increasingly, it is becoming an integral tool when designing, for example, robotic systems. This paper proposes a methodology for the design of robotic systems based on two metamodels: EARL at the implementation platform-independent level and MeROS dedicated to ROS/ROS 2. The procedure is demonstrated by analysing a representative application: a heteregonous multi-robot system with a central coordinator.

Keywords: robot, systems engineering, ROS 2, EARL, MeROS

19

Tomasz Winiarski, Jan Kaniuka, Jakub Ostrysz

dr inż. Tomasz Winiarski tomasz.winiarski@pw.edu.pl

ORCID: 0000-0002-9316-3284

Jest adiunktem w Instytucie Automatyki i Informatyki Stosowanej Politechniki Warszawskiej oraz opiekunem Koła Naukowego Robotyki „Bionik”. Jego zainteresowania naukowe koncentrują się obecnie wokół inżynierii systemów cyberfizycznych, którą aplikuje w obszarze robotyki. W swojej pracy kierował licznymi grantami badawczymi poświęconymi powyższej tematyce. Jest członkiem polskich sekcji stowarzyszeń IEEE i INCOSE.

inż. Jakub Ostrysz jakub.ostrysz.stud@pw.edu.pl

ORCID: 0009-0006-8178-0134

Student kierunku Automatyka i Robotyka na Wydziale Elektroniki i Technik Informacyjnych Politechniki Warszawskiej. W 2023 r uzyskał tytuł inżyniera. Jego zainteresowania badawcze koncentrują się wokół systemów nawigacji robotów mobilnych i systemów sterowania rojem robotów. Aktywny członek Koła Naukowego Robotyki ”Bionik”.

inż. Jan Kaniuka

jan.kaniuka.stud@pw.edu.pl

ORCID: 0009-0009-9379-4906

Student kierunku Automatyka i Robotyka na Wydziale Elektroniki i Technik Informacyjnych Politechniki Warszawskiej. W 2023 r. uzyskał tytuł inżyniera z wyróżnieniem. W ramach pracy inżynierskiej zajmował się implementacją systemu sterowania 4-osiowego robota manipulacyjnego na bazie ROS 2. Aktywny członek Koła Naukowego Robotyki ”Bionik”.

20 Metodyka projektowania systemów robotycznych w oparciu o metamodele EARL i MeROS POMIARY•AUTOMATYKA•ROBOTYKANR2/2024

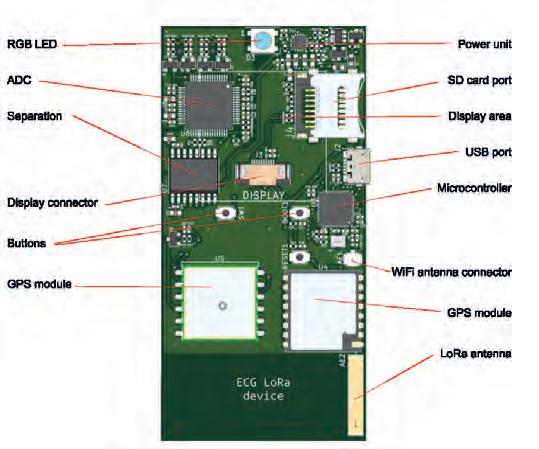

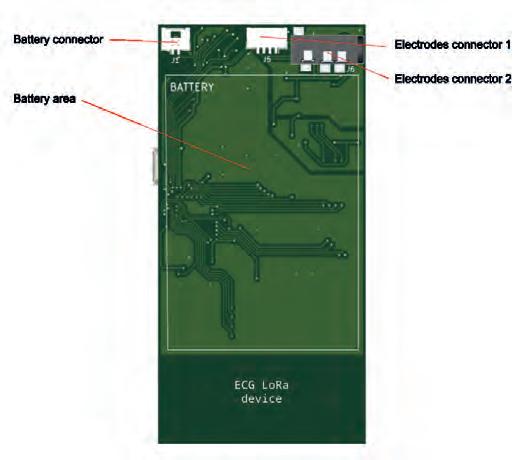

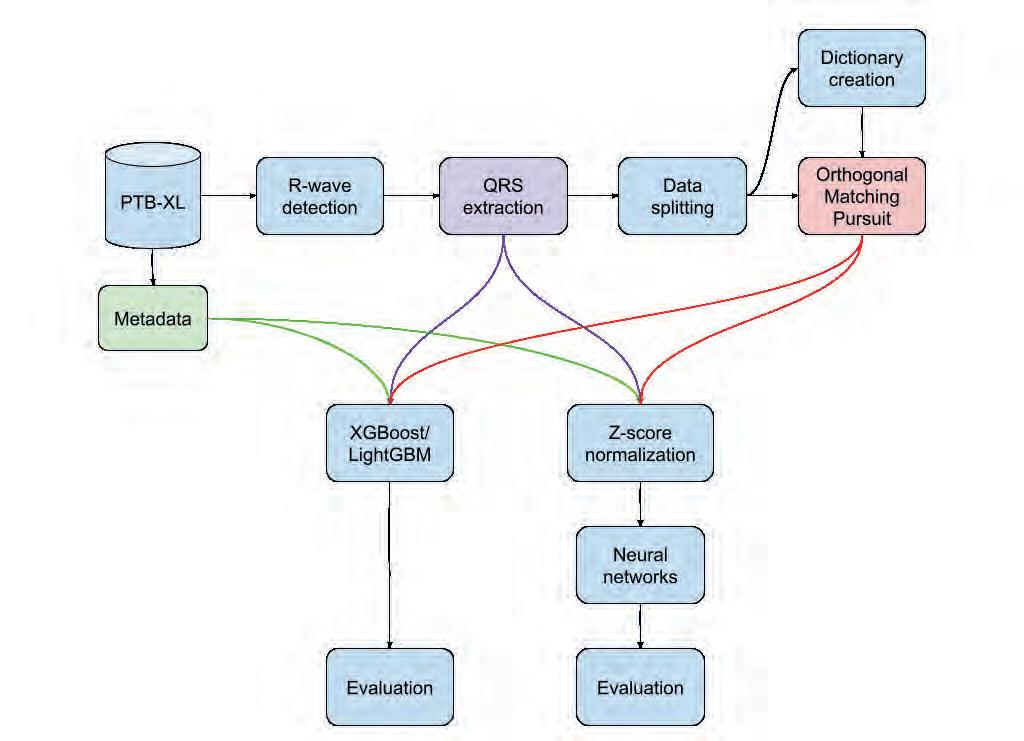

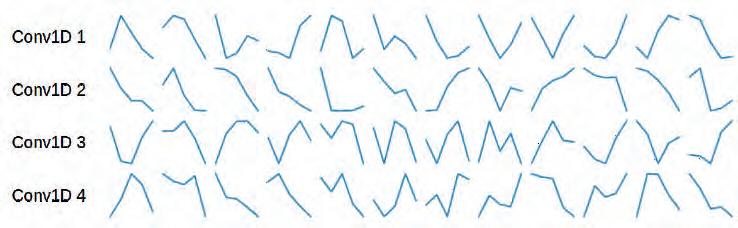

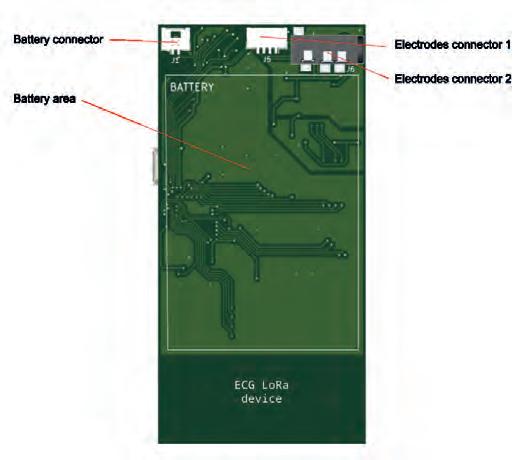

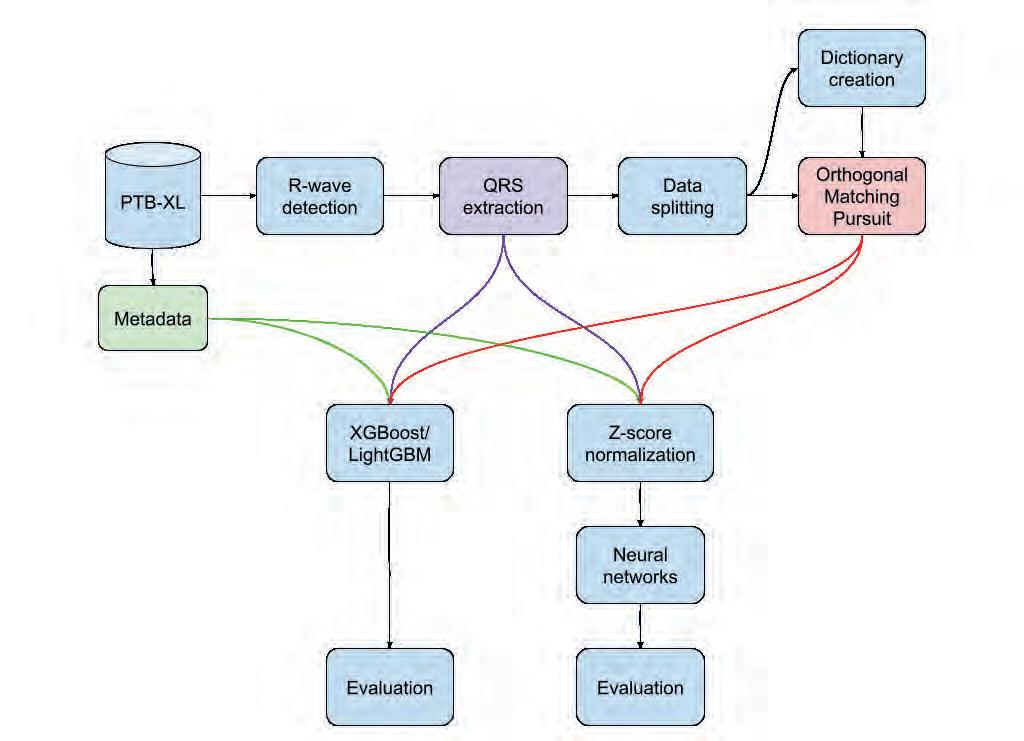

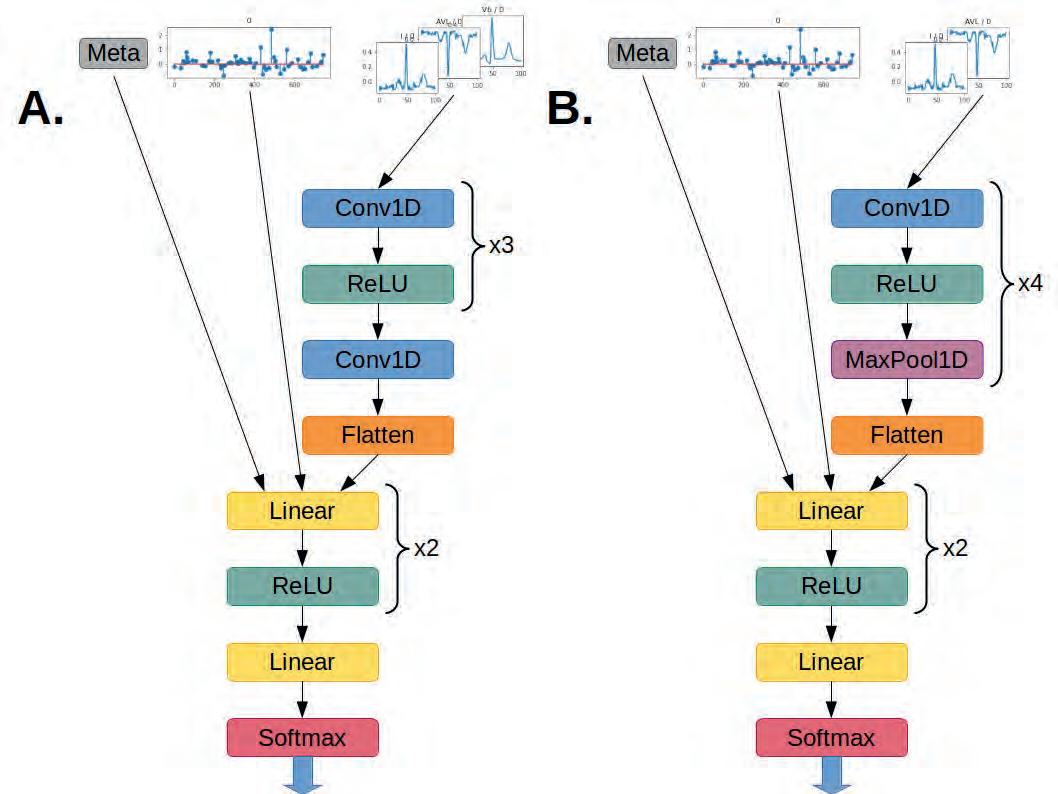

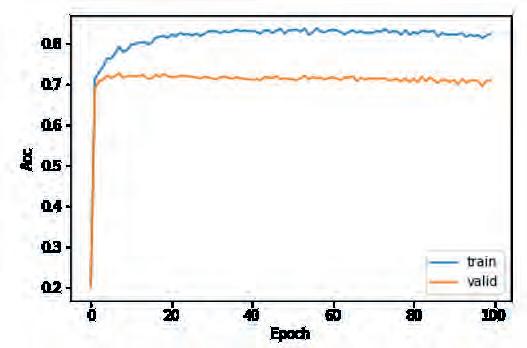

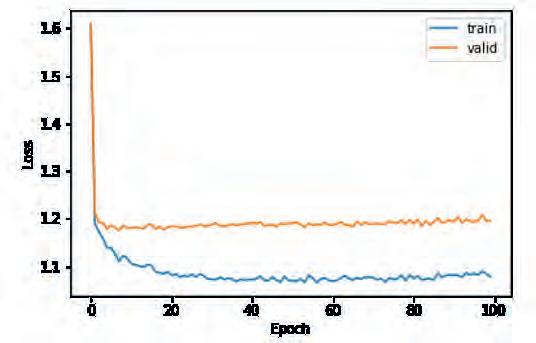

The ECG Signal Monitoring System Using Machine Learning Methods and LoRa Technology

Sandra Śmigiel, Tomasz Topoliński

Bydgoszcz University of Science and Technology, Faculty of Mechanical Engineering, al. prof. S. Kaliskiego 7, 85-796 Bydgoszcz

Damian Ledziński, Tomasz Andrysiak

Bydgoszcz University of Science and Technology, Faculty of Telecommunications, Computer Science and Electrical Engineering, al. prof. S. Kaliskiego 7, 85-796 Bydgoszcz

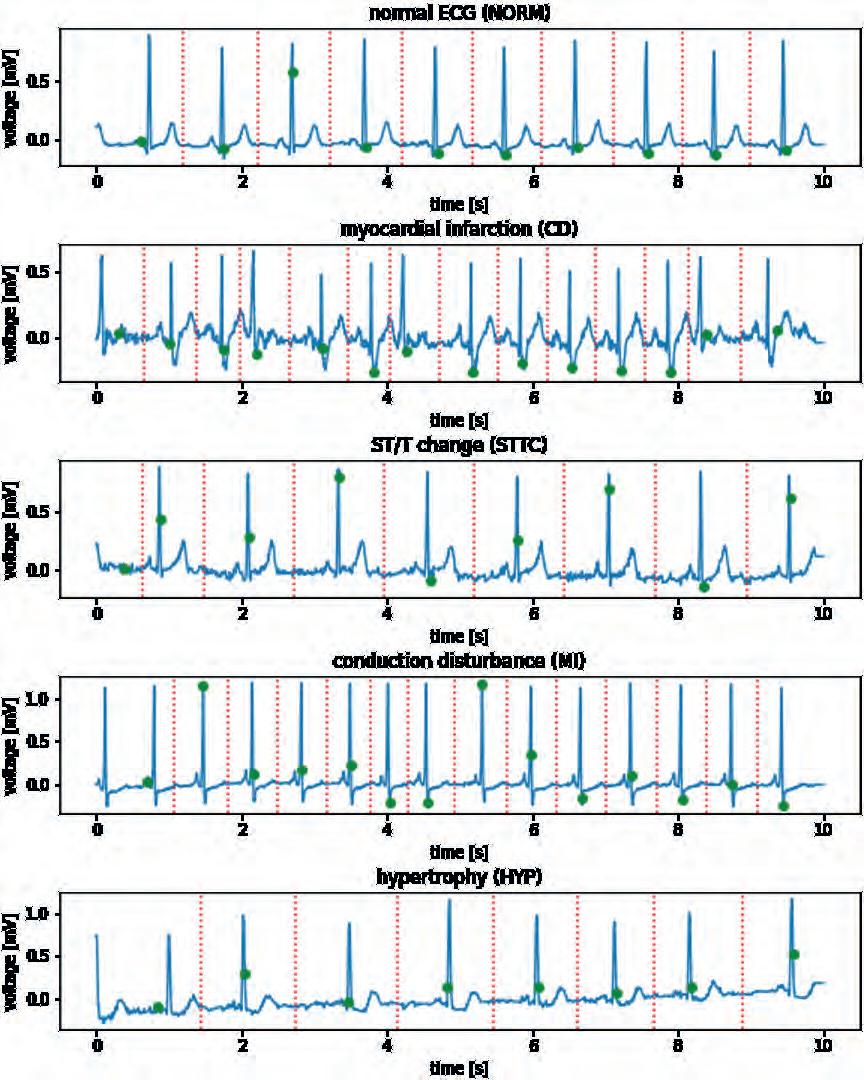

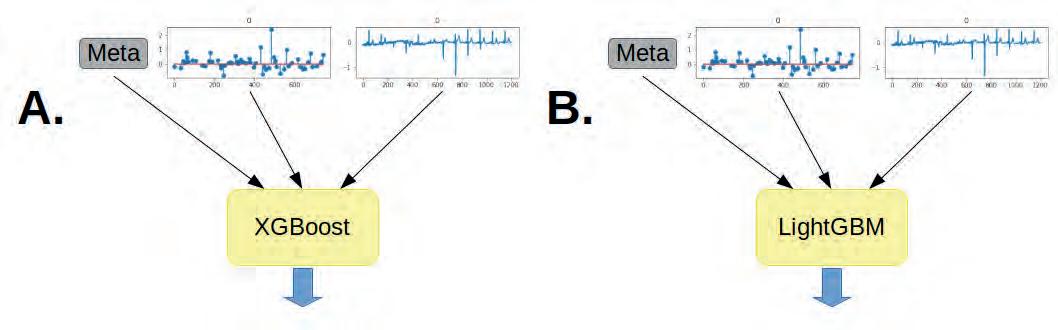

Abstract: An electrocardiogram (ECG) is the first step in diagnosing heart disease. Heart rhythm abnormalities are among the early signs of heart disease, which can contribute to a patient’s heart attack, stroke, or sudden death. The importance of the ECGs has increased with the development of technologies based on machine learning and remote monitoring of vital signs. In particular, early detection of arrhythmias is of great importance when it comes to diagnosing a patient with heart disease. This is made possible through recognizing and classifying pathological patterns in the ECG signal. This paper presents a system for mobile monitoring of ECG signals enriched with the results of the study of the application of machine learning models from the group of Tree-based ML techniques and Neural Networks in the context of heart disease classification. The research was carried out through the use of the publicly available PTB-XL database of the ECG signals. The results were analyzed in the context of classification accuracy for 2, 5 and 15 classes of heart disease. Moreover, a novelty in the work is the proposal of machine learning techniques and architectures neural networks, which, have been selected to be applicable to IoT devices. It has been proven that the proposed solution can run in real time on IoT devices.

Keywords: mobile device, ECG signal, classification, IoT, LoRa, Neural Network, Machine Learning, PTB-XL database

1. Introduction

Cardiology is one of the fields of medicine where devices are finding applications in both diagnosis and therapy. Basic and relatively simple to obtain biomedical signals are increasingly providing useful and even relevant information about a patient’s condition (e.g., blood pressure, heart rate, heart rhythm). When it became possible to remotely transmit information recorded by medical devices, concepts of telemonitoring and even remote treatment began to emerge.

Remote monitoring in cardiology involves the use of electronic devices and telecommunications technology to digitally transmit physiological data from a patient’s home to a healthcare facility, thus helping to monitor the progression of diseases. This can be partially achieved using the parameters mentioned earlier, such as blood pressure and heart rate, which

Autor korespondujący:

Tomasz Andrysiak, tomasz.andrysiak@pbs.edu.pl

Artykuł recenzowany nadesłany 30.11.2023 r., przyjęty do druku 15.05.2024 r.

are measured by devices such as blood pressure monitors and pulse oximeters. In contrast, a comprehensive approach is the use of electrocardiography (ECG). ECG, as a graphical representation of the heart’s electrical activity, makes it possible to detect and analyze abnormal electrical activity of the heart outside the hospital, during daily activities. ECG telemonitoring is responsible for reading the recorded ECG signals, archiving them on a mobile device (saving) and transmitting them to a medical center (sending).

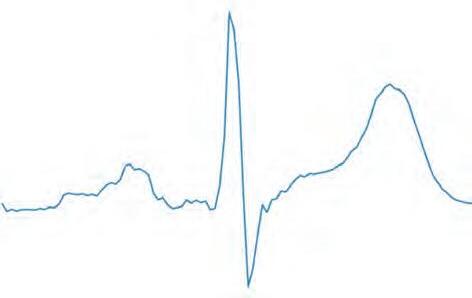

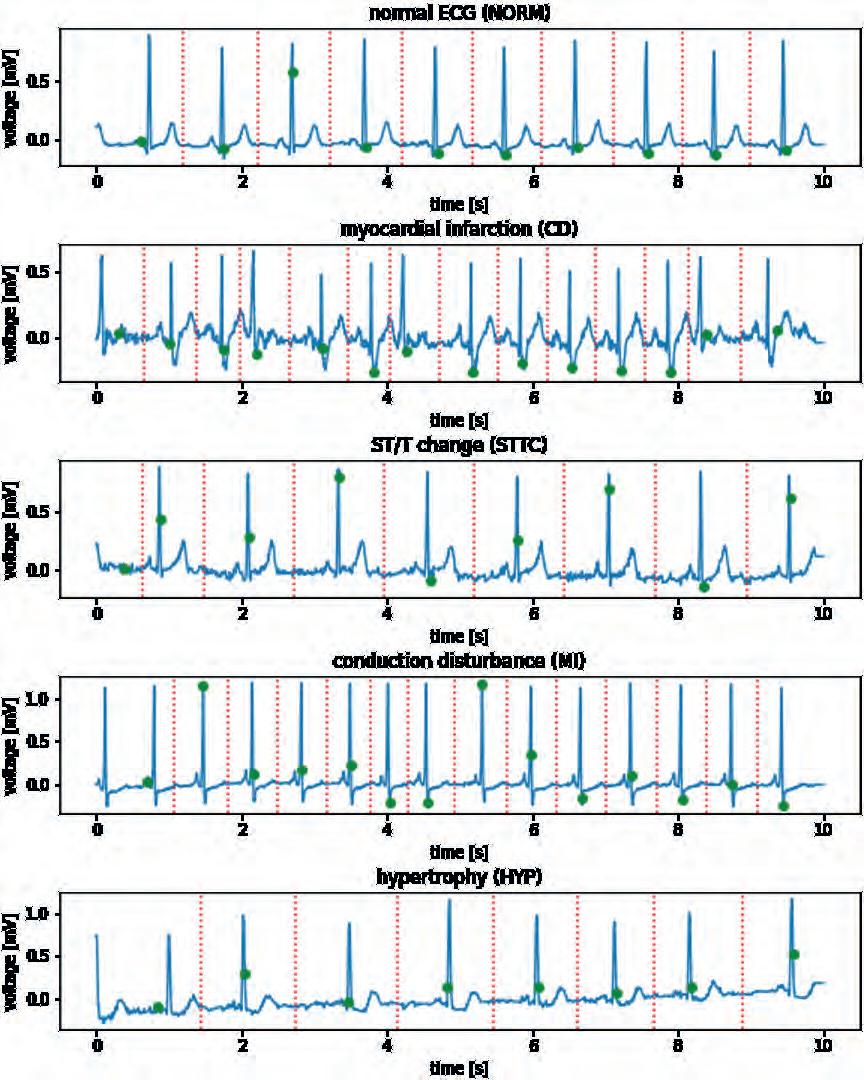

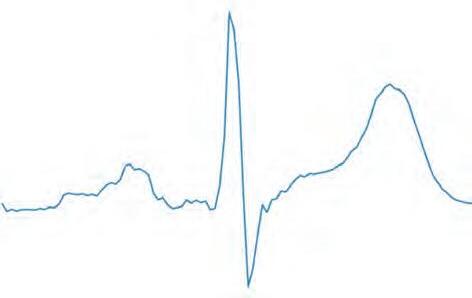

The electrocardiogram (ECG) is determined by many variables. It provides specific curves of electrical differences when the atria and ventricles of the heart muscle depolarize and repolarize, which corresponds to the cardiac cycle. The work of the atria and ventricles of the heart muscle produces waves as a result. The ECG signal consists of repetitive waves, such as the P-wave, QRS complex, and T-wave. These elements make up the ECG signal (fig. 1). The ECG analysis is one of the most important steps in diagnosing a heart disease. Issues in this area involve finding pathological patterns in the ECG signal. Any abnormality in the heart muscle can cause a heart disease, which may contribute to heart attacks, strokes, and cardiac arrhythmias. Many of these are treatable if they are diagnosed in time and the treatment undertaken by doctors is properly conducted. Predicting the onset of these disorders has been a major concern of researchers and scientists for many years [2].

Zezwala się na korzystanie z artykułu na warunkach licencji Creative Commons Uznanie autorstwa 3.0

21 Pomiary Automatyka Robotyka, ISSN 1427-9126, R. 28, Nr 2/2024, 21–36, DOI: 10.14313/PAR_252/21

At the core of ECG signal analysis there are shapes from individual heartbeats, morphological features of the ECG curve components, and their temporal properties. This process requires knowledge of the location and morphology of its various components, such as P-QRS-T. These features correspond to the location, duration, amplitude, and shape of individual waves or deflections. An important step in considering issues corresponding to the analysis of electrocardiographic signals is the pre-processing and de-noising of the signal [16]. The next step is feature extraction, which involves extracting characteristic information from the electrocardiographic waveform. The next step is the ECG signal classification, corresponding to signal evaluation in the context of cardiac diseases. The realization of these areas is possible mainly due to the availability of large, public open-source ECG datasets. The most commonly used databases are Physionet, PhysioBank, and PhysioToolkit [3].

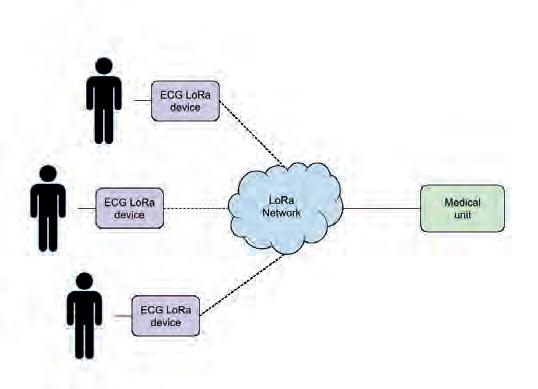

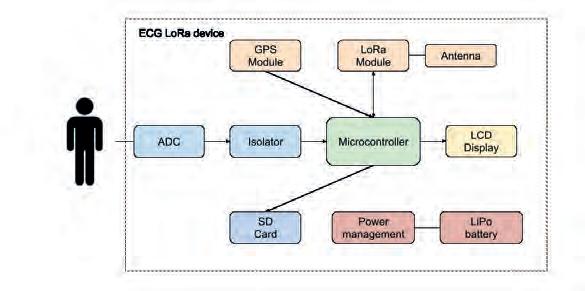

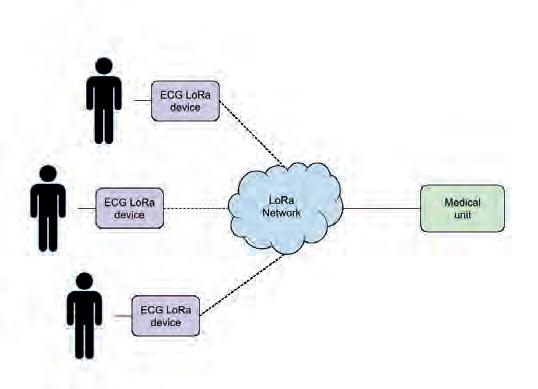

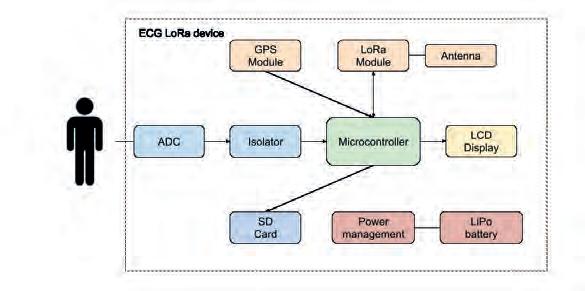

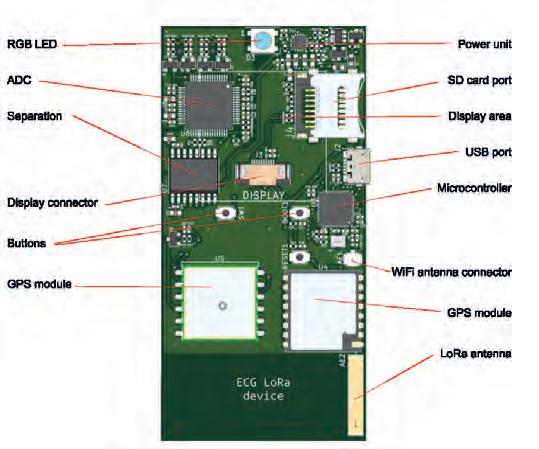

Remote monitoring systems in medicine are seen as a composite of three components: a device (which collects data on physiological parameters), a network-communication interface (which enables data transmission), and a remote analytical platform (which collects and integrates large amounts of data, often enriched with pre-processing and analysis algorithms) [17].

Measurements are most often realized through devices placed on/near the human body. The sensors used for this purpose, in a non-invasive and convenient way for the patient, can provide real-time continuous recording of relevant physiological parameters over a long period of time.

From a clinical and research point of view, ideally, ECG signal monitoring devices should combine the features of an ECG Holter device with the simultaneous ability to transmit and analyze data in real time. The new devices should allow the implementation of novel diagnostic algorithms to find patterns and correlate with standards accepted in the diagnosis and treatment of heart disease. This corresponds to classification and compression processes implemented within the device, as well as within the network and medical system. In this context, the use of artificial intelligence techniques works well. The literature indicates using different approaches to ECG signal classification using machine learning (ML) methods [4]. This division includes classical machine learning and deep learning methods. The most commonly mentioned involve the use of artificial neural networks [12, 13, 23], the Support Vector Machine [10], the Decision Tree [9], the K-Nearest-Neighbor [11], the Multi-Layer-Perceptron, the Deep Learning methods [1, 6, 14, 21, 22], hybrid methods [7, 18] and many others.

An important area from the perspective of the ECG signal processing and analysis is its application in everyday life solutions. This is possible due to the development and proliferation of devices for remote monitoring vital signs. Mobile solutions, i.e. small and unobtrusive devices, are increasingly used for long-

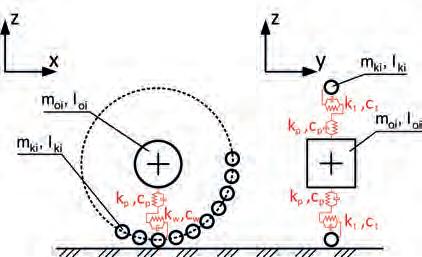

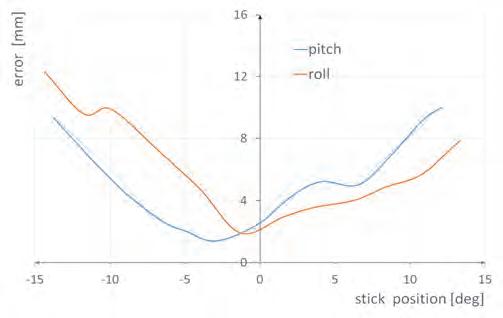

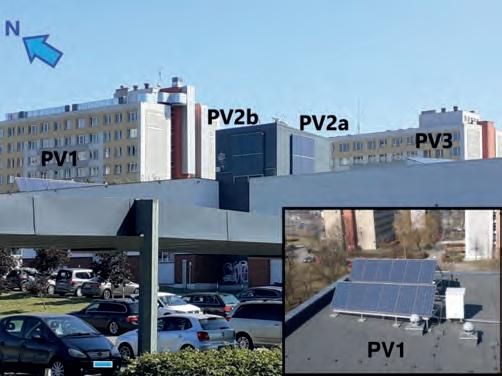

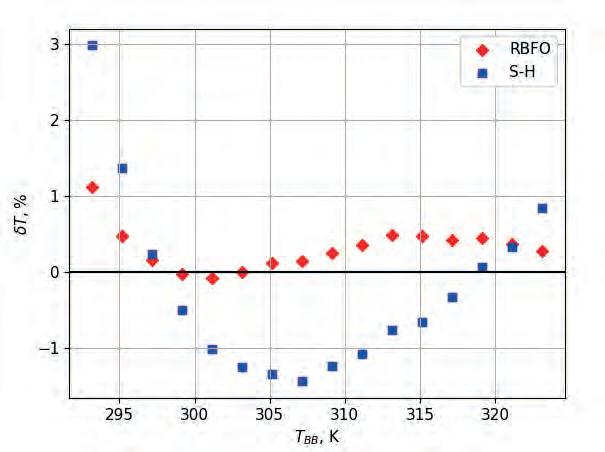

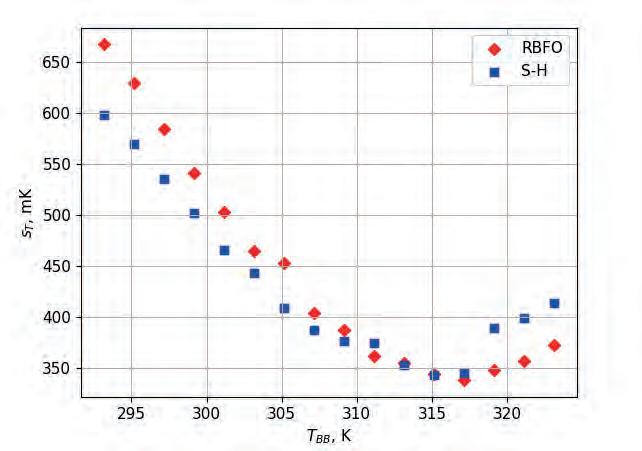

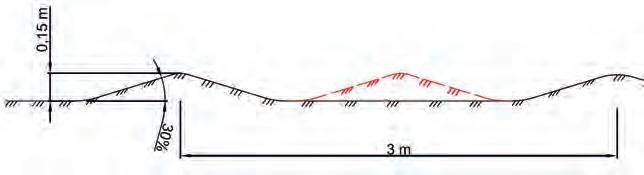

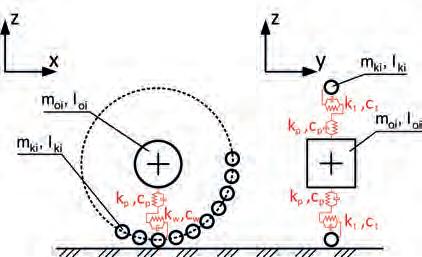

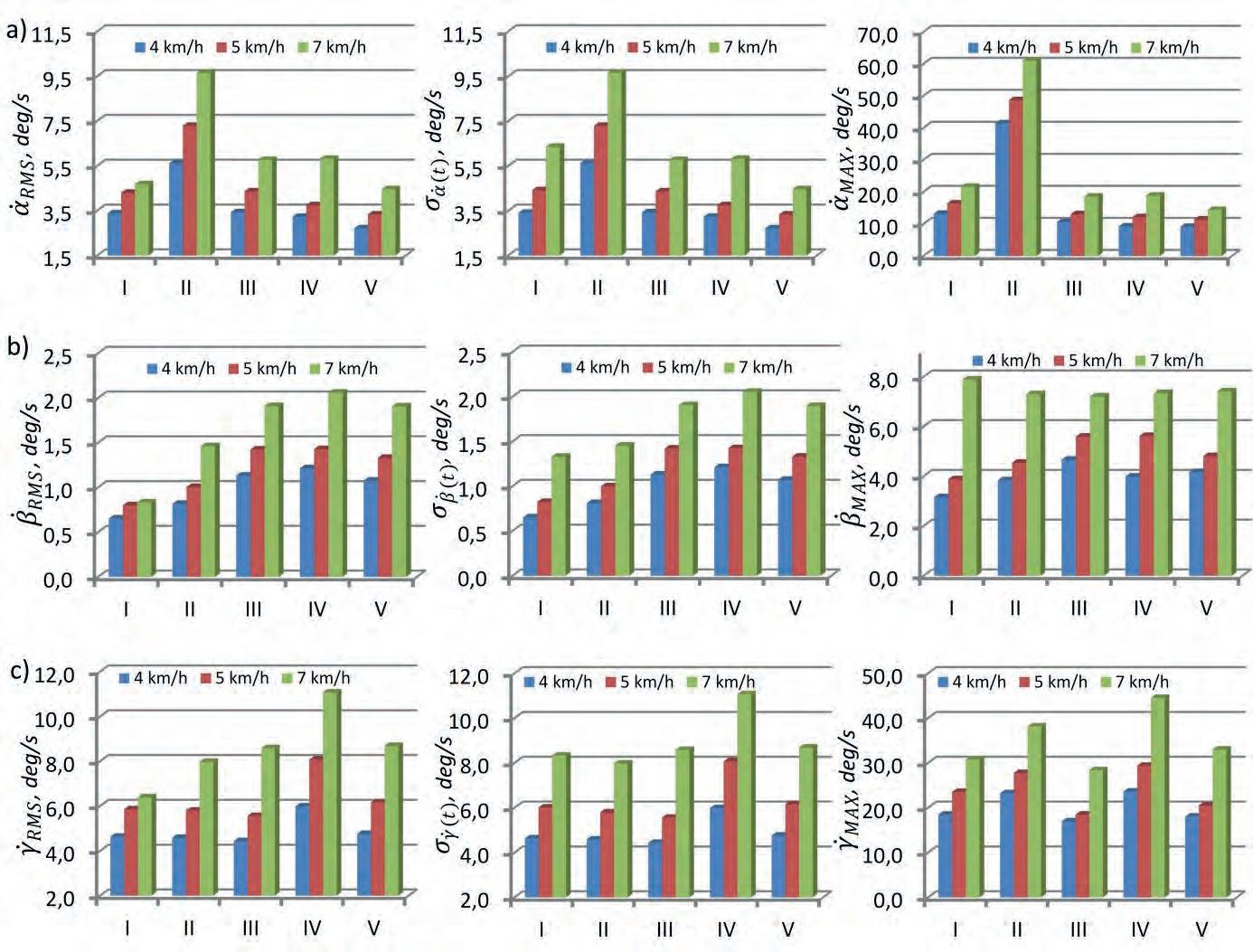

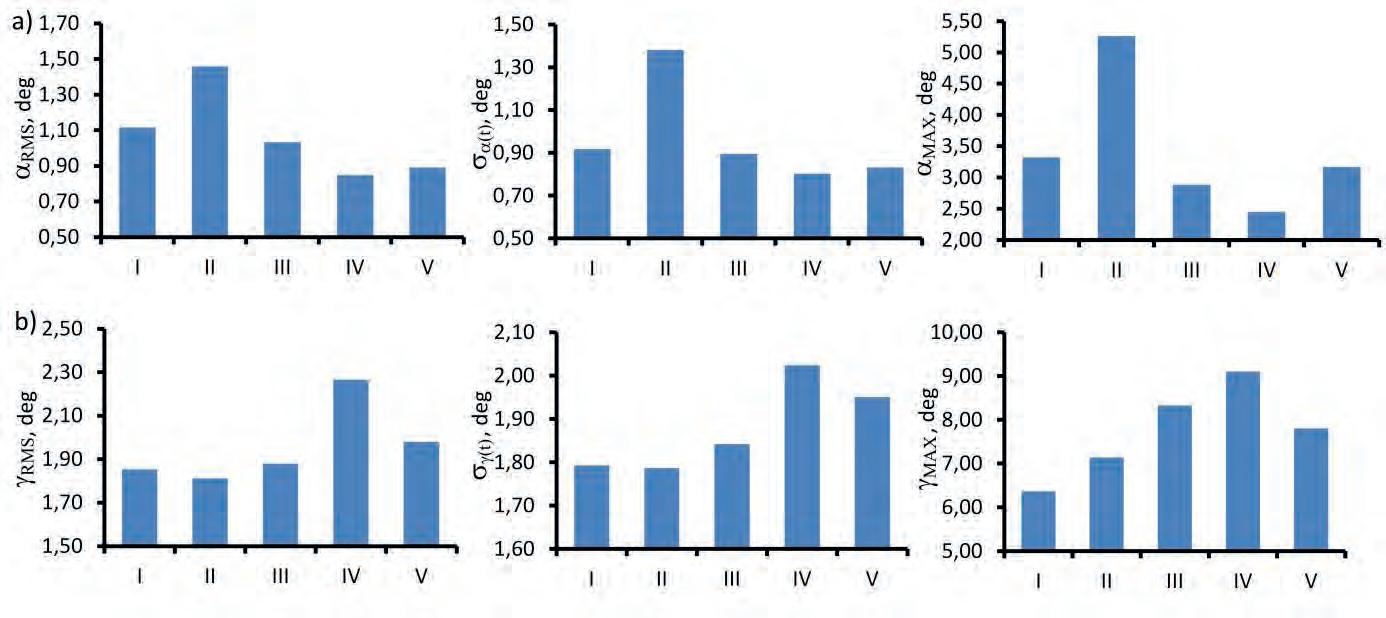

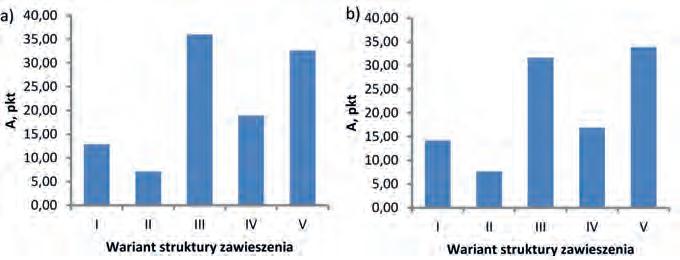

-term ECG monitoring and prevention of heart disease complications. Furthermore, increasingly associated with this context is the Internet of Things (IoT) paradigm, related to smart sensor networks and wireless communication protocols. From the perspective of the high incidence of heart disease, as well as the patients in underdeveloped countries, such solutions could provide automatic analysis of the ECG signal and, for example, classification of various heart diseases [5].