¿DEQUEHABLAMOS CUANDO HABLAMOS DE IA?

OPORTUNIDADES YRIESGOS

JuanAntonio Garde Roca

JuanAntonio Garde Roca

¿DE QUE HABLAMOS CUANDO HABLAMOS DE IA? SUS OPORTUNIDADES Y RIESGOS

.

• LA ÉTICA DEL USO DE LA INTELIGENCIA ARTIFICIAL, tiene en cuenta tanto la ética de los datos, la desplegada en el ámbito digital, así como la estrictamente algorítmica.

• Esta última adquiere una especial complejidad, cuando el sistema posee capacidades de aprendizaje y auto manejo autónomos, sin posibilidad de supervisión efectiva humana.

• La principal finalidad de esta ética es cerciorarse de que se está creando un sistema seguro no sólo bajo control de los seres humanos, sino también al servicio de los mismos y sus derechos, y que alcanza un aseguramiento adecuado de que el sistema esta alineado de forma sensible con los valores socialmente compartidos y las leyes.

• Hoy el debate sobre la ética de uso de la IA incluye tanto la justicia y veracidad de datos, como de la actividad digital, la minimización del sesgo algorítmico y el hecho de que los sistemas de IA estén alineados con los valores y preguntas morales fundamentales de los humanos que los utilizan, dependiendo de sus usos..

Ni la ciencia ni la técnica son neutrales: expresan una visión del mundo y, a la vez, son capaces de modificar esa visión. El mal no está en la ciencia y la técnica, no son neutrales, porque son el resultado de la dualidad del hombre y de la naturaleza y dependen complementariamente de sus usos y empleos.

Octavio Paz

Se ha vuelto terriblemente obvio que nuestra tecnología ha superado a nuestra humanidad. Albert Einstein

La inteligencia artificial puede ser lo mejor o lo peor que ha sucedido en la historia de la humanidad. Stephen Hawking

Estamos ante un gran cambio civilizatorio con base tecnológica. Este cambio contempla la digitalización, la revolución de los datos, la Inteligencia artificial, la biotecnología y otras grandes transformaciones que afectan a la integridad de nuestras vidas.

Parafraseando lo que Lichtemberg afirmara, que quien solo sabe de tecnología ni siquiera sabe de tecnología, ya que el complejo entramado social en que se inserta, con implicaciones económicas, sociales, medioambientales, éticas , legales políticas de poder, destacan hoy como cuestiones excepcionalmente relevantes.

Es un momento clave, para que como ciudadanos, tomemos conciencia. Los medios de comunicación y la experiencia cotidiana nos alertan a diario de algunos malos usos y la necesidad de respeto a nuestros derechos en la vida cotidiana. La aplicación ética de la IA, es tarea del conjunto de las instituciones, no sólo del sector público y las empresas. La Sociedad Civil no puede ser ajena.

Los seres humanos no somos productos tecnológicos, usamos la tecnología que nos aporta, pero no estamos limitados por ella, debemos tener nuestros propios fines y la libertad de elección, no dejar tan solo que ecuaciones no lineales, impredecibles e inexplicables sean las que determinen nuestro objetivo y destino.

Aunque ya en la actualidad, tecnológicamente estamos demostrando la viabilidad del interfaz siliciohumano, generando un amplísimo despliegue potencial de la IA y la neuro ciencia, también el control de las máquinas autónomas de aprendizaje profundo y en áreas muy amplias de la sociedad, desde las finanzas a la salud, la educación a la defensa y los negocios o la política, entre otras muchas.

Las interacciones sociales también se encuentran dominadas por nuevos medios y redes de comunicación, trufadas por la digitalización y la IA , que trascienden las fronteras existentes del espacio y del tiempo, y afectan al conjunto de la vida y los hábitos cotidianos de los humanos.

La Inteligencia Artificial (IA) comprende un conjunto de tecnologías de rápida evolución que pueden favorecer el progreso, si se acompaña de un refuerzo ético y se ofrecen garantías de cumplimiento de los derechos humanos, sociales y digitales, considerándola como bien público, asentándola con una sociedad civil activa.

No obstante, existe un peligro cierto de que la IA se transforme y lo está haciendo también, de ser un instrumento de investigación, conocimiento y progreso, a herramienta de manipulación, conducción y sesgo y no sólo respecto sectores vulnerables. También susceptible para usos delictivos.

El complejo entramado social en que se inserta hoy la tecnología con implicaciones sociales, medioambientales, éticas , legales, políticas, de poder y seguridad, destacan como cuestiones excepcionalmente relevantes. Y más en un mundo polarizado por bloques e intereses ,en el que es preciso promover el activismo social y no sólo absolutismo y automatismo tecnológico, sin valores.

Se necesita acompañar un uso adecuado de estas técnicas y más en concreto se deben adoptar precauciones para 1.Evitar que los algoritmos resultantes presenten sesgos graves. Para ello, es necesario garantizar que el conjunto de datos que se ha utilizado para entrenar un modelo esté equilibrado, que la selección de las variables sea correcta, que la técnica utilizada sea adecuada y que su resultado sea relevante.

2. Garantizar que se respeten los derechos de las personas sobre las que se adoptan las decisiones o recomendaciones, lo que tiene implicaciones sobre las variables que puedan usarse para analizar los datos de partida y en el momento de la toma de decisiones.

3. Considerar que los resultados sean auditables, por la existencia de mecanismos que permitan conocer cómo se han adoptado las decisiones o ser posible analizarlas mediante el cruce con evidencias adecuadas.

CONCEPTO DE ALGORITMO

Desde un punto de vista matemático, el termino debe su origen a Mohammed ben Musa-alKhwarizmi (Uzbekistan 780-840 de nuestra era) podemos definirlo como un conjunto ordenado y finito de operaciones que deben seguirse para resolver un problema o alcanzar un objetivo delimitado.

El algoritmo puede presentarse como un diagrama, flujo o árbol de decisión. Cuando se crea un programa, en esencia lo que se está creando es un conjunto de algoritmos.

Un programa de ordenador es un conjunto de órdenes que se dan a la máquina, escritas en un lenguaje concreto, para que realice una serie de operaciones determinadas con el fin de obtener un resultado.

Un ordenador “en crudo”, inicialmente no entiende el lenguaje humano. Esa es la razón por la que, para comunicarse con su equipo, el programador utiliza un lenguaje de programación.

ALGORITMOS REGULARES Y DE APRENDIZAJE AUTOMATICO

Los primeros algoritmos usados por los robots, y en la toma de decisiones en procesos organizativos, mostraban y muestran una tendencia causal netamente “ingenieril”. Son deterministas en su implantación para alcanzar un resultado, se basan en datos de probabilidad de contextos acotados y estables, se configuran a partir de técnicas de decisión de arriba-abajo, y promueven la traslación en la programación del lenguaje humano al de las máquinas, a partir de las bases de datos y la información existentes.

. Son por tanto, algoritmos de caja blanca, de carácter principalmente determinista, que inicialmente podemos denominar regulares y seguirán desarrollándose en el futuro.

También es cierto que precisan de seguridad- gestión de riesgos, supervisión humana, regulaciones adecuadas y auditorías. Pero lo señalado resulta todavía más imprescindible, por su evolución hacia otra realidad de acelerada innovación.

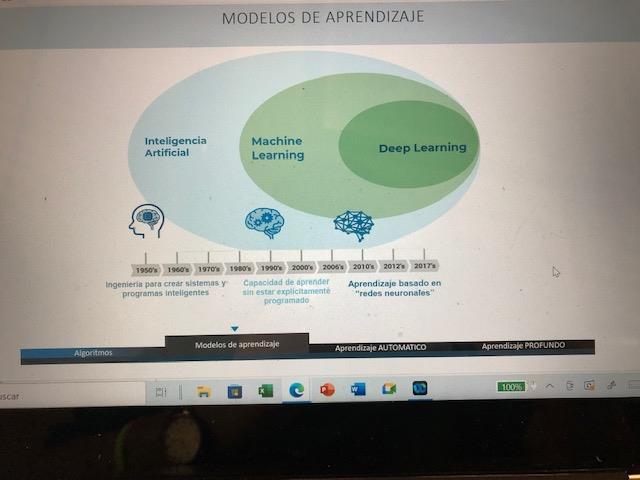

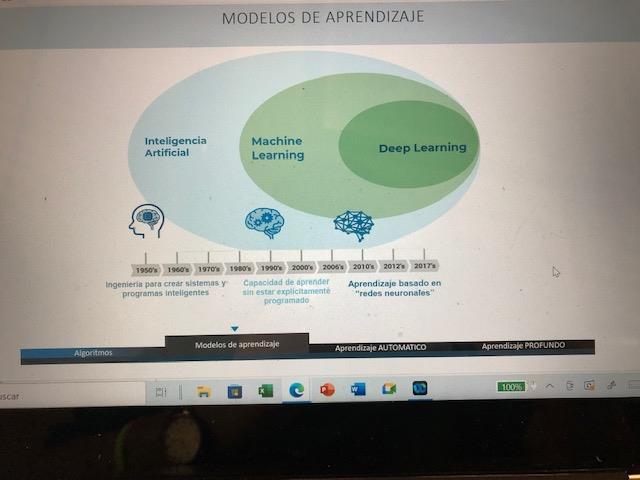

APRENDIZAJE AUTOMÁTICO O MACHINE LEARNING (1)

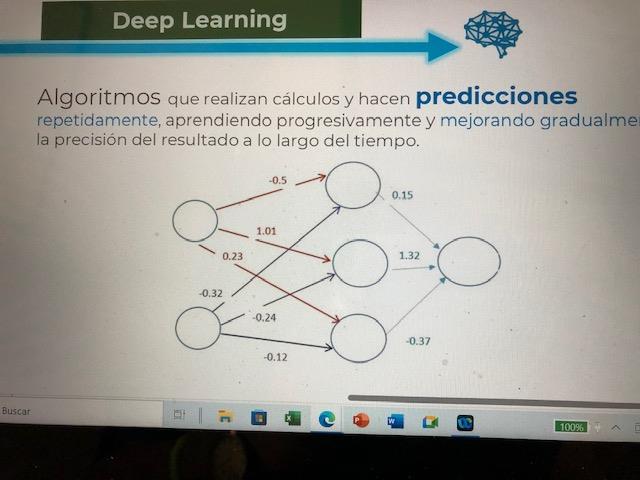

El algoritmo de aprendizaje automático o machine learning, usa técnicas de caja negra. Genera un proceso cualitativamente distinto que ya no es sólo predeterminado por el programa inicial.

Los nuevos programas pretenden, de forma dinámica, que el ordenador no solo se limite a reproducir con sus resultados el funcionamiento deseado, sino que aprenda también con la propia información contenida, superior en varios ordenes de magnitud a la que puede manipular el ser humano.

Analizar esos millones de datos y extraerles un sentido a través de un funcionamiento similar a nuestras redes neuronales, ampliadas en su programación, les permite barajar en segundos un número ingente de intenciones probabilísticas que no son perceptibles para nuestro cerebro. Se configuran en consecuencia a través de técnicas de decisión de abajo a arriba, incorporando también progresivamente un proceso desde el lenguaje del ordenador a lenguajes humanos de salida.

APRENDIZAJE AUTOMÁTICO O MACHINE LEARNING

(2)

En este caso, las cajas negras adquieren un carácter mucho más intenso y desconocido, con mayores capas ocultas, no solo para los expertos sino también para los propios programadores, que los utilizados con anterioridad en la IA.

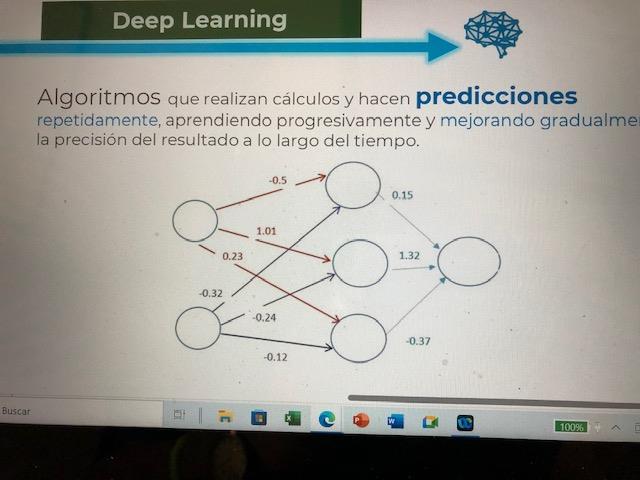

Los métodos se tornan más y más complejos, con este extraordinario despliegue fundamentado en el aprendizaje automático, y de un subcampo dentro éste que viene denominándose deep learning o aprendizaje profundo.

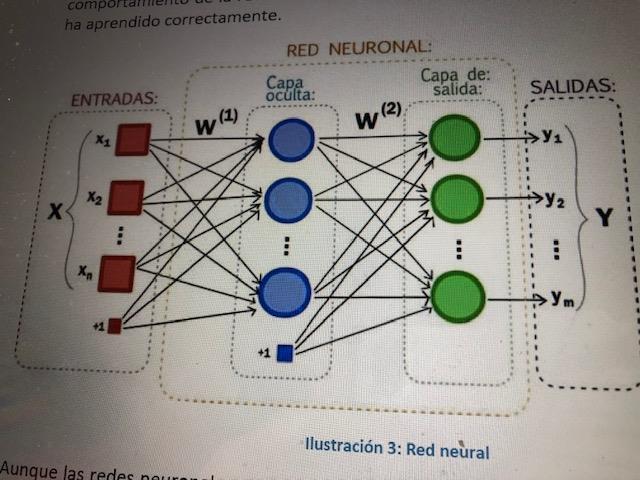

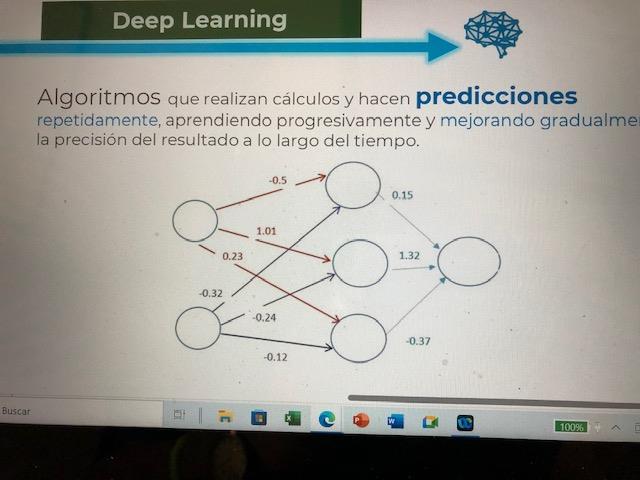

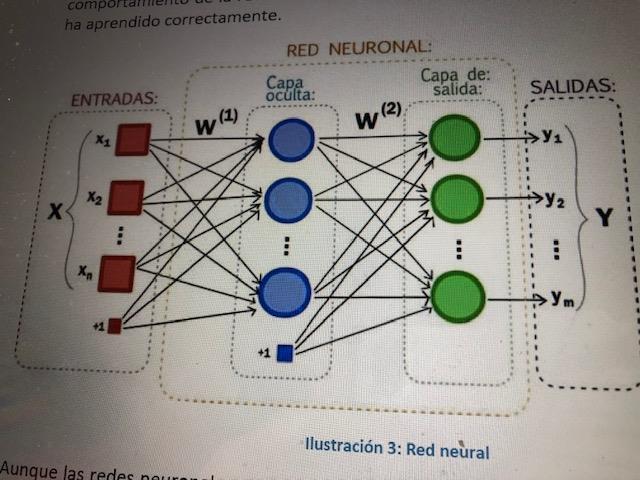

En la programación regular, el algoritmo convierte la entrada en resultados, a través de reglas lógicas y matemáticas. En el aprendizaje automático, se parte de unos casos o valores de entrada, a los que se dota de un cierto peso de importancia en cada caso. Sirven para que la red neuronal juegue contra sí misma, usando para ello ecuaciones agrupadas en múltiples capas, sin conocimiento de las reglas lógicas y matemáticas en el que se produce el aprendizaje que precisa para obtener las salidas.

APRENDIZAJE AUTOMÁTICO O MACHINE LEARNING (3)

. Las neuronas de cada capa se conectan con las neuronas de la capa siguiente, en ciertos casos ocultas, y así sucesivamente hasta una capa de salida.

El aprendizaje algoritmos se efectúa, a partir de procesos de prueba- error. investigan en un instante las decisiones, sin que resulte siempre viable una supervisión humana. Toman decisiones vitales que pueden plantear, ya en la actualidad, dilemas en materias transcendentes, no sólo de la vida cotidiana, sino que influyen así mismo de forma creciente y decisiva en nuestro modelo cultural y civilizatorio.

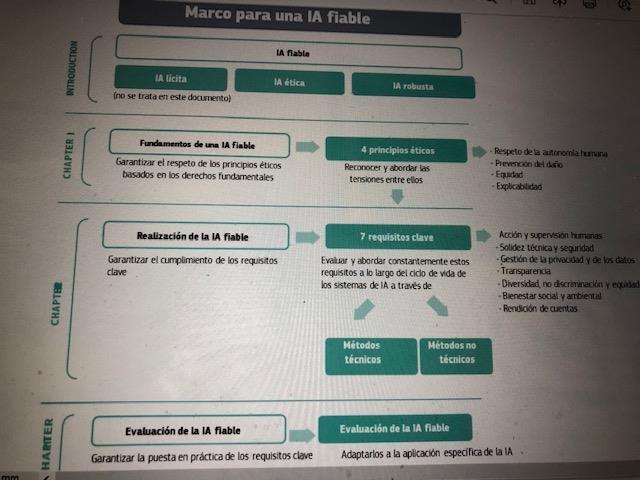

MARCOPARAUNAIAFIABLE YETICA

REFERENCIAS METODOLÓGICAS

La referencia Simbolista. Como los antiguos acadios y los fenicios trabajaron con símbolos. Planteada una pregunta, la convertían en símbolos y luego operaban con expresiones, como hacen los algebristas. Su forma de avanzar era la deducción inversa. Se parte de un pequeño conocimiento y con pequeños pasos se avanza hacia el origen acumulando conocimiento.

La Conexionista. Intentaron reproducir como funcional el cerebro humano aplicando el equivalente a una neurona humana presentada en forma de una ecuación. Sustituían las conexiones del cerebro por las conexiones de las ecuaciones y su enfoque fue el de ingeniería inversa. (Convutional Neural Networks CNN)

• La evolucionista de orientación biologista y cibernética. Siguiendo la idea de Darwin pensaron en sistemas que aprendiesen por selección. Un ejemplo actual es la llamada programación genética. El sistema se auto inventa valores para las variables (mutaciones) y si acierta más que antes, acepta el valor como provisionalmente bueno repitiendo muchas veces el proceso.

• La Bayesiana con raíces matemáticas y de probabilidad. Ven el mundo lleno de incertidumbre que se puede reducir con sucesivas observaciones y experimentos. Creadores del concepto de “redes bayesianas”. Un clasificador Naive (ingenuo) Bayes asume la independencia entre variables predictoras, la presencia de una cierta característica en un conjunto de datos no está en absoluto relacionada con la presencia de cualquier otra característica.

• La analogista con vocación de agrimensores y topógrafos. Como los escolásticos medievales, pensaron por analogía desarrollar algoritmos para medir con precisión si dos cosas son semejantes o no. Una de sus estrategias es KNN.( clasificador de aprendizaje supervisado “de vecinos o proximidad”)

RIESGOS Y SESGOS

El uso de los algoritmos de forma generalizada, con escasa regulación y supervisión, incorporan riesgos, que por su opacidad afectan a la privacidad y los derechos, y configura nuevos dilemas de naturaleza ética y social que no deben ser desdeñados.

La IA atañe hoy, no solo a los servicios y productos digitales, también al modo de vida del conjunto de los ciudadanos, repercute en la toma de decisiones, desplazando en ocasiones los principios sociales y normativos del Estado de Derecho, hacia usos y comportamientos sociales no suficientemente fundados.

ANALIZAR SUS EFECTOS

Es preciso conocer los efectos económicos, jurídicos y sociales que ciertos algoritmos producen, mediante análisis de impacto y evaluaciones independientes, así como promover la responsabilidad ética de las empresas e integrar el concepto de buen gobierno y las herramientas de rendición de cuentas, en el uso de los algoritmos que promueve el sector público, tras algunas experiencias inadecuadas recientes.

La incorporación de la responsabilidad humana resulta clave en el proceso y en la interacción con las máquinas, junto con los códigos y protocolos de ética y el cumplimiento estricto de la prohibición de su uso para determinadas prácticas.

DIFICIL TRANSPARENCIA DE ALGUNOS ALGORITMOS

La insuficiente transparencia pueda propiciar un riesgo social excesivo dado el grado de opacidad y complejidad técnica que conllevan. Siendo fundamental que sus rutas transiten por líneas de desarrollo y sostenibilidad humana, a través de una gobernanza eficiente, que dificulte la manipulación y opacidad de un uso indebido.

La consciencia de los retos y la complejidad que la sociedad en su conjunto debe afrontar con su uso es enorme. Las implicaciones éticas de la IA, la defensa de un uso humano de los algoritmos, el despliegue de estándares de transparencia algorítmica, las oportunidades y riesgos de la IA. son tareas del conjunto de los actores sociales y no sólo del sector público y a ello la Sociedad Civil no puede ser ajena.

DIFICULTAD DEL ACCESO AL CODIGO FUENTE

La transparencia algorítmica no podrá ser acotada de forma estricta sino por la jurisprudencia, y también estará sujeta a ciertas “instrucciones de uso” que pueden presentar complejidades notables. Tomemos como ejemplo los efectos jurídicos que en cada caso pueda adquirir el conocimiento, bien sea del “código fuente” o tan sólo de ciertas instrucciones acerca de su funcionamiento.

Es importante no perder como referencia que las implicaciones que supone la revolución tecnológica, la economía del conocimiento y de los datos, así como la digitalización y el uso actual de los algoritmos por el “aprendizaje automático”, desborda en múltiples aspectos el marco y la arquitectura jurídica y el propio diseño del modelo de estado de derecho constituido.

DIFICULTADES DE SU MARCO REGULATORIO

El marco normativo por establecer permitirá dar respuesta a algunas de las nuevas necesidades, pero no abordar en plenitud la gran batalla por la regulación, que debería poder articularse a nivel internacional.

Lo verdaderamente cierto es que los sistemas de inteligencia artificial desafían nuestra lógica jurídica y la velocidad institucional de la respuesta necesaria. Agudizada por un entorno geo estratégico polarizado por bloques.

Se incide en la privacidad de los datos y su seguridad, así como en señalar a quien corresponde la responsabilidad jurídica de los resultados y efectos de las decisiones automáticas y también, en ofrecer una respuesta adecuada a la necesidad de los nuevos derechos digitales y/ o adaptación de los derechos fundamentales a la era digital...

•

EXIGENCIA DE PRINCIPIOS Y DERECHOS DIGITALES

Si se parte del hecho que admiten muchos tecnólogos, que no existe una transparencia técnica en los resultados algorítmicos de ciertos procesos a partir del uso del aprendizaje automático, ello precisa mas si cabe, unos mecanismos de gobernanza, control interno, auditoría y rendición de cuentas acordes al respecto y el máximo cuidado en la aplicación de los principios y derechos digitales de los ciudadanos.

Aunque la transparencia algorítmica propugna que las decisiones deben partir de evidencias, ser visibles, reconocibles, auditables y explicables a las personas que utilizan, regulan y son afectadas por los sistemas que emplean estos algoritmos, también resulta contrastable que no todos los algoritmos y sus contextos de aplicación, tienen los mismos efectos jurídicos y determinan riesgos similares, ni la regulación las debe someter al mismo tipo de cautelas para su uso.

LOS SESGOS EN LOS ALGORITMOS

Los algoritmos, al igual que las personas, podemos generar sesgos. Los primeros a partir de los datos y la información que utilizamos los humanos al entrenarlos.

Estos sesgos pueden provenir de orígenes muy distintos: de la propia construcción de la herramienta y su objeto, de una incorrecta selección de la información que lo alimenta, de la falta de calidad de los datos que utiliza y, en ocasiones, puede ser relativamente fácil corregirlos con técnicas similares a las que vienen utilizándose en evaluación.

Los sesgos de información se producen también por deficiencias o disparidades de los datos, dada la dificultad que implica efectuar comparaciones homogéneas y las posibles confusiones en la construcción y diseño de las bases de datos.

USO DE LA LA INTELIGENCIA ARTIFICIAL

Específicamente, la Administración Pública debe velar y garantizar el interés público con sometimiento pleno a la ley y al derecho. Se le requiere por tanto, no sólo en su papel regulador, también en sus acciones directas y en el uso algorítmico, un plus de rigor .

El alcance de la transparencia algorítmica no podrá ser acotada de forma estricta sino por la jurisprudencia, y puede estar sujeta a ciertas “instrucciones de uso”. Tomemos como ejemplo los efectos jurídicos que en cada caso pueda adquirir el conocimiento, bien sea del “código fuente” o tan sólo de ciertas instrucciones acerca de su funcionamiento. Es importante no perder como referencia que las implicaciones que supone la revolución tecnológica, la economía del conocimiento y de los datos, así como la digitalización y el uso actual de los algoritmos por el “aprendizaje automático”, desborda el marco y la arquitectura jurídica actúal.

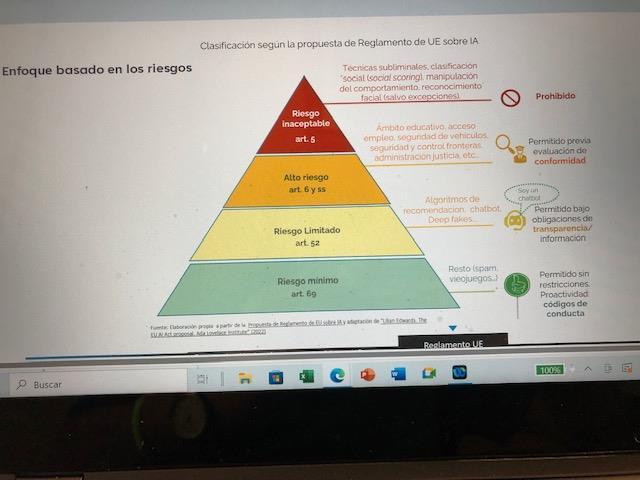

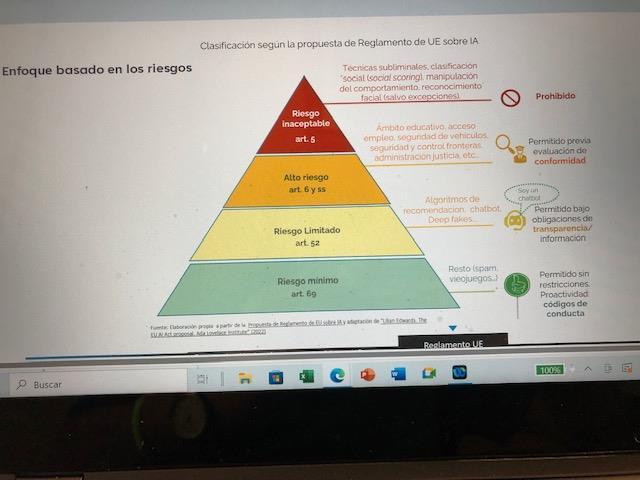

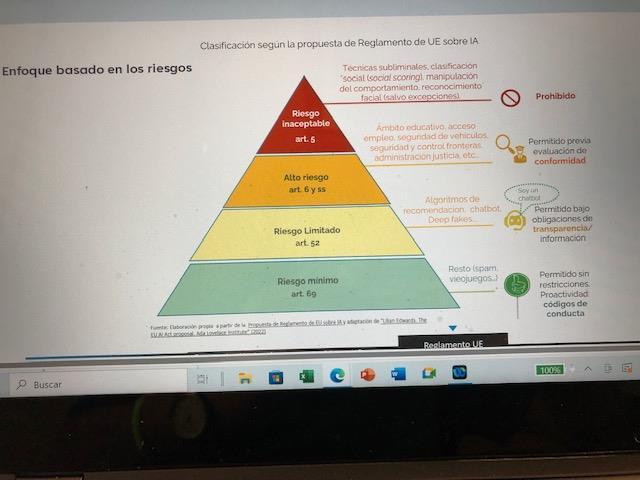

El 13 de marzo de 2024, el Parlamento Europeo tras casi tres años de debate legislativo, ha culminado la tramitación del texto de Reglamento de IA (RIA). En el semestre final de la Presidencia Española y mas tarde Belga, el texto definitivo finalmente ha sido alcanzado, concluyendo la lista de categorías de IA “de alto riesgo” y sus requisitos de control, la normativa mas definitiva respecto de la identificación biométrica en tiempo real y algunos detalles adicionales de la aplicación y cumplimiento de la futura norma.

Este proyecto normativo supondrá la primera regulación jurídica de la IA de carácter global que todavía tardará tres años en poder entrar plenamente en vigor en los países de la UE.

CINCOS PRINCIPIOS PARA UN USO DE UNA IA CONFIABLE PARA LOS CIUDADANOS

• -PRIMERO:

• • LAS PERSONASYSUS DERECHOS,PRINCIPAL REFERENCIADEL BUENGOBIERNO DE LA IA. JUNTOCON LAESTRATEGIAY LA ROBUSTEZTÉCNICADE SU EMPLEO

• • Las personas deben constituir según la Unión Europea,el núcleo central de la transformacióndigital. La tecnología debe servir y beneficiar a todas las personas respetandoplenamente sus derechosfundamentales.Los valores de la UE y los derechos de los ciudadanos reconocidos,se tienen que respetar tanto en línea como fuera de línea.

• ( ReglamentoUE………

•

• Aspiramosa promoveruna vía europeapara la transformación digital basada en los valores europeos y los derechos fundamentalesde la UE, que sitúe a las personas en el centro,reafirme los derechos humanos universales y beneficie a todas las personas,empresasy a la sociedad en su conjunto

• (Declaraciónsobrelos Derechos y Principios Digitales para la Década Digital)

• “Todo interesado tendrá derecho a no ser objeto de una decisión basada únicamente en el tratamiento automatizado, incluida la elaboración de perfiles, que produzca efectos jurídicos en él o le afecte significativamente de modo similar”, a menos que la decisión sea parte de un contrato entre las partes, esté autorizadopor ley o exista consentimientoexplícito.

• ( Artículo 22 Reglamento de Protección de Datos)

LAS PERSONAS YSUS DERECHOS,

PRINCIPAL REFERENCIA DEL

BUEN GOBIERNO DELAIA.

Las personas deben constituir según la Unión Europea, el núcleo central de la transformación digital. La tecnología debe servir y beneficiar a todas las personas respetando plenamente sus derechos fundamentales. Los valores de la UE y los derechos de los ciudadanos reconocidos, se tienen que respetar tanto en línea como fuera de línea.

Aspiramos a promover una vía europea para la transformación digital basada en los valores europeos y los derechos fundamentales de la UE, que sitúe a las personas en el centro, reafirme los derechos humanos universales y beneficie a todas las personas, empresas y a la sociedad en su conjunto

Todo interesado tendrá derecho a no ser objeto de una decisión basada únicamente en el tratamiento automatizado, incluida la elaboración de perfiles, que produzca efectos jurídicos en él o le afecte significativamente de modo similar”, a menos que la decisión sea parte de un contrato entre las partes, esté autorizado por ley o exista consentimiento explícito.

TRANSPARENCIA TRAZABILIDAD E INTERPRETABILIDAD

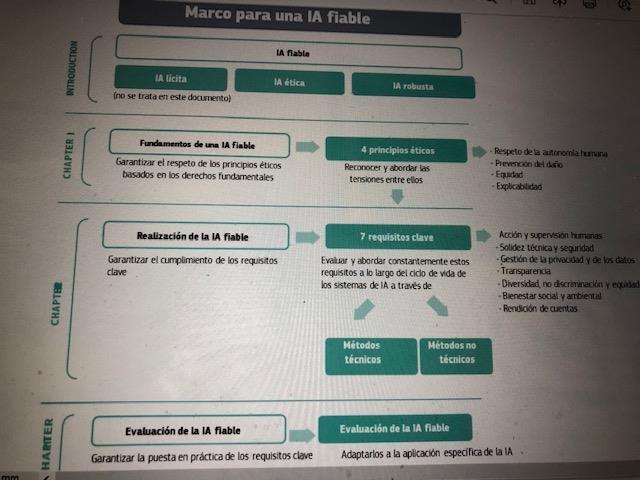

Un componente crucial para conseguir una IA fiable es la transparencia, que engloba tres elementos: 1) trazabilidad, 2) “explicabilidad” (interpretabilidad) y3) comunicación abierta sobre las limitaciones del sistema de IA.

A ellas debe sumarse el factor de AUDITABILIDAD O EVALUABILIDAD y considerar que los resultados sean auditables, por la existencia de mecanismos que permitan conocer cómo se han adoptado las decisiones o ser posible analizarla mediante el cruce con evidencias adecuadas.

• La asociación ALGOVERIT, “La verdad de los algoritmos”, es una asociación civil cuyo objeto es promover el conocimiento de la Inteligencia Artificial y sus usos, así como el de los códigos base y los datos que utilizan sus algoritmos, desde una perspectiva ética y de ciudadanía democrática. WEB https://algoverit.org

info.algoverit@gmail.com

•

•

La Asociación “ALGOVERIT”, pretende aportar con su presencia profesional, técnica y cívica, a hacer avanzar sus objetivos, consciente de los retos y la complejidad que la sociedad en su conjunto debe afrontar y la necesidad del respeto a los derechos digitales y ciudadanos.

Siguiendo la experiencia de asociaciones de otros países y de los núcleos ya existentes en el nuestro, inspirados en la perspectiva estratégica y regulatoria europea y la propuesta de Reglamento Europeo sobre IA, junto con la Declaración de la Carta de Derechos Digitales aprobados por el Consejo, la Comisión y el Parlamento Europeo.

LLa Asoci ación “ALG OVER IT”, prete nde aport ar, con su”, prete nde aport ar, con su prese ncia profe siona

- Compartir la confianza en los resultados positivos que el buen uso de la IA puede aportar al bienestar económico y social, tanto en el sector público como en el privado, en ámbitos como el medio ambiente, el cambio climático, la salud, la investigación, la educación, el empleo y para el progreso general de la humanidad.

- Asumir la complejidad técnica y también económica, política e institucional que el despliegue de la IA y su regulación suponen, así como los sesgos y dilemas de naturaleza ética y social que generan.

- Considerar que la IA atañe hoy, no solo a los servicios y productos digitales, sino al modo de vida del conjunto de los ciudadanos, al proponerse para la resolución de todo tipo de decisiones, desplazando otros criterios, e incidir ya en la totalidad de los procesos económicos y sociales.

- Afirmar el riesgo, que su práctica no regulada puede suponer, de existir un uso inadecuado. Así como los peligros de creación de nuevas brechas sociales y digitales, lo que podría aconsejar considerar la IA asimilable, al menos en parte, a un bien público.

PARA AUDITAR

-Es necesario estudiar el sistema algorítmico en su contexto y en el de la organización a la que sirven. De esa forma, será posible considerar el perfil inicial de los riesgos a los que pueden enfrentarse sus resultados.

-Dicha información resulta fundamental para la elaboración del plan de auditoría. Adicionalmente dicho plan deberá seleccionar el paquete de herramientas y pruebas de análisis precisos para su despliegue.

-En ese despliegue se pueden integrar herramientas especificas propias del funcionamiento de los algoritmos y la tecnología de la IA, también procedentes de la experiencia aprendida de los distintos métodos testing de software, empleados en los últimos años, así como de la amplia y mejor experiencia en técnicas de auditoría y también, los numerosos trabajos y guías existentes de evaluación.

¿PUEDEN AUDITARSE LOS ALGORITMOS?

Existe la posibilidad de una gran variedad de tipos de auditorías y también de objetos de evaluación en relación con los algoritmos.

La complejidad que puede alcanzar esta técnica, así como su innovación constante, llevan a preguntarse por la viabilidad de efectuar procesos integrales de análisis.

También a considerar positivamente el uso de la Inteligencia Artificial (I.A.) como herramienta idónea para una auditoria viable, a partir del uso de algoritmos de aprendizaje automático o “machine learning”.

Todo ello, no anula la posibilidad de que los algoritmos puedan y necesiten ser auditados con rigor, sino que refuerza la necesidad de evaluación y transparencia, siempre considerando con realismo lo que puede y no puede auditarse y el cómo se audita.

En consecuencia, contestando a la pregunta del inicio ¿ Es posible auditar los algoritmos de forma rigurosa?

Más allá de la complejidad y dificultades objetivas se puede y se debe evaluar rigurosamente los algoritmos, dada la existencia de una gran variedad de tipos de auditorías y también de objetos de evaluación y siempre que se considere con realismo lo que puede y no puede auditarse y el cómo se audita.

MUCHAS GRACIAS

JUAN ANTONIO GARDE ROCA

LAINTELIGENCIA ARTIFICIAL YELUSODE LOS ALGORITMOS

JuanAntonio Garde Roca

JuanAntonio Garde Roca

ESTRUCTURA BASICA CON CAPAS OCULTAS

AUDITORIA ALGORITMICA

Los costes de una auditoría algorítmica de caja negra además de ser compleja puede ser muy elevados y los mercados y los inversores, en ocasiones, resultan poco propicios a hacer transparentes y públicos sus limitaciones o vulnerabilidades.

Pero la auditoría y la evaluación pueden y deben tener objetos que pueden ser más precisos y acotados, centrarse en algunos procesos críticos singulares. Se debe también partir del conocimiento de lo que puede esperarse de la auditoría de un sistema de I.A. y qué no es posible esperar. Es preciso propiciar el análisis de la composición y usos de los algoritmos para generar mejoras de su eficiencia que eviten riesgos y sesgos detectables, que sean asumibles con el acervo técnico e instrumental existente y con costes asequibles. La transparencia lo exige también, cuando el algoritmo se aplica sobre acciones de los seres humanos, ya que es preciso adoptar una perspectiva ética, y eso implica la existencia de valores y su explicitación.

CONTROL INTERNO Y EXTERNO

La existencia de regulaciones, modelos y prácticas corporativas regladas de control interno y externo, permiten incorporar la auditoria algorítmica al entorno corporativo de las organizaciones e integrar en sus procesos, actividades y negocios el análisis de los usos de la I.A., que no pueden ser ajenos al modelo de gobierno corporativo y su despliegue.

Es posible considerar el uso adecuado de la propia IA para evaluar otros algoritmos mediante programas específicos de auditoría, lo que constituye un camino de gran recorrido en el futuro.

COMO AUDITAR ALGORITMOS

Podemos diferenciar entre varios tipos de auditorías:

a) la de los datos con que se entrena un algoritmo.

b) la del propósito y finalidad del algoritmo.

c) la del algoritmo.

d) la de los resultados.

No siempre es posible conocer el “código fuente” y solo en ocasiones es útil poder interpretarlo, al menos en una primera fase, pero si es posible, considerando su objeto y la finalidad para la que sirve, discernir su calidad y abordar su análisis.

CÓMOANALIZAR ELSISTEMAALGORÍTMICO

• .

Hay que estudiar el sistema algorítmico en su contexto y en el de la organización a la que sirven, su tipología y conocer el objetivo y la finalidad que pretende, recabando información de los actores e intereses implicados en su diseño, financiación e implementación.

De esa forma, será posible considerar el perfil inicial de los principales riesgos a los que puede enfrentarse. Dicha información resulta fundamental para la elaboración de un plan de auditoría para el algoritmo, que no puede desvincularse de la gobernanza de la organización que lo integra, así como de los modelos de control interno y riesgos establecidos en su contexto.

Se precisará elegir el paquete de herramientas y pruebas de análisis a utilizar, que puede integrar especificidades propias del funcionamiento de los algoritmos y la tecnología de la IA, de la experiencia de los métodos testing de software empleados, así como de la larga experiencia en técnicas de auditoría y evaluación.

CALIDAD DE LAINFORMACIÓN YBASES DE DATOS (1)

El conocimiento de las bases de datos utilizados y la información empleada en el desarrollo, entrenamiento y evaluación del sistema algorítmico, es un apartado fundamental.

Tanto la validez de las muestras, como los grupos relevantes elegidos en las bases de datos, así como las llamadas variables proxi, que son aquellas que no parecen influir de forma aislada, pero que mediante inferencias o correlaciones con otras variables pueden repercutir en el desarrollo de sesgos y en las propias decisiones algorítmicas, deben ser analizados.

Se puede generar un tratamiento desigual de los distintos colectivos, bien por la falta de calidad de los datos elegidos como por el hecho de que sus usos en el entrenamiento algorítmico vengan ya sesgados en las bases de datos, o debido a que su aplicación en el algoritmo produzca ese efecto .

CALIDAD DE LAINFORMACIÓN YBASES DE DATOS (2)

Para verificar la necesaria representatividad de las variables elegidas, y que estas se contemplan de forma adecuada, se viene utilizando todo un conjunto de tablas de naturaleza estadística referidas entre otros aspectos a materias como la edad, el género, la raza, y una distribución por grupos específicos de los colectivos incorporados

La calidad, fiabilidad y validación del origen de estos datos es en consecuencia esencial para la propia evaluación del algoritmo. Junto a ello, el análisis del código fuente, cuando sea viable su conocimiento e interpretación, fundamentalmente a través del uso de nuevas pruebas de entrada y salida y la experimentación con nuevas órdenes de trabajo.

A través de ratios de impacto, tasas de falsos positivos y falsos negativos y otras pruebas, estas aplicaciones métricas, conjuntadas con los testing de software, permitirán un análisis de rigor acerca de la confianza que ofrece el algoritmo.

MÉTODOS DETESTING DE SOFTWARE (1)

Como referencias auditoras de algoritmos pueden utilizarse también modelos más tradicionales de testing de software. Especificamente el llamado ENFOQUE FUNCIONAL o de CAJA NEGRA, pretende considerar los riesgos potenciales de un modelo, abstrayéndose del código fuente, las rutas de tipo interno existente y la información que desconoce. Utilizando pruebas del software, se posibilita validar o no los requisitos funcionales del propio sistema. Su finalidad es descubrir en qué instancias el resultado no se comporta o se atiene a lo que se espera de él, o a sus pretendidas especificaciones.

No se preocupa de lo que el software puede estar generando con sus mecanismos de aprendizaje, lo hace enfocándose en su entrada y salida y, tomando como base las especificaciones, selecciona métricas y resultados, a través del comportamiento del sistema y su comunicación. Es ciertamente habitual su utilización dentro de los propios sistemas o en aquellos módulos que van a actuar como interfaz con los usuarios

METODOS DE TESTING DE SOFTWARE (2)

En su plan de trabajo, se suele primero examinar los requisitos y especificaciones del sistema. Después, se seleccionan pruebas de entradas válidas (caso de prueba positivo), para verificar si las procesa correctamente. También se seleccionan entradas no válidas (caso de prueba negativo), para verificar que el sistema puede detectarlas. A través del medidor de salida esperada, determina las expectativas de todas esas entradas. Finalmente, se ejecutan los casos de prueba y, con un probador de software, se comparan los resultados reales y esperados. Los defectos, si los hay, se corrigen y se vuelven a probar.

En los algoritmos de caja negra no es posible expresar de manera explícita las reglas utilizadas para las decisiones que genera. Se trata por tanto de patrones no explicitados. La prueba se limita a analizar los datos que componen las funciones de entradas y salidas, con la pretensión de generar cierta amplitud de cobertura y valorar la eficiencia respecto del resultado esperado, minimizando el número de casos de análisis sobre los que puede actuar.

Pretenden alcanzar evidencias acerca de la presencia de aciertos o errores asociados tan solo, a la prueba efectuada que es la que resulta disponible. Tiene un carácter esencialmente funcional, detectando fallos en las respuestas cuando la operación depende de respuestas interdependientes o provenientes de otros módulos de los sistemas.

MÉTODOS DE TESTING DE SOFWARD (3)

EN EL MÉTODO DE PRUEBAS ESTRUCTURALES

O DE CAJA BLANCA, se analiza la estructura interna del algoritmo y el código fuente. Se vincula al análisis de los valores de entrada, para examinar flujos y detalles procedimentales en la ejecución del programa, para cerciorarse de que se desenvuelven con los valores de salida adecuados. Pueden desplegarse por unidades, entre flujos, y en la integración de subsistemas.

Se pueden vincular también a requerimientos, que no se refieren directamente a las funciones específicas que incorpora el sistema sino a propiedades emergentes de éste como la fiabilidad, la respuesta en el tiempo, la capacidad de almacenamiento, y la interoperabilidad con otros sistemas de software o hardware. Así mismo, a factores externos como los reglamentos de seguridad y las políticas de privacidad y también estar enmarcados en aspectos como la escalabilidad del sistema, el uso óptimo de las conexiones a las bases de datos, y las posibles necesidades de crecimiento y actualización.

MÉTODOS DETESTING DESOFWARD (4)

El mantenimiento implica estructurar el código fuente de una manera consistente y predecible, e implementar las interfaces asegurando una fácil implementación en el sistema, generalmente con modelos estandarizados.

Los requerimientos no funcionales son también básicos dentro de un desarrollo del software. Al ser requerimientos implícitos internos, se perciben menos por los usuarios, pero resultan muy importantes para las pruebas porque sin estos no se puede asegurar la funcionalidad y un aceptable nivel de calidad del sistema.

Otras principales pruebas y técnicas de uso se vinculan al flujo de control, al flujo de datos, a pruebas de bifurcación, pruebas de caminos básicos, y alcanzan a las pruebas de integración. Pueden también efectuarse con particiones en clases de equivalencia y el análisis de casos límites y fronteras.

El PAPELDE LAS TÉCNICAS CUALITATIVAS (1)

Las técnicas cualitativas pueden tener también un papel importante en el proceso de la auditoría algorítmica. La auditoría y la evaluación nos muestran herramientas y usos habituales que pueden incorporarse fácilmente al análisis algorítmico. Los usuarios y destinatarios muy diversos de los algoritmos, al incorporar diversos sectores: empresas, sector público, técnicos, tecnólogos, y diversos grupos de ciudadanos, integran una amplia gama de intereses.

También los medios de comunicación, las universidades y centros de investigación, las asociaciones ciudadanas y las propias asociaciones de auditores son actores interesados en el uso y la mejora de los algoritmos, tanto en su vertiente interna más técnica como en su faceta social, regulatoria y ética.

El análisis cruzado de información entre los distintos actores puede ser una potente herramienta de auditoria en las diversas vertientes. Puede reforzar el papel de arbitraje o integrador que algunas escuelas de evaluación proponen para las políticas públicas y, en este caso, puede servir también para validar la realidad compleja del despliegue técnico que integra.

ElPAPELDE LAS TÉCNICAS CUALITATIVAS (2)

La triangulación de focos de análisis y pruebas, también de equipos plurales de auditores, parece ser ciertamente recomendable.

La revisión de la creciente literatura académica en este campo, y los observatorios algorítmicos y repositorios de experiencias, están llamados a cumplir un papel creciente en la auditoría algorítmica en el futuro.

La consulta a expertos y validadores también se abre camino para reforzar sendas de evidencias. Cualquiera de las técnicas de las ciencias sociales puede ser empleada, siempre con el necesario rigor, y utilizada en el análisis algorítmico.

ALGUNAS PREGUNTAS PERTINENTES

Dentro de los criterios habituales en evaluación, adquiere importancia en la auditoría algorítmica también los principios de relevancia, pertinencia y sostenibilidad, así como el necesario refuerzo de la “auditabilidad” de los mismos.

¿Qué objetivo(s) tiene el algoritmo ?. ¿Qué se espera de la utilización de dicho algoritmo?.

¿Es relevante dicho objetivo ?. ¿Se ha alcanzado ese objetivo?. ¿Ha tenido el algoritmo efectos inesperados?.

¿Cuál es el su coste?.¿Se encuentra su coste en el mismo nivel que el de algoritmos similares?. Que experiencia existe de la práctica de algoritmos similares?.

¿Hay capacidades en la organización que utiliza el algoritmo para adaptarlo cuando es necesario?. ¿Qué impacto ha tenido la utilización del algoritmo?

PRIVACIDAD Y DERECHOS DIGITALES.

La protección de los datos, junto con la garantía de los derechos y principios digitales, la garantía de privacidad y todo aquello que se deriva de la propiedad del dato, como es el consentimiento vinculado a la cesión sólo para fines específicos, repercuten en el análisis auditor. También la problemática de la responsabilidad jurídica en los usos indebidos de los algoritmos adquiere una importancia muy relevante.

Por lo demás, los informes pueden tener unas características similares a las que figuran en las numerosas guías y manuales de auditoría y evaluación existentes, incluyendo la necesidad de incorporar un informe ejecutivo y unas conclusiones y recomendaciones coherentes con el trabajo realizado.

ARTICULACIÓN MODELO COSO

A partir del modelo COSO para el control interno, El Instituto de Auditores Internos de España considera cinco actividades clave para integrar en estos procesos:

1. La identificación de los riesgos según la complejidad de los algoritmos, objetivos y el entorno. Vinculando también el apetito de riesgos como referencia.

2.La supervisión de la arquitectura de datos empleados. Incluyendo protección de la privacidad, actualización, seguridad y atención a ciber ataques.

3. El análisis del perfil y relevancia de los modelos empleados.

4.La supervisión de la implementación de los algoritmos, su entrenamiento, garantía de la existencia de pruebas suficientes y otros testings.

5.La revisión periódica, actualización de métricas e indicadores de desempeño.

ADMINISTRACION PÚBLICA Y EMPRESAS

Las administraciones públicas, en sus procedimientos y en su regulación, necesitan promover un uso apropiado de la IA y ocuparse de discernir los efectos económicos y sociales que producen sobre la ciudadanía. También propiciar un uso masivo y no sesgado de la calidad de sus propios datos.

Deben apoyar la responsabilidad de las empresas en el mejor uso de los algoritmos y en los desafíos que las nuevas regulaciones producirán, reforzar su rigor en la validación y usos de las bases de datos, velar por la privacidad de la información, así como por el registro adecuado, la transparencia y uso de los algoritmos. La incorporación de la responsabilidad humana resulta clave en la interacción con la máquina, junto con los códigos y protocolos de ética y el cumplimiento estricto de la prohibición en su caso de su uso para determinadas prácticas.

RESUMEN FINAL

Aspectos que acompañaran al trabajo, según características propias de cada auditoría:

-Un Plan de trabajo que tras contemplar la gobernanza del diseño del sistema con el gestor y/o el usuario, programe el objeto a auditar, las técnicas de evaluación que se pretenden utilizar, la elección de los testing de software más adecuados, junto con la propuesta de un equipo plural de evaluadores experimentados.

-El análisis de los riesgos y sesgos que ofrecen mayor vulnerabilidad en función del tipo de algoritmo, la literatura de evidencias, los observatorios y el marco jurídico, económico, tecnológico y ético de actuación.

- El análisis del origen de la información y la evaluación de la correspondiente métrica de las bases de información incluidas en el entrenamiento y los usos del algoritmo.

RESUMEN FINAL-2

- Las garantías establecidas respecto de la privacidad de los datos y el respeto a los límites mostrados del consentimiento de su uso.

- Una descripción general de las medidas técnicas y organizativas de seguridad implementadas con el algoritmo.

-Información sobre las responsabilidades de las partes implicadas respecto al funcionamiento del modelo.

- Hallazgos de posibles sesgos en los resultados obtenidos por las pruebas en el uso de los algoritmos.

- Funcionamiento de la interacción algoritmos-humanos y otros puntos críticos.

- Problemáticas específicas de sectores vulnerables o protegidos.

.

JuanAntonio Garde Roca

JuanAntonio Garde Roca