UNAREDNEURONALESUN

MODELOCOMPUTACIONAL INSPIRADOENLAESTRUCTURA YELFUNCIONAMIENTODEL CEREBROHUMANO.ESTÁ DISEÑADAPARARECONOCER PATRONESYREALIZARTAREAS COMOCLASIFICACIÓN, PREDICCIÓNY

RECONOCIMIENTODE IMÁGENES

1.

NEURONAS (O NODOS):SONLASUNIDADES BÁSICASDEUNAREDNEURONAL.CADANEURONA RECIBEUNAOMÁSENTRADAS,LASPROCESAY PRODUCEUNASALIDA.

2.CAPAS:

CAPA DE ENTRADA:RECIBELOSDATOSDEENTRADA. CAPAS OCULTAS:PROCESANLASENTRADASA TRAVÉSDEUNASERIEDETRANSFORMACIONES.

CAPA DE SALIDA: PRODUCEELRESULTADOFINAL

3.PESOS: CADACONEXIÓNENTRENEURONASTIENE UNPESOASOCIADO,QUEDETERMINALA IMPORTANCIADELASEÑAL.

4.FUNCIÓN DE ACTIVACIÓN:DETERMINASIUNA NEURONADEBEACTIVARSEONO,BASADAENLASUMA PONDERADADESUSENTRADAS.

PROPAGACIÓN HACIA ADELANTE (FORWARD PROPAGATION): LOSDATOSDEENTRADASEPASANATRAVÉSDE LARED,CAPAPORCAPA,HASTAQUESEPRODUCEUNASALIDA.

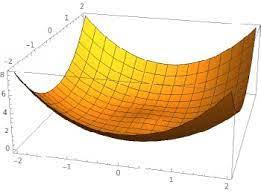

FUNCIÓN DE PÉRDIDA (LOSS FUNCTION): MIDE LA DIFERENCIAENTRELASALIDAPREDICHAYLASALIDAREAL.

PROPAGACIÓN HACIA ATRÁS (BACKPROPAGATION): AJUSTA LOS PESOS DE LA RED PARA MINIMIZAR LA FUNCIÓN DE PÉRDIDA MEDIANTEELCÁLCULODEGRADIENTES.

REDES NEURONALES ARTIFICIALES (ANN): LA FORMA MÁS BÁSICADEREDESNEURONALES.

REDES NEURONALES CONVOLUCIONALES (CNN): UTILIZADAS PRINCIPALMENTE PARA TAREAS DE VISIÓN POR COMPUTADORA.

REDES NEURONALES RECURRENTES (RNN): IDEALES PARA DATOS SECUENCIALES, COMO SERIES TEMPORALES O PROCESAMIENTODELENGUAJENATURAL.

REDES NEURONALES DE RETROALIMENTACIÓN (FEEDFORWARD NEURAL NETWORKS): LAS SEÑALES SOLO VIAJAN EN UNA DIRECCIÓN, DESDE LA ENTRADA HASTA LA SALIDA.

LAS REDES NEURONALES APRENDEN AJUSTANDO LOS PESOS DE LAS CONEXIONES ENTRE NEURONAS PARA MINIMIZAR EL ERROR EN LAS PREDICCIONES ESTE PROCESO ES FUNDAMENTAL PARA QUE LAS REDES PUEDAN REALIZAR TAREAS DE MANERA EFECTIVA. TENIENDOENCUENTALOSSIGUIENTESASPECTOS:

DATOSDEENTRENAMIENTOYCONJUNTOSDEDATOS 1 FUNCIÓNDEPÉRDIDA(LOSSFUNCTION)

2. OPTIMIZACIÓN Y EL ALGORITMO DE DESCENSO DE GRADIENTE

3. PROPAGACIÓNHACIAATRÁS(BACKPROPAGATION) 4 REGULARIZACIÓN

6.

5. TÉCNICASDEMEJORADELRENDIMIENTO

PARA QUE UNA RED NEURONAL APRENDA, NECESITA DATOS LOS DATOSSUELENDIVIDIRSEENTRESCONJUNTOS:

CONJUNTO DE ENTRENAMIENTO: USADO PARA AJUSTAR LOS PESOSDELARED.

CONJUNTO DE VALIDACIÓN: USADO PARA AJUSTAR LOS HIPERPARÁMETROS Y PREVENIR EL SOBREAJUSTE (OVERFITTING).

CONJUNTO DE PRUEBA: USADO PARA EVALUAR EL RENDIMIENTOFINALDELARED

LA FUNCIÓN DE PÉRDIDA MIDE LA DIFERENCIA ENTRE LA SALIDA PREDICHA POR LA RED Y LA SALIDA REAL ESPERADA. ALGUNAS FUNCIONESDEPÉRDIDACOMUNESSON: ERROR CUADRÁTICO MEDIO (MEAN SQUARED ERROR, MSE): UTILIZADOENPROBLEMASDEREGRESIÓN. ENTROPÍA CRUZADA (CROSS-ENTROPY LOSS): UTILIZADO EN PROBLEMASDECLASIFICACIÓN.

LA OPTIMIZACIÓN SE REFIERE AL PROCESO DE AJUSTAR LOS PESOS DE LA RED PARA MINIMIZAR LA FUNCIÓN DE PÉRDIDA. EL MÉTODO MÁS COMÚN PARA HACER ESTO ES EL DESCENSO DE GRADIENTE:

DESCENSO DE GRADIENTE ESTOCÁSTICO (STOCHASTIC GRADIENT DESCENT, SGD): ACTUALIZA LOS PESOS USANDO UNA MUESTRA ALEATORIA DEL CONJUNTO DE ENTRENAMIENTO.

DESCENSO DE GRADIENTE POR LOTES (BATCH GRADIENT DESCENT): USA TODO EL CONJUNTO DE ENTRENAMIENTO PARAACTUALIZARLOSPESOS

DESCENSO DE GRADIENTE POR MINI-LOTES (MINI-BATCH GRADIENT DESCENT): USA PEQUEÑOS LOTES DE DATOS DEL CONJUNTODEENTRENAMIENTO.

VARIANTES AVANZADAS DEL DESCENSO DE GRADIENTE INCLUYEN ADAM, RMSPROP, Y ADAGRAD, QUE ADAPTAN LAS TASAS DE APRENDIZAJEDURANTEELENTRENAMIENTO.

LA PROPAGACIÓN HACIA ATRÁS ES EL ALGORITMO CLAVE PARA ENTRENARREDESNEURONALES CONSISTEENDOSFASES:

1.

PROPAGACIÓN HACIA ADELANTE: LOS DATOS DE ENTRADA SE PASANATRAVÉSDELAREDYSECALCULALAPÉRDIDA.

2.

PROPAGACIÓN HACIA ATRÁS: SE CALCULA EL GRADIENTE DE LA PÉRDIDA CON RESPECTO A CADA PESO USANDO EL MÉTODO DE DIFERENCIACIÓN AUTOMÁTICA. LOS PESOS SE ACTUALIZANENLADIRECCIÓNQUEREDUCELAPÉRDIDA.

LA REGULARIZACIÓN ES UNA TÉCNICA PARA PREVENIR EL SOBREAJUSTE. ALGUNAS FORMAS COMUNES DE REGULARIZACIÓNSON:

L1 Y L2 REGULARIZACIÓN: AÑADEN UN TÉRMINO A LA FUNCIÓNDEPÉRDIDAQUEPENALIZAGRANDESPESOS.

DROPOUT: DURANTE EL ENTRENAMIENTO, SE DESACTIVAN ALEATORIAMENTE CIERTAS NEURONAS, FORZANDO A LA RED A SERMÁSROBUSTA

PARA MEJORAR EL RENDIMIENTO Y LA EFICIENCIA DEL APRENDIZAJE,SEPUEDENUTILIZARVARIASTÉCNICAS: NORMALIZACIÓN Y ESTANDARIZACIÓN DE LOS DATOS: MEJORALACONVERGENCIADELDESCENSODEGRADIENTE DATA AUGMENTATION: AUMENTA LA CANTIDAD DE DATOS DE ENTRENAMIENTO MEDIANTE TRANSFORMACIONES ALEATORIAS.

EARLY STOPPING: DETIENE EL ENTRENAMIENTO CUANDO EL RENDIMIENTO EN EL CONJUNTO DE VALIDACIÓN DEJA DE MEJORAR,PARAEVITARELSOBREAJUSTE.

LAS REDES NEURONALES DE TIPO BIOLÓGICO SON SISTEMAS DE PROCESAMIENTO INSPIRADOS EN EL CEREBRO HUMANO. ESTÁN COMPUESTAS POR NEURONAS QUE SE COMUNICAN A TRAVÉS DE CONEXIONES LLAMADAS SINAPSIS ESTAS REDES SON LA BASE DEL APRENDIZAJE Y LA MEMORIA EN ORGANISMOS VIVOS. VAMOS A EXPLORAR SUS COMPONENTES, FUNCIONAMIENTO Y CÓMO SE RELACIONANCONLASREDESNEURONALESARTIFICIALES.

NEURONAS:

SONLASCÉLULASBÁSICASDELSISTEMANERVIOSO. CADA NEURONA TIENE UN CUERPO CELULAR (SOMA), DENDRITASYUNAXÓN LASDENDRITASRECIBENSEÑALESDEOTRASNEURONAS. ELAXÓNTRANSMITESEÑALESAOTRASNEURONAS.

SINAPSIS:

SONLASCONEXIONESENTRENEURONAS PUEDEN SER QUÍMICAS (MEDIANTE NEUROTRANSMISORES) OELÉCTRICAS. LASSINAPSISQUÍMICASSONMÁSCOMUNESYPERMITENLA TRANSMISIÓN DE SEÑALES MEDIANTE LA LIBERACIÓN DE NEUROTRANSMISORES.

NEUROTRANSMISORES:

SON SUSTANCIAS QUÍMICAS QUE TRANSMITEN SEÑALES A TRAVÉSDELASINAPSIS

DIFERENTES NEUROTRANSMISORES TIENEN DIFERENTES EFECTOSENLASNEURONASRECEPTORAS.

REDES NEURONALES:

LAS NEURONAS ESTÁN INTERCONECTADAS FORMANDO REDESCOMPLEJAS.

ESTAS REDES PUEDEN CAMBIAR SU ESTRUCTURA Y FUNCIONAMIENTO A TRAVÉS DE UN PROCESO LLAMADO NEUROPLASTICIDAD

SEÑALES ELÉCTRICAS:

LAS NEURONAS COMUNICAN A TRAVÉS DE IMPULSOS ELÉCTRICOSLLAMADOSPOTENCIALESDEACCIÓN.

UN POTENCIAL DE ACCIÓN SE GENERA CUANDO LA NEURONA RECIBE SUFICIENTE ESTIMULACIÓN Y LA MEMBRANA CELULARSEDESPOLARIZA.

TRANSMISIÓN SINÁPTICA:

CUANDO UN POTENCIAL DE ACCIÓN ALCANZA EL FINAL DEL AXÓN, PROVOCA LA LIBERACIÓN DE NEUROTRANSMISORES ENLASINAPSIS.

LOS NEUROTRANSMISORES SE UNEN A RECEPTORES EN LA NEURONA RECEPTORA, LO QUE PUEDE EXCITAR O INHIBIR LA NEURONA.

INTEGRACIÓN DE SEÑALES:

LAS NEURONAS RECIBEN MÚLTIPLES SEÑALES A TRAVÉS DE SUSDENDRITAS

INTEGRAN ESTAS SEÑALES PARA DETERMINAR SI SE GENERA UNNUEVOPOTENCIALDEACCIÓN.

EL APRENDIZAJE EN REDES NEURONALES BIOLÓGICAS SE BASA EN LA MODIFICACIÓN DE LAS CONEXIONES SINÁPTICAS, UN PROCESO CONOCIDO COMO PLASTICIDAD SINÁPTICA. HAY VARIOS MECANISMOSDEPLASTICIDAD:

POTENCIACIÓN A LARGO PLAZO (LTP): 1

AUMENTO DURADERO DE LA FUERZA SINÁPTICA TRAS UNA ESTIMULACIÓNREPETIDA.

ASOCIADOCONLAFORMACIÓNDELAMEMORIA.

DEPRESIÓN A LARGO PLAZO (LTD): 2.

DISMINUCIÓNDURADERADELAFUERZASINÁPTICA

CONTRIBUYE A LA ELIMINACIÓN DE CONEXIONES SINÁPTICASINNECESARIAS.

AUNQUE LAS REDES NEURONALES ARTIFICIALES (ANN) ESTÁN INSPIRADAS EN LAS REDES BIOLÓGICAS, HAY VARIAS DIFERENCIAS

CLAVE:

MODELO SIMPLIFICADO: 1

LAS ANN SIMPLIFICAN LAS NEURONAS BIOLÓGICAS USANDO UNIDADES MATEMÁTICAS CON FUNCIONES DE ACTIVACIÓN.

LAS CONEXIONES EN LAS ANN TIENEN PESOS AJUSTABLES, ANÁLOGOSALAFUERZASINÁPTICA.

ALGORITMOS DE APRENDIZAJE: 2.

LAS ANN UTILIZAN ALGORITMOS COMO EL DESCENSO DE GRADIENTE Y BACKPROPAGATION PARA AJUSTAR LOS PESOS.

LAS REDES BIOLÓGICAS DEPENDEN DE PROCESOS BIOLÓGICOSCOMPLEJOSCOMOLTPYLTD.

ESTRUCTURA Y COMPLEJIDAD: 3

LAS ANN TIENEN UNA ESTRUCTURA PREDEFINIDA CON CAPASDENEURONAS.

LAS REDES BIOLÓGICAS SON MUCHO MÁS COMPLEJAS Y FLEXIBLES,CONUNAMAYORCAPACIDADDEADAPTACIÓN.

1. VISIÓN POR COMPUTADORA

RECONOCIMIENTODEIMÁGENESYOBJETOS

CLASIFICACIÓN DE IMÁGENES: IDENTIFICAR EL CONTENIDO DE UNAIMAGEN,COMOANIMALES,VEHÍCULOS,ETC.

DETECCIÓN DE OBJETOS: LOCALIZAR Y CLASIFICAR OBJETOS DENTRODEUNAIMAGEN.

SEGMENTACIÓN DE IMÁGENES: DIVIDIR UNA IMAGEN EN SEGMENTOS SIGNIFICATIVOS, ÚTIL EN MEDICINA PARA IDENTIFICARTEJIDOSYÓRGANOSENIMÁGENESMÉDICAS. EJEMPLOS:

RECONOCIMIENTO FACIAL: UTILIZADO EN SISTEMAS DE SEGURIDADYAUTENTICACIÓN

DIAGNÓSTICO MÉDICO: IDENTIFICACIÓN DE ENFERMEDADES A PARTIR DE IMÁGENES MÉDICAS COMO RADIOGRAFÍAS Y RESONANCIASMAGNÉTICAS.

2. PROCESAMIENTO DE LENGUAJE NATURAL (NLP) ANÁLISISYCOMPRENSIÓNDELLENGUAJE

TRADUCCIÓN AUTOMÁTICA: CONVERTIR TEXTO DE UN IDIOMA A OTRO.

ANÁLISIS DE SENTIMIENTOS: DETERMINAR LA ACTITUD O EMOCIÓNEXPRESADAENUNTEXTO.

CHATBOTS Y ASISTENTES VIRTUALES: INTERACTUAR CON USUARIOSENLENGUAJENATURAL.

EJEMPLOS:

SIRI, ALEXA Y GOOGLE ASSISTANT: ASISTENTES VIRTUALES QUE RESPONDENACOMANDOSDEVOZ

GOOGLE TRANSLATE: TRADUCCIÓN AUTOMÁTICA DE TEXTO Y VOZ.

3. RECONOCIMIENTO DE VOZ

CONVERSIÓNDEVOZATEXTO

SISTEMASDEDICTADO:CONVERTIRLAVOZENTEXTOESCRITO. COMANDOS DE VOZ: CONTROLAR DISPOSITIVOS Y APLICACIONESMEDIANTELAVOZ.

EJEMPLOS:

TRANSCRIPCIÓN AUTOMÁTICA: SERVICIOS QUE TRANSCRIBEN REUNIONES,CONFERENCIASYLLAMADASTELEFÓNICAS CONTROL DE DISPOSITIVOS: INTERACCIÓN CON DISPOSITIVOS DOMÉSTICOS INTELIGENTES A TRAVÉS DE COMANDOSDEVOZ.

4. AUTOMÓVILES AUTÓNOMOS CONDUCCIÓNAUTOMÁTICA

PERCEPCIÓN DEL ENTORNO: UTILIZAR CÁMARAS Y SENSORES PARAENTENDERELENTORNODELVEHÍCULO PLANIFICACIÓN DE RUTA: DETERMINAR LA MEJOR RUTA PARA LLEGARAUNDESTINO.

CONTROL DE MOVIMIENTO: CONTROLAR LA ACELERACIÓN, FRENADOYDIRECCIÓNDELVEHÍCULO

EJEMPLOS:

TESLAAUTOPILOT:SISTEMADECONDUCCIÓNSEMIAUTÓNOMA. WAYMO: PROYECTOS DE VEHÍCULOS AUTÓNOMOS

DESARROLLADOSPORGOOGLE

5. FINANZAS Y ECONOMÍA

PREDICCIÓNYANÁLISISFINANCIERO

PREDICCIÓN DEL MERCADO DE VALORES: UTILIZAR DATOS HISTÓRICOS PARA PREDECIR MOVIMIENTOS FUTUROS DEL MERCADO.

DETECCIÓN DE FRAUDE: IDENTIFICAR TRANSACCIONES FRAUDULENTASANALIZANDOPATRONESDECOMPORTAMIENTO. EJEMPLOS:

ROBO-ADVISORS: ASESORES FINANCIEROS AUTOMATIZADOS QUEGESTIONANINVERSIONES.

SISTEMAS DE DETECCIÓN DE FRAUDE: UTILIZADOS POR BANCOSYEMPRESASDETARJETASDECRÉDITO

6. JUEGOS Y ENTRETENIMIENTO

DESARROLLODEJUEGOSINTELIGENTES

IA EN JUEGOS: CREACIÓN DE PERSONAJES Y ENEMIGOS CON COMPORTAMIENTOSREALISTAS

GENERACIÓN DE CONTENIDOS: GENERACIÓN AUTOMÁTICA DE NIVELESYESCENARIOSDEJUEGOS.

EJEMPLOS:

ALPHAGO: IA DESARROLLADA POR DEEPMIND QUE DERROTÓ A CAMPEONESHUMANOSENELJUEGODEGO.

BOTS EN VIDEOJUEGOS: PERSONAJES CONTROLADOS POR IA QUEINTERACTÚANCONJUGADORESHUMANOS.

7. MEDICINA Y SALUD

DIAGNÓSTICOYTRATAMIENTO

DIAGNÓSTICO ASISTIDO POR COMPUTADORA: AYUDAR A LOS MÉDICOS A DIAGNOSTICAR ENFERMEDADES MEDIANTE EL ANÁLISISDEDATOSMÉDICOS.

DESARROLLO DE MEDICAMENTOS: UTILIZAR IA PARA DESCUBRIRYDESARROLLARNUEVOSFÁRMACOS. EJEMPLOS:

IBM WATSON HEALTH: PLATAFORMA QUE AYUDA EN EL DIAGNÓSTICOYTRATAMIENTODELCÁNCER.

ANÁLISIS GENÓMICO: IDENTIFICACIÓN DE PREDISPOSICIONESGENÉTICASAENFERMEDADES

8. INDUSTRIA Y MANUFACTURA

AUTOMATIZACIÓNYCONTROLDECALIDAD

CONTROL DE CALIDAD: INSPECCIÓN DE PRODUCTOS Y DETECCIÓNDEDEFECTOSENLALÍNEADEPRODUCCIÓN

ROBÓTICA INDUSTRIAL: ROBOTS AUTÓNOMOS QUE REALIZAN TAREASCOMPLEJASENLAMANUFACTURA.

EJEMPLOS:

INSPECCIÓN VISUAL: SISTEMAS QUE INSPECCIONAN PRODUCTOSTERMINADOSPARAGARANTIZARLACALIDAD.

ROBOTS COLABORATIVOS (COBOTS): TRABAJAN JUNTO A HUMANOSENTAREASDEENSAMBLAJEYPRODUCCIÓN.

9. AGRICULTURA AGRICULTURADEPRECISIÓN

MONITOREO DE CULTIVOS: ANÁLISIS DE IMÁGENES SATELITALES Y DRONES PARA MONITOREAR LA SALUD DE LOS CULTIVOS.

PREDICCIÓN DE RENDIMIENTOS: PREDECIR LA PRODUCCIÓN DECULTIVOSUTILIZANDODATOSCLIMÁTICOSYDELSUELO EJEMPLOS:

SENSORES IOT EN AGRICULTURA: MONITOREO DE HUMEDAD, NUTRIENTESYCRECIMIENTODEPLANTAS.

DRONES AGRÍCOLAS: UTILIZADOS PARA LA SIEMBRA, FUMIGACIÓNYMONITOREODECAMPOS.

LAS REDES NEURONALES ARTIFICIALES (ANNS) PUEDEN CLASIFICARSE SEGÚN EL TIPO DE APRENDIZAJE QUE EMPLEAN: SUPERVISADO Y NO SUPERVISADO. A CONTINUACIÓN, SE DESARROLLANEJEMPLOSPARAAMBOSTIPOS.

1. REDES NEURONALES SUPERVISADAS

EN EL APRENDIZAJE SUPERVISADO, LA RED NEURONAL APRENDE A PARTIR DE UN CONJUNTO DE DATOS DE ENTRADA Y SALIDA

EMPAREJADOS ESDECIR,SEENTRENACONEJEMPLOSETIQUETADOS DONDELASALIDADESEADAESCONOCIDA.

EJEMPLO: CLASIFICACIÓN DE DÍGITOS CON UNA RED NEURONAL FEEDFORWARD(MLP)

PROBLEMA: CLASIFICACIÓN DE DÍGITOS ESCRITOS A MANO UTILIZANDOELCONJUNTODEDATOSMNIST.

DESCRIPCIÓNDELMODELO:

ENTRADA:IMÁGENESDE28X28PÍXELES

CAPAS OCULTAS: UNA O MÁS CAPAS COMPLETAMENTE CONECTADAS(FULLYCONNECTED).

SALIDA: 10 NEURONAS (UNA PARA CADA DÍGITO DEL 0 AL 9) CON ACTIVACIÓNSOFTMAX

2. REDES NEURONALES NO SUPERVISADAS EN EL APRENDIZAJE NO SUPERVISADO, LA RED NEURONAL APRENDE A PARTIR DE DATOS SIN ETIQUETAR, DESCUBRIENDO PATRONES O ESTRUCTURASINHERENTESENLOSDATOS.

EJEMPLO: RED AUTOENCODER PARA REDUCCIÓN DE DIMENSIONALIDAD

PROBLEMA: REDUCCIÓN DE DIMENSIONALIDAD DE IMÁGENES DE DÍGITOS ESCRITOS A MANO UTILIZANDO EL CONJUNTO DE DATOS MNIST

DESCRIPCIÓNDELMODELO:

ENTRADA:IMÁGENESDE28X28PÍXELES.

CAPAS OCULTAS: VARIAS CAPAS PARA CODIFICAR Y DECODIFICARLOSDATOS.

CUELLO DE BOTELLA: UNA CAPA INTERMEDIA DE MENOR DIMENSIÓNQUECAPTURALAREPRESENTACIÓNCOMPRIMIDA RESUMEN

REDES SUPERVISADAS: SE ENTRENAN CON DATOS ETIQUETADOS. EJEMPLO:CLASIFICACIÓNDEDÍGITOSCONMLP

REDES NO SUPERVISADAS: SE ENTRENAN CON DATOS SIN ETIQUETAR PARA DESCUBRIR PATRONES. EJEMPLO: AUTOENCODERPARAREDUCCIÓNDEDIMENSIONALIDAD

ESTAS REDES SE UTILIZAN EN UNA VARIEDAD DE APLICACIONES QUE VAN DESDE LA CLASIFICACIÓN Y PREDICCIÓN HASTA LA REDUCCIÓN DE DIMENSIONALIDAD Y LA DETECCIÓN DE PATRONES OCULTOS EN LOSDATOS.

LA TAXONOMÍA DE LAS REDES NEURONALES CLASIFICA LOS DIVERSOS TIPOS DE REDES EN FUNCIÓN DE SU ARQUITECTURA, TIPO DE APRENDIZAJE Y APLICACIÓN. A CONTINUACIÓN, EXPLORAMOS LAS PRINCIPALES CATEGORÍAS DE REDES NEURONALES Y SUS CARACTERÍSTICASDISTINTIVAS.

1. SEGÚN LA ARQUITECTURA

A.REDESNEURONALESFEEDFORWARD(FFNN)

ESTRUCTURA: LAS CONEXIONES ENTRE NEURONAS NO FORMAN CICLOS; LA INFORMACIÓN SE MUEVE EN UNA SOLA DIRECCIÓN, DESDELAENTRADAHASTALASALIDA.

APLICACIONES:CLASIFICACIÓN,REGRESIÓN

EJEMPLO:PERCEPTRÓNMULTICAPA(MLP)

B.REDESNEURONALESCONVOLUCIONALES(CNN)

ESTRUCTURA: INCLUYEN CAPAS CONVOLUCIONALES QUE APLICAN FILTROS PARA EXTRAER CARACTERÍSTICAS ESPACIALES.

APLICACIONES: VISIÓN POR COMPUTADORA, RECONOCIMIENTO DEIMÁGENESYOBJETOS

EJEMPLO:ALEXNET,VGG,RESNET

C.REDESNEURONALESRECURRENTES(RNN)

ESTRUCTURA: TIENEN CONEXIONES QUE FORMAN CICLOS, PERMITIENDOELPROCESAMIENTODESECUENCIASDEDATOS

APLICACIONES: PROCESAMIENTO DE LENGUAJE NATURAL, SERIESTEMPORALES.

EJEMPLO: LSTM (LONG SHORT-TERM MEMORY), GRU (GATED RECURRENTUNIT).

D. REDES NEURONALES DE RETROALIMENTACIÓN (FEEDBACK NETWORKS)

ESTRUCTURA: SIMILARES A LAS RNN, PERMITEN RETROALIMENTACIÓNENSUSCONEXIONES.

APLICACIONES: MODELADO DE SECUENCIAS TEMPORALES Y DINÁMICAS

EJEMPLO:HOPFIELDNETWORKS,BOLTZMANNMACHINES.

2. SEGÚN EL TIPO DE APRENDIZAJE A APRENDIZAJESUPERVISADO

DESCRIPCIÓN: LA RED APRENDE A PARTIR DE EJEMPLOS ETIQUETADOS.

APLICACIONES:CLASIFICACIÓN,REGRESIÓN

EJEMPLO:REDESNEURONALESFEEDFORWARD,CNN.

B.APRENDIZAJENOSUPERVISADO

DESCRIPCIÓN: LA RED APRENDE A PARTIR DE DATOS SIN ETIQUETAS, DESCUBRIENDO PATRONES Y ESTRUCTURAS INHERENTES.

APLICACIONES: AGRUPAMIENTO, REDUCCIÓN DE DIMENSIONALIDAD

EJEMPLO:AUTOENCODERS,SOM(SELF-ORGANIZINGMAPS).

C.APRENDIZAJESEMI-SUPERVISADO

DESCRIPCIÓN: COMBINA EJEMPLOS ETIQUETADOS Y NO ETIQUETADOSPARAMEJORARELRENDIMIENTO

APLICACIONES: CUANDO HAY POCOS DATOS ETIQUETADOS DISPONIBLES.

EJEMPLO: COMBINACIONES DE REDES SUPERVISADAS Y AUTOENCODERS.

D.APRENDIZAJEPORREFUERZO

DESCRIPCIÓN: LA RED APRENDE MEDIANTE LA INTERACCIÓN CON EL ENTORNO, RECIBIENDO RECOMPENSAS O PENALIZACIONES.

APLICACIONES:JUEGOS,CONTROLDEROBOTS.

EJEMPLO:DEEPQ-NETWORKS(DQN),ACTOR-CRITICMETHODS

3. SEGÚN LA FUNCIONALIDAD Y APLICACIÓN A REDESDECLASIFICACIÓN

DESCRIPCIÓN: ASIGNAN ENTRADAS A CATEGORÍAS PREDEFINIDAS.

APLICACIONES: DIAGNÓSTICO MÉDICO, RECONOCIMIENTO DE CARACTERES

EJEMPLO:MLP,CNN.

B.REDESDEREGRESIÓN

DESCRIPCIÓN:PREDICENVALORESCONTINUOS

APLICACIONES: PREDICCIÓN DE PRECIOS, ANÁLISIS FINANCIERO.

EJEMPLO:REDESNEURONALESFEEDFORWARD.

C REDESGENERATIVAS

DESCRIPCIÓN: GENERAN NUEVAS MUESTRAS A PARTIR DE LA DISTRIBUCIÓNAPRENDIDADELOSDATOS.

APLICACIONES:GENERACIÓNDEIMÁGENES,SÍNTESISDEVOZ

EJEMPLO: GENERATIVE ADVERSARIAL NETWORKS (GAN), VARIATIONALAUTOENCODERS(VAE).

D REDESDESEGMENTACIÓN

DESCRIPCIÓN: DIVIDEN UNA IMAGEN EN REGIONES SIGNIFICATIVAS.

APLICACIONES: SEGMENTACIÓN DE IMÁGENES MÉDICAS, VISIÓN PORCOMPUTADORA

EJEMPLO:U-NET,FULLYCONVOLUTIONALNETWORKS(FCN).

4. SEGÚN LA PROFUNDIDAD

A.REDESNEURONALESPROFUNDAS(DNN)

DESCRIPCIÓN:TIENENMÚLTIPLESCAPASOCULTAS,CAPACESDE MODELARFUNCIONESCOMPLEJAS.

APLICACIONES: TAREAS COMPLEJAS EN VISIÓN POR COMPUTADORA,PROCESAMIENTODELENGUAJENATURAL. EJEMPLO:REDESCONMÁSDETRESCAPASOCULTAS.

B REDESNEURONALESSUPERFICIALES

DESCRIPCIÓN:TIENENUNAOPOCASCAPASOCULTAS.

APLICACIONES: TAREAS SIMPLES DE CLASIFICACIÓN Y REGRESIÓN.

EJEMPLO:PERCEPTRÓN,MLPCONUNACAPAOCULTA

LAS FUNCIONES DE BASE SON FUNCIONES MATEMÁTICAS QUE TRANSFORMAN LAS ENTRADAS DE UNA RED NEURONAL ANTES DE APLICARLAFUNCIÓNDEACTIVACIÓN.ENELCONTEXTODELASREDES NEURONALES ARTIFICIALES, ESTAS FUNCIONES NO SUELEN MENCIONARSE EXPLÍCITAMENTE DE LA MISMA FORMA QUE EN OTROS MÉTODOS DE APROXIMACIÓN DE FUNCIONES, PERO EL CONCEPTO PUEDE ENCONTRARSE EN CIERTOS TIPOS DE REDES NEURONALES, COMOLASREDESNEURONALESRADIALES. REDESNEURONALESDEBASERADIAL(RBF)

EN LAS REDES DE BASE RADIAL (RBF), LAS FUNCIONES DE BASE JUEGAN UN PAPEL CLAVE. ESTAS REDES TIENEN UNA ESTRUCTURA DIFERENTE A LAS REDES NEURONALES FEEDFORWARD TRADICIONALES:

CAPADEENTRADA:RECIBELASENTRADASDELMODELO.1.

2. CAPADESALIDA:PRODUCELASALIDADELMODELO.

CAPA OCULTA: CONSISTE EN NEURONAS CON FUNCIONES DE BASERADIALES(GENERALMENTEFUNCIONESGAUSSIANA)

3. FUNCIÓNDEBASERADIAL:

UNA FUNCIÓN DE BASE RADIAL ES UNA FUNCIÓN QUE DEPENDE ÚNICAMENTE DE LA DISTANCIA DE LA ENTRADA DESDE UN PUNTO CENTRAL(CENTRO).

LAS FUNCIONES DE ACTIVACIÓN SON FUNCIONES MATEMÁTICAS APLICADAS EN LAS NEURONAS DE UNA RED NEURONAL DESPUÉS DE LATRANSFORMACIÓNLINEALDELASENTRADAS.DETERMINANSIUNA NEURONA DEBE ACTIVARSE O NO. ESTAS FUNCIONES INTRODUCEN NO LINEALIDAD EN LA RED, PERMITIENDO QUE LA RED NEURONAL APRENDAYMODELERELACIONESNOLINEALES.

CÓMO FUNCIONA: TOMA CUALQUIER VALOR Y LO CONVIERTE EN UNVALORENTRE0Y1.

USO TÍPICO: SE USA EN PROBLEMAS DE CLASIFICACIÓN BINARIA.

VENTAJA: SUAVIZA LAS SALIDAS, ÚTIL PARA INTERPRETAR PROBABILIDADES.

DESVENTAJA: PUEDE CAUSAR QUE LOS GRADIENTES SE DESVANEZCAN, DIFICULTANDO EL ENTRENAMIENTO DE REDES PROFUNDAS.

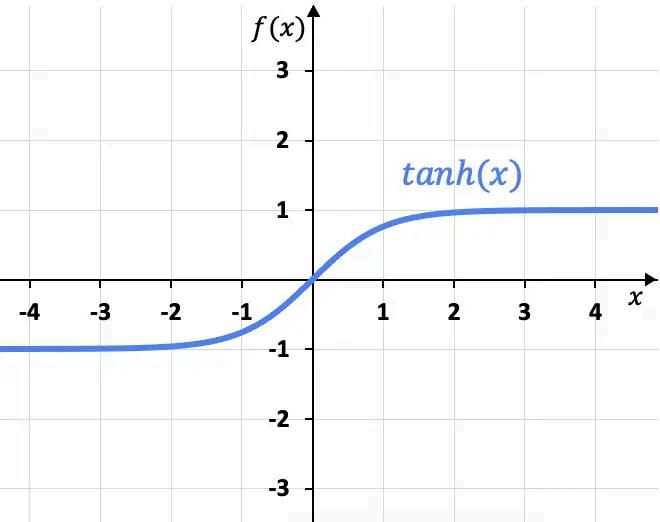

CÓMO FUNCIONA: CONVIERTE CUALQUIER VALOR EN UN VALOR ENTRE-1Y1

USO TÍPICO:SEUSAFRECUENTEMENTEENLASCAPASOCULTAS DELARED.

VENTAJA: LAS SALIDAS ESTÁN CENTRADAS EN CERO, LO QUE PUEDEHACERQUEELENTRENAMIENTOSEAMÁSEFICIENTE.

DESVENTAJA: TAMBIÉN PUEDE SUFRIR DE GRADIENTES DESVANECIENTES,AUNQUEMENOSQUELASIGMOIDE

CÓMO FUNCIONA: CONVIERTE CUALQUIER VALOR NEGATIVO EN 0YDEJALOSVALORESPOSITIVOSSINCAMBIOS

USO TÍPICO: MUY COMÚN EN LAS CAPAS OCULTAS DE LAS REDESNEURONALESMODERNAS.

VENTAJA: EVITA EL PROBLEMA DE GRADIENTES DESVANECIENTESYESCOMPUTACIONALMENTEEFICIENTE

DESVENTAJA: PUEDE CAUSAR QUE ALGUNAS NEURONAS "MUERAN" SI RECIBEN CONSTANTEMENTE VALORES NEGATIVOS DURANTEELENTRENAMIENTO

CÓMO FUNCIONA: SIMILAR A RELU, PERO PERMITE UN PEQUEÑO VALOR NEGATIVO EN LUGAR DE 0 PARA VALORES DE ENTRADANEGATIVOS.

USO TÍPICO: SE USA PARA RESOLVER EL PROBLEMA DE "NEURONASMUERTAS"ENRELU

VENTAJA: PROPORCIONA UNA PEQUEÑA PENDIENTE PARA VALORES NEGATIVOS, AYUDANDO A MANTENER VIVAS MÁS NEURONAS.

DESVENTAJA: INTRODUCE UN PEQUEÑO VALOR NEGATIVO QUE PUEDENOSIEMPRESERIDEAL.

CÓMO FUNCIONA: CONVIERTE UN VECTOR DE VALORES EN UN VECTORDEPROBABILIDADESQUESUMAN1.

USO TÍPICO: USADA EN LA CAPA DE SALIDA PARA PROBLEMAS DECLASIFICACIÓNMULTICLASE

VENTAJA: FACILITA LA INTERPRETACIÓN DE LAS SALIDAS COMO PROBABILIDADES.

DESVENTAJA: COMPUTACIONALMENTE MÁS COSTOSA DEBIDO ALCÁLCULODEEXPONENTES.