EXPERTENMAGAZIN FÜR DIGITALE TRANSFORMATION

EXPERTENMAGAZIN FÜR DIGITALE TRANSFORMATION

Die aktuelle Bedrohungslage QC – Jetzt PQC-Readiness Check starten –Ihr Fitness-Programm für sichere Daten in der Zukunft

DATENEXPLOSION

Wer keine Strategie für die steigenden Datenmengen entwickelt, riskiert den Anschluss an die digitale Zukunft.

Die Supply Chain ist stärker gefährdet denn je, denn Software-Komponenten werden immer komplexer.

Rekursive KI-Systeme erkennen Zusammenhänge und unterstützen Ärzte bei ihren Entscheidungen.

Abonnieren Sie den WIN-verlagsübergreifenden

Bleiben Sie auf dem Laufenden mit den neuesten Entwicklungen und Trends aus der Welt der Künstlichen Intelligenz. Unser kostenfreier Newsletter vom WIN-Verlag wird monatlich versendet und bietet Ihnen spannende Einblicke, exklusive Inhalte und Expertenmeinungen der verschiedenen Branchen.

Melden Sie sich jetzt an und verpassen Sie keine Ausgabe!

heute stehen – und wie sie sich für die Quantenära wappnen können. Denn wer früh beginnt, kann morgen den Unterschied machen.

Liebe Leserin, lieber Leser

• wir stehen an der Schwelle zu einer neuen Ära.

Die Quantentechnologie hat das Potenzial, unsere digitale Welt so tiefgreifend zu verändern, wie es das Internet und die künstliche Intelligenz bereits getan haben. Was heute noch nach Labor klingt, wird schon morgen Geschäftsmodelle, Forschung und ganze Industrien neu definieren.

Mit unserer aktuellen Ausgabe wollen wir Sie auf diese Zukunft vorbereiten. Die rasante Entwicklung des Quanten-Computings stellt bestehende Sicherheitsstrategien auf die Probe. Denn der Quanten-Countdown läuft bereits. Unerbittlich. Es geht um die Post-Quanten-Kryptografie (PQC). Wie dringend der Handlungsbedarf für Unternehmen ist, skizziert im Interview Daniel Stadler, Head of Technology & Innovation bei der NMWP Management GmbH und verantwortlich für den Aufbau des Landeskompetenznetzwerks für Quantentechnologien „EIN Quantum NRW“.

Die aktuelle Bedrohungslage und warum auch Ihr Unternehmen vermutlich schon jetzt gefährdet ist, das erfahren sie, indem sie den PQC-Readiness Check starten, den Digital Business gemeinsam mit der NMWP Management GmbH entwickelt hat. Dieser Meilenstein wird von uns erstmals vorgestellt auf der Messe Quantum Effects, dessen Partner unser Magazin auch ist. Er zeigt Unternehmen, wo sie

Ein faszinierendes Beispiel für das Veränderungspotenzial der Quantentechnologie ist aktuell die Medizintechnik. Hier eröffnet die Quantenforschung Perspektiven, die noch vor wenigen Jahren undenkbar waren: schnellere Entwicklung neuer Wirkstoffe, maßgeschneiderte Therapien, Durchbrüche in der Diagnostik. Es sind Visionen, die nicht nur Branchen verändern, sondern Leben retten können.

Und während wir in die Zukunft blicken, dürfen wir die Gegenwart nicht vergessen. Denn das technologische Wettrennen – ob bei KI oder Quanten – setzt auch die IT-Sicherheit unter Dauerstress. Unser Sonderheft Security beleuchtet, wie Unternehmen sich wappnen können, um im Sturm der Innovationen standzuhalten.

Diese Ausgabe ist Einladung und Impuls zugleich: Lassen Sie uns gemeinsam den Mut fassen, Neues zu denken, Risiken zu meistern – und Chancen zu ergreifen. Die Zukunft beginnt jetzt. •

Herzlichst Ihr

HEINER SIEGER, Chefredakteur DIGITAL BUSINESS

heiner.sieger@win-verlag.de

24 Datenexplosion: Unternehmen am Limit Wer jetzt keine Strategie für die wachsenden Datenmengen entwickelt, riskiert den Anschluss an die digitale Zukunft.

36 Sichere Lieferketten Marco Eggerling von Check Point Software erläutert im Interview, wie sich Lieferketten Software-seitig schützen lassen.

Titelstory / Quantentechnologie

Handlungsbedarf für Unternehmen: Post-Quanten-Kryptografie stellt bestehende Sicherheitsstrategien auf die Probe.

48 Sauberer Wechsel in die Cloud Um den Change erfolgreich zu gestalten, braucht es klare Rollen, transparente Prozesse und eindeutige Ziele.

36 Lieferketten schützen: Software-seitiger Schutz der Supply Chain

38 KI verschärft die Bedrohungslage: IT-Verantwortliche sind jetzt gefordert

40 Moderne Dateninfrastrukturen: Datenauswertung bei der Royal Air Force

42 Privileged Access Management: Ein elementarer Baustein für die IT-Sicherheit

44 Security by Design: Nachträgliche Sicherheit bleibt ein Flickwerk

45 Hybrid- und Multi-Cloud: Schutz personenbezogener Daten

50 Künstliche Intelligenz in der Arbeitswelt

Das 3M-Prinzip hilft bei der effektiven Zusammenarbeit von Mensch und Maschine und bringt bessere Ergebnisse.

QUANTENTECHNOLOGIE

06 Post-Quanten-Kryptografie: So dringend ist der Handlungsbedarf für Unternehmen

Die rasante Entwicklung des Quanten-Computings stellt bestehende Sicherheitsstrategien auf die Probe.

10 Sicherheit im Zeitalter der Quanten Unternehmen stehen vor einer neuen Gefahrenklasse.

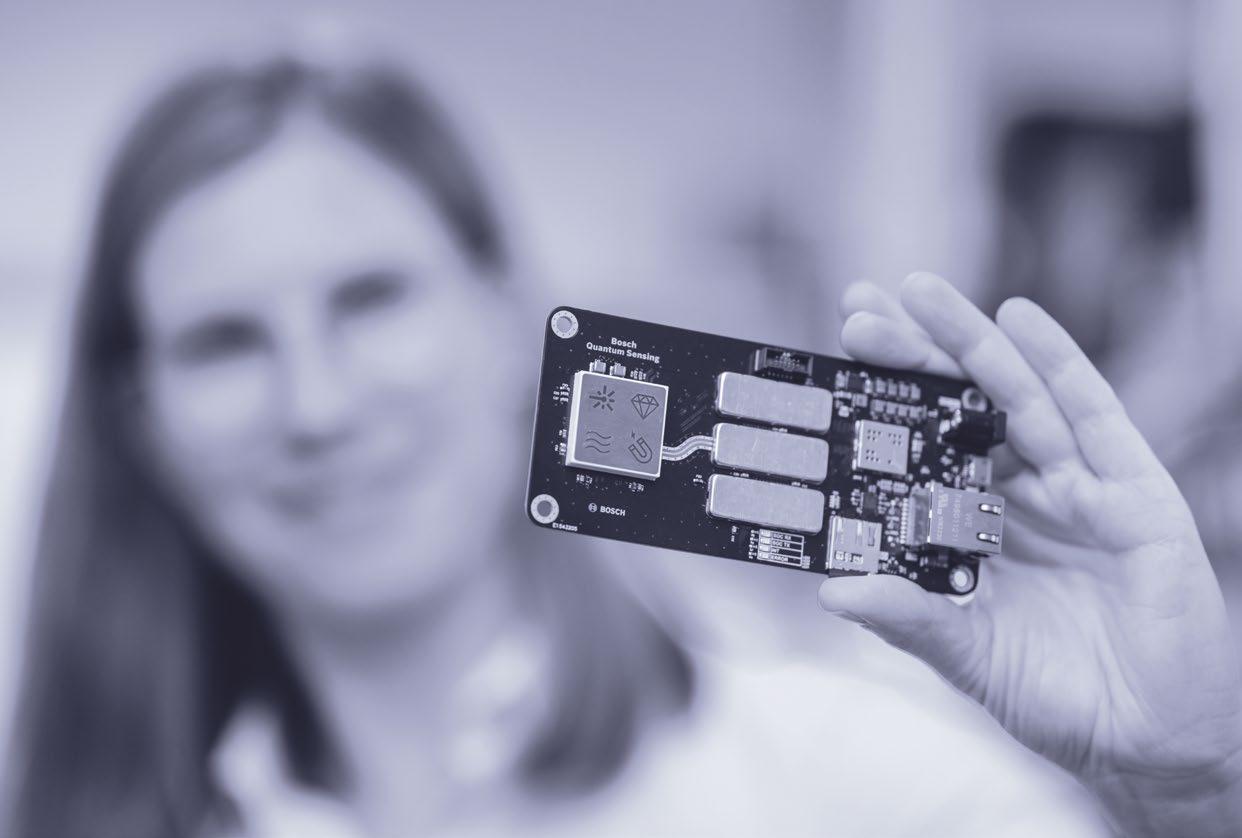

12 Quanten-Sensorik

Bosch Quantum Sensing entwickelt skalierbare Produkte in den Bereichen Medizintechnik und Konsumgütern

14 „Aktiv vorbereiten, um den Anschluss nicht zu verpassen“

Quantencomputing als spezieller Problemlöser

16 Wie Quantentechnologie die Medizin verändert

Neue Möglichkeiten in der Diagnostik

KI

18 KI als treibende Kraft in der Logistik

20 KI-FOMO: Einstieg mit KI-Agenten

22 Der EU AI Act in der Praxis: Was KMUs jetzt wissen und umsetzen sollten

DIGITALE TRANSFORMATION

24 Datenexplosion: Unternehmen am Limit

26 Prozessintelligenz trifft KI: Die Zukunft der Unternehmenssteuerung

28 Customer Journey: Strategie statt Hack

30 Interne Abläufe digitalisieren: Gesteigerte Effizienz, schnellere Prozesse

32 Digitales Wachstum meistern

2025

FRISCH AUSGEPACKT

34 News

SECURITY INSIGHT

35 Titel

36 „Unternehmen müssen Sicherheitsanforderungen vertraglich verankern“

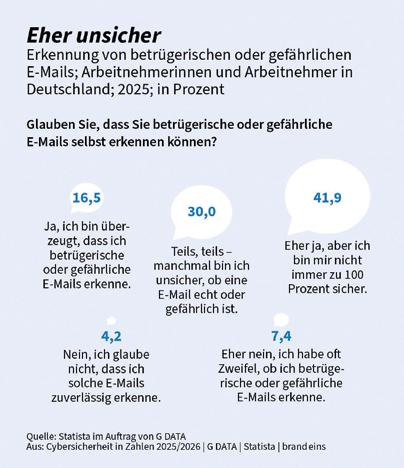

38 Cybersicherheit in Zahlen: Bedrohungslage verschärft sich durch KI

40 Digitale Aufklärung für Europas Sicherheit

42 Privileged Access Management: Der Schlüssel zur Stärkung der Cyberabwehr

44 Security by Design: Sichere IT-Systeme realisieren

45 Hybrid- und Multi-Cloud: Flexibilität mit Verantwortung

CLOUD COMPUTING

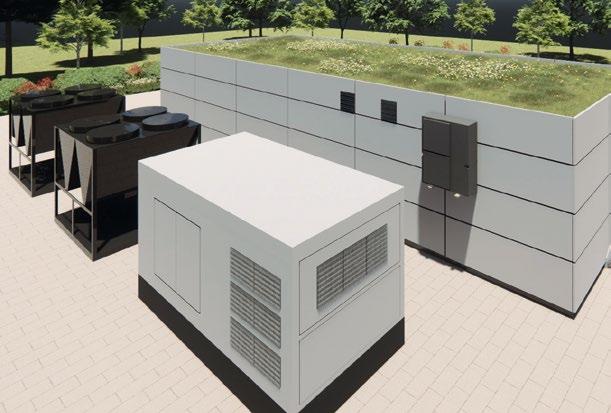

46 Rechenzentren: Vorausschauende Überwachung als Erfolgsfaktor

48 Cloud Change sauber steuern

HR

50 Dirigent der Innovation: Menschliche Führung in der KI-Ära

52 Die Akademie der neuen Generation

DIGITAL HEALTH

54 Digitalisierung in Krankenhäusern: „Digital heißt führen – nicht nur kaufen“

56 Klinisches Denken in Echtzeit

58 Umstrukturierung stationärer Einrichtungen: Sektorendenken digitalisiert?!

RECHT

60 EU Data Act: Weniger Vendor-Lock-in dank verbindlicher Cloud-Wechselregeln

03 Editorial

61 Marketplace

62 Vorschau

62 Impressum

Die rasante Entwicklung des Quanten-Computings stellt bestehende Sicherheitsstrategien auf die Probe. Daniel Stadler, Head of Technology & Innovation bei der NMWP Management GmbH und verantwortlich für den Aufbau des Landeskompetenznetzwerks für Quantentechnologien „EIN Quantum NRW“, erklärt warum PQC jetzt unverzichtbar ist. /// von Heiner Sieger

Herr Stadler, können Sie kurz erläutern, warum die Post-Quanten-Kryptografie (PQC) gerade jetzt eine so wichtige Rolle in der IT-Sicherheit einnimmt – und welche Risiken ohne PQC für Unternehmen bestehen?

Daniel Stadler | Die Uhr tickt: Die Entwicklungen zum Quanten-Computing (QC) schreiten zügig voran, mit mehr und besser nutzbaren Qubits – auch verwendbar für den Shor-Quantenalgorithmus, der die sogenannte „Public-Key-Verschlüsselung“ brechen kann. Gleichzeitig hat eine kürzlich – zunächst als pre-print – veröffentliche Studie die benötigte Zahl an Qubits, um Verschlüsselung nach heutigem Standard – RSA, mit 2048 bit Schlüssel – zu brechen, auf unter eine Million physische Qubits reduziert.

Ist Kommunikation & IT damit zumindest bis zum Aufkommen eines kryptographisch relevanten Quanten-Computers – dem sogenannnten Q-Day – QC-sicher?

spiel, kompromittiert. Mit zügiger Implementierung lässt sich dies auf die Kommunikation & IT vor Nutzung von PQC begrenzen. Was davor geschehen ist, ist kompromittiert und niemand kann garantieren, dass es nicht zu späteren Entschlüsselung per QC gespeichert worden ist.

Wie beurteilen Sie den aktuellen Stand der Technologie und Marktreife von PQC-Lösungen? Gibt es bereits praxistaugliche Anwendungen, die Unternehmen jetzt nutzen können?

DS | PQC, die Postquantenkryptographie, prinzipiell eine „klassische Form“ von Verschlüsselungsalgorithmen, ist gerade im Vergleich zur auf Quanteneffekten basierenden Quantenkryptographie – Quantum-Key-Distribution (QKD) – eine ausgereifte Technologie, die in den vergangenen Jahren weiterentwickelt worden und gereift ist. Deutlich jünger im Vergleich zu heute etablierten Algorithmen zur Public-Key-Verschlüsselung sind sie allerdings noch

” Ohne PQC-Implementierung in einem Unternehmen zum Q-Day wäre sämtliche public-key-verschlüsselte Kommunikation, und auch damit verbundene Zertifikate kompromittiert.

DS | Leider nein, denn auch heute schon wird solche vertrauliche Kommunikation mitgeschnitten, deren Informationsgehalt erwartbar auch noch in 10 bis 20 Jahren relevant sein wird für einen Angreifer. „Harvest now, decrypt later“ heißt dieses auf performanter werdende Rechner generell ausgerichteter Ansatz, der aber durch Quanten-Computing massiv an Brisanz gewinnt. Ohne PQC-Implementierung in einem Unternehmen zum QDay wäre sämtliche public-key-verschlüsselte Kommunikation, und auch damit verbundene Zertifikate zum Bei-

nicht langzeiterprobt, im weit verbreiteten Einsatz. Software-, Hardware- und Dienstleistungsanbieter in der IT erweitern ihre Produkte & Dienste nun verstärkt um PQC, verwenden insbesondere Hybride mit herkömmlichen Methoden. PQC befindet sich heute schon in verbreiteten Webbrowsern, Virtualisierungs-/Container- und Cloud-Lösungen, aber auch in Kryptographie-Bibliotheken (APIs) im Einsatz. Von Hardware-Kryptographie-Modulen (HKMs) über IoT-Lösungen und FPGAs hinzu quanten-sicheren Security-Controllern und SmartCards sind marktreife

Hardware-Produkte verfügbar. Hier gilt es allerdings zu beachten, dass nicht der Einsatz einzelner PQC-Lösungen eine IT quanten-sicher macht, sondern das Management der kryptographischen Assets: gründliche Analyse, zielgerichtete Organisation des Übergangs und priorisierte Implementierung in die bestehende Infrastruktur. Im Rahmen dessen ist Crypto-Agilität, die Vorbereitung des Kryptosystems auf zügig durchführbare Anpassungen der Verschlüsselungsmethoden für die Implementierung von PQC und für die Zukunft nicht nur ein Paradigma, sondern eine Notwendigkeit um flexibel auf Änderungen der Bedrohungslage, z.B. neue Angriffsvektoren oder auftretende Schwachstellen, reagieren zu können.

Welche Ziele verfolgt die Messe Quantum Effects in Stuttgart in diesem Jahr, und welche Rolle spielen dabei PQC und quantensichere IT-Sicherheit?

DS | Unter dem Slogan „Quantentechnologien treffen Anwenderbranchen“ und dem Anspruch sich als „weltweit

führende Messe und Konferenz für anwendungsorientierte Quantentechnologien“ zu positionieren, ist die Zielrichtung gesetzt. Als technologisch-methodisch ausgereifte Verschlüsselungstechnik ist PQC der Anwendungsfall in Reaktion auf das sich abzeichnende Quanten-Computing.

Die Quantum Effects definiert vier thematische Säulen für die diesjährige Messe & Konferenz

• Quantencomputing und Enabling Technologies

• (Quanten-)Software

• Sensing

• Communication von denen das Quanten-Computing die Herausforderung ist, der sich mit PQC sofort effektiv begegnen lässt. Die Säule Communication umfasst neben der PQC auch die Themen Quantensicherheit und Quantenkryptographie als Unterthemen. Die Quantum Effects legt damit ein dem Thema entsprechendes Gewicht auf PQC und quanten-sichere IT, wie auch der vorläufige Stand des Programms deutlich macht.

Welche weiteren Themen stehen auf der Messe noch im Vordergrund? Was können Unternehmen, die sich mit Quantentechnologie beschäftigen, dort lernen?

DS | Die anwendungsorientierte Ausrichtung der Quantum Effects bietet gerade für Unternehmen, in der Breite der schon genannten vier „tragenden Säulen“ der Quantentechnologien viele Anknüpfungspunkte. Quanten-Computing ist zwar die prominenteste Quantentechnologie, die in den vergangenen Monaten durch Fortschrittsmeldungen wichtiger Akteure viel Aufmerksamkeit erregte, und bildet dementsprechend die erste Säule. Gerade dem Bereich zugehöriger Software und dem Sensing sollten die Interessenten und Besucher, neben der genannten Communication, hinreichend Aufmerksamkeit schenken. Das Quantum-Sensing verheißt Messmethoden unerreichter Präzision und Anwendungen, etwa in der Navigation, die über „klassische“ Ansätze nicht machbar

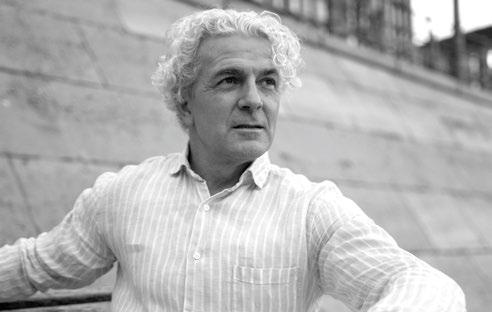

DER GESPRÄCHSPARTNER

Daniel Stadler

ist Head of Technology & Innovation bei der NMWP Management GmbH in Düsseldorf. Er treibt die Umsetzung von Strategien in den Bereichen Deep-Tech, Start-ups und Standortentwicklung voran und verantwortet den Aufbau des Landeskompetenznetzwerks für Quantentechnologien „EIN Quantum NRW“.

sind. Ohne adäquate Quanten-Software bliebe das Quantum-Computing weit hinter seinen Möglichkeiten zurück.

Sie haben einen „PQC-Readiness-Check“ entwickelt –was verbirgt sich hinter diesem Konzept, und wie hilft der Check Unternehmen konkret bei der Einschätzung ihres „Quantum Readiness“-Status?

DS | Wir haben die Idee hierzu während unserer Tätigkeiten im Projekt Q-PrEP entwickelt. Darin weisen wir öffentliche Institutionen europaweit, als Stakeholder einer Community zu PQC und Kryptoagilität, auf die Herausforderung der Verschlüsselung ihrer vertraulichen Kommunikation und Daten durch Quanten-Computing hin, bereiten sie auf diese vor und bilden sie weiter. Die für den öffentlichen Sektor bestehende „Bedrohungslage QC“ ist auch für den privaten Sektor, gerade für Unternehmen mit Kommunikation langjährig vertraulicher Daten relevant. Mit der Überprüfung des Quantum-Readiness-Status (QRS) schärfen wir zunächst das Bewusstsein für die Problematik, bieten dann eine erste Abfrage wesentlicher Eigenschaften der im Unternehmen eingesetzten Kryptographiemethoden und der Einsatzbereiche, aus denen eine erste, allgemeine Schätzung für das Quantum-Readiness-Level resultiert. Damit können wir den Unternehmen eine Einschätzung liefern, wie akut der Handlungsdruck

Einsatzzwecke dieser und damit verbundener Verschlüsselung , zum Beispiel wo langlebige Zertifikate darüber ausgetauscht worden sind, zu berücksichtigen, um ein klares Bild der Lage eines Unternehmens zu erhalten. So vielfältig wie die Kommunikation und IT heutzutage –von/zu Servern, in die Cloud, mit IoT-Geräten, Zertifikaten, Schlüssel-Devices, etc – in den verschiedenen betroffenen Firmen ist, so lang ist auch die Liste ausnutzbarer Schwachstellen, die wir natürlich mit unserer Analysemethodik erfassen wollen. Wenn eine Schwachstelle, das heißt, ein nicht quanten-sicherer Einsatzbereich, übersehen wird, kann diese einem versierten Angreifer unter Anwendung von QC gegebenfalls die Tür ins Firmennetzwerk öffnen oder vertrauliche Daten offenlegen.

Wie wichtig ist Ihrer Erfahrung nach die frühzeitige Integration von PQC in bestehende IT- und Sicherheitsstrategien, und wie können Unternehmen den Übergang mit minimalen Risiken gestalten?

DS | Die frühzeitige Integration ist immens wichtig, gerade was das schon erwähnte Bedrohungsszenario des „harvest now, decrypt later“ anbelangt. Alles, was bis zur vollständigen Umsetzung wirklicher Quantum Readiness an Informationen aus public-key-verschlüsselter Kommunikation aufgezeichnet worden sein könnte, ist

” Crypto-Agilität, die Vorbereitung des Kryptosystems auf zügig durchführbare Anpassungen der Verschlüsselungsmethoden, ist für die Implementierung von PQC und für die Zukunft nicht nur ein Paradigma, sondern eine Notwendigkeit um flexibel auf Änderungen der Bedrohungslage reagieren zu können.

zur PQC-Migration ist. Auf Basis dieser ersten Einschätzung erfolgt dann, je nach Kundenwunsch, die Entwicklung einer auf die spezifischen Anforderungen des Unternehmens ausgerichtete Migrationsstrategie.

Welche Hauptkriterien oder Fragen sollte ein Unternehmen für eine realistische PQC-Einschätzung berücksichtigen? Gibt es typische Schwachstellen, auf die der Check besonders hinweist?

DS | Da im Wesentlichen die Public-Key-Verschlüsselung anfällig gegen QC – Algorithmus von Shor – ist, sind alle

Daniel Stadler

kompromittiert. Selbst wenn Sie heute damit beginnen müssen, auch noch die zukünftigen vertraulichen Daten als verloren gelten, die Sie herkömmlich verschlüsselt verschicken, bis PQC zu 100 Prozent in Ihrer IT implementiert ist,– insofern sie bei einsetzender Verfügbarkeit von kryptographisch relevantem QC nicht veraltet und damit obsolet wären.

Wie Sie richtig fragen, gibt es das Restrisiko, dass sich einzelne PQC-Algorithmen auf lange Sicht doch als anfällig gegen neu entwickelte, entweder herkömmliche oder Quanten-Algorithmen herausstellen. Zum einen werden

deshalb, zumindest für eine Übergangszeit Hybride aus herkömmlichen und PQC-Verschlüsselungsmethoden Verwendung finden. Gleichzeitig ist deshalb aber auch das Konzept der Kryptoagilität – sprich, der Konzeptionierung und Vorbereitung des Kryptosystems auf einen agilen Austausch kompromittierter Algorithmen & Methoden – so wichtig und unumgehbar. Es wäre naiv, für die Zukunft eine stagnierende Kryptoanalyse, ob herkömmlicher oder QC-gestützter Art, zu unterstellen.

Welche Rolle spielt Baden-Württemberg als Standort für Quantentechnologien und PQC-Entwicklung in Deutschland und Europa? Welche Synergien gibt es zwischen Wissenschaft, Wirtschaft und Veranstaltungen wie der Quantum Effects?

DS | Baden-Württemberg verfügt über eine große industrielle Basis, die sich auch in den Quantentechnologien niederschlägt. Großkonzerne, aber auch die größeren Betriebe des Mittelstands entdecken zunehmend Quantentechnologien für sich – als Hersteller/Anbieter oder Early-Adopter. Für einen tieferen Einblick in das Baden-Württembergische Ökosysteme empfehle ich einen Besuch auf dem Stand von QuantumBW, die auch dieses Jahr wieder Mitveranstalter der Quantum Effects sind.

Blicken wir in die Zukunft: Wie wird sich Ihrer Einschätzung nach das Zusammenspiel von Quantencomputing, KI und PQC weiterentwickeln, und welche Auswirkungen wird das auf die digitale Transformation von Unternehmen haben?

DS | Schon heute gibt es Ansätze unter dem Begriff des Quantum-Machine-Learning (QML) und erste Anwendungen, das „Beste aus beiden Welten“ zusammenzubringen, gleichzeitig von den mächtigen Entwicklungen im Bereich KI der vergangenen Jahre zu profitieren und, gerade im Hinblick auch auf den Energieverbrauch, die notwendigen Berechnungen per QC zu erledigen. Allerdings ist Vorsicht geboten, wenn es um Hype-Themen geht: Quanten-Computing beschreibt zwar einen vielversprechenden Paradigmenwechsel im Computing, ist aber vom Fortschritt in Hard- und Software in den kommenden Jahren stark abhängig. KI ist eine etablierte Softwaretechnologie, die auf bestehender, großskaliger Computerhardware ausgerollt ist. Das heißt, dass KI dem Quantencomputing in seiner Reife weit voraus ist und sich natürlich auch stetig weiterentwickeln wird. Egal, ob mit oder ohne Quantencompu-

MEHR ERFAHREN

Machen Sie jetzt den PQC-Readiness-Check!

ting. Entscheidend ist also die Frage: Wann werden Quantencomputer hinreichender Leistungsfähigkeit zur zur Verfügung stehen und wie weit ist die Entwicklung von Quantensoftware bis dahin vorangeschritten? Das definiert auch den Zeitpunkt, an dem wir Quantencomputer als kryptorelevant verstehen müssen. Sinkt die Zahl der benötigten Qubits oder die Anforderung an ihre Qualität durch Verbesserung der Algorithmen oder ihrer Anwendung in den nächsten Monaten oder Jahren, könnte der Q-Day schneller da sein, als es bislang geschätzt worden ist.

Die Uhr tickt also, wir fragen uns nur: wann schlägt es zwölf? •

FUNDIERTE RISIKOEINSCHÄTZUNG

DAS BRINGT IHNEN DER PQC-READINESS-CHECK

Die von der NMWP Management GmbH und Digital Business entwickelte Online-Umfrage dient Unternehmen als strategisches Instrument zur Einschätzung ihrer individuellen Bedrohungslage durch die fortschreitende Entwicklung von Quantencomputern. Sie basiert auf etablierten Leitfäden und umfasst zehn gezielte Fragen, die sowohl technische als auch organisatorische Aspekte beleuchten. Ziel ist es, Unternehmen in eine von drei Handlungs-Kategorien einzuordnen, die jeweils eine klare Empfehlung für den zeitlichen Rahmen der PQC-Migration geben. Die Umfrage liefert nicht nur eine fundierte Risikoeinschätzung, sondern auch konkrete Empfehlungen für die nächsten Schritte – von der Bestandsaufnahme über die RoadmapEntwicklung bis hin zur Umsetzung. Sie eignet sich ideal als Grundlage für weitere Schritte, hin zu einer quantensicheren Infrastruktur

Die Kategorie A steht für sofortigen Handlungsbedarf. Unternehmen in dieser Gruppe verarbeiten besonders schützenswerte Daten, betreiben kritische Infrastruktur oder nutzen langlebige Systeme, die nicht kurzfristig aktualisiert werden können. Sie sind potenziell Ziel sogenannter „Store-now-decrypt-later“Angriffe, bei denen Daten heute abgefangen und in Zukunft mit Quantencomputern entschlüsselt werden. Für diese Organisationen ist eine umgehende Migration zu quantensicheren Verfahren dringend geboten.

Die Kategorie B beschreibt Unternehmen mit Handlungsbedarf in den nächsten fünf Jahren Ihre Systeme und Daten sind mittelfristig gefährdet, etwa durch längere Lebenszyklen oder eingeschränkte kryptographische Agilität. Zwar besteht keine akute Bedrohung, doch eine strategische Vorbereitung auf PQC ist essenziell, um regulatorischen Anforderungen und technologischen Entwicklungen rechtzeitig begegnen zu können.

Die Kategorie C umfasst Unternehmen mit langfristigem Handlungsbedarf innerhalb der nächsten zehn Jahre. Ihre aktuelle Infrastruktur ist entweder agil, wenig kritisch oder die Daten haben eine kurze Lebensdauer. Dennoch sollten auch diese Organisationen frühzeitig PQC in ihre IT-Strategie integrieren, um zukünftige Risiken zu minimieren und technologische Anschlussfähigkeit zu sichern.“

Unternehmen stehen vor einer neuen Gefahrenklasse: Quantencomputer werden in der Lage sein, heutige Verschlüsselungsverfahren zu brechen – insbesondere asymmetrische Algorithmen wie RSA oder ECC. Angreifer speichern sensible Daten mit dem Ziel, sie in einigen Jahren mithilfe von Quantencomputern zu entschlüsseln. /// von Dr. Jan Wehinger und Julian Seyfarth

Gefahr auf Lager: Store Now, Decrypt Later

Die Bedrohung ist nicht theoretisch, sondern bereits praktisch relevant. Verschlüsselte Daten, die heute gespeichert oder abgefangen werden, könnten in fünf oder zehn Jahren entschlüsselt werden, sobald Quantencomputer die notwendigen Rechenkapazitäten erreichen. Dieses Szenario wird als „Store Now, Decrypt Later“ bezeichnet. Angreifer sammeln schon jetzt Daten, um sie zu einem späteren Zeitpunkt zu entschlüsseln. Demnach sollten alle Daten, die auch in fünf Jahren noch schützenswert sind, gegen

werden diese mithilfe des Shor-Algorithmus aushebeln und so die Verfahren vollständig brechen. Auch symmetrische Verschlüsselung wie AES ist betroffen – wenn auch in geringerem Maße: Der Grover-Algorithmus halbiert die effektive Schlüssellänge, weshalb längere Schlüssel empfohlen werden.

Sicher in die Post-Quanten-Ära

Die Lösung liegt in der rechtzeitigen Migration auf Post-Quantum-Kryptographie (PQC) – also Verschlüsse-

DIE AUTOREN

Dr. Jan Wehinger, Partner bei MHP und Julian Seyfarth, Associate bei MHP.

” Der Weg ist klar: Es beginnt mit gezielter Awareness im Unternehmen, gefolgt von einer strukturierten Readiness-Analyse und dem Aufbau von Krypto-Agilität. Darauf aufbauend lassen sich gezielte Pilotprojekte umsetzen und eine belastbare MigrationsRoadmap entwickeln. Dr. Jan Wehinger, Julian Seyfarth

diese Gefahr abgesichert werden. Das gilt besonders für Forschungsunterlagen, staatliche Geheimnisse oder langfristige Vertragswerke.

Klassische Verfahren reichen hierfür nicht mehr aus. Die klassischen Public-Key-Verfahren wie RSA oder elliptische Kurven basieren auf mathematischen Problemen, die für heutige Computer als praktisch unlösbar gelten (etwa die Faktorisierung großer Primzahlen (RSA) oder die Berechnung diskreter Logarithmen (ECC)). Quantencomputer

lungsverfahren, die auch Quantencomputern standhalten. Diese Algorithmen basieren auf mathematischen Problemen, die auch mit Quantenrechnern nicht effizient lösbar sind, darunter gitterbasierte (z. B. CRYSTALS-Kyber, Dilithium, Falcon), hashbasierte (SPHINCS+) und codebasierte Verfahren (Classic McEliece). Seit 2024 hat das US-amerikanische NIST erste PQC-Standards veröffentlicht, die klassische Verfahren wie RSA und ECC ablösen sollen – und die auf heutiger Hardware sofort einsetzbar sind.

Bevor technische Maßnahmen greifen können, braucht es jedoch ein grundlegendes Awareness-Programm. Entscheidungsträger und Fachbereiche müssen verstehen, warum die Bedrohung schon heute real ist, was „Store now, decrypt later“ konkret bedeutet und welche Folgen Untätigkeit für Vertraulichkeit, Compliance und Reputation haben kann. Ohne dieses Bewusstsein erhält PQC in Organisationen nicht die notwendige Priorität.

Darauf aufbauend empfiehlt sich ein strukturiertes Vorgehen in vier Schritten:

1. Bestandsaufnahme (Kryptoinventur)

Der erste Schritt ist ein vollständiges Krypto-Inventar. Ziel ist es, systematisch zu erfassen, welche kryptografischen Verfahren, Protokolle und Anwendungen aktuell im Einsatz sind – und wo Handlungsbedarf besteht. Dazu gehören:

• Systeme & Umgebungen: On-Premise-Systeme, Cloud-Dienste, Client-Server-Anwendungen, eingebettete Systeme (z. B. Steuergeräte, Maschinen, Medizingeräte), mobile und IoT-Komponenten.

• Kommunikationskanäle: Web- und API-Traffic (TLS/HTTPS, gRPC-TLS), VPN-Tunnel (IPsec, WireGuard, OpenVPN), Remote-Zugriffe (SSH, RDP), E-Mail (SMTPS, STARTTLS, S/MIME, PGP), Maschinen-zu-Maschinen-Kommunikation (MQTT, AMQP), Datenreplikation und Storage (TLS-DB-Replika, S3-HTTPS).

• Veraltete oder proprietäre Protokolle: z. B. Zigbee, BLE, Z-Wave, CAN-Bus, Modbus. Diese sind oft schwer zu aktualisieren und benötigen Migrations- oder Kompensationsstrategien.

• Schlüsselmaterial & Abhängigkeiten: Zertifikate, HSM-/ KMS-Instanzen, Secrets-Manager, TPMs, Authentifizierungsmechanismen (JWT, SAML, OAuth, Code-Signing) sowie eingesetzte Kryptobibliotheken (OpenSSL, Bouncy Castle, mbedTLS).

Das Ergebnis ist ein klar dokumentiertes Krypto-Inventar mit Algorithmen, Schlüsselgrößen, Zertifikatslaufzeiten und Fallback-Mechanismen. Es bildet die belastbare Grundlage für Risikoanalysen und die Planung der PQC-Migration.

2. Risikobewertung

Priorisieren Sie Systeme und Daten nach Schutzbedarf und ihrem Lebenszyklus (lange Nutzungsdauer und Schutzbedarf über Jahre oder Jahrzehnte). Besonders betroffen sind Daten mit langfristigem Schutzbedarf (z. B. Geschäftsgeheimnisse, personenbezogene Daten,

sicherheitskritische Software), da sie durch „Store now, decrypt later“-Angriffe bereits heute gefährdet sind.

3. Erste Maßnahmen & Krypto-Agilität

Beginnen Sie mit hybriden Verfahren, die klassische und quantensichere Algorithmen parallel kombinieren, etwa ECDHE zusammen mit ML-KEM. Solche Lösungen verringern das Risiko, sichern Interoperabilität und ermöglichen eine schrittweise Umstellung. Gleichzeitig sollten Systeme so gestaltet werden, dass kryptografische Verfahren ohne großen Aufwand austauschbar sind – Krypto-Agilität ist der Schlüssel.

4. Roadmap für die Migration

Starten Sie mit Pilotprojekten in klar abgegrenzten Bereichen, z. B. innerhalb der PKI oder bei VPN-Gateways, und evaluieren Sie Performance und Kompatibilität. Nutzen Sie die Erkenntnisse, um eine skalierbare Roadmap zu entwickeln, die den kontrollierten Rollout von PQC in der gesamten Organisation sicherstellt.

Heute handeln, um morgen sicher zu sein

Die Zeit zum Handeln ist jetzt. Unternehmen dürfen nicht darauf warten, dass skalierte Quantencomputer marktreif sind – denn wer erst dann reagiert, hat bereits verloren. Die Einführung quantensicherer Kryptografie ist kein einmaliges IT-Projekt, sondern ein strategischer Transformationsprozess, der heute angestoßen werden muss.

Der Weg ist klar: Es beginnt mit gezielter Awareness im Unternehmen, gefolgt von einer strukturierten ReadinessAnalyse und dem Aufbau von Krypto-Agilität. Darauf aufbauend lassen sich gezielte Pilotprojekte umsetzen und eine belastbare Migrations-Roadmap entwickeln. Parallel dazu braucht es ein kontinuierliches Monitoring regulatorischer Anforderungen und technologischer Entwicklungen. Wer diesen Weg jetzt konsequent beschreitet, sichert nicht nur seine Daten – sondern auch Vertrauen, Wettbewerbsfähigkeit und Zukunftsfähigkeit. •

KLARER ANPASSUNGSBEDARF

Weltweit treiben Regierungen die Vorbereitung auf Post-Quantum-Kryptografie voran. Länder wie Kanada, Japan, die USA und Großbritannien entwickeln nationale PQC-Strategien, setzen Fristen zur Migration und starten großangelegte Awareness-Programme. Auch auf EU-Ebene entsteht Handlungsdruck: Zwar nennen die NIS2-Richtlinie und Cyber Resilience Act PQC nicht explizit, doch die geforderte Langzeitsicherheit impliziert klaren Anpassungsbedarf. In Deutschland hat die Bundesregierung PQC als sicherheitskritisches Thema identifiziert (insbesondere für KRITIS-Organisationen) und empfiehlt die Migration ab 2026 einzuleiten.

Dr. Katrin Kobe, CEO von Bosch Quantum Sensing, spricht über Markt, Technik und Tempo.

Und wie sie mit dem Corporate Start-Up Quantensensorik vom Labor in skalierbare Produkte in den Bereichen Medizintechnik und Konsumgütern wächst. /// von Heiner Sieger

Frau Dr. Kobe, Bosch Quantum Sensing ist noch jung. Wie kam es zur Gründung – und warum als Corporate Start-Up?

Dr. Katrin Kobe | Bosch forscht seit mehr als zehn Jahren an Quantentechnologien, insbesondere an der Quantensensorik. Irgendwann war klar: Die Erkenntnisse müssen aus dem Labor in den Markt. Ein Corporate Start-Up ist dafür ideal, weil es die Agilität eines Start-Ups mit den Ressourcen, Kontakten und Qualitätsmaßstäben eines Konzerns verbindet. So treffen wir schnelle Entscheidun-

Welche Ziele verfolgen Sie – und wie übersetzen Sie Forschung in Produkte?

Dr. Katrin Kobe | Unser Ziel ist eine führende Position in der Quantensensorik, konkret mit NV-Technologie. Wir haben den Anspruch, Game Changer zu entwickeln: Lösungen, die die Lebensqualität der Menschen spürbar verbessern – im Sinne des Bosch-Mottos „Technik fürs Leben“. Der Weg dorthin hat zwei Ebenen. Erstens der Markt: Wir priorisieren nur Anwendungen mit klarem Kundennutzen und unterscheidbarem Mehrwert. Zweitens die Technik:

DIE GESPRÄCHSPARTNERIN

Dr. Katrin Kobe

Dr. Katrin Kobe ist promovierte Physikerin und CEO der Bosch Quantum Sensing GmbH. Sie startete ihre Karriere bei McKinsey und leitete anschließend Technologieunternehmen in verschiedenen Branchen (u. a. Optik, Sensorik, Anlagenbau, Energiewirtschaft).

Seit der Gründung führt sie Bosch Quantum Sensing und treibt die Kommerzialisierung von NV-basierter Quantensensorik voran.

gen, validieren Anwendungsfälle mit Kunden und bauen parallel robuste Lieferketten auf. Aus dieser Logik heraus haben wir gestartet und sind inzwischen als GmbH ausgegründet. Heute agieren wir eigenständig – mit dem starken Rücken eines globalen Technologieunternehmens.

Wo steht Bosch Quantum Sensing heute – noch Start-Up oder schon Grown-Up?

Dr. Katrin Kobe | Wir sind vor rund vier Jahren angetreten. Als „klassisches“ Start-Up sehen wir uns nicht mehr. Vieles ist professionalisiert: Strukturen, Qualität, Skalierbarkeit. Gleichzeitig bewahren wir die Geschwindigkeit und den Mut, Dinge iterativ zu testen. Diese Mischung aus Konzern-DNA und Start-Up-Spirit ist in der Quantensensorik ein echter Vorteil.

Aus metergroßen Laboraufbauten machen wir portable, robuste, kosteneffiziente Geräte. Es reicht nicht, der Beste im Labor zu sein. Produkte müssen zuverlässig funktionieren, bezahlbar sein und sich in großen Stückzahlen fertigen lassen und letztlich Kunden begeistern.

Was sind die größten Hürden beim Transfer vom Labor in die Industrie?

Dr. Katrin Kobe | Die härteste Nuss ist die Gleichzeitigkeit widersprüchlicher Anforderungen: maximale Messperformance, Miniaturisierung, Robustheit gegenüber Umwelteinflüssen, Energieeffizienz, Produktionsreife und ein marktgerechter Preis. Unser Team hat den Sensor auf Handygröße miniaturisiert, ohne die Messqualität zu opfern. Parallel haben wir an Stabilität, Kalibrierung, Tempe-

raturmanagement und optischer Anregung gearbeitet. Ein ebenso wichtiger Punkt ist die Lieferkette: Wir brauchen Bauteile, die es so nicht „von der Stange“ gibt. Das lösen wir über gezielte Partnerschaften.

Welche Meilensteine haben Sie in den vergangenen Jahren bereits erreicht?

Dr. Katrin Kobe | Die Miniaturisierung unseres NV-basierten Magnetometers ist ein zentraler Meilenstein – heute als funktionsfähiger Demonstrator erlebbar. Inhaltlich haben wir die relevantesten Anwendungsfelder identifiziert, Use Cases mit Kunden geschärft und Pilotierungen gestartet. Drei Fokusse bestimmen unsere Roadmap: Mobility, Medizintechnik und Exploration. In jedem dieser Bereiche testen oder planen wir Tests unter realen Bedingungen, ob der Sensor die geforderte Sensitivität, Auflösung und Robustheit liefert – und ob der Business Case trägt.

Können Sie konkrete Beispiele nennen, etwa im Bereich Mobility?

Dr. Katrin Kobe | Gemeinsam mit Airbus arbeiten wir am Thema Erdmagnetfeldnavigation. Hintergrund ist die Anfälligkeit von GNSS-Systemen durch Spoofing und Jamming. Magnetfeldbasierte Navigation ist unabhängig von Satellitensignalen und kann als robuste Backup-Lösung die Resilienz erhöhen – etwa in sicherheitskritischen Anwendungen. Für uns ist das ein Paradebeispiel: anspruchsvolle Technologie, hoher Sicherheitsnutzen, klarer Marktbedarf.

Wo sehen Sie die größten Märkte – heute und in Zukunft?

Dr. Katrin Kobe | Die größten Absatzmärkte erwarten wir in der Medizintechnik und bei Konsumgütern. In der Medizintechnik geht es um die berührungslose, hochsensitive Messung schwacher magnetischer Signale – perspektivisch bis hin zur Auswertung neuronaler Aktivitäten. Unsere Vision ist ein Brain-Computer-Interface: Nervensignale erfassen und in Bewegung oder Steuerbefehle übersetzen. Das ist ambitioniert und braucht Zeit, aber die technologischen Grundlagen sind vorhanden. Parallel prüfen wir Konsumgüteranwendungen, bei denen geringe Baugröße und niedrige Kosten zählen.

Welche Rolle spielen Partnerschaften – und wer ist besonders wichtig?

Dr. Katrin Kobe | Partnerschaften sind zentral. Quantensensorik ist Deep Tech an der Grenze des Machbaren. Viele Komponenten existieren nicht in Serienqualität oder -verfügbarkeit. Wir entwickeln das Ökosystem gemeinsam mit Partnern. Kooperationen beschleunigen Performance, Industrialisierung und Qualitätssicherung. Ein Schlüssel ist der Diamant mit NV-Zentren. Hier arbeiten wir mit Element Six zusammen, um Materialeigenschaften für optimale Sensoreigenschaften zu definieren und reproduzierbar zu fertigen. Um diese Zusammenarbeit noch mehr zu stärken, hat Bosch vor kurzem angekündigt, die Bosch Quantum Sensing GmbH als Joint Venture mit Element Six zu fortzuführen (vorbehaltlich behördlicher Genehmigun-

gen). Mit dieser intensivierten Partnerschaft baut Bosch seinen Technologievorsprung für die Kommerzialisierung der Quantensensorik.

Wann rechnen Sie mit marktreifen Produkten – und wie „startbereit“ sind Sie?

Dr. Katrin Kobe | Konkrete Daten nennen wir bewusst nicht. Rechnen Sie in den nächsten Jahren mit Produkten, die sich in großen Stückzahlen fertigen lassen. Der Reifegrad variiert je nach Anwendung: In manchen Piloten sind wir weit, in anderen am Anfang. Aus Start-Up-Perspektive wirken wir bereits „auf der Aschenbahn“, aus Konzernsicht „putzen wir noch die Startlöcher“. Beide Sichtweisen sind berechtigt – entscheidend ist, dass wir kontinuierlich technologische und kommerzielle Risiken abbauen.

Was fasziniert Sie persönlich an der Quantentechnologie?

Dr. Katrin Kobe | Mich begeistert Licht und Optik seit der Schulzeit. Ich habe in der Quantenoptik promoviert und konnte mich in verschiedenen Führungsrollen immer wieder dem Thema befassen. Jetzt habe ich die Möglichkeit, Grundlagenwissen, Unternehmertum und Kundennutzen zu verbinden – in einem Feld, das reale Probleme löst und neue Märkte schafft. Das ist ungemein motivierend.

Welche Fähigkeiten braucht es, um in diesem Umfeld erfolgreich zu sein – bei Ihnen und im Team?

Dr. Katrin Kobe | Visionäres Denken, Trendgespür und Kundennähe sind unverzichtbar – gepaart mit solidem technischem Verständnis. Genauso wichtig sind Ausdauer und Frustrationstoleranz. Nicht jeder Prototyp funktioniert auf Anhieb. Wer hier arbeitet, muss interdisziplinär denken, Hypothesen testen, aus Daten lernen und den Fokus auf den Kundennutzen bewahren. Diese Haltung gilt für Führungskräfte genauso wie für Entwicklerinnen, Entwickler und Business-Teams.

Wie gehen Sie mit Rückschlägen um – und was hält die Motivation hoch?

Dr. Katrin Kobe | Rückschläge gehören in Deep Tech dazu. Unsere Haltung: schnell erkennen, sauber analysieren, strukturiert lösen – und daraus einen Vorsprung machen. Jede Hürde, die wir nehmen, steht auch vor dem Wettbewerb. Was uns antreibt, ist die tägliche Herausforderung und der sichtbare Fortschritt. Wir schaffen keine Routineprodukte, sondern arbeiten an Neuem. Die Summe der kleinen Erfolge hält das Feuer am Brennen.

Was bedeutet all das für Sicherheit und Resilienz?

Dr. Katrin Kobe | Quantensensorik kann Sicherheitsarchitekturen robuster machen: etwa durch magnetfeldbasierte Navigation als Backup bei GPS-Störungen, durch kontaktlose, präzise Diagnostik in der Medizintechnik oder durch sensitive Anomalieerkennung in industriellen Umgebungen. Entscheidend ist, dass wir Technologien bauen, die nicht nur präzise sind, sondern auch zuverlässig, skalierbar und sicher in der Anwendung. •

Dennis Hoppe, Abteilungsleiter für Converged Computing am Höchstleistungsrechenzentrum Stuttgart, erklärt, wie nah Quantencomputing heute schon an industriellen Anwendungen ist, welche Branchen als erste profitieren und warum die Technologie kein Ersatz für klassische Rechnerarchitekturen ist, sondern ein strategischer Zusatznutzen für Unternehmen, um gezielt spezielle Problemstellungen zu lösen. /// von Heiner Sieger

DAS HÖCHSTLEISTUNGSRECHENZENTRUM STUTTGART (HLRS) unterstützt seit Jahrzehnten Industrieunternehmen dabei, komplexe Probleme mithilfe von Supercomputern zu lösen. Dies reicht von der Simulation neuer Materialien und Materialeigenschaften, über die Optimierung von Fertigungsprozessen bis hin zu Nachhaltigkeitsaspekten (Stichwort: Energieeffizienz). Mit industrienahen Forschungsprojekten wie SEQUOIA hat das HLRS frühzeitig seine Expertise im Bereich Quantencomputing erweitert. Zielstellung des HLRS ist es dabei klassische Höchstleistungsrechner und neuartige Quantenprozessoren so zu kombinieren, dass Unternehmen in Zukunft dank hybrider Workflows von völlig neuen Rechenkapazitäten profitieren können.

DER GESPRÄCHSPARTNER

Dennis Hoppe

Abteilungsleiter für Converged Computing am Höchstleistungsrechenzentrum Stuttgart

Herr Hoppe, wie integriert das HLRS Quantencomputing in sein bestehendes Portfolio an Höchstleistungsrechenressourcen? Sehen Sie Quantencomputer als Ergänzung oder als künftigen Ersatz?

Dennis Hoppe | Quantencomputer sind aus unserer Sicht keine Ablösung, sondern eine vielversprechende Ergänzung zu klassischen Höchstleistungsrechnern; insbesondere in sehr spezifischen Anwendungsfeldern, die von einer sehr schnellen Lösung von Optimierungsproblem profitieren können. Hierbei werden sicherlich klassische HPC-Systeme im kommenden Jahrzehnt weiterhin die Basis für die überwiegende Mehrheit wissenschaftlicher und industrieller Anwendungen stellen. Gleichzeitig beobachten wir, dass sich für bestimmte Problemklassen,

beispielsweise bei komplexen Optimierungsaufgaben oder in der Materialforschung neue Potenziale durch Quantenalgorithmen eröffnen.

Am HLRS interessieren wir uns daher besonders für hybride Ansätze, bei denen sich Quantencomputer als spezialisierte Co-Prozessoren innerhalb komplexer HPC-Workflows einsetzen ließen. So, wie sich vor einigen Jahren GPUs als Beschleuniger für KI-Anwendungen etabliert haben, könnten in Zukunft auch Quantenprozessoren als weitere Beschleunigerklassen in heterogenen Rechnerarchitekturen eine Rolle spielen. Für uns ist es wichtig zu verstehen, wie diese Integration gelingen kann. Nicht nur technologisch, sondern auch organisatorisch.

Das SEQUOIA-Projekt verfolgte das Ziel hybrider Rechenansätze aus HPC und Quantencomputing. Welche Herausforderungen und Chancen sehen Sie dabei? DH | Die größte Herausforderung, insbesondere hybrider Ansätze, liegt meiner Meinung nach aktuell auf der Software- und Schnittstellenebene. Es fehlt an durchgängigen Programmiermodellen und Middleware-Lösungen, die klassische HPC-Systeme und Quantenprozessoren nahtlos miteinander verbinden. Das betrifft nicht nur die Entwicklung geeigneter Algorithmen, sondern auch die Frage, wie Workflows orchestriert werden können, die über sehr unterschiedliche Hardwareplattformen hinweg effizient und robust laufen. Gleichzeitig liegt genau darin eine enorme Chance: Wenn es gelingt, Quantenrechner gezielt dort einzusetzen, wo sie einen echten Vorteil bieten. Etwa bei kombinatorischer Optimierung oder in der Simulation quantenmechanischer Systeme können wir neue Rechenpfade erschließen, die heute noch verschlossen sind. Hierbei ist es zentral, dass man sich nicht nur theoretisch mit dem Thema Quantencomputing beschäftigt, sondern an konkreten industriellen Problemstellungen arbeitet, um Mehrwerte aufzuzeigen. Und genau hier haben die SEQUOIA Projekte angesetzt: Sie boten uns und den Projektpartnern ein Experimentierfeld, um den industrieorientierten Nutzen beim Einsatz von QC-Lösungen zu evaluieren.

Wie nah ist das HLRS daran, industrielle Anwendungen mit Quantencomputern zu unterstützen – und in welchen Branchen erwarten Sie die frühesten Vorteile?

DH | Für das Ingenieurwesen ist Quantencomputing besonders spannend. Insbesondere dort, wo klassische Methoden heutzutage an ihre Grenzen stoßen, etwa beim Lösen komplexer, nichtlinearer Differentialgleichungen. In Bereichen wie der Strömungssimulation oder Materialmodellierung könnten Quantenalgorithmen langfristig völlig neue Effizienzgewinne ermöglichen. Zwar sind diese Ansätze heute noch überwiegend experimentell und auf sehr kleine Systeme beschränkt, aber sie zeigen ein enormes Zukunftspotenzial. Unser Ziel am HLRS ist es daher, diesen Entwicklungen frühzeitig zu folgen und sie gezielt in hybride Workflows einzubetten. Die nächsten Jahre werden entscheidend sein: Gelingt es, konkrete Anwendungsfälle im Ingenieurkontext zu identifizieren und belastbare Pilotprojekte aufzubauen, könnte Quantencomputing zu einem echten Innovationsmotor werden.

Welche Rolle spielen Kooperationen mit Forschungseinrichtungen, Industriepartnern und anderen HPC-Zentren? DH | Kooperationen sind für uns ein zentrales Mittel, um neue Technologien wie KI und Quantencomputing in Forschung und Industrie voranzubringen. Kein Spieler kann diese technisch komplexen Felder allein erschließen, es braucht immer ein starkes Team. Deshalb arbeiten wir am HLRS mit einer Vielzahl von Akteuren zusammen, zu dem in erster Linie auch Hardware-Hersteller gehören, um Zugang zu neuen Architekturen zu erhalten, mit

Software-Start-ups, die innovative Frameworks liefern, und mit Industrieunternehmen, die reale Use Cases definieren. Gleichzeitig ist die Vernetzung mit europäischen HPC-Zentren entscheidend, um Synergien zu nutzen. Projekte wie EuroCC oder CASTIEL, aber auch die AI Factory HammerHAI, die allesamt die europäische Expertise bündeln und einen europaweiten Wissenstransfer ermöglichen, sind hier von großer Bedeutung.

Wenn Sie auf die Entwicklung der Quantenhardware in den nächsten fünf Jahren blicken: Welche Voraussetzungen müssen erfüllt sein, damit Quantencomputing breit genutzt werden kann?

DH | In den nächsten fünf Jahren erwarten wir Fortschritte hin zu Quantencomputern mit Hunderten bis möglicherweise Tausenden Qubits. Doch die entscheidenden Herausforderungen liegen weniger in der reinen Qubit-Zahl, sondern in der Qualität der Systeme. Die wesentlichen Hürden bleiben die Verschränkung der Qubits und die Fehlerkorrektur: Nur mit zuverlässigen, reproduzierbaren Ergebnissen wird Quantencomputing breit anwendbar sein. Neben der Hardware müssen auch die Integration in bestehende Rechenumgebungen und die Entwicklung einheitlicher, standardisierter Schnittstellen vorangetrieben werden. Sowohl für Forschungseinrichtungen als auch Unternehmen ist zudem ein gezielter Aufbau von Kompetenzen entscheidend. Deshalb ist es nicht nur für Forschende, sondern auch für Unternehmen wichtig, sich jetzt aktiv vorzubereiten, um den Anschluss nicht zu verpassen und die Chancen dieser Technologie frühzeitig nutzen zu können. •

Fraunhofer IPA forscht an Quantentechnologien für Prothesensteuerung und neue Point-of-Care-Diagnostik. Fraunhofer-Experte Dr. Urs Schneider erklärt, wie Quantensensorik neue Möglichkeiten in Diagnostik, Therapie und Rehabilitation eröffnet. /// von Heiner Sieger

Herr Dr. Schneider, Quantentechnologien gelten als großes Innovationsfeld. Wo sehen Sie die stärksten Anknüpfungspunkte und Potenziale speziell für die Medizintechnik?

Dr. Urs Schneider | Biologische Prozesse laufen physikalisch-chemisch ab. Elektrisch geladene Moleküle ändern ihre Zustände, Informationen werden elektrisch weitergegeben. Damit arbeitet die Biomedizin seit Langem und versteht die Zusammenhänge immer besser. Wenn wir durch hoch empfindliche Magnetfeldsensoren Zustände

wa die Gruppe von Prof. Fedor Jelezko, wie sich laufende Stoffwechselprozesse von lebenden Zellen und Geweben analysieren lassen. Und bei NVision entstehen bereits kommerzielle Messmethoden, die Tumorgewebe in der Bildgebung trennscharf von gesundem Gewebe unterscheiden können – mithilfe sogenannter Hyperpolarisatoren. Mit Hyperpolarisations-MR-Tomographie lassen sich experimentell bereits pH-Wert-Verschiebungen in der Niere sichtbar machen – ein großer Schritt in der funktionellen Nierendiagnostik.

DER GESPRÄCHSPARTNER

Dr. Urs Schneider ist Abteilungsleiter für Biomechatronische Systeme am Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA in Stuttgart. Er forscht an innovativen Technologien für Medizintechnik und Rehabilitation. Heute gilt er als einer der führenden Experten in der Anwendung von Quantensensorik für die Medizin.

” Wenn wir durch hoch empfindliche Magnetfeldsensoren Zustände und Signale in der Natur immer sensibler messen können, entsteht neues Wissen über biologische Zusammenhänge, dass wir zur Gesunderhaltung, Diagnostik und Therapie einsetzen können. Dr. Urs Schneider

und Signale in der Natur immer sensibler messen können, entsteht neues Wissen über biologische Zusammenhänge, dass wir zur Gesunderhaltung, Diagnostik und Therapie einsetzen können.

Stuttgart ist dabei ein besonderer Ort:

Durch die Erkenntnisse von Prof. Jörg Wachtrup, Stickstofffehlstellen in Kohlenstoff-Atomen als „Quanten-Magnetometer“ zu nutzen, hat sich hier eine führende Rolle entwickelt. Stuttgart und Ulm sind durch intensive Forschung und das Kompetenzzentrum für Quantensensorik QSENS zu Hotspots geworden. In Ulm erforscht et-

Welche weiteren Möglichkeiten eröffnet die Quantensensorik?

Dr. Urs Schneider | Neben solchen Erkenntnissen auf biologischer Strukturebene können sehr sensible Magnetometer seit Längerem elektrische Phänomene des Gehirns, des Herzens, der Nerven und Muskeln detektieren. SQUIDs (Superconducting Quantum Interference Devices) kommen etwa in der Forschungsgruppe von Prof. Markus Siegel am Magnetoenzephalographie-Zentrum in Tübingen zum Einsatz.

Mit optisch gepumpten Magnetometern (OPMs) haben Prof. Siegel und sein Kollege Justus Marquetant den

Stromverlauf in Nerven in Echtzeit am Arm zeigen können.

Wie bringt sich das Fraunhofer IPA in diese Forschung ein?

Dr. Urs Schneider | Wir am Fraunhofer IPA forschen seit mehr als 20 Jahren an verbesserten Rehabilitationstechniken für Menschen mit Behinderungen. Unser Neuromechanik-Experte Dr. Leonardo Gizzi arbeitet gemeinsam mit der Bewegungswissenschaftlerin Verena Kopp und dem Medizintechnikexperten Duc Nguyen in zwei faszinierenden Bereichen: zum einen an der Nutzung von in Echtzeit gemessenen Magnetfeldern elektrisch aktivierter Muskeln zur Ansteuerung von Prothesen, zum anderen an der Diagnostik von Herzrhythmusstörungen durch magnetische Zusatzinformationen zum herkömmlichen EKG.

Was ist der Vorteil dieser Ansätze?

Dr. Urs Schneider | Beide Themen vereint zweierlei: Erstens sind magnetische Informationen potentiell präziser anatomisch zuordenbar, da sie örtlich besser auflösen als elektrische Informationen. Das sehen wir bereits beim Gehirn: Ein SQUID-MEG liefert präzisere lokale Funktionsinformationen als ein EEG an derselben Person. Zweitens braucht die Messung von Magnetfeldern keinen „galvanischen“ Gewebekontakt wie EMG, EKG oder EEG. Diese Verfahren sind etabliert, haben aber Nachteile: Rasur für bessere Signale, abfallende Elektroden bei Schweißbildung, Fehlmessungen.

Warum rückt das Thema gerade jetzt in den Fokus?

Dr. Urs Schneider | Magnetische Signale im Körper sind extrem schwach. Mit OPMs und NV-Sensoren sind jedoch portable Geräte immer besser denkbar. Denn ein SQUIDMEG benötigt eine spezielle, mit µ-Metall abgeschottete Umgebung, um Störungen etwa durch das Erdmagnetfeld auszuschließen – das ist stärker als das Muskelsignal! Immer wenn portable Lösungen in der Medizin denkbar wurden, sind neue Märkte für Point-of-Care-Geräte entstanden.

An welchen Projekten arbeiten Sie aktuell?

Dr. Urs Schneider | Im QSENS-Cluster forschen wir an der Nutzung quantensensorisch gemessener Muskelsignale, um eines Tages hochsensibel und kontaktlos Armprothesen anzusteuern. Mit OPM-Sensoren konnten Dr. Gizzi und Dr. Marquetant bereits einen Nachweis im Projekt erbringen. Auch Prof. Soekadar, Lehrstuhlinhaber für Neurotechnologien an der Charité, forscht seit Langem mit seinem Team an der Messung von Gehirnsignalen mit unterschiedlichen Magnetfeldsensoren.

Im Projekt „Vital@ Quantensensorisch Arrhythmiediagnostik“ arbeiten wir an der kontaktfreien Detektion von Herzrhythmusstörungen, gefördert vom Land BadenWürttemberg. Einen Demonstrator zeigen wir erstmals auf der Messe Quantum Effects.

Wie wichtig ist Vernetzung in diesem Feld?

Dr. Urs Schneider | Die Forschung ist hochgradig interdisziplinär und lebt von einer engen internationalen Zusammenarbeit. Nur so lassen sich Erfolge erzielen. QSENS ist eine große, einzigartige Forschungsfamilie unter der koordinierenden Leitung von Prof. Jens Anders.

Für Baden-Württemberg sind Quantencomputing und Quantensensorik erklärte Standortstrategie. Mit der Messe Quantum Effects gibt es dafür den zentralen Marktplatz. Dass die Medizintechnik dabei ein fester Bestandteil ist, freut uns sehr – auch im dritten Jahr. Austausch und Vernetzung sind für uns entscheidend. •

Das Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA zählt mit über 1.000 Mitarbeitenden zu den größten Instituten der FraunhoferGesellschaft. Neben Produktionstechnik und Automatisierung ist die Biomedizintechnik ein wichtiger Forschungsschwerpunkt. Im Bereich Quantentechnologie konzentriert sich das IPA insbesondere auf Quantensensorik – also die hochsensible Messung magnetischer Signale im Körper. Projekte wie QSENS oder Vital@ Quantensensorisch Arrhythmiediagnostik verknüpfen Grundlagenforschung mit klinischen Anwendungen. Ziel ist es, neue Verfahren für Diagnostik, Therapie und Rehabilitation zu entwickeln und in die Praxis zu übertragen

Die Logistikbranche steht vor einem tiefgreifenden Wandel. Mit den rasant fortschreitenden technologischen Entwicklungen rückt künstliche Intelligenz in den Fokus als ein entscheidender Faktor für Effizienz und Innovation. Gerade in der Digitalisierung der Wertschöpfungsketten eröffnet die KI neue Möglichkeiten, Prozesse zu optimieren und die Kundenzufriedenheit zu steigern. /// von Konstantin Pfliegl

DIE LOGISTIKBRANCHE IST SEIT JEHER EIN WESENTLICHER

BESTANDTEIL DER GLOBALEN WIRTSCHAFT. Mit der zunehmenden Globalisierung und den Anforderungen der digitalen Ära steht sie jedoch vor neuen Herausforderungen und Chancen. Eine der vielversprechendsten Entwicklungen in diesem Bereich ist der Einsatz von künstlicher Intelligenz (KI). Die Technologie hat das Potenzial, nicht nur die Effizienz, sondern auch die Nachhaltigkeit und Kundenzufriedenheit in der Logistik auf ein neues Level zu heben.

Logistikplanung und -optimierung

Eine der spannendsten Einsatzgebiete von KI in der Logistik ist die Optimierung von Routen und Lieferketten. Durch den Einsatz von Algorithmen können Unternehmen den idealen Weg zur Auslieferung von Waren bestimmen, basierend auf einer Vielzahl von Variablen wie Verkehrslage, Wetterbedingungen und historischen Lieferdaten. Dies führt nicht nur zu Kosteneinsparungen, sondern reduziert auch die Kohlenstoffemissionen, was in Anbetracht der

globalen Bemühungen zur Reduzierung des ökologischen Fußabdrucks von unschätzbarem Wert ist.

Automatisierung und Effizienzsteigerung und Lagern In Lagerhäusern findet man zunehmend autonome Roboter und automatisierte Systeme, die KI nutzen, um Bestandsverwaltung und Kommissionierung effizienter zu gestalten. Diese Systeme können nicht nur die Platzierung und Entnahme von Waren automatisieren, sondern auch den Bestand in Echtzeit überwachen und so Engpässe oder Überbestände vermeiden.

Prognose und Nachfrageplanung

KI-gestützte Analyse-Tools erleichtern es Logistikunternehmen, Nachfrageprognosen präziser zu gestalten. Durch die Analyse von Verkaufsdaten, saisonalen Trends und externen Marktfaktoren, können Unternehmen ihre Lagerhaltung und Produktion anpassen, um Überproduktion oder -bestände zu vermeiden. Diese präzisen Prognosen helfen

” Künstliche Intelligenz hat das Potenzial, nicht nur die Effizienz, sondern auch die Nachhaltigkeit und Kundenzufriedenheit in der Logistik auf ein neues Level zu heben. Konstantin Pfliegl

PRAXISBEISPIEL I:

ROBOTER BEI AMAZON

In vielen Amazon-Logistikzentren arbeiten Roboter und Menschen Hand in Hand, um Produkte zu finden, zu sortieren, zu transportieren und einzulagern.

Amazon begann bereits im Jahr 2012 mit dem Einsatz von Robotertechnik. Heute setzt der Onlineriese auf verschiedene Arten von Robotern. Palettierroboter sind Roboterarme mit Greifern, die Produkte auf Fließbändern erkennen und sie herunterheben, um sie zum Versand oder zur Lagerung auf Paletten zu stapeln. Eine andere Art von Roboter, der Robo-Stow, hebt Warenpaletten auf verschiedene Ebenen des Logistikzentrums oder platziert sie auf Transporteinheiten, damit diese sie an ihr nächstes Ziel befördern.

Im Mai dieses Jahres stellte Amazon mit Vulcan den ersten RoboterHelfer mit Tastsinn vor. Im Lager Winsen bei Hamburg ist Vulcan bereits im Einsatz. Der Roboter kommissioniert und verstaut Waren in den obersten Reihen der Lagerregale. Da diese Reihen rund 2,5 Meter hoch sind, benutzen Mitarbeiter bislang eine Trittleiter, um sie zu erreichen. Das ist zeitaufwändig, anstrengend und weniger ergonomisch als das Einlagern und Kommissionieren in Hüfthöhe. Vulcan verarbeitet auch Artikel, die direkt über dem Boden gelagert sind, sodass die Mitarbeiter dort arbeiten können, wo es für sie am bequemsten ist.

Amazon Vulcan:

Der Roboter-Helfer verfüggt sogar über einen Tastsinn. (Bild: Amazon)

Unternehmen nicht nur, Kosten zu sparen, sondern auch, besser auf plötzliche Marktnachfragen reagieren zu können.

Verbesserung des Kundenservices

In der digitalen Welt von heute erwarten Kunden Transparenz und Echtzeit-Informationen über ihre Bestellungen. KI-gestützte Chatbots und virtuelle Assistenten haben den Kundenservice revolutioniert, indem sie schnelle Antworten auf Anfragen geben und detaillierte Trackings zur Verfügung stellen. So wird das Kundenerlebnis verbessert sowie die Kundenzufriedenheit erhöht. Darüber hinaus ermöglichen KI-Systeme eine Personalisierung der Dienstleistungen und liefern personalisierte Empfehlungen basierend auf dem individuellen Kundenverhalten.

Sicherheits- und Risikomanagement

Ein oft übersehener, jedoch kritischer Aspekt ist der Einsatz von KI zur Verbesserung der Sicherheit und des Risikomanagements in der Logistik. Dies reicht von der Überwachung

der Sicherheit in Lagern bis hin zur Implementierung von Alarmsystemen, die potenzielle Bedrohungen durch Datenanalysen frühzeitig erkennen können.

Künstliche Intelligenz steht zweifelsohne im Zentrum der Transformation der Logistikbranche. Ihre Fähigkeit, komplexe Prozesse zu analysieren und Muster zu erkennen, ermöglicht eine bislang unerreichte Effizienz und Flexibilität in allen Prozessschritten der Lieferkette. Unternehmen, die sich dieser Technologie widmen und den kulturellen Wandel annehmen, können nicht nur ihre Wettbewerbsfähigkeit steigern, sondern auch den Weg für eine nachhaltigere und innovativere Logistikindustrie ebnen. Die Zukunft der Logistik ist digital und intelligent – und künstliche Intelligenz wird dabei die Schlüsselrolle spielen.

Trotz der Vorteile von künstlicher Intelligenz gibt es aber auch Herausforderungen und ethische Überlegungen: Datenschutz, Arbeitsplatzverluste durch Automatisierung und die Notwendigkeit zur Weiterbildung der Belegschaft sind bedeutende Themen, die angegangen werden müssen, um einen verantwortungsvollen und nachhaltigen Einsatz von KI in der Logistik zu gewährleisten. •

PRAXISBEISPIEL II:

KI AUF DER LETZTEN MEILE BEI DHL

Ob Routenoptimierung oder Kraftstoffeffizienz – der Logistiker DHL setzt bereits umfassend auf künstliche Intelligenz.

KI-Prognosemodelle liefern bei DHL Daten zu einzelnen Sendungen, die mithilfe einer KI-gestützten Software für die Routenoptimierung weiterverarbeitet werden. Das System berücksichtigt alle wichtigen Variablen für die bestmögliche Routensequenz und der Kunde erhält Informationen über die voraussichtliche Lieferzeit, die immer präziser wird, je näher das Lieferfahrzeug kommt. Bis zur Lieferung kann der Kunde noch Änderungswünsche vornehmen, etwa zur Lieferzeit oder zum Lieferort.

Eine optimierte Route vermeidet zudem zusätzliche Fahrten und unnötige Stopps und trägt so zum effizienten Kraftstoffverbrauch bei. Zusätzlich tragen eine KI-gestützte Fahrtenanalyse und Fahrverhaltenanalyse, zum Beispiel zu Leerlaufzeiten, zur Effizienzsteigerung bei.

DHL:

Künstliche Intelligenz optimiert die Letzte-Meile-Lieferung.

(Bild: DHL Group)

Zwischen KI-Hype und Stillstand haben viele mittelständische Unternehmen Angst, etwas zu verpassen. Dagegen hilft ein einfacher Einstieg in die Welt der künstlichen Intelligenz. KI-Agenten sind dafür die praktische Lösung: Sie nehmen Routinen ab, bringen Ordnung in Abläufe und zeigen sofort Wirkung. /// von Gherdi Glaser

KI KANN EIN WICHTIGER BESTANDTEIL UNSERES ALLTAGS WERDEN: Ob in Meetings, in Mails, im Kopf: der ständige Helfer steht eigentlich mit der KI bereit. Trotzdem bekomme ich immer wieder mit, wie gerade Unternehmen Probleme haben, KI in ihren Unternehmen sinnvoll einzusetzen. Aktuelle Studien belegen dieses Gefühl: 57 Prozent der Firmen beschäftigen sich mit KI, 20 Prozent nutzen sie, 37 Prozent planen und doch bleibt vieles nur Theorie. 2025 meldet die Deutsche Industrie- und Handelskammer (DIHK), dass nur mehr als jeder Dritte KI nutzt. Der Rest schaut zu und riskiert abgehängt zu werden. Das kann man als „FOMO” in Zahlen bezeichnen – „Fear of Missing Out“, also die Angst, etwas zu verpassen.

Doch wie ist die Angst zu lösen? Es klingt profan: klein anfangen statt groß zu denken. Kleine und wiederkehrende Tätigkeiten statt Großprojekte. Wer so denkt, stößt schnell darauf, dass es für kleinere Aufgaben eine spezielle Hilfe gibt. Und das sind KI-Agenten, die lästige Aufgaben in Unternehmen ganz einfach abnehmen können. Ein KI-Agent ist ein Softwaresystem, das auf Large Language Models basiert. Am besten kann man sich KI-Agenten wie einen digitalen Kollegen vorstellen: Er verfolgt ein Ziel, arbeitet Aufgaben Schritt für Schritt ab, fragt bei Unsicherheiten nach und hält alles sauber fest. Er wird nie müde, vergisst nichts und schafft damit eine Verlässlichkeit, die in vielen Firmen fehlt. Dieses Prinzip ist Teil des sogenannten „Agentic Approach“. Statt dass ein

einzelnes KI-Tool nur Antworten liefert, arbeiten mehrere spezialisierte Agenten zusammen wie ein eingespieltes Team. Genau dieses Zusammenspiel eröffnet dem Mittelstand völlig neue Möglichkeiten.

Warum KI-Agenten für den Mittelstand gut sind Im Mittelstand fehlen oft die großen IT-Teams und Budgets, um komplette Systeme neu aufzubauen. Prozesse hängen stark von einzelnen Personen ab, und wenn jemand krank wird oder das Unternehmen verlässt, gerät der Ablauf ins Stocken. Gleichzeitig steigt der Druck, weil Kunden schnelle Reaktionen erwarten, Fachkräfte schwer zu finden sind und je-

DER AUTOR

fehlen, bleibt die Arbeit nicht liegen. Denn Routineaufgaben erledigen die Agenten, während sich die Kollegen auf Sonderfälle und wichtige Entscheidungen konzentrieren können.

Der Effekt im täglichen Arbeiten Am deutlichsten zeigt sich der Nutzen von KI-Agenten in typischen Alltagssituationen. Wie das konkret aussieht, zeigen folgende drei Situationen:

1. Onboarding ohne Ping-Pong: Wer neue Mitarbeitende einarbeitet, kennt das - Formulare fehlen, Unterschriften kommen zu spät, Zugänge lassen auf sich warten. Ein KI-Agent übernimmt diese Schritte. Er sammelt die nötigen Angaben ein, legt

Gherdì Glaser ist Innovation Manager bei NTT DATA Business Solutions und Corporate Influencer für künstliche Intelligenz. Er verbindet Data-Science-Expertise mit den Möglichkeiten generativer KI, um praxisnahe Lösungen für den Mittelstand zu entwickeln. Sein Ziel: Geschäftsprozesse neu denken, Mehrwert aus Daten schaffen und eine verantwortungsvolle KI-Kultur etablieren.

der Fehler Zeit und Vertrauen kostet. Genau hier helfen KI-Agenten. Für den Mittelstand bedeutet das weniger wiederkehrende Arbeiten, mehr Zeit für Kunden, Produkte und Entscheidungen. KI-Agenten springen nicht ständig zwischen verschiedenen Programmen, sondern arbeiten Aufgaben Schritt für Schritt ab. Jede Aktion wird automatisch dokumentiert, die Übergaben laufen geordnet ab. So entsteht weniger Doppelarbeit, weniger Nacharbeit und mehr Klarheit, wer wofür zuständig ist. Selbst wenn Mitarbeitende einmal

das Nutzerkonto an, beantragt Berechtigungen, trägt die ersten Zeiten ein und erstellt ein Protokoll. Wichtige Schritte bleiben natürlich freigabepflichtig. Das Ergebnis sind weniger Nachfragen, klare Übersicht und ein schneller Start.

2. Einkauf ohne Dauerabgleich: Im Einkauf stapeln sich oft Bestätigungen und Angebote, die mühsam abgeglichen werden müssen. Preise, Mengen, Liefertermine und jede Abweichung kostet Zeit. Genau hier springen KI-Agenten ein. Sie glei -

chen Positionen automatisch ab, fordern fehlende Informationen ein und melden sich nur dann, wenn wirklich etwas nicht passt. Menschen müssen erst dann entscheiden, wenn ihre Erfahrung gebraucht wird.

3. Produktion ohne Zettelchaos: Auch in der Produktion steckt viel Routine. Prüfschritte werden notiert, Abweichungen weitergegeben, manchmal gehen sogar Informationen dabei verloren. Ein KI-Agent liest die Stückliste, prüft Abweichungen, stellt gezielte Rückfragen und erstellt das Prüfprotokoll automatisch. So läuft der Prozess gleichmäßig, und die Daten sind jederzeit vollständig abrufbar.

„Klingt nett – und sicher?“

KI-Agenten funktionieren jedoch nur mit klaren Spielregeln. Drei einfache Prinzipien reichen bereits aus, um sicher zu starten. Und die sollte auch jeder beachten, damit kein Schaden entsteht.

Erstens: Zugriffsrechte begrenzen. Ein Agent soll nur auf die Daten und Systeme zugreifen, die er für seine Aufgabe wirklich braucht. Dieses Prinzip nennt sich „Least Privilege“. Es schützt sensible Informationen und macht die Abläufe leichter kontrollierbar.

Zweitens: Jeden Schritt dokumentieren. Damit immer nachvollziehbar bleibt, was der KI-Agent getan hat, läuft ein Protokoll mit. In der Fachsprache heißt das „Audit-Trail“. Es ist nichts anderes als ein lückenloses Logbuch: Wer hat wann welche Aktion ausgelöst und mit welchem Ergebnis.

Drittens: Freigaben festlegen. Manche Aufgaben dürfen nicht komplett automatisch laufen. Gerade dort, wo rechtliche oder finanzielle Konsequenzen entstehen, braucht es ein „Okay“ vom Menschen. Diese Freigabe ist schnell gegeben, sorgt aber für Sicherheit und Vertrauen.

Mehr braucht es nicht. Mit diesen drei Regeln arbeiten KI-Agenten verlässlich, nachvollziehbar und im Einklang mit den EU-Vorgaben. In Gesprächen höre ich häufig die Sorge, dass ohne eine große Governance-Struktur gar nichts geht. Meine Erfahrung zeigt, dass sobald diese drei Prinzipien klar sind, sich Fachbereiche viel schneller trauen, die ersten Prozesse wirklich abzugeben. Die anfängliche FOMO ist unbegründet ist – KI-Agenten einzusetzen ist oft deutlich unkomplizierter, als man zunächst denkt.

Legt jetzt los!

Wir halten fest: Der KI-Hype sorgt für Unsicherheit – doch die lähmt uns nur. Diese Unsicherheit ist Teil der KI-FOMO im Mittelstand: Man spürt den Druck, etwas zu verpassen, hat gleichzeitig aber Angst vor den Risiken und der Komplexität von KI. Wer wartet, verliert wertvolle Zeit. KI-Agenten sind kein Zukunftsprojekt, sondern ein sofort nutzbarer Helfer für den Mittelstand. Sie starten klein, wirken schnell und schaffen Strukturen, auf denen sich aufbauen lässt.

Wer heute die ersten Routinen abgibt, lernt morgen, ganze Prozesse zu gestalten. Also: Nicht länger zögern –legt jetzt los. •

” Wer wartet, verliert wertvolle Zeit. KI-Agenten sind kein Zukunftsprojekt, sondern ein sofort nutzbarer Helfer für den Mittelstand. Sie starten klein, wirken schnell und schaffen Strukturen, auf denen sich aufbauen lässt. Gherdi Glaser

Der EU AI Act ist das weltweit erste umfassende Gesetz zur Regulierung künstlicher Intelligenz. Ziel ist es, Risiken zu minimieren und gleichzeitig Innovationen zu ermöglichen. Für viele mittelständische Unternehmen gilt: Die eingesetzten KI-Anwendungen fallen oft in die Kategorien mit geringem oder begrenztem Risiko. /// von Janek Kuberzig und Fritz-Ulli Pieper

Überblick:

Geringes und begrenztes Risiko

Der AI Act stuft KI-Systeme in vier Risikoklassen ein:

• Unannehmbares Risiko – verboten (z. B. soziale Bewertung durch den Staat)

• Hohes Risiko – strenge Anforderungen (z. B. KI in Medizin oder kritischer Infrastruktur)

• Begrenztes Risiko – Transparenzpflichten (z. B. Chatbots, die klar erkennbar als KI kommunizieren)

• Geringes Risiko – nahezu keine Vorgaben

KMUs sind häufig Anwender von KI-Systemen oder KI-Modellen und unterliegen damit regelmäßig geringeren Verpflichtungen. Dies gilt etwa beim internen Einsatz von KI-Chatbots wie Claude und Midjourney oder eines KI-Systems zur Optimierung von Produktionsprozessen wie der Steuerung von Maschinen oder der Verbesserung von Wartungsplänen. Anwender müssen hier keine umfassenden Pflichten aus dem AI Act erfüllen. Unternehmen müssen lediglich dokumentieren, welche Systeme sie einsetzen, deren Ergebnisse regelmäßig prüfen und sicherstellen, dass sie nicht unbemerkt im Anwendungsbereich in regulierte Bereiche übergehen.

1. Transparenz und Dokumentation verbinden: Machen Sie für Kunden und Mitarbeitende sichtbar, wenn KI im Einsatz ist. Halten Sie intern fest, welche Tools genutzt werden, zu welchem Zweck und mit welchen Eingaben. Eine einfache Tabelle oder ein gemeinsames Dokument genügt oft, um Transparenz- und mögliche Nachweispflichten zu erfüllen.

2. Mitarbeitende gezielt schulen: Passen Sie Schulungen an die jeweilige Rolle im Unternehmen an: Büro- und Servicekräfte sollten wissen, wie sie KI-Chatbots korrekt ansprechen, Ergebnisse prüfen und Eingabe von sensiblen Daten vermeiden. Die IT-Abteilung hingegen braucht tiefere Kenntnisse zur Integration der KI-Systeme in bestehende Prozesse sowie zu Schnittstellen und Sicherheitsaspekten. So lernt jede Zielgruppe genau das, was für ihre Arbeit mit KI relevant ist.

3. Verantwortlichkeiten klar festlegen: Ernennen Sie KI-Beauftragte, die neue gesetzliche Entwicklungen beobachten, den Überblick über alle eingesetzten Systeme behalten und Ansprechpersonen für interne Rückfragen sind. In kleinen Betrieben kann dies auch Teil der Aufgaben einer IT- oder datenschutzverantwortlichen Person sein.

Zukunftsausblick:

Wichtige Fristen kennen

Die Vorschriften treten gestaffelt in Kraft. Seit dem 2. Februar dieses Jahres gilt das Verbot für KI-Systeme mit unannehmbarem Risiko. Die Vorschriften für KI-Modelle mit allgemeinem Verwendungszweck gelten seit dem 2. August 2025. Die Anforderungen an Hochrisiko-Systeme werden zum 2. August 2026 wirksam. Der AI-Act ist damit weniger ein Innovationshemmnis, sondern vielmehr ein Rahmen für den verantwortungsvollen Einsatz von KI. Gerade KMUs können daraus als Anwender einen Wettbewerbsvorteil ziehen, weil Anbieter von KI-Systemen Vertrauen schaffen und rechtliche Sicherheit bieten müssen. Für KMUs bedeutet das: Wer jetzt Transparenz, Dokumentation und klare Verantwortlichkeiten verankert, stellt sich als Unternehmen zukunftsfähig auf. •

DIE AUTOREN

Janek Kuberzig (l.) ist Public Affairs Manager Data & (Future) Tech beim Bundesverband Digitale Wirtschaft (BVDW) e. V. (Bild: Janek Kuberzig)

Fritz-Ulli Pieper, LL.M. ist Rechtsanwalt bei Taylor Wessing sowie Lableiter im Lab „Künstliche Intelligenz: Responsibility“ beim BVDW. (Bild: Taylor Wessing)

Rund 70 % aller Beschäftigten in Deutschland nutzen laut KPMG frei zugängliche KI-Anwendungen. Oft unbewusst und ohne Rücksprache mit der IT. Ein Risiko für sensible Daten. Mit BusinessGPT bringt der SofwareDistributor MRM eine Private AI und KI-Firewall in den Markt, die Produktivität und Sicherheit vereint und Datensouveränität gewährleistet. von Angelika Mühleck

Ungeregelte KI-Nutzung im Arbeitsalltag

Ob für die interne Präsentation der Jahreszahlen, schnelle Analysen, Content Creation oder die Angebots-Email an den Großkunden: KI ist Teil des Arbeitsalltags. Doch wenn Mitarbeitende frei verfügbare Systeme wie ChatGPT, Claude, deepseek und Übersetzungsdienste nutzen, geraten sensible Daten in öffentliche KI-Systeme. Vertrauliche Informationen können in externe Trainingsmodelle einfließen und tauchen im schlimmsten Fall in fremden Kontexten wieder auf – ohne dass es in der Geschäftsleitung jemand ahnt. Ein Compliance-Problem – und ein reales Risiko für Geschäftsgeheimnisse.

Die Lösung gegen Schatten-KI: Private AI und AI Firewall

Melanie Achten, Geschäftsführerin beim Spezialdistributor MRM, hat darauf reagiert. „Wir sehen die wachsende Unsicherheit im Umgang mit Künstlicher Intelligenz. Niemand will auf die Produktivitätsgewinne verzichten. Andererseits verschwinden Daten in der Blackbox…“ Aus dieser Beobachtung heraus entstand die Partnerschaft zwischen MRM und dem auf hochsichere IT-Lösungen spezialisierten Unternehmen AGAT.

Zero Data Exposure

Herzstück der AGAT-Software BusinessGPT ist die Private AI, eine Plattform, die generative KI ausschließlich auf den eigenen Datenquellen eines Unternehmens betreibt – von E-Mails über Dokumente bis zum CRM-System. Durch den Einsatz von Retrieval-Augmented Generation (RAG) greift die KI auf vorhandenes Wissen zurück, anstatt sensible Daten an externe Trainingsmodelle weiterzugeben. Zero Data Exposure ist das Grundprinzip. Neben einem Knowledge-Chatbot für Fragen in natürlicher Sprache stehen Funktionen für semantische Suche, Business-Analysen und auch Code-Assistenz bereit.

Governance im Arbeitsalltag

Ergänzend sorgt die AI Firewall von BusinessGPT für Governance. Sie überwacht und steuert in Echtzeit, klassifiziert Daten nach Sensitivität und setzt rollenbasierte Richtlinien durch. So können IT-Verantwortliche definieren, wer welche Inhalte mit KI verarbeiten darf und wo Grenzen gezogen werden. Volle Transparenz und Sicherheit, statt unkontrolliertem Abfluss sensibler Informationen!

Die digitale Zukunft selbstbestimmt gestalten „Für uns war entscheidend, dass unsere Kunden die Datenhoheit behalten“, betont Melanie Achten ihre Wahl. „BusinessGPT dient operativ dem Wissenstransfer und der Automatisierung, strategisch liefert es das Fundament für digitale Selbstbestimmung, Compliance und Unabhängigkeit.“ Für die Microsoft-Expertin und On-Premises-Verfechterin passt auch die Bereitstellung: lokale Installationen, end-to-end-Verschlüsselung, private Clouds oder SaaS (auf europäischen Servern!). Zudem eine datenschutzkonforme und On-Premises-fähige Verbindung mit Kollaborationstools wie Microsoft Teams.

MRM – Spezialdistributor für Software & IT-Sicherheit

MRM Distribution ist vor allem bei IT-Häusern für Software-Lösungen bekannt, die den Mittelstand befähigen, Digitalisierung sicher und bezahlbar umzusetzen. Mit BusinessGPT bringt der Distributor einen Partner in den deutschsprachigen Markt, der KI-basierte Innovationen liefert – und volle IT-Sicherheit garantiert.

Melanie Achten ist Geschäftsführerin der MRM Distribution GmbH.

Die Sicherheitsfunktionen von BusinessGPT Private AI und AI Firewall schützen Unternehmen vor unkontrollierter Schatten-KI.

Die Datenmengen in deutschen Unternehmen wachsen rasant und stellen Geschäftsmodelle, Infrastruktur und Prozesse vor nie dagewesene Herausforderungen. Wer jetzt keine Strategie für die Datenexplosion entwickelt, riskiert den Anschluss an die digitale Zukunft. /// von Julia Neumann

NOCH NIE ZUVOR WURDEN IN UNTERNEHMEN so viele

Daten erzeugt, gesammelt und verarbeitet wie heute –und der Trend zeigt steil nach oben. Ob durch Maschinen, Sensoren, digitale Dienste oder Kundeninteraktionen: Daten entstehen im Sekundentakt und überfordern zunehmend die bestehenden Systeme. Was früher als wertvolle Ressource galt, wird nun zum Risiko, wenn es an Strategie, Struktur und Know-how fehlt.

Die Folgen betreffen Unternehmen jeder Größe und Branche. Besonders kritisch ist die Lage in datenintensiven Bereichen wie Industrie, Finanzwesen, Gesundheitssektor

Datenstrategie:

Vom Datensammeln zum Wertschöpfen Auch wenn digitale Technologien längst in der Breite angekommen sind, verfügen viele Unternehmen bislang nur über rudimentäre Datenstrategien. Studien, unter anderem von Bitkom, zeigen, dass riesige Datenmengen gesammelt, aber kaum systematisch erschlossen werden. Häufig mangelt es an Transparenz, Analysefähigkeiten und einer klaren Strategie. Effektives Datenmanagement bedeutet mehr als Technologie. Es setzt auf durchdachte Strukturen: die gezielte Auswahl relevanter Daten, perfor-

” Effektives Datenmanagement bedeutet mehr als Technologie. Es setzt auf durchdachte Strukturen: die gezielte Auswahl relevanter Daten, performante Speicherlösungen sowie fortschrittliche Analysetools. Julia Neumann

oder Handel. Dort sind Echtzeitprozesse längst Alltag und mit ihnen eine Flut an Informationen, die gespeichert, ausgewertet und abgesichert werden müssen. Doch vielerorts fehlt es an einem klaren Plan, wie mit dieser Herausforderung umzugehen ist. Dabei geht es nicht nur um Technik, sondern um einen Paradigmenwechsel: Daten sind nicht mehr nur Mittel zum Zweck, sie werden zum strategischen Rohstoff, der über Zukunftsfähigkeit entscheidet.

KI als Schlüsseltechnologie für exponentiellesDatenwachstum Nach Prognosen von IDC wurden im Jahr 2024 rund 150 Zettabyte Daten weltweit erzeugt. Bis 2035 soll diese Menge auf über 600 Zettabyte ansteigen. Zum Vergleich: Ein modernes Smartphone hat etwa 128 GB Speicherplatz. 1 Zettabyte entspricht dem Speicherplatz von rund 8 Milliarden solcher Smartphones – also eine unfassbar große Datenmenge. Quellen dafür sind vielfältig – Maschinenkommunikation, IoT-Sensorik, Kundeninteraktionen oder digitale Services. Künstliche Intelligenz spielt dabei eine zentrale Rolle: Einerseits sorgt sie durch neue Anwendungen und Modelle selbst für steigende Datenvolumina. Andererseits wird sie unverzichtbar, um Informationen effizient zu verarbeiten, Muster zu erkennen und Entscheidungen in Echtzeit zu treffen. Ohne KI wird es kaum möglich sein, diese Datenberge gewinnbringend zu bewältigen.

DIE AUTORIN

Julia Neumann ist Head of Communication bei GlobalConnect Germany und zertifizierte KI-Managerin.

mante Speicherlösungen sowie fortschrittliche Analysetools. Hybride Architekturen – bestehend aus lokalen Rechenzentren, Cloud-Diensten und Data Lakes – gewinnen dabei zunehmend an Bedeutung. Entscheidend bleibt die Qualität der Datenbasis: Nur valide und aktuelle Informationen ermöglichen fundierte Erkenntnisse.

Quantencomputing als nächste Evolutionsstufe

Mit der Verfügbarkeit von Quantentechnologien bahnt sich bereits die nächste Welle an. Erste Pilotanwendungen in Deutschland – etwa bei Fraunhofer, DLR oder in Partnerschaften mit IBM – verdeutlichen, welche Leistungsfähigkeit Quantencomputer entfalten können, sei es bei komplexen Simulationen, in der Logistik oder in der Finanzmodellierung.

Diese Entwicklung wird den Datenzuwachs nochmals beschleunigen und die Komplexität weiter erhöhen. Unternehmen sind gut beraten, frühzeitig in skalierbare Infrastrukturen und Sicherheitskonzepte zu investieren, um auf die Anforderungen vorbereitet zu sein.

Infrastruktur als Rückgrat der Datenwirtschaft

Jede Datenstrategie steht und fällt mit einer stabilen technischen Basis. Glasfaserinfrastrukturen bilden das Fundament, um große Datenmengen in Echtzeit zu übertragen und KI-gestützte Prozesse reibungslos umzusetzen. Niedrige Latenz und hohe Bandbreiten sind unerlässlich – gerade, wenn Quantencomputing in den operativen Einsatz kommt.

gilt es, klare Ziele für den Einsatz von Daten zu definieren und skalierbare, sichere Speicher- und Analysearchitekturen zu etablieren. Ein weiterer entscheidender Schritt ist die Integration von Künstlicher Intelligenz, um Prozesse zu automatisieren und Erkenntnisse in Echtzeit zu gewinnen. Gleichzeitig sollten die Potenziale von Quantentechnologien frühzeitig geprüft und in Pilotprojekten erprobt werden.