PARA LA REPRESENTACIÓN DE UN PAISAJE

PARA LA REPRESENTACIÓN DE UN PAISAJE

XXIV FESTIVAL INTERNACIONAL DE LA IMAGEN

XI INTERNATIONAL MEDIA ART HISTORY CONFERENCE

XXI FORO ACADÉMICO INTERNACIONAL DE DISEÑO Y CREACIÓN

[DANI VERA]

Magíster © en Tecnología y Estética de las Artes Electrónicas, UNTREF, Argentina

Magíster en Arquitectura y Diseño, PUCV, Chile danielaignacia.vera@gmail.com ig: @_igna_vera_ +56 982495125 (Chile) +54 11 27773450 (Argentina)

MARITORIO > ENSAYO TECNOPOÉTICO

PARA LA REPRESENTACIÓN DE UN PAISAJE

AFECTIVO

PALABRAS CLAVE

+ Paisaje afectivo

+ Memoria

+ Solastalgia

+ Narrativa no lineal

+ Interactividad visual/sonora

Maritorio es un ensayo tecnopoético que explora la relación entre sujeto y paisaje a partir de un ejercicio personal de memoria afectiva. El proyecto propone el concepto Paisaje afectivo para contrastar la relación extractiva que predomina en nuestras formas de relación con el entorno natural y cultural. Se indaga en cómo las tecnologías contemporáneas pueden mediar y representar esta relación contribuyendo a la construcción de una identidad compartida con el territorio. Para ello se desarrolla un dispositivo interactivo que combina imágenes de un archivo fotográfico propio, escritura poética y archivos de sonido, generando una narrativa visual y sonora que evoluciona en tiempo real, utilizando Kodelife OpenGL y un sistema de interactividad a través de código en Processing.

Este proceso de investigación-creación sostiene que la tecnología no solo registra el paisaje, sino que lo reconfigura en un espacio de representación dinámica donde las afectividades y la memoria se activan mediante la interacción entre imagen y sonido. Este enfoque tecnopoético permite abrir nuevas formas de relación con el entorno, estableciendo un diálogo entre paisaje, memoria y tecnología.

Maritorio invita a reflexionar sobre el papel de la tecnología en la representación del paisaje, no solo como una herramienta de registro, sino como medio para la resignificación de nuestras relaciones afectivas con el territorio. La obra plantea una reflexión crítica sobre la interconexión entre los seres humanos y los paisajes en un contexto de crisis medioambiental, abriendo posibilidades para un entendimiento más profundo del territorio.

Si nuestros recuerdos fueran archivos computacionales dañados por el paso del tiempo, la forma de recuperarlos sería intentando completar esas partes dañadas con nueva información que nos llene de sentido, para así volver a leerlos e imaginar que siguen intactos.

Revisando mí archivo fotográfico de los últimos diez años llamó mi atención la gran cantidad imágenes marinas del Archipiélago de Chiloé, poblado de playas, orillas, islas, embarcaciones, oleajes y otros cuerpos de agua. Inmediatamente me día cuanta de lo mucho que ese entorno natural ha cambiado con el paso de los años, donde las playas se han privatizado, los bosques minimizados y los mares sufren por la contaminación.

Nuestro hábitat se encuentra en constante transformación, pero es probable que la aceleración que percibimos se deba al incremento en la velocidad con la que circula la información y las decisiones que se toman a partir de ello, repercutiendo particularmente en la forma de vida de quienes habitamos en zonas rurales, donde se ha normalizado una relación extractiva con el entorno a partir de la explotación económica de los recursos naturales y culturales.

En contraste, pienso que también podemos tener una relación afectiva con el paisaje, que se construye a partir de nuestras experiencias significativas en contacto con el entorno natural y cultural, y que son atesoradas en la memoria contribuyendo a nuestro sentido de identidad.

FUNDAMENTOS PARA UN DISPOSITIVO INTERACTIVO: MARCO CONCEPTUAL

> AFECTIVO VERSUS EXTRACTIVO

“La imagen de una materia intrínsecamente inanimada puede ser uno de los impedimentos del surgimiento de modos de producción y consumos más ecológicos y más sustentables materialmente.”

(Bennett, 2022: 13)

En Chile existe una lógica extractivista en la manera en la que nos vinculamos con el entorno, y ello no sólo a partir de los recursos naturales con industrias como la minera o la forestal, sino que también en cuanto a los recursos culturales y el paisaje natural por medio de la industria del turismo y la inmobiliaria. En el caso del Archipiélago de Chiloé la actividad turística se ha ido intensificando notablemente en la última década, así como también la presión inmobiliaria sobre las áreas rurales.

En el ensayo “Ruralidad virtual: Reflexiones en torno a las representaciones mediales del Archipiélago”, me aventuré a especular sobre un nexo entre la creciente demanda turística y la manera en que el territorio estaba siendo representado en los medios virtuales, particularmente en las redes sociales y en algunas realizaciones audiovisuales contemporáneas (Vera, 2024).

Me di cuenta de que se estaba propagando una versión estereotipada de la realidad cultural, y a raíz de lo expuesto por Leo Solaas en “La vida del hipersujeto” me pregunté si el conjunto de imágenes que circula en la web no sería también

una suerte de hipertexto de este paisaje, en donde no hay continuidad y cada post vive en su tiempo separado, relegando al espectador la tarea de reconstrucción de sentido a partir del recuerdo de otros post con similar contenido (Solaas, 2017).

Me quedé con la sensación de que estaba siendo testigo de una transformación de mi territorio sin precedentes, invadida por un sentimiento de “solastalgia” (Albrecht et al. 2007), un término medioambiental definido como “la aflicción producida por el cambio ambiental que impacta en las personas mientras están directamente conectadas a su entorno.”

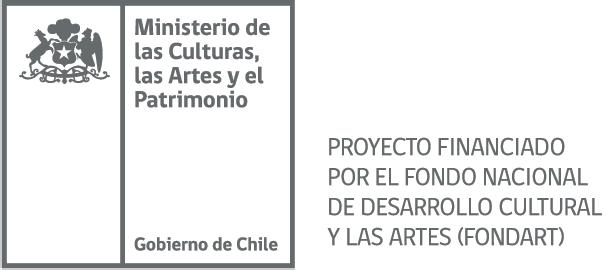

[FIGURA 1] Set de imágenes disponibles en cuentas de perfiles públicos de Instagram asociadas al hashtag #muelledelasalmas y/o a la georeferencia “Muelle de las Almas, Cucao, Chiloé”. Fuente: Elaboración propia a partir de imágenes extraídas del dominio público de internet.

> PAISAJE AFECTIVO

Para efectos de esta indagatoria y proceso de creación, he querido introducir el concepto de Paisaje afectivo como forma de una representación visual y también sonora, semejante a un recuerdo que se ve deteriorado con el tiempo, donde prevalecen fragmentos a los que nos aferramos producto de nuestros afectos.

Me interesa explorar el vínculo afectivo entre sujeto y paisaje, donde existe una carga simbólica otorgada a ciertos elementos del entorno físico geográfico a partir de nuestras experiencias significativas o de nuestra carga cultural, que propicia una relación no extractiva con nuestro ecosistema circundante. En este sentido es vital comprender que los seres humanos somos una parte constitutiva y no separada del paisaje, y que nos comportamos en cuanto nuestro medio ambiente existe (Puentes, 2013).

Pero los paisajes no son fijos, sino que van mutando en el tiempo y a su vez aparecen otros nuevos, donde el conjunto de relaciones entre lo natural y lo cultural también va cambiando. Para efectos de este proyecto entenderemos Paisaje como “el producto de la relación profunda de las comunidades con su territorio y de las estrategias de representación del mismo, en tanto sin imagen no hay tal cosa llamada Paisaje; sin imagen, solo tenemos entorno físico” (Castillo et al. 2021: 33).

> ECOS Y REFERENCIAS ARTÍSTICAS

En cuanto a dichas estrategias de representación del Paisaje, resultan especialmente interesantes aquellas que lo abordan por medio de dispositivos visuales y/o sonoros, y que, además, trabajan con la

noción de fragmentos que dialogan entre sí a través de la interpretación afectiva del espectador. De esta manera, el proyecto se vincula conceptualmente a las Operaciones eidéticas desarrolladas por el arquitecto paisajista James Corner, donde a través de la combinación de elementos visuales e información cartográfica sostiene que las imágenes eidéticas contienen una amplia gama de ideas que vigorizan la creatividad humana, y que en consecuencia, la forma en que uno imagina el mundo condiciona literalmente cómo se conceptualiza y se le da forma a la realidad (Corner & Bick, 2014: 241).

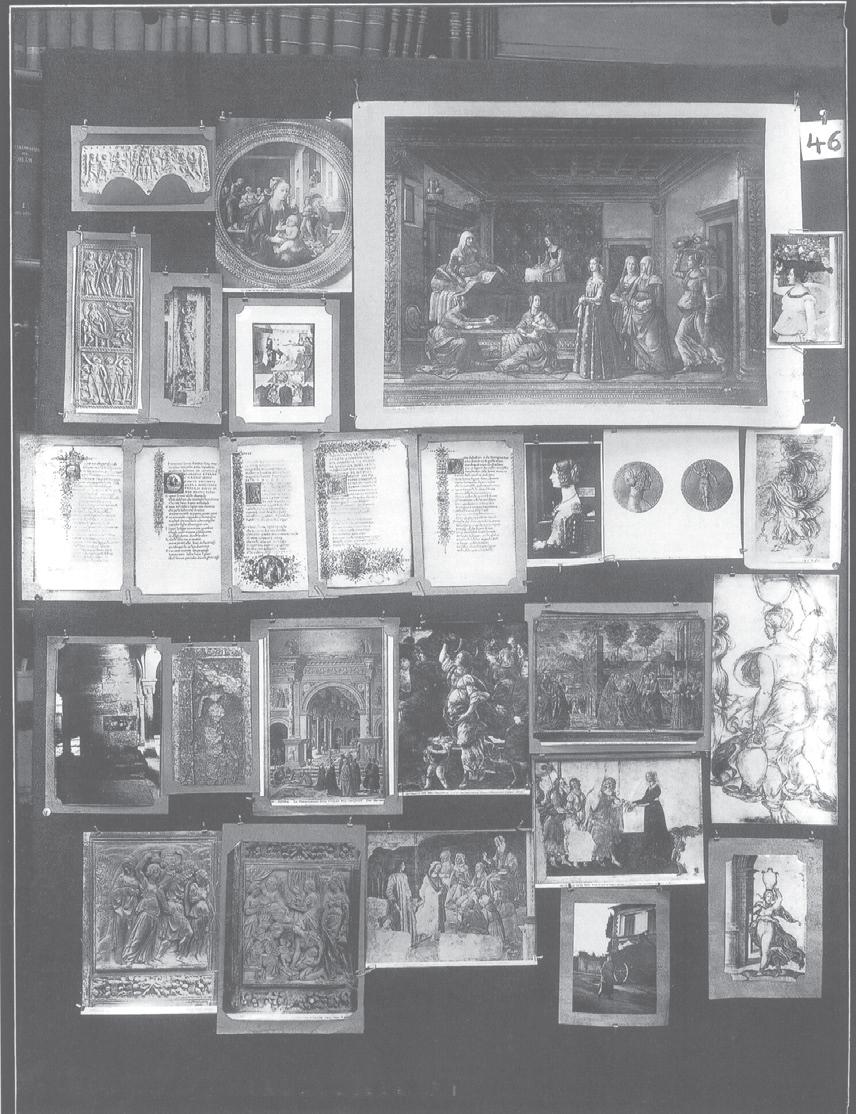

Luego, la representación a partir de fragmentos que presenta una narrativa abierta y no lineal, se observa de manera contundente por primera vez en la obra “Atlas Mnemosyne” de Aby Warbug (1924-1929), en donde a partir de un conjunto de imágenes asimétricas se propone generar una red de relaciones que permita reflexionar sobre la imagen, generando nuevas interpretaciones y analogías. Del mismo modo, el proyecto web “Atlas do Chão” co dirigido por Ana Luisa Nobre y David Sperling, utiliza como motor de búsqueda en el sitio un conjunto de imágenes a las que denominan constelación, cuya finalidad es representar conceptualmente determinados conflictos territoriales asociados a la propiedad del suelo en Brasil, añadiendo para ello una georreferenciación. Esta constelación proviene del mismo principio acuñado por Warbug, donde la idea de Atlas se contrapone a una forma lineal y organizada de leer a interpretar el significado de las imágenes.

Al igual que “Atlas do Chão”, la obra de Victoria Jolly y Juan Castillo “Cruzar los Límites” (2022)

trae consigo la dimensión territorial al ser un trabajo que se despliega por diversas locaciones de Chile, con el fin de repensar las coordenadas cardinales Norte-Sur por medio de una serie de intervenciones efímeras realizadas en zonas rurales. En este caso, la obra se constituye a partir de su registro fotográfico y audiovisual, que permite trasladar estos espacios a otras significaciones sin revelar su ubicación específica, constituyéndose en un paisaje híbrido, que podría ser aquí o allá. En esta obra, que también trabaja la narrativa no lineal de las imágenes para apelar a nuevos significados e interpretaciones, se incorpora el dispositivo como forma de diálogo con el paisaje mediante la generación de texto in situ como parte de la instalación, vinculando de forma asincrónica al espectador con esos territorios aislados.

[FIGURA 2] (Izq.) Una de las diversas imágenes de la obra “Atlas Mnemosyne” de Aby Warbug, publicadas en 2010 por Martin Warnke. (Der.) Registro de una de las acciones llevadas a cabo por Victoria Jolly y Juan Castillo en “Cruzar los límites” en 2022, Chile. Fuente: Imágenes extraídas del dominio público de internet. (Izq.) https://proyectoidis.org/ (Der.) https://www.puntoespora.cl

> UN ENSAYO TECNOPOÉTICO

Imagino que así como una geolocalización en redes sociales o el hashtag asociado a un lugar específico está vinculado a fotografías aportadas por sus usuarios, un Paisaje afectivo podría, en contraste, construirse a partir de imágenes reales o mentales con carga simbólica para un individuo o una comunidad.

Me interesa indagar en el vínculo afectivo entre sujeto y paisaje, pues tengo la impresión de que el sentido de identidad que nos asocia a un territorio está fundado en éste vínculo, y que puede ser abordado desde la representación visual y sonora. Esto me ha movilizado para desarrollar un ensayo tecnopoético como trabajo práctico para el Eje Tiempo, en el marco de la Maestría en Artes Electrónicas de la UNTREF. Para lo cual diseñé un dispositivo sensible a partir de fotografías propias —y no tomadas de internet—, sonidos y escritos en clave poética para plantear un punto de vista: que es posible establecer una relación afectiva y no primordialmente extractiva con el paisaje.

En este dispositivo, programado con lenguaje de código, la interactividad se genera a partir de la relación entre imagen y sonido, comandada por la variable tiempo, donde la amplitud del sonido afectará la velocidad con que percibimos la interacción entre las imágenes. Quizás en el futuro este proyecto pueda desarrollarse de manera colectiva, pero comenzaré incursionando en un ejercicio individual para la representación tecnopoética de mi propio Paisaje afectivo, compuesto por recuerdos e imágenes en los que persiste la presencia del mar en el Archipiélago de Chiloé, Patagonia chilena.

> UNA POÉTICA DE LAS IMÁGENES

Para comenzar, se requería realizar una selección de fotografías bajo un criterio ante todo poético, para poder referirme al significado de las imágenes más allá de su contenido visual. Para ello recurrí a una de las observaciones del arquitecto Alberto Cruz Covarrubias en donde se pregunta “¿Cuál es el tamaño de un barco en el horizonte?” (Figura 3) refiriéndose no a una medida métrica sino que a la relación simbólica entre sujeto y paisaje a partir de la relación entre luminosidad y presencia en el espacio (Purcell, 2013).

Esta relación simbólico-espacial con el paisaje, en donde lo que Purcell señala como “presencia” es en efecto una experiencia de “estar ante” el paisaje, me hizo recordar una de mis propias observaciones arquitectónicas, en donde precisé que “Horizonte y orilla son una única línea que conecta nuestra escala humana con la escala del paisaje”.

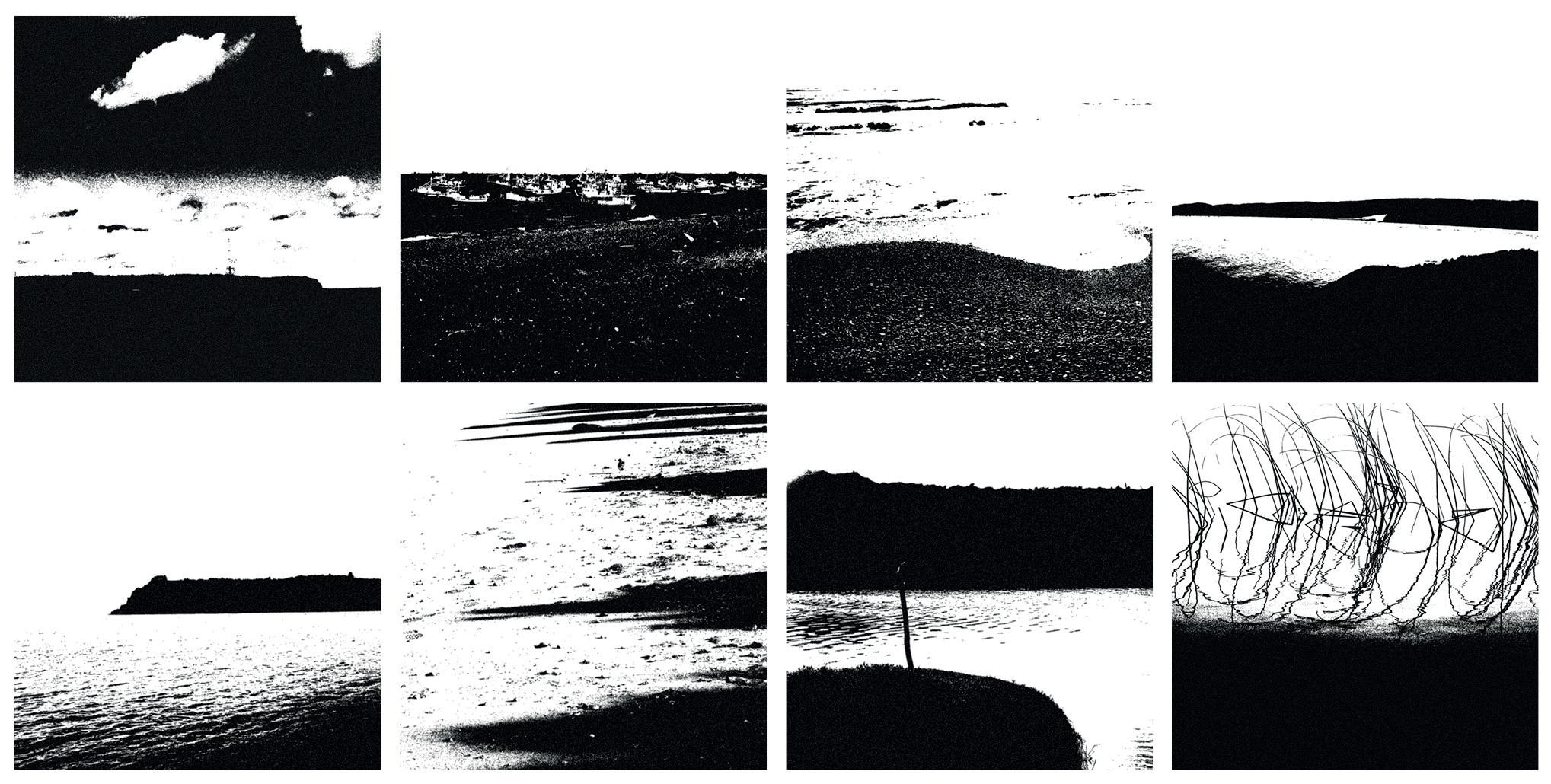

A partir de estas dos observaciones determiné que las fotografías para este proyecto serían de fragmentos de horizontes y orillas que no revelaran su geolocalización a simple vista, y que además no fuesen enclaves ya instalados en el imaginario turístico del territorio. Junto con ello deberían tener una composición visual tal que, al momento de ser editadas, pudieran ser imágenes en el límite entre lo figurativo y lo abstracto. (Figura 4)

Otro aspecto relevante para considerar en la composición visual del dispositivo es el color, que debía ser coherente con el concepto de tiempo pasado y

la sensibilidad que desea transmitirse. Se adopta para ello el color azul de Prusia, utilizado en la cianotipia, en concordancia a lo relatado por Rebeca Solnit acerca del vínculo con el paisaje, quien escribe: “el azul del horizonte, el azul del lugar donde la tierra parece fundirse con el cielo, es un azul más intenso, más onírico, un azul melancólico […], el azul de la distancia.” (Solnit, 202:29)

[FIGURA 3] Croquis que acompaña la observación arquitectónica: “La presencia requiere un tamaño. Desde el litoral la presencia viene configurándose como una interrupción luminosa ubicada en el horizonte.” Fuente: Purcell, J. (2013). Visión de Valparaíso 1953 – 2011. Ediciones Universitarias de Valparaíso. (Pág. 86).

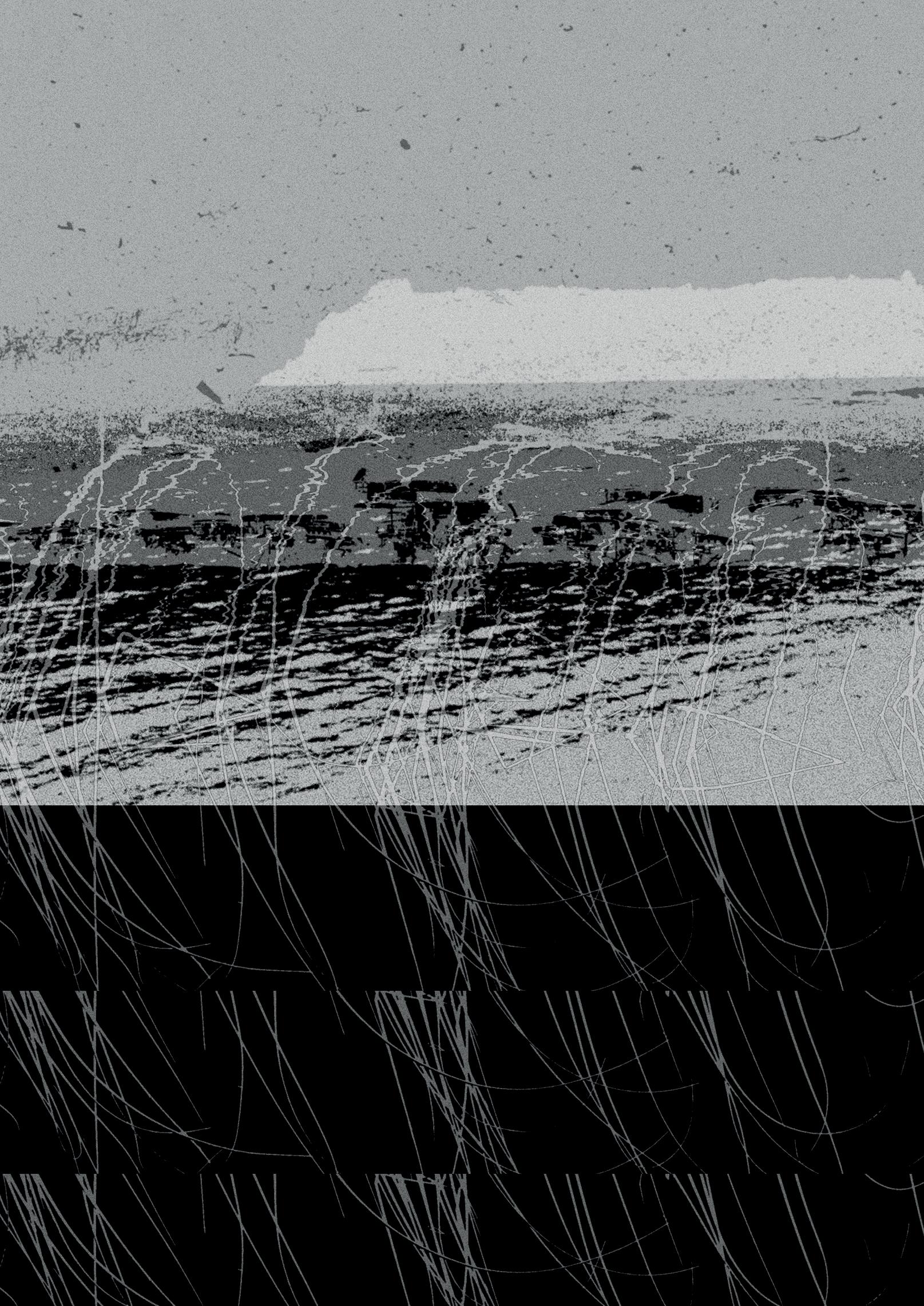

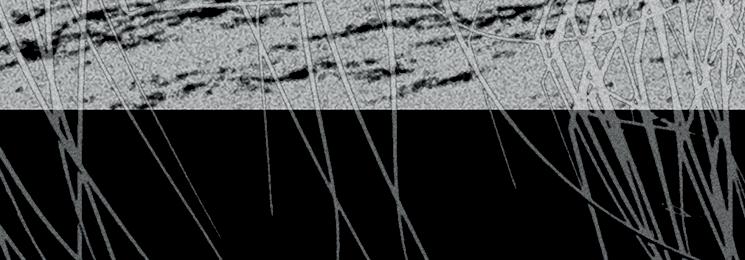

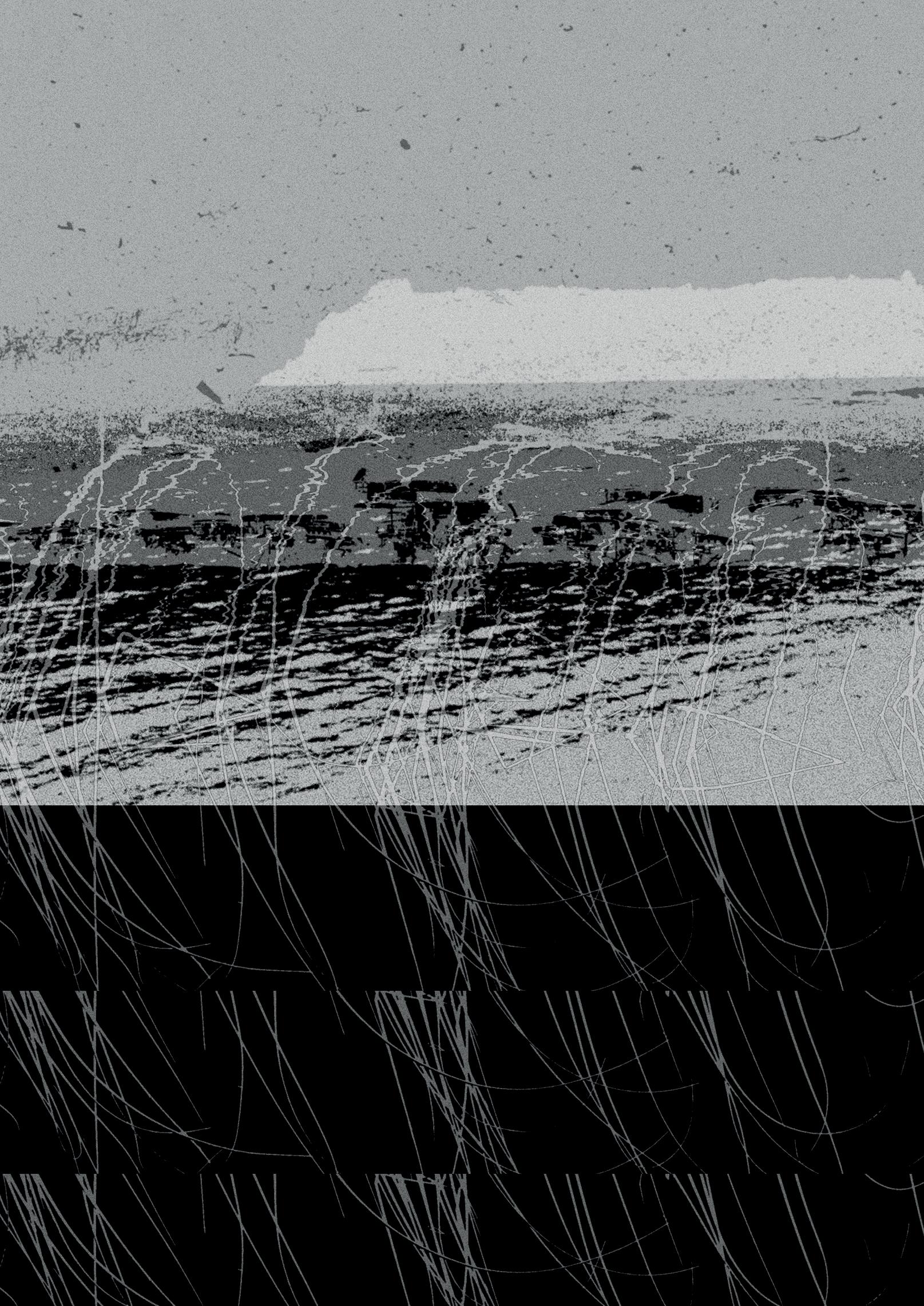

[FIGURA 4] Set de imágenes seleccionadas del propio archivo fotográfico para conformar el montaje visual del dispositivo. Fuente: Elaboración propia (2024).

[FIGURA 5] Maqueta pseudo analógica del montaje visual para el dispositivo realizada en Photoshop. Fuente: Elaboración propia (2024).

> DE LA IMAGEN AL DISPOSITIVO

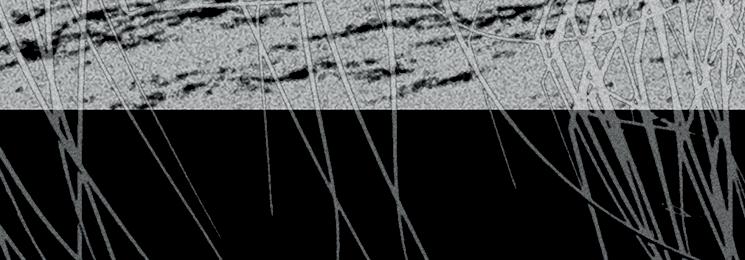

El proceso continúa con la creación de una maqueta visual en Adobe Photoshop, en la que se combinan tres fotografías seleccionadas del archivo, siguiendo las características estéticas previamente mencionadas. En esta fase se exploran diversas posibilidades de montaje, explorando posibilidades de rotación, tamaño y opacidad de las imágenes.

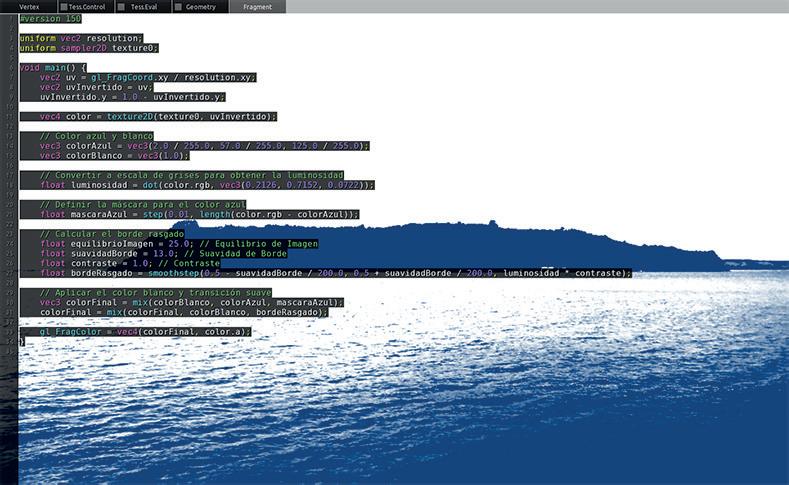

Cada imagen se edita individualmente para emular el efecto de un cianotipo, buscando tonalidades del azul de Prusia, junto con sus gradientes e imperfecciones. Para ello, se aplica el efecto Bordes rasgados disponible en la galería de efectos de Photoshop, con los siguientes parámetros:

+ Color frontal: RGB (2, 57, 125) // Variante del azul de Prusia

+ Equilibrio de imagen: 25

+ Suavidad de borde: 13

+ Contraste: 1

Esta maqueta se convierte en la imagen objetivo del proyecto (Figura 5), estableciendo tres etapas de exploración técnica para el desarrollo del prototipo.

La precisión de los parámetros aquí listados será clave para crear un código que replique esta lógica de edición en tiempo real, utilizando Kodelife Open GL.

> Montaje visual

La primera etapa de exploración visual tiene dos objetivos: la edición de imágenes en tiempo real y la iteración de estas imágenes para crear un montaje animado, ya sea mediante una variable temporal o como respuesta a un evento específico.

Para obtener un resultado visual similar al de la maqueta en Photoshop, se desarrollan ejercicios de escritura de código enfocados en la edición en tiempo real de una única imagen en Kodelife Open GL. En esta fase, se realizan modificaciones simples sobre una variable uniform sampler2D, como la variación de color a escala de grises, control de brillo y alto contraste. Luego, se avanza hacia una combinación de variables que logran el efecto Bordes rasgados de la maqueta. El código final genera un borde irregular en la imagen de entrada, calculando la luminosidad de cada píxel para identificar zonas de alto contraste y áreas cercanas a un tono azul específico. Esta diferencia de color se usa para aplicar una transición progresiva entre el azul y el blanco, creando un degradado suave que mejora la fluidez de los bordes en comparación con un simple efecto de alto contraste.

A continuación, se explora el montaje en tiempo real en Kodelife, incorporando dos nuevas variables de imagen texture2D. El objetivo es no solo superponer imágenes estáticas con variaciones en la coordenada alpha o transparencia, sino también generar una animación como resultado de un evento puntual. El código se va complejizando para incluir factores de interpolación entre imágenes, primero mediante la posición del mouse en la pantalla y luego con la integración de variables float time. Este último factor es clave para la interacción visual y sonora del dispositivo.

Finalmente, se añade un efecto de ruido que se posiciona sobre la interpolación de las imágenes, siguiendo la lógica de edición por capas, lo que crea la ilusión de un movimiento acuático.

[FIGURA 6] (Arriba) Algunos resultados de la experimentación visual para la edición en tiempo real a partir de una fotografía para emular la estética del cianotipo. (Abajo) Código Qr para acceder al video de proceso del proyecto (Duración 00:02:52). Fuente: Elaboración propia (2024).

[FIGURA 8] (Izq.) Capturas de pantalla realizadas durante la activación del dispositivo. (Der.) Código Qr para acceder al video registro de la activación del dispositivo. Fuente: Elaboración propia (2024).

> Diseño sonoro

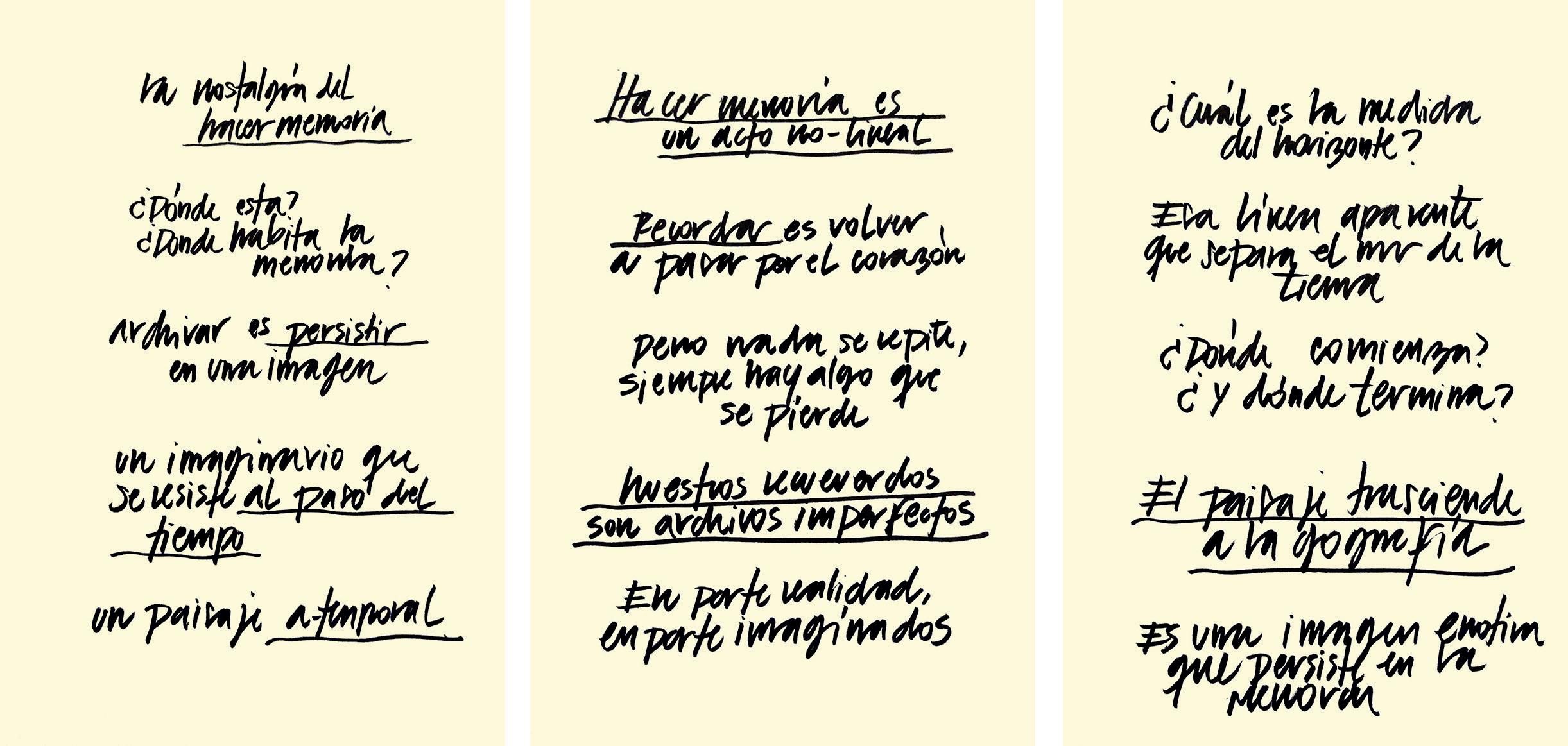

Para el diseño sonoro, se seleccionan tres textos poéticos de propia autoría, creados durante el proceso de investigación, con el fin de reflexionar sobre la relación entre sujeto, paisaje y memoria. La sonoridad de estos textos será central para la performatividad del dispositivo, ya que permitirá apelar a una sensibilidad del espectador frente a la problemática planteada. Los textos son grabados con variaciones analógicas de paneo, amplitud y tono, con una mínima edición digital posterior. Estas variaciones sonoras que realzan ciertas frases clave, han de alterar el factor de interpolación de las imágenes del montaje visual, permitiendo evidenciar una interacción entre imagen y sonido.

Para integrar el sonido al código en desarrollo, se debe migrar desde Kodelife Open GL a Processing, insertando el montaje visual previamente creado en formato PImage para trabajarlo como un archivo de imagen. Se incorporan cuatro archivos de audio: tres corresponden a grabaciones de voz de los textos poéticos, y el cuarto es un sonido ambiente de navegación sobre el mar de Chiloé. Estas cuatro variables soundFile pueden activarse independientemente con teclas específicas del teclado, reproduciéndose en bucle hasta ser desactivadas con las teclas asignadas, permitiendo incluso que todas se reproduzcan simultáneamente.

> Diseño de interactividad visual-sonora Este prototipo fue desarrollado como trabajo práctico para el primer cuatrimestre de la Maestría en Artes Electrónicas, cuya consigna giraba en torno al Eje Tiempo. En este contexto, el manejo de las variables temporales en el diseño del código se

vuelve crucial tanto desde el punto de vista técnico como conceptual.

Desde lo técnico, la variable time se incorpora estratégicamente en la interacción entre la imagen y el sonido, ya que en el código final se utilizan los valores de amplitud registrados de los archivos de audio, mientras están en reproducción, para alterar la temporalidad del ciclo de iteración de las imágenes en función de la intensidad del sonido. De esta manera, a mayor volumen del sonido, mayor será el cambio en el tiempo de la imagen.

Es importante señalar que, en el código, cada archivo de sonido tiene asociada su propia variable de tiempo, que a su vez controla una única imagen. De este modo, cada sonido no solo se activa o desactiva con su propio comando de tecla, sino que también modifica el tiempo de la imagen correspondiente, creando una interacción dinámica en la que el sonido y la imagen se modifican mutuamente en tiempo real.

Desde un punto de vista conceptual, el prototipo propone la cohabitación de tres temporalidades, aludiendo a la dificultad de determinar el tiempo en nuestros recuerdos, los cuales, con el paso del tiempo cronológico, se vuelven cada vez más imprecisos. Al momento de ejecutar el código en Processing, la animación comienza en un Tiempo latente sin sonido, donde las imágenes iteran con un ritmo lento y armónico. El segundo tiempo corresponde al Tiempo drone, que se activa al presionar las teclas “d” o “D” y, al iniciar la reproducción de la pista que contiene el sonido de la navegación marítima, modifica la iteración de la textura de ruido en el montaje visual, alterando el

ritmo del supuesto movimiento acuático. El tercer tiempo corresponde al Tiempo voz, que activa los tres archivos sonoros de las lecturas poéticas, al presionar las teclas “v” o “V”, “1” y/o “2”. Cada uno de estos archivos modifica el tiempo de una de las tres imágenes que componen el montaje visual, permitiendo que se reproduzcan de manera simultánea o independiente.

Esta estructura de código fue pensada para que el prototipo sea activado como una performance, permitiendo a una persona operar las diferentes teclas y generar cada vez un resultado audiovisual levemente diferente.

[FIGURA 7] Textos poéticos que dieron origen al diseño sonoro del dispositivo. Subrayadas se encuentran los fragmentos de mayor amplitud sonora dentro de los archivos de audio. Fuente: Elaboración propia (2024).

Desde el aspecto técnico, se puede sostener que el uso de herramientas tecnológicas con fines artísticos para la representación de paisajes — como, en este caso, un código de programación para la interacción visual-sonora— supera a la imagen estática, pues posibilita una estimulación multisensorial que enriquece las narrativas no lineales que cada espectador construye al asociar estos estímulos con sus propios recuerdos.

En ese sentido, el desarrollo de un dispositivo, aunque aún en estado de prototipo, abre la posibilidad de seguir explorando la interacción entre imagen y sonido, entre afectividad y paisaje, y entre sujetos y territorios. Esto favorece la replicabilidad del proyecto, ya que podría adaptarse a otros contextos territoriales y representar las afectividades de distintas personas o comunidades, trabajando con variadas informaciones visuales y sonoras que amplíen el alcance de la exploración.

Desde el aspecto conceptual, el proyecto aborda el Paisaje afectivo como una forma de representación que trasciende al espacio físico-geográfico para convertirse en una construcción afectiva —quizás la experiencia más próxima a encarnar aquello que llamamos patrimonio. Al basarse en registros y memorias personales, la narrativa no lineal del proyecto crea un diálogo entre lo individual y lo colectivo, invitando al espectador a reconstruir su propio Paisaje afectivo a partir de sus vivencias y rasgos culturales.

Maritorio, al igual que sus referencias artísticas, hace uso de elementos visuales y sonoros presentados

como fragmentos de información, y recurre a la narrativa no lineal para comunicar un sentimiento subjetivo que aborda una preocupación real por la transformación ambiental y cultural que viven muchas comunidades rurales en la actualidad.

Visto de esta manera, el concepto de Paisaje afectivo se configura como un hipertexto, según lo definió Leo Solas, y por ello no difiere sustancialmente del conjunto de imágenes asociadas a un hashtag. Entonces ¿qué los diferencia? Quizás la respuesta radique en la “palabra”, que puede o no estar narrada en clave poética, y que permite que, si bien el conjunto de elementos admite una interpretación abierta, como propone Aby Warburg, siga teniendo un sentido determinado por las intenciones del discurso estético, cultural o político de la obra.

ALBRECHT, G., SARTORE, G., CONNOR, L., HIGGINBOTHAM, N., FREEMAN, S., KELLY, B., STAIN, H., TONNA, A. & POLLARD, G. (2007). Solastalgia: The Distress Caused by Environmental Change. Australasian psychiatry : bulletin of Royal Australian and New Zealand College of Psychiatrists. 15 Suppl 1. https://www.researchgate.net/ publication/5820433_Solastalgia_The_Distress_ Caused_by_Environmental_Change

ATLAS DO CHÃO. (s.f.). Sobre o Atlas. https:// www.atlasdochao.org/

BENNET, J. (2022). Prefacio. En Materia vibrante. Una ecología política de las cosas. Caja Negra. CASTILLO, C., DEL CASTILLO, M., VERA, D., CAÑULEF, M., & GONZÁLEZ, D. (2021). Paisajes en disputa, Pualhue Huilliche. Editorial Universidad de Los Lagos.

CLÉMENT, G. (2018). Manifiesto del tercer paisaje. Editorial Gustavo Gilli, SL.

CORNER, J. & BICK HIRSCH, A. (Eds.). (2014). The landscape imagination: collected essays of James Corner 1990 – 2010. Princeton Architectural Press.

FONTCUBERTA, J. (2016). La furia de las imágenes. Notas sobre la postfotografía. Galaxia Gutenberg.

MORTON, T. (2018). El pensamiento ecológico. Paidós.

PROYECTO IDIS. (s.f.). Atlas Mnemosyne. https:// proyectoidis.org/

PUENTES, M. (2013). La observación arquitectónica de Valparaíso: su periferia efímera. Ediciones Universitarias de Valparaíso.

PUNTO ESPORA. (s.f.). Cruzar los límites. https:// www.puntoespora.cl/

PURCELL, J. (2013). Visión de Valparaíso 1953 –2011. Ediciones Universitarias de Valparaíso.

SMITHSON, R. (1996). A tour of the monuments of Passaic, New Jersey (1967). En J. Flam (Ed.), Robert Smithson: Collected Writings (pp. 68-74). University of California Press. SOLAAS, L. (2017, 26 de Julio). La doble vida del hipersujeto. Medium. https://solaas.medium.com/ la-doble-vida-del-hipersujeto-fdaab9d43dd2

SOLNIT, R. (2021). Una guía sobre el arte de perderse. (C. Ministral, Trans.). (3ra ed.). Fiordo. VERA, D. (2024). Ruralidad virtual: Reflexiones en torno a las representaciones mediales del Archipiélago. Origen, 1(3), 11-17.

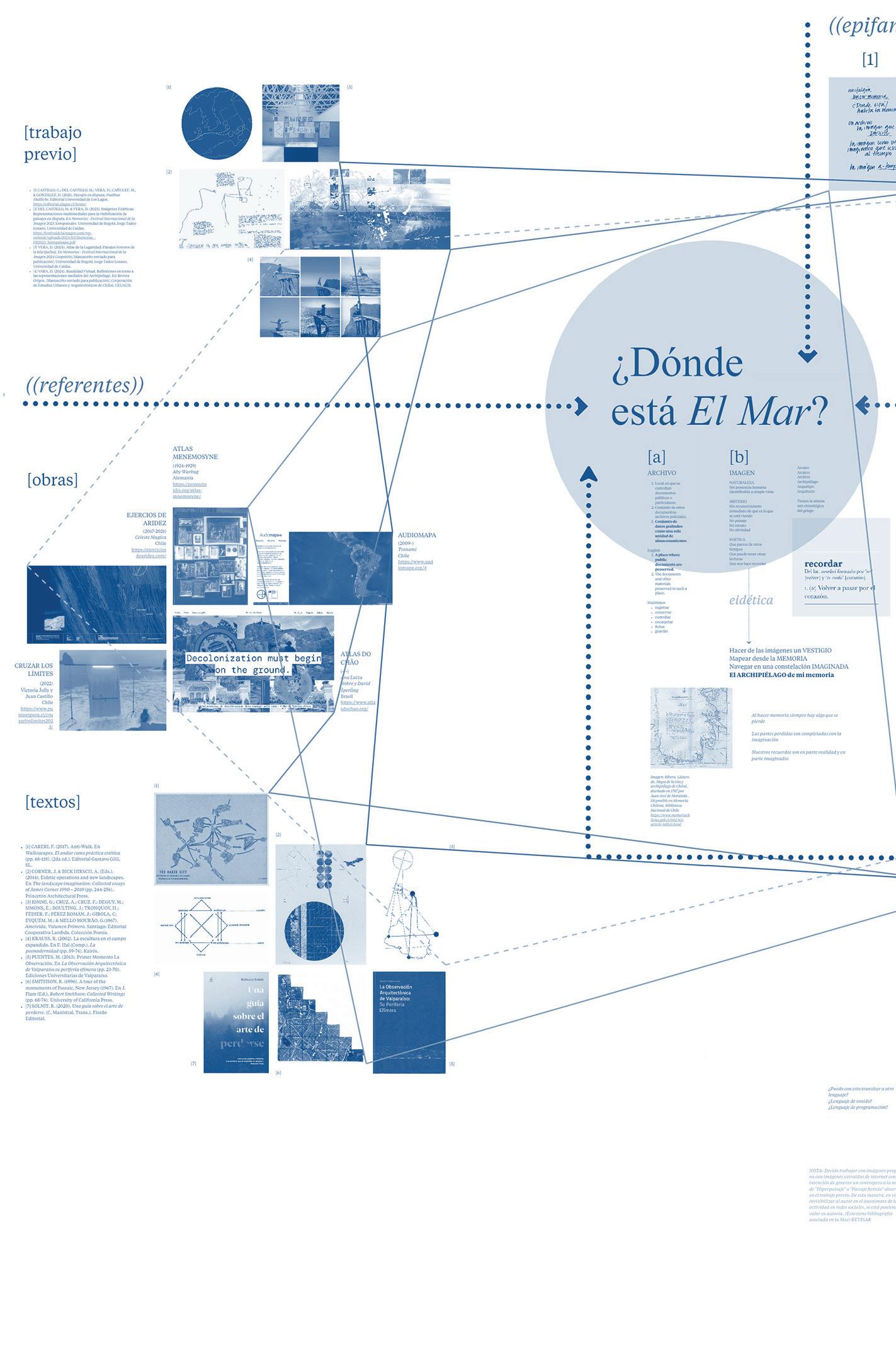

[ANEXO 1] Mapa de desarrollo conceptual de proyecto. Fuente: Elaboración propia (2024).

> CÓDIGO PARA LA INTERACTIVIDAD ENTRE

IMÁGENES Y SONIDOS

import processing.sound.*;

// Declarar las variables de sonido en Processing

SoundFile sampleDrone;

SoundFile sampleVoz;

SoundFile sampleVoz1; SoundFile sampleVoz2; Amplitude rmsDrone; Amplitude rmsVoz; Amplitude rmsVoz1; Amplitude rmsVoz2;

// Declarar diferentes factores de suavisado para Drone y Voces

float smoothingFactorDrone = 0.4; float smoothingFactorVoz = 0.005; float smoothingFactorVoz1 = 0.005; float smoothingFactorVoz2 = 0.005;

// Declarar factores de relentización para Voces float ralentizacionFactorVoz = 0.5; // Reducir este valor para relentizar TiempoVoz float ralentizacionFactorVoz1 = 0.5; float ralentizacionFactorVoz2 = 0.5;

// Usado para almacenar los valores de amplitud suavizados float sumDrone; float sumVoz; float sumVoz1; float sumVoz2;

PShader shader; PImage imagen; PImage imagen1; PImage imagen2; PImage imagen3;

float tiempoGlobal = 0.0; float tiempoDrone = 0.0; float tiempoVoz = 0.0;

float tiempoVoz1 = 0.0; float tiempoVoz2 = 0.0; boolean activarTiempoDrone = false; boolean activarSampleDrone = false; boolean activarTiempoVoz = false; boolean activarSampleVoz = false; boolean activarTiempoVoz1 = false; boolean activarSampleVoz1 = false; boolean activarTiempoVoz2 = false; boolean activarSampleVoz2 = false;

void setup() { size(800, 600, P2D);

shader = loadShader(“shader.txt”); imagen = loadImage(“Imagen_0.jpg”); // Cargo la imagen 0 imagen1 = loadImage(“Imagen_1.jpg”); // Cargo la imagen 1 imagen2 = loadImage(“Imagen_2.jpg”); // Cargo la imagen 2 imagen3 = loadImage(“Imagen_3.jpg”); // Cargo la imagen 3

// Cargar y reproducir un archivo de sonido y hacerlo en bucle

sampleDrone = new SoundFile(this, “Drone1. mp3”);

sampleDrone.loop(); sampleDrone.amp(7.0); // Amplitud del sonido // Crear y conectar el rastreador de rms para Drone1 rmsDrone = new Amplitude(this); rmsDrone.input(sampleDrone);

sampleVoz = new SoundFile(this, “Voz0.mp3”); sampleVoz.loop(); sampleVoz.amp(2.0); // Amplitud del sonido // Crear y conectar el rastreador de rms para Voz0 rmsVoz = new Amplitude(this); rmsVoz.input(sampleVoz);

sampleVoz1 = new SoundFile(this, “Voz1.mp3”); sampleVoz1.loop(); sampleVoz1.amp(1.0); // Amplitud del sonido // Crear y conectar el rastreador de rms para Voz1 rmsVoz1 = new Amplitude(this); rmsVoz1.input(sampleVoz1);

sampleVoz2 = new SoundFile(this, “Voz2.mp3”); sampleVoz2.loop(); sampleVoz2.amp(2.0); // Amplitud del sonido // Crear y conectar el rastreador de rms para Voz2 rmsVoz2 = new Amplitude(this); rmsVoz2.input(sampleVoz2); }

void draw() { // Suaviza los datos de rms por separado para el drone y las voces

sumDrone += (rmsDrone.analyze() - sumDrone) * smoothingFactorDrone; sumVoz += (rmsVoz.analyze() - sumVoz) * smoothingFactorVoz; sumVoz1 += (rmsVoz1.analyze() - sumVoz1) * smoothingFactorVoz1; sumVoz2 += (rmsVoz2.analyze() - sumVoz2) * smoothingFactorVoz2;

// RMS escalado

float rms_scaled_drone = sumDrone; float rms_scaled_voz = sumVoz; float rms_scaled_voz1 = sumVoz1; float rms_scaled_voz2 = sumVoz2;

// Actualizar los tiempos de manera independiente if (activarTiempoDrone) { tiempoDrone += rms_scaled_drone; // Actualiza tiempoDrone

} if (activarTiempoVoz) { tiempoVoz += rms_scaled_voz * ralentizacionFactorVoz; // Ralentiza tiempoVoz

}

if (activarTiempoVoz1) { tiempoVoz1 += rms_scaled_voz1 * ralentizacionFactorVoz1; // Ralentiza tiempoVoz1

} if (activarTiempoVoz2) { tiempoVoz2 += rms_scaled_voz2 * ralentizacionFactorVoz2; // Ralentiza tiempoVoz2

}

// Enviar valores al shader shader.set(“resolution”, (float)width, (float) height);

shader.set(“texture0”, imagen); shader.set(“texture1”, imagen1); shader.set(“texture2”, imagen2); shader.set(“texture3”, imagen3);

shader.set(“tiempoDrone”, tiempoDrone); shader.set(“tiempoVoz”, tiempoVoz);

shader.set(“tiempoVoz1”, tiempoVoz1);

shader.set(“tiempoVoz2”, tiempoVoz2); shader.set(“tiempoGlobal”, (float)millis() * 0.0008);

shader(shader); rect(0, 0, width, height);

// Controlar la reproducción de sampleDrone if (activarSampleDrone) { if (!sampleDrone.isPlaying()) { sampleDrone.loop();

}

} else { if (sampleDrone.isPlaying()) { sampleDrone.stop(); } }

// Controlar la reproducción de sampleVoz if (activarSampleVoz) { if (!sampleVoz.isPlaying()) { sampleVoz.loop(); }

} else { if (sampleVoz.isPlaying()) { sampleVoz.stop(); } }

// Controlar la reproducción de sampleVoz1 if (activarSampleVoz1) { if (!sampleVoz1.isPlaying()) { sampleVoz1.loop(); }

} else {

if (sampleVoz1.isPlaying()) { sampleVoz1.stop(); } }

// Controlar la reproducción de sampleVoz2 if (activarSampleVoz2) { if (!sampleVoz2.isPlaying()) { sampleVoz2.loop(); } } else { if (sampleVoz2.isPlaying()) { sampleVoz2.stop(); } } } void keyPressed() { if (key == ‘d’ || key == ‘D’) { activarTiempoDrone = !activarTiempoDrone; activarSampleDrone = !activarSampleDrone; // Reiniciar tiempoDrone cuando se active if (activarTiempoDrone) { tiempoDrone = 0.0; } } if (key == ‘v’ || key == ‘V’) { activarTiempoVoz = !activarTiempoVoz; activarSampleVoz = !activarSampleVoz; // Reiniciar tiempoVoz cuando se active if (activarTiempoVoz) { tiempoVoz = 0.0; } } if (key == ‘1’) { activarTiempoVoz1 = !activarTiempoVoz1; activarSampleVoz1 = !activarSampleVoz1; // Reiniciar tiempoVoz1 cuando se active if (activarTiempoVoz1) { tiempoVoz1 = 0.0; } } if (key == ‘2’) {

activarTiempoVoz2 = !activarTiempoVoz2; activarSampleVoz2 = !activarSampleVoz2; // Reiniciar tiempoVoz2 cuando se active if (activarTiempoVoz2) { tiempoVoz2 = 0.0; } } }

Este cuadernillo fue diseñado especialmente con motivo del XXIV Festival Internacional de la Imagen. Su contenido corresponde al texto completo de la ponencia presentada en el XXI Foro Académico Internacional de Diseño y Creación, en mayo de 2025, Manizales, Colombia.

El proyecto contenido en esta ponencia fue desarrollado en 2024 en el marco de la Maestría en Artes Electrónicas de la Universidad Nacional de Tres de Febrero, Buenos Aires, Argentina.

CRÉDITOS

[diseño conceptual e investigación] Dani Vera [producción técnica] Dani Vera [diseño editorial] Dani Vera

ACOMPAÑAMIENTO DE PROCESOS

[investigación artística] Paula Guersenzvaig, Paloma Catalá Del Río, Clara Cardinal [producción tecnológica] Leo Núñez, Santiago Fernández García [diseño sonoro] Julia Rossetti, Juanita Olaya

Impreso en Compañía de Impresiones en abril de 2025, Buenos Aires, Argentina

Ejemplar _______ de 15

FONDART Nacional / Beca Chile Crea - Fondart Convocatoria 2024 / Proyecto Folio: 698517

FONDART Nacional / Línea de Circulación Nacional e Internacional / Convocatoria 2025 / Proyecto Folio: 788202

Apoyaron la circulación de este proyecto: