REVISTA DE DIVULGACIÓN CIENTÍFICA DEL COZCYT

Volumen 10 Número 4 Junio - Julio 2023 Publicación Bimestral eek@cozcyt.gob.mx

Consulta la colección completa:

ArtículosyReportajes

Breve historia del Cálculo

Alan Turing: el padre de la inteligencia artificial

Atlas Genómico del Cáncer

Contenido

¿Por qué no se ven auroras boreales en México?

Ahuehuete /Lagarto enchaquirado

José Antonio Gómez Barrón

CuriososyPreguntones

FlorayFaunadeZacatecas

MedioAmbienteySociedad

El paracetamol, un contaminante emergente de preocupación mundial

Laura Annette Romero De León- Leo Alvarado Perea

Alan Turing: el padre de la inteligencia artificial

Jesús Antonio Astorga Moreno

¿Cómo afecta la corrosión tu vida cotidiana?

María Fernanda Dueñas Arteaga . Haideé Ruiz Luna

Breve historia del Cálculo

Susana Leticia Burnes Rudecino . Pedro Rodríguez Juárez

Dra. Gabriela Cortez Pérez

Redacción COZCyT

ArtículosyReportajes

Nuestra Ciencia

ArtículosyReportajes

Redes Booleanas Aleatorias: ¿la Regulación Genética a nuestro alcance?

Alejandro Puga Candelas

Desarrollo de un detector de neutrones solares en Zacatecas (Parte I)

Jesús Iván Santamaría Najar

Atlas Genómico del Cáncer

Jared Eliacim Limones González. Gretel Mendoza Almanza

ExperimentandoconCienciayTecnología

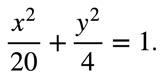

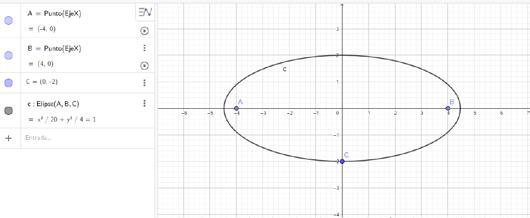

La magia de la elipse

Susana Leticia Burnes Rudecino

Vol. 10 No. 4

1 2 3 5 7 9 11 13 15 17 19

Editorial Directorio

David Monreal Ávila

Hamurabi Gamboa Rosales

Coordinador Editorial

José de Jesús Villa Hernández

Martha Cecilia Acosta Cadengo

Diana Arauz Mercado

Héctor Contreras Salazar

Gabriela Cortez Pérez

José Ismael De la Rosa Vargas

Fernando Favela Rosales

Efrén González Ramírez

Manuel Hernández Calviño

Gerardo Miramontes de León

Iván Moreno Hernández

María José Sánchez Usón

Beatriz Elizabeth Soto Bañuelos

Diana Villagrana Ávila

Nidia Lizeth Mejía Zavala

Ricardo Becerra Reyes

Laura Erika Romo Montano

Lo invitamos a visitar nuestra página https:// cozcyt.gob.mx/divulgacion/revista-eek/ antes de finalizar cualquier artículo de divulgación científica que tenga la intención de enviar. Con mucho gusto consideraremos su contribución.

Revista eek´ Volmen 10, Número 4, Junio - Julio 2023 es una publicación bimestral editada por el Consejo Zacatecano de Ciencia, Tecnología e Innovación (COZCyT). Av. de la Juventud No. 504, Col. Barros Sierra, C.P. 98090, Zacatecas, Zac. México. Tel. (492) 921 2816, www.cozcyt.gob. mx, eek@cozcyt.gob.mx. Editor responsable: Hamurabi Gamboa Rosales.

Reserva de Derechos al Uso Exclusivo No. 04-2021-120810465000-102, ISSN: 2954-3959, otorgados por el Instituto Nacional de Derechos de Autor. Responsable de la última actualización de este número: Consejo Zacatecano de Ciencia, Tecnología e Innovación (COZCyT), Dr. Hamurabi Gamboa Rosales, Av. de la Juventud No. 504, Col. Barros Sierra, C.P. 98090, fechas de última modificación, 21 de marzo de 2024.

Las opiniones expresadas por los autores no necesariamente reflejan la postura del editor de la publicación.

Se autoriza la reproducción total o parcial de los contenidos e imágenes, siempre y cuando se cite la fuente y no sea con fines de lucro.

Ya hace año y medio que el telescopio James Web fue lanzado al espacio para iniciar su misión de proporcionar al medio científico información de gran relevancia en el ámbito de la astronomía y de la cosmología; información a la que nunca antes podíamos haber tenido acceso debido principalmente a las limitaciones tecnológicas que se tenían. Entre otros, tres tipos de datos relevantes sobre el Universo nos ha proporcionado ya el famoso telescopio. Uno de ellos es sobre la radiación emitida por las primeras galaxias que se formaron después del Big Bang, la cual solo se detecta en el infrarrojo. Otro de ellos es el relacionado con la atmósfera de exoplanetas, información importante para determinar si tienen condiciones para desarrollar la vida. Además, información de gran relevancia relacionada con diferentes cuerpos de nuestro sistema solar, que incluye datos sobre características de sus atmósferas, su geología y su química.

En el presente número de eek’, en la sección de Curiosos y Preguntones, explicamos la razón por la que las auroras boreales no se ven en nuestro país. En la sección de Flora y Fauna de Zacatecas les hablamos sobre el árbol Ahuehuete y sobre el Lagarto enchaquirado. En la sección de Medio Ambiente y Sociedad hablamos sobre el paracetamol como contaminante emergente. En la sección de Artículos y Reportajes hablaremos sobre Alan Turing: el padre de la inteligencia artificial, sobre la corrosión, sobre la historia del Cálculo, sobre las redes Booleanas, sobre el desarrollo en Zacatecas de un detector de neutrones solares y, finalmente, sobre el proyecto del atlas genómico del cáncer. También, presentamos un reportaje sobre la Dra. Gabriela Cortes Pérez y sus trabajos de investigación referente a la lingüística. Finalmente, en la sección Experimentando con Ciencia y Tecnología, hablamos sobre la historia de la elipse.

Dr. en C. Hamurabi Gamboa Rosales

Director General del Consejo Zacatecano de Ciencia, Tecnología e Innovación

¿Por qué no se ven

auroras boreales en México?

No las vemos en México porque las auroras boreales son consecuencia de la interacción del viento solar con la configuración magnética de la magnetosfera de la Tierra.

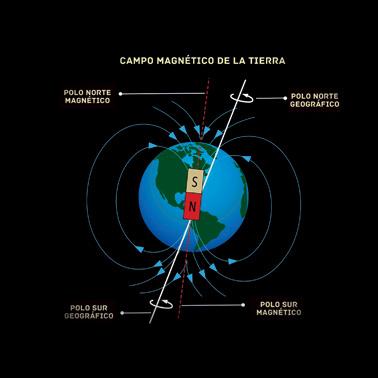

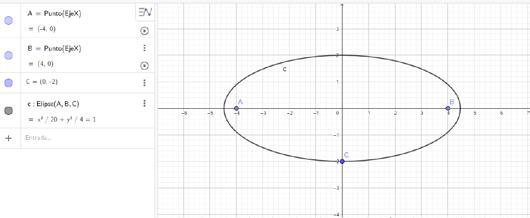

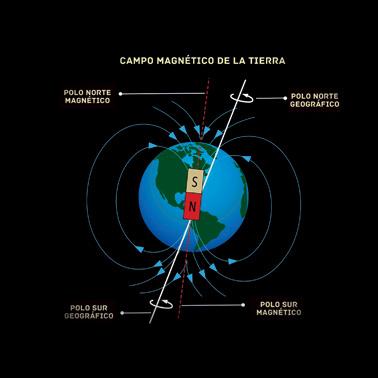

La forma más simple de visualizar el campo magnético de la Tierra es considerarlo como un imán, es decir, una barra con dos polos, Norte y Sur, podemos imaginar líneas magnéticas que salen por el Polo Norte y entran por el Polo Sur del imán. Así es el campo magnético de nuestro planeta. ¡La Tierra es un imán!

El viento solar es un plasma compuesto por partículas cargadas, iones y electrones, iones = positivos y electrones = negativos. Cuando estas partículas están o pasan cerca de una línea magnética se ven obligadas a girar alrededor de ella, hacia la izquierda cuando son positivas y a la derecha cuando son negativas y se trasladan tanto NS como SN. De esta forma, las partículas y el campo magnético son prácticamente inseparables.

El Sol constantemente emite un viento de partículas hacia todas las direcciones. La Tierra está embebida en ese plasma, así que constantemente llegan partículas cargadas del Sol, que obliga-

rán a que interactúen los campos magnéticos provenientes del Sol y el campo de la Tierra, Cuando la dirección de estos campos es opuesta, tiene lugar un proceso de reconexión magnética que facilita la entrada de las partículas solares y además las acelera obligándolas a seguir las líneas del campo magnético terrestre hacia los círculos polares. En esas regiones el campo magnético “abierto” permite la entrada de esas partículas a la atmósfera de la Tierra.

La atmósfera de la Tierra está compuesta mayoritariamente de nitrógeno en 78 %, luego de oxígeno 21 % y el resto de otros elementos. Cuando son colisionados por las partículas energéticas provenientes del Sol, radian luz en color verde y amarillo debido al oxígeno, y en azul y rosado debido al nitrógeno. Lo que forma las famosas auroras boreales.

La intensidad de las auroras depende de la energía que el viento solar transfiere a las partículas durante la reconexión magnética y la energía del viento solar depende del origen de este en el Sol. Cuando el viento está en calma, las auroras se ven solamente en los polos y no en latitudes cercanas al Ecuador.

Sin embargo, podría pasar que cuando hay tormentas solares y expulsan eyecciones de masa coronal muy energéticas, las auroras boreales se pueden ver en latitudes bajas, como durante la súper tormenta del 1 de septiembre de 1859, cuando se avistaron auroras boreales en México, Cuba, Jamaica y en San Salvador. Que se lleguen a ver en esos lugares, repito, depende de la energía de la tormenta solar. Hubo otro evento en el que las auroras se avistaron a latitudes muy al norte de México. Este evento ocurrió el 13 de marzo de 1989.

Las eyecciones de masa coronal, que son liberaciones esporádicas de grandes cantidades de masa, es decir, partículas cargadas, que arrastran consigo el campo magnético del Sol. Las eyecciones de masa coronal también son comunes pero las más violentas no. Como en el caso de los eventos de 1859 y 1989.

La probabilidad de que lleguen estos eventos, es un evento cada 80-100 años. Pero hay que tomar en cuenta que, su llegada no solo estará relacionada con el avistamiento de auroras en latitudes más cercanas al ecuador, pues al ser partículas cargadas también pueden causar disrupciones eléctricas, apagones mundiales e incomunicación satelital.

Agradecemos al Grupo GIRASoL del Instituto de Geofísica de la UNAM y al Dr. Alejandro Lara Sánchez por su colaboración.

Curiosos y Preguntones 1 Curiosos y Preguntones

Imagen 1. lustración del

(https://www.ecured.cu/Campo_magn%C3%A9tico_terrestre#/media/ File:Campo_magn%C3%A9tico_terrestre.jpg)

campo magnético Terrestre.

Jesús Iván Santamaría Najar sannji86@gmail.com

Flora y Fauna de Zacatecas

Ahuehuete Lagarto enchaquirado

Familia: Helodermatidae.

Familia: Cupressaceae.

Nombre científico: TaxodiummucronatumTen.

Nombre común: Ahuehuete.

Estatus de conservación: Especie nativa, Apéndice II IUCN 2022-2: Preocupación menor (LC).

Descripción: Es considerado “el árbol nacional” por su relevancia histórica en nuestro país, su nombre común deriva del náhuatl (ahuehuetl), que significa “viejo del agua”.

Árbol de crecimiento lento de 18 a 25 m y hasta 40 m si es una especie de crecimiento rápido. Tiene hojas aciculares de uno o dos cm de largo dispuestas en pequeñas ramitas. Su corteza tiene apariencia estriada. Tiene conos (estróbilos) femeninos pequeños (1.5 a 2.5 cm) y están presentes de febrero a noviembre. Los conos masculinos están presentes de febrero a marzo. En estos meses se realiza la polinización por viento.

Distribución y habitat: Forma parte importante de bosques ribereños o bosques de galería, a la orilla de ríos y arroyos. Los bosques de galería son agrupaciones de árboles que crecen a lo largo de corrientes de agua.

Se distribuye en gran parte de México, sobre todo en la altiplanicie y en zonas montañosas de las Sierra Madre Oriental y Occidental, Eje Volcánico Transversal Sierra Madre del Sur y en los estados de: Nuevo León, Tamaulipas, Coahuila, Sonora, Sinaloa, Durango, San Luis Potosí, Chiapas, Querétaro, Morelos, Cd. de México, Edo. de México, Hidalgo, Puebla, Veracruz, Michoacán, Guerrero, Oaxaca, Guanajuato, Nayarit, Jalisco, Tlaxcala, Tabasco y Zacatecas.

Uso: Árbol ornamental y de sombra. En cuanto a sus propiedades medicinales, la resina se usa para curar heridas, úlceras, enfermedades cutáneas, dolor de muelas, gota, dolores de cabeza y dolor de tipo reumático. La infusión de la corteza se usa como emenagogo y diurético. Con el tronco se combaten casos de bronquitis y afecciones del pecho.

Referencias

1. de La Especie, 1. Selección. (s/f). TTaaxxooddiiuumm mmuuccrroonnaattuumm TTeenn. Recuperado el 18 de septiembre de 2023, de Gob.mx:8080 website: http://www.conafor.gob.mx:8080/documentos/docs/13/1011Taxodium%20 mucronatum.pdf

2. CONABIO. (s/f-a). Ahuehuete. Recuperado el 18 de septiembre de 2023, de EncicloVida website: https://enciclovida.mx/especies/ 155336-taxodium-mucronatum.

Nombre científico: Helodermahorridum.

Nombre común: Lagarto enchaquirado.

Estatus de conservación: Especie endémica. NOM-059-SEMARNAT-2010: Amenazada (A). Apéndice II IUCN 2022-2: Preocupación menor (LC).

Descripción: Miden de 40 a 90 cm y pueden llegar a pesar hasta 4 kg. Se caracterizan por sus cuerpos que a simple vista parecen estar llenos de chaquiras pero en realidad son pequeñas protuberancias cubiertas de piel conocidas como osteodermos, término que significa "huesos en la piel".

Reproducción: Son ovíparos y las hembras depositan entre cuatro y doce huevos. El periodo de incubación aproximado es de entre cuatro y cinco meses.

Alimentación: Se alimentan de huevos de otros reptiles, aves y presas pequeñas como roedores. Este lagarto segrega una toxina llamada (Exedin-3), el mecanismo de acción de este veneno causa dolor, asfixia, parálisis, hipotermia, entre otras. El veneno se segrega por su dentadura acanalada situada en la parte inferior de su mandíbula.

Distribución: Su distribución es muy reducida, menor al 5 % del territorio nacional. Se encuentra mayormente distribuida en la costa del pacífico, los registros de los últimos años, indican su presencia en el municipio de Monte Escobedo, Zacatecas.

Hábitat: Habitan en climas templados – húmedos, se refugian cerca de arroyos, acantilados rocosos, árboles y en el suelo. Escalan y trepan en los árboles, especialmente en la época lluviosa.

Usos: La toxina Exedin-3, se ha estudiado como posible tratamiento para diabetes tipo 2, Alzheimer y mal de Parkinson.

Referencias

1. CONABIO. (s/f). Lagarto de chaquira. Recuperado el 18 de septiembre de 2023, de EncicloVida website: https://enciclovida.mx/especies/26699-heloderma-horridum

2. El lagarto enchaquirado: Una mordida que no se olvida. (s/f). Recuperado el 18 de septiembre de 2023, de Unam.mx website: https://blogs.ciencia.unam.mx/lahuella/2015/06/08/ellagarto-enchaquirado-una-mordida-que-no-se-olvida/

3. Raufman, J. P., Singh, L., & Eng, J. (1991). Exendin-3, a novel peptide from Heloderma horridum venom, interacts with vasoactive intestinal peptide receptors and a newly described receptor on dispersed acini from guinea pig pancreas. Description of exendin-3(9-39) amide, a specific exendin receptor antagonist. The journal of biological chemistry, 266(5). Recuperado de https:// pubmed.ncbi.nlm.nih.gov/1704369/

4. (S/f). Recuperado el 18 de septiembre de 2023, de Herp.mx website: http://www.herp.mx/ pubs/1991-Beck-Lowe-Ecology-of-the-Beaded-Lizard-Heloderma-horridum-in-a-Tropical-DryForest-in-Jalisco-Mexico.pdf

2

Flora y Fauna de Zacatecas

2 Flora y Fauna de Zacatecas

José Antonio Gómez Barrón jose.gomez2001@alumnos.udg.mx

El paracetamol,

Laura Annette Romero De León

Adscripción: Universidad Autónoma de Zacatecas. LGACs que trabaja:Descontaminación de agua, Fotocatálisis.

Proyecto principal: Síntesis, caracterización y aplicación de materiales mesoporosos novedosos para la degradación de contaminantes orgánicos presentes en el agua mediante fotocatálisis heterogénea.

Leo Alvarado Perea laura.romero@uaz.edu.mx

leoap@uaz.edu.mx

Adscripción: Unidad Académmica de Ciencias Químicas, Universidad Autónoma de Zacatecas.

Proyecto principal: Desarrollo de materiales novedosos para producción de compuestos químicos de alto valor agregado y la descontaminación de agua.

un contaminante emergente de preocupación mundial

El agua es imprescindible para el desarrollo de la vida en la Tierra. Todos los días, diversos sectores como el industrial, agrícola y farmacéutico, así como la población en general, usan agua para llevar a cabo sus actividades. Por lo tanto, las aguas residuales que éstos generan, están contaminadas por compuestos de distinto origen.

En las urbes, las aguas residuales son tratadas mediante tecnologías convencionales como la floculación, adsorción con carbón activado, degradación biológica y cloración [1], entre otras. Posterior a este tratamiento, las aguas residuales son reutilizadas o descargadas directamente en suelos y cuerpos de aguas superficiales locales o acuíferos de aguas subterráneas [2]. Sin embargo, estas tecnologías fueron desarrolladas para reducir bacterias y contaminantes prioritarios, de los que se conocen sus efectos sobre la salud y el medio ambiente [2]. En consecuencia, resultan poco eficientes para la eliminación de cientos de

nuevos contaminantes que son persistentes, bioacumulativos y tóxicos [3]. Estos contaminantes han sido encontrados en reservorios de agua para consumo humano, plantas de tratamiento de agua potable y de aguas residuales, aguas subterráneas, aguas superficiales, ríos y mares [4]. Debido a que son capaces de transportarse libremente de manera descontrolada y son ubicuos en el medio ambiente [3], [4], estos contaminantes tan solo son desplazados pero no eliminados [1].

Normalmente, estos compuestos se encuentran en el medio ambiente acuático en bajas concentraciones, en el rango de nanogramos a microgramos por litro (ng/L-μg/L) [5]. No obstante, pueden acumularse en el ecosistema durante décadas, ocasionando la pérdida de hábitats y biodiversidad, convirtiéndose en una amenaza para el medio ambiente y la salud humana. En conjunto, estos compuestos se denominan, contaminantes emergentes [2].

¿Qué es un contaminante emergente?

Un contaminante emergente es cualquier microorganismo o compuesto químico natural o sintético, que se encuentra en el medio ambiente y, que comúnmente, no se controla; es decir, que no está sujeto a normas o reglamentos debido a la falta de información con respecto a su toxicidad o efecto sobre la vida terrestre y acuática, así como en la salud humana [4], [6]. Su presencia en el medio ambiente es el resultado de la urbanización y densidad de población, así como de la amplia gama de productos y sustancias que se utilizan diariamente, por considerarse esenciales [4].

Diversas categorías de contaminantes emergentes, como productos farmacéuticos y de cuidado personal, pesticidas [4], [6], surfactantes, retardantes de llama, aditivos industriales, narcóticos o drogas ilegales y derivados de la industria alimentaria [4] entre otros, son una preocupación creciente y un problema serio a nivel mundial.

3 Artículos y Reportajes Artículos y Reportajes

Qué grupo de contaminantes emergentes representa un mayor riesgo

En los últimos años, se han llevado a cabo muchas investigaciones enfocadas en el estudio de los contaminantes emergentes encontrados en el suelo y en los diferentes medios acuáticos. Estas investigaciones tienen el objetivo de conocer sus efectos toxicológicos en el medio ambiente y la salud y, de esta manera, contribuir con información relevante para su regulación y límites de concentración permisibles, antes de ser descargados.

Los productos farmacéuticos comprenden una gran variedad de compuestos químicos y naturales diseñados para el tratamiento y prevención de enfermedades humanas y animales [1], [7]. Anualmente, se distribuyen y consumen cientos de toneladas de productos farmacéuticos en todo el mundo. Existen numerosos estudios que demuestran la presencia de compuestos medicinales y sus metabolitos en aguas residuales, aguas subterráneas y superficiales; así como en sedimentos y suelo [1]. Estos compuestos ingresan al medio ambiente debido al tratamiento inadecuado de las aguas residuales [1], la eliminación incorrecta de los medicamentos caducados [8], la aplicación de estiércol como fertilizante en las tierras de cultivo [7] o, en los efluentes provenientes de los sitios su fabricación [8]. Estos contaminantes no se degradan con facilidad y, debido a su estructura estable, persisten en el medio ambiente durante meses o años, acumulándose hasta alcanzar cantidades detectables y biológicamente activas [5], [7], [8].

Los contaminantes farmacéuticos se han encontrado en el entorno natural de todo el mundo [7], generalmente en bajas concentraciones [1], [5], [7]. Sin embargo, debido a que son los principales contribuyentes de contaminantes emergentes y, a que pueden causar efectos adversos en la salud humana y el medio ambiente, son un tema de investigación continua.

¿Por qué el paracetamol es un contaminante emergente?

El paracetamol, también llamado acetaminofén y de nombre químico N-acetil-p-aminofenol (C8H9NO2), fue sintetizado en 1877 en la Universidad Johns Hopkins. Este medicamento ganó popularidad en la práctica clínica debido a su acción analgésica y antipirética porque cuando se utiliza en dosis terapéuticas, rara vez ocurren efectos adversos en comparación con otros medicamentos [9]. Debido a ello, es uno de los fármacos más comunes, comercialmente disponible y ampliamente utilizado a escala mundial [1], [5]. En algunos países, su consumo supera las 200 toneladas anuales [10]. Tan sólo en México, ya sea solo o combinado, se encuentra disponible en más de 400 medicamentos, utilizados para aliviar dolores de cabeza, dentales y musculares; así como cólicos menstruales, resfriados y fiebre [11].

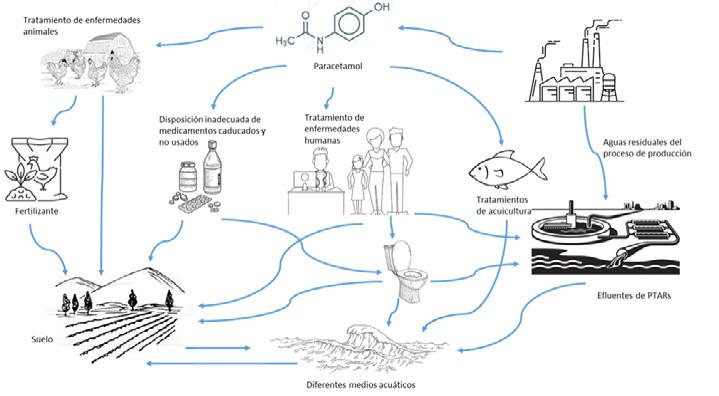

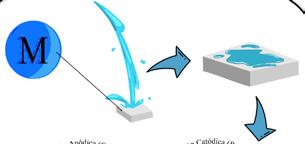

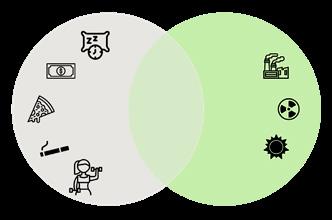

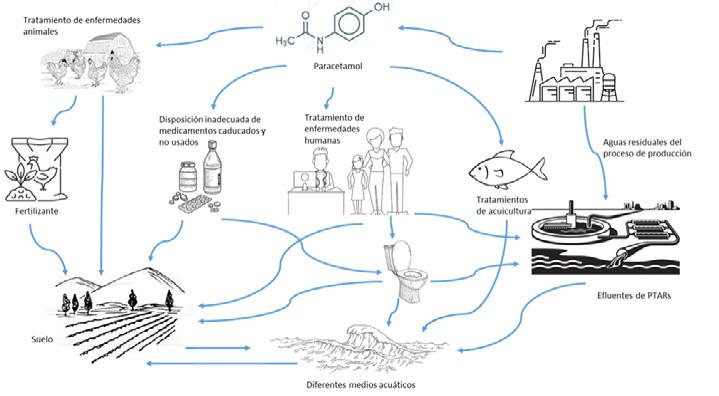

Este medicamento, que ha sido empleado desde hace varias décadas, se ha liberado de manera continua al medio ambiente, principalmente a través de los efluentes de las plantas de tratamiento de aguas residuales (PTARs) y la eliminación incorrecta de los medicamentos vencidos o no utilizados (Figura 1) [2]. Diferentes concentraciones de paracetamol (0.47-64,000 ng/L) han sido reportadas en aguas re-

siduales, aguas superficiales, ríos y agua de mar, entre otros [4].

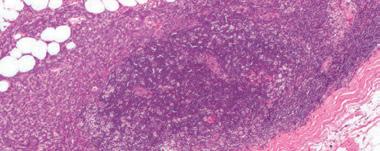

Diversos estudios han encontrado que, en humanos, altera la vía esteroidogénica y aumenta la estrogenicidad de las células suprarrenales H295R y, en animales, ocasiona cirrosis y necrosis hepática crónica [2], afectaciones a la médula espinal, reducción en la síntesis de aminoácidos en las células cerebrales y, disminución en la calidad y cantidad del esperma [4]. Mientras que, en especies acuáticas, afecta el desarrollo embrionario [2] y reduce los niveles de hemoglobina, hematocrito y testosterona [4]. En plantas, inhibe el crecimiento, reduce la acumulación de clorofila y la síntesis de proteínas [4].

Existe una preocupación mundial vinculada al impacto del paracetamol sobre la salud humana, así como en animales terrestres y acuáticos. Sin embargo, es evidente que su presencia en el medio ambiente depende de su tasa de producción, dosis, frecuencia de administración y uso, así como la eficiencia de eliminación en las PTARs. Es por ello que, continuamente, se realizan investigaciones enfocadas al desarrollo de tecnologías que garanticen su correcta eliminación desde su principal fuente de emisión.

[1].Le, T.X.H.; Nguyen, T. Van; Amadou Yacouba, Z.; Zoungrana, L.; Avril, F.; Nguyen, D.L.; Petit, E.; Mendret, J.; Bonniol, V.; Bechelany, M.; et al. Correlation between degradation pathway and toxicity of acetaminophen and its by-products by using the electro-Fenton process in aqueous media. Chemosphere 2017, 172, 1–9.

[2]. Pal, A.; He, Y.; Jekel, M.; Reinhard, M.; Gin, K.Y.-H. Emerging contaminants of public health significance as water quality indicator compounds in the urban water cycle. Environ. Int. 2014, 71, 46–62.

[3]. USEPA Occurrence of contaminants of emerging concern in wastewater from nine publicly owned treatment works.; Washington, 2009;

[4]. López-Pacheco, I.Y.; Silva-Núñez, A.; Salinas-Salazar, C.; Arévalo-Gallegos, A.; LizarazoHolguin, L.A.; Barceló, D.; Iqbal, H.M.N.; ParraSaldívar, R. Anthropogenic contaminants of high concern: Existence in water resources and their adverse effects. Sci. Total Environ. 2019, 690, 1068–1088.

[5]. Samal, K.; Mahapatra, S.; Hibzur Ali, M. Pharmaceutical wastewater as Emerging Contaminants (EC): Treatment technologies, impact on environment and human health. Energy Nexus 2022, 6, 100076.

[6]. Vasilachi, I.; Asiminicesei, D.; Fertu, D.; Gavrilescu, M. Occurrence and Fate of Emerging Pollutants in Water Environment and Options for Their Removal. Water 2021, 13, 181.

[7]. Boxall, A.B.A.; Rudd, M.A.; Brooks, B.W.; Caldwell, D.J.; Choi, K.; Hickmann, S.; Innes, E.; Ostapyk, K.; Staveley, J.P.; Verslycke, T.; et al. Pharmaceuticals and personal care products in the environment: What are the big questions? Environ. Health Perspect. 2012, 120, 1221–1229.

[8]. Zuccato, E.; Calamari, D.; Natangelo, M.; Fanelli, R. Presence of therapeutic drugs in the environment. Lancet 2000, 355, 1789–1790.

[9]. Ameer, B.; Greenblatt, D.J. Acetaminophen. Ann. Intern. Med. 1977, 87, 202–209.

[10]. Stuer-Lauridsen, F.; Birkved, M.; Hansen, L.P.; Holten Lützhøft, H.C.; Halling-Sørensen, B. Environmental risk assessment of human pharmaceuticals in Denmark after normal therapeutic use. Chemosphere 2000, 40, 783–793.

[11]. COFEPRIS Listado actualizado de medicamentos de referencia 2022/01; 2022.

4 Artículos y Reportajes Artículos y Reportajes

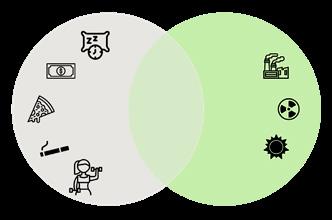

Figura 1. Fuentes de emisión de paracetamol (y compuestos farmacéuticos) al medio ambiente. Modificado de [9].

Jesús Antonio Astorga Moreno jesus.astorga@cinvestav.mx

Adscripción: Departamento de Física del CINVESTAV, Zacatenco. LGACs que trabaja: Cosmología, Gravitación y Física-Matemáticas. Proyecto principal: Cosmología y cadenas de fragmentación.

Alan Turing: El padre de la inteligencia artificial

Podemos notar en algunos textos de ciencia ficción que unos de los sueños más antiguos y largamente acariciados por la ciencia, es el de crear máquinas o robots inteligentes. Bajo ese mismo razonamiento, Alan Turing, en su artículo de 1936 [1], introdujo lo que hoy se conoce como “Máquina de Turing”, un artilugio teórico basado en el principio de que una máquina puede imitar a cualquier otra máquina. Hoy sabemos que la Inteligencia Artificial es un recurso científico y tecnológico que persigue modelar los procesos de la mente y su conexión con el cuerpo mediante programas de cómputo. Esta disciplina tiene sus orígenes en la década de los años 50 [2], cuando Turing, aunque no acuñó el término, fue el primero en abordar esta problemática en un artículo y diseñar un estudio académico formal para resolverlo, como anuncia al principio de su trabajo con la siguiente pregunta: ¿pueden pensar las máquinas?

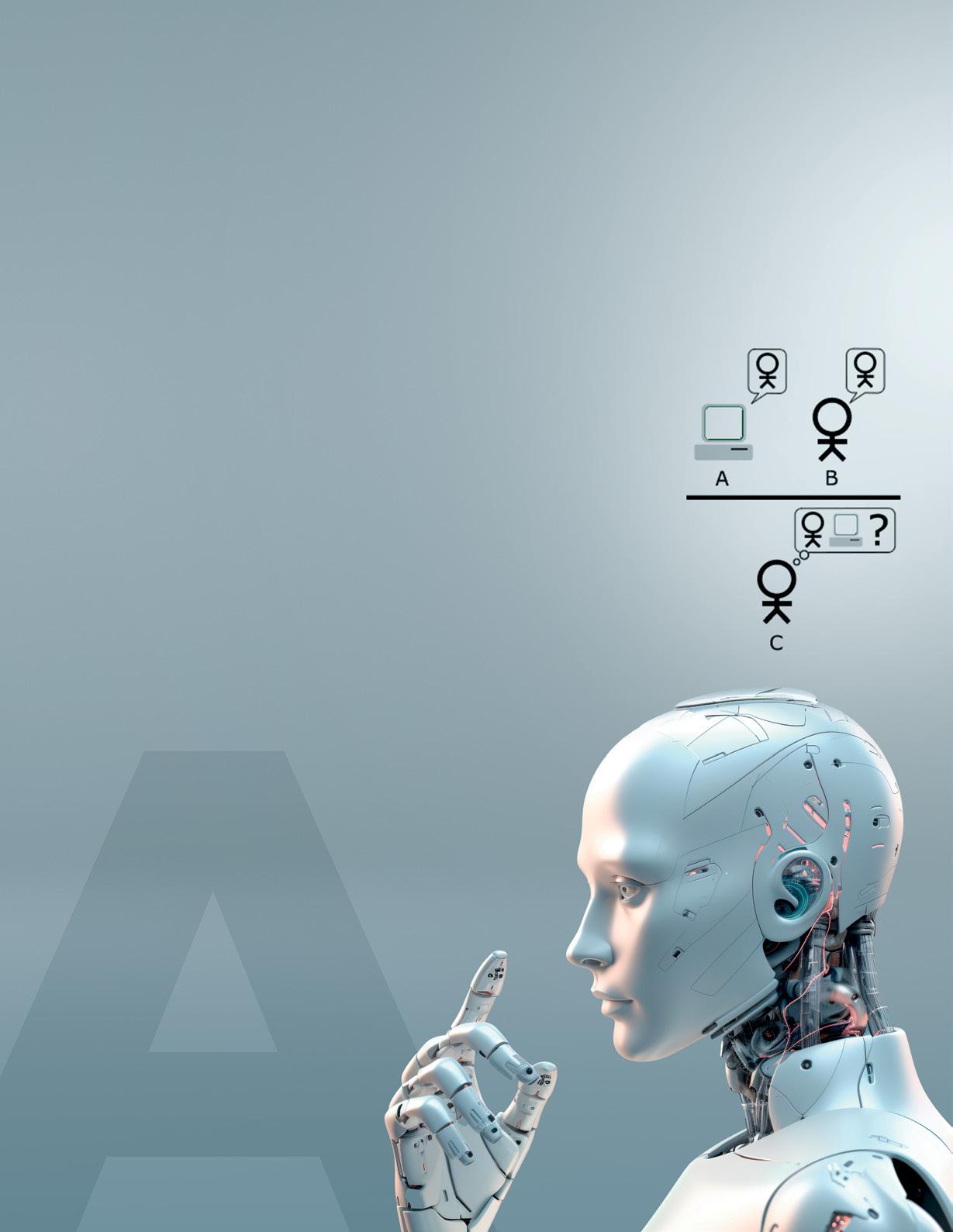

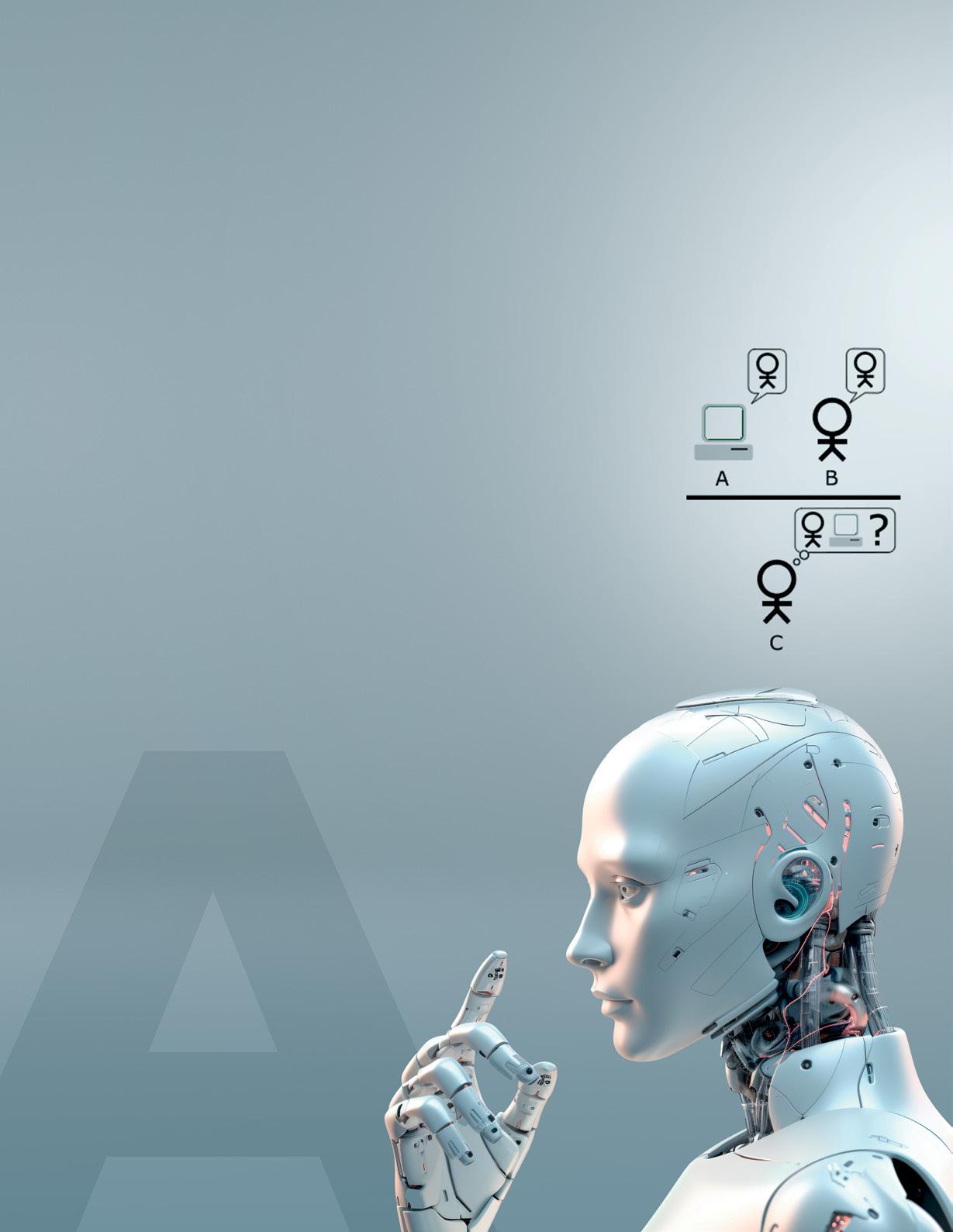

Para determinarlo, propone su famoso test llamado a revolucionar la informática y crear un nuevo campo de investigación: la inteligencia artificial. Tratando de responder a la pregunta de cómo saber si una máquina es inteligente, propuso un curioso experimento: un entrevistador tiene que comunicarse (por ejemplo, con teclado y pantalla) con el entrevistado.

En una habitación, hay un entrevistado humano y en otra hay una máquina dotada de un algoritmo adecuado.

Si dicho algoritmo no proporciona respuestas adecuadas a las preguntas que se le formulan, será muy fácil detectar que en la habitación está una máquina: pero, ¿qué sucedería si el algoritmo fuera lo suficientemente complejo? En este caso sería difícil diferenciar el hombre de la máquina. Por tanto, según el Test de Turing, una máquina sería inteligente si consiguiera engañar al entrevistador de turno.

La prueba sigue siendo objeto de acalorados debates y ha dado lugar a décadas de derivaciones, discusiones y experimentos, todos ellos relacionados con los dispositivos modernos que él imaginó, aunque limitados por la insuficiente tecnología de su época. Turing creía que para el año 2000 el interrogador promedio tendría menos 70 % de posibilidades de acertar, después de un interrogatorio de cinco minutos.

En 1990, el neoyorquino Hugh Loebner estableció una competencia con un premio de $100,000 dólares para quien creara una máquina que pasara dicha prueba. Muchos expertos en Inteligencia Artificial apoyaron esta iniciativa, hasta que se hizo evidente lo malo que era el desempeño de las máquinas. Veintidós años después, ninguna máquina ha ganado y ni siquiera ha estado cerca de hacerlo.

5 Artículos y Reportajes Artículos y Reportajes

Sin embargo, nadie en el mundo de la Inteligencia Artificial interpreta el fracaso para superar el Test de Turing como un argumento en contra de la posibilidad de crear una máquina que piense. Como siempre, se refirió a este tipo de máquina en un tiempo futuro, muchos creen que se podrá hacer más adelante, pero otros simplemente consideran que la prueba del científico no es la herramienta más adecuada para medir la capacidad de razonamiento de una máquina [3].

Aunque las computadoras aún no han logrado engañarnos y hacernos creer que son seres humanos, Turing seguramente se sentiría emocionado por los avances que se han logrado en el campo de la Inteligencia Artificial, la cual florece en muchas áreas: hay desde robots investigando el progreso del cambio climático hasta computadoras que controlan el mundo de las finanzas. Me imagino que hubiese saltado de alegría cuando la computadora Deep Blue le ganó una partida de ajedrez al campeón mundial Gary Kasparov en 1997. También me lo puedo imaginar festejando cuando el programa Watson le ganó a los dos mejores participantes humanos del programa de televisión Jeorpardy.

Es difícil pensar cómo cualquiera de estos logros podría haber sido posible sin las ideas originales y radicales del científico británico. En mi opinión, el Test de Turing continúa siendo una fórmula adecuada para medir el progreso de la Inteligencia Artificial y creo que los seres humanos continuarán debatiendo sobre su validez

por muchos años. Sin embargo, no hay un único modelo de representaciones de la mente, como tampoco hay un enfoque computacional único.

La propuesta funcionalista, por ejemplo, asume que la mente es una máquina de Turing que opera sobre estructuras en forma de reglas de transición entre estados. En esta visión, los estados mentales se corresponden con estados físicos del cerebro; lo que cuenta es lo que las funciones puedan realizar, independientemente del hardware que les dé cuerpo. Así, podemos decir que un robot tiene ciertos estados mentales, expresados en chips de silicón en lugar de neuronas.

Por otra parte, el enfoque conexionista ha propuesto ideas novedosas de representación y computación que usan una representación de neuronas y sus conexiones como inspiraciones para dar cuerpo a las estructuras de datos, así como las activaciones neuronales como inspiraciones para modelar algoritmos. En el medio computacional, este enfoque se conoce como redes neuronales, y tiene también antecedentes en el trabajo de Turing.

Sólo nos queda mencionar que su muerte fue prematura y triste, ya que se cree que se suicidó comiendo una manzana envenenada con cianuro, aunque la verdad no se conoce con certeza absoluta. En un juicio en el que tuvo que prestar declaración, derivado de un robo perpetrado en su casa, confesó que era homosexual, lo cual estaba penado en Inglaterra, por lo que le dieron como opción

ir a la cárcel o someterse a un “tratamiento” de castración química basado en hormonas. Eligió lo segundo, pero la consecuencia fue la pérdida de su forma física, ya que era un consumado atleta que incluso estuvo a punto de ser elegido para asistir a los Juegos Olímpicos. Las repercusiones psicológicas fueron grandes y posiblemente perturbaron aún más su mente, cosa que para un científico destacado como él debió ser una gran desdicha al verse incapaz de pensar con claridad.

Lo relevante y que en cierto sentido viene a dar justicia, es que sus contribuciones han transcendido por su importancia para el goce de las generaciones presentes y venideras, así como para la ciencia. Con todo lo expuesto, no podemos dudar que tiene bien ganado el mérito de ser quizá el primer y mayor de los padres conceptuales de las computadoras, tal y como las conocemos hoy en día. Quién sabe a qué hubiera llegado un espíritu agudo y creativo como el de él si no hubiera muerto a los 42 años.

En cualquier caso, es claro que la sociedad y sobre todo las personas que imparten la justicia, no fueron recíprocos con este genio polifacético del siglo XX, en relación con sus impresionantes contribuciones a la humanidad.

Referencias

[1]. A. M. Turing, “On Computable Numbers, with an Application to the Entscheidungsproblem”, (Proceedings of the London Mathematical Society (2), vol. 42, pp. 230-265, 1936.

[2]. A. M. Turing, “Computing machinery and intelligence”, Mind, 59(236):433-460, 1950.

[3]. G. Esparza, “Alan Turing: bases, forma y críticas a la inteligencia artificial“, : Sección monográfica: filosofía e inteligencia artificial ,vol. 48, 2021

6 Artículos y Reportajes Artículos y Reportajes

¿Cómo afecta la corrosión tu vida cotidiana?

María Fernanda Dueñas Arteaga

Adscripción: Universidad Autónoma de Zacatecas, Unidad Académica de Ingeniería I, Ingeniería en Manufactura.

LGACs que trabaja: Estudio de propiedades corrosivas en materiales; Procesos de Manufactura: Caracterización de Materiales.

Haideé Ruiz Luna 36173662@uaz.edu.mx ruluhaid@uaz.edu.mx

Adscripción: CONACYT-Universidad Autónoma de Zacatecas, adscrita a la Maestría en Ciencia a Ingeniería de los Materiales.

LGACs que trabaja: Síntesis y caracterización de materiales avanzados; Recubrimientos superficiales; Caracterización y desempeño de materiales/recubrimientos.

Proyecto principal: Estudio y Síntesis de Aleaciones Nanoestructuradas Base Cobalto y Níquel con Propiedades Anticorrosivas a Alta y Baja Temperatura”, con clave CB2016-01-286086

El fenómeno de la corrosión se presenta pasivamente en nuestro día a día sin darnos cuenta. Lo podríamos plantear como un agente silencioso (algo así como un cáncer para materiales) que afecta desde la chapa de la puerta que después de una temporada húmeda ya no es tan suave como antes, hasta la tubería de una ciudad donde el agua puede ser tan pesada que carga con sales y metales, haciendo que los ductos no estén en sus óptimas condiciones provocando su desgaste y eventual falla. La corrosión puede definirse como el deterioro de una sustancia (usualmente un metal) debido a una reacción química con su medioambiente [1]. Así es como el ambiente húmedo afectó al resorte de la chapa y la composición natural del agua dañó los ductos hidráulicos de la ciudad.

La corrosión puede verse a simple vista, un ejemplo de ello es esa desagradable capa color marrón que se forma comúnmente sobre la superficie de alguna pieza, según el tipo de componente metálico. Esta capa se debe al contacto directo del material con el oxígeno y puede dar como resultado la formación de

una capa de óxido [2]. En algunos casos dicha capa es uniforme y proporciona protección ante un ataque adicional del ambiente, en otros, no protege puesto que tiende a agrietarse y desprenderse. Un ejemplo de ello puede observarse en las conexiones estructurales de edificios comunes (ver Figura 1) y ocurre debido a la presencia de oxígeno y humedad en el ambiente.

La corrosión de materiales se puede clasificar en tres principales grupos: corrosión en húmedo, por sales o metales fundidos y seca [3]. La primera incluye como medio agua natural, humedad atmosférica, lluvia e incluso soluciones desarrolladas por el humano. Este tipo de corrosión se debe normalmente a la conductividad iónica (traspase de partículas cargadas eléctricamente) del sistema material-solución. En el segundo grupo, la degradación en el metal por corrosión es acelerada por una película delgada de sal fundida en presencia de un ambiente oxidante a elevada temperatura. El tercer tipo de corrosión ocurre sin necesidad de existir un líquido de por medio. Cualquier metal puede oxidarse si hay flujo de oxígeno (o gases

como hidrógeno, sulfuro, nitrógeno o halógenos) y ésto se produce a un ritmo mucho más rápido a altas temperaturas [2].

En el estudio de la corrosión, no solo es importante investigar el comportamiento de los materiales en diversos ambientes, sino también la velocidad con la que el proceso corrosivo ocurre para así determinar la vida media del material en condiciones establecidas. Si bien esta fuerza destructiva ha existido siempre, se le ha prestado atención hasta los tiempos modernos como efecto de los avances de la civilización [4].

De los tres tipos de corrosión conocidos nos centraremos en el fenómeno de la corrosión húmeda o en soluciones líquidas debido a su frecuencia en nuestro entorno.

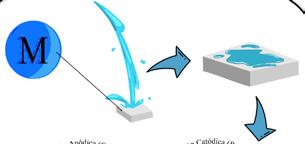

Si analizamos el comportamiento de un metal cualquiera en contacto con un líquido en el sistema se tendrían dos reacciones denominadas anódica y catódica, dado que este tipo de corrosión es naturalmente electroquímica.

Imaginemos un metal divalente llamado “M” en una solución acuosa, conocida como electro-

7 Medio Ambiente y Sociedad Medio Ambiente y Sociedad

lito, que contiene oxígeno y es conductora (Figura 2 a). El proceso de corrosión involucrará la reacción anódica (también llamado proceso de oxidación), en donde el metal disuelto se transfiere al electrolito como iones positivos M2 (cationes) (Figura 2 b) produciéndose electrones los cuales permanecen en el metal. En la reacción catódica (proceso de reducción) el metal ve reducida su carga de valencia y hay un consumo de electrones producidos en la reacción anódica (Figura 2 c). Ambas reacciones deben ocurrir al mismo tiempo y a la misma velocidad global para evitar una concentración de carga eléctrica en el metal. El producto de estas reacciones puede verse reflejado en la formación de una capa de óxido en la superficie del metal "M" (Fig 2 d) [1].

Este principio es el método clásico de evaluación de daños por corrosión y consiste en la exposición de una muestra en el medio por estudiar, sometida a las mismas condiciones que se presentan en la práctica, es decir, condiciones reales de trabajo. La resistencia a la corrosión bajo condiciones específicas se determinan por la velocidad de reducción del espesor del metal convertido en óxido por unidad de tiempo (mm/año) [5]. Los inconvenientes de este método es que para algunos casos el comportamiento de una probeta metálica no es exactamente como una estructura real (llámese tuberías, tanques, calderos, etc.), puesto que no está sometida a las mismas tensiones y porque obtener una correlación

aproximada del tiempo de vida útil del material supone tiempos de exposición prolongados, que pueden durar días, meses e incluso años, según el tipo de información que se desee obtener. Para solventar dichas desventajas y determinar la velocidad de corrosión se han desarrollado los métodos electroquímicos los cuales se basan en ensayos de polarización. Estos presentan varias ventajas en relación con el método de pérdida de peso como poco gasto de tiempo para realizar las medidas experimentales, pueden obtenerse medidas semi-continuas y rápidas, lo que resulta útil tanto en estudios cinéticos como para monitorear la corrosión en procesos de planta [6].

La aplicación de técnicas de polarización, tales como la potenciostática y la potenciodinámica, han sido exitosas en la evaluación de la velocidad de corrosión y también en el estudio de los fenómenos involucrados en la reacción de corrosión [7]. El uso de estas técnicas se ha vuelto rutinario, sobre todo con la ayuda de las computadoras y de los programas que permiten llevar a cabo de manera automática los experimentos y el análisis de los resultados obtenidos, simplificando enormemente el trabajo de obtención de las curvas experimentales [8]. Uno de los principales equipos, denominado potenciostato, para realizar estas pruebas, ha sido desarrollado desde 1942 y consta de 3 electrodos potenciostáticos necesarios para medir la diferencia de potencial entre nuestra aleación a analizar (electrodo de tra-

bajo) y un material con potencial de reducción estable (electrodo de referencia) por medio de un contra electrodo que aplica corriente medida como una caída de tensión en una resistencia en serie [9].

El deterioro debido al entorno es tan importante que no solo es aplicable a productos metálicos, también existe el deterioro de otros materiales como la madera, cerámica, plásticos, entre otros, como consecuencia de su medio ambiente. La relevancia en su estudio recae en evitar la falla del material a causa de algún daño en su estructura interna, así como poder prevenir la falla, ya sea mediante la aplicación de recubrimientos o tratamientos para aumentar la vida útil del material [10].

La temprana detección del proceso corrosivo nos llevará a tomar medidas precautorias, ya sea seleccionando un material mejor para llevar a cabo la tarea si dentro de las posibilidades está cambiar el medio ambiente: ya sea removiendo oxígeno o añadiendo inhibidores anticorrosivos, cambiando el diseño del sistema para así evadir la corrosión, cambiando el potencial (normalmente al hacer el metal. más negativo para contrarrestar la tendencia natural de los iones positivos del metal por transferirse al ambiente) o depositando sobre la superficie del material recubrimientos protectores o de sacrificio, con la finalidad de incrementar el tiempo de vida medio del material en cuestión.

Figura 2 . a) Plaquita de átomos M cubierta de agua, b) Reacción anódica; encargada de arrancar electrones de los

electrones en el agua creando un anión hidróxido

Referencias

[1] E. Bardal, Corrosion and Protection. Springer, 2003.

[2] Y. Meas and et.al, Técnicas Electroquímicas para el control y estudio de la corrosión. Querétaro, 2001.

[3] R. F. Decker and E. L. Langer, Metals Handbook, Ninth., vol. 13A-Corrosion. American Society for Metals International, 1986. Accessed: Jan. 29, 2023. [Online]. Available: https://edisciplinas. usp.br/pluginfile.php/5955752/mod_resource/ content/1/ASM Metals HandBook Volume 13Corrosion.pdf

[4] Y. Yan et al., “Corrosion behavior of stainless steel-tungsten carbide joints brazed with AgCuX (X = In, Ti) alloys,” Corros. Sci., vol. 200, p. 110231, May 2022, doi: 10.1016/j.corsci.2022.110231.

[5] UNE, “Corrosión de metales y aleaciones, Términos principales y definiciones.” Madrid-España, 2020.

[6] R. Winston Revie and He. H. Uhlig, “Corrosion and Corrosion Protection,” Fourth.New Jersey: Wiley-Interscience a John Wiley & Sons, INC, 2008, pp. 12–13.

[7] J. Y. Hu, S. S. Zhang, E. Chen, and W. G. Li, “A review on corrosion detection and protection of existing reinforced concrete (RC) structures,” Constr. Build. Mater., vol. 325, p. 126718, Mar. 2022, doi: 10.1016/j.conbuildmat.2022.126718.

[8]P. Maass, Handbook of Hot‐Dip Galvanization. Wiley, 2011. doi: 10.1002/9783527636884.

[9] A. Hickling, “Studies in electrode polarisation. Part IV.—The automatic control of the potential of a working electrode,” Trans. Faraday Soc., vol. 38, pp. 27–33, 1942, doi: 10.1039/TF9423800027.

[10] G. Koch, “Cost of corrosion,” in Trends in Oil and Gas Corrosion Research and Technologies, Elsevier, 2017, pp. 3–30. doi: 10.1016/B978-0-08101105-8.00001-2.

8 Medio Ambiente y Sociedad Medio Ambiente y Sociedad

átomos M y lanzarlos a través del metal hasta la reacción catódica, c) Reacción catódica; aquí se consumen los

(OH)- y se junta con los iones libres del metal M formando d) Óxidos (Corrosión)-Dueñas

Figura 1 . Efecto de la corrosión en conexiones estructurales del conjunto Quantum-UAZ-Dueñas

a) b) c)

+

Breve historia del Cálculo

Susana Leticia Burnes Rudecino Pedro Rodríguez Juárez susana.burnes@uaz.edu.mx pedrordz@uaz.edu.mx

Adscripción: Unidad Académica de Preparatoria, Universidad Autónoma de Zacatecas. LGACs que trabaja: Educación, Procesamiento de señales, salud.

1Obtener la tangente de una curva en cualquier punto. Esto se utilizaba en el diseño de lentes ópticas o para determinar la dirección instantánea de una trayectoria curva. El problema se hacía complicado pues los griegos de la antigüedad, consideraban que la recta tangente a una curva estaba localizada a un lado del punto dado y no sobre la curva, ya que no se tenía una comprensión del límite de una función.

Adscripción: Unidad Académica de Preparatoria, Universidad Autónoma de Zacatecas. LGACs que trabaja: Educación, Agua subterránea, Electrónica aplicada.

El cálculo aparece como una herramienta para resolver problemas sobre cuestionamientos importantes que los hombres se hacían en la antigüedad, y que al paso del tiempo su estudio se convirtió en una poderosa herramienta en diferentes áreas de la ciencia aplicada.

Conocer la evolución de las ideas que dieron origen al cálculo, permite valorar la contribución de los diferentes personajes que participaron en el desarrollo de esta materia tan relevante de las Matemáticas Modernas. Sus inicios comienzan con el planteamiento de los siguientes problemas específicos:

2

Encontrar el máximo y/o mínimo de una función. Este problema surge de la necesidad en determinar la altura máxima de un proyectil al ser lanzado en batalla o para conocer la distancia máxima recorrida por los planetas, o también en la búsqueda de un diseño de barriles de vino cuya capacidad fuese máxima.

3

Calcular el área bajo una curva. En este caso se planteó el problema de la cuadratura de un círculo o bien, la determinación del área de una figura cualquiera empleando áreas de polígonos conocidas, de manera que se dificultaba el cálculo por no contar con polígonos que completaran el área de la figura, cuando ésta era irregular.

4

Determinar la longitud de una curva, llamada también rectificación de una curva. Un problema necesario para determinar la distancia de cualquier trayectoria, esto se complicaba pues se creía que la longitud de una suma de segmentos de recta no era igual a la distancia reconstruida de la longitud de una curva irregular.

Como se observa, los problemas planteados fueron diversos, y al no contar con una escritura matemática generalizada, los razonamientos y las soluciones también fueron variados y únicos en cada problema al resolverse mediante palabras escritas que dependía específicamente de la forma de escribir de la persona que lo resolvía. De aquí que, el estudio de la evolución de las ideas que sentaron las bases del cálculo a lo largo del tiempo es importante y permite conocer a las personas involucradas en dicho proceso.

Sin embargo, a Newton y Leibniz se les otorga el nombre de creadores del Cálculo, por ser los que sintetizaron y generalizaron dichos conceptos en un nuevo campo de las matemáticas.

Por ser este texto una breve historia del Cálculo, solo se mencionarán los personajes más relevantes que influyeron en su desarrollo histórico..

La historia del cálculo se remonta a la época de los antiguos griegos, específicamente con las paradojas de Zenón (490- 430 A.C.) y sus interesantes planteamientos sobre si es posible recorrer una pista de carreras cuando hay un número infinito de puntos en una trayectoria finita dada, puesto que “no

9 Artículos y Reportajes

Artículos y Reportajes

puede tocarse un número infinito de puntos en un tiempo finito”, apareciendo por primera vez el concepto de división infinita.

Posteriormente, Eudoxo (408-355 A.C.) de Asia Menor propone el método de Exhaución. Sin tener claro el concepto de límite, determina el área de una figura mediante la búsqueda exhaustiva de polígonos inscritos conocidos.

Arquímedes (225 A.C.) de Siracusa calcula áreas y volúmenes usando el método de Eudoxo, determinando el área de una curva por medio de una sucesión de polígonos regulares inscritos en ella, cuya suma se aproxima al área de la figura deseada. Mediante este método, Arquímedes pudo obtener una medida bastante precisa de π, convirtiéndose en el primer ejemplo de una serie infinita.

Por otro lado, Kepler (1571-1630) de Leonberg, encontró el área de una elipse mediante las sumas de líneas. Además, calculó en forma exacta el volumen de más de 90 sólidos de revolución, considerando el sólido compuesto de infinitos cuerpos infinitesimales de volúmenes conocidos.

Para 1637, el francés Renato Descartes (1596-1650) publicó en el Discours de la méthode pour bien conduire sa raison et chercher

la vérité dans les sciences, en su famoso apéndice La géométrie, la terminología y relación de las propiedades algebraicas y analíticas de una curva dada. De manera que la geometría se redujo concretamente al álgebra y al análisis, dando un sinfín de posibilidades para estudiar una infinidad de formas geométricas de forma generalizada.

Fermat (1601-1665) de Francia, sin hacer referencia al concepto de límite, obtuvo un método para hallar la tangente a una curva,

comparando en un punto x cualquiera a con siendo cada vez más pequeño.

Impresionado por “la manera que tenía Fermat de trazar tangentes”, Newton (1643-1727) del Reino Unido desarrolla en 1671, el método del cálculo de Fluxiones. Esto gracias a la Gran Plaga de 1665-1666 que cerró la universidad donde estudiaba Newton, de manera que tuvo tiempo para desarrollar las ideas fundamentales de sus fluxiones. Un pensamiento abstracto intuitivo del movimiento, al trazar imaginariamente una curva mediante un punto que “fluía”. Si la trayectoria era infinitamente corta en un tiempo infinitamente pequeño, se le conocía como “fluxión”, es decir, la velocidad con la

que la variable x fluye con el tiempo; lo que actualmente se conoce como la derivada y que Newton representó como x

Por otro lado, Leibniz (1646- 1716) de origen alemán, realiza también estudios sobre las tangentes, utilizando el Teorema Fundamental del cálculo donde se establece que la derivación y la integración tienen una relación inversa; publica Nova methodus pro maximis et minimis en 1684, en donde aparecen por primera vez las nomenclaturas de la derivada, y de la integración que se siguen utilizando actualmente.

Al ser consciente de la importancia y relevancia del simbolismo matemático, Leibniz proporciona al progreso científico una nueva forma de dar solución a problemas que fueron resueltos con palabras escritas y con interés sobre el método para investigar la continuidad de funciones. Dando la oportunidad de que el conocimiento se hiciera de dominio público y que su nombre quedara en la posteridad como siempre lo había deseado; a diferencia de Newton, que por miedo al rechazo, no publicó inmediatamente sus resultados, sino hasta más tarde en la Philosophiæ naturalis principia mathematica, dándose la famosa disputa con Leibniz, en un tiem-

po que la comunidad científica se dividió para determinar quién fue el creador del cálculo y donde la ciencia vivía intimidada por prejuicios religiosos e intolerancia científica. Pese a ello, se considera que de 1637 a 1687 es el origen de Matemáticas Modernas con la Geométrie de Descartes y con La Principia de Newton, siendo comparable con la edad de oro de las sociedades científicas en Grecia.

En conclusión, se sabe que el origen del cálculo se remonta a los griegos antiguos y su desarrollo se fue dando con diferentes personas que contribuyeron por el interés en resolver la continuidad de funciones en problemas de aplicación o en las Matemáticas Abstractas. Sin embargo, gracias al pensamiento matemático de las mentes brillantes de Newton y Leibniz, se tiene el cálculo que conocemos actualmente y que ha dado como resultado las ecuaciones más importantes en diferentes áreas del conocimiento como dinámica, electricidad, física, movimiento, transmisión de calor, óptica, etc.

Referencias

[1] E. Temple Bell, Historia de las matemáticas, 3a ed. Fondo de Cultura Económica, 2016.

[2] "El nacimiento del cálculo. Leibniz y Newton |". http:// www.nocierreslosojos.com/calculo-historia-leibniz-newton/ (accedido el 28 de junio de 2023).

10 Artículos y Reportajes

Artículos y Reportajes

Gabriela Cortez Pérez Dra.

El español se habla en más de veinte países en el mundo. Caracterizar a una lengua que es oficial en tantos lugares es una labor titánica tan solo desde la perspectiva territorial, más si se tiene en cuenta que, además de la variación diatópica, una de las características inherente a todas las lenguas es su constante evolución. Esto ha derivado en que el estudio sistematizado de la lengua española se haya realizado desde particularidades nacionales, con el paradigma casi inevitable del español de la Península.

Desde el siglo pasado, en Latinoamérica se inicia una tradición lexicográfica que apuesta por la descripción del español americano que, sin dejar de lado el nivel fonético y sintáctico, pretende dar cuenta de las variaciones lingüísticas características de cada nación. Así, en cada país se van conformando estudios para la descripción del español, por medio de diccionarios diferenciales y contrastivos, tesauros y tesoros.

Aun con los numerosos corpus que actualmente detallan las múltiples manifestaciones del español, sigue siendo pertinente acrecentarlos con descripciones sincrónicas que den cuenta de manera más exhaustiva de la variación diatópica, porque en tales recuentos no aparecen ni como vocablos ni como palabras algunas lexías que son de uso frecuente de hablas particulares, por ejemplo, reborujar, duraznillo y pitaya, tan zacatecanas, esto obedece a que son constituyentes lingüísticos de comunidades de habla con usos particulares, debido a que se producen en contextos determinados, regularmente de habla coloquial, estratificación poco contemplada en los corpus de grandes dimensiones, que tienden a describir la lengua estándar.

Dra. Gabriela Cortez Pérez

Breve Semblanza gbycorpez@uaz.edu.mx

Doctora en Ciencias del Lenguaje por la Escuela Nacional de Antropología e Historia (ENAH)

Adscripción: Universidad Autónoma de Zacatecas, Unidad Académica de Letras: Licenciatura en Letras y Maestría en Competencia Lingüística y Literaria.

LGACs que trabaja: Análisis del texto y del discurso. Lingüística aplicada a la planificación y la lexicología.

Proyecto principal: Del léxico a la sintaxis: análisis morfosintáctico del habla zacatecana.

Es por ello que el CA UAZ 112 Lenguaje y Literatura -encabezado desde 2020 por la Dra. Cortez y conformado por la Dra. Martha Cecilia Acosta Cadengo, la Dra. Beatriz Elizabeth Soto Bañuelos y la Dra. Diana Villagrana Avila, además de la colaboración de la Dra. Matilde Hernández Solís- trabaja desde hace años en la descripción de la comunidad de habla del estado.

Las líneas de investigación del CA confluyen entre estudios lingüísticos y literarios, con el fin de caracterizar al habla zacatecana desde el nivel léxico y sintáctico.

Redacción COZCyT 11 Nuestra Ciencia Nuestra Ciencia

Con ello se pretende atender, por un lado, la descripción diatópica del habla de Zacatecas, y, por otro, ubicar los vacíos formativos en las habilidades lingüísticas de los estudiantes zacatecanos para obtener pautas para una reformulación didáctica de los contenidos de lengua, lo que le confiere, además de la pertinencia social, un objetivo didáctico al trabajo.

La Dra. en Ciencias del Lenguaje por la Es cuela Nacional de Antropología e His toria (ENAH), perfil PRODEP, SNI I y docente investigadora de la UAZ, ha colaborado y encabezado in vestigaciones encaminadas a la conformación del corpus del español de Zacatecas. Tales recuentos permitirán la zonificación léxica del estado, lo cual representa una tarea de gran magnitud, que contribuirá de manera significativa a la caracterización de nuestra lengua materna y a uno de los propósitos fundamentales de los estudios lingüísticos del CA: la elaboración del Diccionario Regional del español de Zacatecas (DREZ).

La importancia de un diccio nario como el DREZ radica en la validación de la producción lingüís tica de cada región, no en contraposi ción con la lengua estándar, sino como un complemento incluyente con el que se busca una descripción exhaustiva de la realidad lingüística, que servirá, además, para fijar los usos que en muchas ocasiones no se registran, por considerarse fuera de la norma culta.

El corpus obtenido se procesa y analiza con tres métodos: la lematización y análisis sintáctico de discursos orales y escritos y el procesamiento de encuestas de disponibilidad léxica. La obtención de datos que refieren al vocabulario se logra con programas computacionales. En el nivel sintáctico no existen procesadores automatizados, por lo que el análisis de la tipología oracional, la madurez sintáctica y los niveles de subordinación serán hechos de manera personal por las investigadoras.

La lematización consiste en determinar las frecuencias de aparición de palabras y vocablos de acuerdo con su categoría gramatical para diferenciar las palabras léxicas de las funcionales, porque es con las primeras que se puede describir la variación en este nivel de la lengua. Así, se identifica la frecuencia de palabras y vocablos y, con ello, la recurrencia del léxico que conforma al habla de Zacatecas.

Si bien la lengua como sistema no atiende la variación lingüística, en el habla es su rasgo fundamental. La diversidad en los actos de habla es un hecho en cada interacción y es, también, un factor identitario de cada comunidad lingüística, por lo que hay que dejar constancia de los usos lingüísticos zacatecanos, ya que el prescriptivismo que ha permeado a los estudios del español se ha traducido en la cotidianidad en que los usuarios de variedades consideradas como no prestigiosas duden y desdeñen su producción, lo cual atenta contra el principio de la diversidad lingüística.

Para establecer los rasgos de una comunidad de habla se requiere de una recopilación de datos que implican trabajo de campo y documental para conformar el corpus, formado por una exhaustiva recopilación de textos escritos y orales de lengua culta, subculta y no estándar representativos de

los 58 municipios del estado. En el apartado de lengua culta se consideran textos de literatura, periodismo, ciencia, técnica, discurso político, religión y habla culta; en lengua subculta, literatura popular, conversaciones grabadas; en lengua no estándar, textos regionales, documentos antropológicos, jergas y conversaciones grabadas. Partiendo de la hipótesis de que el léxico regional de una zona dialectal se encuentra, principalmente, en la lengua coloquial, se ha decidido dar un porcentaje mayor a la lengua oral, por lo que el equipo trabaja en la recolección de entrevistas orales realizadas a informantes de diferentes edades que tienen por característica haber nacido en Zacatecas y sólo haber salido del estado por estancias cortas. La recopilación de las entrevistas orales se incluirá en el Repositorio del Diccionario del español de México, RDEM, que es un depósito abierto de materiales documentales de diversos tipos del español de México.

El trabajo para la conformación del DREZ inició en colaboración con Luis Fernando Lara Ramos, investigador de El Colegio de México (ColMex) y coordinador del Diccionario del español de México (DEM). Durante la primera etapa de elaboración del DREZ se ha trabajado en la selección de instrumentos de validación o comparación con diccionarios testigo; acotación de la sincronía, de 1940 a 2010; delimitación de la muestra, mediante límites geográficos y sociales; recolección de datos tanto orales como escritos en cada uno de los registros comunicativos, a partir de la aplicación de encuestas, la lectura de autores zacatecanos, la investigación hemerográfica, la recolección de hojas parroquiales, panfletos, actas de cabildo, grabaciones y cartas personales. Las acciones anteriores tienen como objetivo la búsqueda del español zacatecano, especialmente el coloquial. De tal manera, se cuenta con un abanico que se amplía a cada despliegue o, en otros términos, un gran número de datos que requiere de varias lecturas minuciosas y su interpretación tanto horizontal como transversal, así como criterios de clasificación cuantitativa y cualitativa.

El DREZ apuesta por ser un aporte a los estudios lingüísticos diatópicos del estado y del país con la intención de que abone, también, desde una perspectiva social y cultural, a la configuración identitaria de Zacatecas a partir de sus usos lingüísticos.

12 Nuestra Ciencia Nuestra Ciencia

Aprendizaje automático: Algoritmos inspirados en el funcionamiento del cerebro humano

Alguna vez te has preguntado, ¿cómo es que las computadoras tienen la capacidad de aprender y generar respuestas confiables sobre un tema en particular?

Teodoro Ibarra Pérez

Adscripción: Instituto Politécnico Nacional, Unidad Profesional Interdisciplinaria de Ingeniería Campus Zacatecas (UPIIZ).

LGACs que trabaja: Agricultura de precisión, Redes neuronales artificiales, Sistemas embebidos.

Proyecto principal: Robótica aérea inteligente aplicada a la estimación de descriptores y detección temprana de plagas de insectos en cultivos de frijol en la zona centronorte del Estado de Zacatecas.

Ramón Jaramillo Martínez tibarrap@ipn.mx rjaramillom@ipn.mx

Adscripción: Instituto Politécnico Nacional, Unidad Profesional Interdisciplinaria de Ingeniería Campus Zacatecas (UPIIZ).

LGACs que trabaja: Inteligencia artificial, Sistemas embebidos y Robótica.

Proyecto principal: Robótica aérea inteligente aplicada a la estimación de descriptores y detección temprana de plagas de insectos en cultivos de frijol en la zona centronorte del Estado de Zacatecas.

Tradicionalmente, hasta hace menos de una década, la mayoría de las computadoras eran programadas mediante modelos de programación basados en reglas. Actualmente, la tendencia está cambiando, ya que cuando se incrementa el grado de dificultad, aumenta considerablemente el número de reglas y los algoritmos se vuelven complejos y poco eficientes para ser ejecutados en una computadora de uso convencional.

Por ejemplo, en un sistema experto sobre obesidad se suele considerar un número considerable de reglas basadas en el conocimiento médico de varios especialistas. Para evaluar el sobrepeso y considerar factores de riesgo en un paciente, algunas de las reglas podrían incluir: “Si el paciente tiene antecedentes familiares de obesidad”, “Si el índice de masa corporal se encuentra por encima de los límites establecidos”, “Si el paciente no realiza actividad física”, “Si el peso del paciente está por encima de los umbrales en relación con su edad y estatura”, “Si el paciente es hipertenso, con diabetes o apnea del sueño”, entre otras reglas.

Los sistemas expertos simples pueden contener decenas de reglas, mientras que los sistemas más complejos pueden contener entre cientos o incluso miles de reglas, por lo que este tipo de sistemas se limita al contexto y al conocimiento programado en ese momento, debido a que por lo regular se suelen presentar infinidad de posibilidades que no se tomaban en cuenta a la hora de programarlos.

Por otro lado, en este tipo de sistemas no se tenía la capacidad de aprender por sí solos sobre la diversidad en la sintomatología de sus pacientes, ni mucho menos se podía mejorar en la precisión y el diagnóstico cada vez que se realizaba una nueva consulta. Hoy en día este problema parece estar resuelto gracias a los sistemas inteligentes con algoritmos inspirados en el funcionamiento del cerebro humano.

En 1986, los científicos Geoffrey Hinton y David Rumelhart contribuyeron significativamente en el campo de la inteligencia artificial con la presentación del primer algoritmo de aprendizaje automático o machine learning. Hoy en día, después de 40 años hemos comenzado a presenciar un increíble avance en el campo de la inteligencia artificial gracias al mejoramiento y a la velocidad de procesamiento

en las computadoras, las cuales pueden aprender a reconocer patrones y a tomar decisiones basadas en datos que contienen ejemplos etiquetados, es decir, datos con respuestas previamente conocidas a diferencia de los modelos tradicionales donde cada tarea era programada de forma explícita y generalmente con reglas.

La forma en que las computadoras aprenden está basada en algoritmos y modelos matemáticos que tratan de imitar el funcionamiento del cerebro humano. Por ejemplo, imaginemos que queremos enseñar a un robot las cinco vocales. Al igual que un niño, al principio el robot comienza con poca o ninguna habilidad para reconocer o identificar las vocales por lo que utilizaremos técnicas de aprendizaje automático.

Antes de ello, sería interesante recordar cómo fue que aprendimos las vocales en nuestra infancia. Es probable que el profesor haya dibujado en el pizarrón la forma de cada una de las vocales y las haya etiquetado con un nombre para diferenciarlas entre sí y en algún momento tuvimos que realizar planas y planas en la libreta. Este proceso conocido como entrenamiento tenía un propósito en particular, reconocer las vocales.

13 Artículos y Reportajes

Artículos y Reportajes

Para nuestro robot, se puede utilizar un procedimiento similar al utilizado por el niño. Como se trata de un robot, es muy probable que se conecte una cámara para capturar las imágenes de las vocales. En este proceso, es importante reunir una cantidad de imágenes que contengan varios tipos de escritura, por ejemplo, imágenes de las vocales “A”, “E”, “I”, “O”, “U” escritas a mano y con diferentes estilos, ya que cada uno de nosotros tenemos una escritura diferente, sin embargo, existen características y patrones en cada letra que las diferencian una de la otra. Por esta razón, es importante describir las características y patrones más importantes con la ayuda de etiquetas y diferenciadores para que nuestro robot pueda reconocerlas. Pero ¿cómo ocurre ese aprendizaje de diferenciación entre una imagen y otra en una computadora?

En el campo de la visión por computadora, generalmente se utilizan algoritmos de redes neuronales convolucionales o CNN (por sus siglas en inglés, Convolutional Neural Network). Este tipo de redes poseen una enorme cantidad de neuronas artificiales conectadas entre sí. Durante el proceso de entrenamiento, cada imagen se descompone en pequeñas partes, identificando patrones y características significativas mediante operaciones matemáticas llamadas convolución y agrupación.

Una neurona artificial se comporta de manera similar a las neuronas o células nerviosas del

cerebro humano, ya que se comunican entre sí mediante impulsos eléctricos para transmitir mensajes de un extremo a otro; de esta manera la información viaja desde el cerebro hacia el sistema nervioso central con la finalidad de ejercer acciones de control y coordinación entre los órganos del cuerpo es decir, ejecutar diversas acciones como el movimiento de pies, manos, labios, ojos y otras partes del cuerpo humano.

Es natural que todas las acciones realizadas diariamente de manera sincronizada y casi perfecta fueron entrenadas y perfeccionadas a través el tiempo mediante un proceso llamado aprendizaje, es decir, cuando nacimos no teníamos la habilidad de caminar, hablar o realizar tareas que hoy en día realizamos de manera natural y autónoma. En este mismo contexto, los robots y computadoras pueden aprender para llegar a perfeccionar algún tipo de tareas mediante algoritmos de aprendizaje automático.

Una CNN permite reconocer imágenes mediante un algoritmo iterativo que reduce el error de forma gradual hasta obtener un resultado deseado. Este procedimiento se realiza varias veces con diferentes imágenes hasta obtener el error mínimo deseado. Una vez que la red ha sido entrenada lo suficiente, se procede a evaluar el rendimiento mediante un conjunto de imágenes de prueba que nunca le fueron mostradas a la red para determinar la capacidad y habilidad que adquirió la red

para identificar correctamente las vocales.

El modelo de lenguaje conocido como ChatGPT es otro ejemplo de sistemas inteligentes basados en algoritmos de aprendizaje automático. Este sistema fue desarrollado por OpenAI con aproximadamente 175 mil millones de parámetros, un millón de veces más que los parámetros utilizados en el reconocimiento de imágenes, lo que lo hace uno de los más grandes y potentes en la historia de la inteligencia artificial.

Actualmente nos encontramos inmersos en la era de los datos donde aquellos que los recopilen y analicen de forma certera y precisa, tendrán la oportunidad de experimentar con el nuevo oro del siglo XXI, donde algunos especialistas lo llaman la era de la automatización de la creatividad y probablemente los temas relacionados con derechos de autor tomarán un rumbo distinto al que estamos acostumbrados actualmente.

¿Desaparecerá por completo el copyright?, lo cierto es que el conocimiento generado por las máquinas es producto del conocimiento generado por el ser humano donde ahora es evidente que nos pertenece a todos. Hoy en día, no se necesita un talento extraordinario para crear actividades artísticas interesantes, solo es necesario aprender a manejar una nueva herramienta donde tú pones las ideas y la inteligencia artificial pone lo suyo: “el lienzo y la pintura”.

Referencias

[1] C. R. Rahman et al., “Identification and recognition of rice diseases and pests using convolutional neural networks,” Biosystems Engineering, vol. 194, pp. 112–120, Jun. 2020, doi: 10.1016/j.biosystemseng.2020.03.020.

[2] M. Pak and S. Kim, “A review of deep learning in image recognition,” in 2017 4th International Conference on Computer Applications and Information Processing Technology (CAIPT), Aug. 2017, pp. 1–3. doi: 10.1109/ CAIPT.2017.8320684.

[3] L. J. Sandoval Serrano, “Algoritmos de aprendizaje automático para análisis y predicción de datos,” Revista Tecnológica; no. 11, 2018.

[4] A. Moreno et al., Aprendizaje automático. Edicions UPC, 1994.

14 Artículos y Reportajes Artículos y Reportajes

Desarrollo de un Detector de neutrones solares en Zacatecas

(Parte I)

Jesús Iván Santamaría Najar sannji86@gmail.com

Adscripción: Unidad Académica de Estudios Nucleares, Universidad Autónoma de Zacatecas.

LGACs que trabaja: Física Solar, Rayos Cósmicos, Física de Plasmas.

Proyecto principal: Aceleración de partículas relativistas en descargas eléctricas y su efecto en rayos cósmicos.

Al dirigir la mirada hacia el firmamento, ya sea de día o de noche, podemos apreciar cuerpos celestes brillantes, desde el Sol, planetas, estrellas, nebulosas y, posiblemente, cometas. Todo esto que observamos es luz, ondas electromagnéticas. Nuestro ojo es un instrumento astronómico que puede distinguir una pequeña parte o región del espectro electromagnético. Con otro tipo de instrumentos podemos observar otro tipo de ondas electromagnéticas, como las ondas de radio, ultravioleta, infrarrojo y rayos X.

Desde de la segunda década del siglo XX, se conoce que no solamente llegan ese tipo de ondas electromagnéticas, sino también partículas altamente energéticas, como protones (H), partículas alfa (He), fotones y electrones, que llegan a velocidades cercanas a las de la luz.

A este tipo de partículas se les ha clasificado como rayos cósmicos y dan información sobre el universo que no podemos conocer a partir de las ondas electromagnéticas o la luz.

Los rayos cósmicos o RC son útiles para explorar el en entorno interplanetario y extragaláctico, pero a su vez afectan a nuestro Planeta. El estudio de este tipo de partículas se lleva a cabo para conocer el origen, emplearlo como indicador de las perturbaciones solares y asimismo para evitar y/o prevenir efectos secundarios sobre los seres humanos y nuestros medios tecnológicos.

Los rayos cósmicos primarios provienen de lugares del universo donde se producen explosiones de supernovas, de núcleos activos de galaxias y de nuestro Sol. Los RC provenientes de galaxias llegan a nuestro planeta constantemente, aunque su intensidad cambia en función del ciclo solar. A las partículas que son aceleradas por el Sol se les conoce como rayos cósmicos solares.

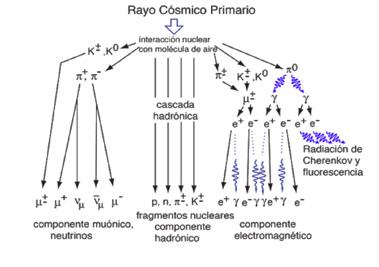

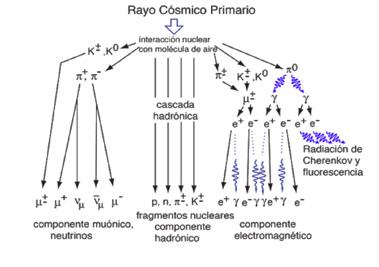

Los RCs no alcanzan la superficie terrestre directamente, sino que chocan con los átomos de los cuales están constituida la atmósfera. La interacción entre los RC y la composición de la atmósfera generan una cascada de partículas secundarias (protones, neutrones, muones, y electrones) como se muestra en la Figura 1. Si suponemos que una partícula primaria llega con una velocidad de 200 000 kilómetros por segundo, dos terceras partes de la velocidad

de la luz, gran cantidad de partículas atómicas, muones y otras podrían ser detectadas mediante contadores situados a nivel del suelo cerca de los polos magnéticos.

El campo magnético terrestre es otro de los filtros, aunque en los polos no tiene efecto. A medida que nos situamos en el ecuador las partículas primarias cargadas deben contener una mayor velocidad para que sean capaces de atravesar este campo. Existen contadores de partículas ubicados en diferentes latitudes de la Tierra que miden, por lo tanto, rayos cósmicos de distintas velocidades.

Para incrementar la cantidad de partículas detectadas, los contadores de un monitor de neutrones se encuentran envueltos en plomo, en donde, las partículas y algunos pocos muones generan más neutrones. Los detectores de neutrones cuentan estos neutrones producidos, proporcionando así una estimación del flujo que los originó en la parte alta de la atmósfera. En la actualidad estos contadores siguen en primer lugar como instrumentos dedicados a la medición de rayos cósmicos solares y de rayos cósmicos menos energéticos procedentes de otras partes del universo logrando medir los flujos de rayos cósmicos con energías mayores que 1 GeV (giga-electrón-volt), al detectar neutrones secundarios con energías mayores que 10 MeV (mega-electrón-volt).

El estudio de RC es empleado para analizar las perturbaciones en el medio interplanetario que alcanzan al planeta Tierra. Años de observaciones han facilitado medir la intensidad de los RC que es modulada por el campo magnético de la heliosfera, cuando el Sol contiene muchas manchas, el campo magnético de la heliosfera tiene mayor intensidad y esto explica la reducción en la intensidad de detección de rayos cósmicos galácticos. De lo contrario, cuando existe disminución de manchas solares el escudo protector es más débil y gran cantidad de estos RC galácticos llegan a la Tierra. También podemos encontrar variaciones muy espontáneas cuando se manifiestan erupciones solares que lanzan campos magnéticos a la heliosfera.

15 Artículos y Reportajes Artículos y Reportajes

Los detectores o contadores se dividen en grupos de acuerdo con la función de las partículas que miden: nucleones (protones y neutrones), mesones (muones) y componentes electromagnéticas (fotones, electrones), por lo que daremos una breve descripción de un tipo específico de detectores que se emplean a nivel de tierra que es el "monitor de neutrones". Estos instrumentos son capaces de detectar rayos cósmicos que penetran en la atmósfera de la Tierra con energías comprendidas entre 0.5 y 20 GeV, este rango de energías que no pueden ser medidas con detectores situados en el espacio con la misma facilidad, economía y precisión estadística. Existen dos tipos de detectores estandarizados, el IGY (IG, por sus siglas en inglés International Geophysical Year) y el NM46. Un ejemplo de monitor de neutrones del tipo NM64 como se muestra en la Figura 2.

Los tubos de un monitor de neutrones detectan principalmente neutrones térmicos, es decir, aquellos que viajan con una energía cinética de aproximadamente 0.025 eV. En un contador tipo NM64, el gas que se encuentra en su interior es generalmente trifloruro de boro (BF3), enriquecido al 96% con el isótopo 10B (boro 10), a una presión de 0.27 bar.

La detección de un neutrón térmico por parte del tubo contador se produce porque este interacciona con un núcleo de 10B, produciendo una reacción exotérmica:

Los productos de esta reacción son detectados debido a la ionización del gas dentro del tubo. Este se comporta como un contador proporcional trabajando a una tensión de cerca de 2800 V (NM64).

A partir de 1990, en los nuevos monitores de neutrones los tubos contadores que se emplean contienen helio-3 (3He- helio-3) en lugar de BF3. Los contadores basados en 3He tienen un diseño más simple. La reacción exotérmica de los neutrones con el 3He es la siguiente:

Una ventaja adicional de los tubos de 3He es que el tubo contador puede operar con una presión del gas más alta y con una tensión inferior a 1500 V. Cuanto mayor sea la presión del gas del tubo contador mayor es la eficiencia por unidad de volumen que se puede alcanzar.

Aunque los contadores basados en las mencionadas reacciones (1) y (2) son muy eficientes para la detección de neutrones térmicos debido a la dependencia de velocidad, de la sección transversal, los neutrones más rápidos pueden detectarse rodeando el tubo contador con un material moderador que contenga hidrógeno, como la cera de parafina o el polietileno.

Para este proyecto que desarrollaremos en el estado de Zacatecas, emplearemos un detector de neutrones del tipo esférico NRD de la marca Eberline de 9 pulgadas de diámetro con un tubo contador tipo Helio-3 (Figura 3). Los neutrones se detectan indirectamente a través de reacciones nucleares que dan lugar a partículas cargadas energéticamente, como por ejemplo las partículas alfa (He). El NRD se encuentra rodeado por una esfera de polietileno de alta densidad de 19.9 cm (7.7 pulgadas) de diámetro. Esta esfera de polietileno modera los neutrones entrantes y ayuda a proporcionar una respuesta al detector o contador de BF3. La concentración de boro ofrece una sensibilidad, típica de aproximadamente 10 cpm (cunetas por minuto) por microsievert por hora (microSv/h) o 100 cpm por milirem/h.

Referencias

[1] R. D. Strauss et al., «The Mini-Neutron Monitor: A new approach in neutron monitor design», Journal of Space Weather and Space Climate, vol. 10, p. 39, ene. 2020, doi: 10.1051/swsc/2020038.

[2] B. -b. Li et al., «EAS thermal neutron detection with the PRISMALHAASO-16 experiment», Journal of Instrumentation, vol. 12, n.o 12, p. P12028, dic. 2017, doi:10.1088/1748-0221/12/12/p12028 .

[3] L. P. Babich, «Thunderstorm neutrons», Physics-Uspekhi, vol. 62, n.o 10, pp. 976-999, oct. 2019, doi: 10.3367/ufne.2018.12.038501.

[4] C. A. Federico, O. L. Gonçalez, E. S. Da Fonseca, K. C. De Souza Patrão, M. A. Pereira, y L. V. E. Caldas, «Verification of response of neutron monitor for In-Flight neutron dosimetry», Journal of Aerospace Technology and Management, vol. 5, n.o 3, pp. 315-322, ago. 2013, doi: 10.5028/jatm.v5i3.222.

16 Artículos y Reportajes Artículos y Reportajes

Figura 1.Cascada de partículas secundarias generadas por un rayo cósmico primario.

Figura 2.Esquema de un mini monitor de neutrones, donde muestra la estructura interna y una fotografía del MNM del Instituto de Geofísica (UNAM).

Figura 3. neutrones tipo NRD.

de Cáncer Genómico Atlas

Jared Eliacim Limones González

Adscripción: Universidad Autónoma de Zacatecas. LGACs que trabaja: Ciencias Biomédicas, Bioinformática, Ciencias Ómicas.

Proyecto principal: Análisis de la expresión de genes de las rutas Notch, Hippo y Nrf2 en muestras de pacientes con cáncer cervicouterino.

Gretel Mendoza Almanza Jared051197@gmail.com

grmendoza@uaz.edu.mx

Adscripción: Consejo Nacional de Ciencia y Tecnología.

LGACs que trabaja: Biotecnología, Biología Molecular.

Proyecto principal: Análisis integral del proteoma y transcriptoma implicado en el desarrollo del cáncer de mama en la población femenina mexicana.

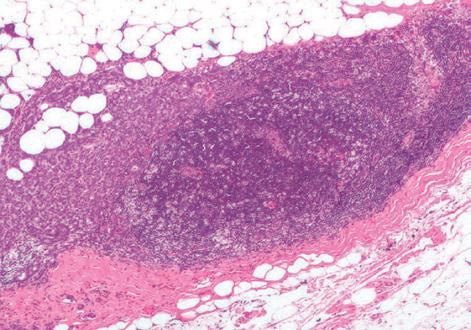

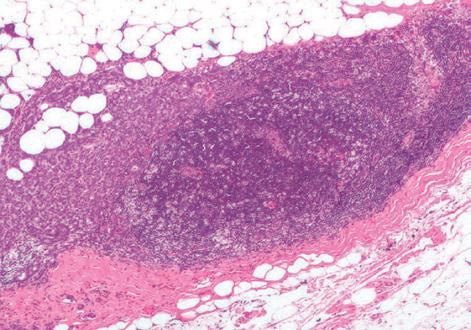

INTRODUCCIÓN