Les instituts de recherche HEPIA

La recherche appliquée et le développement (Ra&D) sont réalisés dans le cadre de quatre instituts disposant d’équipements « up-to-date » et de moyens importants en termes de ressources humaines et financières.

Les quatre instituts sont :

inPACT : institut du paysage, de l’architecture, de la construction et du territoire avec pour axes stratégiques de recherche :

• construction et développement durable

• énergie, bâtiment et territoire

• gestion et organisation des projets de construction et d’aménagement

• hydraulique urbaine et territoriale

• paysage, nature et ville

inIT : institut d’ingénierie informatique et des télécommunications avec pour axes stratégiques de recherche :

• embedded & real time systems

• data sciences & computational intelligence

• networking, trust, privacy and security

inSTI : institut des sciences et technologies industrielles avec pour axes stratégiques de recherche :

• bio-ingénierie

• industrie 4.0

• mécanique des fluides et énergie

• matériaux et nanotechnologies

inTNE : institut terre-nature-environnement avec pour axes stratégiques de recherche :

• écologie et gestion des milieux naturels et aménagés

• fonctions environnementales sous pressions anthropiques dans les agroécosystèmes

Cette structure Ra&D mise en place dès 2011 vise non seulement à améliorer notre performance et notre réactivité eu égard aux nombreuses sollicitations de nos partenaires industriels et institutionnels, mais elle permet aussi, grâce à ses axes stratégiques de recherche de profiler l’institution dans le paysage des Hautes Ecoles régionales et suisses. En effet, le fait qu’HEPIA regroupe en son sein tous les pôles du domaine HESSO « ingénierie et architecture » permet d’effectuer naturellement des projets de recherche transdisciplinaires dont les innovations sont transférées à l’externe vers des partenaires via des licences sur brevet ou par la cession de brevets mais aussi par la création d’entreprises.

En outre, c’est également en 2011 qu’est né le Geneva Creativity Center (GCC) dont l’objectif principal est d’amener plus rapidement des innovations élaborées au sein des Hautes écoles genevoises que sont l’Université de Genève et la HES-SO Genève vers la société ainsi que de pouvoir répondre aux problématiques des entreprises et des collectivités. De ce fait, quel que soit le point d’entrée, les entreprises bénéficient de facto d’une offre étendue de compétences de pointe; voir le site internet : http://www.creativitycenter.ch/

De surcroît, fruit d’une étroite collaboration entre l’Université de Genève et la HES-SO Genève, le Laboratoire de Technologie Avancée (LTA) propose aux entreprises une véritable plateforme technologique mettant à disposition des équipements, des infrastructures de pointe communes aux deux institutions ainsi que des conseils d’experts. Site internet : https://www.lta-geneve.ch/

Ainsi, le corps professoral, les assistants et assistantes de recherche, le personnel administratif et technique composant les instituts de la Haute école du paysage, d’ingénierie et d’architecture de Genève, sont en permanence au service de la société et de son environnement.

Gilles Triscone Professeur HES, Responsable de la coordination Ra&D gilles.triscone@hesge.chInstitut du paysage, d’architecture, de la construction et du territoire - inPACT

La convergence des compétences de l’institut inPACT dans les domaines de l’Architecture, de l’Architecture du paysage, du Génie civil et des Techniques du bâtiment est unique en Suisse romande.

La mission d’inPACT est de développer des solutions innovantes pour l’environnement construit de demain. Interlocuteur privilégié, compétent et neutre des acteurs économiques et des collectivités publiques, il est fortement implanté dans le tissu professionnel et économique.

L’ancrage de l’institut au cœur de l’agglomération du Grand Genève, dont les contraintes territoriales sont particulières, le met au défi de concilier une croissance sur un territoire limité tout en conservant une qualité de vie reconnue au niveau mondial.

Les activités de l’institut s’articulent autour des axes stratégiques suivants :

● construction et développement durable

● énergie, bâtiment et territoire

● gestion et organisation des projets de construction et d’aménagement

● hydraulique urbaine et territoriale

● paysage, nature et ville

InPACT valorise la composante paysagère et environnementale comme référent commun et indicateur du projet territorial. Au travers de ses diverses activités de recherche appliquée et de mandats, l’institut intègre les questions spécifiques liées à la durabilité, l’écologie, la performance des structures porteuses, l’économie, les énergies renouvelables, au Smart building et au développement des ouvrages innovants.

Bernd Domer Professeur HES, Responsable institut inPACT bernd.domer@hesge.chLe projet consiste

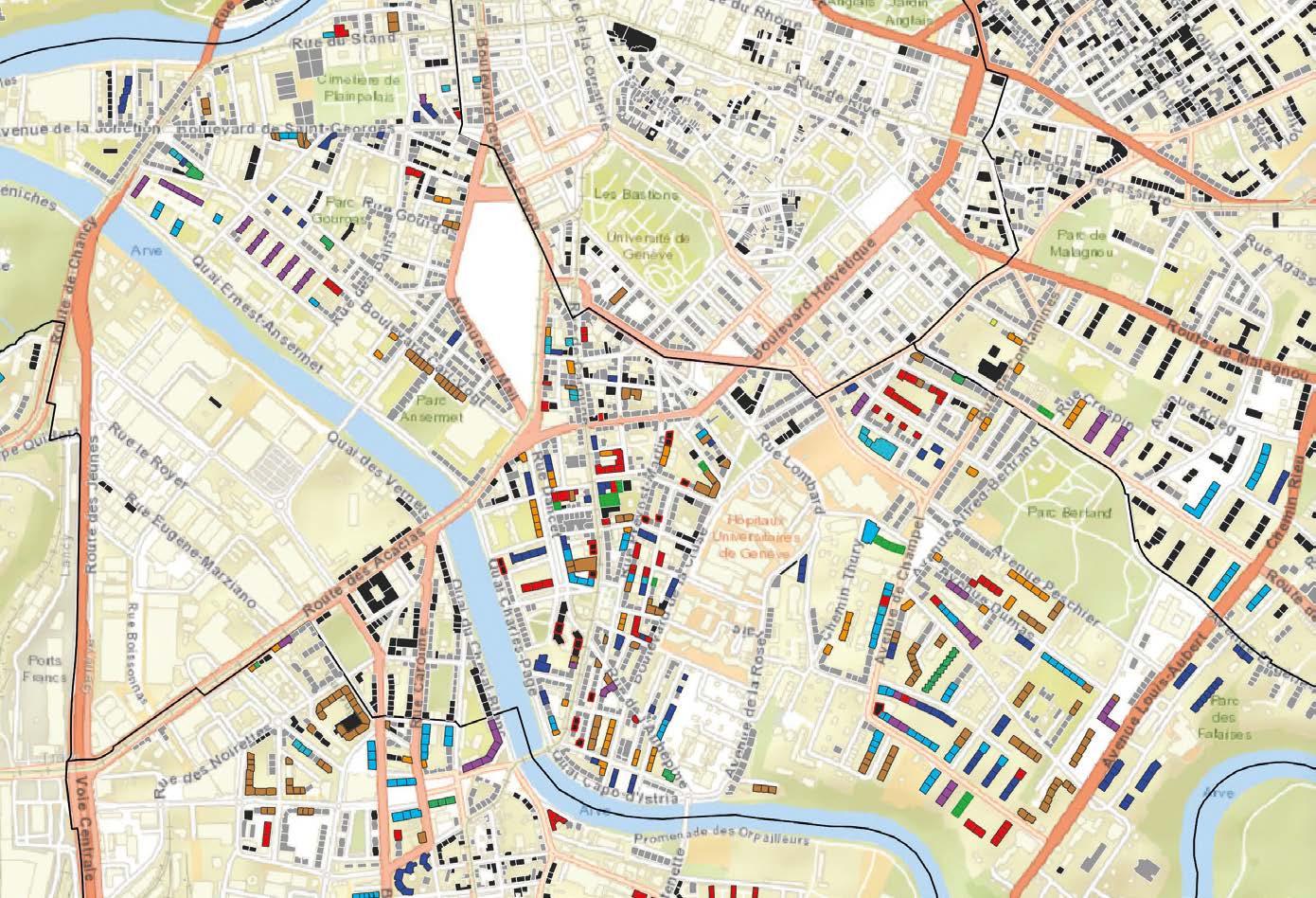

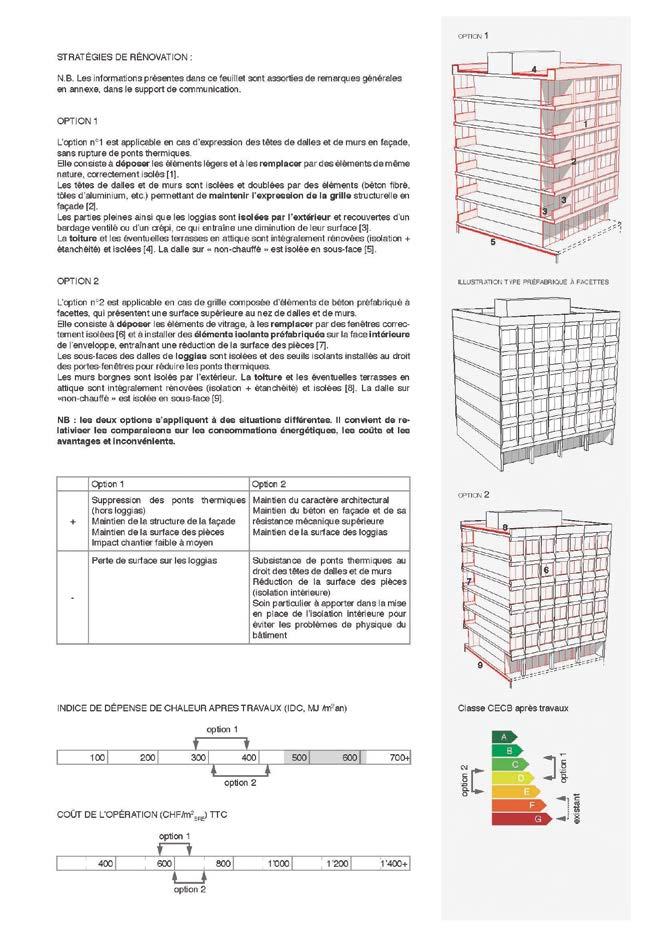

i) à établir un atlas typologique constructif et architectural du parc de logements collectifs genevois de 1946 à 1990,

ii) à produire pour chaque type une fiche d’orientation proposant deux scénarios détaillés de rénovation énergétique avec estimation du gain énergétique et des coûts d’intervention,

iii) à mettre à disposition un recensement permettant de géolocaliser les immeubles par type, par année de construction et par performance et agent energétiques.

Les fiches et le recensement sont utilisés par des collectivités publiques (communes, SIG, Office cantonal de l’énergie) et des régies immobilières dans une démarche proactive pour

i) identifier les bâtiments prioritaires pour une rénovation énergétique,

ii) informer leurs propriétaires sur le potentiel d’économie énergétique (sauts de classe CECB) et sur des scénarios possibles ou probables de rénovation de leurs immeubles afin de les inciter à entreprendre des travaux de rénovation ambitieux.

La première étape du projet visait à analyser et caractériser le parc de logements collectifs genevois de l’après-guerre à la fin du 20ème siècle, qui représente une grande partie de la surface de référence énergétique du canton candidate à la rénovation. Ce travail a permis de mettre en évidence neuf archétypes constructifs et architecturaux qui prédominent sur le territoire genevois et pour lesquels des stratégies de rénovation différenciées peuvent être élaborées.

Dans une deuxième étape, chaque type a fait l’objet d’une étude de cas permettant de proposer et de chiffrer un ou deux scénarios détaillés de rénovation énergétique globale pour l’enveloppe du bâtiment. Le résultat est explicité via des fiches de bonnes pratiques sous forme de triptyque mises à disposition des collectivités publiques et des régies immobilières. Ces fiches servent à présenter aux propriétaires les différentes options qui s’offrent à eux en fonction du type de bâtiment qu’ils possèdent.

Dans un troisième et dernier temps, un recensement à l’échelle du canton de Genève a été mené afin de rattacher l’ensemble des immeubles de la période concernée à l’un des types préalablement définis. Ces données, combinées à d’autres informations issues du SITG (indice de dépense de chaleur, époque de construction, agent énergétique), sont reprises dans une interface cartographique offrant la possibilité de géolocaliser les immeubles selon leur type ou un filtre combinant les différentes caractéristiques des bâtiments.

Le croisement des données typologiques et énergétiques permet d’identifier les bâtiments prioritaires en matière de rénovation énergétique et d’initier un dialogue proactif avec leurs propriétaires sur la base des fiches de bonnes pratiques avec pour objectif de les inciter à lancer des projets de rénovation ambitieux et respectueux de la substance architecturale des bâtiments.

Légende

1 - Fiche type 6 (exemple), page 1

2 - Fiche type 6 (exemple), page 2

3 - Fiche type 6 (exemple), page 3

Les fiches de bonnes pratiques sont mises à disposition du public sur les sites Internet des partenaires du projet (SIG et Office cantonal de l’énergie). Elles sont utilisées par les collectivités publiques et par les régies immobilières dans leurs démarches auprès des propriétaires. Le recensement géolocalisé doit faire l’objet d’une mise en ligne via une couche du Système d’Information du Territoire à Genève (SITG) accessible au public.

www.hesge.ch/hepia/recherche-developpement/ projets-recherche/solution-renovation

Dans l’objectif de favoriser l’intégration de la nature dans les places de jeux en ville, le groupe de recherche « Technique et Paysage » d’HEPIA a été mandaté conjointement par la Ville et le Canton de Genève pour produire un catalogue d’exemples et une méthode permettant de qualifier une place de jeux dans son rôle pédagogique de sensibilisation à la nature. Cette recherche permettra aux différents acteurs publics et privés de tenir compte des bonnes pratiques dans leurs futurs aménagements d’espaces dédiés aux jeux.

Plusieurs axes constituent la relation « jeu et nature » : la biodiversité, la matérialité, le paysage, les activités et les usages ainsi que la planification et la participation. Dans le catalogue d’exemples, il est intéressant de prendre connaissance de quelques places emblématiques de cette relation au vivant. La méthode d’évaluation quant à elle, basée sur l’étude de deux sites dans un contexte différent (cours d’école et parc de quartier), permet de mesurer la qualité des projets, existants ou futurs, sur leur potentiel de relation à la nature.

Cette étude est le prolongement et le développement de travaux d’étudiant·e·s d’HEPIA en architecture du paysage qui ont réfléchi à la réalisation d’aménagements urbains où la nature au sens large en fait partie intégrante ; en particulier pour les espaces de jeux.

En effet, le fait que les places de jeux ont un impact important sur la vie sociale, il est intelligent de les utiliser pour faire passer des messages de sensibilisation aux problématiques auxquelles la nature doit faire face, comme par exemple la biodiversité.

Les différentes recommandations présentes dans ces fiches offrent un panel non exhaustif de possibilités en expliquant pour chacune les avantages et les inconvénients.

Une typologie des éléments pour apporter la dimension « nature » est développée dans le guide, ce qui permet de définir une liste non exhaustive d’éléments forts, favorables à l’accueil de la biodiversité tout en répondant aux exigences d’usages du lieu, tels que des structures végétales, des revêtements perméables, une matérialité durable, le rapport au paysage, etc.

Un outil sous la forme d’un tableau synthétique offre la possibilité d’évaluer le potentiel d’un ou plusieurs éléments forts, déjà présents ou proposés dans le projet, et vient conclure ce travail qui pose les bases d’une réflexion à poursuivre en relation avec tous les acteurs de l’espace public.

Légendes

1 - Le diagramme, un outil d’évaluation de la qualité du rapport à la nature

2 - Végétal, matérialité et paysage, quand la nature se prête au jeu

visuels :

© HEPIA / Eric Amos et Thibault Brütsch

Le catalogue d’exemples et la méthode d’évaluation des qualités des places de jeux et de leur rapport à la nature sont disponibles sur demande auprès du groupe de recherche « Technique et Paysage » à HEPIA. Une version électronique est librement consultable sur internet.

www.hesge.ch/hepia/recherche-developpement/ projets-recherche/places-jeux-et-nature

À l’image des pratiques ancestrales, l’objet de la recherche est de tester l’opportunité de bâtir en puisant dans les gisements issus de la déconstruction et proposer une forme actualisée de l’utilisation des matériaux disponibles afin de valoriser le travail et l’énergie déployés antérieurement, dans un esprit de frugalité et d’économie de moyens. Autant de solutions vertueuses et reproductibles qui ont été expérimentées avec succès sur deux sites : Lullier et Bernex.

• Inventaire descriptif restreint des murs en pierres sèches du sud du canton de Genève

• Le mur en pierres, un milieu propice et favorable à la présence de biodiversité dans les murs

• Inventaire des sources de matériaux, gravières et carrières du bassin genevois

• Construction de prototypes de murs « composites » selon la technique de pierres sèches

La technique de construction en pierres sèches retrouve toute son actualité au regard des attentes actuelles en termes de biodiversité, économie de moyens et identité régionale. Mais qu’en est-il à Genève, de quel patrimoine parle-t-on et comment concilier pratiques vernaculaires et respectueuses de l’environnement avec les modes de constructions actuels et l’inscription de ces ouvrages dans le paysage ?

Dans le canton de Genève, la recherche de la présence de murs n’a pas permis d’identifier spécifiquement des ouvrages en pierres sèches sur les documents cartographiques ni dans la littérature. Une campagne de repérage basée sur la consultation de partenaires professionnels et un arpentage du territoire du sud du canton de Genève ont permis de confirmer la quasi-absence d’assemblage en pierres sèches.

De nombreux murs patrimoniaux, de soutènement ou de limite, sont observables en milieu rural, mais tous maçonnés avec des degrés variables d’état de dégradation. Plus celle-ci est avancée, plus l’apparence du parement et ses fonctions se rapprochent des murs en pierres sèches sans pour autant en réunir tous les aspects, mais en offrant une réelle opportunité d’accueil pour une certaine forme de biodiversité.

La méthode de construction qui emploie le mortier de chaux ou le mortier bâtard (mélange ciment et chaux) s’explique par le fait que ces ouvrages vernaculaires peu élaborés sont faits de l’appareillage de pierres majoritairement alluvionnaires qui ont pour origine les dépôts laissés par les glaciers en plaine. Leur disponibilité due à l’épierrage des champs, leur proximité des cours d’eau et la facilité d’exploitation sont la meilleure explication à leur utilisation fréquente.

Lorsque l’on s’approche des massifs du Jura et du Salève, l’apparition des pierres calcaires se fait plus fréquente sans que pour autant l’assemblage à sec soit la règle du fait de la forme peu favorable à l’assemblage (polyforme) et requérant un effort élevé pour tailler la pierre.

Légendes

1 - Explorer les carrières et les décharges de matériaux pierreux offre des perspectives de réemploi très importantes.

2 - Exemple de mur en pierres assemblé sans liant, constitué d’une diversité de pierres et de béton issus de la démolition et appareillé selon les principes de la construction en pierres sèches.

3 - Le chantier de démolition, un gisement pour la fourniture de matériaux destinés à la reconstruction d’un mur selon le principe de l’appareillage à sec.

visuels :

© HEPIA / Eric Amos et Alex Verhille

• Un recueil constitué de 10 fiches descriptives et illustrées d’ouvrages géolocalisés sur le territoire, vernaculaires ou actuels, illustre le potentiel de réalisations favorables à l’environnement et dans le respect du cycle vertueux des matériaux.

• Une liste non exhaustive des carrières et gravières où se procurer les matériaux.

Librement consultables en format électronique sur internet :

www.hesge.ch/hepia/recherche-developpement/ projets-recherche/mubersec

La réalisation de tels ouvrages requiert de l’expertise. La formation s’effectue via la participation à des ateliers de construction menés conjointement avec des partenaires spécialistes :

• Formateur / constructeur de murs en pierres sèches (Felsenfalter à Berne)

• Ecologue, Atelier Nature et Paysage (ATNP Sàrl à Genève)

• Technique et Paysage pour le concept et l’intégration au paysage (TEP- institut inPACT, HEPIA, HES-SO Genève)

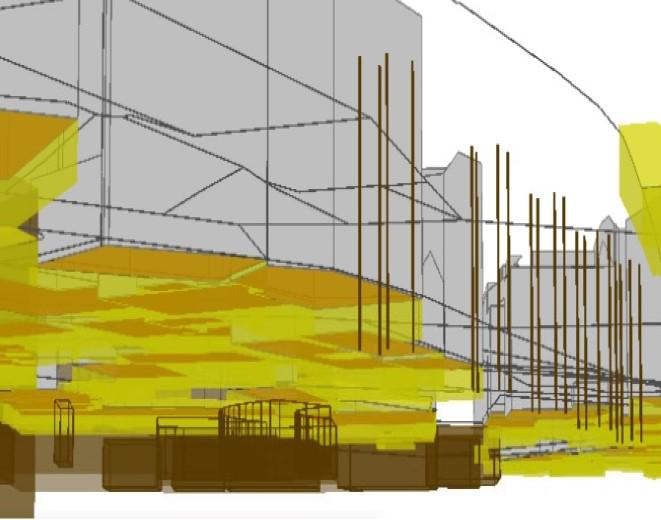

Le projet centralise la gestion des données liées aux espaces souterrains et les valorise afin d’améliorer leur exploitation, leur visualisation et les processus de prise de décision qui en dépendent. Une fois établie, la caractérisation volumique des objets permet de vérifier si les contraintes spatiales de type distance minimale ou restriction de passage sont bien respectées. Ce projet fera ainsi évoluer les outils de planification urbaine.

• Etablissement d’une ontologie complète des objets souterrains.

• Transfert des objets souterrains issus d’une base de données GIS dans une base de données RDF (triple store).

• Processus automatisé de complétion du positionnement et de l’emprise volumique des objets.

• Analyse et indication d’incertitude sur le positionnement et la géométrie des objets.

• Étude de l’encombrement du sous-sol dans le but d’optimiser son exploitation.

Soutenu par l’agence suisse pour l’encouragement de l’innovation (Innosuisse), le projet « Impulse – SUBSURFACE » ouvre la porte de l’ère digitale aux données numériques nécessaires pour la planification et l’exploitation du sous-sol. Les objets du sous-sol répertoriés incluent les éléments naturels de type racines des arbres. Les objets non naturels regroupent les réseaux utilitaires, les sous-sols planifiés ou existants des bâtiments, les installations géotechniques, les tunnels et les tranchées couvertes. Les restrictions de droit public à la propriété foncière sont également considérées.

Une nouvelle structuration des données permettant l’interopérabilité des données GIS et des données BIM est mise en avant et intègre les processus de correction, de complétion et d’analyse de précision. Un jeu de règles de correction et de complétion vient s’ajouter aux règles de construction définies dans les normes et permet de produire la géométrie de chaque objet.

L’introduction d’un indice de confiance associé à chaque objet modélisé permet de fixer des limites de tolérance relatives à son emplacement. Il est également utilisé pour établir un taux de complétion global des objets dans chaque zone. Basé sur un modèle stochastique, cet indice interprète soit les données numériques présentes soit les informations non numériques de précision. La calibration du modèle a été réalisée grâce à l’apport des données réelles par les Services Industriels de Genève.

Un moteur de validation de règles permet de vérifier si les objets existants respectent les bonnes pratiques énoncées dans les règles de pose et d’optimiser la mise en place des nouveaux objets. Un ensemble de plusieurs centaines de règles officielles a été sélectionné dans les recueils de normes pour les constructions en sous-sol.

Légendes

1 - Vue d’ensemble des objets dans la zone de Cornavin. © MIC (HEPIA)

2 - Représentation des objets physiques avec leur enveloppe. © Topomat technologies SA ; UNIGE ; MIC (HEPIA)

3 - Réseau d’eau potable. © MIC (HEPIA)

4 - Partie en sous-sol des bâtiments. © MIC (HEPIA)

5 - Vue d’ensemble des objets dans la zone de Praille-Acacias-Vernets. © Topomat technologies SA ; UNIGE ; MIC (HEPIA)

6 - Visualisation de l’encombrement avec des cubes de différentes couleurs. © Topomat technologies SA ; UNIGE ; MIC (HEPIA)

Adouane, K. ; Boujon, F. ; Domer, B. Digital Modelling of Underground Volumes, Including the Visualization of Confidence Levels for the Positioning of Subsurface Objects. Appl. Sci. 2021, 11, 3483. https://doi.org/10.3390/app11083483

Adouane, K. ; Boujon, F. ; Domer, B. Qualifying spatial information for underground volumes. EG-ICE 2021, 28th International Workshop on Intelligent Computing in Engineering, Berlin, Germany.

• Partenaire industriel : Topomat technologies SA

• Partenaires académiques : HEPIA et UNIGE

• Partenaires d’implémentation :

- Etat de Genève (Direction de l’Information du Territoire, Office de l’Urbanisme, Office des transports, Office de l’Energie, Office de l’Eau) ;

- Services Industriels de Genève

Avec la végétalisation de sa toiture et de ses façades, le projet d’enveloppe végétale sur le bâtiment GIBOR des HUG s’inscrit dans l’esprit du programme Nature en Ville instauré par l’Etat de Genève. Les effets du réchauffement climatique et les îlots de chaleur sont devenus une réalité. Repenser la ville et notamment la qualité de ses constructions en y intégrant la nature représente une opportunité pour améliorer le cadre de vie et le bien-être des habitants et des usagers, tout en leur offrant tous les services rendus par la biodiversité.

• Diminution de l’accumulation de chaleur par les toitures et les façades.

• Fixation des micro-polluants et diminution de la réverbération.

• Diminution de la température de l’air en journée comme de nuit.

• Effet « éponge » des toitures qui retiennent l’eau des précipitations au service du végétal et de la qualité de l’air tout en limitant la surcharge des réseaux.

• Points relais pour la biodiversité, insectes, abeilles sauvages, oiseaux...

• Création d’un maillon dans la continuité écologique des espaces verts existants.

• Création d’un environnement agréable pour les citoyens.

• Intégration de la construction à son contexte urbain et social.

Ce projet est un exemple de la complémentarité voulue entre pédagogie et recherche appliquée dans les HES. Un projet d’étudiant·e·s a permis dans un premier temps d’explorer différents concepts techniques et végétaux. Ensuite, l’une des propositions retenue par le maître d’ouvrage a été développée par le groupe de recherche Technique et Paysage (TEP). L’enjeu de ce projet consiste à créer un relais de biodiversité sur l’enveloppe d’un bâtiment implanté dans un désert minéral et qui n’a pas été conçu ainsi. Concevoir une construction végétalisée englobant toitures et façades est une performance technologique qui permet de répondre aux enjeux écologiques et climatiques de la ville dense.

Une typologie des différents supports a été développée afin de s’adapter aux performances thermiques des façades tout en les préservant. Le dessin de la structure inspirée de la dendromorphologie constitue à faire un lien entre le sol et la toiture afin de favoriser la biodiversité.

Prendre d’assaut la façade, telle est la vocation des deux espèces végétales choisies : le lierre, garantie d’une force tranquille et persistante et la vigne vierge caduque, qui représente la flamboyance, la fulgurance de la croissance et la renaissance.

Une végétation rudérale prend place au pied des façades en s’installant dans un sol constitué de matériaux graveleux récupérés sur les toitures. Ainsi, leur exportation en décharge ne sera pas nécessaire selon le principe retenu de la valorisation des matériaux sur site.

Un jardin d’ombre dans un renfoncement de toiture vient offrir une chambre végétalisée destinée prioritairement aux occupants des bureaux dont les fenêtres donnent sur les murs borgnes de la nouvelle construction.

La toiture extensive joue son rôle de relais de la biodiversité et offre une capacité de rétention des eaux météoriques qui contribue à la bonne gestion des eaux de pluie et à l’amélioration climatique.

Légendes

Partir à l’assaut de la façade sur un support structuré et structurant :

1 - 1e année

2 - 3e année

3 - 5e année

4 - Faire le lien de la bio-diversité, du sol à la toiture

5 - Micro paysage de fraicheur révélé au personnel hospitalier

6 - Eclairage sculptural, éclairement indirect de l’espace public, préservation de la luminosité pour les parties hautes

De la conception au suivi de la réalisation, ce projet représente non seulement un terrain d’exercices et d’observations emblématique d’une pédagogie innovante et appliquée typiquement HES et d’une recherche fortement ancrée dans des besoins citoyens. La conception de la structure, sa matérialité, son système d’ancrage et d’assemblage feront l’objet d’une présentation dans la cadre de conférences sur les façades végétalisées. Le concept de végétation rudérale expérimentale fera l’objet de suivi comparatif avec un mélange grainier testé sur le site de Lullier.

• Une structure en acier inoxydable de profil standard avec système d’ancrage à articulations et rupture de pont thermique.

• Un système de végétalisation des toitures intensif et extensif, avec natte de rétention d’eau météorique et système d’irrigation automatique.

Paola Tosolini, Denis Clément, Ricardo Lima (HEPIA), Sabine Emad (HEG)

La séparation des fonctions architecturales qui a marqué l’urbanisme et l’architecture du siècle passé, se révèle aujourd’hui inadaptée pour répondre aux défis posés par le développement durable. Via une analyse multidisciplinaire de la notion de « mixité programmatique », ce projet questionne le modèle du bâtiment monofonctionnel. A l’issue du projet, un guide adressé aux maitres d’œuvre et d’ouvrage permettra de les orienter vers des choix programmatiques optimisés.

• Véritable réflexion multidisciplinaire sur l’enjeu de la mixité programmatique dans le bâtiment.

• Inventaire des potentiels générés par les combinaisons des divers programmes des bâtiments.

• Outil concret d’accompagnement pour le maître d’ouvrage dans l’établissement du cahier des charges en vue de réaliser un bâtiment multifonctionnel répondant aux besoins personnels, professionnels ou sociétaux de tous les utilisateurs tout en optimisant son fonctionnement énergétique.

Ce projet de recherche vise à investiguer les potentialités du bâtiment multifonctionnel à Genève comme l’une des réponses possibles aux défis du développement durable en ville.

La notion de mixité programmatique, bien planifiée dès la phase d’avantprojet permet de mutualiser des fonctions de locaux offrant ainsi à chaque programme des espaces et fonctionnalités supplémentaires. L’intégration anticipée de la notion de multifonctionnalité permet non seulement de diminuer les coûts de construction de même que les frais de gestion et d’entretien en optimisant ainsi le rapport qualité/coût du bâti mais contribue également à augmenter de façon significative la qualité des lieux de travail et de vie.

Sur la base de cahiers de charge de concours d’architecture en Suisse ayant des programmes divers (résidentiels, sociaux, administratifs, commerciaux, industriels, hôteliers, touristiques, culturels, etc.) le projet propose à l’aide d’un système de matrices d’inventorier les potentiels générés par les combinaisons d’usages inédits des différentes catégories de bâtiments. Différents paramètres sont pris en compte tels que l’optimisation de la structure porteuse, l’intégration des énergies renouvelables mais aussi la prise en compte de nouveaux modes de gestion mutualisés du bâtiment pour aboutir à de nouveaux types architecturaux innovants. Une analyse de l’adaptabilité des exigences légales relative à la conception multifonctionnelle sera également développée.

Les combinaisons de programmes les plus performantes selon des critères interdisciplinaires seront soumises à un échantillon représentatif des acteurs du bâtiment multifonctionnel. Cette étude de marché permettra de hiérarchiser leurs préférences et de les intégrer dans un guide à l’attention des maîtres d’ouvrage.

Partenaires

FTI (Fondation pour les Terrains Industriels) ; OCEN (Office Cantonal de l’énergie – République et canton de Genève) ; DT (Département du Territoire) ; PPDU (Plateforme de développement urbain de la HES-SO//Genève).

Un guide sur les potentiels de la mixité programmatique pour la ville durable

Le projet Reno-Ve a consisté à développer pour une fondation immobilière de droit public genevoise un outil de pilotage permettant au conseil de fondation de déterminer des priorités d’intervention en matière de rénovation à l’échelle de son parc immobilier. Cet outil innovant se base sur une approche multicritères, incluant divers aspects tels que les questions de vétusté, le social, la consommation d’énergie, le rendement mais aussi le potentiel de rénovation, la densification et la transition énergétique.

Le projet a été développé sur la base du portefeuille de la fondation, composé de 18 bâtiments, caractérisés par une grande hétérogénéité. L’outil de pilotage qui en est issu est simple et totalement transparent. Il permet de poser des bases objectives pour la réflexion que tout propriétaire de parc immobilier ne devrait pas manquer de se poser, dans un souci de bonne gestion, afin d’assurer la pérennité de son portefeuille d’immeubles et leurs transitions vers plus de durabilité.

Lors de la première étape du projet, dix critères d’analyse ont été définis pour être appliqués au parc immobilier, cinq d’entre eux concernant l’état actuel de l’immeuble, et cinq autres relatifs à son potentiel :

Etat actuel

Enveloppe

Structure

Installations techniques

Consommation d’énergie

Rendement économique

Potentiel

Aptitude à la rénovation

Densification

Transition énérgétique Photovoltaïque

Gestion des occupants

Quatre grandes options stratégiques ont été proposées, qui peuvent être combinées et pondérées :

• Énergie (accent sur les économies d’énergie et la transition vers les énergies renouvelables).

• Vétusté (actions en fonction du degré de vétusté).

• Facilité (focus sur les cas où une intervention pose peu de problèmes techniques et humains).

• Optimisation économique (accent sur les bâtiments en fonction de leurs performances économiques).

La deuxième étape a été la collecte de données et les visites techniques des bâtiments de la fondation. Un rapport détaillé a été établi pour chacun d’entre eux, basé sur les critères ci-dessus. Cette étape s’est avérée très utile, car elle offrait ainsi au conseil d’administration une vision complète et synthétique de son portefeuille.

La troisième étape, le développement de l’outil de pilotage multicritères, a permis de fournir un système simple, transparent et utilisable en toute autonomie. Il a été développé comme un simple outil Excel, permettant de fixer les priorités des interventions de rénovation en fonction d’une option stratégique spécifique ou d’une combinaison d’options stratégiques.

L’outil de pilotage ne prétend pas automatiser le processus décisionnel, mais donne des indications objectives au propriétaire pour l’aider à prendre des décisions et à passer d’un processus décisionnel au cas par cas à un processus raisonné, intégrant un maximum de critères.

L’outil de pilotage a été livré à la fondation qui va l’utiliser pour établir ses priorités stratégiques et en termes de rénovation. Il pourra également être proposé à d’autres entités propriétaires de portefeuille immobiliers.

Le projet sera présenté à l’occasion du séminaire sur l’état de la recherche du réseau BRENET (building and renewable energy network) à Aarau en septembre 2020.

Le projet structure les données liées à la représentation numérique d’objets en soussols et teste leur intégration dans des logiciels d’analyse. La première partie est dédiée à la sélection et la description d’éléments physiques ou virtuels qui constituent les soussols du Canton de Genève. La deuxième partie identifie des alternatives logicielles pour permettre l’import et l’analyse de ces données. Le projet se termine par l’établissement de tests de type « intersections géométriques ».

• Élaboration d’une première structuration d’objets souterrains avec leurs attributs, basée sur les résultats d’un workshop interdisciplinaire.

• Définition des orientations de la convergence des systèmes GIS et BIM (GeoBIM, InfraBIM, Geol-IM).

• Expérimentation de l’intégration des objets souterrains dans divers types de logiciels (GIS, DAO+, BIM).

• Développement d’un flux de travail pour l’intégration d’objets souterrains dans un logiciel BIM et détection de conflits spatiaux mutuels.

La densification des villes combinée à la pénurie des espaces constructibles rend les volumes en sous-sols de plus en plus attractifs. Ce développement est freiné par le manque de structuration de données d’objets souterrains ainsi que de leurs qualités. Mandaté par la Direction de l’information du territoire (DIT) du Canton de Genève et par l’Office fédéral de topographie Swisstopo, le projet « Underground » explore les diverses possibilités pour structurer les données existantes et leurs intégrations dans des logiciels d’analyse.

Partant d’un workshop qui a permis d’identifier les cas d’usage, l’étude se base sur le « Système d’Information du Territoire à Genève » (SITG). Le SITG met à disposition un inventaire numérique exhaustif d’objets souterrains. Les éléments du sous-sol qui sont dans un premier temps répertoriés sont les couches géologiques et éléments naturels de type racines d’arbres par exemple (objets naturels). Les objets non naturels (man made objects) sélectionnés, recensent les réseaux utilitaires, les tunnels, les installations géotechniques. Enfin, les restrictions de droit public à la propriété foncière sont intégrées dans le modèle.

Trois possibilités d’importation de données sont identifiées, expérimentées et évaluées :

• Dans un premier temps, les couches numériques du SITG sont explorées puis superposées via un logiciel GIS.

• Une deuxième méthode se réfère à l’exploitation d’un logiciel DAO+, spécialisé en travaux publics.

• Une troisième alternative d’import est proposée au regard de l’utilisation d’une maquette numérique BIM. L’intégration des données dans un logiciel BIM permet par la suite l’utilisation de fonctions pour détecter de potentiels conflits géométriques présents dans les modèles importés.

Légendes

1 - Installations géotechniques, secteur Cornavin ©MIC

2 - Modèle après classification ©MIC

3 - Intégration des bâtiments avec sous-sols ainsi qu’un tunnel ©MIC

4 - Intégration de l’objet tunnel, et son alignement virtuel (RDPPF) ©MIC

5 - Emprise théorique de racines d’arbres, secteur PAV ©MIC

6 - Modélisation géologique, secteur PAV ©MIC

• Du BIM pour le sous-sol ? Domer B. (2019), CadastreRevue spécialisée consacrée au cadastre suisse 31:26-28

• Projet Underground avec des données BIM / géographiques à Genève, Benmansour Y., Domer B., Dubois A., 3DGI - la conférence sur la géoinformation 3D, Muttenz, 29.08.2019

• Digital Construction Permit: A Round Trip Between GIS and IFC, Chognard S., Dubois A., Benmansour Y., Domer B., Advanced Computing Strategies for Engineering, p. 287-306, Proceedings of the 25th EG-ICE Workshop, Lausanne, 10.-13.06.2018

L’étude eRen1 a démontré que des rénovations énergétiques de bâtiments étaient techniquement faisables dans le respect de leur substance architecturale. Le bilan économique de telles opérations, qui a également été évalué, est nettement moins concluant. eRen2, mené conjointement avec la HEIA-FR (Prof. S. Schwab) a pour but d’explorer les synergies qui pourraient naître en cas de combinaison de projets de densification et de rénovation de l’existant, aux niveaux énergétique, d’usage et économique.

Le projet eRen2 se situe à la convergence de politiques publiques : la protection du territoire par la densification de l’habitat existant et la transition énergétique du bâti existant. Mettre en œuvre des projets permettant d’atteindre ces deux objectifs semble une évidence. Pourtant, le nombre de projets de rénovation-densification n’a pas explosé au cours des dernières années. eRen2, basé sur des scénarios développés sur 6 bâtiments réels, a permis d’identifier les contraintes et les moteurs pour réaliser de tels projets.

Le projet eRen2 utilise comme cas d’étude les mêmes immeubles de rendement qu’eRen1, typiques de la construction de logements collectifs de 1945 à 1990. Les questions sont les suivantes :

• Quel est le potentiel de densification des immeubles, au niveau structurel, constructif, spatial et réglementaire ?

• La densification permet-elle de réduire la consommation d’énergie par m2 au-delà d’une rénovation simple ?

• Les revenus supplémentaires générés par la densification permettent-ils d’améliorer le rendement par rapport à une rénovation simple ?

Après avoir défini des scenarios génériques de densification, une combinaison de scenarios a été appliquée à chacun des 6 immeubles, en fonction de critères spatiaux, urbanistiques et constructifs. Finalement, les scénarios ont été développés constructivement et chiffrés (coût et énergie).

La réglementation urbanistique est une barrière majeure à la densification. Sur 6 scenarios, seul 1 pourrait être envisagé sans dérogation importante, et 4 sur 6 bénéficient de droits acquis qu’ils perdraient peut-être en cas de projet de densification-rénovation.

La baisse de la consommation d’énergie par m2 de SRE (surface de référence énergétique) est réelle lors d’une densification-rénovation par rapport à une rénovation d’enveloppe simple. Toutefois, l’écart demeure trop faible pour justifier en soi, d’étendre le projet à une densification. Financièrement, la densification-rénovation est systématiquement perdante lorsque l’on compare les options de statu quo, rénovation simple et rénovation-densification. Cependant, la méthode utilisée (discounted cash flows) est très sensible au taux d’escompte. En extrapolant sur des taux d’escompte plus bas, conformes aux prévisions du marché actuel plutôt qu’aux taux de ces dernières années, la situation change drastiquement.

Le projet eRen2 fait l’objet d’une publication, disponible sur demande. L’étude a été présentée lors des événements suivants :

• Congrès BRENET à l’ETH de Zurich en septembre 2018

• Présentations de projets des programmes thématiques HES-SO à Sion en juin 2019

• Smart living lab lunch à Fribourg en juin 2019

Elle sera également présentée à Bern en octobre 2019 (avec des conclusions étendues) dans le cadre du congrès Advanced Building Skins.

De sorte à favoriser les actions en faveur de l’amélioration du climat urbain, le groupe de recherche « Technique et Paysage » d’HEPIA a été mandaté par la Ville de Sion pour produire un guide sous forme de fiches de recommandations pertinentes pour un retour à une perméabilité des sols et l’amélioration de l’albédo pour lutter contre les ilots de chaleur en ville.

• Améliorer la perméabilité des sols urbains et réduire les îlots de chaleur.

• Garantir que les revêtements et les sols assument un rôle d’« éponge » vis-à-vis des eaux météoriques pour éviter la surcharge des réseaux et des cours d’eau tout en contribuant à alimenter les nappes phréatiques.

• Prendre en compte l’intégration des revêtements dans un cadre historique et paysager.

• Contribuer à la création de milieux adaptés à la biodiversité en ville et favorables à la végétation.

Ce guide a pour ambition d’accompagner la conception ou la réhabilitation d’un espace urbain à l’aide de 9 fiches relatant les avantages et les inconvénients de divers types de revêtements du point de vue du climat urbain.

En fonction des objectifs climatiques et des exigences du lieu, le guide permet, grâce à une typologie développée et détaillée, de fournir une aide permettant de cibler le meilleur choix, voire le meilleur éventail de possibilités de revêtements.

Etant donné l’importance d’une bonne perméabilité des sols, il est nécessaire d’intégrer la réflexion sur la conception des revêtements dès le début du projet. Que le matériau soit du béton, de l’enrobé, du bois ou encore de la pierre naturelle, il est généralement possible de définir une mise en œuvre favorable à l’infiltration des eaux météoriques et l’amélioration de l’albédo. Les différentes recommandations illustrées et décrites dans les fiches présentent un panel non exhaustif de possibilités.

Lorsqu’il n’est pas possible d’utiliser des revêtements perméables et/ou semi-perméables, il existe des alternatives et des mesures de compensations en appliquant, lors de la conception, des propositions selon la formule « Éviter, Réduire, Compenser », qui constitue la doctrine des naturalistes appliquée à l’amélioration du climat urbain.

Légende

1 - « Éviter, Réduire, Compenser », formule appliquée à la gestion des eaux météoriques

visuels :

© HEPIA / Brice Goyard

Ce guide, constitué de 9 fiches de recommandations pour des actions en faveur de la perméabilité des sols en milieu urbain, est destiné à être publié en format papier par la ville de Sion et à être inséré dans le recueil des 16 fiches traitant des aménagements extérieurs de la ville de Sion. Le guide des revêtements perméables de la ville de Sion est disponible en ligne et peut être consulté librement.

www.hesge.ch/hepia/recherche-developpement/ projets-recherche/repersion

Eric Amos, Christian Betti, Romain Legros, Alex Verhille, Géraldine Wälchli

Eric Amos, Christian Betti, Romain Legros, Alex Verhille, Géraldine Wälchli

La Ville de Sion a proposé aux étudiants en architecture du paysage d’HEPIA de faire des propositions d’aménagements bénéfiques à la qualité de vie en ville. Le groupe de recherche « Technique et paysage » d’HEPIA a ensuite été mandaté pour réaliser un guide sous la forme de 16 fiches de recommandations. L’objectif est de sensibiliser les acteurs privés à l’importance et à la complexité de l’aspect environnemental dans ses interactions avec la ville pour améliorer la qualité du climat urbain.

Trois axes ont été identifiés : le végétal, le sol et l’eau, pour lesquels il est envisageable de mettre en place rapidement des actions locales dans un contexte privé. Seize fiches thématiques développent ces trois axes offrant des principes d’aménagements respectueux de l’environnement et de l’homme, visant à sensibiliser, pas à pas, tous les acteurs aux bienfaits des services écosystémiques apportés par la nature en ville.

La problématique des îlots de chaleur en ville est devenue une préoccupation majeure de même que les principes de développement durable et leurs bienfaits font l’objet d’une demande sociale forte. Aujourd’hui, 80% des habitants suisses sont citadins et les espaces privés en ville représentent avec les espaces publics, de réelles opportunités de porter la nature au cœur de la ville. En effet, le choix des matériaux et leur mise en œuvre, les plantes utilisées et leur mode d’entretien, le respect et la valorisation du sol et de l’eau, sont déterminants pour le développement d’écosystèmes favorables à notre cadre de vie.

L’axe « végétal » aborde la question de la biodiversité en recommandant la composition de haies constituées d’espèces adaptées aux conditions locales et l’installation de plantes couvre-sol ou de pelouses favorables aux pollinisateurs et sans besoin de pesticides. Ainsi, planter des arbres fruitiers, pailler son jardin potager, valoriser ses déchets domestiques par le compostage sont autant de pratiques vertueuses et garantes de qualité. Par ailleurs, la présence des arbres et leur capacité à rafraîchir l’atmosphère par l’ombrage et l’évapotranspiration sont également des vecteurs de bien-être doublés de repères patrimoniaux de première importance. Ils doivent être identifiés, respectés, préservés et renouvelés.

L’axe « sol » traite de la question de la fragilité du sol, en rendant les particuliers attentifs à la nécessité de favoriser sa porosité et à son rôle en tant que réservoir d’eau et de substrat vital pour le développement des végétaux.

L’axe « eau » recommande de composer avec le cycle naturel de l’eau pour la mettre en valeur et profiter de ses bienfaits. Collecter et stocker l’eau de pluie et épurer les eaux grises dans le but de pouvoir arroser son jardin, c’est soulager les réseaux et minimiser les risques d’inondations en aval et faire ainsi également des économies de ressources.

Ce guide destiné à des propriétaires privés sera publié en format papier par la ville de Sion, notamment dans le cas des demandes d’autorisation de construire. Il sera aussi édité sous une forme électronique pour en faciliter la diffusion au plus grand nombre. Une opération d’information auprès des services concernés de la ville est planifiée pour aider les collaborateurs à s’approprier ces nouveaux documents de travail.

Légendes

1 - Les bienfaits des toitures et des façades végétalisés.

Légendes

1 - Les bienfaits des toitures et des façades végétalisés.

L’état de Genève planifie la mise en place d’une politique du numérique en créant une « Administration en Ligne » (AeL) performante. Un élément est l’accélération du traitement des demandes d’autorisation de construire par une dématérialisation de la procédure. La technologie BIM (Building Information Modeling) dispose du potentiel d’optimisation du traitement des demandes définitives. Son format d’échange standard IFC assure l’interopérabilité entre divers types de logiciels.

Le format d’échange est un fichier texte relativement léger, encapsulé de façon à ce que l’ensemble des logiciels BIM puissent le lire et le générer. De plus, la technologie BIM permet de condenser dans ce format les données nécessaires et suffisantes à l’élaboration d’une demande d’autorisation de construire définitive. Enfin, le format IFC prend en charge les problématiques de gestion des différentes versions et de traitement centralisé via des plateformes variables.

Cette étude de faisabilité s’appuie sur la modélisation des données, son transfert et sa capitalisation dans le cadre des demandes d’autorisation de construire définitives. De plus, l’étude prospecte également l’interopérabilité entre des données géographiques issues du Système d’Information du Territoire Genevois (SITG) et des données de constructions issues du BIM.

Les « workpackages » réalisés ont testé la faisabilité d’un passage du tout papier vers un modèle tout numérique dans le but d’optimiser les traitements et les prises de décisions. En effet, contrairement aux logiciels de DAO, le BIM traite des attributs supplémentaires à la géométrie et permet donc de stocker des paramètres alphanumériques essentiels à la formulation d’une demande d’autorisation.

Les paramètres peuvent être requêtés et filtrés. Les requêtes permettent aux différents services intervenant dans le processus d’accéder exclusivement aux données les concernant sans devoir interpréter le modèle dans sa globalité. Ceci implique par contre que les données soient saisies selon des règles fixées à l’aide de gabarits spécifiques aux différents logiciels utilisés pour construire des données BIM. Les données sont extraites selon une grille représentée par un « Model view definition » (MVD). Les MVDs ont été créés individuellement pour les logiciels les plus répandus sur le marché. La faisabilité et la pertinence du circuit des données des logiciels SITG – BIM – SITG ont pu être démontrées.

Étude de faisabilité visant un traitement numérique des informations nécessaires pour la procédure de demande d’autorisation de construire

• Optimisation du temps de traitement

• S’inscrit parfaitement dans les divers projets lancés dans le cadre de la gouvernance BIM

• Traite la thématique de la convergence des systèmes GIS et BIM (dit GeoBIM)

• Création d’un prototype d’enrichissement de données SITG par un intermédiaire BIM

Logiciels utilisés dans le cadre de démonstrateur : Revit 2017, Archicad 2017, model viewer de Solibri

Gestion des données sur BIMserver installé sur un serveur linux Ubuntu équipé de TomCat

Transformation de données : FME

Informations territoriales : SITG

Les processus de serveur ont été initiés sur une machine serveur Ubuntu équipé de TomCat.

Les processus autres ont été initiés sur une Workstation 64 bits sous Windows 7 disposant de plus de 12go de RAM.

Bernd Domer, Stefano Riboni, Elie Torri

Bernd Domer, Stefano Riboni, Elie Torri

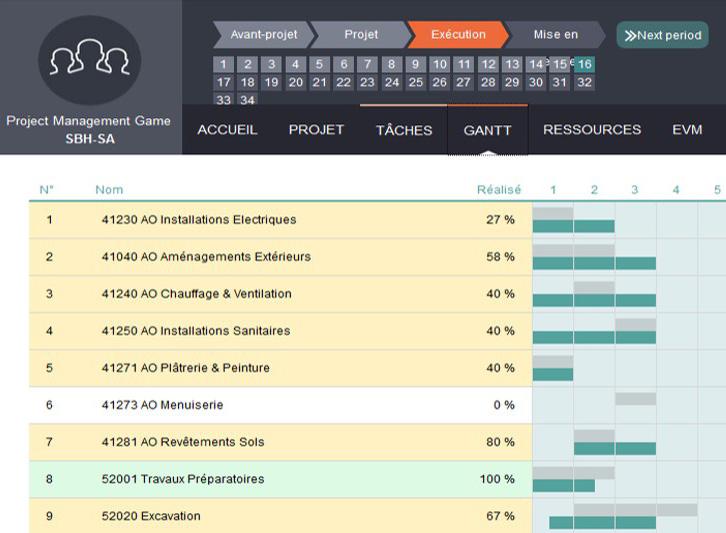

Afin d’expérimenter de façon tangible le contenu de l’enseignement en gestion de projet, une solution innovante consiste à l’élaboration d’un scénario transposé en « jeu sérieux » auquel l’étudiant est convié à participer. Il se retrouve alors immergé dans une succession de décisions / répercussions, avec pour objectif de satisfaire le client en menant à bien le projet dans les délais impartis.

Cette simulation, ludique et prenante, offre une première expérience quant aux aléas d’un chantier.

• Nécessite simplement une connexion internet

• Ludique

• Encourage le travail d’équipe

• Oblige les étudiants à prendre des décisions par rapport à leur analyse subjective des situations (sans forcément avoir toutes les clés)

• Offre une première expérience aux étudiants de la diversité des problèmes rencontrés au cours de la réalisation d’un projet

• Permet à l’enseignant de suivre le travail des étudiants, avec divers outils d’évaluation mis à disposition sur la plateforme du Serious Game

Bien que d’une manière générale ce soient les architectes qui sont chargés de gérer la planification d’un projet de construction, il est opportun que les futurs ingénieurs civil soient sensibilisés aux problématiques et enjeux qui en découlent, pour être plus à même de comprendre ce qui se passe à l’échelle de la maîtrise d’ouvrage.

Or, pour des étudiants principalement attirés par des sujets à caractère technique, il peut être intéressant de procéder par une approche différente du cours magistral. C’est ce qui est proposé par le biais du Serious Game : un jeu de simulation de gestion de projet en ligne, ou le participant endosse le rôle du chef de projet, et doit gérer les différentes phases de son avancement.

Le scénario est entièrement pensé et développé par l’enseignant. Il se base sur des données concrètes : on imagine la construction d’un immeuble en région genevoise, l’organisation du projet est cadrée et des plans sont fournis. De nombreuses situations sont imaginées, dans lesquelles plusieurs décisions sont proposées, chaque prise de décision s’accompagnant de répercussions sur les différents indicateurs (satisfaction client et direction, qualité, coûts et délais). Des aléas de chantier sont intégrés, afin de tester la capacité du joueur à réagir face à des difficultés imprévues. Afin de garantir l’exécution dans le budget et les délais impartis, l’étudiant doit ainsi faire preuve d’une bonne maîtrise des notions du cours tout en se montrant perspicace et entreprenant, qualités importantes pour relever les challenges proposées par ce « jeu sérieux ».

Ce support peut ainsi être vu comme un moyen pédagogique innovant, permettant une mise en application concrète du contenu du cours. La première expérimentation auprès des étudiants en 3ème année a abouti à des retours très enthousiastes de leur part.

L’utilisation du Serious Game représente une innovation pédagogique dans l’apprentissage de la gestion des projets de la construction. Les participants doivent prendre des décisions dans un environnement dynamique. Ils sont obligés d’émettre des hypothèses pour justifier leur choix. Le scénario peut s’utiliser pour la formation en management des architectes et ingénieurs.

Pour les joueurs, il suffit de disposer d’un accès internet, de créer un compte sur albasim.ch et de recevoir le code de la partie à jouer par l’administrateur, rôle échu à l’enseignant. Le scénario de la partie peut être édité uniquement si l’enseignant possède les droits de scénariste.

USS se place dans le contexte d’une valorisation intense de l’énergie solaire dans le tissu bâti, non seulement sur les toitures, mais aussi sur les façades, afin de répondre aux objectifs énergétiques et climatiques de la Suisse. Il s’inscrit à la suite du cadastre solaire élaboré sur un plan horizontal (toitures et territoire) à Genève et vise à développer une méthode et un outil pour analyser l’irradiation solaire sur les façades d’immeubles en recourant aux outils de GIS 2.5D et 3D et de modélisation solaire.

• Outil intégré et performant calculant le potentiel solaire sur les toitures, le terrain (toitures/couverts potentiels) et les façades d’immeubles grâce aux outils GIS 2.5D et 3D.

• Approche géomatique innovante pour modéliser en 3D les façades à partir de modèle numérique de surface en 2.5D (approche par hyperpoints).

• Recours au cloud computing permettant une analyse du potentiel solaire sur un large territoire (plusieurs km2).

• Dispositif de visualisation 3D du résultat d’irradiations solaires sur les façades en vue d’une valorisation plus intensive des façades.

Urban Solar Skin (USS) est un projet financé dans le cadre du programme de recherche du domaine Ingénierie & Architecture (HES-SO) et du sousprogramme Energy District 2050, et co-financé par les Services industriels de Genève (SIG) et l’Office cantonal de l’énergie (OCEN). Il s’inscrit dans un partenariat scientifique international : hepia, HES-VS, Ecole polytechnique de Milan, Faculté des sciences de Lisbonne.

USS se place dans le contexte d’une valorisation intense de l’énergie solaire dans le tissu bâti, non seulement sur les toitures, mais aussi sur les façades, afin de répondre aux objectifs énergétiques et climatiques. En effet, les nouvelles technologies solaires PV sont particulièrement compatibles au niveau technique et architectural avec une valorisation active de l’énergie solaire sur les façades (selon le concept de BiPV).

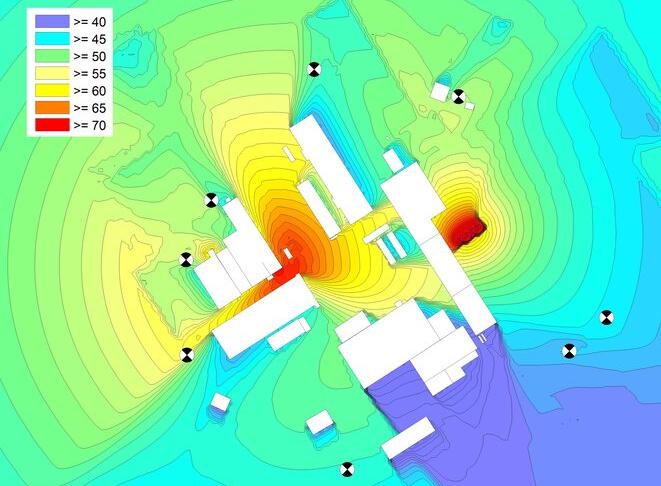

USS fait suite au projet du cadastre solaire élaboré sur un plan horizontal (toitures et territoire) à Genève. Il propose un outil intégré analysant le potentiel solaire non seulement sur les toitures mais aussi sur les façades (Image 1), dans le but de sensibiliser, communiquer et inciter à la valorisation des façades selon différents modes possibles : solaire actif (PV), ou passif tenant compte du micro-climat urbain.

Si le calcul de l’irradiation solaire sur le terrain et les toitures se base sur un modèle numérique de surface (MNS) en 2.5D issu de relevés LiDAR, alors le calcul sur les surfaces doit intégrer la 3D au sens strict afin de modéliser la surface des façades. Cela est effectué en se basant sur le MNS 2.5D et en générant un ensemble de points (appelés ‘hyperpoints’) le long des façades entre le bord des toitures jusqu’au terrain (cf. Image 2). Le calcul d’ombrage et d’irradiation solaire se fait ensuite sur chacun des points des façades.

Légendes

1 - Irradiation solaire annuelle sur les toitures et les façades dans un quartier à Meyrin à Genève

2 - Génération d’hyperpoints le long des façades à partir du MNS 2.5D (bord toitures) et du MNT (terrain)

L’outil USS a fait l’objet d’un test pilote sur un large territoire du Canton de Genève (12 km2). Selon les résultats de cette phase, il sera possible d’élargir l’analyse et de proposer un cadastre solaire des façades sur une grande partie du Canton (zones urbanisées). Dans le cadre de la planification énergétique territoriale, les applications des résultats du cadastre solaire sont multiples :

• identification des façades à haut potentiel, notamment dans les zones d’activités et industrielles,

• implications sur le marché immobilier en redéfinissant la valeur des bâtiments par rapport à leur potentiel énergétique solaire en toiture et sur les façades,

• évaluation de l’apport solaire passif (bilan énergétique),

• leviers d’actions pour les collectivités pour inciter à l’accroissement de l’installation de panneaux solaires à travers différentes mesures et actions.

Les scripts développés Java permettent de calculer l’irradiation horaire à partir de données météorologiques en tenant compte des ombres portées. Les valeurs horaires d’irradiation sur plan horizontal sont issues de Meteonorm (v7) qui établit des valeurs statistiques à partir des données mesurées à Genève-Cointrin sur la période 1985-2005. Les outils de système d’information géographique, tels que ArcGIS, permettent de traiter les données d’altitude issues du LiDAR pour reconstituer le modèle en 2.5D (toitures) et 3D (façades) du territoire. De plus, dans une phase de post-traitement, ces outils permettent aussi de produire les indicateurs utiles pour la communication et l’aide à la décision.

Enfin, dans la perspective des mises à jour régulières du cadastre solaire (selon le développement du bâti), une optimisation informatique des scripts permet de les exécuter sur des plateformes de Cloud computing accélérant ainsi le temps de calcul.

L. Rinquet, G. Rey, R. Camponovo, P. Gallinelli, D. Varesano (HEPIA), S. Schwab (HEIA-FR), S. Citherlet (HEIG-VD), G-A. Morand (HEVS)

Le projet eRen vise à développer des outils d’aide pour proposer différentes solutions de rénovation énergétique pour les enveloppes d’immeubles de logement en Suisse romande. A partir de l’analyse de dix études de cas concrètes représentatives des typologies constructives et architecturales marquantes du 20ème siècle, il tente de favoriser une approche équilibrée prenant en compte considérations énergétiques, patrimoniales et économiques.

• Dresser un inventaire des différentes typologies constructives existantes en Suisse romande.

• Proposer des solutions de rénovation exhaustives, réalistes et chiffrées servant de bases de travail pour les acteurs de la rénovation thermique du bâtiment.

• Porter une réflexion plus large sur le marché de la rénovation thermique en mettant en évidence ses forces et faiblesses.

L’assainissement énergétique des immeubles d’habitation est un enjeu majeur de la stratégie énergétique 2050 de la Confédération suisse. Malgré la volonté politique, le taux de rénovation énergétique reste relativement limité et le rythme ne semble pas s’accélérer. Parmi les obstacles les plus fréquents on peut indiquer le coût des travaux, le faible prix de l’énergie, les difficultés techniques, les questions patrimoniales, la disponibilité de spécialistes qualifiés, ou la pénurie de logements.

Les interventions ponctuelles sans vision d’ensemble sont la norme. Lorsqu’un projet complet est mené à bien, il se résume souvent à une mise à jour des installations techniques, un remplacement des fenêtres et une isolation périphérique. Ces solutions éventuellement valables sur le plan énergétique posent souvent des questions constructives, de respect du patrimoine, de physique du bâtiment ou encore de durabilité.

L’étude eRen part du postulat que le parc bâti de Suisse romande se décline en différentes typologies constructives, témoins d’époques et de modes de construction différents, qui participent à l’identité de la ville et méritent chacune un traitement particulier afin d’en préserver au mieux les qualités. eRen propose donc un travail sur l’enveloppe des bâtiments basé sur une approche globale et interdisciplinaire cherchant le meilleur équilibre entre efficience énergétique, aspects constructifs et de physique du bâtiment, économie, co-bénéfices et co-pertes et valeur patrimoniale.

En développant des outils d’aide et de réflexion pour la rénovation énergétique des principaux types d’immeubles d’habitation en Suisse romande, le projet constitue un cadre de référence accessible aux principaux acteurs pour leur permettre d’agir ensemble avec efficacité dans le cadre d’une rénovation énergétique tout en tenant compte des valeurs d’usage et culturelles du bâtiment à rénover.

Légendes

1 - Façade d’un bâtiment étudié.

© hepia / leea

2 - Rez-de-chausse présentant un fort potentiel d’isolation. © hepia / leea

3 - Thermographie d’une façade-rideau métallique. © hepia / leea

4 - Installation d’un dispositif de mesure de valeur U sur la toiture d’un bâtiment.

© hepia / leea

5 - Stratégie d’intervention à l’échelle d’un bâtiment. © hepia / leea

6 - Stratégie d’intervention à l’échelle d’un détail constructif. © hepia / leea

L’étude, de par son exhaustivité, permet de sensibiliser différents acteurs professionnels actifs en rénovation thermique (propriétaires, régies, services de l’énergie et des constructions, ingénieurs conseils, architectes) aux questions patrimoniales et de préservation du tissus bâti. L’étude est également valorisée dans le cadre de l’enseignement de la construction à l’hepia (haute école du paysage d’ingénierie et d’architecture) et l’heia-fr (haute école d’ingénierie et d’architecture de Fribourg).

• Mesure des valeurs U de différents éléments de construction sur des bâtiments témoins grâce à l’installation de dispositifs de mesure in situ.

• Bilans thermiques des bâtiments sur logiciel.

• Modélisation du comportement thermique de détails de construction sur logiciel.

Lionel Rinquet, Nicolas Brun, Kinn Galeuchet, Théo Mandanis, Giovanni Salvador, Nicolas Simard, Loic Simon

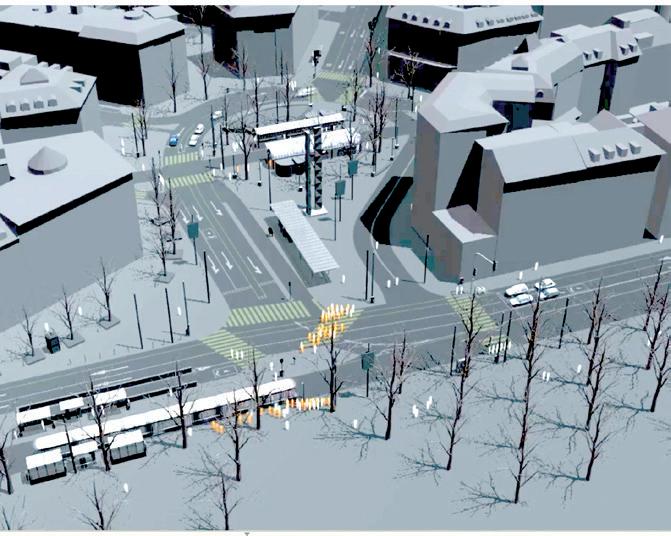

Le projet Tosa 2 s’inscrit dans un projet plus large qui vise à développer l’utilisation de bus électriques à recharge rapide, sur le réseau genevois. Il s’attache au développement du système de recharge « flash » de grande capacité qui doit alimenter en courant les bus électriques lors de leurs arrêts.

• Conception d’un mât métallique pour supporter une station de charge rapide.

• Intégration des équipements électriques dans le paysage urbain.

• Collaboration étroite avec les différents mandataires et initiateurs du projet.

• Collaboration avec un bureau d’ingénieur civil pour le dimensionnement structurel.

Le projet Tosa est né d’un consortium d’entreprises (TPG, OPI, SIG, ABB) ayant pour ambition de développer un bus électrique pour le réseau de transport public genevois. Hepia participe activement au déroulement de ce projet, en particulier dans le domaine de la conception des structures qui doivent prendre place aux différents arrêts pour approvisionner les bus en énergie électrique. Cette collaboration a déjà donné naissance au projet TosaStruct qui consistait en la conception d’un élément préfabriqué en béton fibré ultra performant, remplacé par une structure métallique dans le déploiement du système.

Dans le cadre du projet Tosa 2, des étudiants en architecture, génie civil et en architecture du paysage ont conçu le mât métallique comme support d’un bloc chargeur capable d’alimenter les bus en courant électrique lors de leurs arrêts, ainsi que les armoires d’installations techniques et l’intégration du tout sur les arrêts de la ligne 23 des TPG. Toutes les contraintes permettant à ce projet de s’inscrire dans une certaine réalité ont été considérées : contraintes structurelles, urbanistiques, techniques, esthétiques, etc. Le mât métallique a fait l’objet d’études plus approfondies, entre autres avec un bureau d’ingénieurs civils, pour préciser certains points de sa conception et le rendre réalisable.

Légendes

1 - Montage photo du mât métallique par les étudiants de hepia.

2 - Bus électrique à sa station de recharge. © abb.ch

3 - Coupe sur une station de recharge.

4 - Plans d’exécution du mât métallique.

• Articles de presse.

• Collaboration étroite avec les différents partenaires et initiateurs du projet.

• Collaboration avec un bureau d’ingénieurs civils pour le dimensionnement structurel et l’étude de faisabilité.

• Participation au think tank « Transports en commun » du DETA.

• Pédagogie, ateliers interdisciplinaires CEN.

• Logiciel de simulation des structures SCIA.

Le projet TosaStruct a étudié l’utilisation d’un matériau novateur dans des conditions difficiles. Il s’agit d’un béton fibré ultra performant (dit BFUP). Ce matériau possède plusieurs qualités qui le rend attractif pour une réalisation particulière : une résistance élevée à la compression et à la traction et une excellente qualité de la surface démoulée.

• Tests en laboratoire de la résistance du BFUP à la compression et à la traction.

• Validation de l’utilisation de pigments colorés pour ce matériau.

• Tests de mise en place du BFUP pour des coffrages d’une géométrie complexe.

• Réalisation de deux éléments préfabriqués pour l’utilisation dans le cadre du projet TOSA.

Le consortium TOSA (www.tosa2013.com) développe actuellement la prochaine génération de bus électriques. Au lieu d’être lié à une ligne de contact comme pour le système des trolleybus aujourd’hui en service, le consortium propose des bus avec des batteries très puissantes. Ces batteries sont rechargées aux arrêts de ligne dans un temps record : environ 15 secondes uniquement.

Pour prouver la fiabilité de la technologie, le consortium a projeté une ligne de test entre la gare CFF de l’aéroport et Palexpo. Cette ligne à nécessité deux potences de recharge. L’emplacement d’une de ces potences sur le viaduc de l’aéroport avec une capacité de charge réduite et sans possibilité d’ancrage au sol fut un véritable challenge pour les ingénieurs d’hepia.

L’application d’un matériau novateur, le béton fibré ultra performant (BFUP), était la solution. La résistance élevée de ce matériau à la traction et à la compression a permis de réduire l’épaisseur des parois de la potence par un facteur 3 et en conséquence, dans la même proportion, le poids propre. Aucune armature passive n’était nécessaire pour renforcer la structure. Avant la production des deux potences en éléments préfabriqués, plusieurs tests en laboratoire ont été menés afin de s’assurer des caractéristiques du matériau.

Les deux éléments préfabriqués d’une géométrie complexe et d’une hauteur de plus que 4 m ont été coulés en une seule fois. La conception du coffrage à du tenir compte des pressions importantes du béton frais ainsi que de la rétraction des éléments formant l’évidement pour éviter une fissuration pendant la phase de prise du ciment.

Après la mise en place des potences de recharge, la ligne a pu être inaugurée en présence de la conseillère fédérale Doris Leuthard et plusieurs conseillers d’état le 26.05.2013.

Légendes

1 - Ajout des fibres métalliques à la masse cémenteuse du béton.

2 - Coffrage pour le test de fluidité du matériau et des différents aspects de surface.

3 - Essai de la résistance à la flexion.

4 - Coffrage de l’élément pendant la préfabrication.

5 - Arrêt « Palexpo » avec potence de recharge et abri.

6 - Arrêt « gare CFF aéroport » lors de l’inauguration le 26.05.2013 en présence de Doris Leuthard, conseillère fédérale.

Publications

• UHPFRC 2013, Proceedings of the RILEM-fib-AFGG International Symposium on Ultra High Performance Fibre-Reinforced Concrete, Marseille, 2013, « Construction of two precast power units in UGPFRC »

• Dimension 2/2013, magazine pour la clientèle de l’entreprise Holcim

• hepianews 8/2013

• Présentation à la journée de la recherche hepia 2013

• Les équipements de test du LEMS (laboratoire des essais des matériaux et des structures, voir fiche séparé).

• Logiciel de simulation des structures.

Lionel Rinquet, Reto Camponovo, Peter Gallinelli, Miguel Sanchez, Damien Varesano, Eric Vittecoq, Martina Zsely Schaffter

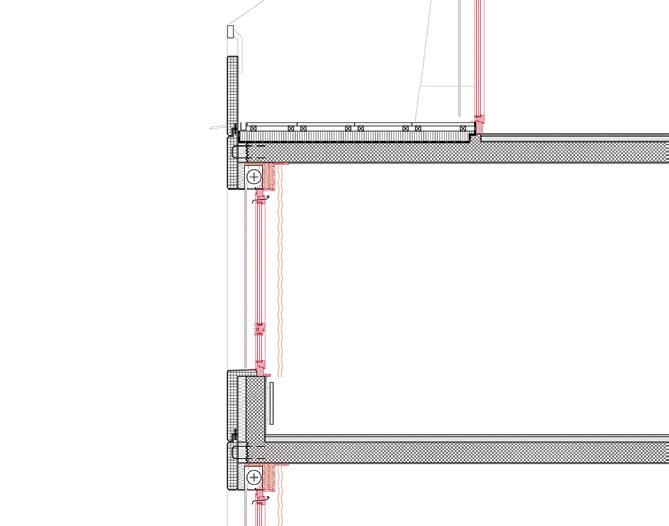

Le projet H-CEVA a testé en grandeur nature le comportement des éléments vitrés en double peau compacte respirante imaginés pour les façades des gares du CEVA par le groupement des ateliers Jean Nouvel. hepia, mandatée par l’entreprise Hevron SA a mené, en collaboration avec Beaud Ingénierie Sàrl, l’analyse de l’atmosphère interne des éléments (l’évaluation des risques de condensation et d’encrassement et la rédaction de consignes d’entretien pour l’exploitant). Les partenaires ont ainsi contribué à perfectionner le prototype en vue de la production en série.

• Implication sur un projet phare de l’agglomération genevoise.

• Elaboration d’un protocole d’essai, essais et mesures de comportement sur un système de façade novateur (double peau compact en régime 100% extérieur).

• Test sur les filtres à poussières contenues dans les éléments de façade par exposition in situ et analyse en laboratoire.

Le consortium SHZ, piloté par Hevron SA, réalise les façades qui habilleront les cinq gares du CEVA. Au cœur du projet architectural, ces façades sont composées d’éléments de double peau compacte respirante intégrant plusieurs couches de verres qui réagissent aux conditions météorologiques de manière complexe.

Deux campagnes d’essais se sont déroulées conjointement.

La première a consisté à mesurer durant quatre mois les paramètres physiques de trois prototypes à l’échelle 1:1 installés sur le site de la future gare des Eaux-Vives à Genève. Le monitoring du renouvellement d’air, des températures et de l’humidité à l’intérieur et l’extérieur des éléments a permis de vérifier leur comportement dans des conditions météorologiques variées, d’analyser les risques de formation de condensation et de salissures sur la surface intérieure des verres et d’affiner le système en vue de la production en série.

La deuxième a étudié l’efficacité des filtres anti-poussières assurant la « respiration » des éléments. Un caisson métallique muni de verres et de filtres installé dans la gare de l’aéroport de Cointrin a permis de reproduire par circulation d’air de manière accélérée l’encrassement des filtres et le dépôt des suies ferroviaires sur les verres. Ces suies ont été récoltées sur les verres et ont fait l’objet d’analyses par le service analytique du département TIN (technologies industrielles) d’hepia pour les quantifier et les qualifier.

La synthèse des essais a permis d’évaluer objectivement les risques d’encrassement des éléments de façade et de proposer des prescriptions de maintenance à l’usage de l’exploitant, le but étant de minimiser les coûts d’entretien en cycle de vie.

Légendes

1 - Montage des sondes dans les éléments en atelier chez Hevron SA. © hepia / leea

2 - Condensation intérieure résultant de l’ombre portée de la croix de Saint-André.

© hepia / leea

3 - Grandeurs physiques mesurées.

© hepia / leea

4 - Caisson de test installé à Genève Cointrin.

© hepia / leea

5 - Verres intégrés au caisson de test.

© hepia / leea

6 - Filtre testé en accéléré. © hepia / leea

Les essais ont permis d’appréhender par le biais d’une analyse des grandeurs physiques le comportement d’éléments respirants de double peau compacte en milieu 100% extérieur ce qui constitue une nouveauté dans le domaine de la façade et contribue à réduire significativement les coûts en cycle de vie de l’ouvrage. L’expertise et l’expérience acquise par l’équipe d’hepia durant ce projet ont été valorisées auprès des entreprises du consortium de constructeurs et serviront également au titre de la pédagogie.

• Sondes de température et d’humidité.

• Sondes de mesure de concentration de CO2.

• Caisson étanche en aluminium avec ventilateur pour recréer des conditions d’encrassement accélérées des filtres à poussières.

• Spectrométrie de fluorescence X et spectrométrie infrarouge (TIN).

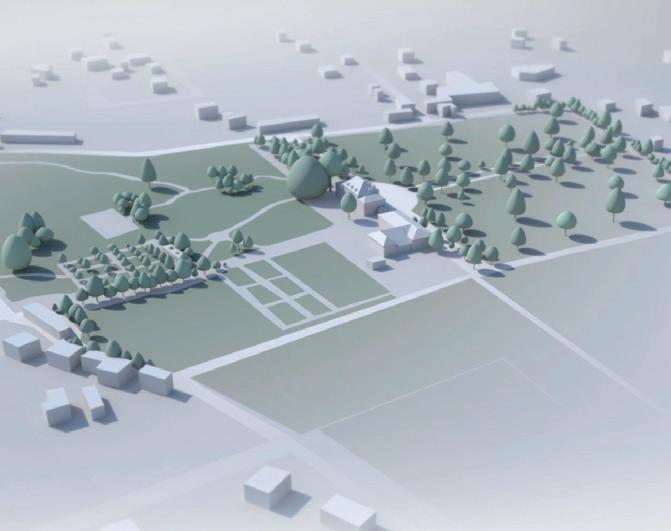

Le projet INTERREG IVAsQUAD s’inscrit dans un contexte de multiplication des projets transfrontaliers d’aménagement qui font face à des méthodes, des pratiques et des législations différentes. Il a pour finalité de stimuler les réseaux d’acteurs suisses et français autour d’une réflexion sur les projets d’urbanisme durable et de créer avec leur collaboration des centres de compétences au niveau des territoires transfrontaliers, permettant un suivi et le pilotage sur le long terme des quartiers durables.

• Déployer et enrichir l’observatoire transfrontalier Eco-Obs des écoquartiers.

• Formaliser et valider des lignes directrices pour soutenir activement les opérateurs dans la planification et la réalisation de quartiers durables / « écoquartiers ».

• Organiser des formations afin de renforcer les compétences des professionnels.

• Structurer et pérenniser des centres de compétences régionaux.

Si les porteurs politico-administratifs des projets urbains sont en majorité sensibilisés aujourd’hui aux enjeux du développement urbain durable, ils se sentent souvent démunis pour les intégrer de façon cohérente dans les projets d’aménagement aux différents stades (appel à projets pour les plans de quartier, concours, mandats d’étude parallèle, etc.). Des outils, des labels, des référentiels existent, qui permettent d’évaluer de façon factuelle les projets de quartiers durables, mais ne suffisent pas en eux-mêmes à soutenir le processus de planification. En effet, ce processus requiert un outil de pilotage intégrant les diverses étapes de développement du projet ainsi que l’implication des différentes parties prenantes. Ces besoins ont été notamment mis en évidence dans les contextes transfrontaliers suisses et français lors du projet Interreg IVA « Eco-Obs: observatoire transfrontalier des écoquartiers », mené entre 2009 et 2012. De tels besoins ont motivé le montage d’un nouveau projet Interreg IVA

- sQUAD, piloté par la HES-GE / hepia (CH) et INES-Plateforme évaluation et formation (F) qui associe des partenaires académiques, privés, et du monde associatif. Il a démarré en janvier 2014 et s’achèvera durant l’été 2015.

Le projet sQUAD a pour finalité de stimuler les réseaux d’acteurs suisses et français autour d’une réflexion sur les projets d’urbanisme durable et de créer avec leur collaboration des centres de compétences au niveau des territoires transfrontaliers, permettant un suivi et le pilotage sur le long terme des quartiers durables.

Cela implique:

• de déployer l’observatoire Eco-Obs et de capitaliser du savoir sur les processus en cours de construction de quartiers durables sur des territoires transfrontaliers (le Grand Genève, l’Arc Jurassien, le Valais et le Chablais, la région de Chambéry et celle de Grenoble);

• de formaliser sur cette base des lignes directrices pour l’accompagnement d’opérateurs urbains dans le processus de planification de quartiers (assistance à maîtrise d’ouvrage ou AMO en France);

• de favoriser des échanges d’expériences et de savoir-faire entre les acteurs techniques et politiques;

• d’organiser des formations visant à mettre sur pied des démarches de co-apprentissage à partir de cas pratiques et de références théoriques reconnues.

En résumé, le projet proposé vise à répondre effectivement et de manière opérationnelle aux besoins des collectivités et des acteurs privés. Il ne se limite pas au déploiement d’un simple outil d’observation, mais contribue au développement d’un réseau de compétences et de savoir-faire au service des maîtres d’ouvrage.

Légendes

1 - Ecoquartier « Eikenott » réalisé à Gland (VD).

2 - Ecoquartier d’ « Ecovela » à Viry - France.

3 - Image de synthèse du futur écoquartier des Vergers à Meyrin.

4 - Territoires sQUAD.

Treize quartiers pilotes ont été analysés par le biais des outils proposés par l’observatoire (grilles d’évaluation selon Quartier durables/Sméo en Suisse, Label Ecoquartier en France, dispositif d’analyse des processus de planification sous l’angle du pilotage et de la gouvernance). Les retours d’expériences de ces analyses ont permis d’identifier les critères incontournables communs entre la France et la Suisse dans la perspective d’un pilotage stratégique, et de développer les lignes directrices guidant le processus de planification et la composition des quartiers durables.

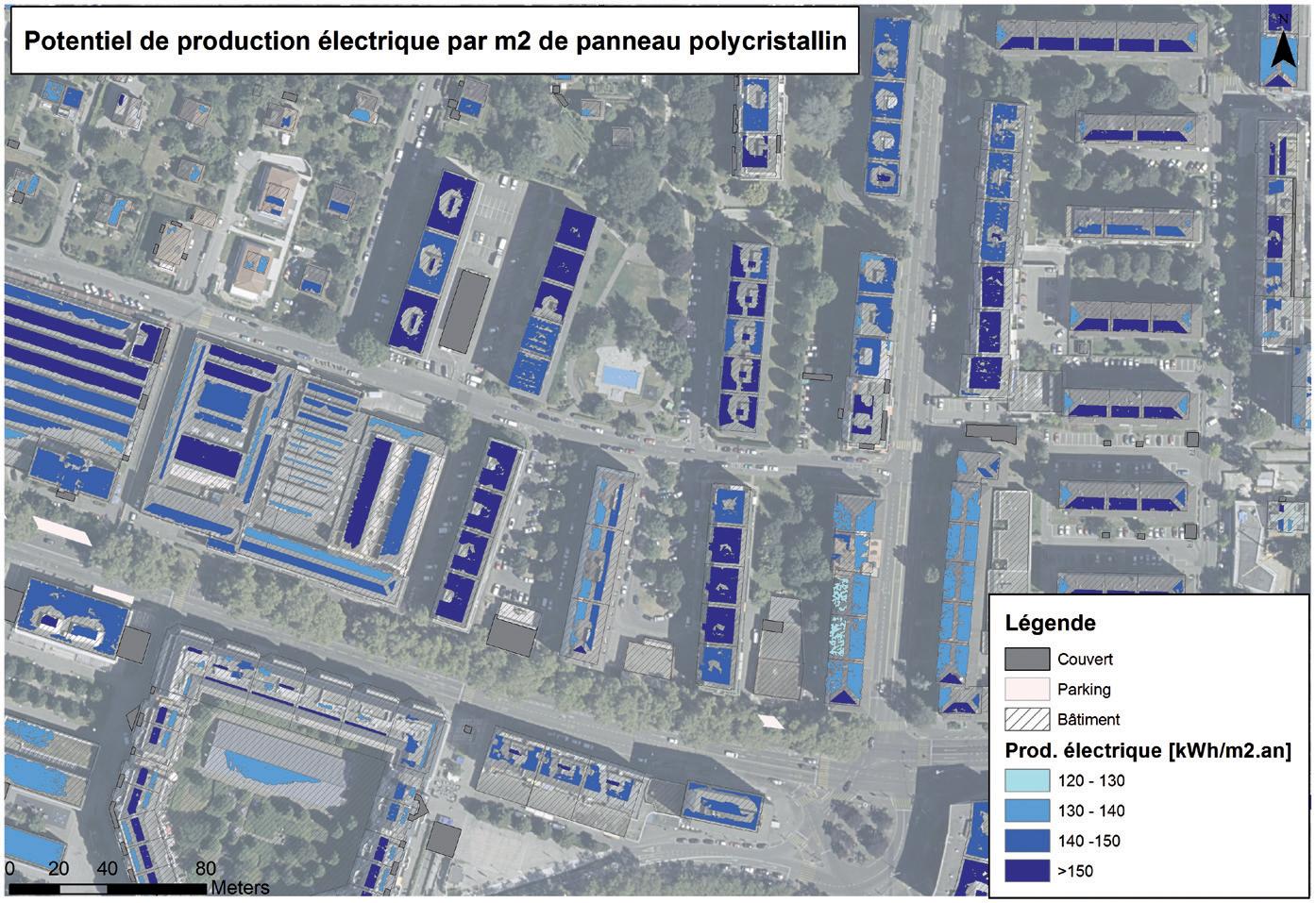

Trois chercheurs d’institutions académiques différentes ont développé un outil « SIG-solaire » qui a été mis à disposition de la présente étude sur le canton de Genève. Il permet d’évaluer de façon systématique l’irradiation solaire accessible sur le territoire et particulièrement le potentiel de production énergétique sur les toits et les façades des bâtiments. Il se base sur les données météorologiques locales ainsi que sur les données géographiques facilement disponibles, par exemple au travers du Système d’information du territoire genevois (SITG).

• Cartographie du potentiel solaire de façon systématique et automatique sur un large territoire, en s’appuyant sur les données 3D des bâtiments.

• Communication au public sur le potentiel solaire des toitures.

• Gain de temps dans les avant-projets d’installation de panneaux solaires (nombreux déplacements in situ évités).

• Découverte du potentiel solaire sur d’autres objets que les faces de toits (sur le terrain par exemple abris/car-ports, parkings, etc.).

L’outil proposé est issu d’un travail interdisciplinaire mettant en synergie un certain nombre de compétences et de techniques dans les domaines de la télédétection, des systèmes d’information géographique (SIG) 2D et 3D, de l’analyse d’images, et des indicateurs environnementaux. Il permet d’évaluer l’irradiation solaire sur le territoire à différentes échelles temporelles avec une précision et une fiabilité tout à fait satisfaisantes pour les besoins énoncés par les mandants; ceci grâce à la reconstitution précise du territoire en 3D au travers des données aéroportées LiDAR et à une intégration des différentes sources d’ombrage.

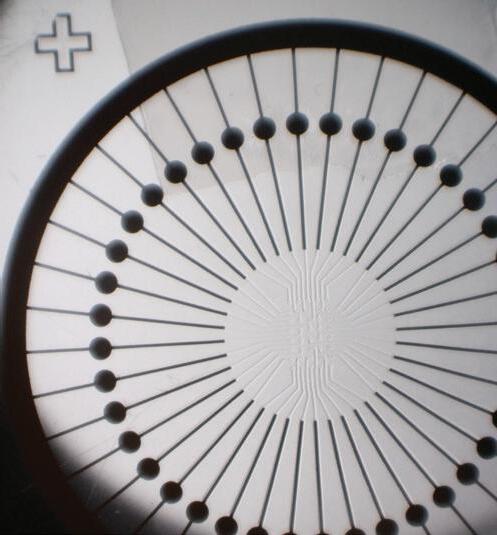

L’ombrage sur la composante directe de l’irradiation est évalué à chaque heure d’une journée type à partir d’un voisinage proche (bâti, arbres), ou lointain (relief). Le facteur d’ombrage sur la composante diffuse peut être approché par le Sky view factor, qui analyse le degré de visibilité ou la non-obstruction dans le demi-hémisphère centré sur un point donné, selon le principe du « Fisheye ».

Les résultats bruts d’irradiation sont ensuite traités, dans une phase de post-traitement, dans des outils SIG pour produire des indicateurs utiles pour la communication et l’aide à la planification et à la décision : statistiques d’irradiation par toiture, ratios d’ombrage, parties des toitures productives, potentiels de production énergétique thermique et électrique sur les toitures et les façades.

Légendes

1 - Ecoquartier « Eikenott » réalisé à Gland (VD).

2 - Ecoquartier d’ « Ecovela » à Viry - France.

3 - Image de synthèse du futur écoquartier des Vergers à Meyrin.

4 - Territoires sQUAD.

L’outil SIG-solaire a pu être mis en œuvre afin d’élaborer le cadastre solaire sur tout le canton de Genève, sous mandat de l’Office cantonal de l’énergie (OCEN) et des Services Industriels de Genève (SIG), notamment grâce aux puissances de calcul et au traitement spatial systématique et automatisé propre aux SIG, tout en gardant une grande précision d’analyse (pixel de 0.5 m) nécessaire à une analyse fine de l’irradiation solaire sur les toitures. Dans le cadre de la planification énergétique territoriale, les applications des résultats du cadastre solaire sont multiples :

• implications sur le marché immobilier en redéfinissant la valeur des bâtiments par rapport à leur potentiel énergétique solaire en toiture et sur les façades,

• évaluation de l’apport solaire passif (bilan énergétique),

• leviers d’actions pour les collectivités pour inciter à l’accroissement de l’installation de panneaux solaires à travers différentes mesures et actions.

Les scripts développés Java permettent de calculer l’irradiation horaire à partir de données météorologiques en tenant compte des ombres portées.