security insight

security insight

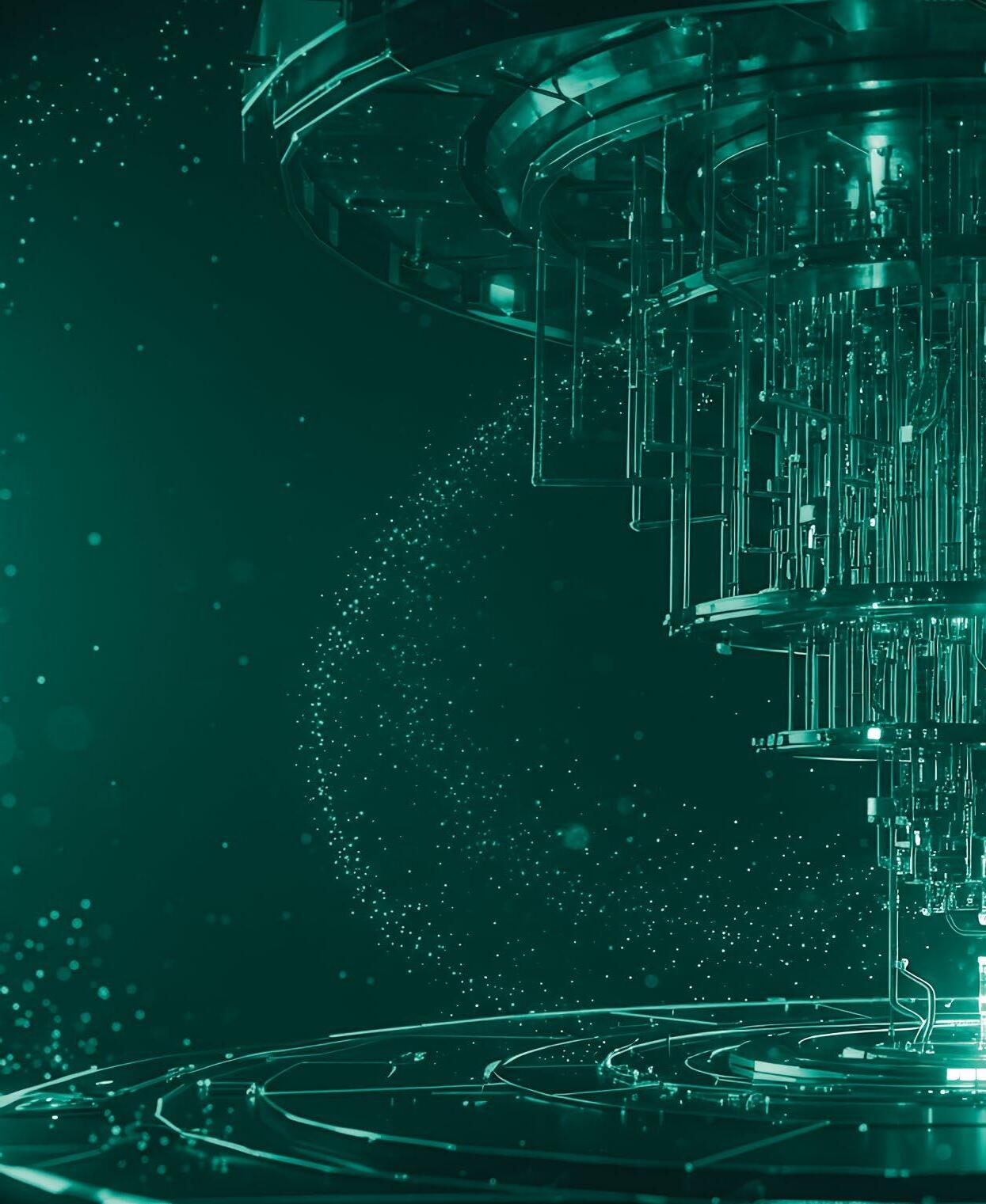

Revolution im Rechenzentrum: Warum Unternehmer und Aufsichtsräte jetzt den Grundstein für die neue technologische Entwicklung legen sollten

DATENMANAGEMENT

Nur wer klare Sicht auf die Daten des Unternehmens hat, kann seine BusinessPotenziale rechtzeitig heben.

Die Förderung von Frauen in der IT ist nicht nur ein Gebot der Stunde, sondern strategische Notwendigkeit.

Intelligente Automatisierungslösungen im Gesundheitswesen erfordern eine speziell entwickelte KI.

Bleiben Sie auf dem Laufenden mit den neuesten Entwicklungen und Trends aus der Welt der Künstlichen Intelligenz. Unser kostenfreier Newsletter vom WIN-Verlag wird monatlich versendet und bietet Ihnen spannende Einblicke, exklusive Inhalte und Expertenmeinungen der verschiedenen Branchen.

Melden Sie sich jetzt an und verpassen Sie keine Ausgabe!

sondern auch bestehende Prozesse revolutionieren –von der Finanzmodellierung bis zur Entwicklung nachhaltiger Produkte.

Frühzeitiger Kompetenzaufbau erfoderlich

Liebe Leserin, lieber Leser

Nach KI steht jetzt Quantencomputing an der Schwelle, unsere digitale Welt grundlegend zu verändern. Und weil die Technologie immer hörbarer anklopft, war es höchste Zeit, dazu einen Titel zu machen.

Exponentiell schnellere Lösungen

Anders als klassische Computer nutzen Quantencomputer die Prinzipien der Quantenmechanik, um komplexe Probleme exponentiell schneller zu lösen. Während heutige Supercomputer bereits enorme Rechenleistungen erbringen, stoßen sie bei Aufgaben wie Materialforschung, Medikamentenentwicklung oder Optimierung globaler Lieferketten an ihre Grenzen. Quantencomputer hingegen versprechen, diese Herausforderungen nicht nur schneller, sondern auch deutlich energieeffizienter zu bewältigen – ein entscheidender Faktor angesichts des weltweit rasant steigenden Stromverbrauchs durch IT-Infrastrukturen.

Neue Horizonte bei der Nachhaltigkeit

Gerade im Hinblick auf Nachhaltigkeit eröffnen sich neue Horizonte: Quantenalgorithmen können den Energieverbrauch in Produktionsprozessen, Logistik oder beim Design neuer Materialien drastisch senken und so einen Beitrag zur Bewältigung des Klimawandels leisten. Unternehmen, die frühzeitig das Potenzial dieser Technologie erkennen und in Pilotprojekte investieren, sichern sich entscheidende Wettbewerbsvorteile. Denn die Integration von Quantencomputing wird nicht nur neue Geschäftsmodelle ermöglichen,

Für Aufsichtsräte und Unternehmenslenker ist es daher unerlässlich, sich jetzt mit Quantencomputing auseinanderzusetzen, Kompetenzen aufzubauen und strategische Partnerschaften zu suchen. Wer zu lange zögert, riskiert, von der nächsten Innovationswelle überrollt zu werden und wertvolles Know-how an Wettbewerber zu verlieren. Die Weichen für die digitale und nachhaltige Zukunft werden heute gestellt –Quantencomputing ist dabei ein Schlüssel, wie unsere Interviewpartner und Autoren deutlich machen.

Apropos Kompetenzaufbau: Digital Business ist stolzer Partner zweier richtungsweisender Plattformen zum Thema: Die Veranstaltung LaFutura x QuantumBasel bringt am 10. und 11. Juni 20 25 Vordenker, Futuristen und Innovationsexperten zusammen, um das transformative Potenzial von Quantencomputing und KI der nächsten Generation zu erkunden. Und am 7. und 8. Oktober 2025 dreht sich auf der Quantum Effects in der Messe Stuttgart alles rund um Quantentechnologien und -lösungen. Der von unserem Magazin mit verliehene Quantum Effects Award 2025 zeichnet besondere Innovationen aus. Über die erfahren Sie bei uns natürlich aus erster Hand

Ich wünsche viel Erfolg auf Ihrem Weg in die Zukunft.

Ihr

HEINER SIEGER, Chefredakteur DIGITAL BUSINESS

heiner.sieger@win-verlag.de

20 Die Kampfansage Freshworks will den Kundenservice neu gestalten und fordert CRM-Giganten wie Salesforce und ServiceNow heraus.

30 Erfolgreiche Strategien für eine sichere Cloud Professionelle Cloud-Security ist komplex. Unternehmen sollten sich auf die wichtigsten Aspekte konzentrieren.

TITEL QUANTENCOMPUTING: KOPFÜBER IN DIE ZUKUNFT

Damir Bogdan, anerkannter Quantencomputing-Experte, erklärt im Interview, weshalb Unternehmen bereits jetzt den Grundstein für den technologischen Sprung in die Zukunft legen sollten.

34 Die Evolution der Automatisierung Moderne KI-Agenten ermöglichen eine neue Dimension der Automatisierung.

44 Balanceakt zwischen Innovation und Sicherheit: Gefahren unvorsichtiger KI-Nutzung

46 Fluch und Segen – KI in der Cybersecurity: Expertentalk

50 Mehrschichtiger Ransomware-Schutz : Die richtige Verteidigungsstrategie

51 Automatisierte Compliance: Continuous Compliance im Finanzsektor

52 Schutz der KI: Strategien gegen Daten Poisoning

54 Rolle der KI in der Cybersecurity: Licht und Schatten der künstlichen Intelligenz

40 Docuware-Interview: „Die Zukunft für Frauen in IT-Berufen sieht sehr rosig aus“

Diverse Teams sind oft erfolgreicher, da sie die Stärken aller Mitarbeiter optimal nutzen.

2025

QUANTENCOMPUTING

06 Kopfüber in die Zukunft Chancen und Hürden von Quantentechnologie

12 Vom Labor in die Praxis Quantencomputing-Strategie bei T-Systems

14 Quantenrechner versus Kryptografie Bedrohung für Verschlüsselungsverfahren

DIGITALE TRANSFORMATION

16 Potenzial für mehr Umweltschutz Refurbishment gegen Elektroschrott

18 Fünf Dimensionen verantwortungsvoller Digitalisierung

Transformation der Energieversorgung

20 Die Kampfansage Freshworks fordert CRM-Giganten heraus

22 Milliardengrab Erreichbarkeit

Viele Unternehmen verschenken unnötig Geld

24 Archivierung: Dokumente frisch halten Abläufe und Prozesse besser steuern

26 So druckt und scannt man sicher IT-Sicherheit beginnt beim Drucker

27 Data Culture für das KI-Zeitalter Die richtige Datenstrategie für Analysen

28 In fünf Schritten zur zur e-Invoicing-Compliance Rechtssichere Umsetzung der E-Rechnung

CLOUD COMPUTING

30 Erfolgreiche Strategien für eine sichere Cloud-Nutzung

Wichtige Aspekte der Cloud-Security KI

32 KI-Agenten –nützliche Helferlein im Kundendienst Großer Mehrwert für Unternehmen

34 Die Evolution der Automatisierung KI-Agenten versus klassischer Automatisierung

36 Kollege KI

Sprach-KI stärkt den Kundenservice und Sales

37 KI-Potenziale verstehen und gezielt heben Integrationsstand von KI-Anwendungen

38 Mit KI-Lösungen die Datenresilienz verbessern Microsoft AI für die Bedrohungserkennung

HR

40 Interview mit Docuware: „Die Zukunft für Frauen in IT-Berufen sieht sehr rosig aus“ Diverse Teams sind häufig erfolgreicher

42 Siemens geht neue Wege Employer Branding zur Fachkräftegewinnung

SECURITY INSIGHT

43 Titel

44 Den Balanceakt zwischen Innovation und Sicherheit meistern Gefahren durch den unvorsichtigen KI-Einsatz

46 KI in der Cybersecurity: Der schmale Grat zwischen Fluch und Segen Expertentalk

50 Mehrschichtiger Ansatz schützt vor Ransomware Die richtige Verteidigungsstrategie

51 Automatisierte Einhaltung der Compliance im Finanzsektor Continuous Compliance für weniger Aufwand

52 Immun gegen Datengift: So schützen Unternehmen ihre KI Strategien gegen Data Poisoning

54 Die Rolle der KI in der Cyber-Security Licht und Schatten der künstlichen Intelligenz

NEWS

55 Frisch ausgepackt

DIGITAL HEALTH

56 Künstliche Intelligenz im Gesundheitswesen kommt in Schwung Digitalisierung als Schlüssel zu mehr Effizienz

58 Entlasten, vernetzen, verbessern Entbürokratisierte Digitalisierung ist kein Luxus

RECHT

60 Die Pläne der neuen Koalition: Datenschutz light, Cybersecurity heavy? Ein Blick auf die wichtigsten Punkte

03 Editorial

61 Marketplace

62 Vorschau

62 Impressum

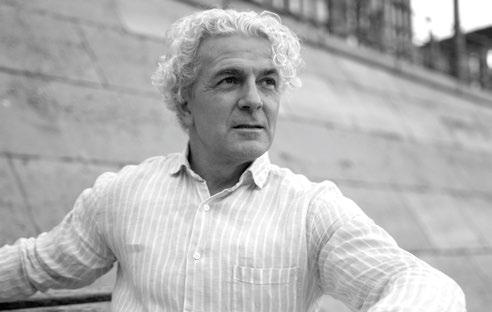

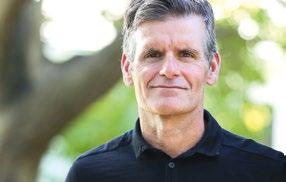

Damir Bogdan, CEO von Quantum Basel, erklärt wie QuantumBasel die neuen Technologien vorantreibt, welche Rolle die Nachhaltigkeit bei der Revolution der Rechenzentren spielt und warum Unternehmer und Aufsichtsräte bereits jetzt den Grundstein für den technologischen Sprung in die Zukunft legen sollten. /// von Heiner Sieger

Herr Bogdan, Sie haben einen äußerst spannenden Berufsweg genommen. Was ist ihr fachlicher Hintergrund?

Damir Bogdan | Ich begann meine Karriere Ende der 80er Jahre als Wirtschaftsinformatiker. Damals arbeitete ich mit alten Mainframe-Systemen. In den 90er Jahren fokussierte ich mich hauptsächlich auf Informatik in der Finanzbranche. Hier war ich in verschiedenen Rollen tätig, von der Leitung komplexer Netzwerkumstellungen bis zur Softwareentwicklung. Ich half beim Aufbau eines Nearshore Development Centers für Schweizer Banken in Südeuropa. Parallel dazu leitete ich Initiativen, die letztlich zur Gründung der Swisscom IT Services führten. Mit rund

DER GESPRÄCHSPARTNER

Transistoren auf Chips werden immer kleiner, und bei sieben Nanometern war eine Grenze erreicht. Hier begann mein Interesse am Quantencomputing, das sich als potenzielle Ergänzung zu traditionellen Rechnerarchitekturen herausstellte, da es die Problemlösungsfähigkeit in exponentiellen Größendimensionen erweitern könnte. Ein Auftrag eines großen multinationalen Kunden führte mich nach Basel, wo ich in die Entstehung des Innnovationscampus uptownBasel eingebunden wurde. Monique und Dr. Thomas Staehelin, die Investoren von uptownBasel suchten jemanden, der die technologische Strategie entwickeln konnte – insbesondere im Bereich Quan-

Damir Bogdan ist CEO von QuantumBasel und ein anerkannter Experte im Bereich Quantencomputing. Er begann seine Karriere als Wirtschaftsinformatiker und sammelte umfassende Erfahrung in der IT-Branche, insbesondere im Finanzsektor. Mit seinem visionären Ansatz fördert er die Demokratisierung von Quantentechnologien und treibt deren Integration in Industrie und Bildung voran.

3000 Mitarbeitenden übernahm ich eine führende Rolle in der Entwicklung neuer Technologien, insbesondere in der Elektronik und im Mobile Commerce. Diese Dinge führten dazu, dass ich zum CIO und später COO der drittgrößten Bankengruppe in der Schweiz ernannt wurde. Dort war ich über zehn Jahre in der Geschäftsleitung tätig.

Wann und wie sind Sie schließlich in die Welt des Quantencomputings eingetreten?

DB | 2014 entschied ich, meinen Fokus auf Innovation zu verlagern. Ich ging ins Silicon Valley, baute eine Unternehmensberatung auf und engagierte mich in der strategischen Beratung von Technologiekonzernen. Der Kontakt mit Start-ups im Valley brachte mich an den Punkt, an dem ich die Grenzen des Moore‘schen Gesetzes bewusst wahrnahm. Die über 30 Jahre geltende Faustregel, wonach sich die Rechenleistung durch Verdoppelung der Transistorenzahl etwa alle 18 Monate steigert, stieß zunehmend an physikalische und technologische Grenzen. Die

tencomputing -, um die Region als Innovationsstandort zu positionieren. Und so begann vor zweieinhalb Jahren meine Reise als CEO von QuantumBasel – der eigens dafür gegründeten Tochtergesellschaft von uptownBasel.

Was ist Quantum Basel und welche Vision verfolgen Sie mit diesem Technologie-Hub?

DB | Quantum Basel ist ein Kompetenzzentrum für Quantencomputing und künstliche Intelligenz, das Innovationen in diesen Bereichen fördert und demokratisieren will. Unsere Vision ist es, den Zugang zu Quantencomputern für Unternehmen weltweit zu erleichtern und die Anwendungen dieser Technologien zu verbreiten. Die Thematik Quantencomputing mag viele Menschen im ersten Moment abschrecken, weil sie komplex wirkt. Deshalb setzen wir auf Aufklärung und Training.

Wo setzen Sie mit Ihrer Aufklärungsarbeit für Quantencomputing an?

© Jessica/stock.adobe.com

DB | Wir arbeiten eng mit Aufsichtsräten und Unternehmensleitungen zusammen, um ihnen verständlich zu machen, welche Auswirkungen das Quantencomputing auf ihre jeweilige Industrie haben könnte. Dabei helfen wir, die richtigen Fragen zu stellen: Warum und wie ist Quantencomputing für meine Branche relevant? Welche Probleme lassen sich damit lösen?

Dafür bieten wir Trainingsformate und Projekte an, schulen bestehende Teams im Bereich Quantum und AI und bereiten neue Mitarbeitende gezielt auf diese Themen vor. Demokratisierung bedeutet für uns auch, Menschen und Unternehmen eine Brücke zu diesen neuen

Wie positionieren Sie sich mit Quantum Basel gegenüber anderen Zentren für Quantencomputing weltweit? DB | Unser Alleinstellungsmerkmal ist die neutrale Positionierung zwischen den verschiedenen Quantencomputing-Architekturen. Im Gegensatz zu vielen anderen Institutionen sind wir nicht darauf beschränkt, nur eine Architektur oder eine bestimmte Technologieplattform zu unterstützen. QuantumBasel ist das einzige europäische Unternehmen, das sowohl Zugang zu Ionenfallen-Computern als auch supraleitenden Systemen anbietet, und das einzige Unternehmen weltweit, das Zugang zu gate-basierten und annealing-basierten Quantencom-

”

Der zunehmende Energieverbrauch, der durch den exponentiellen Einsatz von KI-Technologien entsteht, ist alarmierend. Quantenrechner bieten durch ihren deutlichen geringeren Energiebedarf bei komplexen Rechenoperationen das Potenzial nachhaltigerer Lösungen. (Damir Bogdan)

Technologien zu bauen – ohne dass sie selbst immense Erstinvestitionen tätigen müssen. Daher erhalten sie bei uns Zugang zu verschiedenen Quantensystemen und -architekturen, ohne sich auf eine einzelne Lösung oder Anbieter festlegen zu müssen. Wir pflegen aktive Partnerschaften mit führenden Quanten-Technologieanbietern wie IBM, D-Wave und IONQ sowie weiteren spezialisierten Hardwareherstellern.

Was bewirken diese Partnerschaften?

DB | Diese Partnerschaften sollen sicherstellen, dass wir flexibel auf die schnelllebigen technologischen Fortschritte reagieren und die besten Lösungen für unsere Kunden bereitstellen können. Quantum Basel ist mehr als nur ein Technologie-Hub; wir sehen uns als Enabler, der Unternehmen auf ihrem Weg zu nachhaltigen, technologischen Lösungen begleitet und ihnen hilft, Quantentechnologien in praktikable Geschäftsstrategien umzuwandeln.

putern bietet. Wir können so den besten Ansatz für das jeweilige Problem liefern. Damit bieten wir bei Quantum Basel eine einzigartige und unabhängige Beratung an, um die am besten geeignete Technologie für die spezifischen Herausforderungen unserer Kunden zu ermitteln. Unsere Unabhängigkeit ermöglicht es uns zudem, ein Netzwerk von Partnerschaften zu pflegen, das Zugang zu den neuesten Entwicklungen und der gesamten Bandbreite verfügbarer Hardware bietet.

Kollaborieren Sie auch mit anderen Wissenschaftlern zusammen?

DB | Auf akademischer Seite arbeiten wir eng mit Universitätspartnerschaften und Fachhochschulen zusammen, um die nächste Generation an Quantenfachkräften auszubilden. Diese Zusammenarbeit im Bildungsbereich ist entscheidend, denn der Fachkräftemangel stellt eine erhebliche Herausforderung in unserer Branche dar. Durch die Anbindung an lokale, spezialisierte Ausbildungsan-

gebote bleibt unser Näherungsansatz gewährleistet und sichert den Zugang zu einem talentierten, wissensstarken Nachwuchs.

Neben unseren Kooperationen verstehen wir uns auch als Innovatoren beim Aufbau einer nachhaltigen Technologieplattform. Der Energieverbrauch herkömmlicher Rechnerarchitekturen nimmt exponentiell zu, nicht zuletzt durch die zunehmende Verbreitung von KI-Technologien. Quantenrechner bieten durch ihren deutlichen geringeren Energiebedarf bei komplexen Rechenoperationen das Potenzial für ressourcenschonendere Lösungen. Mittelfristig verfolgen wir das Ziel, das Konzept von Quantum Basel auf andere internationale Märkte zu übertragen und weiterzuentwickeln.

Wie gestalten Sie dabei den Wissenstransfer zwischen den beteiligten Stakeholdern?

DB | Wir arbeiten intensiv daran, unser Angebot an hochmodernen Technologieplattformen weiter auszubauen und zu vermarkten. Dazu gehört die Entwicklung von Plänen für den länderübergreifenden Austausch zwischen Forschenden, Ingenieur:innen sowie der direkte Zugang zu unseren Technologien und Projekten.

Durch die Stärkung dieser Netzwerke, fördern wir den Wissenstransfer und machen Quantencomputing einem globalen Publikum zugänglich. Unser langfristiges Ziel ist der Aufbau eines nachhaltigen, interdisziplinären Ökosystems, das Quantum und AI-Technologien rund um den Globus verknüpft. Dabei legen wir Wert auf die strategische Zusammenarbeit mit Unternehmen und Bildungsinstitutionen, um die Entwicklung neuer Geschäftsmodelle und -lösungen zu beschleunigen. Unser internationales Engagement macht deutlich: Quantum Basel bleibt nicht stehen, sondern entwickelt sich dynamisch weiter, um global innovative Ansätze zu etablieren und zu fördern.

Initiativen zu starten. Dies unterstreicht nicht nur unseren Status als Innovationsführer, sondern zeigt auch den internationalen Bedarf und die Anerkennung, die Quantencomputing weltweit erlangt. Wir wollen regionale Unterschiede und Bedürfnisse berücksichtigen und gleichzeitig die Technologie und das Wissen von Quantum Basel zur Nutzung anbieten. Über die nächsten Jahre hinweg planen wir, diese Strategie auf weitere Länder und Städte auszudehnen, um mit der wachsenden Nachfrage nach Quantenlösungen Schritt zu halten.

Welche konkreten Herausforderungen sehen Sie bei der Integration von Quantentechnologie in bestehende Industrieprozesse?

DB | Die grundlegendste Herausforderung besteht darin, die Relevanz und das Verständnis von Quantentechnologien auf allen Hierarchieebenen eines Unternehmens zu etablieren. Das beginnt häufig mit einer großen Kluft zwischen dem, was technisch möglich ist, und dem, was als geschäftlich umsetzbar und vorteilhaft angesehen wird. Viele hochrangige Führungskräfte haben das Konzept noch nicht vollständig integriert – nicht zuletzt deshalb, weil es eine radikale Abkehr von traditionellen IT- und Rechensystemen bedeutet. Quantencomputer allein werden keine Wunder vollbringen; der Schlüssel liegt darin, die richtigen Anwendungsbereiche zu identifizieren, von der Optimierung über die Simulation bis hin zu maschinellen Lernen.

Stoßen Sie auch auf Hürden bei der Weiterentwicklung und praktischen Implementierung der Technologie?

DB | Ein wesentliches Hindernis ist die Verbreitung von Hypes, die unrealistische Erwartungen schüren. In der Vergangenheit haben überzogene Erwartungen zu Enttäuschungen geführt, als die Technologie ihre Verspre-

” Unser langfristiges Ziel ist der Aufbau eines nachhaltigen, interdisziplinären Ökosystems, das Quantum und AI-Technologien rund um den Globus verknüpft und das auf die aktuellen und zukünftigen Bedürfnisse der Industrie zugeschnitten ist.

Wie gehen Sie bei der Globalisierung des Themas vor und mit welchen Nationen gibt es schon nennenswerte Fortschritte?

DB | Wir bauen Partnerschaften mit verschiedenen internationalen Regierungen und Organisationsstrukturen auf, um Quantum Hubs und Technologiezentren auf der ganzen Welt zu entwickeln. Kürzlich haben wir Verträge mit Telangana in Indien abgeschlossen, um ein AI- und Quanten-Technologiezentrum in Hyderabad zu errichten. Ebenso haben wir Gespräche mit der saudischen Regierung und anderen globalen Partnern geführt, um ähnliche

(Damir Bogdan)

chungen nicht sofort gehalten hat. Wir legen großen Wert darauf, realistische Potenziale aufzuzeigen und Geschäftsfelder zu definieren, in denen Quantentechnologie heute bereits einen klaren Mehrwert leisten kann. Ein weiterer Aspekt ist die Integration in bestehende Prozesse. Wir gehen systematisch und strukturiert vor: Zuerst führen wir strategische Analysen durch, um potenzielle Einsatzbereiche zu identifizieren. Im nächsten Schritt priorisieren wir, wo sich der Einsatz von Quantencomputing kurzfristig lohnt. Sobald wir einen Anwendungsfall validiert haben, setzen wir auf kleine, überschaubare Pi-

lotprojekte zur Validierung und Skalierung. Zusammenarbeit mit Innovationsteams ist dabei entscheidend, um Quantenprojekte zu einem integralen Bestandteil der Unternehmensstrategie zu machen. Dies erfordert Investitionen, nicht nur in Technologie, sondern auch in die Ausbildung der Mitarbeiter und die Schaffung einer Kultur des Experimentierens und Lernens. Schließlich ist die Kompatibilität von Quantencomputern mit bestehenden IT-Infrastrukturen eine kritische Frage. Es handelt sich hierbei um eine hybride Technologie, die nicht als Ersatz, sondern als Ergänzung zu bestehenden Architekturen betrachtet werden sollte. Unternehmen müssen bereit sein, ihre bestehenden Systeme entsprechend anzupassen und Brücken zwischen der klassischen und der neuen Technologie zu schlagen.

Welche konkreten Anwendungen und Erfolge können Sie für das Quantencomputing präsentieren?

DB | Ein bemerkenswertes Beispiel ist die Zusammenarbeit mit dem Konzern Vinci Energies: es wurde mittels eines hybriden Ansatzes eine Simulationstechnologie für die Planung und Optimierung von Heizungs-, Lüftungs- und Klimaanlagen in industriellen Umgebungen entwickelt. Traditionelle Rechner sind häufig ineffizient in der optimalen Lagenberechnung solcher komplexen Systeme – ein Quantencomputer hingegen kann eine Vielzahl von Lösungen parallel prüfen, wodurch eine exaktere und schnellere Berechnung der optimalen Lösungen möglich wurde.

Wir konnten signifikante Einsparungen in Materialund Energieverbrauch sowie eine drastische Verkürzung der Planungsprozesse erreichen. Ein weiteres bemerkenswertes Projekt führten wir mit Pfizer durch, bei dem der Produktionsprozess für Medikamente optimiert wird. Nachdem das bestehende Verfahren bereits KI-optimiert war, gelang es, durch den Einsatz von Quantencomputing die Produktion zusätzlich zu beschleunigen. Das führt zu erheblichen Zeit- und Kostenersparnissen und trägt zur strategischen Ressourcenschonung im Unternehmen bei.

• Qubits:

Die Grundeinheiten von Quanteninformation. Im Gegensatz zu klassischen Bits, die entweder 0 oder 1 sein können, können Qubits viele Zustände gleichzeitig einnehmen (Superposition).

• Mooresches Gesetz:

Beobachtung, dass sich die Anzahl der Transistoren auf einem Mikrochip etwa alle zwei Jahre verdoppelt. Dieses Gesetz ist zunehmend an seine physikalischen Grenzen gestoßen.

Das Tempo macht also den Unterschied?

DB | Einer der großen Vorteile des Quantencomputings ist die Möglichkeit, Aufgaben mit außergewöhnlich hoher Geschwindigkeit auszuführen. In einer zunehmend wettbewerbsorientierten und kostenbewussten Welt ist jede Optimierung ein entscheidender Wettbewerbsvorteil. In der medizinischen Bildverarbeitung ist es uns beispielsweise gelungen, die Effizienz der Krebsdiagnose deutlich zu steigern. Gemeinsam mit dem Start-up Moonlight AI haben wir Algorithmen für Bildverarbeitungsprozesse entwickelt, welche klinische Tests erheblich beschleunigen können, und damit wichtige Konsequenzen für die Diagnose und Therapieansätze eröffneten. Auch hier zeigt sich, dass Projekte, die traditionell langwierig und ressourcenintensiv sind, durch Quantencomputing dramatisch verbessert werden können. All diese Projekte sind Beispiele dafür, wie Quantencomputing nicht nur theoretische, sondern greifbare Vorteile für die industrielle Anwendung bieten kann. Sie manifestieren sich in signifikanten Verbesserungen sowohl effizienter Nutzung der Ressourcen als auch im Hinblick auf Arbeitsabläufe, die in der Industrie von strategischer Bedeutung sind.

Und wie verankern Sie Nachhaltigkeit in all diesen technologischen Entwicklungen?

DB | Nachhaltigkeit ist ein bedeutender Bestandteil unserer Gesamtstrategie und fließt in alle unsere Aktivitäten und Technologieentscheidungen ein. Unsere Quantencomputer verbrauchen deutlich weniger Energie als traditionelle Supercomputer, insbesondere bei rechenintensiven Anwendungen. Zum Vergleich: Ein Quantencomputer benötigt etwa 17 Kilowatt Stunden für seine Leistung. Moderne Supercomputer wie das Modell in Bologna benötigen im laufenden Betrieb bis zu 10 Megawatt Leistung – ein Vielfaches dessen, was Quantencomputer in vergleichbaren Anwendungen verbrauchen . Solche drastischen Einsparungen sind ein wichtiger Schritt hin zu nachhaltigeren Rechenzentren. Darüber hinaus setzt Quantum Basel auf grüne Energie für den gesamten Campus. Ein direkter Anschluss an ein Wasserkraftwerk

• Supercomputer: Hochleistungsrechner mit enormer Rechenleistung, spezifisch für umfangreiche Datenverarbeitungsprozesse und rechenintensive Aufgaben.

• Superposition: Ein grundlegendes Konzept in der Quantenmechanik, das besagt, dass ein Quantensystem in mehreren Zuständen gleichzeitig existieren kann.

• Quanten-Annealer:

Spezialisierte Quantencomputer, die darauf ausgelegt sind, Optimierungsprobleme zu lösen. Im Gegensatz zu universellen Quantencomputern, die ein breiteres Spektrum an Algorithmen ausführen können, konzentrieren sich Quanten-Annealer auf das Finden von minimalen Energiezuständen in komplexen Systemen.

liefert die benötigte Energie, die unter anderem für die Kühlung und den Betrieb unserer Systeme nötig ist. Ebenso machen wir uns die entstehende Abwärme zunutze: Die am Campus entstehende Abwärme wird in das lokale Wärmenetz eingespeist – damit werden mehrere Tausend Haushalte versorgt.

Ein Quantencomputer ist also auch ein EnergiesparWunder?

DB | Ja, und das ist auch dringend nötig: Der steigende Energieverbrauch, der durch den exponentiellen Einsatz von KI-Technologien entsteht, ist alarmierend. Ohne Gegenmaßnahmen wird allein der Energiebedarf von Rechenzentren weltweit mehr als zehn Prozent des globalen Stromverbrauchs ausmachen. Quantencomputing spielt also eine bedeutende Rolle, um KI-Prozesse energieeffizienter zu gestalten und die Rechenressourcen umweltfreundlicher zu nutzen. Ferenc Krausz, der Energieexperte und Physik-Nobelpreisträger von 2023, kommentierte, dass der eigentliche Nutzen des Quantencomputings in seiner Energieeffizienz liegen könnte. Bei allem technologischen Fortschritt dürfen wir unsere Verantwortung für unseren Planeten. Nachhaltigkeit bedeutet für uns daher nicht nur die Reduzierung von Energieverbrauch, sondern auch die Entwicklung eines ökologisch nachhaltigen Technologieansatzes und die Schaffung sozialer Verantwortung.

Sie sprachen zuvor von der Rolle von Bildung und Förderung des Quantenfachkräfte-Nachwuchses. Wie setzen Sie sich dafür ein?

DB | Bildung ist zweifellos einer der wichtigsten Pfeiler für den Erfolg in der Quantenrevolution. Aus diesem Grund haben wir gemeinsam mit der Universität Basel ein Institut für Quantencomputing gegründet, das QC2 (Quan-

haben, um das Curriculum zum Quantencomputing-Studium zu entwickeln. Dies legt den Grundstein für Bachelor- und Masterprogramme und hilft, mehr Studierende in den Bereich zu führen.

Vermutlich operieren Sie im Bereich Nachwuchsförderung auch grenzüberschreitend?

DB | Da sich der Fachkräftemangel in der Quantenindustrie weltweit spürbar ist, geht es uns ebenso darum, neue Lösungen jenseits des klassischen Bildungswegs zu fördern. Wir arbeiten beispielsweise mit internationalen Universitäten zusammen, um ihnen Zugang zu unseren Hardwaresystemen zu ermöglichen. Studierende können verschiedene Architekturen testen und damit praxisnah lernen und wertvolle Erfahrungen sammeln. Quantum Basel bietet auch regelmäßig Stipendien und projektbezogene Fördergelder an, um studentische Forschungsprojekte zu unterstützen. Ein weiteres spannendes Projekt ist die Zusammenarbeit mit Universitäten weltweit, um die Quantenforschung und den Austausch durch interdisziplinäre Veranstaltungen und Hackathons zu fördern. Ziel unseres Engagements ist es, nicht nur die Fachkräfte von morgen auszubilden, sondern auch den Weg zu einer anerkannten, interdisziplinären Forschungsgemeinschaft zu ebnen. Durch die Verbindung von Bildung, Forschung und Unternehmensinteressen legen wir den Grundstein für ein internationales Quanten-Ökosystem, das auf die aktuellen und zukünftigen Bedürfnisse der Industrie zugeschnitten ist.

Und zuletzt, welchen Ratschlag geben Sie Unternehmensführern und Aufsichtsräten in Bezug auf Quantencomputing?

DB | Angesichts der schnellen technischen Entwicklungen im Quantenbereich sollten Unternehmensführer kei-

” Viele hochrangige Führungskräfte haben das Konzept noch nicht vollständig integriert – nicht zuletzt deshalb, weil es eine radikale Abkehr von traditionellen IT- und Rechensystemen bedeutet. Unternehmen müssen bereit sein, ihre bestehenden Systeme anzupassen. (Damir Bogdan)

tum Computing and Coherence Center). Dieses Institut unterstützt aktiv die Entwicklung von Nachwuchstalenten und bietet eine Plattform für innovative Forschung und Zusammenarbeit. Derzeit forschen acht Professoren an einer Vielzahl von Bereichen von Quantencomputing und Quantenphysik bis hin zu Anwendungen. Unser Engagement in der Förderung von Nachwuchstalenten beschränkt sich jedoch nicht nur auf diese Hochschule. Es besteht eine enge Zusammenarbeit mit der Fachhochschule Nordwestschweiz, bei der wir bereits in den ersten Jahren eine Professur für Quantenphysik finanziert

nesfalls weiter warten. Jetzt ist die Zeit zu handeln und sich aktiv mit Quantencomputing auseinanderzusetzen. Wer den technologischen Wandel verpasst, riskiert, in einigen Jahren hinter der Konkurrenz zurückzufallen. Zwei Schritte sind essenziell: Eine sicherheitstechnische Bewertung der aktuellen Systeme und die Entwicklung von Strategien, um Quantencomputing fortan als integralen Bestandteil ihrer digitalen Transformation zu etablieren. Der frühzeitige Einstieg und die laufende Evaluierung technischer Fortschritte sind dann der Schlüssel, um die Wettbewerbsfähigkeit zu sichern. •

Warum nicht jede Aufgabe KI braucht und Effizienz der Schlüssel zur digitalen, grünen Zukunft ist

KÜNSTLICHE INTELLIGENZ GILT ALS SCHLÜSSELTECHNOLOGIE DER DIGITALISIERUNG.

Doch ihr Einsatz hat Folgen: Vor allem große Sprachmodelle verschlingen enorme Rechenleistung und verursachen einen hohen Energieverbrauch. Unternehmen stehen deshalb vor einer entscheidenden Frage: Wo schafft KI echten Mehrwert und wo treibt sie den Ressourcenverbrauch unnötig in die Höhe? Immer mehr Firmen erkennen, dass Nachhaltigkeit in der IT nicht beim Kauf stromsparender Hardware beginnt, sondern bei der Art und Weise, wie Software entwickelt wird. Denn ohne effiziente, bedarfsgerechte Systeme bleibt jede Digitalstrategie lückenhaft sowohl technisch als auch ökologisch.

CodeCamp:N unterstützt Unternehmen aus der Versicherungs- und Finanzdienstleistungsbranche sowie den Mittelstand beim Aufbau digitaler Lösungen und Anwendungslandschaften. Besonderes Augenmerk liegt auf der individuellen Entwicklung moderner Software, die gezielt auf Effizienz ausgelegt sind. Mit durchdachter Architektur, sauberen Codes und der Wahl passender Technologien lassen sich bei gleichbleibender Funktionalität Energieverbrauch, Betriebskosten und Komplexität deutlich reduzieren.

Jede Lösung wird von uns individuell geprüft: Welche Anforderungen bestehen wirklich? Wann sind kleinere, fokussierte Systeme oder klassische Prozessverbesserungen sinnvoller als der Einsatz umfassender KI-Modelle? Der bewusste Einsatz digitaler Mittel macht Nachhaltigkeit für uns zu einem festen Bestandteil jeder digitalen Strategie.

Nachhaltige IT hat zwei Dimensionen: Zum einen die Reduktion des Ressourcenverbrauchs innerhalb der Systeme, etwa durch reduzierte Datenlast, schlanke Softwarearchitektur und passgenaue Infrastruktur. Dieser Ansatz, der den Kern von Green-Efficiency bildet, verbindet Leistungsfähigkeit und Ressourcenschonung und sorgt so für geringere Betriebskosten und langfristige Wettbewerbsfähigkeit. Zum anderen geht es darum, nachhaltige Prozesse durch digitale Lösungen gezielt zu unterstützen, etwa durch Automatisierung, papierlose Workflows oder datenbasierte Entscheidungsfindung.

Nachhaltigkeit messbar machen:

Der CodeCamp:N-Beipackzettel

CodeCamp:N hat den Einsatz nachhaltiger Softwarelösungen zum Prinzip gemacht und setzt Green-Efficiency in Kundenprojekten konsequent um. Dabei stehen performante, langlebige Anwendungen im Vordergrund.

Ein konkretes Beispiel dafür ist der CodeCamp:N-Beipackzettel für Energieeffizienz : Jede von uns entwickelte Lösung wird automatisch damit ausgestattet. Der Beipackzettel zeigt transparent auf, wie viel Energie eine Anwendung verbraucht und wo Einsparpotenziale liegen. Er schafft Orientierung und unterstützt fundierte Entscheidungen in der digitalen Transformation.

Die Vorteile sind klar: Wer frühzeitig auf Effizienz setzt, spart Kosten, erhöht die Stabilität seiner Systeme und verlängert deren Lebensdauer. Nachhaltige Software wird damit zur wirtschaftlich und ökologisch sinnvollen Entscheidung und zu einer tragfähigen Basis für die digitale Zukunft.

Du möchtest wissen, wie nachhaltige Digitalisierung in Deinem Unternehmen umgesetzt werden kann? Melde Dich gerne bei uns.

Kontakt:

CodeCamp:N GmbH

Solgerstraße 18, 90429 Nürnberg Tel.: +49 175 9723518 hallo@codecamp-n.com www.codecamp-n.com/beipackzettel

Dr. Christine Knackfuß-Nikolic, CTO von T-Systems, verfolgt mit ihrem Team eine klare Mission: Quantencomputing als Schlüsseltechnologie der Digitalisierung für Unternehmen nutzbar machen. Im Interview gewährt sie Einblicke in Strategie, Use Cases und Zukunftsperspektiven. /// von Heiner Sieger

Frau Dr. Knackfuß-Nikolic, Sie sind als CTO von T-Systems eng mit dem Thema Quantencomputing befasst. Welche Rolle spielt Quantencomputing aktuell in Ihrer Technologie-Strategie und wie ordnen Sie das Thema im Kontext der Digitalisierung ein?

Dr. Christine Knackfuß-Nikolic | Quantentechnologie ist für uns eine Schlüsseldisziplin, die das Potenzial hat, grundlegende Herausforderungen der Digitalisierung zu lösen. In unserer Strategie nimmt das Thema Quanten deshalb einen zentralen Platz ein. Wir sehen die Technologie als einen enormen Innovationstreiber für Wirtschaft und Gesellschaft und arbeiten daran, diese Potenziale auch für unsere Kunden nutzbar zu machen. Wichtig ist mir das Zusammenspiel von Quantencomputing mit cloudbasierten Diensten, KI und Sicherheitsthemen – erst der integrierte Ansatz schafft einen echten Mehrwert für die Digitalisierung.

T-Systems bietet Kunden bereits heute Zugang zu Quantencomputern über die Quantum Cloud. Wie sieht das konkrete Leistungsportfolio aus?

| Unser Leistungsportfolio umfasst den Zugang zu verschiedenen amerikanischen und europäischen Quantencomputern, inklusive Beratungsdienstleistungen, Trainings und Proof-of-Concepts. Unternehmen können damit ihre eigenen Anwendungsfälle direkt am Quantenrechner testen – ohne in eigene Hardware investieren zu müssen.

rung von Mobilfunkantennen und deren Ausrichtung mit Quantum-inspirierten Rechnern – die Rechenzeit können wir damit von mehr als sechs Stunden auf ein paar Minuten verkürzen. Der Test ist so erfolgreich, dass wir dafür ein Patent angemeldet haben. Ein weiteres Beispiel aus den T-Labs: Wir haben gemeinsam Osram eine Methodik entwickelt, um Baugruppen mit Toleranz Unter- oder Überschreitungen so zu kombinieren, dass weniger Ausschuss und dadurch Kosten entstehen. Die T-Systems begleitet Unternehmen von der Potenzialanalyse über die Entwicklung solcher Proof-of-Concepts bis hin zur Integration in bestehende Geschäftsprozesse. Unser Ziel ist es, den Zugang zu Quantencomputing so niedrigschwellig und praxisnah wie möglich zu gestalten.

Viele Unternehmen stehen noch am Anfang beim Thema Quantencomputing. Wie unterstützt T-Systems diese bei der Vorbereitung auf diese tiefgreifende technologische Transformation?

| Besonders profitieren Industrien, die mit hochkomplexen, variablen Prozessen arbeiten oder große Lösungsräume analysieren, etwa die Automobilbranche, Logistik, Chemie oder das Finanzwesen. Hier gibt es teilweise bereits marktreife Fragestellungen, die mit Quantencomputing oder der Brückentechnologie Quantum-inspired Computing effizienter gelöst werden könnten. Um diese Branchen richtig fit für die Quantentransformation zu ma-

” Nur wenn Quantencomputing in die bestehende IT- und CloudLandschaft integriert wird, können Unternehmen langfristig profitieren. Sicherheitsaspekte und Datenschutz müssen dabei

von Anfang an mitgedacht werden.

Quantencomputing gilt als Schlüsseltechnologie für die Zukunft. Welche realen Use Cases sehen Sie schon heute in der Industrie, und wie unterstützt T-Systems Unternehmen dabei, diese Potenziale zu heben?

| Wir sehen heute konkrete Anwendungsfälle im Bereich Optimierung, etwa bei komplexen und dynamischen Lieferketten, Verkehrssteuerung oder im Finanzwesen. Auch die Materialwissenschaften und der Energiesektor profitieren durch neue Möglichkeiten in der Simulation, etwa bei Batterien oder nachhaltigen Werkstoffen. In der Telekom testen wir beispielsweise die optimale Positionie-

(Dr. Christine Knackfuß-Nikolic)

chen, bieten wir neben technischem Zugang umfassende Trainingskonzepte, Workshops und Beratung an. Unsere Experten unterstützen beim Kompetenzaufbau, identifizieren relevante Use Cases und begleiten Unternehmen bei der Entwicklung und Umsetzung erster Pilotprojekte.

T-Systems verfolgt einen ganzheitlichen Ansatz mit einem 360-Grad-Ökosystem rund um Quantencomputing. Was sind aus Ihrer Sicht die wichtigsten Erfolgsfaktoren, damit Unternehmen von dieser Technologie nachhaltig profitieren können?

DIE GESPRÄCHSPARTNERIN

Dr. Christine Knackfuß-Nikolic ist promovierte Wirtschaftswissenschaftlerin und seit März 2024 Chief Technology Officer (CTO) von T-Systems. In ihrer Funktion verantwortet sie technologische Strategie und Innovationen der T-Systems.

| Der wichtigste Erfolgsfaktor ist der Aufbau eines robusten Ökosystems, das Unternehmen partnerschaftlich begleitet. Dazu gehören offene Schnittstellen, Zusammenarbeit mit Forschungseinrichtungen und Start-ups sowie ein niederschwelliger Zugang zu Technologie und Know-how. Ebenso essenziell: kontinuierliche Weiterbildung und Investitionen in die Digitalisierung von Geschäftsprozessen. Nur wenn Quantencomputing in die bestehende IT- und Cloud-Landschaft integriert wird, können Unternehmen langfristig profitieren. Sicherheitsaspekte und Datenschutz müssen dabei von Anfang an mitgedacht werden. Ein Beispiel so eines Ökosystems ist QUTAC – 14 DAX-Konzerne, die Quantumcomputing von der Forschung in die Anwendung bringen.

Wie bewerten Sie den aktuellen Durchbruch der T-Labs bei der Übertragung verschränkter Photonen über kommerzielle Glasfaser?

| Dieser Durchbruch ist ein Meilenstein, weil er zeigt, dass Quantentechnologien die nächste Evolutionsstufe der sicheren Kommunikation einleiten können. Die Fähigkeit, verschränkte Photonen über kommerzielle Infrastruktur –in diesem Fall unsere Glasfaser – zu transportieren, hebt das Thema Quantenkommunikation auf ein industriell nutzbares Niveau. Für uns ist das ein strategischer Vorteil: Wir positionieren uns als Vorreiter im Bereich Quantenkommunikation und arbeiten am sichersten Netz von morgen mit Quantenkryptografie.

Wie sieht Ihre Kooperationsstrategie aus, um Technologien wie den Qunnect-Ansatz in Geschäftsmodelle zu übersetzen?

| Die Deutsche Telekom setzt bewusst auf eine enge Zusammenarbeit mit Start-ups, Universitäten und Forschungsinstituten. Das umfasst gemeinsame Innovationsprojekte, die Entwicklung von Standards und die Überführung von Forschungsideen in marktreife Anwendungen. Mit Partnern wie Qunnect arbeiten wir daran, neue Quantenkommunikationstechnologien aus dem Labor in die Nutzbarkeit für Firmen zu bringen.

Werfen wir noch einen Blick in die Zukunft: Wie schätzen Sie die Entwicklung der Quantenhardware und -software in den nächsten Jahren ein? Welche technologischen Meilensteine erwarten Sie für die breite industrielle Nutzung?

| Die Entwicklungen in Quantenhardware und -software sind rasant. Wir erwarten, dass die nächsten Jahre weitere Leistungssteigerungen und zunehmend fehlerresistente Quantencomputer bringen. Insbesondere hybride Architekturen, die klassische und Quantencomputer kombinieren, werden sich etablieren. Wichtige Meilensteine sind unter anderem neue Algorithmen für industrielle Anwendungsfälle und standardisierte Schnittstellen, sodass Unternehmen Quantenleistung einfach in bestehende Prozesse integrieren können. In der Software erwarten wir einen Innovationsschub durch quelloffene Plattformen und den zunehmenden Einsatz von KI zur Steuerung und Optimierung von Quantenlösungen.

Und was ist Ihre persönliche Vision: Wann und wie wird Quantencomputing aus Sicht von T-Systems vom Labor zur produktiven Unternehmensanwendung – und welche Etappen stehen bis dahin bevor?

| Meine Vision ist, dass Quantencomputing in den nächsten fünf bis zehn Jahren Teil des regulären IT-Werkzeugsatzes vieler Unternehmen wird. Die entscheidenden Etappen sind: weitere Reife der Hardware, Experimentiermöglichkeiten über sichere Cloudplattformen, Kompetenzaufbau bei Unternehmen sowie die Entwicklung industriebezogener Anwendungen. Der Weg führt uns von der Grundlagenforschung zu konkreten, marktfähigen Lösungen. Die Telekom wird als Innovationspartner Unternehmen Schritt für Schritt begleiten und ihnen helfen, Quantencomputing sicher und gewinnbringend zu nutzen. •

Die überlegene Rechenleistung von Quantencomputern könnte in Zukunft dazu beitragen, spektakuläre Durchbrüche in der Wissenschaft zu erzielen. Gleichzeitig birgt die Möglichkeit, anhand spezieller Algorithmen mathematische Probleme schneller zu lösen, eine Gefährdung aktueller Kryptosysteme. /// von Cindy Provin

BEREITS IN ETWA FÜNF JAHREN KÖNNTE ES SO WEIT SEIN, dass Quantencomputer allgemein verfügbar sind, die so leistungsfähig sind, dass sie heute gängige und als sehr sicher geltende Verschlüsselungsverfahren überwinden könnten. Wenn uns die letzten Jahrzehnte der Digitalisierung eines gelehrt haben, dann dass Technologien, die heute noch als Utopien gelten, sehr schnell sehr real werden können. Als Computer noch ganze Räume füllten, hätte der Gedanke, ein wesentlich leistungsfähigeres Gerät jederzeit in der Hosentasche herumzutragen, mindestens für Irritation gesorgt. Heute nutzen ca. fünf Milliarden Menschen ein Smartphone.

Derart kometenhaft dürfte sich die Verbreitung von Quantenrechnern zwar nicht gestalten, dennoch ist davon auszugehen, dass die Technologie irgendwann auch in die falschen Hände geraten wird. Damit hätten Cyberkriminelle bisher ungeahnte Möglichkeiten.

Realer als man vielleicht denkt

Auf den ersten Blick mag die Bedrohung durch Quantencomputer wie Science-Fiction erscheinen, doch wenn man sich vor Augen führt, wo überall asymmetrische Kryptografie – die besonders gefährdet ist – zum Einsatz kommt, wandelt sich das Bild. Sichere Verbindungen von User zu Website über HTTPS, Ende-zu-Ende-verschlüsselte Messenger-Nachrichten oder digitale Zertifikate, dahinter steckt eine Public-Key-Infrastruktur. Sie kommt auch zum Einsatz, wenn digitale Verträge elektronisch signiert werden. Der Zusammenhang zwischen dem geheimen privaten Schlüssel und dem öffentlichen Schlüssel wird bei der PKI mittels komplexer, schwer umkehrbarer mathematischer Operationen hergestellt. Heute wird dafür gerne die Faktorisierung großer Zahlen genutzt. Die Multiplikation großer Primzahlen ist trivial, während die Primfaktorzerlegung des entstandenen Pro-

” Auf den ersten Blick mag die Bedrohung durch Quantencomputer wie Science-Fiction erscheinen, doch wenn man sich vor Augen führt, wo überall asymmetrische Kryptografie – die besonders gefährdet ist –zum Einsatz kommt, wandelt sich das Bild.

(Cindy Provin)

DIE AUTORIN

Cindy Provin ist CSO bei Utimaco.

Verheerende Angriffe auf digitale Wertschöpfungsketten wären die Konsequenz. Unternehmen müssen also handeln und Vorbereitungen für den sogenannten Q-Day treffen. Damit wird das hypothetische Datum bezeichnet, ab dem kryptografisch relevante Quantenrechner allgemein verfügbar sein könnten.

dukts mit heutiger Technologie nicht in reeller Zeit lösbar ist, sofern man die Zahlen groß genug wählt. Dies könnte sich allerdings durch Quantenrechner ändern. Mit dem Shor-Algorithmus existiert in der Theorie bereits ein spezielles Verfahren, dass sich die Quanteneffekte zunutze macht, um Faktorisierungsprobleme wesentlich schneller zu lösen.

Um auch zukünftig noch Sicherheit im digitalen Raum zu gewährleisten, werden also neue Verfahren benötigt, die so komplex sind, dass sie auch Angriffen mit Quantenrechnern standhalten. Dieses Gebiet wird als Post-Quanten-Kryptografie (PQC) bezeichnet und setzt beispielsweise auf komplexe Vektorprobleme in hochdimensionalen Gittern, um die Verknüpfung zwischen dem öffentlichen und dem privaten Schlüssel herzustellen.

Wie bereitet sich die Wirtschaft vor? Zukünftig werden sich alle Digitalunternehmen mit der PQC-Migration befassen müssen. Tatsächlich damit begonnen hat allerdings lediglich ein Fünftel der Unternehmen, wie eine Umfrage von Utimaco unter mehr als 200 Organisationen in den USA, dem Vereinigten Königreich und Deutschland zeigt. Ein gutes Drittel (34 Prozent) der Teilnehmenden möchte binnen ein bis drei Jahren mit der Umstellung beginnen, 21 Prozent in drei bis fünf Jahren und 8 Prozent in fünf bis zehn Jahren. 17 Prozent der Unternehmen haben noch gar keine Pläne zur Umstellung auf PQC.

Bei diesen Planungen sollten Unternehmen bedenken, dass es sich bei der Umstellung auf PQC um eine großangelegte Transformation handelt. Je nach Situation müssen sie für mehrere kryptografische Anwendungsfälle neue Infrastrukturen etablieren. Unterschiedliche Implementierungen und längere Schlüssel können bestehende Systeme stören. Um keine bösen Überraschungen zu er-

leben, setzt die Mehrheit der Unternehmen (63 Prozent), die aktuell an PQC arbeiten, daher auf einen hybriden Ansatz, der klassische und Post-Quanten-Kryptografie kombiniert. 17 Prozent setzen dagegen vollständig auf PQC.

Post-Quanten-Kryptografie deutlich einfacher in bestehende IT-Infrastrukturen integrieren Nur zwölf Prozent der befragten Unternehmen planen, Quantum Key Distribution (QKD) als zusätzliche Sicherheitsmaßnahme einzusetzen – eine Technologie zum Schlüsselaustausch, die auf quantenphysikalischen Effekten basiert. Mögliche Gründe für die geringe Verbreitung sind der hohe Aufwand für spezialisierte Hardware sowie physikalische Einschränkungen bei der Datenübertragung. Post-Quanten-Kryptografie (PQC) hingegen lässt sich deutlich einfacher in bestehende IT-Infrastrukturen integrieren. Wichtig ist dabei, dass Unternehmen darauf achten, kryptoagile Hardware- oder Kryptografieanbieter zu wählen, damit bei Bedarf problemlos neue, quantensichere Algorithmen implementiert werden können. •

Jedes Jahr gibt es weltweit immer mehr Elektroschrott. Bitter ist das vor allem deshalb, weil es längst eine Lösung dafür gibt: Refurbishment, also die standardisierte Wiederaufbereitung gebrauchter IT-Hardware. Viele Firmen nutzen diese Option aber noch nicht. Dabei wäre es so einfach. /// von Jan Schillinger

LAUT AKTUELLEN ZAHLEN DER EUROPÄISCHEN STATISTIKBEHÖRDE EUROSTAT wanderten 2022 rund fünf Millionen Tonnen ausgedienter Elektro- und Elektronikgeräte aus den 27 EU-Staaten in den Müll. Dazu gehörten alte Waschmaschinen ebenso wie Handys oder Computer. Das sind pro Kopf durchschnittlich 11,2 Kilogramm Elektroschrott pro Jahr. Zum Vergleich: Zehn Jahre zuvor waren es je Person noch 6,7 Kilogramm.

Die Europäische Kommission hat der Wegwerfgesellschaft inzwischen den Kampf angesagt; seit Sommer vergangenen Jahres ist das sogenannte Right to Repair in Kraft. Mit Hilfe der Richtlinie soll es Verbraucherinnen und

DER AUTOR

Recycling vs. Refurbishment Schließlich gibt es in Unternehmen nicht selten alle paar Jahre Hunderte, wenn nicht Tausende Laptops, PCs, Smartphones & Co., die entsorgt und durch neue ersetzt werden. Häufig werden diese Geräte geschreddert und recycelt. Auf den ersten Blick mag das Wort Recycling vielleicht sogar positiv klingen. Tatsächlich gibt es aber eine weitaus nachhaltigere Lösung für eine umweltschonende Entsorgung gebrauchter IT-Hardware.

Die Rede ist vom Refurbishment. Dabei handelt es sich um die standardisierte und zertifizierte Wiederaufbereitung gebrauchter IT-Geräte. Den Assets wird somit ein

Jan Schillinger ist Director Strategy & Corporate Development beim IT-Dienstleister Green IT Solution. Foot: Felix Finger

” Ein Irrglaube, der sich beispielsweise hartnäckig hält, ist die Annahme, Daten könnten von den Geräten nicht revisionssicher gelöscht werden. Dies ist jedoch schlichtweg falsch. (Jan Schillinger)

Verbrauchern leichter gemacht werden, Elektrogeräte reparieren zu lassen. Diese Richtlinie wurde Ende 2024 auch in deutsches Recht überführt – nämlich in Form der Nationalen Kreislaufwirtschaftsstrategie (NKWS).

Diese Maßnahmen sind aus meiner Sicht auf jeden Fall ein Schritt in die richtige Richtung. Was dabei jedoch noch außen vor bleibt, ist, wie auch mehr Unternehmen dazu animiert werden können, umweltschonend mit ihrer gebrauchten IT-Hardware umzugehen. Dieser Aspekt stellt bislang einen blinden Fleck der NKWS dar. Und das, obwohl gerade im Business-Kontext der Hebel für einen ressourcenschonenderen Umgang mit ausrangierten IT-Assets besonders groß ist.

zweites Leben geschenkt, und sie können deutlich länger genutzt werden. Nachhaltig ist das vor allem deshalb, weil der größte Teil der CO2-Emissionen, die mit IT-Hardware einhergeht, bei der Rohstoffgewinnung, der Produktion und dem Transport entsteht. Konkret entfallen auf diese drei Bereiche ganze zwei Drittel der gesamten CO2-Emissionen eines IT-Assets. Sorgt man umgekehrt dafür, dass die Geräte länger im Umlauf sind, müssen automatisch weniger neue Produkte hergestellt werden – was sich wiederum positiv auf die Umwelt auswirkt.

100 Prozent sichere Datenlöschung ist möglich Dennoch schöpfen viele Unternehmen dieses Potenzial

noch nicht aus. Die Gründe dafür sind vielseitig und reichen von Compliance-Gründen bis hin zu mangelndem Wissen über den Refurbishment-Prozess. Ein Irrglaube, der sich beispielsweise hartnäckig hält, ist die Annahme, Daten könnten von den Geräten nicht revisionssicher gelöscht werden. Dies ist jedoch schlichtweg falsch. Ein professionelles Refurbishment ist dazu in der Lage, eine 100 Prozent sichere Datenlöschung zu garantieren und die DSGVO-konforme Datenlöschung auch revisionssicher zu dokumentieren.

Transparenz ist das A und O Gerade im Unternehmensfeld ist diese Verlässlichkeit absolut essenziell, schließlich liegen auf vielen IT-Geräten mitunter vertrauliche Daten vor, die für die weitere Nut-

Jeder einzelne dieser Schritte ist mit viel Arbeit verbunden. Dieser Aufwand ist jedoch notwendig, um Unternehmen ein Maximum an Transparenz zu ermöglichen und so ihr notwendiges Vertrauen zu gewinnen. Denn nur dann werden sich künftig noch mehr Firmen dazu entscheiden, ihre gebrauchte IT-Hardware lieber refurbishen statt recyclen zu lassen. Darüber hinaus sollte es Unternehmen möglich sein, den Refurbishment-Partner vor Ort zu besuchen. Auch diese Maßnahme stärkt letztendlich das Vertrauen und zeigt transparent die zertifizierten Prozesse sowie die Sicherheitsvorkehrungen vor Ort.

Unabhängig davon, dass nach wie vor ein gehöriges Maß an Aufklärung rund um das Refurbishment bei Unternehmen notwendig ist, hat sich der Markt in den vergangenen Jahren stark weiterentwickelt. Damals hatte Refur-

” Den Asstes wird ein zweites Leben geschenkt, und sie können somit deutlich länger genutzt werden.

(Jan Schillinger)

zung der Hardware entfernt werden müssen. Hilfreich ist dabei auf jeden Fall, wenn Firmen den gesamten Prozess des Refurbishments konsequent nachverfolgen können: von der Beauftragung über den Transport zum Refurbishment-Lager bis hin zur Inventarisierung der Ware, einer DSGVO-konformen und revisionssicheren Dokumentation der Datenlöschung sowie einem entsprechenden Reporting.

bished Hardware oftmals noch einen etwas fragwürdigen Ruf – es mangelte an Verlässlichkeit, ob die professionelle Wiederaufbereitung auch tatsächlich funktioniert. Heute hat sich das entscheidend gewandelt und es zeichnet sich bei immer mehr Firmen ab, wie wichtig ihnen das Thema Nachhaltigkeit ist. Daran gilt es anzuknüpfen und noch mehr Unternehmen dazu zu ermutigen, neue Wege mit ihrer gebrauchten IT-Hardware zu beschreiten. •

zuverlässige Messsystem für moderne Rechenzentren

info@pq-plus.de www.pq-plus.de

Ein Kernelement, um die Energieversorgung zu transformieren, ist die Digitalisierung.

Der Gasnetzbetreiber Open Grid Europe erarbeitete anhand eines innovativen Modells, wie er verantwortungsvoll mit Daten und Algorithmen umgehen kann. Herausgekommen sind 84 nachhaltige Initiativen für den Arbeitsalltag im Bereich

Corporate Digital Responsibility. /// von Marcus Schüler

DIE ENERGIEWIRTSCHAFT IST FÜR DEN GRÖSSTEN ANTEIL

DER EMISSIONEN IN DEUTSCHLAND VERANTWORTLICH. Bis 2030 sollen die Treibhausgasemissionen des gesamten Sektors mehr als halbiert werden. Auf dem Weg in eine klimaneutrale Zukunft setzt sich Open Grid Europe (OGE) als einer der führenden Gastransporteure Europas für die Transformation der Energieversorgung ein.

DER AUTOR

Gemeinsame Methode mit messbaren Ergebnissen Basis des sechsmonatigen Projekts war ein von MHP entwickeltes Vorgehensmodell mit den fünf Dimensionen Digital Competence & Inclusion, Green IT, Tech4Good, Privacy und Digital Ethics, die wiederum verschiedene Maßnahmen umfassen. Zu Projektbeginn fand ein Kickoff-Termin bei Open Grid Europe statt, um sich einen

Marcus Schüler ist Associated Partner Artificial Intelligence bei MHP.

”

„Corporate Digital Resonsibility“ erweitert den traditionellen analogen Ansatz der Corporate Social Responsibility und fokussiert sich auf die sozialen Aspekte in einem digitalen, von künstlicher Intelligenz getriebenen Umfeld. (Marcus Schüler)

Zu den zahlreichen Aktivitäten in den Handlungsfeldern Ökologie, Ökonomie und Soziales gehört das Projekt „Corporate Digital Resonsibility“. Es zielt auf die Digitalisierung als ein Kernelement der Transformation ab und ist integraler Teil der Digitalisierungsstrategie. CDR erweitert den traditionellen analogen Ansatz der Corporate Social Responsibility und fokussiert sich auf die sozialen Aspekte in einem digitalen, von künstlicher Intelligenz getriebenen Umfeld. Ziel ist es, sowohl der nachhaltigen und gesellschaftlichen Verantwortung gerecht zu werden als auch den Ansprüchen von Investoren, im Sinne der ESG zu arbeiten.

Überblick über die Best Practices zu verschaffen und die Basis individuell auf das Unternehmen anzupassen. Für die Dimension Digital Ethics wurde beispielsweise definiert, dass sich OGE mit ethischen Risiken und Nebenwirkungen der Digitalisierung auseinandersetzt. Ziel ist eine vertrauensvolle Umgebung für alle Stakeholder:

Mitarbeitende, Investoren, Gesellschaft, Partner und Politik. Die Dimension Privacy & Self-Determination sieht den Schutz der eigenen digitalen Identität vor – damit Mitarbeitende selbstbestimmt handeln und autonom entscheiden können.

Anschließend erarbeitete das Team Themenkomplexe und Initiativen, die sowohl auf Reifegrad und Komplexität als auch auf Relevanz und Potenzial für SDGs, ESG sowie für Stakeholder überprüft und entsprechend gewichtet wurden. Danach erstellte es für die priorisierten Initiativen eine Roadmap. Im letzten Schritt definierte und etablierte es eine CDR Governance, um das Projekt zu operationalisieren. Zuständig ist ein Core Team, das die verschiedenen Dimensionen betreut, sich vierteljährig über Themen wie Statusupdates, Maßnahmen-, Budget- und Kommunikationsplanungen sowie Synchronisierungen mit der IT-Strategie austauscht. So wird sichergestellt, dass die Dimensionen fest in der Unternehmensstruktur und -kultur verankert sind und langfristig wirken.

Mehr als 80 konkrete Initiativen

Insgesamt kamen 19 Themen und 84 Initiativen zusammen, die das gesamte Spektrum einer verantwortungsvollen Digitalisierung abdecken. Jede Initiative wird im Arbeitsalltag als Programm oder Projekt von einem verantwortlichen Owner oder einer Ownerin gesteuert. Sie bilden das CDR-Kernteam und leiten jeweils ein interdisziplinäres Team. Den Vorsitz hat der Leiter IT-Management. Schwerpunkte bilden die Aufgabengebiete Tech for Good, verbunden mit technischen Innovationen und Innovationen für den Gastransport, Green IT, bezogen auf eine nachhaltige Infrastruktur und Arbeitsorganisation, sowie Digital Conclusion & Competence, welches auf den intensiven Aufbau digitalen Know-hows unter Mitarbeitenden abzielt.

Maßnahmen im Aufgabengebiet Tech for Good sind beispielsweise der Einsatz von Drohnen als effiziente und nachhaltige Unterstützung, etwa für Trassenerkundungen in der Leitungstechnik, für Vermessung und Baustellendokumentation sowie die Entwicklung einer Software, mit der die Netzsteuerung den Maschineneinsatz optimieren kann, um so direkte CO2-Emissionen zu reduzieren. Im Gebiet Green IT geht es unter anderem um das Leasen von refurbished Hardware oder in größeren Dimensionen um ein Modernisierungsprogramm der Netzwerktechnologie

Im Bereich „Tech for good” kommen Drohen zum Einsatz, um zum Beispiel Trassenerkundungen und Baustellendokumentationen zu unterstützen.

mit dem ab dem Jahr 2025 der Stromverbrauch um rund 40 Prozent reduziert werden soll. Die prognostizierte jährliche Einsparung entspricht dem Jahresstromverbrauch von rund 25 Vierpersonenhaushalten.

Direkter Einfluss auf den Unternehmenswert Corporate Digital Responsibility ist seit 2023 fester Bestandteil des OGE Nachhaltigkeitsberichts. Erste Programme und Projekte wurden bereits erfolgreich umgesetzt und dienen der Entwicklung zukünftiger Geschäftsmodelle. Dazu gehört eine mit Low Code, sprich ohne traditionelle Programmiersprache entwickelte App namens Shary, die Fahrgemeinschaften zwischen Kolleginnen und Kollegen vermittelt. Dadurch sollen die Emissionen für den Weg zwischen Wohnort und Arbeit reduziert werden. Seit der Veröffentlichung der App 2023 haben sich bereits 100 User registriert und es sind erste Fahrgemeinschaften entstanden. Im Bereich Green IT konnte beispielsweise eine längere Nutzungsdauer von IT-Equipment und Smartphones erreicht werden. Anklang findet auch die „Hacker School“. Hier engagieren sich Mitarbeitende als sogenannte Inspirer ehrenamtlich für Kinder und Jugendliche, speziell für solche aus einem sozioökonomisch benachteiligten Umfeld, und begeistern sie für die IT und das Programmieren. Weitere Änderungen, zu denen das Projekt beigetragen hat: Das Innovationsmanagement mit Fokus auf Digitalisierung ist seitdem fest in der Unternehmensstruktur und -kultur verankert, um Antworten auf die Herausforderungen des Branchenwandels und zukünftige Fragen rund um die Klimaziele zu finden. Green IT ist ein klarer Bestandteil der CDR-Aktivitäten geworden, um Emissionen und der Ressourcenverbrauch mithilfe von Digitalisierung zu senken. Im Bereich Digital Inclusion and Competence wurden neue Netzwerke erschlossen, etwa mit dem Digitalen Campus Zollverein und der RWTH Business School; gemeinsam bieten mit der HySchool eine Weiterbildung zum Thema Wasserstoff an. Insgesamt zahlen die Initiativen auf acht Sustainable Development Goals und vierzehn ESG-Kennzahlen ein. •

Dennis Woodside, CEO von Freshworks, fordert etablierte Giganten wie Salesforce und ServiceNow im CRM- und ITSM-Markt heraus. Mit dem Fokus auf mittelständische Unternehmen und den europäischen Markt will er weiter Marktanteile gewinnen und die Zukunft des Kundenservice neu gestalten. /// von Heiner Sieger

Seit Ihrem Amtsantritt vor drei Jahren haben Sie Freshworks als Herausforderer im CRM- und ITSM-Markt positioniert. Was ist Ihre Strategie, um mit den etablierten Giganten zu konkurrieren?

Dennis Woodside | Freshworks konzentriert sich auf mittelgroße Unternehmen mit etwa 5000 Mitarbeitern, die oft von größeren Anbietern übersehen werden, aber auch große Konzerne. Wir bieten kostengünstige und benutzerfreundliche Lösungen, die bis zu einem Drittel der üblichen Kosten betragen und unkompliziert sind. Freshworks konkurriert auch mit Zendesk, Salesforce und ServiceNow, indem es AI-gestützte Kundenbetreuung und Software für die Mitarbeitererfahrung anbietet.

Wie unterscheidet sich Ihr Ansatz für KI-gesteuerte Lösungen von dem Ihrer Wettbewerber?

um mit Unternehmensriesen wie Salesforce und ServiceNow zu konkurrieren?

DW | Unsere Produkte bieten eine intuitive Benutzeroberfläche und leistungsstarke Automatisierungsfunktionen, die sowohl für kleine als auch für große Unternehmen geeignet sind. Dies ermöglicht es uns, eine breite Palette von Kunden zu bedienen und gleichzeitig wettbewerbsfähig zu sein.

Sie haben ein beachtliches Umsatzwachstum von 22 Prozent im vierten Quartal 2024 erzielt. Welche Schlüsselfaktoren haben diesen Erfolg angetrieben? Und wie planen Sie, dieses Momentum in den wettbewerbsintensiven CRM- und ITSM-Märkten aufrechtzuerhalten?

DW | Der Erfolg von Freshworks beruht auf der Unzufriedenheit von Unternehmen mit ihren bisherigen Dienst-

DER GESPRÄCHSPARTNER

Dennis Woodside ist seit 2022 President und CEO von Freshworks und hat das Unternehmen erfolgreich als Herausforderer im CRM- und ITSM-Markt positioniert. Vor seiner Tätigkeit bei Freshworks war er Vorstandsmitglied bei ServiceNow, CEO von Dropbox und hatte verschiedene Führungspositionen bei Google inne, darunter als Chief Operating Officer von Motorola Mobility.

DW | Unser Ansatz für KI-gesteuerte Lösungen ist darauf ausgerichtet, sowohl die Mitarbeiter- als auch die Kundenerfahrung zu verbessern. Wir setzen KI ein, um Routineaufgaben zu automatisieren und den Unternehmen zu helfen, schneller und effizienter zu skalieren. Unsere KI-Lösungen sind darauf ausgelegt, sofortigen Mehrwert zu bieten und sind einfach zu implementieren. Wir verfolgen dabei einen dreigleisigen Ansatz: Freddy AI-Agent löst sofort Kundenprobleme. Der Freddy AI Copilot: Verbessert die Fähigkeiten und Produktivität der Mitarbeiter durch Vorschläge für Antworten auf Kundenanfragen. Freddy AI Insights ist ein Produkt für Manager, das Fragen zur Geschäftsentwicklung in der eigenen Serviceumgebung beantwortet, ähnlich wie ChatGPT. Diese Lösungen sind kostengünstig, schnell einsatzbereit und out-of-the-box verfügbar.

Freshworks betont die Erschwinglichkeit und Einfachheit seiner Angebote. Wie balancieren Sie diese Prioritäten mit dem Bedarf an fortschrittlichen Funktionen,

leistern und den schnellen Entwicklungen in den KI-Lösungen. Geschwindigkeit und niedrige Kosten sind die USPs von Freshworks. Wir planen, dieses Momentum durch kontinuierliche Innovation und die Erweiterung unserer Produktpalette aufrechtzuerhalten. Zudem werden wir weiterhin in unsere Vertriebs- und Marketingstrategien investieren, um neue Märkte zu erschließen.

Wie wichtig ist der europäische KMU-Sektor für die Wachstumsstrategie von Freshworks im Rahmen dieser Strategie?

DW | Europa macht bereits 40 Prozent des Umsatzes aus, wobei Deutschland der viertgrößte Markt nach den USA, Großbritannien und Indien ist. Freshworks hat mehr als 3000 Kunden in Deutschland, darunter auch den VfB Stuttgart, der jetzt das Pokalfinale erreicht hat. Diese Unternehmen wollen ihre Effizienz verbessern und ihre Kunden besser bedienen, ohne zusätzliche Berater und Experten bezahlen zu müssen. Der europäische

KMU-Sektor ist von entscheidender Bedeutung für unsere Wachstumsstrategie. Diese Unternehmen sind das Rückgrat der globalen Wirtschaft und bieten enorme Wachstumschancen.

Ihr jüngster AI Workplace Report hat gezeigt, dass 42 Prozent der deutschen Mitarbeiter einen Jobwechsel in Betracht ziehen würden, um in Umgebungen zu arbeiten, die KI besser nutzen. Wie nutzt Freshworks diese Erkenntnis, um Unternehmen dabei zu unterstützen, Top-Talente anzuziehen und zu halten?

DW | Freshworks nutzt KI, um das Training neuer Mitarbeiter zu vereinfachen und zu beschleunigen, sowie um

einfache Probleme löst, ohne dass menschliches Eingreifen erforderlich ist. Dies reduziert die Bearbeitungszeit und verbessert die Kundenzufriedenheit. Ein weiteres Beispiel ist Freshservice, das IT-Prozesse automatisiert und die Effizienz der IT-Teams erhöht. Ein konkretes Firmenbeispiel aus Europa habe ich auch:

DPD BeLux hat innerhalb von weniger als zwei Jahren seine veraltete ITSM-Lösung auf Freshservice umgestellt und 63 Mitarbeitende mit dem neuen System ausgestattet. Dies führte zu einer wesentlichen Verbesserung der Effizienz und Produktivität der Mitarbeitenden. Dies spiegelt sich dann in einer 51-prozentigen Steigerung der Mitarbeiterzufriedenheit wider.

Da die Akzeptanz von KI weltweit wächst, welche Rolle sehen Sie für Europa bei der Gestaltung der Zukunft von KI-gesteuerten Geschäftslösungen?

DW | Europa spielt eine führende Rolle bei der Gestaltung der Zukunft von KI-gesteuerten Geschäftslösungen, insbesondere durch seine fortschrittlichen regulatorischen Rahmenbedingungen und die hohe Akzeptanz von Technologie. Europäische Unternehmen wollen ihre Serviceteams verbessern und sicherstellen, dass Servicemitarbeiter und Kunden zufriedener sind.

” Der Erfolg von Freshworks beruht auf der Unzufriedenheit von Unternehmen mit ihren bisherigen Dienstleistern und den schnellen Entwicklungen in den KI-Lösungen. Geschwindigkeit und niedrige Kosten sind unsere USPs. (Dennis Woodside)

die Anzahl langweiliger und anstrengender Fragen zu reduzieren, die Kundenagenten zu Beginn erhalten. Unsere Produkte sind darauf ausgelegt, den Mitarbeitern mehr Zeit für kreative und strategische Aufgaben zu geben, was zu einer höheren Zufriedenheit und Bindung führt.

Generative KI transformiert Arbeitsabläufe in verschiedenen Branchen. Welche spezifischen Beispiele gibt es dafür, wie die KI-Tools von Freshworks Unternehmen dabei helfen, die Effizienz und Kundenzufriedenheit zu verbessern?

DW | Ein Beispiel ist unsere KI-gesteuerte Lösung Freshdesk, die Kundenanfragen automatisch beantwortet und

Wie sehen Sie die zukünftige Entwicklung von künstlicher Intelligenz bei Freshworks, und welche neuen Anwendungsfälle erwarten Sie in den kommenden Jahren?

DW | KI wird derzeit überwiegend dazu genutzt, um Fragen zu beantworten. In Zukunft wird künstliche Intelligenz jedoch zunehmend in der Lage sein, Aktionen im Namen der Nutzer durchzuführen, wie z.B. das Management von Flügen und Reisen – eine Art persönlicher Butler. Freshworks entwickelt seine KI-Angebote in diese Richtung weiter. Mit der Zeit wird KI weit mehr für unsere Kunden und deren Kunden tun können, als nur Fragen zu beantworten. •

Durch nicht angenommene Anrufe verschenken die meisten deutschen Unternehmen jährlich viel Geld. Frank Froux, Geschäftsführer und Gründer der matelso GmbH, erläutert im Interview, warum die telefonische Erreichbarkeit zudem ein unterschätztes Umsatzgrab ist, wie KI helfen kann, den Zustand zu verbessern, und wie die Zukunft des Vertriebs aussehen könnte. /// von Heiner Sieger

Frank, Du hast in Bezug auf die telefonische Erreichbarkeit von Unternehmen eine Zahl errechnet, die einem fast die Schuhe auszieht: 136 Millionen Euro Schaden jährlich durch verpasste Anrufe allein bei den Kunden Deines Unternehmens. Wie ist diese Zahl zustande gekommen?

Frank Froux | Die Berechnung war keineswegs ein Schnellschuss. Ich habe sie rund 25-mal durchgerechnet, weil sie selbst mir Respekt eingeflößt hat. Wir bei matelso wickeln pro Jahr etwa 15 Millionen Telefonanrufe über unsere Systeme ab – alle im Kontext von Online-Marketing-Kampagnen. Das bedeutet, dass ein Marketingverantwortlicher im Vorfeld viel Arbeit investiert hat: In den Aufbau einer Website, in Traffic-Generierung und Conversion-Optimierung. Wir wissen aus unseren Daten, dass rund 26 Prozent dieser Anrufe nicht entgegengenommen werden. Wenn man konservativ mit einem Wert von 70 Euro pro Lead rechnet – und zur Sicherheit noch 50 Prozent abzieht, um etwaige Streuverluste zu berücksichtigen –, ergibt sich eine gewaltige Summe: 15 Millionen Anrufe x

26 % x 70 Euro x 0,5. Das ergibt jährlich einen „Cashburn“ von 136 Millionen Euro – nur bei unseren Bestandskunden.

Gibt es bestimmte Unternehmensgrößen oder Branchen, die besonders von diesem Problem betroffen sind?

FF | Es wäre naheliegend, das Problem nur bei kleinen oder mittelständischen Unternehmen zu vermuten. Aber das ist ein Trugschluss. Entscheidend ist nicht die Größe, sondern ob in der Organisation ein Customer Care Center, ein Callcenter oder ein Business Development Center strukturell verankert ist. Ist das nicht der Fall, sind Erreichbarkeitsprobleme vorprogrammiert. Selbst große Weltkonzerne mit Tausenden Mitarbeitenden und internationalem Vertrieb sind betroffen – etwa im Maschinenund Anlagenbau. Mir fällt dabei immer wieder auf: In großen wie in kleinen Organisationen gibt es Datenschutz-, Sicherheits- oder Gleichstellungsbeauftragte – aber niemanden, der für Erreichbarkeit verantwortlich ist. Genau dort beginnt das Problem.

DER GESPRÄCHSPARTNER

Frank Froux

ist Gründer und Geschäftsführer der matelso GmbH aus Kaiserslautern. Seit mehr als 25 Jahren ist er als Unternehmer, Entwickler und Vordenker im Tech-Sektor aktiv. Als Pionier im Call Tracking verknüpft er Marketing und Telekommunikation zu messbaren Erfolgslösungen. Mit matelso verwaltet er Millionen von Telefonnummern und setzt auf zukunftsfähige hybride Kommunikationsmodelle.

MEHR ERFAHREN

Hier geht’s zum Podcast mit Frank Froux.

” „Erreichbarkeit ist kein Nice-to-have – sie entscheidet über Umsatz oder Verlust.“ (Frank Froux)

Wie hat sich die telefonische Erreichbarkeit im Zuge der Digitalisierung verändert?

FF | Die Digitalisierung hat uns Flexibilität gebracht –aber auch neue Herausforderungen. Heute arbeiten viele mobil: vom Homeoffice, vom Zug, von wechselnden Standorten. Was sie jedoch selten mitnehmen, ist der klassische Telefonapparat auf dem Schreibtisch. Und viele Unternehmen nutzen immer noch stationäre On-Premise-Telefonanlagen – teils sogar standortübergreifend unterschiedliche Systeme. Diese Systeme liefern keine Echtzeitdaten. Will ein Marketingverantwortlicher wissen, wie viele Anrufe eingegangen und wie viele verloren gegangen sind, stößt er an Grenzen: Man braucht spezielle Administrator-Zugänge, technisches Know-how und oft viel Geduld. Die Folge: schlechte Erreichbarkeit bleibt lange unentdeckt – und teuer.

Was ist aus technologischer Sicht nötig, um das zu ändern?

FF | Zentral ist der Umstieg auf eine Cloud-basierte Lösung. Nur so lassen sich Anrufdaten konsolidieren und über Standorte hinweg analysieren. Cloud-Plattformen ermöglichen modernes Routing, automatische Verteilung von Anrufen und eine klare Sicht auf die Erreichbarkeit. Damit das funktioniert, müssen Daten aus verschiedenen Quellen – Webseiten, Landingpages, Online-Kampagnen – intelligent miteinander verknüpft werden. Das verhindert beispielsweise, dass auf einer Website eine Rufnummer angezeigt wird, obwohl im Callcenter gerade niemand eingeloggt ist.

Wie stark ist das Thema „Daten“ mit der Frage der Erreichbarkeit verbunden?

FF | Ohne eine solide Datengrundlage ist jede Optimierung reines Bauchgefühl. Zwei Silos dominieren aktuell das Marketing: Einerseits die Welt der Webseiten und Kampagnen, andererseits die Welt der Telefonie. Diese Welten sind in vielen Unternehmen strikt getrennt. Das führt zu absurden Situationen: Telefonnummern werden ausgespielt, obwohl niemand erreichbar ist – vergleichbar mit einem Chat, der sofort antwortet: „Wir sind leider nicht da.“ Wir bei matelso setzen uns dafür ein, dass solche Disconnects überwunden werden – mit smarten, datengetriebenen Lösungen, die Öffnungszeiten, Verfügbarkeit und Besucherströme dynamisch berücksichtigen.

Kommen wir zur künstlichen Intelligenz: Welche Rolle spielt sie in der Zukunft der Erreichbarkeit?

FF | Eine entscheidende – aber nicht in allen Bereichen sofort. Wir beschäftigen uns in unserem Labor intensiv mit KI-Telefonbots. Unser Ziel: Ein automatisierter Erstkontakt per Telefon, der ein Grund-Servicelevel sicherstellt. Aber zwei Herausforderungen sind noch ungelöst: die Latenz, also wie schnell eine KI antwortet – im Telefongespräch zählt jede Sekunde – und das domänenspezifische Wissen. Ein Bot muss den „thematischen Fingerabdruck“ eines Unternehmens verstehen – seine Produkte, Preise, Prozesse. Außerdem braucht er Schnittstellen zu Kalen-

dern oder ERP-Systemen, um z.B. Termine buchen oder einen Bestellstatus abfragen zu können. An genau diesen Punkten scheitern viele Lösungen derzeit noch.

Gibt es konkrete Entwicklungen aus Ihrem „Labor“, die schon heute funktionieren?

FF | Ja, wir arbeiten an hybriden Modellen: Mensch und KI im Zusammenspiel. Ein Beispiel: Unsere KI analysiert live den sogenannten Halluzinations-Grad – also wie wahrscheinlich es ist, dass sie gerade Blödsinn erzählt. Sobald ein bestimmter Schwellenwert überschritten wird, wird der Dialog an einen Menschen übergeben. So können wir Qualität und Effizienz miteinander verbinden. Gleichzeitig bieten wir auch klassische Service-Center-Dienstleistungen an – mit echten Mitarbeitenden hier in Kaiserslautern, die im Namen unserer Kunden Telefonate oder Chats übernehmen. Gerade in Spitzenzeiten oder bei fehlendem Personal ist das ein wertvoller Zusatzservice.

Wie lässt sich all das mit dem Marketing verknüpfen –insbesondere in Bezug auf die Customer Journey und den ROI?

FF | Hier kommt unser Kernbereich Call Tracking ins Spiel. Call Tracking liefert nicht nur Transparenz über die Erreichbarkeit, sondern auch über die Performance einzelner Marketingkanäle. Unternehmen investieren viel Geld in Google Ads, Social Media oder Display-Werbung. Mit Call Tracking erkennen sie, welcher Kanal wie viele qualifizierte Leads liefert – auch telefonisch. Das erlaubt eine präzisere Budgetsteuerung und verbessert die Customer Journey.

Wie wird sich die Kommunikation zwischen Unternehmen und Kunden in den nächsten Jahren verändern?

FF | Wir denken Kommunikation nicht mehr kanal-getrennt, sondern als dialogorientierten Prozess. Unsere Plattform entwickelt sich zu einem System, das sogenannte „Dialogmarketing-Strecken“ automatisiert abbildet. Ein Beispiel: Am Monatsanfang wird ein Brief verschickt, wenige Tage später folgt eine E-Mail, dann eine SMS – bis hin zu einem automatisierten Outbound-Call oder einem QR-Code auf einer Weinflasche. Ziel ist immer: einen qualifizierten Termin mit dem Kunden zu generieren. Die Verbindung von KI, klassischer Telekommunikation und generativer Content-Produktion erlaubt es, solche Kampagnen intelligent und individuell zu gestalten. Wir glauben, dass dieser vernetzte, medienübergreifende Ansatz die Zukunft des Vertriebs ist.

Was sollten Unternehmen jetzt tun, um nicht den Anschluss zu verlieren – ganz konkret?

FF | Erstens: Das Thema Erreichbarkeit ernst nehmen und eine zuständige Person benennen – ein „Erreichbarkeitsbeauftragter“. Zweitens: Eine cloudbasierte Plattform einführen, die alle Anrufe erfasst und analysiert. Drittens: Daten und Prozesse so verknüpfen, dass echte Handlungsfähigkeit entsteht. Nur wer weiß, wann und wo Anrufe verloren gehen, kann sinnvoll reagieren – und bares Geld sparen. •

Dokumentenaufbewahrung ist mehr als eine Pflicht. Richtig aufgesetzt – digital und in der Cloud – steigert ein Archiv die Effizienz bei Bezahlprozessen und Buchhaltung.

Wie sich dieser Weg Schritt für Schritt gehen lässt, zeigt das Beispiel des Tiefkühl-Spezialisten Bofrost. /// von Christoph Nordmann

DIE DIGITALE TRANSFORMATION BRINGT KOMPLEXE

HERAUSFORDERUNGEN MIT SICH. Historisch gewachsene IT-Strukturen, Datensilos und Insellösungen stehen integrierten Prozessen im Weg. Das betrifft auch das Dokumentenmanagement. Gerade das Archiv wurde lange Zeit stiefmütterlich und als reine Pflichtaufgabe behandelt. Wer Archivsysteme gezielt einsetzt, kann interne Abläufe und Prozesse besser steuern und die Effizienz im laufenden Betrieb kontinuierlich steigern. Gerade Cloud-basierte Lösungen eröffnen hier neue Spielräume, ohne bewährte Strukturen sofort aufgeben zu müssen.

So auch bei Bofrost. Das Unternehmen mit Sitz am Niederrhein ist europäischer Marktführer, wenn es um den Direktvertrieb von Tiefkühlkost geht. Allein in Deutschland zählt der Händler mehr als zwei Millionen Haushalte zu seinen Kunden und liefert Eiscreme, Gemüse, Fleisch, Fisch direkt an die Haustür. In Europa sind es knapp 4 Millionen Kunden. 1966 gegründet, blickt Bofrost heute auf insgesamt 254 Niederlassungen, an denen knapp 11.000 Mitarbeitende in ganz Europa arbeiten. Der jährliche Umsatz beläuft sich auf mehr als 1,47 Milliarden Euro.

einige große Projekte an, wobei Bofrost schon früh in entsprechende Plattformen investiert hat. So führte das Unternehmen 2006 für Deutschland und einige weitere europäische Standorte SAP als ERP-System ein. Die Lösung zielte zunächst hauptsächlich darauf, Aufgaben im Finanzbereich digital aufzustellen und zu optimieren. Schnell wurde das System um eine Archivlösung ergänzt, um die SAP-Belege revisionssicher speichern zu können. Dabei entschied sich Bofrost für Easy archive for SAP des deutschen DMS-Experten Easy Software. Die On-Premises-Version läuft seitdem auf den Firmenservern des Unternehmens und sorgt für eine reibungslose Archivierung bei minimalem Aufwand.

Unterbrechungsfreie Lösung für den Point of Sales Im Jahr 2018 startete Bofrost mit den Planungen, die Point-of-Sale-Geräte (PoS) auszutauschen. Ziel war es, die Systeme in den etwa 3.000 Auslieferfahrzeugen auf den neuesten digitalen Stand zu bringen. Als größte Herausforderung erwies sich dabei die digitale Infrastruktur in Deutschland: Nach wie vor gibt es schwarze Flecken, die nicht ausreichend mit breitbandigem Internet versorgt

” Gerade das Archiv wurde lange Zeit stiefmütterlich und als reine Pflichtaufgabe behandelt. (Christoph Nordmann)

Auf Digitalisierungs-Kurs

Aus IT-Sicht bringt eine solch lange Erfolgsgeschichte spezielle Herausforderungen mit sich. Historisch gewachsene Strukturen und dezentrale Prozesse und Systeme müssen im Zeitalter der digitalen Transformation stärker zusammengezogen werden, um Synergien zu schaffen und die Effizienz zu verbessern. Bei Bofrost zum Beispiel arbeiteten die Gesellschaften in den einzelnen Bundesländern lange Zeit sehr eigenständig, um die jeweiligen Anforderungen auf dem Markt besser erfüllen zu können. Im Zuge der Expansion in Europa und der wachsenden Digitalisierung arbeitete der Direktvertreiber derzeit jedoch daran, die Dienste in Deutschland stärker zu zentralisieren und die Geschäftsentwicklung ganzheitlich voranzutreiben. Auch für die IT stehen damit in den nächsten Jahren