Éditorial

par Alexandra Giannopoulou

Un nombre considérable d’interactions et de relations quotidiennes entre les individus, les entités publiques et commerciales se sont délocalisées en ligne, désormais relayées par des infrastructures technologiques numériques. Ces nouvelles formes d’interaction et d’engagement mutuel dans le domaine numérique émergent à une échelle et à un rythme sans précédent. Au sein des recherches qui explorent, analysent et critiquent les effets négatifs des systèmes informationnels et technologiques sur les individus, émerge également une discussion sur les injustices et inégalités systémiques. Ainsi, des points de vue et des propositions alternatives visant à contrer ces préjudices systémiques, provoqués ou amplifiés par les systèmes technologiques et informationnels, gagnent en importance dans les espaces de débats politiques, universitaires, communautaires et de la société civile contemporaines.

Cet ensemble d’essais explore les interrelations entre la numérisation, la datafication et les droits fondamentaux. Cette transformation numérique offre, selon la Commission européenne, « de nouvelles possibilités de rendre les droits fondamentaux plus effectifs, mais elle s’accompagne aussi de défis »1. À travers ces essais, nous invitons le lecteur à se pencher sur l’importance de la protection des droits fondamentaux dans la sphère numérique, ainsi que sur le rôle crucial de la Charte des droits fondamentaux de l’Union européenne (Charte de l’UE) dans la lutte contre les oppressions, les préjudices et les injustices systémiques qui semblent encodés dans les technologies existantes. Le potentiel émancipateur de la Charte de l’UE en tant que moyen de résistance aux biais technologiques et à l’oppression est au cœur de ces essais.

La Charte de l’Union européenne, rédigée au tournant du millénaire, constitue un jalon important dans instruments juridiques contraignant qui définissent le cadre européen des droits de l’homme. Elle vient s’ajouter à d’autres instruments internationaux et européens relatifs aux droits de l’homme, tels que la Déclaration universelle des droits de l’homme (DUDH), la Convention européenne des droits de l’homme (CEDH), une série d’instruments spécifiques à certains domaines, ainsi que les constitutions nationales et les « déclarations des droits ».

La Charte est contraignante pour les institutions de l’UE ainsi que pour les États membres lorsqu’ils agissent dans le cadre de la législation de l’UE. Elle peut donc s’assurer de combler les lacunes existantes dans les cadres nationaux et internationaux en matière de protection des droits de l’homme et offrir un niveau de protection accru. Avec l’entrée en vigueur du Traité de Lisbonne, la Charte est devenue un instrument juridiquement contraignant, ayant la même valeur juridique que les Traités de l’UE. La Charte se profile désormais comme la principale voie de recours en matière de droits fondamentaux, car elle peut offrir aux individus des possibilités tangibles de faire respecter directement les droits fondamentaux qu’elle consacre devant les tribunaux, y compris dans le cadre de la réglementation des relations entre acteurs privés.

Toutefois, dans la pratique, il a été démontré que « les références à la Charte sont formelles, déclaratoires, voire décoratives et combinées avec des références à la CEDH, sans distinction »2. Il apparaît donc clairement que le potentiel de nombreuses dispositions de la Charte n’a pas encore été exploité.

La multitude de droits et de libertés consacrés par la Charte des droits fondamentaux lui confère l’image d’un instrument moderne de protection des droits de l’homme à l’ère du numérique. C’est le seul instrument juridique international contraignant qui mentionne clairement le droit à la protection des données, distinct du droit au respect de la vie privée. Comme en témoigne la jurisprudence et les commentaires abondants, les articles 7 et 8 de la Charte de l’Union européenne apparaissent comme des droits fondamentaux autour desquels s’articulent la plupart des affaires relatives aux droits numériques. Cependant, les essais inclus dans cette série démontrent qu’il existe de nombreux autres droits et libertés de la Charte qui sont ou peuvent servir de base solide pour les contentieux en matière de droits numériques.

Le potentiel de la Charte pour la protection des droits numériques s’étend au-delà des droits fondamentaux classiques pour englober une série d’autres droits et libertés qui – face à la numérisation et à la datafication continues des tâches et de la vie quotidiennes – sont susceptibles de revêtir une importance et une utilité croissantes dans la sphère numérique. Ces droits et libertés, au même titre que tous les droits de l’homme, sont conçus pour défendre les valeurs de l’Union européenne et l’État de droit et, in fine, pour protéger les individus et les groupes contre l’injustice, le traitement discriminatoire et la marginalisation. Cependant, dans le domaine numérique, ces abus sont de plus en plus fréquents, notamment en raison de l’utilisation de l’intelligence artificielle (IA), de l’accès aux biens et services numériques et leur fourniture (parfois sélective), de l’émergence et l’expansion de modèles commerciaux et de revenus basés sur l’extraction de données et de la dépendance croissante des entités publiques et privées à l’égard des processus de prise de décision basés sur la technologie.

De nombreux cas analysés dans cette série d’essais illustrent des préjudices directs et soulignent l’impact des violations des droits fondamentaux causées par des systèmes technosociaux invasifs. La compilation d’articles visant à mettre en évidence le lien entre les droits fondamentaux et les droits numériques est en fin de compte une tentative d’aborder l’héritage du pouvoir dans le contexte des technologies numériques, ainsi qu’une opportunité de fournir une critique sur la valeur des protections des droits fondamentaux dans certains contextes ou environnements.

Abordant des questions à forte charge idéologique, ces essais ne peuvent prétendre à l’universalité, mais tentent plutôt d’identifier des domaines clés où l’impact des technologies numériques sur les droits fondamentaux est ou peut rapidement devenir visible. Nous avons invité des auteurs de divers horizons juridiques, politiques, universitaires et autres, qui explorent des questions telles que la numérisation des procédures d’asile, la liberté d’expression et la modération de contenu, l’égalité et la non-discrimination algorithmique, la protection sociale et les services publics numériques en général à l’ère du numérique, la négociation collective et les travailleurs des plateformes. Les essais inclus dans cette série présentent un éventail de discours juridiques, sociaux et technologiques, tout en partageant tous une approche commune visant à consolider la pensée critique qui soutient l’importance des protections des droits fondamentaux dans les systèmes de technologies numériques. Nous espérons que ce numéro spécial inspirera une réflexion plus approfondie, plus critique et plus nuancée sur les droits fondamentaux dans le domaine numérique, à mesure que nous nous efforçons d’obtenir le respect de la protection des droits numériques.

1 Communication de la Commission au Parlement européen, au Conseil, au Comité économique et social européen et au Comité des régions, « Stratégie visant à renforcer l’application de la Charte des droits fondamentaux dans l’Union européenne », COM(2020) 711 final, 2 décembre 2020, p. 2.

2 J. Adams-Prassl & M. Bobek, « Introduction » in M. Bobek & J. Adams-Prassl (dir.), The EU Charter of Fundamental Rights in the Member States, Hart Publishing, 2022, p. 7.

Anna Mazgal, Directrice exécutive de Wikimédia Europe

Introduction

L’article 11 sur la liberté d’expression et d’information est ancré dans le paradigme européen du discours ouvert et libre qui privilégie la prise de risque en permettant aux individus de communiquer librement, voire de franchir les limites de l’acceptable sans être soumis à une censure préventive. Ce paradigme repose également sur la conviction selon laquelle, dans l’exercice de ce droit, les citoyens peuvent avoir besoin d’une protection spéciale contre les tentatives de l’État de contrôler la dissidence. Le paysage de la communication en ligne est principalement constitué de plateformes qui servent d’intermédiaires. Cela représente à la fois un défi pour l’exercice de notre liberté d’expression et un besoin d’étendre la protection de la liberté d’expression aux entreprises et à leurs machines algorithmiques de modération des propos. Cet exercice s’accompagne de compromis.

En Europe, l’échange d’informations accéléré par Internet pose un défi à la fois aux utilisateurs et aux législateurs en raison de la nécessité d’appliquer un équilibre proportionné et approprié de tous les droits susceptibles d’être affectés par la modération de l’information en ligne. Malgré que les législateurs aient développé des cadres juridiques visant à éliminer les discours illégaux, les utilisateurs, en particulier les communautés racisées et queers, sont les plus touchés. Ces discours préjudiciables deviennent souvent eux-mêmes une forme de censure, car ils représentent une forme de suppression au moyen d’un musellement violent1. Pour ces raisons, il est nécessaire d’assurer une protection solide des formes légales d’expression, non seulement à travers la suppression d’interférence, mais également par le biais d’obligations positives de la part de l’État2

La quantité d’informations produites, divulguées et échangées à travers les plateformes d’intermédiation dépasse de loin la capacité humaine de traitement. Les législateurs européens ont donc choisi de confier aux intermédiaires d’Internet, ou plateformes, le soin de décider au jour le jour de ce qui est autorisé ou pas dans le cadre de leurs services. C’est ainsi qu’un système privatisé de contrôle de la liberté d’expression en ligne a vu le jour.

Le code fait loi, tout comme les conditions d’utilisation

Un examen rapide de la législation qui a vu le jour dans l’UE au cours des cinq dernières années démontre clairement que les conditions générales d’utilisation (CGU) des plateformes en ligne sont devenues essentielles dans la mise en place de cadres de gouvernance relatifs à la réglementation de la liberté d’expression. Ces obligations contractuelles entre une plateforme intermédiaires et ses utilisateurs, notamment lorsqu’elles émanent de contraintes juridiques, créent un écosystème d’application privée en ligne.3 Les plateformes doivent par exemple intégrer dans leurs CGU les exceptions au droit d’auteur mentionnées dans la Directive sur le droit d’auteur dans le marché unique numérique (Directive sur le droit d’auteur). L’article 17 confère à un utilisateur le droit d’utiliser une œuvre protégée par le droit d’auteur d’une tierce personne ou d’y faire référence, par exemple à des fins de citation, de critique, de revue, de caricature, de parodie ou de pastiche. Parallèlement, ce même article soumet à une obligation de modération du contenu en vertu de laquelle les plateformes peuvent recourir à la modération automatisée du contenu chargé afin de faire respecter la protection des droits d’auteur. Cette obligation transforme les CGU en un cadre propice à un équilibre entre les droits contradictoires d’un titulaire de droits et d’un utilisateur bénéficiant d’une exception au droit d’auteur, garantissant ainsi la liberté d’expression et l’élimination des contenus illégaux. De même, le règlement relatif à la lutte contre la diffusion des contenus à caractère terroriste en ligne (TERREG) contraint les plateformes à inclure dans leurs CGU des dispositions relatives à l’utilisation abusive de leurs services par la diffusion de propagande terroriste (article 5 (1)). Cela signifie que la mise en œuvre des dispositions légales dans leurs systèmes internes et leur application sont laissées à l’appréciation des plateformes. Bien que cela soit logique du point de vue de la liberté d’entreprise, le pouvoir de décision en matière de qualification des contenus terroristes incombe alors entièrement à une entreprise privée.

En vue de limiter les risques de débordement de la surveillance des contenus, les législateurs obligent les plateformes à appliquer des « mesures spécifiques » en tenant compte des droits fondamentaux des utilisateurs en matière de liberté d’expression et d’information (article 5 (3) (c)). Cette pratique découle d’un cadre normatif spécifique qui souligne l’importance de garantir le respect des droits fondamentaux au sein des grandes plateformes privées : au niveau mondial, les Principes directeurs relatifs aux entreprises et aux droits de l’homme adoptent de tels objectifs. Ces principes sont directement mentionnés dans le considérant 12 d’une autre réglementation européenne de référence, la législation sur les services numériques (DSA).

L’impact de ces cadres normatifs est difficile à estimer en l’absence de recherches fondées sur des données probantes.

La DSA apparaît comme un renforcement remarquable de la liberté d’expression, car elle stipule que le système interne obligatoire de traitement des plaintes peut être utilisé non seulement pour des plaintes contre des décisions spécifiques d’une plateforme, mais aussi contre des violations des droits fondamentaux.4

L’Œil de Sauron

Qu’exige-t-on exactement des plateformes en ce qui concerne l’élimination des contenus indésirables ? Dans le cas de TERREG et de la Directive sur le droit d’auteur, l’accent est mis sur la garantie de l’indisponibilité du matériel illégal. Ces deux actes juridiques prévoient un ensemble de mesures visant à garantir le retrait ou le blocage des contenus illégaux. Il est à noter que tout au long du processus législatif, les dispositions imposant aux plateformes d’utiliser des outils algorithmiques pour passer au crible tous les contenus à la recherche d’ éléments illégaux ont été considérées comme extrêmement controversées dans le cadre de chacun de ces actes juridiques européens. Dans le cas de la Directive sur le droit d’auteur, l’article 17 a suscité une opposition véhémente de la part de la société civile et un certain nombre de manifestations dans les rues. En signe de protestation, les versions espagnole, italienne et polonaise de Wikipédia ont été désactivées 5 L’utilisation d’un logiciel pour faire correspondre les chargements avec une base de données de contenus illégaux (dans les cas tant des droits d’auteur que de la propagande terroriste) est semblable à un contrôle de sécurité dans un aéroport : l’objectif est de « scanner » les contenus illégaux, mais la machine dévoile tous les contenus qui la traversent. Selon les opposants à l’introduction de ces systèmes, la simple existence de tels systèmes les rend propices aux abus. Dans TERREG comme dans la Directive sur le droit d’auteur, le langage utilisé pour ces mesures est marqué par la périphrase : alors que la Directive sur le droit d’auteur mentionne « leurs meilleurs efforts […] pour garantir l’indisponibilité d’œuvres et autres objets protégés spécifiques », TERREG décrit des « mesures techniques » qui doivent être liées à des « mesures appropriées et efficaces […] notamment en matière de surveillance et de vérification humaines ».

Le TERREG et la Directive sur le droit d’auteur, respectivement, obligent ou permettent aux plateformes de faire recours au filtrage de contenu. Les algorithmes utilisés pour le filtrage des contenus par ces plateformes sont tous propriétaires, de sorte qu’il est difficile de se prononcer sur leur efficacité réelle, leur précision et leur capacité à comprendre le contexte. C’est pourquoi la surveillance humaine est d’une importance capitale. Toutefois, compte tenu des pratiques connues en matière de vérification humaine du contenu par les plateformes, telles que la très courte durée des délais d’évaluation du contenu et la faible connaissance du contexte culturel et social par les modérateurs,6 il est difficile de dire si elle peut être effectuée de manière efficace.

Le chiffrement pourrait devenir la prochaine victime de cette approche généralisée qui s’apparente à une stratégie de gestion des risques selon laquelle il vaut mieux tout examiner pour repérer les contenus illicites en ligne. La proposition de règlement établissant des règles en vue de prévenir et combattre les abus sexuels sur les enfants impose aux plateformes l’obligation d’analyser les communications privées de tous les utilisateurs, y compris celles qui sont protégées par un chiffrement. Bien que la sécurité et le bien-être des enfants sont d’une importance capitale, le « contrôle des discussions» proposé a été fortement critiqué par la société civile, le Contrôleur européen de la protection des données ainsi que le gouvernement allemand.7

Les plateformes interviennent dans différents domaines d’application des limitations de la liberté d’expression. Par exemple, les blocages de virement ont privé Wikileaks de 95 % de ses revenus lorsque PayPal, Mastercard et Visa ont cessé d’accepter les dons, sans qu’aucune procédure judiciaire n’ait jamais été engagée à l’encontre de Wikileaks.8 Plus récemment, le Conseil de l’UE a suspendu les licences de diffusion de Russia Today (RT) France (entre autres) dans l’ensemble de l’UE, invoquant une propagande excessive et une distorsion des faits, devenues une menace pour la sécurité internationale après l’invasion de l’Ukraine par la Russie. Bien que la décision ait été approuvée par le Tribunal de l’Union européenne, certains experts estiment que cette mesure manquait de légitimité et n’était pas proportionnée, car elle ne concernait pas seulement le contenu illégal, mais aussi la capacité à fournir un accès à des informations qui n’étaient pas illégales.

Un Internet nouveau et propre ?

Il semble que l’effort législatif conjoint pour éliminer les contenus illégaux porte un coup à la liberté d’expression. L’exercice du droit à la liberté d’expression en ligne ne peut se faire que si l’on s’exprime soi-même. Par conséquent, tout outil algorithmique qui filtre de manière préventive notre discours en ligne au moment de son chargement constituera une violation directe de l’article 11 de la Charte.

L’exercice d’équilibrage fondé sur des concepts politisés tels que la sécurité et la sûreté publiques, d’une part, et le secret d’entreprise sur les technologies propriétaires, d’autre part, crée une législation qui est scrutée à travers le monde et copiée dans des régions qui ont un bilan désastreux en matière de protection des droits de l’homme et des libertés. Des décisions telles que l’interdiction de diffusion de RT France constituent un précédent extrêmement dangereux en Europe, où de nombreux États membres sont confrontés à la montée de l’autoritarisme et au mépris de l’État de droit, et où de telles décisions peuvent être prises à l’encontre des médias – et des projets communautaires, tels que Wikipédia –qui fournissent des informations vérifiées et permettent un débat public.

Nous devons nous interroger sur l’impact de ces mesures générales de prévention sur notre liberté d’expression. Il convient également de se demander si leur unique objectif est de débarrasser Internet de toute difficultés et de toute complexité, ainsi que des séquelles passées et actuelles des injustices systémiques et de l’impérialisme européen.

La réglementation récemment adoptée tente d’apporter des garanties dans le contexte de l’approche généralisée et standardisée de la police de la parole, notamment par le biais de lignes directrices sur les mécanismes de plainte et l’obligation d’inclure les droits fondamentaux dans les CGU. Les communautés racisées et queers, les immigrés et les réfugiés, ainsi que d’autres groupes victimes d’une oppression systémique, sont confrontés à des obstacles qui ne seront pas levés par cette réglementation. En nous contentant de ces garanties, nous risquons de refléter une opinion plutôt choquante émise par Voltaire lorsqu’il écrivit : « On n’a jamais prétendu éclairer les cordonniers et les servantes ». Enfin, l’opacité des algorithmes et l’amplification algorithmique créent une bulle qui renforce la désinformation et les contenus qui divisent l’opinion publique. Ce sont les caractéristiques du modèle commercial basé sur la surveillance, qui privilégie le droit au respect de la vie privée, au détriment de notre liberté d’expression. Ni les actes juridiques susmentionnés, ni aucun autre – y compris la législation sur les marchés numériques – ne s’attaque à la cause des problèmes actuels en matière de liberté d’expression .Face à l’inaction de la législation européenne,, il convient de se demander si l’introduction des droits de l’homme dans les relations entre entreprises et clients ne légitime pas au passage l’existence d’un capitalisme de surveillance, aussi bénéfiques que soient les nouvelles règlementations qui contraignent les entreprises à respecter les droits de l’homme.

“La Charte se profile désormais comme la principale voie de recours en matière de droits fondamentaux, car elle peut offrir aux individus des possibilités tangibles de faire respecter directement les droits fondamentaux qu’elle consacre devant les tribunaux, y compris dans le cadre de la réglementation des relations entre acteurs privés.”

Romain Lanneau, chercheur à Statewatch

L’article 18 de la Charte des droits fondamentaux de l’Union européenne (la Charte) garantit le droit d’asile, mais ne l’accorde pas automatiquement à tous les demandeurs. En revanche, la Charte stipule que toute personne a droit à un examen de sa demande de protection internationale conformément au droit international et au droit de l’UE.1 Ce principe est renforcé par l’article 19 de la Charte, qui interdit strictement les expulsions collectives ainsi que le renvoi, l’expulsion ou l’extradition de toute personne « vers un État où il existe un risque sérieux qu’il soit soumis à la peine de mort, à la torture ou à d’autres peines ou traitements inhumains ou dégradants. »2

Au cours des deux dernières décennies, les procédures d’asile au sein de l’UE ont été de plus en plus imprégnées de technologies numériques. La plupart de ces évolutions ont été initiées dans le but de contrôler et de surveiller les demandeurs d’asile ainsi que d’empêcher leur arrivée dans l’UE. Cependant, certaines initiatives de la société civile se sont également efforcées d’exploiter les technologies numériques dans le but d’aider les demandeurs d’asile à remplir leurs demandes3 ou de les protéger contre les refoulements 4

Malgré leur importance, les droits numériques dans le contexte des procédures d’asile sont souvent négligés par les praticiens du droit, les demandeurs d’asile eux-mêmes et les acteurs de la société civile. Ces droits sont rarement considérés comme prioritaires, surtout lorsqu’ils sont confrontés à un risque de détention ou d’expulsion. Cependant, la volonté des autorités de renforcer le déploiement et l’utilisation des technologies numériques, des données et de l’intelligence artificielle (IA) n’a pas faibli, et ce dans le double objectif de limiter l’entrée des demandeurs d’asile sur le territoire de l’UE et d’évaluer les demandes de ceux qui en déposent une. En conséquence, le droit d’asile est désormais inextricablement lié aux technologies numériques. Cet essai vise à explorer la relation complexe entre ces deux concepts et à examiner comment les droits numériques peuvent être mis à profit dans la protection des droits des demandeurs d’asile.

Le droit à la vie privée : Protéger les

demandeurs d’asile

contre les technologies invasives et la « pseudoscience »

L’article 7 de la Charte garantit le droit au respect de la vie privée, protégeant les individus contre les intrusions injustifiées, inutiles et disproportionnées dans leur vie privée.5Ce droit peut toutefois être restreint par les autorités publiques conformément au principe de proportionnalité énoncé à l’article 52 6 Au sein de l’UE par exemple, tous les demandeurs de passeport sont obligés de fournir leurs empreintes digitales aux autorités afin de permettre une identification plus précise,7 même s’il « n’est pas déterminant » que cette méthode « ne soit pas totalement fiable ».8

Dans le cadre des demandes d’asile, la protection de la vie privée est d’autant plus cruciale, car les autorités s’efforcent souvent d’amasser le plus d’informations possible sur chaque demandeur. Cette préoccupation est d’autant plus importante qu’il est désormais possible d’accéder à d’énormes volumes de données numériques sur les individus. La plus haute juridiction de l’UE a d’ailleurs estimé que la prévention de l’entrée illégale sur le territoire de l’UE constitue un objectif d’intérêt général.9 Cette position oblige les demandeurs d’asile à compromettre leur vie privée pour avoir une chance d’obtenir une protection. La question qui se pose alors est de savoir dans quelle mesure les autorités peuvent être autorisées à fouiller dans la vie privée d’un demandeur d’asile.

La vérification de l’identité et de la véracité des récits des demandeurs d’asile est un élément essentiel du processus d’évaluation des demandes. Si certaines caractéristiques de l’identité – comme les empreintes digitales – sont relativement faciles à vérifier, d’autres sont plus difficiles à confirmer, à l’instar de l’âge et l’identité sexuelle. Il apparaît souvent impossible de valider par des documents l’affirmation d’un demandeur d’asile selon laquelle il est mineur ou qu’il s’identifie comme homosexuel, bien que ces informations puissent avoir un impact significatif sur l’issue de sa demande, le déroulement des entretiens et son hébergement.

Les autorités publiques ont longtemps cherché un test définitif qui permettrait de séparer le bon grain de l’ivraie. Avant l’intervention de la Cour de justice de l’Union européenne (CJUE) en 2014, les demandeurs d’asile étaient parfois soumis à des questions intrusives et humiliantes dans le cadre de la validation de leurs récits. Par exemple, les autorités néerlandaises incitaient fréquemment les demandeurs d’asile à fournir leur propre vidéo pornographique lors de leurs entretiens, comme preuve de leur prétendue orientation sexuelle. Bien qu’il s’agisse officiellement d’un choix, l’avocat général Sharpston

“La Charte se profile désormais comme la principale voie de recours en matière de droits fondamentaux, car elle peut offrir aux individus des possibilités tangibles de faire respecter directement les droits fondamentaux qu’elle consacre devant les tribunaux, y compris dans le cadre de la réglementation des relations entre acteurs privés.”

“...le droit d’asile est désormais inextricablement lié aux technologies numériques...”

a émis « de sérieux doutes quant à savoir si un demandeur, qui est la partie vulnérable dans la procédure de demande d’octroi du statut de réfugié, peut réellement être censé avoir donné un consentement parfaitement libre et éclairé aux autorités nationales dans de telles circonstances »,10 en particulier compte tenu de la dynamique de pouvoir en jeu. La CJUE a finalement aboli cette pratique dans sa décision ABC, citant des atteintes à la dignité humaine (article 1 de la Charte) et au droit à la vie privée (article 7).11

Dans leur quête d’un moyen de distinguer les demandeurs légitimes, les autorités d’asile nationales ont eu recours à des méthodes pseudo-scientifiques, assimilables à la recherche d’un sérum de vérité.12 En 2018, dans le cadre de l’affaire F c. Hongrie, l’utilisation de « tests de personnalité projectifs » pour déterminer la sexualité des demandeurs a été particulièrement controversée. La CJUE a déclaré qu’un tel test « ne pourra être admis que si celui-ci est fondé sur des méthodes et des principes rigoureux, reconnus par la communauté scientifique internationale ».13 Dans le cadre de l’évaluation de la sexualité d’un individu, les tests projectifs de personnalité sont loin de répondre à ces critères. La Cour a également souligné dans sa décision que le « consentement n’est pas nécessairement libre, étant de facto, imposé sous la pression des circonstances dans lesquelles se trouvent les demandeurs de protection internationale ».14

Au cours des dernières années, des tribunaux nationaux ont été saisis de cas où les autorités chargées des demandes d’asile ont sollicité les téléphones des demandeurs15 afin d’extraire et d’analyser des données stockées à la recherche de preuves susceptibles de soutenir les allégations des intéressés. En Allemagne, un tribunal a jugé cette pratique illégale, à moins que des solutions moins intrusives aient été envisagées. Les juges ont clairement indiqué que l’utilisation des nouvelles technologies doit être à la fois nécessaire et adaptée à l’objectif visé.16

À l’avenir, il est plausible que les autorités aient recours à l’IA pour vérifier l’identité d’une personne.17 Toutefois, les assertions selon lesquelles les technologies de vision artificielle peuvent déterminer la sexualité d’une personne évoquent davantage la pseudoscience qu’elles n’offrent de garanties crédibles. La réglementation sur l’IA de l’UE, actuellement en cours de négociation, n’aborde ni ne prévient de manière adéquate contre les préjudices potentiels liés à l’utilisation de l’IA dans le contexte des migrations 18 Par conséquent, les défis juridiques fondés sur le droit à la vie privée resteront cruciaux pour définir les limites des pratiques numériques acceptables dans le cadre des procédures d’asile.

Le droit à la protection des données individuelles : Une condition préalable à un recours effectif contre la prise de décision automatisée et semi-automatisée

L’UE a mis en place un ensemble complexe de bases de données19 destinées à identifier toutes les personnes qui cherchent à entrer au sein de l’UE. Ces systèmes d’information sont destinés à aider les autorités migratoires et policières à prendre des décisions concernant les personnes, telles que leur droit d’entrée ou de séjour dans l’attente d’une décision en matière d’asile.20 L’article 8 (2) de la Charte confère à toute personne dont les données ont été collectées par une autorité européenne le droit à la protection des données individuelles. Cela inclut le droit d’accéder aux données stockées à leur sujet et de rectifier ou d’effacer toute donnée incorrecte.21

Les demandeurs d’asile sont progressivement contraints à livrer des informations personnelles détaillées. Dans sa version la plus récente, le système Eurodac recueillera les images faciales et les informations personnelles de demandeurs d’asile (et d’autres ressortissants étrangers) âgés d’à peine six ans.22 Les autorités nationales collectent et échangent massivement les données personnelles des individus, qui n’en ont généralement pas conscience jusqu’à ce que ces données servent de base à une décision concernant leur cas.

Bien que la multiplication des bases de données nouvelles et élargies puisse faciliter la prise de décision, elles ne sauraient constituer la seule source d’information pour une décision concernant les demandes d’asile. En 2006, dans l’affaire Espagne c. Commission, la CJUE a statué que les autorités ne devraient pas prendre de décisions automatisées fondées uniquement sur des informations stockées dans un système d’information européen. Les décisions doivent reposer sur une évaluation individuelle de la situation du demandeur, y compris une évaluation des motifs légaux de refus d’entrée.23

Néanmoins, la pratique consistant à refuser l’entrée et à expulser des personnes perçues comme présentant un risque pour la sécurité nationale persiste. Les États concernés manquent souvent de transparence quant aux motifs de ces décisions. En 2020, la CJUE a précisé qu’une personne a le droit d’obtenir un minimum de motifs pour le refus d’entrée dans l’Union. L’article 47 de la Charte24, qui consacre le principe de l’égalité des armes, exige des autorités nationales qu’elles divulguent le nom de l’État à l’origine du partage des informations ayant servi de base à la décision, ainsi que les motifs spécifiques de l’évaluation des risques. Cette divulgation permet aux demandeurs d’exercer un recours effectif contre la décision.25 De même, en vertu de l’article 8 (2) de la Charte, le droit d’accès sert de « garde-fou permettant aux personnes concernées de poursuivre leur action »26, telles que demander la suppression ou la rectification d’accusations injustifiées qui ont une incidence sur leur droit à un procès équitable.

Malgré ces dispositions, l’accès à l’information est loin d’être uniformément respecté par les États membres. Bien trop souvent, les demandeurs d’asile découvrent que des preuves « secrètes » sont utilisées contre eux. Dans certains cas, c’est le pays duquel une personne demande l’asile qui fournit les données sur lesquelles les autorités fondent leur décision.27 Même si l’échange de données avec un pays tiers doit respecter les normes de protection de l’UE,28 y compris l’interdiction d’utiliser des informations obtenues sous la torture, dans la pratique, cela ne fait pas l’objet d’un contrôle adéquat 29

Depuis la mise en œuvre du dernier règlement sur les systèmes d’information30 et du règlement Europol31, le risque que les autorités nationales s’appuient sur des données inexactes ou illégales a été amplifié. Néanmoins, les normes de protection des données pour les demandeurs d’asile s’avèrent bien moins strictes que celles dont bénéficient les citoyens de l’UE. Le récent scandale du « Traitement des données personnelles pour l’analyse des risques » (PeDRA - Processing of Personal Data for Risk Analysis), dans lequel Frontex a proposé la collecte de données personnelles intrusives, violant de manière flagrante les droits de protection des données, en est un exemple32. Dans le même temps, le Contrôleur européen de la protection des données (CEPD) a affirmé que les règles régissant l’agence sont vagues en ce qui concerne les « conditions ou limites du partage des données avec d’autres agences, États et pays tiers, ainsi que les recours disponibles pour les individus ».33

Comme l’a souligné le CEPD, « la vie privée et la protection des données font partie des droits de l’homme trop souvent suspendus aux frontières de l’Union européenne ».34 Cette affirmation met en évidence un thème récurrent dans la réglementation en matière d’asile, de migration et de frontières, illustrant la tendance à considérer certains groupes de migrants comme des problèmes de sécurité et ne méritant pas les protections accordées aux citoyens ou à d’autres catégories de ressortissants étrangers 35

Droits d’asile numériques : Un appel à des garanties accrues dans le contexte de la numérisation des procédures

Les technologies publiques sont souvent utilisées par les autorités dans la perspective d’améliorer l’efficacité et d’atténuer ou d’éliminer les biais dans la prise de décision humaine. Cependant, des études sur l’impact de ces technologies montrent souvent des effets contraires.36 Les questions de discrimination et de racisme persistent, mais elles s’enchevêtrent dans la complexité des systèmes techniques. Il est donc de plus en plus difficile de déterminer quand et comment se produisent les violations des droits.

Les négociations législatives en cours au sein de l’UE visent à étendre l’utilisation des technologies numériques dans les procédures d’asile et de migration. Néanmoins, ces négociations ouvrent également des perspectives de renforcement de la protection de la vie privée. La proposition de règlement relatif à l’examen des demandes d’asile pourrait permettre de renforcer la protection du droit à la vie privée des demandeurs d’asile. Cet objectif peut être atteint grâce à l’inclusion d’un mécanisme indépendant conçu pour contrôler la protection des droits fondamentaux des personnes lors de leur identification par les autorités frontalières. Toutefois, ce règlement doit encore être approuvé, et il relèvera en fin de compte de la compétence de l’Agence des droits fondamentaux et des États membres dans le cadre de leurs juridictions respectives, afin de clarifier la procédure de ce nouveau mécanisme.37

Dans les années à venir, la numérisation des procédures d’asile et d’immigration devrait s’accentuer. Il est donc primordial de renforcer la compréhension de la vie privée, de la protection des données et des autres droits numériques parmi les demandeurs d’asile, les migrants et les activistes de la migration, les professionnels du droit et les organisations non gouvernementales.

Jens Theilen, Université Helmut Schmidt, Hambourg

Inégalités numériques et historiques

Dans son livre Peau noire, masques blancs, le philosophe et révolutionnaire anticolonialiste Frantz Fanon décrit ce qu’il appelle le « regard blanc » (« white gaze ») et ses implications: « Car le Noir n’a plus à être noir, mais à l’être en face du Blanc. […] La connaissance du corps est une activité uniquement négatrice. C’est une connaissance en troisième personne. »1 Plus d’un demi-siècle plus tard, le récit de Fanon trouve un écho étrange dans les expériences de Joy Buolamwini, chercheuse noire au MIT Media Lab. Alors qu’elle travaillait sur un projet qui consistait à projeter des masques numériques sur son reflet, elle s’est rendu compte que la technologie de reconnaissance faciale qu’elle utilisait ne pouvait pas détecter suffisamment les contours de son visage à moins qu’elle ne porte un masque blanc. La juxtaposition par Fanon de la peau noire et des masques blancs dans le titre de son livre prend ainsi un sens littéral inattendu. Buolamwini a appelé ce phénomène le « regard codé » (« coded gaze »): une forme de biais algorithmique aux effets discriminatoires. On en observe un exemple dans l’utilisation des logiciels de reconnaissance faciale par les forces de l’ordre, où une identification erronée peut entraîner une surveillance et des arrestations accrues.2 Dans une publication ultérieure en collaboration avec Timnit Gebru, Buolamwini a analysé trois classificateurs commerciaux de genre. L’analyse a révélé que « les sujets masculins étaient classés avec plus de précision que les sujets féminins », que « les sujets à la peau claire étaient classés avec plus de précision que les sujets à la peau foncée » et que « tous les classificateurs avaient les pires performances pour les sujets féminins à la peau foncées ».3

Le parallèle entre le concept de « regard blanc » de Fanon et celui de « regard codé » de Buolamwini montrent clairement que les structures oppressives telles que le racisme et le (cis)sexisme restent centrales dans les environnements numériques. Internet n’a pas instauré un espace utopique exempt d’inégalités, et il serait illusoire de placer nos espoirs dans la technologie en tant que solution facile aux problèmes sociétaux. À l’inverse, il n’est pas non plus judicieux de considérer les inégalités numériques comme des problèmes entièrement nouveaux, apparus uniquement avec les avancées technologiques. Elles sont en réalité enracinées dans des pratiques historiques de surveillance et de traitement des données qui ont longtemps été utilisées comme outils d’esclavage, de colonialisme, de patriarcat et d’autres formes de domination. Comme l’a dit Simone Browne, spécialiste de la surveillance: « La surveillance n’est pas une nouveauté pour les Noirs. C’est le fait de l’antiblackness » ». Elle met en garde contre le fait de considérer la surveillance comme « un phénomène récent apparu avec les nouvelles technologies telles que la reconnaissance faciale automatisée ou les véhicules autonomes sans conducteur (ou les drones) », et affirme qu’elle est continue, permanente et profondément ancrée dans le racisme, l’antiblackness et d’autres pratiques, performances et politiques oppressives.4 Les inégalités numériques ne sont que la continuité des inégalités historiques.

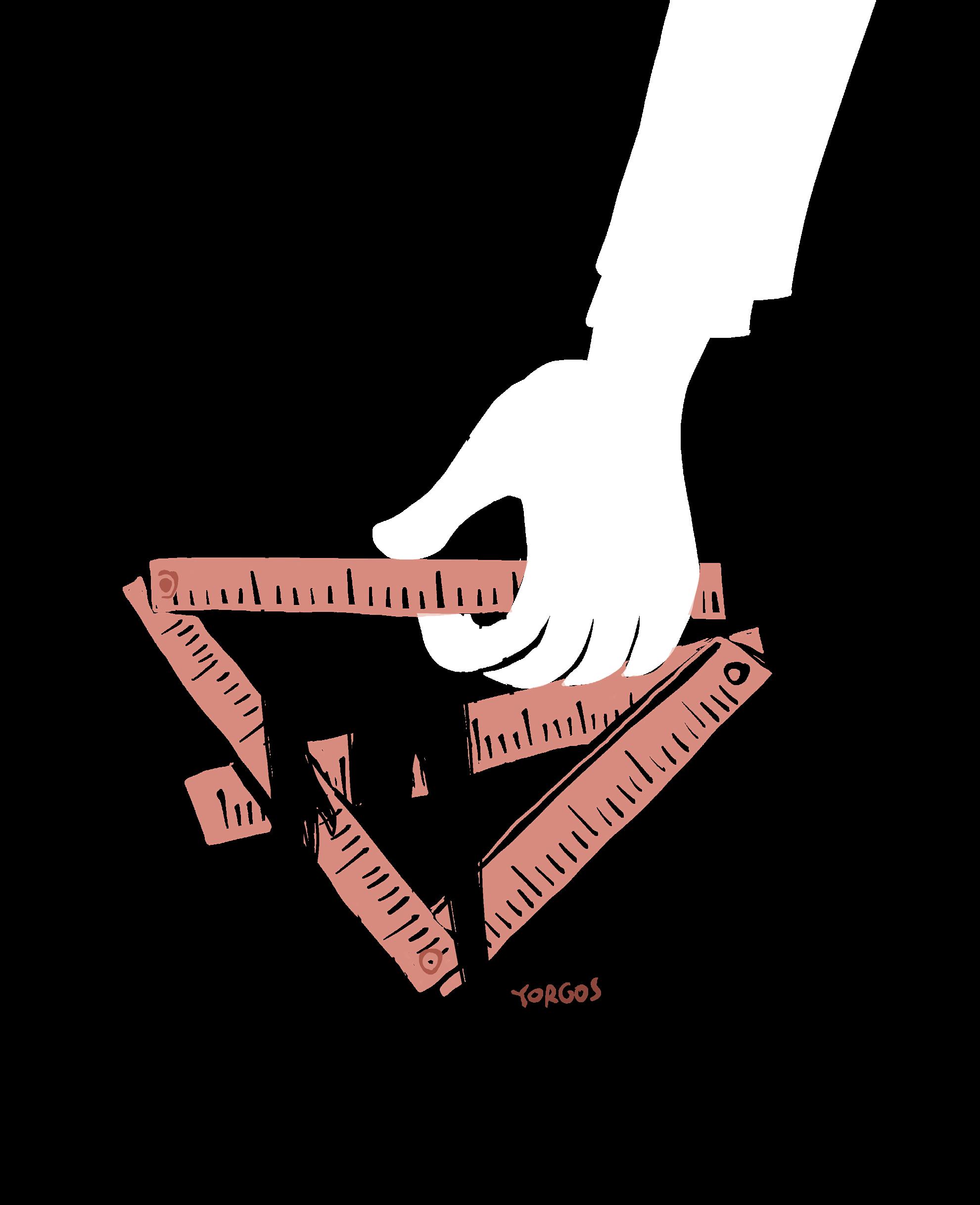

La promesse d’égalité

Face aux inégalités sous toutes ses formes, le droit fait la promesse d’égalité. L’article 20 de la Charte des droits fondamentaux de l’Union européenne (UE) (« la Charte ») exprime cette promesse de façon concise: « Toutes les personnes sont égales devant la loi ». Cette formulation très générale prend une forme plus concrète dans la clause de non-discrimination de l’article 21 (ainsi que dans divers actes de droit dérivé), qui interdit toute discrimination fondée sur une longue liste, non limitative, de motifs, dont le sexe, la race, la religion, le handicap, l’âge ou l’orientation sexuelle. La nécessité de telles listes montre clairement que si l’égalité et la non-discrimination sont aujourd’hui largement acceptées comme des idéaux abstraits, dans la pratique, leur promesse n’est toujours pas tenue. Un nombre décourageant d’exemples atteste que cela vaut pour les contextes numériques et l’utilisation des nouvelles technologies: la politique prédictive qui cible de manière disproportionnée les personnes de couleur et les populations défavorisées; les discours de haine sur les réseaux sociaux visant les personnes queers, les femmes, et en particulier les femmes transgenres et les femmes de couleur; la discrimination des femmes sur le marché du travail basée sur des décisions algorithmiques; les stéréotypes racistes et sexistes reflétés dans les résultats des moteurs de recherche en ligne; ainsi que bien d’autres exemples.5

Le décalage entre l’idéal et la réalité met en lumière des possibilités d’amélioration: nous pouvons utiliser la promesse d’égalité pour lutter contre les inégalités, y compris leurs manifestations dans le domaine numérique. À cet égard, les clauses d’égalité et de

“...les inégalités (sont) enracinées dans des pratiques historiques de surveillance et de traitement des données qui ont longtemps été utilisées comme outils d’esclavage, de colonialisme, de patriarcat et d’autres formes de domination...”

non-discrimination de la législation européenne recèlent un potentiel inexploité considérable, d’autant plus qu’elles s’appliquent aussi bien aux acteurs privés qu’aux organismes publics. Depuis toujours, les droits fondamentaux et les droits de l’homme sont dirigés contre l’État, mais ne contraignent pas – du moins pas directement – les actions des acteurs privés.6 Cependant, dans la conjoncture actuelle de capitalisme de surveillance7, le pouvoir de générer et de maintenir les inégalités numériques n’appartient plus seulement à l’État, mais aussi à des acteurs privés tels que les entreprises multinationales: les entreprises qui proposent et utilisent des logiciels génériques de reconnaissance faciale, qui gèrent les plateformes de médias sociaux et les moteurs de recherche et qui déterminent qui peut être banni ou non pour discours haineux, et quels algorithmes sont utilisés pour générer des résultats de recherche, et ainsi de suite. Le droit européen diffère du droit international des droits de l’Homme en ce qu’il oblige ces acteurs privés à respecter la promesse d’égalité, au moins dans certains cas.8

Est-ce que « toutes les personnes » sont égales devant la loi ?

Le droit n’est cependant pas une panacée, et cette promesse d’égalité peut être indéfiniment reportée pour certains. L’une des critiques fréquemment formulées à l’encontre de la législation sur la non-discrimination est qu’elle tend à considérer les motifs de discrimination, tels que le genre et la race, comme des catégories distinctes et homogènes.9 À l’inverse, l’utilisation de l’intersectionnalité comme cadre de référence illustre la manière dont les systèmes d’oppression tels que le racisme et le (cis-)sexisme s’imbriquent et ont un impact sur différentes personnes de différentes manières.10 À titre d’exemple, comme indiqué précédemment, l’analyse de Buolamwini et Gebru sur les classificateurs commerciaux de genre a non seulement révélé une diminution de la précision en fonction de la race et du genre, mais a également révélé que les résultats étaient particulièrement mauvais pour les femmes de couleur. Les algorithmes peuvent également intégrer des représentations culturelles et des stéréotypes connus spécifiquement pour les femmes noires ou à d’autres femmes de couleur. Un exemple flagrant en est l’ancien cas des recherches Google sur les « filles noires », où les premiers résultats affichaient majoritairement du contenu pornographique. Ce n’est qu’après une pression publique soutenue que des changements ont été apportés.11

Malgré une prise de conscience croissante de l’importance de l’analyse intersectionnelle, un rapport récent du Center for Intersectional Justice a révélé que « les organes juridiques européens ne sont pas encore suffisamment outillés pour traiter efficacement les cas de discrimination intersectionnelle ».12 Des progrès considérables en la matière seraient nécessaires pour combattre les inégalités sans négliger les plus vulnérables. Comme le dit Aisha Kadiri, « la prise en compte du type unique de biais auquel les personnes concernées sont confrontées exige la reconnaissance de l’intersectionnalité dès le départ ».13 Bien que la doctrine juridique la considère comme subsidiaire par rapport à des clauses de non-discrimination plus spécifiques, la promesse d’égalité pour « toutes les personnes » inscrite dans l’article 20 de la Charte devrait servir à rappeler que la discrimination ne peut être cloisonnée en motifs de discrimination distincts, mais qu’elle doit être appréhendée de manière holistique.

Il n’y a pas de solution miracle

Adopter une approche intersectionnelle pour lutter contre les inégalités numériques implique également de de s’interroger sur les bénéficiaires et les victimes du déploiement de nouvelles technologies. À titre exemple, il y a quelques années, la principale société de transport public de Berlin a utilisé la classification automatisée du genre sur certains de ses distributeurs de billets pour accorder une réduction aux femmes à l’occasion de la Journée internationale de la femme. Ce qui semble à première vue être un projet bénin visant à réduire légèrement l’écart de rémunération, s’avère toutefois n’être avantageux que pour certaines femmes, au détriment d’autres. Des études comme celle de Buolamwini et Gebru démontrent non seulement que les femmes de couleur sont davantage susceptibles de ne pas bénéficier de la réduction, mais également la notion même d’attribution d’un genre binaire aux individus sur la base de l’apparence physique

de leur visage est fondamentalement discriminatoire pour les transgenres. La classification automatisée du genre contribue à normaliser l’idée erronée que le genre est identifiable à partir de l’apparence physique et s’oppose donc à une identité de genre autodéterminée – c’est pourquoi de nombreuses personnes transgenres rejettent cette technologie dans son ensemble, plutôt que de militer pour une réforme visant à la rendre plus inclusive.14 Cet exemple montre que les nouvelles technologies ne contribuent pas uniquement à la création d’inégalités entre les groupes, mais aussi, par la manière dont elles catégorisent les personnes et normalisent certains modes de pensée, aux processus mêmes de genrisation et de racialisation.15

Il est important de comprendre l’ampleur des problèmes, car cela met en évidence une question récurrente en ce qui concerne les égalités numériques. Souvent, il n’y a pas de solution miracle, car ces inégalités sont intimement liées à la technologie en question. Ce constat ne se limite pas qu’aux conceptions trans-exclusionnistes du genre, mais il s’applique aussi à de nombreuses formes de technologie, lorsqu’elles sont considérées dans le contexte plus large de leur développement, de leur utilisation et de leur institutionnalisation. Les historiens de la technologie ont démontré qu’à maintes reprises, les nouvelles technologies n’ont pas seulement servi les intérêts des détenteurs du pouvoir, mais qu’elles ont été délibérément développées et utilisées pour soutenir les efforts de domination, de maintien de l’ordre et de surveillance. Que ce soit par le biais de schémas de classification des genres et des races ou d’autres méthodes, les inégalités sont enracinées dans les fondements mêmes des infrastructures numériques qui nous semblent aujourd’hui si familières. « Le sexisme est une caractéristique, pas un bug »,16 et « le racisme anti-Noir, que ce soit dans les résultats de recherche ou dans les systèmes de surveillance, n’est pas seulement un symptôme ou une conséquence, mais une condition préalable à la fabrication de ces technologies ».17 Les bugs, les symptômes et les résultats peuvent être facilement corrigés, mais les problèmes sont plus profonds.

Les limites des revendications en matière d’égalité

Le langage de l’égalité et de la non-discrimination fait courir le risque de ne se limiter qu’à revendiquer l’inclusion et l’exactitude des résultats, tout en ignorant le rôle crucial des structures oppressives telles que le racisme et le (cis-)sexisme dans la conception même des technologies numériques, ainsi que les contextes politiques, institutionnels et économiques de leur utilisation. Pour reprendre l’exemple de la reconnaissance faciale, il apparaît rapidement qu’outre l’objectif commercial de son utilisation, ces systèmes technologiques intéressent principalement les organismes chargés de l’application de la loi, tels que la police et les services de contrôle aux frontières. l est important de noter que ces derniers dépendent souvent de technologies privées et d’importantes sociétés de conseil en technologie. Ces institutions sont gangrénées par le racisme et d’antiblackness ; le contrôle aux frontières de l’Europe, en particulier, est fondé sur des logiques coloniales violentes qui considèrent que la vie des Noirs n’est pas indispensable.18 Il est difficile d’appréhender des problèmes de ce type dans le langage juridique de l’égalité et de la non-discrimination. Comme le souligne Dean Spade, juriste et activiste trans, des questions structurelles telles que les disparités de richesse, le ciblage des sanctions pénales, les atteintes à l’environnement, l’application des lois relatives à l’immigration et bien d’autres sont « considérées comme neutres par le principe de non-discrimination ».19 Ainsi, les revendications d’égalité en droit peuvent donc légitimer des institutions profondément injustes, même si des changements superficiels sont apportés au niveau des symptômes ou des résultats. Une reconnaissance faciale plus précise serait en effet, à première vue, plus égalitaire en termes de genre et de race. Cependant, dans le contexte de son utilisation par les forces de l’ordre, la promesse d’égalité perd son attrait.

Revenons à la notion de « regard blanc » de Frantz Fanon et au « regard codé » de Joy Buolamwini, qui l’a revisitée. Dans ces références au « regard », comme dans d’autres, la vision est liée au pouvoir – comme le dit la féministe noire bell hooks, il y a « un pouvoir dans le regard ». Elle développe la notion de « regard oppositionnel » (« oppositional gaze ») pour exprimer le pouvoir de regarder en retour de manière provocante et courageuse: « Je ne me contenterai pas de regarder fixement. Je veux que mon regard change la réalité ».20 Comment pouvons-nous transformer la réalité au moyen de revendications d’égalité? Comme je l’ai fait valoir plus haut, nous pouvons utiliser la promesse d’égalité pour contester les inégalités, y compris leurs manifestations dans les environnements numériques. Nous devons cependant être conscients de ses limites. Dans le meilleur des cas, l’égalité signifierait la réciprocité, un regard mutuel basé sur

“La

promesse d’égalité devant le droit ne doit pas épuiser l’horizon de notre imagination et de nos actions collectives.”

un même pied d’égalité, où la noirceur ne se définirait plus par rapport à la blancheur. Cependant, les revendications d’égalité devant la loi n’aboutissent généralement pas à ce type de réciprocité. Difficile de les utiliser pour remettre en question le regard dominant qui définit d’emblée les sujets racialisés et genrés, et dont les intérêts sont codés dans nos infrastructures numériques et nos nouvelles technologies. Dans de nombreux cas, nous devrions résister à l’attrait de l’exactitude et de l’inclusion dans lequel l’égalité se glisse si facilement, et nous concentrer sur l’opposition et le refus. Comme le disent les auteurs du Feminist Data Manifest-No: « Nous refusons de croire que convaincre des institutions injustes de nous écouter est le seul moyen de faire avancer les choses. Nous nous engageons à co-construire notre langage et nos questions avec les communautés que nous servons afin de renforcer notre pouvoir ».21 La promesse de l’égalité devant la loi ne doit pas épuiser l’horizon de notre imagination et de nos actions collectives.

Raphaële Xenidis, Professeure assistante en droit européen, Sciences Po École de droit

Série d’articles: Les droits numériques sont des droits fondamentaux de la Charte

Précisions

Les recherches menées dans cet article sont liées à un projet qui a bénéficié d’un financement du programme de recherche et d’innovation Horizon 2020 de l’Union européenne dans le cadre de la subvention Marie Skłodowska-Curie n° 898937.

Introduction

L’article 21 de la Charte des droits fondamentaux de l’Union européenne (UE) (ci-après « la Charte ») protège le droit fondamental à la non-discrimination. Il comprend deux paragraphes : l’article 21 (1), une clause de non-discrimination ouverte, basée sur le modèle de l’article 14 de la Convention européenne des droits de l’homme (CEDH), qui interdit « toute discrimination fondée notamment sur le sexe, la race, la couleur, les origines ethniques ou sociales, les caractéristiques génétiques, la langue, la religion ou les convictions, les opinions politiques ou toute autre opinion, l’appartenance à une minorité nationale, la fortune, la naissance, un handicap, l’âge ou l’orientation sexuelle. » ; et l’article 21 (2), qui interdit « toute discrimination fondée sur la nationalité » « [d]ans le domaine d’application du traité instituant la Communauté européenne et du traité sur l’Union européenne, et sans préjudice des dispositions particulières desdits traités ». De nombreuses recherches ont mis en lumière l’omniprésence de biais et d’inégalités dans les systèmes algorithmiques.1 Dans ce contexte, les protections et les garanties offertes par le droit fondamental à la non-discrimination sont d’une importance capitale. Le présent article analyse la manière dont le droit à la non-discrimination consacré par l’article 21 pourrait être interprété et appliqué dans un contexte numérique. À cet effet, la section 1 explore d’abord la pertinence du droit fondamental à la non-discrimination dans une société algorithmique et présente l’exemple concret de la partialité raciale dans les logiciels de surveillance des examens utilisés par certaines universités durant la pandémie de Covid-19. Ensuite, la section 2 met en évidence les questions d’interprétation nées de la « transposition » du droit à la non-discrimination dans un contexte algorithmique. Enfin, la section 3 explique comment l’article 21 pourrait servir d’instrument de prévention et de correction de la discrimination algorithmique.

1. La pertinence du droit fondamental à la nondiscrimination dans une société algorithmique

En raison du champ d’application de la Charte, tel qu’exprimé à l’article 51 paragraphe1, l’interdiction de discrimination s’applique aux « institutions et organes de l’Union » ainsi qu’aux « États membres uniquement lorsqu’ils mettent en œuvre le droit de l’Union ». Par conséquent, il incombe à l’UE de s’abstenir de toute forme de discrimination fondée sur l’ensemble des éléments énumérés à l’article 21. Cela signifie, par exemple, que Frontex, une agence de l’UE, ne peut pas utiliser un logiciel de contrôle des frontières qui discrimine les individus sur la base de facteurs tels que la couleur de la peau, l’origine ethnique ou la langue.

Cependant, les États membres ont une obligation plus limitée : la clause de non-discrimination contenue dans l’article 21 ne s’applique que lorsqu’il existe un « lien direct » avec la législation de l’UE.2 Dans le cadre du champ d’application matériel des quatre directives anti-discrimination de l’UE (directives 2000/43/CE, 2000/78/CE, 2004/113/CE et 2006/54/CE), les dispositions du droit dérivé interdisent la discrimination fondée sur le sexe ou le genre, la race ou l’origine ethnique, l’orientation sexuelle, le handicap, la religion ou les croyances et l’âge.3 L’article 21 de la Charte, qui consacre le principe général de l’égalité de traitement, s’applique dans le cadre spécifique défini par ces directives.4 Toutefois, lorsque les directives ne peuvent pas, en principe, s’appliquer directement aux parties privées, la Cour de justice de l’Union européenne (CJUE) a reconnu à l’article 21 (1) de la Charte des effets horizontaux directs.5 Ainsi, l’article 21 interdit aux employeurs privés au sein de l’UE de déployer des outils de recrutement algorithmiques qui défavorisent indûment les femmes ou les candidats handicapés.

Dans les cas où la situation ne relève pas du champ d’application du droit dérivé de l’UE, mais conserve un lien direct avec le droit de l’UE,6 l’article 21 fonctionne de manière subsidiaire.7 Par exemple, l’article 21 interdit à un État membre de mettre en œuvre un système algorithmique discriminatoire dans le cadre du traitement de données à caractère personnel, qui est régi par le Règlement général sur la protection des données de l’UE.8

Examinons un exemple concret. En 2022, une étudiante néerlandaise nommée Robin Pocornie, soutenue par le Racism and Technology Centre, a déposé une plainte pour discrimination auprès de l’organisme néerlandais de promotion de l’égalité et de l’institution nationale des droits de l’homme, le College voor de Rechten van de Mens (l’Institut des droits de l’homme). Pocornie a affirmé que l’utilisation par la Vrije Universiteit Amsterdam (l’Université libre d’Amsterdam) d’un logiciel de surveillance pour empêcher la tricherie lors des examens passés à domicile pendant la pandémie de Covid-19 en 2020 était discriminatoire à son égard en raison de sa race. L’application n’a pas reconnu son visage à plusieurs reprises, compliquant ainsi sa participation aux examens et lui imposant un stress inutile. D’après les preuves qu’elle a recueillies, les étudiants non racisés n’ont pas rencontré ce problème. Son affirmation confirme les recherches universitaires montrant que les systèmes commerciaux de reconnaissance faciale sont nettement moins performants lorsqu’ils tentent d’identifier les visages de personnes (et en particulier de femmes) à la peau plus foncée.9 Lorsque ces systèmes sont utilisés pour contrôler l’accès aux ressources, aux services, aux institutions ou aux privilèges, leurs performances médiocres pour certains groupes démographiques entraînent des discriminations injustes.

2. Application de l’article 21 aux biais algorithmiques

Cette section est l’occasion d’analyser l’interprétation juridique de l’article 21 en relation avec la partialité algorithmique. Dans le cas de l’application de surveillance biaisée, le système a été utilisé pour surveiller les examens, qui font partie intégrante des cours et permettent d’accéder à des opportunités futures. Conformément au droit européen,10 cette affaire relève du champ d’application de la Directive 2000/43/CE relative au principe de l’égalité de traitement entre les personnes sans distinction de race, qui s’étend au domaine de l’éducation.11 Le principe général d’égalité de traitement inscrit à l’article 21 s’applique également à ce cas, car la directive établit le lien permettant aux États membres d’être considérés comme appliquant le droit communautaire. Conformément à la décision de la CJUE dans l’affaire Egenberger, l’interdiction de la discrimination est directement applicable aux entités publiques et privées.12 L’article 21 de la Charte confère donc au requérant un droit directement exécutoire à l’égalité de traitement algorithmique à l’encontre de la Vrije Universiteit Amsterdam (l’Université libre d’Amsterdam).

Néanmoins, la transposition du droit fondamental à la non-discrimination dans le contexte des biais algorithmiques pose quelques défis quant à la qualification juridique de ces biais. Par exemple, dans son jugement provisoire du 7 décembre 2022, l’Institut néerlandais des droits de l’homme a mis l’accent sur les difficultés rencontrées par Pocornie pour présenter des preuves que l’outil de surveillance fonctionnait différemment pour les étudiants ayant des couleurs de peau différentes.13 L’Institut a souligné qu’étant donné que « les registres [informatiques] n’étaient pas fournis aux candidats à l’examen », « la requérante […] n’avait aucune idée des notifications que le logiciel avait enregistrées dans son cas et ne pouvait donc pas les relier à un événement particulier ou à une action (ou absence d’action) de sa part ». Cette remarque met en évidence le défi auquel sont confrontées les victimes de biais algorithmiques lorsqu’il s’agit de faire naître un soupçon raisonnable de discrimination. Le manque d’accès à des informations compréhensibles sur le fonctionnement du système et l’« atomisation » des expériences individuelles dans l’environnement en ligne entravent la comparaison heuristique traditionnelle qui sous-tend l’application de la loi sur la non-discrimination. Cependant, l’Institut néerlandais des droits de l’homme a analysé l’expérience de la candidate avec le logiciel de surveillance dans le contexte de la recherche existante sur les biais dans les logiciels de reconnaissance faciale afin d’établir une présomption de discrimination. Cette présomption a déplacé la charge de la preuve sur le défendeur, en l’occurrence l’Université (et le fournisseur du logiciel).14

L’Institut néerlandais des droits de l’homme a catégorisé l’affaire comme un cas de discrimination indirecte, estimant qu’il était « possible que les algorithmes de détection des visages […] aient, de manière pratique, une incidence plus particulièrement sur les personnes ayant une couleur de peau plus foncée ». En vertu du droit dérivé de l’UE, la constatation d’une discrimination indirecte aboutit à un test de proportionnalité ouvert, selon lequel une pratique discriminatoire prima facie peut être justifiée si elle répond à un objectif légitime par des moyens appropriés et nécessaires. Toutefois, du point de vue de l’article 21 de la Charte, la proportionnalité doit être évaluée à l’aide des critères énoncés à l’article 52 (1). La présente disposition stipule que « toute limitation de l’exercice des droits et libertés reconnus par la présente Charte doit être prévue par la loi et respecter le contenu essentiel desdits droits et libertés », et que « des limitations ne peuvent être apportées que si elles sont nécessaires et répondent effectivement à des objectifs d’intérêt général reconnus par l’Union ou au besoin de protection des droits et libertés d’autrui ». Il en résulte une seconde problématique liée à la transposition des paramètres du test de proportionnalité au fonctionnement d’un système algorithmique. Dans l’affaire relative à la surveillance, la partie défenderesse a soutenu que « la discrimination opérée est […] justifiée par l’intérêt légitime de prévenir la fraude aux examens dans le contexte de la pandémie de [COVID-19] » et que « l’utilisation d’un logiciel de surveillance était à la fois appropriée et nécessaire à cet égard ». Un défendeur pourrait soutenir que la garantie de l’équité des examens et le maintien du mérite dans l’éducation sont un objectif d’intérêt général et que, compte tenu des circonstances, l’utilisation d’un logiciel de surveillance était à la fois appropriée et nécessaire. En outre, un défendeur pourrait affirmer que la proportionnalité stricto sensu est maintenue, car le signalement pourrait ne pas atteindre le seuil permettant de le qualifier de préjudice discriminatoire, en particulier s’il ne résulte pas en un préjudice ultérieur. À l’inverse, l’Institut néerlandais des droits de l’homme, se référant à la jurisprudence de la Cour européenne des droits de l’homme, a affirmé que la signalisation constituait en soi un préjudice discriminatoire et que « l’absence alléguée de conséquences matériellement préjudiciables dues au fait que la durée de l’examen a été prolongée n’était pas pertinente ».15

3. Mettre à profit les atouts de l’article 21 pour lutter contre la discrimination algorithmique

Si la section 2 a mis en lumière certains des problèmes rencontrés dans le traitement des biais algorithmiques sous l’angle du droit fondamental à la non-discrimination, l’article 21 de la Charte contient également un certain nombre de dispositifs intéressants qui peuvent être exploités pour interpréter la disposition de manière ciblée dans le contexte des systèmes algorithmiques.

Premièrement, l’article 21 (1) fournit une liste ouverte de catégories protégées qui pourraient être exploitées dans le contexte de la différenciation algorithmique systémique.16 Par exemple, l’« origine sociale » et la « fortune » sont explicitement mentionnées à l’article 21 comme des éléments protégés, qui pourraient servir de base pour lutter contre la discrimination algorithmique fondée sur le revenu ou le profilage socio-économique. Néanmoins, cet article concerne exclusivement les situations dans lesquelles les États membres appliquent le droit de l’UE, mais ces situations ne relèvent pas au champ d’application matériel des directives de non-discrimination. En effet, dans l’affaire FOA, la CJUE a affirmé que « il n’y a pas lieu d’étendre le champ d’application de la directive 2000/78 par analogie au-delà des discriminations fondées sur les motifs énumérés de manière exhaustive à l’article 1er de celle-ci ».17

La dimension ouverte de la clause de non-discrimination de l’article 21 de la Charte pourrait également faciliter la correction des schémas complexes de discrimination algorithmique,18 un phénomène dont la recherche a montré qu’il était très répandu.19 Toutefois, la réticence manifestée par la CJUE dans l’affaire Parris à l’égard de la discrimination intersectionnelle, si elle se reflète dans l’interprétation de l’article 21, pourrait réduire l’efficacité de la Charte dans la lutte contre la discrimination algorithmique.20

En second lieu, en principe, l’application de l’article 21 ne nécessite pas la distinction conventionnelle entre la discrimination directe et indirecte.21 Pour les situations qui présentent un lien direct avec le droit européen, mais qui n’entrent pas dans le champ d’application du droit dérivé de l’UE en matière de lutte contre la discrimination, un régime de justification unifié découle de l’article 52 (1). Étant donné la difficulté de qualifier le

“...es droits fondamentaux protégés par la Charte, tels que la non-discrimination, devraient fonctionner de manière transparente audelà de la frontière entre les domaines physique et numérique...”

biais algorithmique en tant que discrimination directe ou indirecte,22 et les obstacles probables à la justification des cas de discrimination algorithmique directe, le cadre de justification unifié attaché à l’article 21 de la Charte pourrait constituer une voie de recours intéressante. Toutefois, dans la pratique, la CJUE a tendance à intégrer le cadre analytique différencié prévu par les directives anti-discrimination de l’UE en ce qui concerne les justifications pour interpréter l’interdiction de discrimination telle qu’elle est définie par la Charte.23

Les restrictions au droit fondamental à l’égalité de traitement en vertu de l’article 21 ne peuvent être tolérées que si elles sont « prévues par la loi et respectent l’essence des droits et libertés », tels qu’ils sont garantis par la Charte. Ainsi, la marge de manœuvre des entreprises privées est intrinsèquement réduite, car tout système discriminatoire doit s’aligner sur un cadre légal et respecter « le contenu essentiel » du droit à la non-discrimination. En outre, le test de proportionnalité intégré à la Charte impose deux conditions : les limitations doivent être « nécessaires » et « répondent effectivement à des objectifs d’intérêt général reconnus par l’Union ou au besoin de protection des droits et libertés d’autrui. » Dans le cas de l’outil de surveillance algorithmique, on pourrait affirmer que l’atteinte au droit des étudiants à la non-discrimination n’était pas prévue par la loi, ne respectait pas l’essence du droit fondamental garanti par l’article 21, ne correspondait pas véritablement aux objectifs d’intérêt général reconnus par l’UE et n’était pas nécessaire pour protéger les droits et les libertés d’autrui.24 Le régime établi à l’article 52 (1) restreint donc considérablement l’ensemble des justifications admissibles avant même de procéder à une analyse de la proportionnalité stricto sensu. Cet aspect unique du droit à la non-discrimination, tel qu’il est consacré à l’article 21 de la Charte, pourrait donc contribuer à anticiper et à contourner certaines des difficultés liées au contrôle de la proportionnalité stricto sensu des décisions prises dans le contexte des compromis entre l’équité et la précision dans les systèmes algorithmiques.25

Conclusions

Afin de rappeler le titre de cette série d’articles, la prise de conscience du fait que les droits garantis par la Charte sont des droits numériques et vice versa est d’une importance capitale dans le contexte d’une société algorithmique. En effet, les droits fondamentaux protégés par la Charte, tels que la non-discrimination, devraient fonctionner de manière transparente au-delà de la frontière entre les domaines physique et numérique. Une interprétation téléologique de ces droits est essentielle pour garantir que les transformations sociotechniques, telles que le déploiement généralisé de systèmes algorithmiques d’évaluation des risques et de prise de décision, ne compromettent pas l’équilibre normatif inscrit dans les cadres juridiques. Par conséquent, pour garantir une protection efficace des droits fondamentaux, il est nécessaire de réévaluer les réglementations existantes à la lumière de la manière dont les avancées technologiques modifient la dynamique du pouvoir et redistribuent les coûts et les bénéfices sociétaux.

Nadia Benaissa, Bits of freedom

Un

espace pour être et devenir : la protection de la vie privée, la base du développement personnel

Conformément à l’article 20 de la Charte des droits fondamentaux de l’Union européenne (UE) (« la Charte »), toutes les personnes sont égales et se trouvent sur un pied d’égalité en droit. Cependant, l’égalité n’implique pas l’homogénéité. Nous percevons, communiquons et aimons de diverses manières. Nous portons en nous des histoires familiales uniques, nous naviguons dans des structures de pouvoir différentes et nous portons la signification historique et sociale de notre race et de notre sexe dès le jour de notre naissance. Et nous sommes constamment confrontés à des interprétations politiques de la manière dont nous nous exprimons, de ce que nous représentons et de ce en quoi nous croyons.

Nous sommes tous égaux, mais pas identiques.

De ce fait, nous avons besoin d’espace. De l’espace pour explorer, pour hésiter, pour se décider et changer à nouveau d’avis, pour persister et persévérer. De l’espace pour comprendre qui nous étions, qui nous sommes et qui nous aspirons à être. Un espace pour apprendre à connaître notre moi intérieur, sans l’interférence, la condescendance ou le dénigrement des autres. Et de l’espace pour vivre notre réalité, même si cette réalité n’est pas populaire, aimée ou même comprise.

Cet espace est l’élément vital de notre développement personnel et d’une société libre et ouverte. Il est en partie garanti par le droit au respect de la vie privée, tel que stipulé dans la Charte : « Toute personne a droit au respect de sa vie privée et familiale, de son domicile et de ses communications. ». Le droit au respect de la vie privée est inextricablement lié à d’autres droits de l’homme. Par exemple, le traitement de données relatives au sexe, à la religion ou à l’appartenance ethnique pourrait porter atteinte aux droits de l’individu à l’égalité de traitement ou à la liberté d’expression religieuse. Par conséquent, le droit au respect de la vie privée joue le rôle de garant des autres droits de l’homme. Cet article examine plusieurs cas récents aux Pays-Bas où la violation du droit au respect de la vie privée a entraîné la violation d’autres droits de l’homme.

Des identités

réduites à des stéréotypes: le traitement des données et les dangers du réductionnisme stéréotypé

Avec l’avènement de capacités technologiques de traitement des données apparemment illimitées, le droit au respect de la vie privée est mis à rude épreuve. Les données contenant des informations personnelles sont traitées, analysées et interprétées à une échelle sans précédent. Les idées et les conclusions tirées de ces données sont diffusées et échangées. Les aspects multiples qui construisent les identités sont simplifiés, catégorisés et regroupés dans des profils prédéterminés, un processus qui réduit les identités complexes à de simples stéréotypes.

En effet, le profilage pourrait simplifier la prédiction de la réaction d’un individu vis-àvis des stratégies publicitaires ou du succès de traitements médicaux. Mais dans quelle mesure est-il approprié d’estimer, sur la base du profilage, les convictions politiques d’un électeur, la probabilité qu’une personne soit impliquée dans des « transactions suspectes » ou qu’elle commette une fraude aux prestations sociales ?

En outre, la prise de décision automatisée basée sur le profilage a été annoncée comme une promesse de simplicité, d’efficacité et d’efficience. Malheureusement, il semble que ce soit le contraire qui se produise et que les conséquences soient de plus en plus évidentes, car nous constatons que divers droits fondamentaux sont fragilisés en raison de violations du droit au respect de la vie privée.

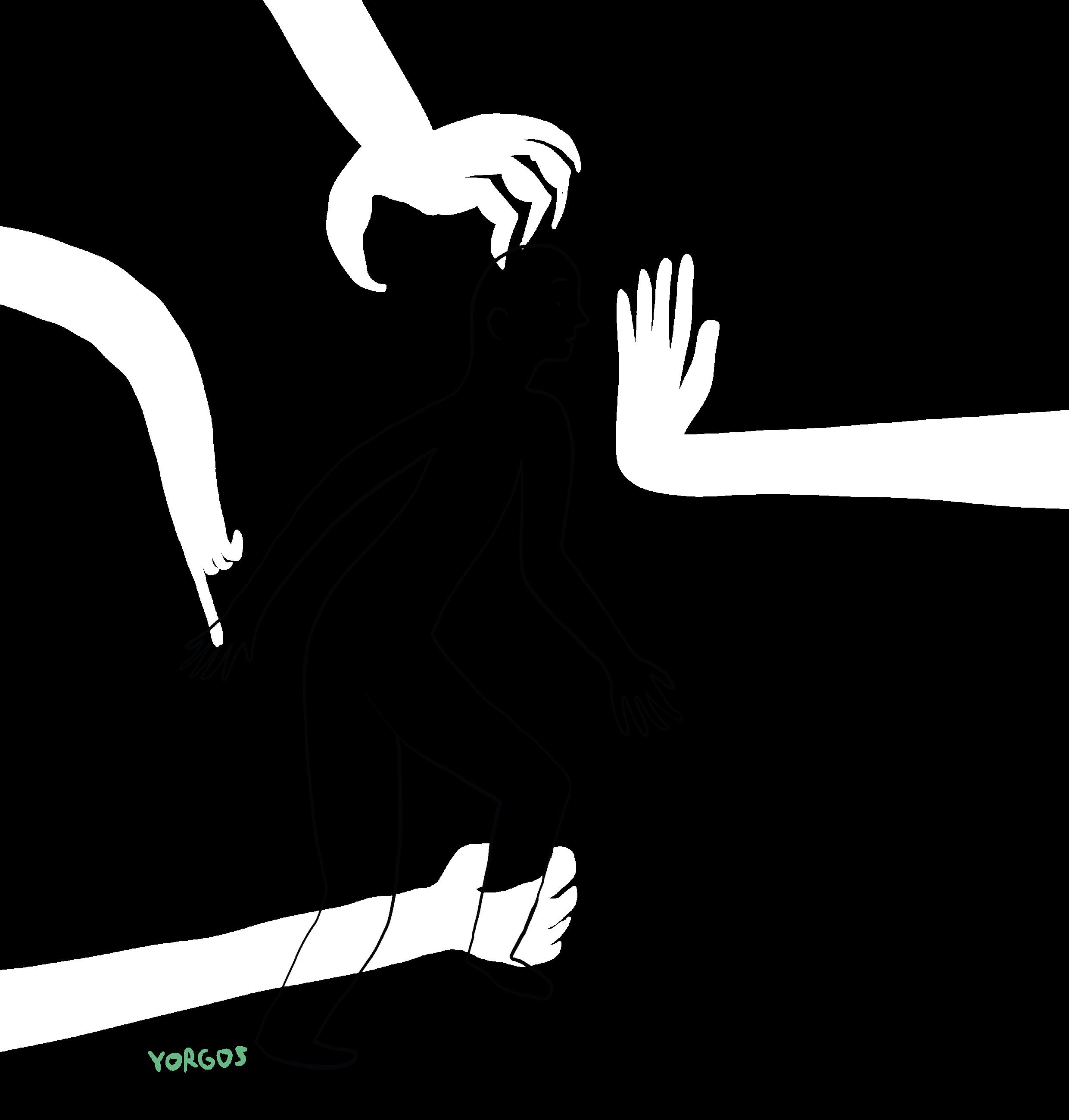

Une discrimination combinée: l’impact cumulatif des biais

Le domaine de la sécurité sociale numérique offre un exemple frappant d’atteintes à la vie privée entraînant d’autres violations des droits de l’homme. Le système de protection sociale numérique néerlandais a suscité le désormais célèbre scandale des allocations familiales1 En 2018, il est apparu que de nombreux parents qui recevaient des allocations familiales de l’administration fiscale néerlandaise avaient été identifiés à tort comme fraudeurs. Cette classification erronée a contraint les parents à rembourser des milliers d’euros à l’État, plongeant nombre d’entre eux dans de graves difficultés financières, de se retrouver sans domicile fixe et de subir un stress et une pauvreté aiguë. Selon une révélation alarmante, pas moins de 2090 enfants de parents concernés ont été pris en charge entre 2015 et 20222

Parmi les parents concernés, il s’est avéré qu’un nombre disproportionné d’entre eux étaient issus de l’immigration. Cette constatation a été corroborée par des enquêtes ultérieures, qui ont révélé que l’administration fiscale utilisait des données relatives à la nationalité des parents. L’autorité néerlandaise de protection des données3 a confirmé cette affirmation et identifié trois processus de traitement illicites. Premièrement, les doubles nationalités étaient traitées. Deuxièmement, les données relatives à la nationalité étaient utilisées comme indicateur pour le modèle de classification des risques. Troisièmement, ce modèle était utilisé pour détecter la fraude organisée. L’Autorité a conclu à l’existence d’une discrimination fondée sur la nationalité. L’enquête complémentaire d’Amnesty International4 a révélé que la discrimination était perpétrée non seulement sur la base de la nationalité, mais aussi de l’appartenance ethnique. En effet, l’utilisation des données relatives à la nationalité a facilité le ciblage discriminatoire des minorités ethniques par le modèle de classification des risques. Comme le souligne Amnesty dans son rapport, « le profilage ethnique viole l’interdiction de la discrimination. Il conduit à la criminalisation de certains groupes de personnes et renforce les associations traditionnellement stéréotypées entre la fraude et l’appartenance ethnique ».

En outre, l’enquête a révélé que les personnes qui recevaient des allocations plus élevées étaient plus susceptibles d’être accusées de fraude. Les personnes issues de ménages à faibles revenus ont donc été touchées de manière disproportionnée en raison de leur plus grande dépendance vis-à-vis des prestations et des sommes plus importantes qu’elles percevaient. De plus, les parents à faible revenu ont rencontré des difficultés à rembourser les sommes considérables exigées par le gouvernement néerlandais. L’évaluation d’Amnesty a qualifié la situation de discrimination intersectionnelle5, car les personnes les plus touchées étaient généralement des groupes ethniques minoritaires, qui sont généralement plus susceptibles d’avoir de faibles revenus. Pour aggraver le problème, il semble par la suite qu’un profilage religieux6 était également pratiqué, les personnes ayant fait des dons à des mosquées étant considérées comme présentant un risque plus élevé.

Le scandale des allocations familiales illustre de manière frappante la nature intersectionnelle de la discrimination, dans laquelle plusieurs axes de biais se renforcent mutuellement. Ce phénomène n’est pas nouveau. Dès 1989, Crenshaw7 soulignait que l’intersection des couches politiques et sociales de nos identités pouvait nous rendre plus vulnérables à la discrimination ou aux privilèges. Des facteurs tels que le sexe, l’appartenance ethnique, la classe sociale, l’orientation sexuelle, la religion, le poids et le handicap peuvent tous influer sur la position d’une personne dans le spectre du pouvoir au sein de la société. L’intersection de multiples facteurs peut soit consolider une position de privilège, soit exposer un individu à une discrimination aggravée. Ce phénomène est bien illustré par le scandale des allocations familiales du type d’aide garde d’enfants. Par exemple, les personnes musulmanes, à faible revenu et possédant au moins une origine ethnique non néerlandaise ont été triplement pénalisées uniquement sur la base de ces classifications, sans tenir compte de leur situation individuelle.

L’incrimination avant la transgression: le coût des présomptions

Ces formes distinctes de discrimination apparaissent lorsque des collecteurs de données, tels que le bureau de l’administration fiscale du gouvernement néerlandais dans notre exemple précédent, établissent des profils sur la base des données collectées. Alors que