9 | 100 godzin tygodniowo Szaleńczy wyścig AI w Dolinie Krzemowej

10 | Dagma MSP Day

Usługi to przyszłość

12 | Upgrade'25

Branża SH w obliczu nowych wyzwań

14 | Canalys Forums EMEA Transformuj się lub giń

16 | Data Center Nation

Polska staje się regionalnym liderem

18 | Czas na partnerstwo wokół AI Igor Grdic, dyrektor regionalny Vertiv na Europę Środkową, o polskim rynku centrów danych i naszej transformacji w kierunku gospodarki opartej na AI

19 | SUSE Rancher Prime Szansa na biznes w erze kontenerów

20 | Całe miasto w jednej aplikacji Rozmowa z Eweliną Włoch, Naczelnik iem Wydziału Cyfryzacji i Nowych Technologii w Urzędzie Miasta Rybnik

23 | Mint Service Desk Nowa jakość komunikacji (OPGK Rzeszów)

24 | Nie ma transformacji bez skanowania Przyszłość skanowania dokumentów niezmiennie jawi się w jasnych barwach

27 | Skanery Epson

Realna wartość dla klientów, konkretna korzyść dla resellerów

28 | Bezpieczeństwo zaczyna odgrywać kluczową rolę dla klientów Rozmowa z Michałem Czeredysem, prezesem Arcusa

29 | Marketing apokalipsy Felieton Krzysztofa Jakubika

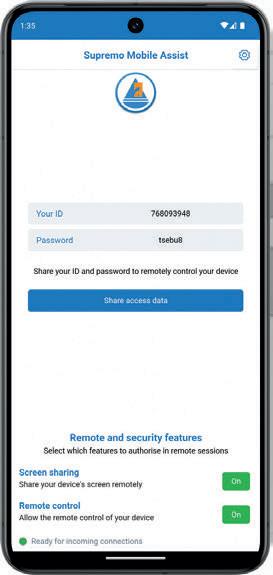

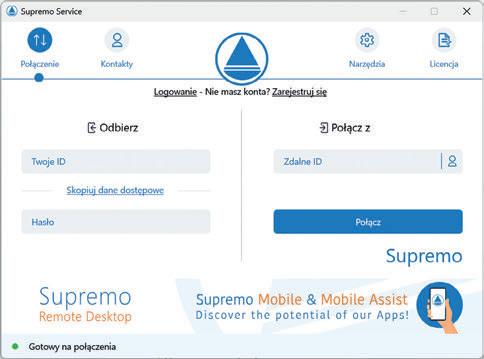

30 | Supremo Mobile Assist Mobilne zarządzanie bez granic (Nanosystems)

32 | NAS dla mas Rynek NAS dla sektora SOHO przetrwał rywalizację z usługami chmurowymi i dynamicznie ewoluuje

35 | Banki muszą być odporne na stres Rozmowa z Tomaszem Kokotem, Dyrektorem Obszaru Biznesowego w Sygnity

36 | Bądź o krok przed cyberzagrożeniami

Serwery HPE ProLiant oraz inne rozwiązania HPE dla SMB oferują szereg technologii oraz bezpiecznych mechanizmów, które pozwalają wyprzedzać działania cyberprzestępców.

38 | KSeF: odpowiedzialność po stronie integratora?

W ostatnich miesiącach znacznie wzrosło zapotrzebowanie na wdrożenia związane z Krajowym Systemem e-Faktur

41 | Od chaosu do pełnej kontroli

Cohesity rewolucjonizuje ochronę danych

42 | IT w logistyce

Przełom na wyciągnięcie ręki

45 | Wysoka cena zmowy

Felieton Marcina Babiaka

46 | Dolina Krzemowa i okolice

Arcitecta, ExaGrid i HYCU: trzy odpowiedzi na problemy z danymi

48 | Usługi zarządzane zwiększają wartość firmy

Rozmowa z Maciejem Toroszewskim, Customer Success Directorem w Meniga – UK Top FinTech Company w 2025

50 | Psychologia sprzedaży: brakujący element strategii

Felieton Sławomira Janczewskiego

51 | Siedem wartości w przywództwie IT Jak budować nadzieję i zaufanie w świecie niepewności?

52 | O świecie wojen, które nie wyglądają jak wojna

Felieton Adrianny Kilińskiej

53 | AI w praktyce

Ankieta CRN.pl

54 | „Ławka”, czyli mityczny byt firm usługowych IT

Felieton Tomasza Onyszko

55 | Europejski problem z produktywnością Produktywność pracy w Europie jest dziś aż o 24 proc. niższa niż w USA

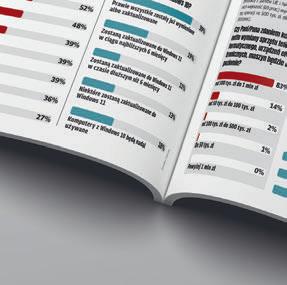

56 | Hiperskalerzy na krzywej rosnącej Dane raportu „GTM Channel Decision Maker Survey”

56 | Czy i dlaczego Europa upadnie...

Felieton Arnolda Adamczyka

58 | Umowy B2B ponownie na świeczniku Jaka przyszłość czeka wyjątkowo popularną w IT formę współpracy z personelem?

60 | Ostatnia szansa na IP Box? Czy możliwość korzystania z popularnej ulgi będzie ograniczona?

60 | Dark patterns w świetle przepisów Stosowanie dark patterns może zostać zakwalifikowane jako nieuczciwa praktyka rynkowa

66 | Inwigilacja w imię dziecka Felieton Wojciecha Urbanka

9

Szaleńczy wyścig AI w dolinie Krzemowej Podczas gdy w Europie coraz częściej pojawiają się pomysły czterodniowego tygodnia pracy, specjaliści od AI zza oceanu pracują po 100 godzin tygodniowo.

29

Marketing apokalipsy, czyli strach sprzedaje się najlepiej Strach jest jednym z głównych motorów napędow ych rynku rozwiązań cyberbezpieczeństwa.

58 54

Umowy B2B ponownie na świeczniku Jaka przyszłość czeka wyjątkowo popularną w IT formę współpracy z personelem?

„Ławka”: mityczny byt firm usługowych IT Pomysł „Ławki” w sektorze IT przestał się sprawdzać. Również w Polsce.

„JEŻELI HANDEL TOWARAMI PRZYNOSI POKAŹNE ZYSKI, TO I TAK SĄ ONE NIEWIELKIE W PORÓWNANIU Z POŻYTKIEM, JAKI PŁYNIE

David S. Landes, „Bogactwo i nędza narodów”

Tomasz Gołębiowski

Redaktor naczelny

Po wyjątkowo obfitym lipcu, kiedy to obroty w europejskiej dystrybucji wzrosły rok do roku o 7,7 proc., dwa kolejne miesiące nieco stonowały dobre nastroje. W sierpniu wynik poprawił się o 1,5 proc., podczas gdy we wrześniu o 1,3 proc. Średnio cały trzeci kwartał tego roku zamknął się wzrostem na poziomie 3,7 proc., a sumarycznie od stycznia do września 2025 r. było to 47 proc. w porównaniu z tym samym okresem ubiegłego roku. Co oznacza, że biorąc pod uwagę szereg geopolitycznych i gospodarczych wyzwań, z jakimi mierzy się Stary Kontynent, europejska dystrybucja zachowuje stabilną pozycję rynkową, rosnąc kilkukrotnie szybciej niż przeciętne unijne PKB. Warto dodać, że jedną z sił napędowych okazały się w omawianym okresie pecety, których segment zanotował w III kwartale poprawę obrotów rok do roku na poziomie 15 proc., zaś łącznie w trzech pierwszych kwartałach bieżącego roku wynik w tym przypadku sięgnął bardzo przyzwoitych 11 proc. na plusie.

Szczególnym optymizmem napawa wynik dystrybucji w Polsce, która ze wzrostem na poziomie 8 proc. ustępowała w pierwszych dziewięciu miesiącach 2025 r. jedynie Hiszpanii i krajom nordyckim (w obu przypadkach po 14 proc. wzrostu rok do roku). Sam trzeci kwartał na polskim rynku, z wynikiem dodatnim na poziomie 5 proc., może i nie rzuca na kolana, ale jednak w porównaniu z danymi z Wielkiej Brytanii i Irlandii (0 proc.), a przede wszystkim Niemiec (2 proc. spadku), zdecydowanie powinien cieszyć. Dla porządku dodam, że III kwartał był korzystny także dla dystrybucji we Francji (+ 7 proc.) i krajach nordyckich (+ 10 proc.), a zwłaszcza dla Hiszpanii (16 proc. w górę). Generalnie, średnia europejska to w III kwartale 6 proc., a w okresie od stycznia do września 7 proc. Pod względem wartości (value) sprzedaży poprzez europejską dystrybucję w pierwszych dziewięciu miesiącach tego roku liderem okazał się Microsoft, wyprzedzając HPE oraz VMware, a w pierwszej piątce zmieściły się ponadto Cisco oraz Dell Technologies. Z kolei pod względem wielkości (volume) sprzedaży w rankingu Top 5 znalazły się: Apple, HP, Lenovo, Samsung i Dell. Ciekawe są jednocześnie wstępne prognozy analityków Contextu odnośnie do całego 2025 r., który ma się zamknąć wynikiem rzędu 5,3 proc. na plusie, pod warunkiem, że w czwartym kwartale europejska dystrybucja zanotuje wzrost o co najmniej 6,6 proc. rok do roku. Korzystne przewidywania współgrają z nastrojami większości integratorów, resellerów i retailerów, z których – jak wynika z danych Contextu – 64 proc. oczekuje, że w kolejnych 12 miesiącach ich biznes będzie prosperował lepiej niż obecnie, podczas gdy przeciwnego zdania jest jedynie 7 proc. respondentów (z ponad 6 tys. wszystkich uczestników analizy).

A skoro wybiegamy w nieco dalszą przyszłość, warto wspomnieć o zapowiedziach Gartnera, który wieszczy, że globalne wydatki na produkty i usługi IT wzrosną w przyszłym roku niemal o 10 proc., przekraczając tym samym poziom 6 bln dol. Motorami napędowymi rynku mają być inwestycje w sprzęt oraz oprogramowanie dla centrów danych, co ma wynikać z rosnącego zapotrzebowania na usługi AI.

MIESIĘCZNIK CRN POLSKA www.CRN.pl

Rok 28, numer 11 (514), 12 listopada 2025 PL ISSN 2080-8607

REDAKCJA

Aleja Stanów Zjednoczonych 51, lok. 508 04-028 Warszawa redakcja@crn.pl

Tomasz Gołębiowski tg (redaktor naczelny) tel. 608 425 699 tomasz.golebiowski@crn.pl

Wojciech Urbanek wu (zastępca red. naczelnego) tel. 691 672 065 wojciech.urbanek@crn.pl

Karolina Marszałek km (sekretarz redakcji) karolina.marszalek@crn.pl

Andrzej Gontarz ag andrzej.gontarz@crn.pl

Krzysztof Jakubik kj krzysztof.jakubik@crn.pl

Krzysztof Pasławski kp krzysztof.paslawski@crn.pl

Tomasz Janoś tj tomasz.janos@crn.pl

FELIETONY

Arnold Adamczyk, Maciej Babiak Krzysztof Jakubik, Sławomir Janczewski, Adrianna Kilińska, Krzysztof Kozakiewicz, Tomasz Onyszko, Wojciech Urbanek GRAFIKA, LAYOUT, Tomasz Baziuk

FOTOGRAFIE

Theta Art Studio Tomasz Pisiński, PhotobyMysluk.pl, Adrian Stykowski, Piotr Syndoman, archiwum

PRENUMERATA prenumerata@crn.pl

REKLAMA I PROJEKTY SPECJALNE Agata Myśluk tel. 694 455 426 agata.mysluk@crn.pl

Jacek Goszczycki tel. 601 935 513 jacek.goszczycki@crn.pl

WYDAWCA

Peristeri Sp. z o.o. Aleja Stanów Zjednoczonych 51, lok. 508 04-028 Warszawa

Reklamy są przyjmowane w siedzibie wydawnictwa. Za treść ogłoszeń redakcja nie ponosi odpowiedzialności. © 2025 Peristeri Sp. z o.o. Wszelkie prawa zastrzeżone. Computer Reseller News Polska contains articles under license from The Channel Company. © 2025 The Channel Company. All rights reserved.

Ministerstwo Rodziny, Pracy i Polityki Społecznej inwestuje w platformę AI. Na sfinansowanie zamówienia zamierzało przeznaczyć 4 mln zł. Przetarg ogłoszono w sierpniu br., a oferty zostały otwarte we wrześniu br. Ministerstwo wybrało do realizacji zamówienia spółkę Deloitte Advisory, która złożyła jedyną ofertę (o wartości 3,99 mln zł brutto), uzyskując 85 pkt. w kryteriach oceny. Zamówienie obejmuje dostawę, instalację, konfigurację i uruchomienie kompletnej platformy AI. Będzie ona zawierać serwer z oprogramowaniem umożliwiającym uruchamianie modeli sztucznej inteligencji.

Satya Nadella, prezes Microsoftu, zarobił w 2025 roku fiskalnym 96,5 mln dol., o niemal jedną piątą więcej niż rok wcześniej. Na powyższą kwotę składają się: wynagrodzenie podstawowe w wysokości 2,5 mln dol. (niezmienione od 2023 r.), 84 mln dol. w nagrodach akcyjnych, 9,5 mln dol. w ramach planu motywacyjnego pozakapitałowego oraz 196 tys. dol. tytułem innych świadczeń.

Analitycy PFR Ventures i Inovo.vc podali, że w III kw. 2025 r. 39 spółek pozyskało w sumie 464 mln zł od 45 funduszy. Wynik nieznacznie przewyższa średnią z okresu 2023 – 2024 (423 mln zł), jest jednak niższy niż w II kw. 2025 r., gdy 48 firm zostało zasilonych przez 549 mln zł od 37 funduszy venture capital. Tym niemniej już po 9 miesiącach 2025 r. przekroczono poziom finansowania, na którym rynek zatrzymywał się w dwóch poprzednich latach. Liczba transakcji w br. nie odbiega natomiast od wyników z 2024 roku. Ich średnia wartość wyniosła około 11–12 mln zł na jedną firmę.

sfinalizowało przetarg na body leasing specjalistów IT. Przedmiotem zamówienia jest zawarcie umowy ramowej na 2 lata na świadczenie usług wsparcia informatycznego dla systemów IT w resorcie finansów. Zajmie się tym udostępniony przez wykonawcę wyspecjalizowany personel. CIRF zamierza przeznaczyć na realizację zamówienia blisko 200 mln zł.

rozstrzygnął przetarg na dostawę klastra obliczeniowego, który powstanie na potrzeby trenowania i korzystania z modeli LLM. Przetarg ruszył w maju br., a oferty zostały otwarte w lipcu 2025. Złożyli je: Comtegra, Enigma Systemy Ochrony Informacji i Galaxy Systemy Informatyczne. COI wybrał ofertę spółki Enigma Systemy Ochrony Informacji o wartości ponad 14,5 mln zł. Wykonawca dostarczy klaster obliczeniowy na potrzeby trenowania i korzystania z modeli LLM w środowisku chmury prywatnej. Będzie on składać się z 3 serwerów z 24 modułami GPU i przełącznika backend z portami 400G Ethernet. COI zamawia też oprogramowanie, w tym platformę do zarządzania klastrami kontenerów oraz software do tworzenia, trenowania, uruchamiania i zarządzania modelami AI/ML. Do tego dochodzi serwis gwarancyjny urządzeń i wsparcie techniczne oprogramowania.

„Chcemy, aby APN Promise był jednym z kluczowych, globalnych partnerów Microsoftu” – Gregor Primus, CCO APN Promise.

Meta zwalnia 600 pracowników w dziale AI, a konkretnie osoby skupione na produktach sztucznej inteligencji, infrastrukturze i długoterminowych badaniach nad sztuczną inteligencją. Nie dotkną jednak TBD Lab, nowego zespołu skupiającego najlepiej opłacanych pracowników. „Dzięki mniejszemu zespołowi decyzje będą podejmowane szybciej, a każdy pracownik będzie miał większą odpowiedzialność, szerszy zakres obowiązków i większy wpływ na projekty. Większość dotkniętych pracowników będzie miała możliwość przeniesienia na inne stanowiska w Meta, gdzie ich wiedza na temat sztucznej inteligencji może być przydatna” – poinformował Alexandr Wang, dyrektor ds. sztucznej inteligencji.

, jako właściciel 90 proc. udziałów w Huawei Polska, w liście do polskiego premiera i wicepremierów wyraża zaniepokojenie dotyczące projektu nowelizacji ustawy o krajowym systemie cyberbezpieczeństwa. „Obawiamy się, że obecny projekt ustawy, w szczególności przepisy dotyczące ‘dostawców wysokiego ryzyka’, zostaną wykorzystywane do wyeliminowania Huawei z kluczowych sektorów” – stwierdza koncern. Według niego przygotowywane przepisy sprawią, iż w Polsce Huawei oprócz 5G zostanie wykluczony z takich sektorów jak energetyka, zdrowie, transport, gospodarka odpadami, zaopatrzenie w wodę, czy produkcja, przetwarzanie i dystrybucja żywności.

Awaria infrastruktury AWS spowodowała problem z dostępnością do wielu serwisów. Globalnie dotyczył takich platform jak Snapchat, Fortnite, Canva, Zoom, Roblox, Duolingo, Shutterstock czy McDonald’s, a w Polsce między innymi Poczty Polskiej. Koncern wszczął dochodzenie w tej sprawie.

Amazon zwalnia do 15 proc. pracowników w dziale kadr. Chodzi o jednostkę pod nazwą People eXperience and Technology (PXT), która zatrudnia ponad 10 tys. osób na całym świecie. Kolejne redukcje planuje w innych działach – wynika z nieoficjalnych informacji. Koncern na razie nie skomentował tych doniesień. W czerwcu br. CEO Amazona, Andy Jassy stwierdził, iż spodziewa się zmniejszenia liczby pracowników w firmie w perspektywie najbliższych lat. Taki jego zdaniem będzie efekt wzrostu wydajności dzięki wykorzystaniu sztucznej inteligencji w całej organizacji.

Kaseya pozwała Slide, dostawcę oprogramowania do tworzenia kopii zapasowych i odzyskiwania danych. Zarzuca mu kradzież własności intelektualnej. Twierdzi, że współzałożyciel i szef Slide, Austin McChord, odtworzył swoje poprzednie przedsięwzięcie, Datto. Firma ta została przejęta przez Kaseyę w 2022 r. za 6,2 mld dol., specjalizując się w dedykowanych MSP rozwiązaniach utrzymania ciągłości biznesowej, backupu i disaster recovery. Kaseya domaga się, by sąd nakazał wstrzymanie sprzedaży produktu Slide’a do tworzenia kopii zapasowych.

„To jest inwestycja w bezpieczeństwo narodowe” – Michał Kanownik, prezes Związku Cyfrowa Polska, o projekcie ustawy o nowelizacji KSC.

„Wiele firm IT przyjmuje strategię ‘wait and see’, co jest sygnałem rosnącej ostrożności” – Dominik Malec, Head of Experis IT Resourcing w Manpower Group, o sektorze pracy.

Amazon zamierza zwolnić nawet 30 tys. pracowników w sektorze korporacyjnym – podał Reuters w końcu października br. Byłyby to rekordowe cięcia w historii firmy. Na koniec II kw. 2025 r. koncern zatrudniał na świecie 1,54 mln osób. Liczba ta obejmuje jednak głównie personel magazynowy. W sektorze korporacyjnym pracuje około 350 tys. osób. W ostatnich miesiącach cięcia dotknęły między innymi działy chmury, sklepów, komunikacji oraz urządzeń Amazona.

APN Promise powołał spółkę, która będzie działała na rynku niemieckim, który jest 15 z kolei, na którym polska firma prowadzi swoje interesy. Co więcej, w ciągu najbliższych dwóch lat APN planuje rozszerzyć działalność na co najmniej 30 różnych krajów. Zapowiada koncentrację na rynkach o dużym potencjale – w tym w krajach nordyckich, Afryce oraz na Bliskim Wschodzie. Natomiast niemiecka spółka w ciągu najbliższych 3 lat ma osiągnąć kilkadziesiąt milionów dolarów przychodów.

Wrocławski Spyrosoft przejmuje amerykańską spółkę Carimus, która specjalizuje się w tworzeniu aplikacji i doradztwie. W 2024 r. miała ok. 5,3 mln dol. przychodów. Cena za 100 proc. udziałów to 2 mln dol., powiększona o ok. 0,6 mln dol. Przewidziane są też dodatkowe odroczone płatności w kwocie 1,9 mld dol. Celem przejęcia jest rozszerzenie bazy klientów polskiej firmy w USA i wzrost przychodów.

Nvidia zainwestuje 1 miliard dolarów w Nokię w ramach umowy między firmami o współpracy w zakresie sztucznej inteligencji. Przejmie przy tym 2,9 proc. udziałów w fińskiej firmie. Koncerny będą wspólnie pracować nad rozwiązaniami sieciowymi opartymi na AI. Zbadają też możliwości włączenia technologii Nokii do przyszłej architektury infrastruktury AI Nvidii. Nokia ostatnio odnotowała gwałtowny wzrost sprzedaży sprzętu do infrastruktury sieciowej w rezultacie popytu ze strony klientów AI i centrów danych.

Comarch podpisał warunkową umowę z CGI ISMC (Polska), dotyczącą sprzedaży Comarch Polska. Po finalizacji transakcji spółka ta będzie obejmować działalność krakowskiej firmy w zakresie rozwoju i utrzymania systemów IT dla sektora publicznego. Strony przewidują, że do zakupu dojdzie na przełomie 2025 i 2026 r. Wartość umowy nie została ujawniona. W 2024 r. Comarch wypracował blisko 190 mln zł przychodów ze sprzedaży do klientów z sektora publicznego. CGI ISMC (Polska) jest spółką zależną kanadyjskiej firmy CGI. Sprzedaż to element strategii uproszczenia portfolio Comarchu i koncentracji na najważniejszych liniach biznesowych.

Szwedzka firma Sigma Embedded Engineering otworzyła biuro w Krakowie. Jej polski oddział skoncentruje się na takich obszarach, jak motoryzacja, technologia medyczna i przemysłowy IoT. W pierwszym roku zespół będzie liczył około 30 pracowników zaangażowanych w realizację projektów. Obecnie firma z centralą w Göteborgu zatrudnia 4,5 tys. osób w 12 krajach.

Zainteresowanie grantami na „Cyberbezpieczne Wodociągi” znacznie przekroczyło ustalone limity. Łączna wartość 896 wniosków o dofinansowanie wyniosła ponad 730 mln zł. To przeszło trzy razy więcej niż kwota przygotowana do podziału (313 mln zł). Natomiast limit wsparcia to 552 projekty. O granty mogły starać się podmioty Krajowego Systemu Cyberbezpieczeństwa – przedsiębiorstwa wodociągowo-kanalizacyjne i jednostki wykonujące zadania użyteczności publicznej. Minimalna wysokość dofinansowania dla jednego podmiotu to 130 tys. zł.

W dynamicznej branży IT personalna karuzela kręci się

szybciej niż w innych. Prezentujemy kilka najważniejszych zmian, które nastąpiły w minionych tygodniach.

Maciej Bocian został dyrektorem działu usług danych i pamięci masowych w HPE. Będzie kierował zespołem odpowiedzialnym za sprzedaż rozwiązań z tej kategorii. Jednocześnie wzmocni zespół zarządzający firmy w Polsce. Maciej Bocian to ekspert z ponad 20-letnim doświadczeniem w sprzedaży, rozwoju biznesu i transformacji centrów danych na rynku polskim oraz CEE. Ostatnio był Regional Sales Managerem VAST Data na CEE i CIS (2024 – 2025). Wcześniej stał na czele Pure Storage w kraju i regionie (2017 – 2024). Pełnił również role kierownicze w NetApp, Bull Polska, Cisco i IBM.

1 listopada br. Łukasz Bolikowski dołączył do Comarchu jako Chief AI Officer. Będzie wyznaczał strategiczne kierunki rozwoju firmy w zakresie sztucznej inteligencji. Ma również sprawować nadzór nad wdrażaniem rozwiązań AI w produktach i usługach Comarchu. Łukasz Bolikowski dotychczas pełnił funkcję Vice President of Data Science w BCG X (Boston Consulting Group). Wcześniej założył Laboratorium Analizy Danych Stosowanych na Uniwersytecie Warszawskim, gdzie rozwijał metody uczenia maszynowego i systemy oparte na blockchainie.

Tomasz Woźniak po ponad 17 latach kierowania Future Mind przekazał stanowisko CEO Tomaszowi Koperskiemu (na zdj.), dotychczasowemu CTO (od 2009 r.). Tomasz Koperski równocześnie objął funkcję Executive Vice President w Solicie, fińskiej firmie, z którą Future Mind połączył siły w grudniu 2023 r. Z kolei Tomasz Woźniak przechodzi do rady nadzorczej Future Mind. Będzie także strategicznym doradcą w ramach całej Grupy Solita. W zarządzie pozostaje Paweł Josiek, współzałożyciel Future Mind, jako dyrektor operacyjny.

Halina Frańczak objęła stanowisko Market Leadera i Managing Directora w DXC Technology. Zajmie się opracowaniem i wdrożeniem strategii rozwoju firmy w Polsce. Będzie współpracowała z Maciejem Tomczykiem, który pełni równoległą funkcję Managing Directora. Przed przejściem do DXC przez 18 lat pracowała w Deloitte. Ostatnio pełniła funkcję Chief Sustainability Officer w Polsce, na Ukrainie i krajach bałtyckich. Kierowała również działaniami marketingowymi w Polsce i regionie Europy Środkowej w Deloitte, a wcześniej w Accenture.

Roman Kasprzyk został dyrektorem handlowym w KBJ. W nowej roli będzie odpowiadał za relacje ze strategicznymi partnerami i umacnianie pozycji KBJ jako dostawcy usług opartych na technologii SAP-a i rozwiązaniach chmurowych. Roman Kasprzyk jest związany z branżą IT od 2004 r. Ostatnio przez trzy lata pracował w Grupie Euvic jako Enterprise Account Executive. Wcześniej zarządzał sprzedażą w MDS (2019 – 2022), Ricohu (2018 – 2019) oraz w Komputronik Biznes (2014 – 2018).

Paweł Mydło objął stanowisko dyrektora ds. rozwoju biznesu w Scalo i będzie kierował działalnością firmy w Stanach Zjednoczonych. Dostawca usług IT z centralą we Wrocławiu jest obecny na rynku amerykańskim od ponad trzech lat, a obecnie planuje dalszą ekspansję za oceanem. Paweł Mydło już wcześniej, do grudnia 2024 r., był związany ze Scalo jako Senior Business Development Manager. Ostatnio w RITS rozwijał biznes tej firmy w USA. Doświadczenie na stanowiskach menedżerskich zdobywał również w Codibly i Axence.

Łączymy technologie w obszarze Cyberbezpieczeństwa, Secure Cloud i Secure Networks, oparte na rozwiązaniach zaufanych producentów z naszego portfolio

Wspólnie z naszymi partnerami realizujemy projekty, które zwiększają bezpieczeństwo, efektywność i wartość dla klienta końcowego

Zaufane rozwiązania. Cyberbezpieczeństwo, chmura i sieci od wiodących producentów.

Eksperci po Twojej stronie. Doradztwo, presales i lokalne wsparcie techniczne.

Wspólny wzrost. Szkolenia, marketing i elastyczne finansowanie projektów.

Chcesz dołączyć do sieci partnerów Infinigate? Napisz do nas: sales-pl@infinigate.com

W Krakowie powstanie Fabryka AI. Zbuduje ją konsorcjum kierowane przez Akademickie Centrum Komputerowe Cyfronet AGH. Wartość projektu to 70 mln euro (ok. 300 mln zł), w tym połowa to środki unijne. Ośrodek o nazwie Gaia AI Factory skoncentruje się na badaniach i rozwoju rozwiązań AI w ochronie zdrowia i sektorze kosmicznym oraz na LLM. Jest drugą w Polsce Fabryką AI w ramach unijnego programu EuroHPC JU. Pierwszy taki ośrodek - PIAST AI Factory - rusza w Poznaniu kosztem 50 mln euro (ok. 210 mln zł).

Samsung otworzył w Warszawie swoje największe Business Experience Centre w Europie. Nowy ośrodek jest miejscem współpracy dla partnerów firmy, a także prezentacji i testowania rozwiązań dla różnych branż. Partnerzy mają do dyspozycji sale konferencyjne i strefy spotkań. W sumie jest to ponad 1200 mkw. powierzchni z 9 interaktywnymi strefami, prezentującymi ponad 180 scenariuszy biznesowych. Centrum wyposażono w pełne portfolio rozwiązań i produktów Samsunga. Obecne są także rozwiązania partnerów technologicznych.

Asseco i Comarch rywalizują o duży kontrakt w przetargu w Agencji Restrukturyzacji i Modernizacji Rolnictwa. Przedmiotem zamówienia jest utrzymanie i rozwój SIA (System Informatyczny Agencji) na czas 47 miesięcy. Na sfinansowanie zamówienia ARiMR zamierza przeznaczyć ponad 410 mln zł. Comarch złożył ofertę o wartości 376 mln zł, a Asseco Poland 348,6 mln zł. Kryteria oceny to po pierwsze cena (60), a po drugie doświadczenie osób skierowanych do realizacji zamówienia (40). Ostatnio, w 2023 roku, ARiMR powierzyła Asseco rozwój i utrzymanie SIA.

Komputronik podpisał umowę inwestycyjną z Euvic 2030 i WB iTotal. W rezultacie poznańska spółka pozyskała dodatkowe finansowanie, a Euvic staje się jednym z najsilniejszych graczy na rynku sprzętu IT. W ramach umowy Euvic 2030 i WBiTotal zobowiązali się do zapewnienia Komputronikowi zwiększonych limitów kredytów kupieckich w wysokości co najmniej 20 mln zł. Uzgodniono też emisję 980 tys. nowych akcji, z których 735 tys. obejmie Euvic (6,82 proc. akcji w podwyższonym kapitale spółki).

Allegro inwestuje w centralny hub logistyczny. Ruszy w Piotrkowie Trybunalskim w IV kw. 2026 r. Obiekt o powierzchni blisko 27 tys. mkw. wyposażono w automatykę sortującą, 144 doki liniowe i bezsłupową konstrukcję o wysokości 12 metrów. Według firmy nowa inwestycja stanowi strategiczny krok w jej dalszym rozwoju. Obecnie Allegro dysponuje szeregiem mniejszych magazynów i centrów przeładunkowych w całej Polsce.

JetBrains, dostawca narzędzi dla deweloperów, utworzy w Polsce centrum badawczo-rozwojowe. Ośrodek ma powstać do 2027 r. Firma z siedzibą w Amsterdamie decyzję o inwestycji wyjaśnia dużym potencjałem pozyskania talentów w Polsce. Deklaruje, iż nasz kraj stanowi strategiczny kierunek rozwoju. Obecnie JetBrains zatrudnia w Polsce około 60 osób. Do końca 2026 r. zamierza zwiększyć tę liczbę do 200. Nowi ludzie będą angażować się w globalne projekty firmy, w tym w rozwój najważniejszych produktów z oferty AI JetBrains..

MON podpisał list intencyjny z Palantir Technologies. Amerykańska firma specjalizuje się w analizie danych na dużą skalę. Współpraca z polskim resortem obrony obejmuje między innymi rozwiązania sztucznej inteligencji. Warunki finansowe nie zostały ujawnione. Finalizacja umowy jest spodziewana do końca roku. Alex Karp, CEO Palantira, zapowiedział, że firma zamierza zwiększać obecność w Polsce zarówno w obszarze wojskowym, jak też w technologiach podwójnego zastosowania.

W październiku br. CBA zatrzymało 3 osoby w woj. wielkopolskim i śląskim, które według śledczych brały udział w wyprowadzaniu środków unijnych na szkodę NCBR i PARP. Dwóch z zatrzymanych występowało jako grantobiorcy, a jeden był podwykonawcą. Jak ustalono, prace wykonywane w związku z grantami były pozorne, a wystawione faktury poświadczały nieprawdę. Szkoda NCBR wyniosła 1,6 mln zł, a PARP ponad 1,3 mln zł. W tej samej sprawie w lipcu br. CBA zatrzymało 4 osoby.

Rząd przyjął projekt nowelizacji ustawy o Krajowym Systemie Cyberbezpieczeństwa. Trafi on do prac w parlamencie. Nowelizacja dostosowuje krajowe przepisy do NIS2, wprowadza mechanizmy zwiększające bezpieczeństwo infrastruktury krytycznej, instytucji publicznych i sektora prywatnego. .Zmiany mają umożliwić m.in. wycofywanie z użytku sprzętu lub oprogramowania, uznanego za potencjalnie niebezpieczne dla bezpieczeństwa państwa – tzw. dostawcy wysokiego ryzyka. Z krytycznej infrastruktury telekomunikacyjnej ma on zniknąć w ciągu 4 lat, a z pozostałej w ciągu 7 lat. Zdaniem prezesa Cyfrowej Polski, Michała Kanownika, proces ten nie powinien generować dodatkowych kosztów dla firm czy instytucji, gdyż czas na realizację tego procesu standardowo odpowiada cyklom wymiany sprzętu. Z projektu wynika, że decyzja o uznaniu firmy za dostawcę wysokiego ryzyka będzie procesem wieloetapowym.

Podczas gdy w Europie coraz częściej pojawiają się pomysły czterodniowego tygodnia pracy, specjaliści od AI zza oceanu pracują po 100 godzin tygodniowo.

Wojciech Urbanek

Wnajwiększych laboratoriach sztucznej inteligencji w Dolinie Krzemowej najlepsi badacze i menedżerowie pracują od 80 do 100 godzin tygodniowo. Niektórzy porównują tę sytuację do warunków wojennych. Jak mówi Joshua Batson, naukowiec w Anthropic: „Zasadniczo staramy się uzyskać dwadzieścia lat postępu naukowego w ciągu dwóch lat. Niezwykłe innowacje pojawiają się w systemach sztucznej inteligencji co kilka miesięcy”. Wyraźnie widać, że kierownictwo, a także badacze takich firm jak Microsoft, Anthropic, Alphabet, Apple oraz OpenAI postrzegają swoją pracę jako krytyczną, uważając, że znaleźli się w przełomowym momencie historii.

KONCERNY, KTÓRE POZYSKAŁY NAJZDOLNIEJSZYCH SPECJALISTÓW, WYCISKAJĄ ICH JAK CYTRYNĘ.

Część badaczy stało się już wielokrotnymi milionerami, ale wielu z nich przyznaje, że nie mieli czasu na wydanie swoich fortun. Wielki wyścig o kasę rozpoczął Mark Zuckerberg, który zamienił się w rekrutera i wyruszył na łowy talentów AI, oferując im niebotyczne kontrakty. Nagle okazało się, że praca stosunkowo małej grupy badaczy stała się jednym z najcenniejszych zasobów na świecie. Potężne koncerny, które pozyskały najzdolniejszych specjalistów, zaczęły ich wyciskać jak cytrynę. „Wszyscy pracują non stop. Jest to niezwykle intensywne i wydaje

się, że nie ma żadnego naturalnego punktu zatrzymania” – przyznaje Madhavi Sewak, badacz AI w Google DeepMind.

Niektóre startupy uwzględniają oczekiwania ponad 80-godzinnego tygodnia pracy w swoich umowach o pracę. Jednak według osób zaznajomionych ze sprawą, najzdolniejszych wcale nie trzeba wiązać zapisami, bowiem najbardziej motywuje ich intensywna konkurencja z rywalami, a także własna ciekawość związana z nowymi możliwościami modeli AI.

W Meta członkowie TBD Lab, a więc nowi pracownicy, których zadaniem jest opracowanie firmowych modeli AI, pracują w pobliżu biurka Zuckerberga w siedzibie firmy w Menlo Park w Kalifornii. Warto jednak odnotować, że koncern pod koniec października poinformował o zwolnieniu 600 osób z zespołów skupionych na produktach sztucznej inteligencji i jej badaniu. Co istotne, redukcje nie dotknęły TBD Lab. Alexandr Wang, dyrektor ds. sztucznej inteligencji Meta, tłumaczy, że dzięki zmniejszeniu liczby specjalistów decyzje będą podejmowane szybciej, a każdy pracownik będzie miał większą odpowiedzialność, szerszy zakres obowiązków i większy wpływ na projekty. To, czego Alexandr Wang nie powiedział, ale czego można się spodziewać, to że w ślad za tym pójdzie wyższe wynagrodzenie.

Najbardziej intensywne okresy dla wielu pracowników przypadają podczas pracy

nad modelami lub nowymi produktami, kiedy czas pracy wykracza poza harmonogram „9-9-6” – od 9 rano do 9 wieczorem, sześć dni w tygodniu. Jeden z dyrektorów startupu żartobliwie określił ten harmonogram jako „0-0-2”, czyli od północy do północy, z dwugodzinną przerwą w weekendy. To zawrotne tempo dotyczy na ogół wąskiej podgrupy pracowników, z których większość próbuje poprawić podstawowe modele AI lub osadzić je w nowych produktach. Ich słabiej opłacani koledzy wracają do domu dużo szybciej. Jak tłumaczy Madhavi Sewak: „Masz te wszystkie dobre pomysły i wiesz, że to rywalizacja z czasem. Nie chcesz pozwolić, żeby pozostały one niezbadane, a więc kiedy masz wolny czas, pracujesz nad tym i gonisz za kolejnymi nowymi pomysłami”.

Są takie firmy w Dolinie Krzemowej, które pracują cały tydzień. W związku z tym niektóre z nich serwują swoim pracownikom jedzenie w weekendy. Stałą praktyką jest przy tym wyznaczanie często rotujących „kapitanów”, odpowiedzialnych za monitorowanie rozwoju produktu. „W poprzednich czasach boomu, takich jak dot-com pod koniec lat 90. lub przyspieszone przejście na urządzenia mobilne, gdy pojawił się iPhone, adopcja użytkowników miała miejsce przez dekadę lub dłużej. Ze sztuczną inteligencją jest inaczej, bo 90 procent firm z listy Fortune 500 już używa produktów AI, a więc po zaledwie kilku latach od jej pojawienia się. Czas między przełomami badawczymi a premierami produktów skompresował się z kilku lat w przeszłości do luki między czwartkiem a piątkiem” – mówi Aparna Chennapragada, CPO ds. doświadczeń AI w Microsofcie. Podstawowy problem polega na tym, że trudno jest zaplanować pracę ze względu na specyficzny rozwój nowych modeli – trudno jest przewidzieć, jak będą się zachowywać. „Proces bardziej przypomina ewolucję niż inżynierię. Często nie wiesz co wyjdzie z treningu. Nie wiesz też, co się wydarzy, dopóki tego nie przetestujesz. Nawet nie wiesz, co zrobi model, kiedy znajdzie się na wolności” – mówi Joshua Batson. Badacz porównuje przy tym intensywność obecnych doświadczeń do swojej pracy w laboratorium testowym podczas pandemii Covid-19, kiedy kierował pracą grupy międzynarodowych naukowców, której celem było zrozumienie trajektorii wirusa…

To już druga edycja wydarzenia poświęconego usługom zarządzanym, a zarazem potwierdzenie, że grono rodzimych Managed Service Providerów systematycznie rośnie w siłę.

Tegoroczny DAGMA MSP Day był wypełniony prezentacjami pokazującymi, jak aktywnie działać w modelu Managed Service Provider i wykorzystywać jego przewagi w stosunku do tradycyjnej sprzedaży. Menedżerowie z DAGMA Bezpieczeństwo IT podzielili się przy tym wiedzą, w jaki sposób, na bazie wielu produktów z portfolio spółki, można budować swoją konkurencyjność, tworząc dla klientów wyjątkowe na rynku pakiety usługowe. Wprowadzeniem do konferencji było przypomnienie najważniejszych powodów, dla których model MSP może być tak

W MSP ZBYT NISKIE MARŻE TO BŁĄD. NALEŻY ZACZYNAĆ OD RAZU Z WYŻSZYMI.

atrakcyjny i perspektywiczny dla partnerów. Po pierwsze, większość rozwiązań oferowanych w tym modelu opiera się na zasadzie pay-as-you-go. Daje to partnerom dużą elastyczność w sposobie rozliczeń z klientami oraz możliwość uzyskania wyższej marży w zależności od przyjętej strategii biznesowej. Drugim, niezwykle istotnym elementem jest agregacja – im większy wolumen zakupowy partnera u dystrybutora, tym korzystniejsze warunki handlowe. To mechanizm, który wprost przekłada się na zwiększenie rentowności biznesu.

Tomasz Janoś

Trzeba również podkreślić, że model MSP nie wymaga prowadzenia odrębnych projektów czy rozbudowanej dokumentacji. Proces wdrożenia jest szybki i intuicyjny, wystarczy uruchomić konsolę, dodać klientów oraz przypisać im odpowiednie plany ochrony.

Kolejną zaletą jest stabilność przychodów. Model MSP opiera się na cyklicznych rozliczeniach abonamentowych, co zapewnia przewidywalność finansową i ciągłość wpływów. DAGMA Bezpieczeństwo IT wystawia faktury w cyklach miesięcznych, natomiast sposób, w jaki partnerzy rozliczają się ze swoimi klientami może być w pełni dowolny i zależeć wyłącznie od ich polityki biznesowej.

Wreszcie nie można pominąć kwestii wygody zarządzania swoją ofertą. Jedna konsola, jedno logowanie i pełna widoczność wszystkich klientów pozwalają na sprawne monitorowanie oraz efektywne administrowanie usługami.

Większy potencjał MSP

Blok prezentacji produktowych obejmował te rozwiązania z portfolio DAGMA Bezpieczeństwo IT, które partnerzy mogą obecnie oferować swoim klientom w modelu usługowym. I co ciekawe, nie wszystkie z nich to tylko software. Owszem, trzy rozwiązania – Holm Security, Acronis i ESET – to platformy oparte na oprogramowaniu, ale czwarty produkt – od Stormshielda – to również sprzęt.

Dla zgromadzonych na konferencji partnerów ważne było to, że w przypadku każdego z nich menedżerowie katowickiej spółki wyjaśnili szczegółowo i na przykładach, jak model MSP może sprawić, by te oferty stały się bardziej atrakcyjne zarówno dla partnerów, jak i ich klientów.

Na pierwszy ogień poszło Holm Security, czyli nowoczesna platforma do zarządzania podatnościami. Może ona stanowić podstawę proaktywnej, opartej na ryzyku ochrony przed zagrożeniami, takimi jak ransomware czy phishing. Przy czym nie najniższa wcale cena dla klienta w przypadku tradycyjnej sprzedaży tego rozwiązania, może w jakimś stopniu ograniczać możliwości resellera. Co prawda w takim wariancie platforma daje klientowi możliwość wykonania nieograniczonej liczby skanowań podatności, ale tak naprawdę mało kto tego potrzebuje. Oferta robi się dla klientów znacznie bardziej atrakcyjna cenowo, gdy partner oferuje taką usługę wielu organizacjom w modelu MSP, w regularnych odstępach czasu skanując ich środowiska i pobierając za to opłaty z dobrą marżą. W przypadku ESET, który jest doskonale znanym, kompleksowym rozwiązaniem do ochrony punktów końcowych, wariant MSP wręcz znosi – w porównaniu z tradycyjną sprzedażą licencji – ograniczenia odnośnie do liczby kupowanych stanowisk. I tak w przypadku modelu resellerskiego pakiety Entry, Advanced i Complete są sprzedawane od 5 stanowisk, a jeżeli chodzi o pakiety Enterprise i Elite – 25 stanowisk. Za to w wariancie MSP, ESET można sprzedawać już od jednego stanowiska. Okazuje się to bardzo wygodne, gdy klientem jest bardzo mała organizacja – przykładowo kancelaria adwokacka – której będzie za-

leżeć na zaawansowanej ochronie z XDR. Można wtedy jej zaoferować pakiet Enterprise lub Elite już od kilku stanowisk.

Co do Acronisa, to trudno o platformę równie dobrze skrojoną pod świadczenie wielu usług w modelu MSP. Taką, która łączy wiele elementów cyberbezpieczeństwa w ramach jednej konsoli. Dzięki temu partner, jako dostawca usług, jest w stanie po jednym logowaniu zobaczyć, czy u jego klientów nic złego się nie dzieje. A jeśli w jednej konsoli widać wszystkich klientów i wszystkie z wielu technologii ochrony, które obejmuje platforma, nic dziwnego, że według DAGMA Bezpieczeństwo IT w przypadku Acronisa aż 80–90 proc. partnerów wybiera model MSP.

Także sprzętowy Stormshield UTM może być oferowany w formie usługi. Urządzenie jest udostępniane w kilku wariantach w ramach miesięcznych opłat. Partnerzy oferujący tego typu ochronę jako usługę, mogą to robić w różnych scenariuszach. Poprzez umieszczenie urządzenia UTM u każdego swojego klienta, bądź w oparciu o rozwiązanie działające u siebie, które zdalnie filtruje ruch klientów.

Ważnym elementem wydarzenia był panel dyskusyjny, w którym udział wzięli zarówno ci partnerzy, którzy od dawna oferują usługi w modelu MSP, jak i ci, którzy zdecydowali się na to dopiero niedawno, po poprzednim DAGMA MSP Day. Dzieląc się doświadczeniami, zarówno pierwsi, jak i drudzy wskazywali na duże ułatwienie procesu sprzedaży i wdrażania rozwiązań.

– Już wcześniej, bo od 2014 roku, świadczyliśmy usługi outsourcingowe. Dopiero niedawno dowiedzieliśmy się, że jest taki model, jak MSP. I on całkowicie odmienił u nas sposób sprzedaży oprogramowania – tłumaczył Daniel Kubica z IT-Logic.

Partnerzy chwalili znacznie większą elastyczność systemu licencjonowania w przypadku usług.

– Już w przypadku małych środowisk, 5–10 komputerów, a nawet jednej licencji mogę oferować klientowi XDR-a. Wtedy poziom

Paweł Jurek, Business Development Director, DAGMA Bezpieczeństwo IT

Wprzypadku Acronisa czy ESET udostępniamy ofertę MSP jako Pay as you go, czyli partnerzy mogą rozpocząć taki biznes w zasadzie od zerowych zobowiązań. A często partner nie chce mieć obowiązku stałych opłat, jeśli nie wie, jak mu pójdzie. Dlatego chcemy eliminować takie problemy na starcie. Mówimy partnerom, że mamy dla nich model, w którym zaczną nam płacić wtedy, gdy sami zaczną zarabiać. Kolejną rzeczą jest maksymalne uproszczenie działalności. Wyobraźmy sobie taką sytuację, w której partner dowiaduje się u klienta o możliwości zrobienia biznesu, po czym najpierw musi zgłosić ten temat, zarejestrować go, zaraportować wszystko u dystrybutora itd. W przypadku naszej oferty MSP w ogóle nie musi się tym zajmować. Dlatego ci partnerzy, którzy zaczęli według tego modelu pracować, widzą jak dużo czasu oszczędzają. Mają swój cennik, a zatem z góry wiedzą, ile to będzie klienta kosztować.

Mogą przy tym dowolnie kształtować swoją marżę. Przy czym już w trakcie jednej wizyty mogą podpisać kontrakt z klientem, uruchomić mu ochronę, dajmy na to 10 stacji roboczych i na koniec miesiąca podesłać fakturę.

Sprzedaż usług MSP rośnie w naszym przypadku bardzo dynamicznie. To wzrost, który w dużej mierze napędzają nasi partnerzy, bo przecież my nie funkcjonujemy w oderwaniu od nich. To właśnie oni stanowią siłę napędową całego tego ekosystemu, przesuwając rynek resellerski w stronę modelu MSP. W tym tradycyjnym resellerzy sprzedają licencje i zakładają projekty, co bywa czasochłonne, a jednocześnie mało elastyczne. Natomiast model MSP daje im swobodę, elastyczność i pełną dowolność odnośnie do tego, jak partner świadczy swoje usługi. W tym celu nie musi realizować projektów, działając znacznie sprawniej. W minionym roku wielu partnerów zaczęło przechodzić z klasycznego modelu sprzedaży licencji na model MSP. Widzą bowiem, że ich klienci oczekują dziś czegoś więcej. W sprzedaży tradycyjnej dostarcza się licen-

Mateusz Bielas, Product Manager Acronis, DAGMA Bezpieczeństwo IT

cje i często kontakt z klientem kończy się na dłuższy czas, zwykle do momentu odnowienia. Tymczasem obecnie klienci oczekują wartości dodanej, podobnie jak partnerzy oczekują jej od nas. My wspieramy partnerów, a klienci oczekują podobnego wsparcia od swoich resellerów – chcą, aby oprócz samej licencji dostali także wdrożenie, obsługę i opiekę.

bezpieczeństwa u takiego klienta zwiększa się znacząco, a jednocześnie ja nie mam progu wejścia – mówił Piotr Owczak z Libero. Wątek braku progu wejścia i ułatwionego w ten sposób rozwijania działalności przewijał się w całej debacie.

– Wcześniej, w ramach etatu, byłem kimś, kto wdraża różne rozwiązania w firmach. Ale zauważyłem, że model MSP może otworzyć mi drogę do własnej działalności. I rzeczywiście, doprowadził mnie do niezależności i wystartowania ze swoim biznesem – mówił Kamil Giemza z KeyGate IT.

Dyskutanci wskazywali też, jak dużą zaletą jest posiadanie wszystkich klientów w jednej konsoli – bez konieczności przelogowywania się, uruchamiania dedykowanych połączeń itp. O tym, że MSP sprawdza się, niech świadczy fakt, że kiedy rozmówcy mieli znaleźć jakieś wady tego modelu czy popełniane w jego oferowaniu błędy, w zasadzie tylko jeden z nich pokusił się o to. – W moim przypadku to były zbyt niskie marże na samym początku. Zalecam zacząć od razu z wyższymi – stwierdził Robert Krymarys z WeLikeIT.

Choć polski rynek software house’ów wciąż rośnie, towarzyszy temu spadek marż – wynika z pierwszego w Polsce raportu na temat rynku sektora SH, zaprezentowanego podczas tegorocznej edycji Upgrade.

Tomasz

Gołębiowski

BĘDĄ OD OPROGRAMOWANIADOSTAWCÓW ŻĄDAĆ WIĘKSZEJ EFEKTYWNOŚCI

W DZIAŁANIU.

leksander Vuković, były trener i piłkarz Legii Warszawa, podsumował kiedyś sytuację stołecznego klubu stwierdzeniem, że „w Legii nigdy nie jest tak dobrze jak podają media, ani tak źle, jak podają media”. Pasuje ono bardzo dobrze do wyników analizy, jakiej dokonali specjaliści SH Advisory, bazując na danych finansowych ponad 940 software house’ów („Polski rynek usługowego dostarczania oprogramowania – analiza 2025”). Okazuje się, że w 2024 r., w wartościach bezwzględnych doszło do wzrostu przychodów całej branży o ponad 7,4 proc. rok do roku. W tym czasie 62 proc. spośród badanych software house’ów zanotowało wzrost przychodów, zaś 54 proc. osiągnęło wzrost zysków. Typowy (mediana) software house w Polsce wygenerował w ubiegłym roku około 19 mln zł przychodu, osiągając niecały 1 mln zł zysku netto, przy marży zysku netto na poziomie 4,7 proc. (co

stanowiło 0,2 p.p. mniej niż w roku 2023). Średni przychód był jednak ponad dwukrotnie wyższy i wyniósł ponad 48 mln zł (średni zysk to 3,6 mln zł).

Autorzy badania zwracają uwagę, że różnica między średnią a medianą pokazuje, że polska branża SH jest ogromnie zróżnicowana, a przy tym zdominowana przez niewielką grupę dużych graczy. Co ciekawe, wśród dużych firm z tego segmentu (o obrotach powyżej 100 mln zł) jest grupa kilku dominatorów (Sii, Epam, Comarch, Asseco), którzy przez swoją skalę nawet w ujęciu jednostkowym istotnie wpływają na średnie wyniki nie tylko dla całej grupy 943 badanych podmiotów, ale również w gronie spółek o przychodach przekraczających poziom 200 mln zł.

– Ten rynek normalnieje albo wręcz już się stał normalnym rynkiem, czyli takim, który podlega wahaniom koniunktury. Jak wiadomo, praktycznie od powstania w Polsce ten sektor cieszył się sporymi wzrostami, które wynikały głównie z nadwyżki popytu nad podażą dzięki arbitrażowi cenowemu, z czasem uzupełnionemu o percepcję wysokiej jakości usług dostarczanych przez polskich programistów. Taki stan nigdy nie trwa wiecznie, bo koszty i ceny rosną, jak też pojawia się równie skuteczna konkurencja. Polskie software

house’y muszą się do tej sytuacji dostosować – mówi Przemysław Soroka, partner w SH Advisory.

Dodaje przy tym, że widać wciąż ogromne zainteresowanie zarówno rodzimych, jak i zagranicznych podmiotów inwestycjami w polski sektor SH. To pozytywny sygnał, jeśli chodzi o kondycję tej branży. Jednocześnie obie strony, a więc inwestorzy i właściciele, pogodzili się z niższymi wycenami.

– Wcześniej, gdy rynek rósł, myślano w kategoriach „the only way is up” i stąd wyceny były wysokie, czemu pomagał niski koszt pieniądza. Jednak te najbardziej atrakcyjne spółki nadal mogą liczyć na solidne wyceny, przekraczające 10-krotność wskaźnika EBITDA – przyznaje Przemysław Soroka.

O tym, że przyszłość jest niepewna i jak się przygotować na dalszy rozwój wydarzeń, żywiołowo dyskutowano podczas Upgrade’25 w gronie wybitnych specjalistów i menadżerów, zaproszonych do podwrocławskiego Zamku Topacz przez stowarzyszenie ITCORNER. Jak podkreśliła Karolina Charewicz-Jakubowska, CEO organizacji zrzeszającej ponad 80 firm technologicznych: „stare scenariusze działania odchodzą w przeszłość, a nowe technologie już nie wystarczą do odniesienia sukcesu – dziś przewagę ma ten, kto potrafi zmieniać swój sposób myślenia o biznesie”. W podobnym tonie wypowiadało się wielu uczestników wydarzenia.

– Nasza branża wchodzi w fazę niepewności. Nie mamy jeszcze odpowiedzi na szereg

nowych pytań, zwłaszcza w kontekście AI, która zdaje się być największym czarnym łabędziem w historii sektora SH – mówił Tomasz Woźniak, do niedawna CEO Future Mind (podczas Upgrade’25 ogłosił swoją decyzję o przekazaniu sterów w ręce Tomasza Koperskiego i przejściu do rady nadzorczej).

Choć już teraz część firm deklaruje zaawansowane prace nad rozwojem korzystnych dla użytkowników końcowych rozwiązań na bazie AI, to jednocześnie takie produkty są często traktowane przez przedsiębiorców w charakterze „entertainment tools”, które mogą się przydać, ale nie są niezbędne z punktu widzenia rozwoju biznesu. Z drugiej strony część branży z niepokojem obserwuje inicjatywy w rodzaju nowej funkcji, o jaką OpenAI chce rozszerzyć ChataGPT, która umożliwia robienie zakupów bez konieczności odwiedzania stron sprzedawców. Jeśli pomysł „wypali”, może się to wiązać ze zmniejszeniem popytu w sektorze e-commerce na nowe aplikacje, co uderzyłoby w interesy działających na tym rynku software house’ów. W ocenie specjalistów SH Advisory, wpływ AI na sektor software house’ów będzie wieloraki. Przykładowo, klienci będą od dostawców oprogramowania żądać większej efektywności w działaniu, a przy tym lepszego rozliczania czasu – już teraz jedną z obaw wyrażanych przez klientów jest to, że płacą „dużo” za coś, co „AI zrobi w kilka minut”. Ponadto użytkownicy biznesowi będą oczekiwać dostarczania rozwiązań o znacznie wyższej jakości, skoro „nie marnuje się czasu na kodowanie prostych rzeczy dzięki AI”. To z kolei rodzi pytanie o to, czy software house’y powinny zajmować się również doradztwem biznesowym. Przeciwnicy takiego podejścia argumentują, że SH co do zasady są ekspertami we własnej dziedzinie, czyli dostarczaniu oprogramowania,

nie dysponując know-how w zakresie doradztwa biznesowego. Z drugiej strony, według ekspertów SH Advisory, trudno będzie w dzisiejszych czasach sprzedawać systemy i jednocześnie abstrahować od kontekstu oraz sensu biznesowego, jaki za nimi stoi, jak też wartości biznesowej, jaką ze sobą niosą.

Trudno też abstrahować od faktu, że usługa doradcza często oznacza wyższą od standardowej marżę w procesie dostarczania oprogramowania i oddawanie tej części projektu innym dostawcom czy firmom doradczym, wydaje się działaniem wbrew własnemu interesowi ekonomicznemu.

Powrót do korzeni

Tymczasem na horyzoncie mogą pojawić się kolejne tzw. czarne łabędzie. Jak wyraził się Tomasz Muter, współzałożyciel Droids on Roids: „Dziś AI, jutro komputery kwantowe, a potem, kto wie, może AGI”. Uczestnicy Upgrade’25 zgodzili się, że w obecnych czasach należy – poza śledzeniem i rozwojem najnowszych technologii – skoncentrować swoje działania na podstawach biznesu, a przede wszystkim rozmawiać z klientami, budując z nimi możliwie mocne relacje.

Grzegorz Rudno-Rudziński, Managing Partner w Univio, podkreślał w powyższym kontekście, że sprzedaż i doradztwo

dotyczy nie tyle firm, co pracujących w nich konkretnych ludzi, na nich więc należy skupić swoją uwagę. Tym bardziej, że zdecydowana większość członków ITCORNER-a jest zdania, że nie ma sensu czekanie na powrót koniunktury, jaką sektor SH cieszył się przez minioną dekadę. – Ludzie postrzegają spółki IT jako bardzo solidne biznesy, a często to dość wrażliwe podmioty, które po utracie klienta przynoszącego im 40 procent przychodów stają na granicy przetrwania. Trzeba mieć tego świadomość i przygotować się na możliwe turbulencje. Moim zdaniem, na tak zwany koniec dnia sprowadza się to do jak najlepszego rozumienia potrzeb klientów i bliskości z nimi.

To właśnie jest w tym wszystkim najważniejsze, niezależnie od okoliczności – podsumowuje Kamil Tatol, CEO Flying Bisons. Pełna treść raportu „Polski rynek usługowego dostarczania oprogramowania – analiza 2025” jest dostępny pod adresem www.shadvisory.eu.

Ewolucja branży IT, z którą mamy obecnie do czynienia, dotyczy wyjątkowo wielu obszarów i stawia pod znakiem zapytania dotychczasowe modele biznesowe.

Tomasz Gołębiowski, Barcelona

Ponad tysiąc producentów, dystrybutorów i integratorów, którzy wzięli udział w Canalys Forums EMEA 2025, zgodziło się co do dwóch kwestii. Pierwsza dotyczy trudności z budową portfolio produktów i usług bazujących na AI. W tej sytuacji, jeśli nie wiemy, co zaproponować klientom, zacznijmy od siebie. Druga kwestia to kłopot z ustaleniem strategii rozwoju w dobie nakładających się na siebie wielu zmiennych. W takim przypadku, gdy „mgła rynkowej wojny” ogranicza nam widoczność, warto zwiększyć nacisk na budowanie trwałych relacji z klientami i dogłębną znajomość ich potrzeb.

WIELU Z NAJLEPSZYCH PARTNERÓW MICROSOFTU PRZESZŁO

Z MODE LU TRANSAKCYJNEGO NA USŁUGI ZARZĄDZANE.

W pozostałych sprawach, jakimi obecnie żyje ekosystem partnerski branży IT, pytań jest znacznie więcej niż klarownych odpowiedzi. Dlatego hasło „Opportunity in Uncertainty”, pod jakim przebiegało tegoroczne Canalys Forums

EMEA, bardzo dobrze oddaje moment dziejowy, w jakim znajduje się obecnie rynek IT.

– Branża technologiczna pozostaje najlepiej rozwijającym się sektorem światowej gospodarki. Jednocześnie przechodzi jedną z epokowych transformacji w kilku różnych obszarach. Jednym z nich jest rynek hiperskalerów, który w w yniku szybkiego rozwoju dostawców typu neoclouds zaczyna się rozwarstwiać – podkreśla Steve Brazier, założyciel Canalys (obecnie Omdia).

W ten sposób nawiązał do tego, że niewątpliwym liderom w postaci AWS, Google Cloud i Microsoftu, zaczynają coraz mocniej deptać po piętach tacy dostawcy, jak CoreWeave, Paperspace, Nebius czy Lambda Labs (przy czym nowych graczy wciąż przybywa). „Nowochmurowcy” przyciągają klientów

Analitycy Omdia przewidują, że do 2028 roku...

l …20 proc. dystrybutorów zostanie przejętych, skonsoliduje się lub zakończy działalność;

l …aż 25 proc. partnerów w branży IT to będą debiutanci (niespełna 5 lat działalności);

l …ponad połowie transakcji na marketplace’ach będą towarzyszyć usługi świadczone przez f irmy z ekosystemu

partnerskiego (dobra wiadomość dla partnerów!);

l …50 proc. ataków ransomware będzie kierowanych na sieci OT i łańcuchy dostaw, co może zachwiać ciągłością działania branży logistycznej oraz produkcyjnej;

l …o połowę wzrosną koszty ubezpieczeń w sektorach, które są najbardziej zagrożone cyberatakami.

optymalizacją kosztów i wydajności poprzez ustawienie wszystkich procesorów konkretnie pod zastosowania AI. Łączne tegoroczne inwestycje w rozwój infrastruktury w sektorze neoclouds mają wynieść 181 mld dol., podczas gdy hiperskalerzy wyłożą na ten cel 361 mld dol. To nadal znacząca różnica, ale jednak nie mamy już do czynienia z przepaścią.

Biznes w cieniu „shadow AI”

Za szalonym tempem inwestycji w infrastrukturę wspierającą rozwój AI, nie idzie wcale przekonanie co do miejsca, w które nas ten rozwój doprowadzi. Na razie pewne jest to, że choć konsumenci korzystają z generatywnej sztucznej inteligencji na masową skalę, to inaczej rzeczy się mają z użytkownikami biznesowymi. Ze zrozumiałych zresztą powodów, do których zaliczają się wątpliwości odnośnie do precyzji uzyskiwanych wyników, jak też problem z bezpieczeństwem danych. Towarzyszącym temu wyzwaniem jest „shadow AI”, a więc wykorzystywanie przez pracowników narzędzi GenAI w celach służbowych przy pomocy prywatnych urządzeń.

W tej sytuacji coraz więcej firm IT idzie za radą Rezy Honarmanda, który uważa, że optymalną strategią jest wdrażanie rozwiązań AI najpierw na własne potrzeby. Z danych Omdia wynika, że tak właśnie robi ponad 45 proc. firm part -

nerskich. Przy czym, choć nie należy zwlekać z decyzjami w tym zakresie, to „pociąg” możliwości jeszcze nie odjechał.

– Przed nami 7–8 lat szans na rozwój, to się nie stanie z dnia na dzień – uspokaja Senior Vice President w TD Synnex.

Warto przy tym zwrócić uwagę na pozytywny wpływ, jaki rozwój AI wywiera na rynek sprzętu. Jak ujął to Jay McBain, Chief Analyst w Omdia: „każdy dolar wydany na software, to drugi dolar wydany na hardware”.

Sektor MSP pod presją

Drugim sposobem na wzmocnienie swojej pozycji rynkowej jest model usług zarządzanych. W dłuższej perspektywie zapewnia stabilne przychody i ułatwia utrzymanie klienta na konkurencyjnym rynku. Ponadto jest już dobrze zdefiniowany i wspierany przez coraz większą grupę producentów i dystrybutorów.

– Wielu z naszych najlepiej prosp erujących partnerów przeszło z mo delu transakcyjnego na świadczenie usług zarządzanych – mówi Bart van der Knaap, General Manager EMEA Channel w Microsoftcie.

Jednak również ten sektor rynku zmaga się obecnie z nowymi wyzwaniami. Nowe rządowe regulacje, choć wzmacniają popyt na usługi zarządzane, śrubują wymagania sprzętowo-programowe, komplikując providerom skuteczną opiekę na systemami swoich klientów. Wiąże się to z rosnącymi wymogami ze strony firm z sektora cyberubezpieczeń wobec Managed Service Providerów, a jednocześnie stawki polis systematycznie rosną. Jednym z przykładowych powodów odmowy wypłacenia odszkodowania jest „shadow IT”. Jeśli, dajmy na to, wyciek danych firmowych nastąpił podczas urlopu pracownika, który na prośbę szefa wysłał mu ważny raport ze swojej prywatnej komórki, ubezpieczyciel uzna, że procedury bezpieczeństwa były niewystarczające.

Niemniej globalny rynek MSP rośnie w tempie dwucyfrowym, choć – jak podkreśla Robin Ody, Practice Leader w Omdia – niemało, bo 23 proc. dostawców usług zarządzanych nie uzyskuje regularnych profitów z tego tytułu. Jednocześnie, wśród aktualnych trendów w ekosystemie partnerskim na czoło wysuwają się takie zmiany w programach partnerskich, w efekcie których producenci coraz bardziej koncentrują się na swoich kluczowych partnerach. Wpisuje się w to niedawna decyzja Microsoftu dotycząca limitu minimum 30 mln dol. przychodów w regionie dla każde-

każdy z naszych projektów

większość z naszych projektów

mniejszość naszych projektów

żaden z naszych projektów

go dystrybutora. To oznacza, że z gigantem z Redmond pożegna się około… 2/3 jego autoryzowanych dystrybutorów, co kojarzy się z nie tak dawnym casusem partnerów VMware’a po przejęciu tegoż przez Broadcoma. Tymczasem, jak podkreśla Jay McBain, mniejsi partnerzy i dystrybutorzy to często wyspecjalizowani gracze obsługujący konkretne nisze. Odcinając takich partnerów, traci się dostęp do określonego segmentu rynku.

Lepsze wyniki (mimo wszystko)

Niezależnie jednak od rynkowych turbulencji, jak wynika z danych Omdia, w sumie 67 proc. spośród 180 tys. partnerów działających w regionie EMEA, przewiduje, że ich tegoroczne wyniki będą lepsze od uzyskanych w 2024 r. Biorąc pod uwagę obecny krajobraz całego rynku, należy to chyba uznać za pozytywną informację. Choć dla pozostałych 33 proc. to żadne pocieszenie.

Polski rynek centrów danych dynamicznie rośnie i ma spory potencjał do dalszego rozwoju. Ale, aby utrzymać tempo wzrostu inwestycji, potrzebne jest pokonanie barier związanych z zasilaniem i wsparcie regulacyjne.

Krzysztof Pasławski

Konferencja Data Center Nation 2025 w Warszawie zgromadziła blisko 1 tys. uczestników – operatorów centrów danych, inwestorów, dostawców infrastruktury, firm technologicznych, doradców z sektora nieruchomości, firm budowlanych i instytucji publicznych. W strefie wystawienniczej zaprezentowało się kilkudziesięciu dostawców, a program obejmował ponad 25 sesji i paneli dyskusyjnych. Omawiano wyzwania i kierunki rozwoju branży centrów danych w Polsce i regionie Europy Środkowo-Wschodniej. Tematyka konferencji koncentrowała się wokół czterech zagadnień: transformacji energetycznej, rozwoju infrastruktury cyfrowej, roli regulacji i polityki państwowej i wpływu nowych technologii – w tym sztucznej inteligencji i tzw. neocloudów – na popyt na usługi data center. – Tegoroczna edycja DCN Warsaw potwierdziła, że polski rynek dojrzewa i za-

czyna pełnić rolę regionalnego lidera. Obok dynamicznego napływu inwestycji w infrastrukturę cyfrową, coraz większą wagę przywiązuje się do efektywności energetycznej, zrównoważonego rozwoju oraz kompetencji inżynierskich – komentuje Paweł Olszynka, Market Research Director w PMR Market Experts, który moderował jeden z paneli.

Jak podkreślali uczestnicy konferencji, Polska stoi przed ogromną szansą, by stać się strategicznym cyfrowym hubem Europy Środkowo-Wschodniej – jednakże pod warunkiem odpowiedniego wsparcia instytucjonalnego i energetycznego.

Dla inwestorów kluczowe znaczenie ma wzrost gospodarczy Polski i solidne fundamenty makroekonomiczne. Atutem naszego kraju jest też potencjał inżynierski. W oczach zagranicznych graczy uwiarygodniły nas regiony chmurowe najwięk-

szych hiperskalerów, co potwierdziło że w Polsce warto inwestować Aby nasz kraj mógł lepiej wykorzystać swoje szanse na rynku centrów danych, potrzebne są jednak ułatwienia regulacyjne – wynika z dyskusji podczas panelu poświęconego przyszłości polskiego rynku.

– Dyskusja pokazała, że kluczowym czynnikiem dalszego rozwoju będzie współpraca sektora prywatnego z administracją, szczególnie w obszarach regulacji, dostępności energii i planowania przestrzennego i nadania centrom danych statusu obiektów o krytycznym znaczeniu dla infrastruktury państwa – mówi Paweł Olszynka.

Ograniczenia mocy przyłączeniowych niezmiennie stanowią wąskie gardło inwestycji w data center w kraju. Stąd wielu prelegentów podkreślało, że rozbudowa infrastruktury energetycznej jest konieczna dla utrzymania dynamiki inwestycji. Istotna jest przy tym transformacja w stronę OZE, ponieważ decyzje inwestorów coraz częściej zależą od dostępności stabilnych i „zielonych” źródeł zasilania. Tym niemniej nasz kraj z roku na rok ma coraz lepszy miks energetyczny i jest tylko kwestią czasu, kiedy pochodzenie energii przestanie być problemem – wynika z jednej z dyskusji. Zaznaczano również, że pochodzenie energii, choć ważne, z punktu widzenia przedsiębiorców ustępuje miejsca cenie i bezpieczeństwu oraz ciągłości zasilania.

AI zmienia projekty centrów danych

Podczas panelu poświęconego chłodzeniu cieczą podkreślano, że rozwój AI zmienia sposób projektowania, budowy i obsługi centrów danych. Przy tym do

najważniejszych wyzwań należy odprowadzanie ciepła. Przykładowo pojedyncza szafa AI może obecnie przekraczać 140 kW, a prognozy mówią o 1 MW na szafę. W tej sytuacji systemy chłodzenia powietrzem już nie wystarczają. Przewiduje się więc skokowy wzrost rynku chłodzenia cieczą. Według Omdia globalne wydatki na ten cel zwiększą się 6-krotnie w ciągu najbliższych 5 lat, z poziomu 1,9 mld dol. w 2024 r. do 10,3 mld dol. w roku 2029.

Wśród dostawców, którzy przygotowują się do tej zmiany, jest Schneider Electric. Na początku 2025 r. producent ten przejął Motivair, dostawcę specjalizującego się w produkcji systemów wydajnego chłodzenia.

– Obciążenia AI generują ponad 10 razy więcej ciepła niż konwencjonalne serwery. W porównaniu z powietrzem, woda absorbuje 4 razy więcej ciepła na gram, co czyni ją znacznie lepszym medium chłodzącym –zaznacza Claudia Cantarello, Business Developer Schneider Electric ds. chłodzenia cieczą w Europie.

Dodaje przy tym, że chłodzenie może pochłaniać nawet 40 proc. budżetu energetycznego centrum danych, a chłodzenie cieczą jest nawet 3 tys. razy bardziej efektywne niż wykorzystywanie w tym celu powietrza.

Michał Redlich, wiceprezes, FAST Group

Wmojej ocenie to nie pojedyncze czynniki napędzają rynek centrów danych, lecz sam jego szybki wzrost staje się katalizatorem zmian. Coraz więcej firm i instytucji chce uczestniczyć w tym segmencie gospodarki, choć często brakuje im pełnego spojrzenia, kompetencji i doświadczenia. Obserwujemy rosnącą złożoność projektów, zwłaszcza w infrastrukturze krytycznej – serwerownie są coraz większe i muszą spełniać coraz bardziej restrykcyjne wymagania. Dobrym przykładem jest obiekt Polskich Sieci Energetycznych w Radomiu o wartości 0,5 mld zł, który nasza firma ukończyła niedawno w konsorcjum z PORR. W sektorze prywatnym także widoczne jest ogromne zainteresowanie.

Część inwestorów działa spekulacyjnie, ale są podmioty gotowe do kompleksowego rozwoju projektów. Dodatkowym akceleratorem jest sztuczna inteligencja – jeszcze niedawno mówiliśmy o inwestycjach rzędu 2–20 MW, a dziś dyskusje toczą się wokół mocy od 50 do nawet 500 MW.

Podczas panelu dotyczącego suwerenności sztucznej inteligencji dyskusja koncentrowała się na tym, jak suwerenność AI kształtuje krajobraz technologiczny Europy i jakie ma to znaczenie dla Polski. Wraz z Romanem Siodą z Nvidii i Piotrem Kowalskim z PLDCA/Beyond, analizowaliśmy powiązania między technologią, energią i polityką. Suwerenność AI jest obecnie kwestią strategii krajowej – rządy inwestują w gigafabryki AI i infrastrukturę obliczeniową o wysokiej wydajności, aby zabezpieczyć lokalne moce przerobowe na potrzeby lokalnych firm. Zaczyna się to od inicjatyw na mniejszą skalę, ale wkrótce przekształci się w pełnowymiarowe fabryki AI, zdolne do produkcji i zarządzania modelami AI na poziomie krajowym. Sukces Europy w erze AI będzie za-

Igor Grdic, Regional Director – Central Europe, Vertiv

leżał od tego, jak zbuduje ona fizyczny i energetyczny „szkielet inteligencji” – centra danych, systemy zasilania i technologie chłodzenia, które umożliwiają rozwój AI. Oprócz idei, AI opiera się na infrastrukturze, a to właśnie ta infrastruktura zdefiniuje konkurencyjność kontynentu w nadchodzącej dekadzie.

Tegoroczna edycja DCN Warsaw była, jak dotąd, zdecydowanie największa – zgromadziła ponad 950 uczestników reprezentujących ponad 400 firm i instytucji z 32 krajów. To wyraźnie pokazuje, jak szybko Polska i region Europy Środkowo-Wschodniej zyskują na znaczeniu na europejskiej mapie centrów danych. Tegoroczne dyskusje koncentrowały się głównie na sztucznej inteligencji, zaopatrzeniu w energię, suwerenności danych i zrównoważonym rozwoju – kluczowych trendach kształtujących dzisiejszą transformację branży. Potwierdziło to również, że DCN Warsaw jest platformą referencyjną dla wymiany wiedzy i współpracy liderów rynku, w tym inwestorów, operatorów, decydentów oraz łańcucha dostaw usług i produktów dla centrów danych. Naszym celem jest, aby DCN Warsaw pozostało nie tylko największym i najważniejszym wyEwa Napiórkowska, Market Development Manager, Data Center Nation

darzeniem w branży centrów danych w regionie Europy Środkowo-Wschodniej, ale także tym, które rok po roku inspiruje do współpracy, rozwoju i innowacji.

Potrzebna jest „strategia wymiany”

INFRASTRUKTURA

DATA CENTER TO FUNDAMENT

CYFROWEJ GOSPODARKI.

Istotna jest też koordynacja etapu konstrukcyjnego i projektowego oraz zaangażowanie jednostek odpowiedzialnych za operacje już na etapie projektowania centrum danych. Istotne staje się przygotowanie „strategii wymiany”. Chodzi o to, iż centrum danych buduje się na 20 lat i w tym czasie co najmniej część urządzeń trzeba będzie wymienić. Już w trakcie projektowania należy więc upewnić się, czy będzie można zastąpić starszy sprzęt nowym bez zatrzymywania pracy centrum danych.

– Infrastruktura data center to fundament cyfrowej gospodarki. Polska dzięki transformacji energetycznej, strategicznemu położeniu i rosnącej kadrze inżynierskiej, ma wyjątkowy potencjał, by przyciągać inwestycje w nowoczesne centra danych. To szansa na stworzenie silnego ekosystemu innowacji, od startupów AI po technologie kwantowe, a tym samym umocnienie pozycji Polski jako lidera zrównoważonej infrastruktury cyfrowej w regionie – podkreśla Adam Ponichtera, Country Managing Director Poland Data4 Group i wiceprezes Polish Data Center Association.

„Współpraca między globalnymi dostawcami a lokalnymi ekspertami będzie kluczowa dla przyspieszenia transformacji Polski w kierunku cyfrowej gospodarki opartej na AI” – mówi Igor Grdic, dyrektor regionalny Vertiv na Europę Środkową.

Zacznijmy od tego, w jakim miejscu znajduje się polski rynek centrów danych?

Polska stała się regionalnym centrum rozwoju centrów danych w Europie Środkowo-Wschodniej. Po chwilowym spowolnieniu, podczas którego inwestorzy oczekiwali na wyjaśnienie trendu przejścia od tradycyjnych obciążeń chmurowych do modeli opartych na sztucznej inteligencji, obserwujemy ponowny wzrost. Jego kolejna faza będzie napędzana przez sztuczną inteligencję i obliczenia o wysokiej gęstości, co doprowadzi do powstania tzw. fabryk AI – centrów danych zaprojektowanych specjalnie do trenowania sztucznej inteligencji i wnioskowania. Projekty te będą coraz częściej wykraczać poza Warszawę, w zależności od dostępnej mocy energetycznej i gotowości infrastruktury.

Jakie są mocne strony naszego, lokalnego rynku?

Warto zaznaczyć, że Polska ma drugą co do wielkości sieć ciepłowniczą w Europie, co stwarza wyjątkowe możliwości synergii przemysłowej, ponownego wykorzystania energii i poprawy efektywności wykorzystania zasobów. W połączeniu z inwestycjami w infrastrukturę energii odnawialnej i wsparciem rządowym dla cyfryzacji, Polska staje się jednym z najbardziej obiecujących rynków centrów danych w Europie. Największe wyzwania prawdopodobnie będą związane z dostępnością energii i mocą sieci, ale są to również obszary, w których innowacje mogą odblokować wzrost. Centra danych będą coraz częściej podążać za energią, czyli do regionów z dostępem do sieci, odnawialnymi źródłami energii i efektywnymi strategiami ponow-

INWESTUJĄCY W KOMPETENCJE GOTOWE NA AI.

nego wykorzystania ciepła. Transformacja energetyczna Polski i jej rozbudowana infrastruktura ciepłownicza stwarzają więc wyjątkową szansę na przekształcenie zrównoważonego rozwoju w przewagę konkurencyjną.

Jakie rozwiązania cieszą się największym popytem na polskim rynku? Wraz ze wzrostem gęstości i dynamiki obciążeń, popyt przesuwa się w kierunku wydajnej infrastruktury zasilania i chłodzenia. Dla Vertiv oznacza to dostarczanie rozwiązań infrastrukturalnych o znaczeniu krytycznym: systemów zasilania, zarządzania ciepłem, prefabrykowanych modułowych centrów danych oraz zintegrowanych systemów monitorowania i sterowania. Prefabrykowane rozwiązania modułowe zyskują na popularności w Polsce, ponieważ umożliwiają szybsze wdrożenie, przewidywalną wydajność i skalowalność. Są to kluczowe czynniki w obecnym cyklu, napędzanym przez sztuczną inteligencję. Widzimy, że zarówno klienci hiperskalowi, jak i korporacyjni przygotowują swoją infrastrukturę pod kątem AI i przetwarzania brzegowego. Partnerstwa między globalnymi dostawcami technologii a lokalnymi integratorami będą odgrywać jeszcze bardziej strategiczną rolę w najbliższej przyszłości.

Jak rozwój sztucznej inteligencji zmienia centra danych?

Związana z tym zmiana konstrukcji i działania data center jest wręcz fundamentalna. Środowiska chłodzone powietrzem ewoluują w kierunku architektur chłodzenia cieczą – w tym systemów bezpośrednich do układu scalonego (direct-to-chip) i systemów immersyjnych, aby poradzić sobie z emisją ciepła generowaną przez procesory graficzne nowej generacji. Przykładowo, szafy rack AI wyposażone w najnowsze GPU NVIDIA mogą osiągać moc 130–150 kW na szafę, a wkrótce na-

wet 300 kW. Bezpieczne i efektywne zarządzanie tą gęstością wymaga nowego podejścia zarówno w systemach zasilania, jak i chłodzenia. Vertiv odgrywa kluczową rolę w umożliwieniu tej transformacji. Projektujemy i produkujemy infrastrukturę szkieletową, która zasila, chłodzi i łączy obciążenia AI – od jednostek dystrybucji chłodzenia cieczą (CDU) i inteligentnych systemów szyn zbiorczych po prefabrykowane modułowe bloki mocy. Nasza koncepcja Vertiv OneCore umożliwia szybkie wdrażanie infrastruktury gotowej do obsługi AI na dużą skalę. Została już wykorzystana w wielu europejskich projektach, takich jak inicjatywa Polar w Norwegii.

Jaka, w takim razie, będzie rola partnerów w kanale sprzedaży na rynku centrów danych?

Lokalni partnerzy są niezbędni dla modelu biznesowego Vertiv i rozwoju polskiego ekosystemu centrów danych. W miarę, jak projekty stają się coraz bardziej złożone, polegamy na partnerach posiadających bogate doświadczenie w dziedzinie elektryki i mechaniki – takich, którzy są w stanie uczestniczyć w realizacji projektu, instalacji i uruchomieniu kluczowych systemów. Vertiv utrzymuje globalne umowy z głównymi dostawcami hiperskalerów i usług kolokacji, ale w projektach korporacyjnych współpracujemy z lokalnymi partnerami. To podejście zapewnia elastyczność i szybkość reagowania na potrzeby klientów przy jednoczesnym zachowaniu najwyższych standardów technicznych. W przyszłości partnerzy inwestujący w kompetencje gotowe na AI – takie jak integracja chłodzenia cieczą, montaż prefabrykowanej infrastruktury czy zrównoważone rozwiązania energetyczne – będą mieli największe możliwości. Współpraca między globalnymi dostawcami a lokalnymi ekspertami będzie kluczowa dla przyspieszenia transformacji Polski w kierunku cyfrowej gospodarki opartej na AI.

Do obsługi aplikacji cloud-native wybierana jest platforma Kubernetes. Dla partnerów handlowych to szansa na dostarczenie klientom realnej wartości biznesowej. Jak sprawnie przeprowadzić ich przez tę zmianę?

Proces przejścia od monolitu do mikroserwisów stał się nowym paradygmatem IT. To dobrze, bo tradycyjne aplikacje monolityczne stały się hamulcem dla innowacji. Są trudne w skalowaniu, a każda zmiana wymaga przebudowy i wdrożenia całej aplikacji. Nowoczesne podejście oparte na mikroserwisach dzieli aplikacje na małe, niezależne i łatwe w zarządzaniu komponenty. Daje to niespotykaną dotąd elastyczność, przyspiesza cykle wdrożeniowe i pozwala na błyskawiczne skalowanie zgodnie z potrzebami. To właśnie konteneryzacja, wspierana przez Kubernetes, jest idealnym środowiskiem dla mikroserwisów. Zastępuje ona tradycyjną, ciężką wirtualizację, oferując znacznie lepsze wykorzystanie zasobów. Dlatego przyszłość należy do konteneryzacji i wirtualizacji cloud-native, która przenosi korzyści znane z kontenerów – jak skalowalność i efektywność – do świata maszyn wirtualnych, unifikując całe środowisko IT.

Rancher Prime: centrum dowodzenia transformacją

W teorii wszystko brzmi doskonale, ale w praktyce klienci stają przed wyzwaniem, jak zarządzać rosnącą liczbą kontenerów i klastrów Kubernetes, szczególnie w środowiskach hybrydowych i multi-cloud, jak zapewnić bezpieczeństwo i uprościć codzienne operacje?

Odpowiedzią na te pytania jest SUSE Rancher Prime – wiodąca na rynku, otwarta platforma do zarządzania Kubernetesem. Rancher sprawia, że przejście do świata cloud-native staje się szybkie, łatwe i bezproblemowe. Jest jak uniwersalny pilot do całego ekosystemu Kubernetes, rozwiązujący kluczowe problemy: l Zarządzanie cyklem życia klastrów: umożliwia wdrożenie, aktualizację i skalowanie dowolnych certyfikowanych dystrybucji Kubernetes (RKE2, EKS, AKS, GKE i inne) za pomocą jednego interfejsu, niezależnie od tego, gdzie się znajdują – we własnej serwerowni, w chmurze publicznej czy na brzegu sieci (edge).

l Centralizacja i bezpieczeństwo: zapewnia scentralizowane uwierzytelnianie i kontrolę dostępu (RBAC) dla wszystkich klastrów. Umożliwia egzekwowanie globalnych polityk bezpieczeństwa nawet w rozproszonych środowiskach.

l Uproszczenie operacji: dostarcza intuicyjny interfejs i bogaty katalog gotowych do wdrożenia aplikacji, co radykalnie skraca czas dostarczania oprogramowania. Klienci korzystający z Rancher Prime notują skrócenie czasu wdrażania aplikacji nawet o 40 proc. i redukcję kosztów operacyjnych IT do 30 proc. dzięki automatyzacji i lepszemu wykorzystaniu zasobów.

SUSE Rancher Prime to potężne narzędzie do zarządzania konteneryzacją, lider w raportach Gartnera i Forrestera. Dostępne jest samodzielnie oraz w pakiecie Rancher Prime Suite, które rozszerza go o funkcje: l. SUSE Virtualization (Harvester): nowoczesna platforma do wirtualizacji cloud-native, pozwalająca zarządzać z jednego miejsca maszynami wirtualnymi i kontenerami.

2. SUSE Security (NeuVector): zapewnia kompleksowe bezpieczeństwo w modelu zero-trust dla całego cyklu życia kontenera – od skanowania obrazów po ochronę w czasie rzeczywistym.

3. SUSE Observability: oferuje zaawansowane możliwości monitorowania i analizy środowiska, zapewniając pełen wgląd w jego stan i wydajność pracy.

Partnerzy SUSE mają szansę, by przeprowadzić swoich klientów przez cyfrową transformację. Kubernetes i konteneryzacja to także podstawa wdrożeń AI, ponieważ zapewniają skalowalność, przenośność i efektywne zarządzanie zasobami.

SUSE zapewnia partnerom kompleksowe wsparcie, by ułatwić sprzedaż i wdrożenie rozwiązań z rodziny Rancher. Oferuje bezpłatne szkolenia techniczne i sprzedażowe, możliwość rejestracji projektów oraz atrakcyjne ceny specjalne i rabaty w ramach programu partnerskiego.

Wykorzystajmy razem potencjał SUSE Rancher Prime, aby budować nowoczesne, wydajne i bezpieczne środowiska IT dla klientów zainteresowanych konteneryzacją oraz rozwiązaniami AI.

Autoryzowanym dystrybutorem rozwiązań SUSE jest Ingram Micro.

Kontakt dla partnerów:

Radosław Czubaszek, Partner & Distribution Development Manager, SUSE tel. 602-406-294 radoslaw.czubaszek@suse.com

„Naszym zadaniem nie jest tworzenie rozwiązań tylko dla jednego wydziału, czy jednej jednostki miejskiej. Chcemy, żeby z każdego systemu mogło korzystać możliwie dużo użytkowników, zarówno po stronie administracji, jak i mieszkańców” – mówi Ewelina Włoch, Naczelnik Wydziału Cyfryzacji i Nowych Technologii w Urzędzie Miasta Rybnik.

Jaki jest zakres zadań i kompetencji zespołu, którym Pani kieruje? Nazwa sugerowałaby, że macie Państwo inny obszar działania niż tradycyjny dział informatyczny w urzędzie…

Ewelina Włoch Wydział Cyfryzacji i Nowych Technologii powstał dwa lata temu z założeniem, że będzie reprezentował szersze podejście do wykorzystania technik cyfrowych niż standardowy dział IT. Chodzi o to, aby nie ograniczać się tylko do obsługi samego urzędu, ale też patrzeć na potrzeby całego miasta, wdrażając różnego rodzaju

PRZYMIERZAMY SIĘ DO STWORZENIA CYFROWEGO BLIŹNIAKA

CAŁEGO MIASTA. PRACE RUSZĄ W PRZYSZŁYM ROKU.

usługi dla pojedynczych mieszkańców, ale też funkcjonujących w mieście organizacji. Naszym zadaniem jest realizacja holistycznego podejścia do wprowadzania rozwiązań cyfrowych.

Jesteście w trakcie realizacji cyfrowego bliźniaka miasta. Czy to jest jeden z elementów wspomnianego nowego podejścia do roli IT w mieście?

To na pewno przykład wykorzystania możliwości oferowanych przez nowoczesne techniki cyfrowe. Jako że Rybnik był jednym z pionierów informatyzacji admini-

stracji samorządowej, to funkcjonujące obecnie w urzędzie systemy były wdrażane wiele lat temu i są już generalnie przestarzałe. Obecnie staramy się je stopniowo aktualizować, modernizować, bo jak wiadomo postęp w dziedzinie ICT jest wyjątkowo dynamiczny. Jednym z przykładów tych działań jest stworzenie cyfrowego bliźniaka miejskiego pasa drogowego. Nie chodzi jednak tylko o zbudowanie cyfrowego modelu tych terenów. Powstaje cały system do zarządzania pasem drogowym. Będą w nim informacje o całej infrastrukturze pasa drogowego, w tym o znajdujących się w jego obrębie reklamach. Integrujemy go z systemami dziedzinowymi, jak na przykład systemem finansowo-księgowym, jak również z systemem obiegu dokumentów. Pozwoli to na szybsze podejmowanie decyzji i sprawniejsze wydawanie zezwoleń. Pracownicy mniej czasu będą musieli spędzać w terenie, bo wiele informacji będą mogli pobrać bezpośrednio z systemu. A jak już pojadą w teren, to specjalna aplikacja mobilna umożliwi im, przykładowo, sprawdzenie, czy dana reklama lub inna instalacja jest legalnie postawiona w pasie drogowym. Będą też mieli dostęp do informacji o wszelkich innych, znajdujących się tam obiektach.

Kto będzie głównym użytkownikiem tego rozwiązania?

Naszym zadaniem, jako Wydziału Cyfryzacji i Nowych Technologii, nie jest tworzenie rozwiązań tylko dla jednego wydziału. Za zarządzanie pasem drogowym odpowiada

Zarząd Dróg Miejskich, ale z cyfrowego bliźniaka będą korzystać także inne jednostki miejskie, na przykład Zarząd Zieleni Miejskiej, wydział architektury, wydział promocji, wydział inwestycji, wydział gospodarki miejskiej i inne. Chcemy, żeby z tego rozwiązania mogli korzystać też mieszkańcy miasta. Jako urzędnicy ułatwiamy sobie dzięki takim systemom pracę, optymalizujemy funkcjonowanie urzędu, ale naszym celem jest, by służyły one bezpośrednio również samym mieszkańcom.

Czy w planach jest stworzenie cyfrowego bliźniaka całego miasta? Tak, przymierzamy się do tego. Planujemy ruszyć z pracami w przyszłym roku. Wiele informacji o mieście jest już dostępnych w Rybnickim Systemie Informacji Przestrzennej (RSIP). Jego wielką zaletą jest to, że dane aktualizują się codziennie w sposób automatyczny, co jest możliwe dzięki integracji z systemami źródłowymi. Jeżeli, dajmy na to, wydział geodezji coś zmieni, to następnego dnia rano ta konkretna aktualizacja znajdzie się w naszym geoportalu. Przy czym część zasobów jest ogólnodostępna dla wszystkich zainteresowanych za pomocą przeglądarki internetowej, podczas gdy do warstwy wewnętrznej mają dostęp tylko upoważnieni pracownicy urzędu i innych jednostek miejskich. W przyszłym roku będziemy aktualizować ortofotomapę, która ma być robiona w bardzo dobrej jakości. Wykonywane w tym celu naloty lotnicze chcemy też od razu wykorzystać do budowy cyfrowego bliźniaka całego miasta. Do tworzenia modelu pasa drogowego wykorzystywane jest natomiast obecnie skanowanie za pomocą urządzeń zainstalowanych na specjalnym samochodzie.