EDITORIAL

La primavera ha terminado con multitud de encuentros realizados por distintas firmas comerciales. Siempre se han producido, sin embargo parece que en los últimos meses el afán por celebrar micro eventos en los que hablar de tú a tú con los clientes gana protagonismo en el mercado.

Esta cuestión está vinculada con otras dos sin duda atractivas. Por un lado la cercanía de IBC, que un año más abrirá sus puertas en septiembre y servirá como amplificador y dinamizador de las novedades del mercado. Por otro la opinión, cada vez más marcada en los grandes directivos del sector broadcast, respecto al futuro de las grandes ferias. Recientemente charlando con Jeff Rosica, CEO de AVID, nos comentaba que las ferias internacionales pierden fuelle en pro de los eventos locales, que tienden a hacerse desde 2020 cada vez más potentes y más numerosos.

El tiempo dirá si esa tendencia se acentúa o, por el contrario, los grandes eventos internacionales recuperan facturación, expositores y visitantes prepandemia.

Lo cierto es que, entre tanto, ferias como Bitam Show, referente nacional del audiovisual español, este 2023 batirá récord de expositores y facturación.

Hablando de eventos, la revista TM Broadcast ha organizado recientemente un nuevo Desayuno de Trabajo en el que ha tenido el privilegio de contar con algunos de los directivos top y charlar distendidamente sobre cuestiones relativas a “Nuevas tecnologías y optimización de costes”. Ya estamos trabajando en un amplio artículo que verá la luz el próximo número para trasladar a todos los lectores las interesantes opiniones que nos brindaron.

Fueron muchos los temas planteados como se verá. Al tiempo que detectamos, como viene siendo habitual estos últimos meses, un desbordante interés por los asuntos relacionados con IA, futuro, posibilidades, incluso aspectos éticos relacionados con su uso.

En sus manos un nuevo ejemplar de TM Broadcast. El número pre-vacacional. Disfrute de los contenidos de primer nivel preparados especialmente para usted.

Editorial EDITORIAL TM Broadcast 3

EDITOR

Javier de Martín editor@daromediagroup.com

DIRECCIÓN DE CONTENIDOS

Mercedes González mercedes.gonzalez@tmbroadcast.es

DIRECCIÓN ADMINISTRACIÓN

Laura de Diego laura.dediego@daromediagroup.com

DIRECCIÓN COMERCIAL

Javier M. Gutiérrez jmg@tmbroadcast.es

PUBLICIDAD

Sergio Castaño sergio.castano@tmbroadcast.es

Patricia Pérez ppt@tmbroadcast.com

REDACCIÓN redaccion@tmbroadcast.es

MAQUETACIÓN

Sorex Media

COLABORADORES

Yeray Alfageme

Carlos Medina

Luis Pavía

Carlos Alberto Martín

Javier Guerra

Luis Sanz

Alfonso Redondo

José Luis Cordero

Carlos González

Fernando Suárez

SUSCRIPCIONES suscripciones@tmbroadcast.es

Imprime: IMEDISA ARTES GRÁFICAS S.L.

Dep. legal: M-11254-2008

ISSN: 1888-6965

Impreso en España en junio de 2023

TM Broadcast no se hace responsable de las opiniones vertidas en los reportajes e informaciones firmadas. Todos los derechos reservados. Esta publicación no puede ser reproducida ni en todo ni en parte en ningún medio impreso ni electrónico, ni registrada en, ni transmitida por cualquier sistema sin permiso previo por escrito de la editorial.

TM Broadcast es una publicación de Daró Media Group S.L.

Centro Empresarial Tartessos

Calle Pollensa 2, Oficina 14 28290 Las Rozas, Madrid.

Tf: 91 640 46 43

20 Final de la UEFA Champions League con Movistar+

Charlamos con Movistar Plus+ acerca de los desafíos que ha supuesto una producción de tal calado, los procesos de pre y post producción requeridos para una emisión fluida, las medidas de seguridad adoptadas y la innovación implementada en esta última edición.

26 Protocolos de contribución y distribución en entornos Broadcast

Una visión panorámica de los protocolos para contribución de señales de TV en entornos broadcast: ST2110, SRT, NDI y más.

Actualidad 4 SUMARIO SUMARIO 6 The Viewfinder, por Yeray Alfageme 19

36

Yamaha Serie DM7: mayor potencia y menor precio TM Broadcast y AV Integración

Audiovisual, otra de las cabeceras de este grupo editorial, fueron los únicos medios españoles en asistir a la presentación de la nueva serie DM7 de Yamaha en la Japan House, Kensington, Londres.

Computación cuántica, ¿ficción o realidad?

Para comenzar, debemos entender qué es la computación cuántica y por qué suena un poco a ciencia ficción o a serie de TV con Sheldon Cooper a la cabeza.

50

44 62

HDR Broadcast TV. Tecnología y creatividad mano a mano

Vamos a conocer a través de este artículo cómo el HDR conquista poco a poco el panorama actual del audiovisual profesional.

con

SUMARIO TM Broadcast 5

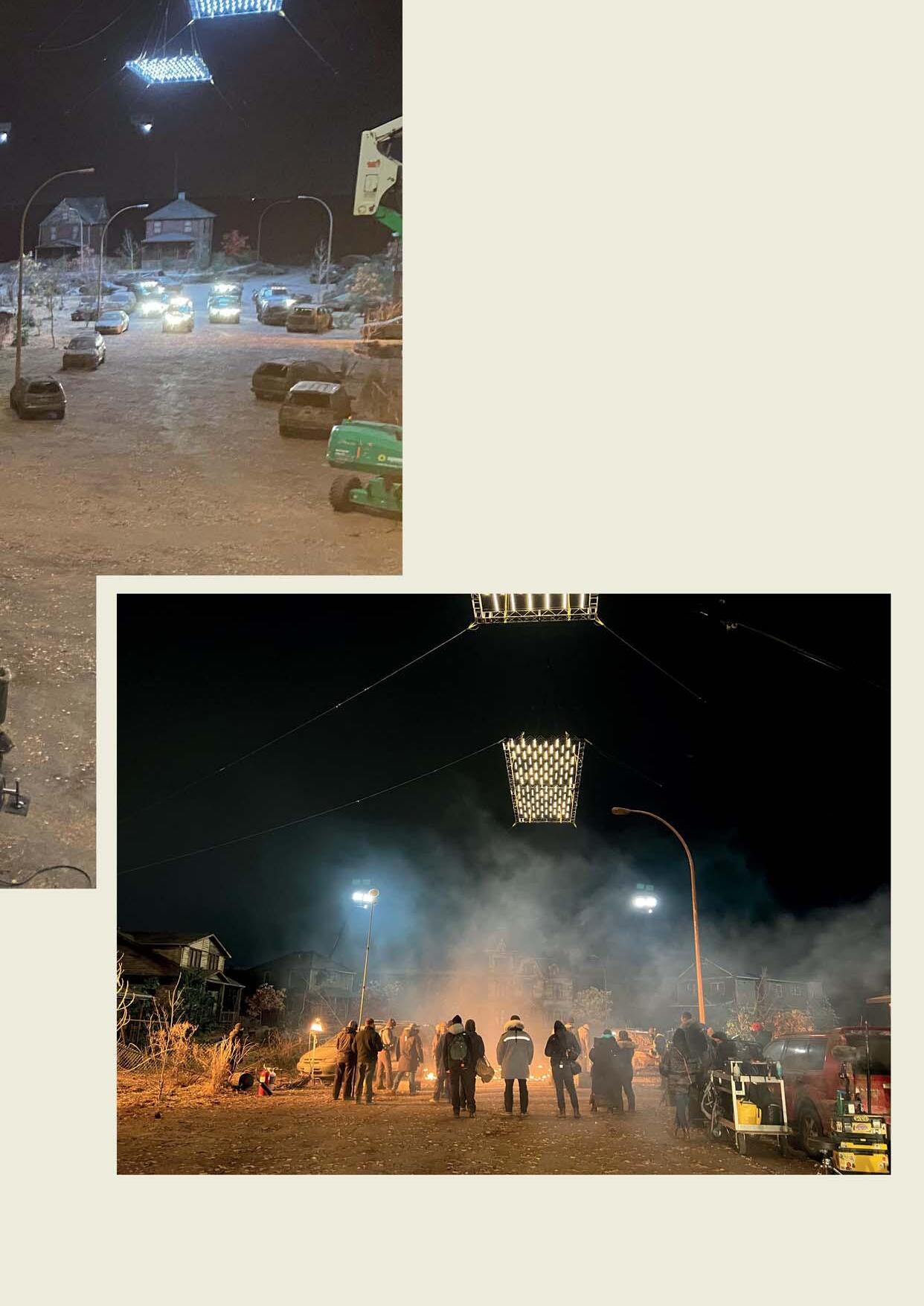

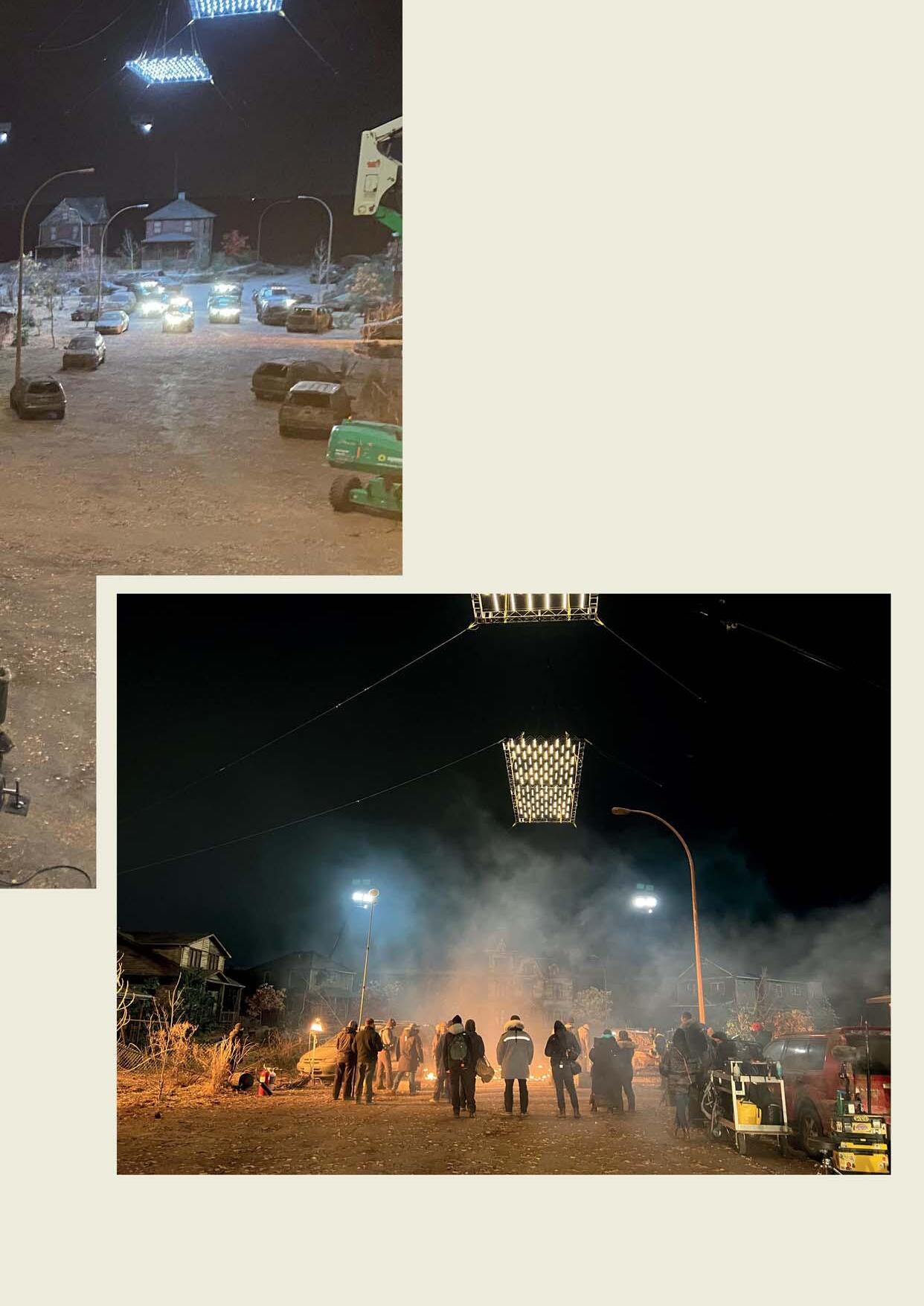

Filmando “The Last Of Us”

A día de hoy es difícil decir cuándo estará disponible esta tecnología, pero parece que está más cerca de lo que imaginábamos hace unos años. Eben Bolter 56 Revolucionando la industria de los medios: Liberando el poder de los entornos virtualizados en la nube

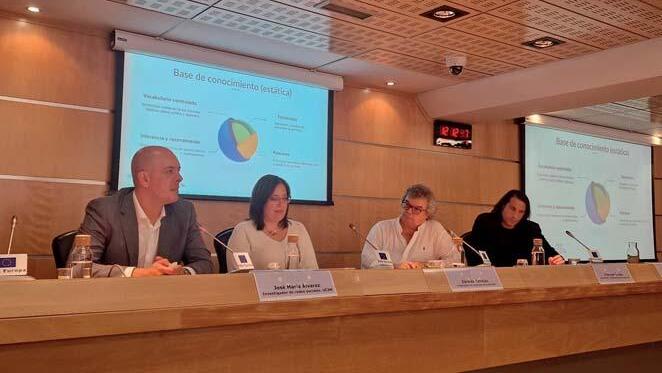

Proyecto IVERES de RTVE: los primeros resultados usando la IA contra la desinformación

RTVE, que, junto con la Universidad Autónoma de Barcelona (UAB) lidera el proyecto IVERES, ha dado a conocer el pasado jueves 15 de junio los primeros resultados de la lucha contra las fake news y la desinformación generalizada; la presentación se ha hecho a través de un acto celebrado en la sede del Parlamento Europeo en España (Madrid), y ha coincidido con la tramitación en el PE de la primera ley que regula el uso de la IA

En este sentido, Borja Díaz-Merry, responsable de VerificaRTVE ha explicado cómo se están aplicando ya en la redacción de Torrespaña diversas herramientas de verificación, con muy buenos resultados. Después de indicar que “los desinformadores están muy bien preparados”, ha instado a “disponer del mayor número posible de herramientas para que los equipos de investigación puedan equilibrar la balanza y puedan luchar eficazmente y rápidamente contra las falacias”.

La Oficina del Parlamento Europeo en Madrid ha celebrado el encuentro “Ciencia y tecnología ante la desinformación en Europa. Proyecto IVERES”. Para Damián Castaño, jefe de prensa de la Oficina, “la nueva ley significa un paso muy importante y posiblemente estará disponible durante la presidencia española de la UE y deberá ajustarse a los principios y valores de los países miembros”. Verónica Ollé, directora del Gabinete de la Presidencia de RTVE, ha puesto el énfasis en la conveniencia de alejar el temor a las nuevas tecnologías, “mientras no se pierda de vista que los ciudadanos tenemos derecho a una información veraz, reconocida constitucionalmente”. Por su parte, Mª Ángeles Ferre González, jefa de la Subdivisión de Programas Temáticos Científico-técnicos de la Agencia

Estatal de Investigación ha resaltado la oportunidad de la colaboración público-privada y la acción decidida de la Agencia por impulsar proyectos que supongan un avance en la lucha contra la desinformación.

Pere Vila, director de Estrategia Tecnológica de RTVE ha defendido la bondad del trabajo multidisciplinar conjunto que representa el proyecto IVERES, cuyo objetivo es proporcionar una herramienta de inteligencia artificial en español que ayude para la verificación de audios, imágenes y textos y permita conocer su autenticidad, entre otras utilidades y ha reclamado a instituciones y empresas que “inviertan en conocimiento para que cada vez haya más ingenieros e ingenieras formados para abordar los nuevos desafíos a los que se enfrenta la sociedad”.

La jornada ha servido para dar a conocer los avances en el desarrollo del proyecto IVERES. Santiago Tejedor, de la UAB y codirector del proyecto, ha explicado el trabajo de su equipo en internacionalizar las claves del periodismo de verificación y la necesidad de realizar un gran esfuerzo pedagógico “si queremos evitar que la IA se vea como un enemigo”. Respecto de la investigación en monitorado de redes sociales, José María Álvarez de la UC3M, ha reconocido la dificultad en distinguir las verdades de las falsedades, si bien hay un consenso en considerar que estamos delante de un problema de gran magnitud y en concreto, en su área de investigación, “aumentado por los modelos de IA en lenguaje generativo, que son una locura”.

Actualidad 6 NOTICIAS TM Broadcast RTVE

Esta acción se encuadra dentro del plan estratégico del grupo mediático, que planea abrir centros de producción virtual en otras ciudades como Barcelona, Madrid, Miami y Nueva York; las instalaciones que Grup Mediapro ha establecido en Miami, Florida, contarán con una pantalla LED de grandes dimensiones y tecnología punta, gracias a su alianza con BrandStar

digitalmente. Este sistema de grabación permite explorar nuevas fronteras audiovisuales ya que ofrece posibilidades infinitas de customización y genera entornos inmersivos para películas, series, programas de televisión, anuncios, vídeos musicales y eventos híbridos.

Esta nueva línea de negocio se enmarca en un ambicioso plan de Grup Mediapro que tiene como objetivo proporcionar equipamientos de producción virtual en sus principales centros de producción a lo largo de 2023-2024. En esta primera fase de desarrollo, el grupo prevé abrir centros en Miami, Barcelona, Nueva York y Madrid.

Mediapro US ha inaugurado recientemente el centro de producción virtual más grande del sur de Florida, Estados Unidos, que incluye la instalación con una pantalla LED, de grandes dimensiones: 24 metros de ancho, 7 metros de alto y más de 1.000 paneles. Este videowall LED, capaz de generar entornos inmersivos, permitirá al grupo ofrecer servicios de producción virtual a sus clientes.

El acuerdo plurianual firmado entre Mediapro US y BrandStar, una

de las productoras con más recorrido de los Estados Unidos, ha permitido impulsar esta nueva línea de negocio. BrandStar se ha hecho cargo del diseño, construcción e instalación de la pared LED y también ofrecerá servicios de soporte para operar el sistema de producción virtual.

Esta instalación audiovisual funciona con el software Unreal Engine, una herramienta de creación 3D que combina de manera sincrónica el entorno real con elementos creados

En Barcelona el plató de producción virtual se pondrá en marcha a finales de 2023. Este estudio se ubicará en el 22@, el centro de producción audiovisual urbano más grande de Europa, y combinará 235 m2 de pantallas LED con croma. En el tercer trimestre de este mismo año, el grupo sumará un nuevo centro de producción virtual de 1.500 m2 en Nueva York. La segunda fase de este plan estratégico se completará con la puesta en marcha, a partir de 2024, de otro centro en Madrid. Y, en las siguientes fases, Grup Mediapro desplegará esta tecnología en todos sus centros de producción.

Actualidad NOTICIAS TM Broadcast GRUP MEDIAPRO 8

Grup Mediapro inaugura en Florida el centro de producción virtual más grande del sur del estado

Blackmagic

presenta tres modelos

de solución

portátil

broadcasting: Atem TV Studio HD8, HD8 ISO y 4K8

El nuevo Atem Television Studio es un switcher de producción en vivo profesional integrado en un panel de control de transmisión, por lo que puede usarse para trabajos de alto nivel y al mismo tiempo portátil debido a su tamaño compacto. Tiene 8 entradas SDI convertidas a estándares, salidas auxiliares, 4 manipuladores de croma, 2 manipuladores descendentes, SuperSource, 2 reproductores multimedia y un amplio catálogo de transiciones. Además, hay un modelo ISO que registra las 8 entradas para editar.

Permite seleccionar entre transiciones, como disolver, o efectos más dramáticos, como sumergir en color, apretar DVE y empujar DVE. Incluso puede agregar un DVE para efectos de imagen en imagen con gráficos personalizados. Por último, puede usarse para transmitir la señal en directo.

El panel frontal incluye botones para seleccionar fuentes, activar transiciones y configurar efectos de vídeo. También ofrece una barra en T incorporada para el control de transición manual. El panel frontal incluso tiene un área de control del mezclador de audio con medición en vivo en una pantalla LCD diseñada para mostrarlo.

Grabación en el almacenamiento de red interno

Atem Television Studio HD8 ISO admite la grabación de todas las entradas de vídeo en el almacenamiento flash interno M.2 opcional. El

de

almacenamiento interno estará disponible para compartir a través de la red Ethernet local para que obtenga un flujo de trabajo de posproducción completo. Esto significa que las personas pueden trabajar en tareas de posproducción, como edición, corrección de color y preparación de gráficos, mientras graban nuevos programas en vivo.

Mezclador de audio Fairlight incorporado

Con un mezclador de audio Fairlight incorporado, Atem Television Studio permite realizar mezclas complejas de sonido en vivo. El mezclador interno presenta suficientes canales para todas las entradas SDI, así como canales adicionales para las entradas XLR, RCA y MADI. Cada canal de entrada cuenta con ecualizador paramétrico de 6 bandas de la más alta calidad, compresor, limitador, expansor y puerta de ruido, así como controles de nivel y panorama.

El nuevo switcher de Blackmagic se presenta en tres modelos diferentes con distintas capacidades y características:

ATEM TV STUDIO HD8

Switcher de producción en vivo compacto con panel de control de transmisión incorporado, 8 entradas 3G-SDI, transmisión, grabación, vista múltiple, DVE, manipuladores, cámara web USB, reproductores multimedia, intercomunicación y almacenamiento en la nube opcional.

ATEM TV STUDIO HD8 ISO

Este modelo ISO incluye todas las funciones de ATEM Television Studio HD, agrega grabación ISO de las 8 entradas y admite hasta 8 cámaras remotas con control y tally para cada cámara.

ATEM TV STUDIO 4K8

Switcher de producción en vivo Ultra HD similar al modelo HD no ISO, aunque con diferentes características: incluye 8 entradas 12G-SDI, 10 salidas auxiliares 12G-SDI para grabadoras externas, conmutador Ethernet 10G de 4 puertos y más.

Actualidad BLACKMAGIC DESIGN

NOTICIAS TM Broadcast 10

EL NUEVO SWITCHER DE BLACKMAGIC SE PRESENTA EN TRES MODELOS DIFERENTES CON DISTINTAS CAPACIDADES Y CARACTERÍSTICAS.

La distribuidora española

Magnetrón cumple 50 años en la industria del audio

Magnetrón, una de las empresas españolas a la cabeza de la distribución de equipos de sonido de alta calidad, realiza un recorrido por su trayectoria ante su quincuagésimo aniversario

La empresa española, distribuidora oficial de Sennheiser para España y Portugal, cumple en 2023 cincuenta años dedicados a la dinamización del mercado audiovisual, comprometidos con la calidad del sonido y el servicio a sus clientes. Durante estos 50 años de trayectoria, la mayorista se ha ocupado de la distribución de otras marcas reconocidas del audio profesional (FBT, Rycote, Neumann, Xílica, Blaze, Klipsch, entre otros).

Desde sus orígenes, en 1973, hasta hoy, Magnetrón se ha situado a la vanguardia tecnológica del sonido, centrándose en un único objetivo: ofrecer el mejor acabado en la gestión del audio. A este respecto, su director, Jesús Pascual, comenta:

“Este aniversario supone para nosotros un hito importante, aunque esto solo significa el comienzo. Estamos muy entusiasmados con lo que nos va a deparar el futuro y nos comprometemos a seguir ofreciendo solo el mejor sonido a nuestros clientes”.

A pesar de los cambios constantes en el panorama global, Magnetrón se mantiene fiel a su compromiso de ofrecer «solo el mejor sonido» con innovaciones como el EW-DX de Sennheiser, que brinda un sonido superior y seguridad inalámbrica, o las soluciones TeamConnect Ceiling, que ofrecen una alta calidad de audio para salas de reuniones y conferencias o espacios de colaboración.

Otro buen ejemplo es la gama de amplificadores

DSP PowerZone Connect de Blaze Audio o los roomkit de sala optimizados que Xílica, en colaboración con Sennheiser, ha lanzado recientemente.

TM Broadcast

MAGNETRÓN

Ateme integra el protocolo BISS-CA para protección de contenidos en todas sus soluciones premium

Ateme, empresa dedicada a las soluciones de compresión, entrega y transmisión de vídeo con innovación en su núcleo, ha hecho que el estándar BISS-CA para la protección de contenido sea accesible dentro de todos sus productos y soluciones premium, ya que la firma es co-desarrolladora del BISS-CA estándar; ofrecer la solución de forma gratuita busca contribuir a facilitar la adopción del protocolo por parte de la industria.

Un protocolo de codificación desarrollado conjuntamente con la Unión Europea de Radiodifusión (European Broadcasting Union) y los Servicios de Eurovisión, el Acceso Condicional al Sistema de Codificación Interoperable Básico (BISS-CA) ofrece acceso abierto y condicional y brinda a los usuarios una contribución transparente, rastreable e independiente del proveedor y un sistema de codificación de distribución primaria. BISS-CA es seguro gracias a su encriptación con claves rodantes. Como estándar, es interoperable entre codificadores, transcodificadores, multiplexores y decodificadores. También es escalable y simple de operar, utilizando claves públicas para administrar activos. Ateme incorpora BISS-CA a sus soluciones premium KYRION, TITAN y PILOT.

Ateme tiene como objetivo ayudar a los propietarios de contenido a luchar contra la piratería de transmisiones deportivas en vivo. Desde la introducción de BISS-CA en 2018, Ateme ha empleado con éxito el

estándar y mejorado sus beneficios. Por ejemplo, al agregar soluciones de marca de agua de diferentes proveedores de seguridad de datos, con control directo a través de BISS-CA, Ateme ha transformado la protección de canales en una solución antipiratería completa, con eliminación de activos cuando se detecta una fuga. Agregar el modo de audio BISSCA también aumenta la granularidad de la gestión de activos, lo que permite el cifrado separado de cada canal de datos. Esto hace posible aislar audio o datos específicos y transferirlos de forma segura a receptores dedicados.

“La piratería está aumentando. Según la firma internacional de investigación Parks Associates, podría resultar en la pérdida de hasta 113 mil millones de dólares para los servicios de transmisión para 2027”, dijo Julien Mandel, director senior de marketing de soluciones en Ateme. “Por eso es importante continuar la lucha contra la piratería. Es por eso que en Ateme que-

remos hacer que BISS-CA sea más accesible, incluyéndolo en nuestros productos y soluciones premium. Lanzado en NAB Show 2018, BISS-CA ha evolucionado para cumplir con nuevos modos de operación. Hoy en día, no es solo para la distribución satelital: la combinación de BISS-CA con cualquier protocolo de transmisión de solicitud de repetición automática (ARQ), como el transporte confiable seguro (SRT), permite la transmisión segura a través de Internet pública, así como la entrada/salida segura hacia/desde la nube. A medida que continuamos innovando y mejorando nuestras soluciones, también nos complace ofrecer todas las nuevas soluciones de entrega premium con acceso gratuito al soporte de BISS-CA en nuestros codificadores KYRION, nuestro conjunto de transcodificadores TITAN y nuestro sistema de gestión PILOT”.

Actualidad ATEME

NOTICIAS TM Broadcast 12

Berdonés y Jimeno lanzan una OPA para llegar al 80% del capital de Secuoya

Raúl Berdonés y Pablo Jimeno anuncian una opa para adquirir la mayoría del capital de la compañía de contenidos. Los fundadores del grupo anuncian una oferta pública de adquisición del 55% del capital que, sumado al 25% actual, supone el 80% del accionariado, con una prima sobre el valor actual de cotización de las acciones del 55,9% y con un valor de compañía de 127,5 millones de euros. De esta manera, Secuoya deja claro su objetivo de consolidarse como un estudio independiente, de accionariado español y de alcance global.

Además, la compañía comunicará en un futuro cercano su estrategia empresarial al menos para el próximo lustro, con la meta de integrar talento creativo y productores destacados en el mercado hispanohablante.

Desde los inicios de su andadura, el Grupo Secuoya ha apostado por la internacionalización, y hoy opera de forma habitual en cuatro mercados: Estados Unidos, Latinoamérica, Oriente Medio y Europa.

Con Secuoya Studios como eje central de la estrategia integral de operación 360º de su negocio de contenidos, la compañía apuesta por el talento en español, tanto a nivel creativo como ejecutivo: David Martínez, Alfredo Pérez de Albéniz y Eduardo Campoy dirigen las áreas creativas del estudio, Unscripted, Cine y Ficción, a las que se suman los departamentos de Stories, capitaneado por Eduardo Galdo, Production Services y Commercial & Distribution, este último liderado por el equipo de Sergio Pizzolante, ubicado en la oficina de Miami.

SECUOYA TM Broadcast

MLEDGE, un proyecto sostenible de desarrollo de infraestructuras Cloud y machine learning

La iniciativa sostenible para el desarrollo de redes eficientes y soluciones en la Nube y de Federated Learning será fundamental para la evolución de las infraestructuras Cloud y machine learning/aprendizaje federado en España; además, el proyecto, que cuenta con financiación del Ministerio de Asuntos Económicos y Transformación Digital y de los fondos europeos Next Generation, se orienta a impulsar la I+D+i nacional y cuenta con los Objetivos de Desarrollo Sostenible de la Agenda 2030

La toma de decisiones basada en datos e impulsada por algoritmos de Aprendizaje Automático o Machine Learning (ML) está cambiando la forma en que funcionan la sociedad y la economía, con un profundo impacto positivo en nuestra vida cotidiana. Para que estas soluciones sean efectivas, a menudo se tienen que procesar datos cerca del usuario/a final y dichos datos pueden ser privados y confidenciales.

El Aprendizaje Distribuido y, en particular, Federado (FL: Federated Learning) emerge como un paradigma líder dentro de la rama del ML satisfaciendo estas dos propiedades. El aprendizaje federado ha crecido en paralelo con la expansión de la nube hacia el borde (CloudEdge) pero, curiosamente, ambos se han desarrollado en su mayoría de forma

independiente, a pesar de su paralelismo natural. En MLEDGE (Aprendizaje Automático en la Nube y en el Borde), IMDEA Networks trabajará, con el Dr. Nikolaos Laoutaris como investigador principal, para revertir esta tendencia mediante la implementación de FL como una capa intersectorial independiente pero optimizada sobre Cloud Edge, con aplicaciones y datos del mundo real para demostrar que esta sinergia puede producir grandes beneficios para todos.

Se estima que la economía de los datos alcanzará un impacto de 827.000 millones de euros para los 27 países de la UE en 2025. Por ello, el objetivo es habilitar un ecosistema próspero de servicios FL en el borde, seguros y eficientes, capaces de facilitar el uso de datos persona-

les y B2B confidenciales para entrenar modelos de machine learning (para usuarios/as finales individuales u organizaciones administrativamente independientes que colaboran bajo diferentes suposiciones de confianza -de total a nula, y cualquier nivel intermedio-).

Eficiencia, sostenibilidad y seguridad

Como destaca Elisa Cabana, Investigadora Postdoc de IMDEA Networks: “El proyecto aporta investigaciones, entre otras áreas, en la de servicios de aprendizaje federado (FLaaS), procesamientos en el borde de la nube (Cloud Edge), uso eficiente de FL en nubes híbridas y protección contra ataques, protección de datos sensibles o confidenciales que sean intercambiados, gestión de los desafíos de portabilidad de datos en

NOTICIAS TM Broadcast 14 Actualidad IMDEA NETWORKS

el borde, etc.”. En este contexto, el equipo diseñará un marco de desarrollo y componentes que ayuden a popularizar este tipo de servicios, así como soluciones contra ataques de envenenamiento o inferencia lanzados desde servidores de borde rebeldes y/o nodos de agregación “honestos pero curiosos”. Incluye la creación de una ‘marca de agua’ para proteger contra la redistribución de datos o metadatos intercambiados entre servidores en el borde en el marco del FLaaS.

Otros aspectos a destacar serán, como resume Cabana: “Crear una capa de lógica económica y de negocio que implemente una distribución justa de costes e ingresos entre las partes cuando colaboren

en el entrenamiento de modelos de ML, y dar soporte a DevOps (Conjunto de prácticas que agrupan el desarrollo de software y las operaciones de TI. Su objetivo es hacer más rápido el ciclo de vida del desarrollo de software y proporcionar una entrega continua de alta calidad) y al desarrollo continuo de servicios de aprendizaje automático en la nube, optimizando los costes mediante su monitoreo, predicción y asignación inteligente y energéticamente eficiente de los trabajos de computación”. La investigación contribuirá, además a diseñar, implementar y hacer públicos demostradores que trabajen con datos sensibles de individuos, y alimenten modelos útiles en áreas de la econo-

mía tradicional y de la economía digital como FinTech, identidad, salud, transporte, control de acceso, etc.

El proyecto será fundamental para el desarrollo de infraestructuras Cloud y ML/FL en España y para el fomento de la I+D+i nacional. Contribuirá a los Objetivos de Desarrollo Sostenible establecidos por las Naciones Unidas para 2030 y promoverá el desarrollo sostenible de redes eficientes y soluciones FL a través del trabajo práctico que puede impactar de manera sustancial y positiva en el medio ambiente.

Actualidad IMDEA NETWORKS

Panasonic introduce la actualización ST2110 en su línea de cámaras de estudio AK-HC3900

La multinacional tecnológica de origen japonés, cuya línea de productos abarca desde cámaras de estudio básicas hasta de alta gama, la línea PTZ UE160 y la plataforma de vídeo en directo Kairos, anuncia una actualización ST2120 para su cámara de estudio AK-HC3900, que estará disponible a partir del tercer trimestre de 2023 a través de un código de activación AK-SFC391 de pago

La actualización de software para el modelo AK-HC3900 apunta a mejorar la calidad y eficiencia en los centros de producción y a reducir costes, debido a que elimina la necesidad de unidades de control de cámara (CCU) y, con la nueva adaptación, garantiza la transmisión sin compresión de calidad broadcast.

Gracias a esta implementación la cámara de estudio Panasonic AK HD podrá conectarse a un equipo de emisión o conmutador de red compatible, lo que da la posibilidad de transmitir imágenes HD sin comprimir la calidad broadcast, directamente desde el cabezal a través de IP con una latencia muy baja, sin necesidad de una CCU. También admite vídeo de retorno IP (HD), señal de referencia (PTP), salida de señal troncal (HD), entrada de avisador y entrada/salida de audio de intercomunicación IP con el ST2110.

Por otro lado, la AK-PLV100, que ya admite esta renovada adaptación sin comprimir, también recibirá una actualización de firmware en un

futuro cercano. Esto permitirá la salida SMPTE ST2110, incluida la compresión JPEG-XS de serie directamente desde el cabezal de la cámara, lo que facilitará las operaciones de producción en directo y minimizará el número de dispositivos externos necesarios.

La mejora también garantiza que este modelo se conecte directamente a Panasonic KAIROS a través de IP, lo que ahorra espacio y da la posibilidad de obtener una producción y distribución en directo efectiva y flexible con un gran número de cámaras. Cuando se enlaza al ST2110, un único mainframe KAIROS Core 100 puede conectar simultáneamente hasta 48 entradas y 32 salidas, utilizando una pequeña unidad central de 1U de rack. La conexión sin CCU del modelo HD AK-HC3900 economiza aún más espacio y reduce el cableado para un funcionamiento eficiente, además de disminuir significativamente el consumo de energía en comparación con los sistemas convencionales.

NOTICIAS TM Broadcast 16 Actualidad PANASONIC

Cellnex despliega para Aena la primera red privada 5G en el aeropuerto de San Sebastián

Aena, la gestora aeroportuaria que más volumen de pasajeros maneja a nivel mundial, ha llegado a un acuerdo con el operador de infraestructuras y servicios de telecomunicaciones Cellnex Telecom para desplegar y poner en servicio la primera red privada basada en tecnología 5G en los aeropuertos españoles.

Aena deposita su confianza en Cellnex para instalar y desplegar la red 5G en el aeropuerto de San Sebastián, pero no solo eso: también se encargará de desarrollar diferentes casos de uso vinculados a la adquisición, recopilación y tratamiento seguro de datos medioambientales (gases y partículas en suspensión, temperatura, humedad y ruido) gracias a la Plataforma SmartBrain de Cellnex y a la operativa con drones, sobre todo en materia de seguridad y monitorización avanzada.

La quinta generación de comunicaciones móviles, más conocida como 5G, revolucionará los procesos de transformación digital gracias a su alta velocidad de transmisión de datos, su baja latencia, su capacidad de gestión de una alta densidad de dispositivos conectados y, especialmente, por su elevada disponibilidad y fiabilidad. En su aplicación aeroportuaria, el 5G supondrá un antes y un después, convirtiéndose en la base para el futuro desarrollo del aeropuerto y constituyéndose en la base para una enorme gama de nuevas aplicaciones y funcionalidades que permitirán un servicio mas eficiente y sostenible.

Cellnex cuenta para este proyecto con la colaboración de Nokia como partner para la red 5G, y con Inetum para el uso de drones, el suministro de los mismos y su operativa.

A nivel global, Aena ha identificado el 5G como una de las tecnologías clave para su proceso de transformación digital. A pesar de que la conectividad en los aeropuertos es un hecho desde hace unos años, el salto a esta nueva tecnología permitirá desarrollar nuevas aplicaciones en campos tan importantes como el de la seguridad o las operaciones. El 5G facilitará el avance del internet de las cosas (IoT), la implementación del BigData, la realidad virtual y aumentada, y la inteligencia artificial.

Esta nueva tecnología, y las aplicaciones y funcionalidades que giran sobre ella, potenciarán igualmente la gestión sostenible de la actividad aeroportuaria, compatibilizándola con la conservación del entorno natural y la gestión ambiental.

El Jefe de la División de Ideación y Emprendimiento de Aena, Pablo López Loeches, ha destacado la importancia de disponer de una red 5G privada en uno de nuestros aeropuertos que nos permita probar casos de uso aeroportuarios específicos que requieren de alta capacidad, baja latencia y alta densidad de dispositivos, además de una nueva capa de conectividad que ofrezca a la comunidad aeroportuaria la posibilidad de disponer de un servicio de

transmisión de datos de gran fiabilidad y alta disponibilidad.” Ha afirmado también que “la realización de estas pruebas nos permitirá identificar el grado de madurez de la tecnología 5G y en qué medida puede adaptarse a las necesidades de Aena para mejorar nuestros servicios internos de conectividad.”

Por su parte, Miquel Mir, director de Negocio Empresas en Cellnex España ha destacado “la importancia de las infraestructuras de telecomunicaciones y tecnologías como el 5G para contribuir a la optmización de los procesos en entornos tan complejos como los aeropuertos en los que la seguridad y la eficiencia operativa son claves, más allá de la conectividad para los pasajeros”, y se ha mostrado “satisfecho de participar conjuntamente con Aena en este piloto que servirá para sentar las bases de los futuros despliegues de este tipo de redes, y sus múltiples casos de uso, en los aeropuertos españoles; además de poder demostrar las capacidades de Cellnex como operador de infraestructuras neutras de telecomunicaciones y su experiencia para ayudar al despliegue de redes críticas”.

NOTICIAS TM Broadcast 17 Actualidad CELLNEX

Sony lanza la cámara HXC-FZ90 para simplificar la producción 4K en vivo

“A medida que los formatos de producción se diversifican según los proyectos, vemos que más empresas buscan una forma flexible de cambiar a voluntad entre 4K, HD y HDR. Es posible que aún estén produciendo la mayoría de sus encargos en HD, pero saben que necesitan una prueba de futuro y quieren poder responder ahora a los informes con un componente 4K o HDR”, comentó Norbert Paquet, director de producción en vivo de Sony Europa.

Si bien la mayoría de las empresas de producción de eventos, organizaciones de e-sports o instituciones educativas producen la mayor parte de su contenido en HD, son cada vez más conscientes de los beneficios que ofrece la producción 4K y buscan formas sencillas de cambiar a 4K. La cámara HXC-FZ90 de Sony

permite un cambio fluido y sin problemas en el momento elegido por los organizadores del evento. El HXC-FZ90 también es compatible con HLG (Hybrid Log Gamma) y SLog3 para el flujo de trabajo SR Live de Sony, que permite HD, HDR o 4K HDR cuando se desee.

Las características clave del nuevo sistema de cámaras de estudio HXCFZ90:

• Sensor CMOS 4K de 2/3” de un solo chip con montura B4 que permite una resolución de 2000 líneas de TV

• Licencia 4K disponible semanal o mensualmente o como característica permanente

• Compatibilidad integrada con HLG y S-Log3 para el flujo de trabajo SR Live

• Función ARIA: Optimización automática de la imagen según las características del objetivo

• Integración simple con CNA-2 web RCP Control que permite un monitoreo avanzado

• Cableado simplificado con Prompter o cámaras PTZ (ILMEFR7 por ej.) por Network Trunk (Ethernet)

• Conector mini jack estéreo para una conexión sencilla de auriculares

• Manejo sencillo de la cámara desde el panel frontal de la nueva CCU HXCU-FZ90 con funcionalidades como IRIS y control de pintura

• Función de asistencia de enfoque avanzada

NOTICIAS 18 TM Broadcast Actualidad SONY

LA HXC-FZ90 SALDRÁ AL MERCADO EL PRÓXIMO INVIERNO (2023)

La calma que precede a la tormenta

Tras la revolución que supuso el HD hace ya unos años y el cambio brutal que está siendo el UHD junto con la tecnología IP, que, aunque no están técnicamente relacionados, pero por requisitos técnicos muchas veces van de la mano, parece que hace ya un tiempo que se nos está dando una tregua.

Es cierto que al UHD y a la tecnología IP les queda un tiempo de implantación, pero al menos no están apareciendo nuevas tendencias, como el fallido 3D, que nos enturbien las aguas. Toda tecnología tiene un proceso de madurez y parece que al UHD le está llegando su tiempo. Yo al menos viví la llegada del UHD y el IP como apelotonada con el HD, pero no está siendo el caso ahora mismo.

Y me alegro. En este mundo tan rápido y que corre tanto que a veces dan ganas de hacer una parada y bajarse de él, está bien que las cosas tomen su tiempo. Más aún cuando creo sinceramente que al UHD le falta mucho por aportar. En el momento que todos en nuestras casas podamos disfrutar de todo lo que esta tecnología nos ofrece, especialmente el HDR y WCG, será cuando los creadores y artistas tendrán vía libre para sorprendernos y exprimir todas las posibilidades al igual que lo hecho con el HD y el color, para los nostálgicos.

Sin embargo, ya hay mar de fondo. La IA, el ML, las tecnologías generativas van a suponer un antes y un después no solo en nuestra industria si no en el mundo. Por

primera vez me alegro de que en el broadcast nos cueste avanzar en ocasiones y que nos lo estemos tomando con cierta calma, aunque hay iniciativas reales y muy buenas usando IA y estas nuevas herramientas.

Que se den su tiempo. Hay que ser pioneros, no cabe duda. Es más divertido y mejor. Pero no hay que correr en exceso. Dejemos al UHD y a todo lo que ello conlleva, como el IP, madurar y que todo lo nuevo vaya llegando de manera más natural que impuesta.

Seguro que disfrutamos más de todo el abanico de posibilidades que nos brindan todas estas herramientas desde la calma que desde el estrés autogenerado de imponernos un ritmo frenético que no ha lugar.

Me encanta lo nuevo, lo novedoso y lo innovador, pero también adoro la seguridad, la calma y la certeza de que estoy pisando suelo firme y seguro. El UHD empieza a ser suelo firme, seguro y probado. Disfrutémoslo mientras llega el siguiente huracán que va a sorprendernos a todos.

@yerayalfa www.linkedin.com/yerayalfa

THE VIEWFINDER The Viewfinder TM Broadcast 19

Por Yeray Alfageme, Business Development Manager en Optiva Media an EPAM company

20 TM Broadcast MOVISTAR+ DEPORTES

Cómo se prepara una final de la Champions

MOVISTAR+

Movistar Plus+ realizó la cobertura total de la UEFA Champions League, ofreciendo desde el día 9 de junio tanto el choque de temporada, la final, como todo lo que sucedía antes y después de la cita en Estambul, Turquía. En TM Broadcast hemos querido conocer cómo ha sido el despliegue de medios y de equipos tecnológicos y humanos para retransmitir una de las citas deportivas con mayor expectación de todo el año. Charlamos con Movistar Plus+ acerca de los desafíos que ha supuesto una producción de tal calado, los procesos de pre y post producción requeridos para una emisión fluida, las medidas de seguridad adoptadas y la innovación implementada en esta última edición.

21 TM Broadcast MOVISTAR+ DEPORTES

¿Cuáles son los principales desafíos que enfrenta Movistar+ al producir la final de la UEFA Champions League y cómo los aborda?

Se trata de uno de los eventos deportivos más relevantes de la temporada, y el compromiso de Movistar Plus+ con nuestros abonados es ofrecerles la mejor experiencia televisiva. Para ello, implicamos a todas las áreas de la compañía: nuestro equipo de narración le da rigor al evento y técnicamente nos valemos de los últimos avances tecnológicos.

¿Cuánto tiempo lleva la planificación y preparación de la producción televisiva de un evento de esta magnitud?

La señal internacional la produce el broadcaster que posee los derechos en el territorio donde se juega la final. El resto de operadores que personalizamos la señal internacional en esta edición, arrancamos la pre producción con tres meses de antelación, a partir de la site visit que organiza UEFA. Desde ese momento cada operador diseña su plan de producción y los últimos detalles se cierran una vez que se conocen los equipos que van a disputar la final.

¿Qué tecnologías innovadoras se utilizaron para mejorar la experiencia de visualización de los espectadores durante la final de la Champions League?

En las finales de la UCL del ciclo 2021/24 se ha incorporado como estándar de producción el UHD HDR HLG BT2100. Además, en todos los flujos de producción UHD en la UCL,

no sólo en la final, la señal internacional se produce, además de en estéreo y 5.1, en Dolby Atmos. Esta mezcla, aparte del multicanal inmersivo, incluye diversos objetos como sonidos personalizados de ambas aficiones o el audio de los comentaristas, que son totalmente personalizables por el consumidor final.

¿Qué enfoque creativo adoptáis para destacar la emoción y la intensidad del partido en la transmisión televisiva?

Movistar Plus+ cuenta con un activo fundamental, su equipo. Nuestros narradores y comentaristas son capaces de transmitir esa emoción desde el terreno de juego hasta los hogares de nuestros abonados. Esto,

DEPORTES

22 MOVISTAR+ TM Broadcast

unido a las mejores tomas y repeticiones de las jugadas más importantes, logran que el espectador experimente la competición con la misma intensidad que si estuviese en el estadio.

¿Cómo se aseguran de capturar los momentos clave del partido y brindar una cobertura exhaustiva de todas las acciones importantes y desde todos los ángulos?

El plan de cámaras del Host Broadcaster contemplaba 35 posiciones dentro del estadio que se sumaron a las cámaras aéreas (cable-cam, dron y helicóptero) y capturaron todo lo que acontecía tanto en el terreno de juego como en los alrededores del estadio y de la ciudad. Entre todas estas cámaras de campo había 7 super slow motion, 2 ultra slow motion y 4 steady cam por radio frecuencia.

Para ello contamos también con 7 EVS 12 de canales que permiten visualizar todas las repeticiones de las acciones más importantes del partido.

Paralelamente, Movistar Plus+ realizó su señal personalizada con 6 posiciones de cámaras adicionales.

¿Qué requerimientos en cuanto a personal y equipo técnico hay para llevar a cabo una producción televisiva de esta envergadura y cómo se organizaron estos durante el evento?

Para cubrir una final de UEFA Champions League desplazamos a un equipo humano de 55 personas, incluyendo perfiles técnicos, editoriales, artísticos y de producción.

MOVISTAR+

DEPORTES TM Broadcast 23 “

”

EN LAS FINALES DE LA UCL DEL CICLO 2021/24 SE HA INCORPORADO COMO ESTÁNDAR DE PRODUCCIÓN EL UHD HDR HLG BT2100

.

En cuanto a los medios técnicos, el Host Broadcaster destinó 2 unidades móviles encargadas de la producción de la señal internacional y, además de ello, Movistar Plus+ empleó una unidad móvil dedicada exclusivamente a la personalización de la señal para nuestra plataforma.

¿Cómo son los procesos de edición y postproducción que siguen tras el partido para preparar los contenidos destacados y los resúmenes?

Tanto la señal internacional como las señales de las cámaras principales se grabaron en la unidad móvil y en nuestro centro de producción. A partir de todo ello, el equipo editorial y de realización elaboraron las piezas que formaron parte del programa post partido (“Noche de Champions”). Dispusimos además de herramientas como “El Líbero”, que nos permitieron analizar en detalle las jugadas más destacadas del partido.

¿Qué medidas de seguridad se implementaron para garantizar la integridad de la producción televisiva y la transmisión en vivo de la final de la Champions League?

Para asegurar el suministro eléctrico, UEFA requería, tanto al Host Broadcaster como al resto de operadores con medios de producción propios en el estadio, que las unidades móviles cumplieran con la norma IEC 60364-7-717: 2009.

De esta forma se evitaba que cualquier incidencia eléctrica afectara a la retransmisión del partido.

Además de ello, el transporte de la señal desde el estadio hasta nuestro

centro de producción estaba encriptado para que solo los right-holders tuvieran acceso. Finalmente, Movistar Plus+ implementó sus propias medidas antipiratería en el proceso de emisión.

¿Cómo integraron la presencia de los patrocinadores y socios comerciales en la producción televisiva sin interrumpir la experiencia de los espectadores?

El principal soporte publicitario durante el partido es la publicidad perimetral del terreno de juego, cuyo contenido comercial se personaliza para distintos mercados a través de un sistema de Virtual Board Replacement. De esta forma se consiguió una presencia de los anunciantes poco intrusiva y sin alterar la experiencia del espectador.

¿Cuáles fueron los desafíos logísticos más importantes que enfrentaron al desplegar equipos de

producción en el estadio? ¿Cómo los superaron?

Al tratarse de un evento internacional que atrae a numerosos aficionados, medios de comunicación, y personal implicado en la organización del partido, exigió una mayor planificación para organizar la logística de transportes y alojamientos del equipo que desplazamos. Siempre hay que tener en cuenta las limitaciones de la ciudad en cuanto a capacidad hotelera además de las alteraciones en el tráfico que tienen determinadas capitales, que se acentúan cuando se celebran eventos de estas características.

¿Qué tipo de innovaciones o mejoras implementaron en comparación con las ediciones anteriores de la final de la UEFA Champions League?

En esta final de la UCL, aparte de la señal internacional del partido,

DEPORTES 24 MOVISTAR+ TM Broadcast

ENCRIPTADO PARA QUE SOLO LOS RIGHT-HOLDERS

TENGAN ACCESO. MOVISTAR PLUS+ IMPLEMENTA

SUS PROPIAS MEDIDAS ANTIPIRATERÍA EN EL PROCESO DE EMISIÓN.

EBU puso a disposición de todos los broadcasters diversas señales de cámara como la cámara master, la aérea y la beauty, además de la señal internacional sin grafismo, sin necesidad de estar desplazado en Estambul.

En cuanto a cámaras especiales, aparte de las grúas, polecams, steadycams… había 2 fan cam cinematic style que se encargaron de captar las reacciones de ambas aficiones con mayor profundidad de campo.

También fue la primera final de UCL que utilizó la tecnología SAOT para ayudar a reducir el tiempo necesario para verificar los goles en posibles fuera de juego.

¿Qué aspectos destacados o momentos memorables capturaron durante la producción televisiva de la final de la Champions League?

Los equipos que llegan a la final y sus protagonistas definen los mejores momentos del partido. Además de las mejores acciones futbolísticas, la final de este año vino marcada por el interés que siempre suscitan Pep Guardiola y sus jugadores.

MOVISTAR+

“ EL TRANSPORTE DE LA SEÑAL DESDE EL ESTADIO HASTA NUESTRO CENTRO DE PRODUCCIÓN ESTÁ

26 TM Broadcast PROTOCOLOS TECNOLOGÍA

Protocolos de contribución y distribución en entornos Broadcast

Una visión panorámica de los protocolos para contribución de señales de TV en entornos broadcast: ST2110, SRT, NDI y más.

En el apasionante mundo del broadcast, donde la innovación y la tecnología avanzan a pasos agigantados, es fundamental mantenerse al día con los últimos avances en protocolos de contribución y distribución de señales. En este artículo exploraremos algunos de los más relevantes en entornos broadcast, como ST2110, SRT, NDI, DASH, HLS, RTMP y muchos más.

Estos protocolos desempeñan un papel fundamental en la transmisión y entrega de contenido audiovisual en tiempo real, ya sea para la televisión tradicional, la transmisión por Internet o los servicios de vídeo bajo demanda. Cada uno de ellos tiene sus propias características y beneficios, y es importante comprender cómo funcionan y cuándo es más apropiado utilizar cada uno de ellos.

Comenzaremos hablando sobre el estándar ST2110, que ha revolucionado la forma en que se manejan las señales de vídeo, audio y datos en los entornos de producción y distribución de televisión IP. Exploraremos su arquitectura y cómo permite la transmisión de múltiples flujos de media y alta calidad en tiempo real.

Seguidamente nos sumergiremos en el protocolo SRT (Secure Reliable Transport), que ha ganado popularidad debido a su capacidad para garantizar la entrega segura y confiable de señales de vídeo a través de Internet. Veremos cómo SRT utiliza técnicas de corrección de errores y retransmisión selectiva para asegurar una transmisión robusta y de baja latencia.

Continuaremos nuestro recorrido con NDI (Network Device Interface), un protocolo desarrollado por NewTek que permite la transmisión de vídeo y audio de alta calidad a través de una red de área local (LAN). Exploraremos sus aplicaciones en entornos de producción en vivo y cómo ha simplificado la conectividad y la interoperabilidad entre diferentes dispositivos.

Además, analizaremos los protocolos de distribución de contenido DASH (Dynamic Adaptive Streaming over HTTP) y HLS (HTTP Live Streaming), utilizados ampliamente en la transmisión de vídeo a través de Internet. Veremos cómo funcionan estas tecnologías de transmisión adaptativa y cómo han mejorado la experiencia de visualización para los usuarios finales.

27 TM Broadcast PROTOCOLOS TECNLOLOGÍA

Por Yeray Alfageme, Business Development Manager en Optiva Media an EPAM company

No podemos dejar de mencionar el popular protocolo RTMP (RealTime Messaging Protocol), ampliamente utilizado para la transmisión en tiempo real de contenido multimedia a través de Internet. Exploraremos su arquitectura y su relevancia en el contexto actual de la transmisión de vídeo en vivo.

ST2110

El protocolo ST2110 ha desempeñado un papel revolucionario al cambiar la forma en que se gestionan las señales de vídeo, audio y datos en entornos de contribución y distribución broadcast basados en IP. El ST2110 es un estándar desarrollado por SMPTE (Society of Motion Picture and Television Engineers) que define un conjunto de especificaciones técnicas para el transporte de flujos de media en tiempo real sobre redes IP.

Una de sus principales características es su enfoque basado en flujos separados, lo que significa que el vídeo, el audio y los datos se transmiten como flujos independientes, a diferencia de los métodos tradicionales que encapsulaban todos los componentes en un solo flujo. Esto proporciona una mayor flexibilidad y escalabilidad, ya que cada elemento se puede manejar y procesar individualmente.

El estándar ST2110 utiliza el protocolo de transporte IP (Internet Protocol) para el enrutamiento y la transmisión de los streams. Esto permite la interconexión de equipos de diferentes fabricantes y la integración de sistemas en una infraestructura de red común. Además, el protocolo aprovecha las redes Ethernet

ST2110

A ENTORNOS SIN COMPRESIÓN, DONDE SE REQUIEREN GRANDES ANCHOS DE BANDA, POR EJEMPLO MÁS DE 1 GBPS EN SEÑALES HD-SDR, ES PRÁCTICAMENTE INVIABLE PARA DISTRIBUCIÓN DE CONTENIDO.

estándar, lo que reduce los costos de implementación y facilita la migración hacia entornos IP.

En cuanto a la calidad de la señal, el ST2110 ofrece una excelente fidelidad y precisión sin compresión. El protocolo admite resoluciones de vídeo hasta 4K y más allá, así como audio de alta calidad, incluyendo herramientas para formatos inmersivos como el sonido envolvente. Además, el ST2110 proporciona baja latencia, lo que resulta fundamental en aplicaciones en tiempo real, como transmisiones en vivo o producciones interactivas.

ST2110 está diseñado para entorno de producción. Debido a su orientación a entornos sin compresión, donde se requieren grandes anchos de banda, por ejemplo más de 1 Gbps en señales HD-SDR, es prácticamente inviable para distribución de contenido. La práctica totalidad de entorno de producción en IP trabaja con este protocolo y es cierto que, sobre todo en grandes eventos y producciones, se puede usar para contribuir entre centro de producción sobre redes privadas de gran ancho de banda, pero no es lo más recomendable o al menos apropiado.

Además, el ST2110 se integra de manera efectiva con otros protocolos y estándares comunes en la industria como son el SMPTE ST2022-6 para la transmisión sobre redes IP y el AES67 para la interoperabilidad de audio sobre IP. Esto fomenta la compatibilidad y la colaboración entre diferentes sistemas y garantiza la flexibilidad en la elección de equipos y tecnologías siempre dentro de un entorno de red controlado y de alta capacidad, como puede ser una unidad móvil o centro de producción.

TECNOLOGÍA

28 PROTOCOLOS TM Broadcast

“

”

ESTÁ DISEÑADO PARA ENTORNO DE PRODUCCIÓN. DEBIDO A SU ORIENTACIÓN

SRT (Secure Reliable Transport)

El SRT es un protocolo de transporte de código abierto desarrollado por Haivision, diseñado específicamente para superar los desafíos de la transmisión de vídeo a través de Internet. Con su combinación de técnicas de corrección de errores y retransmisión selectiva, consigue una entrega segura y confiable de señales de vídeo, incluso en entornos con pérdida de paquetes, alta latencia o fluctuaciones en el ancho de banda.

Una de sus características destacadas es la capacidad para adaptarse dinámicamente a las condiciones de red en tiempo real. Utilizando algoritmos inteligentes de control de flujo y control de congestión, el protocolo puede ajustar automáticamente la velocidad de transmisión y la cantidad de corrección de errores según las condiciones de la red. Esto asegura una óptima calidad de transmisión y minimiza los efectos de la pérdida de paquetes.

Otra ventaja importante es su enfoque en la seguridad. El protocolo utiliza cifrado de extremo a extremo para proteger la confidencialidad e integridad de los datos transmitidos, lo que garantiza la privacidad y evita posibles ataques o manipulaciones de la señal. Además, el SRT incluye mecanismos de autenticación y control de acceso, lo que permite verificar la identidad de los

participantes en la transmisión y controlar quién puede acceder a ella.

SRT se utiliza sobre todo en distribución de contenido o en contribuciones entre centros de producción distantes en las que la conectividad se realice a través de Internet. En estos entornos el SRT facilita la entrega de contenido broadcast a múltiples destinos como estaciones de televisión, proveedores de servicios de transmisión por Internet o plataformas de vídeo bajo demanda. El protocolo se integra con facilidad en sistemas de distribución existentes y se adapta a diferentes requisitos de ancho de banda y latencia, lo que lo hace ideal para entornos de transmisión en vivo o eventos deportivos.

Además, el SRT se ha convertido en un estándar ampliamente adoptado por la industria, con el respaldo de numerosos fabricantes de equipos y proveedores de servicios. Esto garantiza la interoperabilidad y la compatibilidad entre diferentes soluciones y asegura la flexibilidad en la elección de equipos y tecnologías.

PROTOCOLOS

TECNOLOGÍA TM Broadcast 29 “

ENTRE CENTROS DE PRODUCCIÓN DISTANTES EN

QUE LA CONECTIVIDAD

DE INTERNET. ”

SRT

SE UTILIZA SOBRE TODO EN DISTRIBUCIÓN DE CONTENIDO O EN CONTRIBUCIONES

LAS

SE REALICE A TRAVÉS

NDI (Network Device Interface)

Desarrollado por NewTek, ahora Vizrt, el NDI es un protocolo que permite la transmisión de vídeo y audio de alta calidad, así como datos auxiliares, a través de una red IP en su más amplio sentido. NDI está diseñado, al igual que ST2110, para entornos de producción pero, debido a la compresión que realiza sobre la señal, se puede usar para distribuir señales en ciertos entornos controlados aunque, como hemos comentado, su objetivo principal es simplificar la conectividad entre diferentes dispositivos en un entorno de producción en vivo y facilitar la interoperabilidad entre ellos.

Una de las principales ventajas del NDI es su enfoque basado en software, lo que significa que se puede implementar en sistemas existentes sin la necesidad de hardware adicional. Gracias al NDI, cualquier dispositivo o aplicación compatible puede convertirse en una fuente o destino de vídeo/audio en la red, lo que brinda una gran flexibilidad y facilidad de uso.

Además, está pensado para usarse en redes Ethernet estándar, debido a su adaptación a los anchos de banda existente y sus características técnicas. Una funcionalidad que ejemplifica este hecho es que una señal HDSDR ocupa menos de 1 Gbps de ancho de banda, lo que permite usar una única conexión Ethernet entre el equipo y la red.

El protocolo NDI también ofrece una baja latencia, lo que es crucial para la producción en vivo y la colaboración en tiempo real. Esto signifi-

ca que los cambios y ajustes realizados en una fuente de vídeo o audio se reflejan rápidamente en los destinos, sin retrasos perceptibles. Esta característica es especialmente valiosa en entornos de producción donde la sincronización y la respuesta en tiempo real son fundamentales.

Como hemos señalado el protocolo NDI está orientado a contribución,

más concretamente a entornos de producción. No es tan común su uso en entornos de distribución, aunque puede usarse, ya que no dispone de mecanismos tan avanzados de corrección de errores o adaptación a anchos de banda variables como el SRT u otros.

La compatibilidad del NDI con una amplia gama de dispositivos y software ha contribuido a su creciente

TECNOLOGÍA 30 PROTOCOLOS TM Broadcast

“

”

UNA DE LAS PRINCIPALES VENTAJAS DEL NDI ES SU ENFOQUE BASADO EN SOFTWARE, LO QUE SIGNIFICA QUE SE PUEDE IMPLEMENTAR EN SISTEMAS EXISTENTES SIN LA NECESIDAD DE HARDWARE ADICIONAL.

popularidad en la industria broadcast. Numerosos fabricantes de equipos y desarrolladores de software han adoptado el protocolo NDI en sus productos, lo que garantiza la interoperabilidad y la compatibilidad entre diferentes soluciones.

RIST (Reliable Internet Stream Transport)

Desarrollado por la Iniciativa RIST, que reúne a múltiples actores de la industria, el RIST es un protocolo de transporte que utiliza Internet para la contribución y distribución de señales multimedia en tiempo real. Su objetivo principal es superar los desafíos asociados a la transmisión sobre Internet garantizando una entrega fiable y de baja latencia.

Una de sus características fundamentales es el enfoque en la fiabilidad de la transmisión. El protocolo

utiliza técnicas de corrección de errores como la retransmisión selectiva y la recuperación de paquetes perdidos, para garantizar la integridad de los datos transmitidos. Esto permite una transmisión robusta incluso en redes con pérdida de paquetes, latencia variable o congestión, algo muy común en la red de redes.

Además, el estándar RIST implementa mecanismos de control de flujo y control de congestión para garantizar una transmisión eficiente y adaptativa. Estos mecanismos monitorean y regulan la cantidad de datos transmitidos en función de las condiciones de la red, evitando la saturación y el cuello de botella. Esto asegura un uso óptimo del ancho de banda disponible y minimiza los efectos de la congestión de la red.

nes de cifrado de extremo a extremo para proteger la confidencialidad de los datos transmitidos. Además, incluye mecanismos de autenticación y control de acceso, lo que permite verificar la identidad de los participantes en la transmisión y protegerla contra ataques maliciosos.

Como su propio nombre indica, RIST está orientado 100% a la distribución de contenido a través de Internet. Por supuesto puede usarse en entornos de contribución y producción, pero no está desarrollado para ello. Este protocolo es especialmente fiable, quizá con una mayor latencia que protocolos de distribución similares, pero con un extra de seguridad y robustez.

Hay que mencionar que RIST, aunque bastante extendido y por ello lo incluimos aquí, no está tan extendido como protocolos más modernos como SRT o más sencillos como RTMP o DASH.

Zixi

El protocolo ZIXI surgió como una solución avanzada para la contribución y distribución de contenido en entornos broadcast a través de Internet. Desarrollado por ZIXI, este protocolo se centra en garantizar una entrega fiable y de baja latencia sin comprometer la calidad del contenido transmitido adaptándose para ello a la situación de la red en cada momento.

La seguridad es otra preocupación importante en la transmisión broadcast y el RIST también aborda este aspecto. El protocolo ofrece opcio-

Una de las características clave del ZIXI es su capacidad de gestión del ancho de banda. Utilizando algoritmos inteligentes, el protocolo puede adaptar dinámicamente la velocidad de transmisión y la com-

PROTOCOLOS TECNOLOGÍA TM Broadcast

31

RIST IMPLEMENTA MECANISMOS DE CONTROL DE FLUJO Y CONTROL DE CONGESTIÓN PARA GARANTIZAR UNA TRANSMISIÓN EFICIENTE Y ADAPTATIVA. ”

“

presión del flujo de vídeo en función de las condiciones de la red. Esto asegura una óptima utilización del ancho de banda disponible y permite una transmisión de alta calidad incluso en entornos con fluctuaciones en el ancho de banda.

Además, incorpora mecanismos avanzados de corrección de errores y retransmisión selectiva para garantizar la integridad de los datos transmitidos. Esto permite que el protocolo recupere paquetes perdidos o dañados en tiempo real, minimizando los efectos de la pérdida de paquetes en la calidad y la coherencia del contenido transmitido.

La baja latencia es otro aspecto crucial en la transmisión broadcast en tiempo real y el ZIXI aborda esta preocupación de manera efectiva. El protocolo ha sido diseñado para minimizar la latencia en la transmisión de vídeo y audio, lo que permite una colaboración y una interacción en tiempo real entre los diferentes puntos de contribución y distribución. Esto es especialmente valioso en eventos en vivo, donde la sincronización precisa es esencial.

Ofrece también una solución completa para la seguridad de la transmisión. El protocolo soporta encriptación de extremo a extremo, lo que garantiza la confidencialidad e integridad de los datos transmitidos. Además, incluye mecanismos de autenticación y control de acceso para proteger contra accesos no autorizados y asegurar la autenticidad de los participantes en la transmisión.

Por su naturaleza, ZIXI es usado principalmente en entornos de distribución o como contribución entre eventos en directo y centros de producción. De hecho, hay muchos fabricantes que han implementado sus propios protocolos basados en ZIXI, ya que este permite servir como base a otras implementaciones más avanzadas. Paulatinamente ha ido siendo sustituido por protocolos más modernos como SRT pero aún hay muchos entornos en los que ZIXI es un protocolo fundamental.

Dynamic Adaptive Streaming over HTTP (DASH)

El protocolo DASH se basa en el estándar HTTP y utiliza técnicas de streaming adaptativo para entregar contenido multimedia de manera eficiente. En lugar de transmitir un único flujo de vídeo, DASH divide el contenido en segmentos más pequeños y los entrega al dispositivo receptor a través de conexiones HTTP estándar. Estos segmentos pueden tener diferentes resoluciones, tasas de bits y formatos de compresión.

Una de las principales ventajas del DASH es su capacidad de adaptación dinámica. El protocolo monitorea constantemente las condiciones de la red y las capacidades del dispositivo receptor, ajustando la calidad del vídeo en tiempo real para garantizar una reproducción suave y sin interrupciones. Así, el contenido se adapta automáticamente a la conexión de red y a las capacidades del dispositivo, optimizando la experiencia de visualización para cada usuario.

UNA DE LAS PRINCIPALES VENTAJAS DEL DASH ES SU CAPACIDAD DE ADAPTACIÓN DINÁMICA

Otra característica clave del DASH es su compatibilidad con múltiples formatos de vídeo, como MPEGDASH, HLS y Smooth Streaming. Esto permite a los proveedores de contenido adaptar sus transmisiones a diferentes dispositivos y plataformas, asegurando una amplia accesibilidad y una experiencia de usuario consistente en una variedad de dispositivos, desde televisores inteligentes hasta teléfonos móviles.

Por supuesto está 100% orientado a distribución de contenido a usuarios finales a través de Internet. Evidentemente también puede usarse en redes IPTV más controladas, pero su potencial se desarrolla por completo cuando hay que llevar el contenido a millones de usuarios finales con diferentes dispositivos cada uno. Evidentemente DASH se basa en redes CDN para dicha distribución.

Además, este estándar ofrece ventajas significativas en términos de almacenamiento y escalabilidad. Los segmentos de contenido se almacenan en caché en el lado del cliente, lo que reduce la carga en los servi-

TECNOLOGÍA 32 PROTOCOLOS TM Broadcast

“

. ”

dores de transmisión y facilita la entrega eficiente a un gran número de usuarios simultáneos. Esto hace que el estándar DASH sea una opción rentable para la distribución masiva de contenido en línea.

El protocolo DASH también permite a los usuarios pausar, adelantar o retrasar el contenido sin problemas. Gracias a la entrega basada en segmentos, los usuarios pueden saltar a cualquier punto del contenido sin la necesidad de descargar todo el archivo de vídeo siempre que el origen de la CDN lo permita. Esto proporciona una mayor flexibilidad y comodidad para los espectadores, mejorando su experiencia de visualización.

HTTP Live Streaming (HLS)

El estándar HLS utiliza el protocolo HTTP para transmitir contenido multimedia en segmentos pequeños y adaptativos, similar a DASH. El con-

tenido se divide en segmentos de duración fija; estos se almacenan en servidores de origen y se entregan a los dispositivos receptores a través de conexiones HTTP estándar mediante redes CDN. Estos segmentos pueden tener diferentes resoluciones, tasas de bits y formatos de

compresión, lo que permite una adaptación dinámica según las condiciones de la red y las capacidades del dispositivo.

Una de las ventajas clave del HLS es su compatibilidad con una amplia gama de dispositivos y plataformas. El protocolo es compatible con navegadores web, sistemas operativos móviles y dispositivos de transmisión, lo que garantiza que los usuarios puedan acceder al contenido sin problemas desde una variedad de dispositivos, ya sean teléfonos móviles, tablets, televisores inteligentes o computadoras.

El HLS también ofrece una experiencia de visualización optimizada mediante la transmisión adaptativa. El protocolo monitorea continuamente las condiciones de la red y las capacidades del dispositivo receptor, seleccionando automáticamente la calidad de vídeo más adecuada para garantizar una reproducción fluida y sin interrupciones. Esto significa que los usuarios experimentarán una calidad de vídeo óptima en función de su conexión de red y las capacidades de su dispositivo.

Otra ventaja importante del HLS es su capacidad para manejar interrupciones y fluctuaciones en la conexión de red. Si se produce una interrupción momentánea o una disminución en la calidad de la red, este estándar puede cambiar sin problemas a una calidad de vídeo más baja para evitar interrupciones en la reproducción. Esto asegura que los espectadores puedan disfrutar del contenido sin problemas, incluso en redes con limitaciones de ancho de banda.

PROTOCOLOS TECNOLOGÍA TM Broadcast

33 “

SEGMENTOS PEQUEÑOS Y ADAPTATIVOS,

”

EL ESTÁNDAR HLS UTILIZA EL PROTOCOLO HTTP PARA TRANSMITIR CONTENIDO MULTIMEDIA EN

SIMILAR A DASH.

De la misma manera que DASH, HLS está orientado por completo a la distribución de contenido sobre Internet, entornos OTT e IPTV. Junto con DASH son los protocolos más extendidos y, me atrevería a decir que, debido a su altísima compatibilidad casi con cualquier dispositivo, HLS es el protocolo más usado en Internet para la distribución de contenido en streaming.

Además, el HLS ofrece ventajas en términos de almacenamiento y transmisión de contenido bajo demanda. Los segmentos de contenido se almacenan en caché en el lado del cliente, lo que reduce la carga en los servidores de transmisión y facilita la entrega a un gran número de usuarios simultáneos. Esto hace que el HLS sea una opción escalable y rentable para la distribución masiva de contenido en línea.

Real-Time Messaging Protocol (RTMP)

El RTMP fue desarrollado por Macromedia (ahora Adobe) y se ha

convertido en un estándar de facto para la transmisión en vivo y la interacción en tiempo real en Internet. El protocolo utiliza una conexión persistente entre el servidor de transmisión y el cliente receptor, lo que permite una transmisión continua y confiable del contenido multimedia.

Una de las ventajas principales del RTMP es su baja latencia. El protocolo ha sido diseñado para minimizar la demora entre la transmisión y la reproducción del contenido, lo que lo hace ideal para aplicaciones en vivo donde la sincronización precisa

es esencial. Esto permite a los espectadores disfrutar de eventos en tiempo real, como transmisiones deportivas o conciertos, sin retrasos significativos.

Además, el estándar RTMP ofrece una alta calidad de transmisión de medios. El protocolo permite la entrega de contenido en diferentes formatos y tasas de bits, lo que garantiza una reproducción fluida y una calidad de vídeo y audio óptima. Esto es especialmente importante en entornos broadcast, donde la calidad del contenido es fundamental.

TECNOLOGÍA

34 PROTOCOLOS TM Broadcast “

”

UNA DE LAS VENTAJAS PRINCIPALES DEL RTMP ES SU BAJA LATENCIA. EL PROTOCOLO HA SIDO DISEÑADO PARA MINIMIZAR LA DEMORA ENTRE LA TRANSMISIÓN Y LA REPRODUCCIÓN DEL CONTENIDO.

Conclusiones

En este artículo técnico de divulgación sobre protocolos de contribución y distribución en entornos Broadcast, hemos explorado varios protocolos relevantes y su papel en la transmisión y entrega de contenido audiovisual en tiempo real. Cada uno de estos protocolos tiene características únicas y beneficios específicos y es importante comprender cómo funcionan y cuándo es más apropiado utilizarlos.

El protocolo ST2110 ha revolucionado la forma en que se gestionan las señales de vídeo, audio y datos en entornos de producción y distribución de televisión IP. Su enfoque basado en flujos separados proporciona flexibilidad y escalabilidad y su integración con el protocolo IP y las redes Ethernet estándar facilita la interoperabilidad y la migración hacia entornos IP.

El protocolo SRT se ha destacado por su capacidad para garantizar la entrega segura y confiable de señales de video a través de redes no confiables. Con técnicas de corrección de errores y retransmisión selectiva, el SRT logra una transmisión robusta y de baja latencia, adaptándose dinámicamente a las condiciones de la red y asegurando la privacidad de los datos transmitidos.

El estándar NDI ha simplificado la conectividad y la interoperabilidad en entornos broadcast a través de redes de área local. Su enfoque basado en software permite la integración en sistemas existentes sin hardware adicional costoso y su baja latencia y capacidad de transmitir datos auxiliares enriquecen la producción en vivo.

Por su parte, el RIST ha surgido como una solución confiable y eficiente para la contribución y distribución de contenido en tiempo real sobre redes IP no confiables. Sus técnicas de corrección de errores y control de flujo garantizan la integridad de los datos transmitidos, y su enfoque en la seguridad protege la confidencialidad e integridad de la señal.

Centrándonos más en la distribución Zixi, el protocolo de protocolos, junto a DASH Y su hermano HLS son lo más usados en la industria con mucha diferencia. El ya antiguo RTMP se ha visto también superado por SRT y está cayendo en desuso con el único freno de una compatibilidad prácticamente universal pero con problemas de fiabilidad y estabilidad que SRT no tiene.

El RTMP también es conocido por su capacidad de adaptación a las condiciones de la red. Puede ajustar dinámicamente la calidad de transmisión en función del ancho de banda disponible y las fluctuaciones en la conexión. Esto asegura una transmisión estable y sin interrupciones, incluso en redes con limitaciones de ancho de banda o enlaces no confiables.

En términos de aplicación en entornos de contribución y distribución broadcast, ofrece flexibilidad y compatibilidad con una variedad de dispositivos y plataformas. Los proveedores de contenido pueden utilizar RTMP para transmitir señales de vídeo y audio desde diferentes fuentes como cámaras de estudio, unidades móviles de producción o aplicaciones de transmisión en vivo, hacia servidores de transmisión y distribución.

El protocolo RTMP también se utiliza ampliamente en la distribución broadcast a través de plataformas en línea y servicios de streaming. Permite a los proveedores de contenido entregar transmisiones en vivo o contenido pregrabado a una amplia audiencia, brindando una experiencia de visualización interactiva y en tiempo real.

Aunque el RTMP ha sido ampliamente utilizado en el pasado, es importante mencionar que su popularidad ha disminuido en los últimos años debido al surgimiento de protocolos más modernos y eficientes, como el HLS y el DASH. Sin embargo, sigue siendo relevante en ciertos casos de uso y entornos específicos que requieren baja latencia y transmisión en tiempo real.

PROTOCOLOS

TECNOLOGÍA TM Broadcast 35

Yamaha Serie

DM7

Mayor potencia y menor precio

TM Broadcast y AV Integración Audiovisual, otra de las cabeceras de este grupo editorial, fueron los únicos medios españoles en asistir a la presentación de la nueva serie DM7 de Yamaha en la Japan House, Kensington, Londres, el pasado 6 de junio; la multinacional nipona congregó a un reducido número de periodistas para presentar este nuevo lanzamiento, en su primer evento presencial tras la pandemia.

36 TM Broadcast YAMAHA SERIE DM7 PRODUCTOS

La nueva gama de mesas de mezclas digitales de Yamaha, la serie DM7, se compone de dos consolas, un modelo de tamaño medio y un modelo compacto, más un nuevo software de control que funcionaría en ambos modelos, y dos paquetes de actualizaciones: uno, para el sector Broadcast y el firmware Theatre, enfocado a eventos de sala.

Con una narrativa exquisita —y coincidiendo con el trigésimo quinto aniversario del lanzamiento de su primera mesa de mezclas digital, en 1988— Yamaha eligió la Japan House en Londres como escenario para la presentación de su nueva serie de consolas mezcladoras de audio, reivindicando de esta forma su herencia milenaria y vinculando la filosofía nipona al desarrollo de sus productos.

Desde que creara su primer producto, el Reed Organ, en 1887, Yamaha —cuyo nombre hace referencia al universo samurái gracias a la combinación de los vocablos ‘yama’ (montaña) y ‘ha’ (espada)— no se ha detenido en su camino de desarrollar nuevos productos, ya sean instrumentos musicales o herramientas de gestión y control de audio, bajo los principios de la más estricta tradición nipona: la precisión, la flexibilidad y la adaptación, en este caso, al mercado. Además, en el desarrollo de estas series Yamaha ha puesto gran atención en la reducción de costes, impulsando así la inserción del producto con uno de los precios más competitivos del mercado.

Los valores de la tradición japonesa están presentes en cada una de las acciones de Yamaha; así, el hecho de encuadrar la presentación de sus nuevas soluciones de mezcla digital de audio en el marco de la Japan House de Londres, compartiendo espacio con una exposición sobre el uso de la seda en el antiguo Japón, no debe considerarse como algo secundario. Usando la comparación con el hilo de seda, material resistente pero delicado, flexible

pero poderoso, a partir del cual se elaboran diversos productos, desde cinturones trenzados hasta sofisticadas armaduras samurái, el origen y objetivo de la nueva línea DM7 aparece cristalino ante el espectador: se trata de una nueva serie que busca simplificar los flujos de trabajo usando la tecnología más puntera y respondiendo a las necesidades que se han ido identificando durante los últimos años.

Tras un breve recorrido por la exposición de la parte superior, en el que invitados y prensa pudieron conocer de primera mano las tradiciones ancestrales en artesanía y telares de seda de la cultura japonesa, la presentación dio comienzo en la sala de eventos de la Japan House, estructurada de un modo sencillo, a través de las intervenciones de Karl Christmas, Marketing Manager - Digital Mixers & Production, Tobias Weich, recientemente nombrado Director de la División de Audio Profesional de Yamaha, y Andy Cooper, director del área de ingeniería de Audio Profesional de Yamaha en Reino Unido.

A modo de introducción, Christmas hizo un breve recorrido por las dificultades que la pandemia de 2020 y la consecuente crisis de suministros tuvieron sobre la industria en general —y particularmente sobre Yamaha—, y celebró poder contar de nuevo con la presencia de periodistas e invitados para presentar el último y esperado lanzamiento de Yamaha Music; Tobias Weich, Director de la División de Audio Profesional de Yamaha en Europa, habló sobre los

37 TM Broadcast YAMAHA SERIE DM7 PRODCTOS

retos a los que se enfrenta Yamaha en Europa y expuso brevemente las directivas que han llevado a la prestigiosa firma a desarrollar las consolas DM7, y, por fin, Andy Cooper, especialista en ingeniería de amplia trayectoria en la casa, trasladó al público los avances integrados en la nueva Serie DM7, no sin provocar alguna que otra exclamación de sorpresa entre los presentes.

Y no es para menos: las nuevas consolas DM7 y DM7 compact vienen con una pantalla multitáctil que ofrece nuevas funcionalidades,

visualización completa de la selección de canales y permite modificar los parámetros de forma rápida; incorporan inteligencia artificial para detectar el pre-set más adecuado para la pieza que se esté reproduciendo (modo Assist)… y hasta puede dividirse en dos. Pero vamos por partes.

Las consolas mezcladoras

DM7

y DM7 Compact

La nueva gama de mesas de mezclas digitales de Yamaha, la serie DM7, se compone de dos consolas, un modelo de tamaño medio y un

modelo compacto, más un nuevo panel de control que funcionaría en ambos modelos, y dos paquetes de actualizaciones: uno, para el sector Broadcast y el firmware Theatre, enfocado a eventos de sala. De esta manera, la línea DM7 resulta la más versátil de Yamaha hasta el momento, siendo capaz de adaptar sus funcionalidades a cualquier tipo de evento, desde un concierto hasta un espectáculo teatral, pasando por cualquier tipo de streaming o producciones en vivo.

Las nuevas consolas mezcladoras DM7 y DM7 compact disponen de

PRODUCTOS

38 YAMAHA SERIE DM7 TM Broadcast

LAS NUEVAS CONSOLAS MEZCLADORAS DM7 Y DM7

COMPACT DISPONEN DE 120 Y 72 CANALES, RESPECTIVAMENTE, ADEMÁS DE 48 BUSES DE MEZCLA, 12 MATRICES Y NUEVAS FUNCIONES

120 y 72 canales, respectivamente, además de 48 buses de mezcla, 12 matrices y nuevas funciones, todo ello destinado a obtener un audio de gran calidad al mismo tiempo que se

facilita la labor de los técnicos a los mandos.

Uno de los elementos que más llamó la atención de algunos de esos técnicos, que acudieron invitados a

la presentación, fue el despliegue que hace la pantalla de vista de canales; se trata de una pantalla multitáctil de 12,1 pulgadas que ofrece al usuario toda la información disponible sobre cada uno de los canales de los que dispone. Con ayuda de los dedos, el usuario puede mover el ecualizador (EQ) o ajustar el tamaño en que se muestran canales y ajustes —esto es gracias al nuevo software de control DM7, que permite editar todos los elementos que uno pueda pensar: teclas, acciones, controladores, joystick, flujos de transporte… Además, incorpora dos

YAMAHA SERIE DM7

PRODUCTOS TM Broadcast 39 “

”

nuevos faders y puede usarse para expandir los controles en modelos anteriores de consolas Yamaha.