12 minute read

HIKVISION

SIGURNOST NA RUBNIM URE SIGURNOST NA RUBNIM UREĐ ĐAJIMA AJIMA KOLIKO SU SIGURNE NADZORNE KAMERE?

PITANJE MOŽE NA PRVI POGLED IZGLEDATI JEDNOSTAVNO, ALI ONO TO, ZAPRAVO, NIJE. DEFINICIJA SIGURNOG JE SUBJEKTIVNA, GOVORIMO LI O FIZIČKOJ ILI DIGITALNOJ SIGURNOSTI ILI NJIHOVOJ KOMBINACIJI. ZBOG TOGA SE OVO PITANJE MORA PREFORMULISATI: “JE LI LAKO HAKIRATI SIGURNOSNU KAMERU?”

Advertisement

Pripremio: Odjel marketinga za Evropu, Pripremio: Odjel marketinga za Evropu, Hikvision Hikvision marketing.eu@hikvision.com marketing.eu@hikvision.com

Mikko Hypponen, poznati fi nski ekspert za cyber sigurnost, postao je popularan po izjavi: “Ako je uređaj pametan, ranjiv je!” Time je ukazao na činjenicu da su nesigurni svi uređaji koji se sastoje od hardvera i softvera, a povezani su s internetom. Prema njemu, IP sigurnosna kamera je ranjiv uređaj koji je izložen potencijalnim hakerskim napadima i ključno pitanje je u kojoj mjeri ih je lako izvesti? Sigurnosne kamere dostupne su na tržištu u brojnim oblicima, a dizajnira ih, razvija i izrađuje više proizvođača iz različitih zemalja. Moderne kamere toliko su tehnološki napredne da spadaju u kategoriju rubnih računarskih uređaja za internet stvari. To znači da one obrađuju više složenih procesa i posjeduju veliku računarsku snagu.

Napadi i odbrane

Prateća tehnološka dostignuća pružaju nevjerovatne inovativne sigurnosne mogućnosti, ali nose i ozbiljne digitalne rizike. Savremene kamere sastoje se od mnoštva komponenti koje se proizvode interno ili ih rade drugi proizvođači i upravo zbog te svoje složenosti, kamera postaje zanimljiva i privlačna platforma za napade “cyber negativaca”. Činjenica je da je u historiji bilo mnogo primjera hakiranih kamera (npr. slučaj Mirai botnet malvera), što ih čini omiljenom metom cyber napadača. No, jesu li kamere stvarno laka meta? Zavisi. Kao što postoje različite vrste kamera, isto važi i za raznolike tipove digitalnih sigurnosnih mjera za kamere koje proizvođači mogu primijeniti. Upravo to je suštinski odgovor na gore navedeno pitanje. Otpornost kamera u osnovi zavisi od spremnosti proizvođača kamere da uloži napor i resurse u njihovu zaštitu.

Učiniti kamere težom metom

Je li sigurnost kamere investicijski prioritet za proizvođača? Činjenica je da su sve IP kamere ranjive. Međutim, istina je i sljedeće: što je teže hakirati kameru, veća je vjerovatnoća da će napadač odustati i preći na drugu kameru koju percipira kao lakšu metu. Hakeri su pametni i sofi sticirani, ali i vrlo pragmatični ljudi. Oni više vole lake mete, ukoliko mogu postići sličan rezultat. Proizvođač kamera koji ulaže u cyber sigurnost kako bi proizveo kameru otpornu na ovu vrstu napada učinit će svoj proizvod nepoželjnijom metom za hakere. Oni će se, u tom slučaju, radije fokusirati na kamere na kojima će postići iste rezultate uz manje napora. Zbog toga ulaganja u cyber sigurnost, poput proizvodnih procesa na bazi koncepta sigurnosti ugrađene u dizajn (Secure by Design) i Centra za sigurnosni odgovor, predstavljaju razliku između hakirane i kamere otporne na napade. Isto važi i za ulaganja u Centar za transparentnost izvornog koda i imenovanje regionalnih direktora za cyber sigurnost. Iako ove mjere ne moraju nužno podizati opći nivo sigurnosti, one pokazuju predanost kompanije cyber sigurnosti. Zato odgovor na pitanje je li lako hakirati sigurnosnu kameru najlakše možete dobiti ako provjerite proizvođača i njegov pristup zaštiti svojih proizvoda od cyber napada. Tada je na ovo pitanje lakše dati odgovor.

Predrasude u vještačkoj inteligenciji?

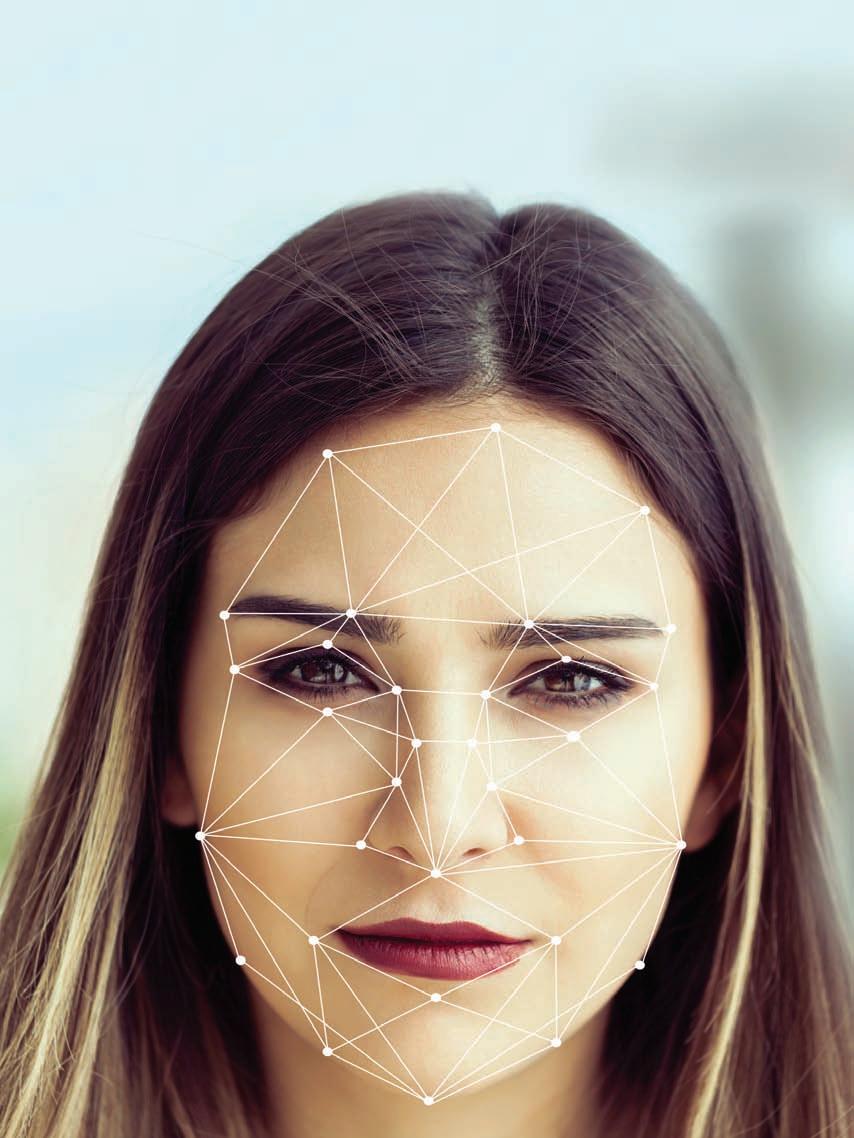

RASNA I SPOLNA PRISTRASNOST SISTEMA ZA PREPOZNAVANJE LICA

PREKOMJERNA UPOTREBA SILE ORGANA REDA NAD AFROAMERIKANCIMA I PROTESTI KOJE SU TAKVI SLUČAJEVI IZAZVALI ŠIROM SAD-a I DIJELA EVROPSKIH ZEMALJA U FOKUS SU STAVILI PROBLEME VEZANE ZA RASIZAM I ŠOVINIZAM. POKRENULO JE TO DIJALOG I O TOME JESU LI NOVE TEHNOLOGIJE PODLOŽNE RASNOJ I SPOLNOJ PRISTRASNOSTI

Piše: Vesna Matić Karić redakcija@asadria.com

Tokom kampanje “Black Lives Matter” bačeno je svjetlo na mogućnost da algoritmi u sistemima za prepoznavanje lica mogu biti pristrasni kada je riječ o ljudima tamnije boje kože, ali i ženama. Čitava situacija je dovela do toga da su, počevši od maja, tehnološki giganti poput IBM-a i Amazona suspendovali ili potpuno povukli iz upotrebe svoje sisteme za prepoznavanje lica zasnovane na AI algoritmima. Amazon je otišao i korak dalje te policiji uskratio upotrebu svog Rekognition softvera na godinu dana.

Tehnologija protkana predrasudama?

Miriam Vogel, predsjednica i izvršna direktorica kompanije Equal AI, napisala je na ovu temu veoma zanimljiv članak za TechChrunch. Naime, Vogel je jedno vrijeme radila sa Sally Yates, zamjenicom glavnog tužioca SAD-a, na educiranju o implicitnoj pristrasnosti pred saveznim organima za provođenje zakona u američkom Ministarstvu pravde. Tokom obuke su spoznali da aktivnosti pri provođenju zakona, kao što je prediktivni rad policije, često ciljaju zajednice u kojima žive stanovnici tamnije boje kože, što je na kraju i rezultiralo disproporcionalnim brojem hapšenja u tim zajednicama. Sva ta hapšenja se unose u sistem, gdje postaju statistički podaci, koji se zatim objedinjuju u veće skupove podataka, a koji se posljednjih godina koriste za stvaranje AI sistema. I tu dolazimo do problema. Ovaj postupak stvara povratnu petlju, gdje prediktivni policijski algoritmi navode zakonodavce da posmatraju kriminal samo u naseljima kojima i inače patroliraju, utječući tako direktno na podatke, a samim time i na buduće preporuke koje se tiču upotrebe ove tehnologije. To implicira da bi i hapšenja na protestima također mogla rezultirati statističkim podacima u budućim skupovima podataka koji će biti korišteni za izradu AI sistema. Ova povratna petlja u okviru AI-ja indirektno utječe na zakonodavstvo, pravdu, pa i samo društvo, jer s podacima prikupljenim na ovakav način dolazi do odluka, poput one koliko dugo će se neko zadržati u zatvoru, odnosno koliku kaznu će dobiti. Utjecaj se prostire na čitavo društvo jer će ovakvi podaci sutra utjecati i na to ko može dobiti kredit za kupovinu kuće ili ko će dobiti priliku da dođe na intervju u nekoj kompaniji itd. Kada imate automatiziran sistem zasnovan na vještačkoj inteligenciji koji očito nije imun na ljudska prirodna obilježja, poput boje kože, postavlja se pitanje kako u ovakvim slučajevima izbjeći još

veću nepravdu prema određenim društvenim skupinama, prvenstveno onima nad kojima već postoji društvena stigma.

Promjenjiva stopa tačnosti

Nedavni izvještaj Centra za etiku podataka i inovacije (CDEI), nezavisnog odbora koji je osnovala britanska vlada, pruža objašnjenje brojnih aspekata tehnologije za prepoznavanje lica: kako tačno funkcioniše, koristi i rizike njene upotrebe te pravni i regulatorni okvir kojim je okružena tehnološka sfera u toj zemlji. A da je tema pristrasnosti sistema za prepoznavanje lica izazvala pažnju britanske vlade, govori i činjenica da i ovaj izvještaj skreće pažnju na promjenjivu stopu tačnosti sistema koja zavisi od etničke pripadnosti, spola i starosti, sa često lošijim performansama kada je riječ o tamnoputim ljudima i Azijatima, stvarajući tako dodatne prepreke za nedovoljno zastupljene grupe koje pristupaju ključnim uslugama koje država nudi. Prema riječima Miriam Vogel, jasno je da vještačka inteligencija kakvu danas poznajemo i koristimo može održati, pa čak i uvećati nesvjesnu pristrasnost i to zahvaljujući tome što se prikupljeni podaci koje koriste zakonodavne snage, a koji ciljaju na ljude druge boje kože, koriste kao statistički podaci prilikom stvaranja AI sistema i kao takvi doprinose širenju pristrasnosti čak i kroz današnju tehnologiju.

Potencijalno rješenje problema

Međutim, i za ovaj problem postoji rješenje, a ono se svodi na uvođenje raznolikosti ideja i iskustava prilikom stvaranja AI-ja. Ali kao što se dosad pokazalo, to i nije lako uraditi. Uprkos dugogodišnjim obećanjima onih koji rade u IT sektoru na mnogo složenijim stvarima od uklanjanja na predrasudama stvorenih algoritama da će poraditi na povećanju raznolikosti, posebno kada je riječ o spolu i rasnoj pripadnosti, to se ipak nije desilo. Naime, nedavno objavljeni izvještaji pokazuju da je u Googleu i Microsoftu broj zaposlenika tamnije boje kože već pet godina i dalje skoro isti, odnosno da nije porastao čak ni za jedan cijeli procenat. Udio tamnoputih radnika u Appleu, prema posljednjim izvještajima, nije se do danas maknuo s

mjesta od početnih 6%. Zanimljivo je spomenuti da nabrojane kompanije objavljuju demografske izvještaje o tehničkoj radnoj snazi, dok neke, kao što je Amazon, ne rade čak ni to. Vogel smatra da bi, ukoliko se cijela situacija želi popraviti, etika obavezno trebala biti dio informatičkog obrazovanja, ali i zapošljavanja u okviru IT-a. Isto tako, AI timovi bi trebali biti obučeni i upoznati s antidiskriminacijskim zakonima i implicitnoj pristrasnosti, a pri tome bi se stalno trebalo naglašavati kakve sve negativne posljedice mogu proisteći iz zloupotrebe ovih stavki te kakav negativan utjecaj mogu imati na ljude. Kompanije bi morale poraditi na uključivanju različitih perspektiva prilikom kreiranja vlastite vještačke inteligencije, dok bi im vlada trebala biti partner tako što bi uspostavila jasna očekivanja i uputstva vezana za nastanak AI-ja.

Zakon o algoritamskoj odgovornosti

Prošle godine je u SAD-u predložen i zakon koji bi od korporacija zahtijevao da revidiraju svoje sisteme zasnovane na mašinskom učenju (poput onih namijenjenih prepoznavanju lica ili algoritama za ciljano reklamiranje) kada je u pitanju pristrasnost. Riječ je o Zakonu o algoritamskoj odgovornosti (Algorithmic Accountability Act). Inače, podržalo ga je nekoliko američkih senatora i, ukoliko bude odobren, tražio bi od Savezne trgovinske komisije da kreira pravila za procjenu “veoma osjetljivih” automatiziranih sistema. U tom slučaju, kompanije bi morale procijeniti jesu li algoritmi koji pokreću ove sisteme pristrasni ili diskriminirajući, kao i da li predstavljaju rizik za privatnost ili sigurnost potrošača. Zakon o algoritamskoj odgovornosti zapravo je usmjeren na velike kompanije koje imaju pristup ogromnoj količini podataka. Primjenjivao bi se na kompanije koje godišnje zarade više od pedeset miliona dolara, koje posjeduju informacije o najmanje milion ljudi ili uređaja ili koje primarno djeluju kao posredničke

Testirajući gotovo 200 algoritama za prepoznavanje lica od gotovo stotinu developera, NIST je utvrdio da su lažni pozitivni rezultati bili najviši među afroameričkom, azijskom i američkom indijskom populacijom.

kompanije koje kupuju i prodaju podatke potrošača. Ove godine u aprilu američka Savezna trgovinska komisija izdala je i vodič u kojem kompanije drži odgovornim za razumijevanje podataka koji leže u samoj osnovi AI-ja, kao i za njihove implikacije, te za pružanje transparentnih i objašnjivih ishoda potrošačima. Ron Wyden, jedan od senatora koji je podržao spomenuti zakon, dao je sljedeću izjavu: “Računari su u sve većoj mjeri uključeni u proces donošenja najvažnijih odluka koje utječu na život Amerikanaca – bilo da je to odluka ko može ili ne može kupiti kuću, zaposliti se ili čak ko će otići u zatvor. Ali umjesto da eliminišu pristrasnost, ovi algoritmi prečesto ovise o pristrasnim pretpostavkama ili podacima koji, zapravo, mogu pojačati diskriminaciju protiv žena i tamnoputih ljudi.” Pristrasnost u AI algoritmima postala je problem posebno kada je riječ o softveru za prepoznavanje lica. U Velikoj Britaniji su brojni sudski slučajevi dali zeleno svjetlo za legitimnu upotrebu ovog tipa tehnologije u svrhu borbe protiv kriminala, tako da je njihova policija već započela s tom praksom počevši od ove godine. Međutim, bitno je napomenuti da je u nezavisnom izvještaju Etičke komisije londonske policije navedeno da bi se ova tehnologija trebala koristiti samo ukoliko bi se pokazalo da neće generisati rodnu ili rasnu pristrasnost u policijskim operacijama.

Protivljenje IBM-a

U pismu upućenom Američkom kongresu u junu ove godine izvršni direktor IBMa Arvind Krishna rekao je da se njihova kompanija čvrsto protivi upotrebi bilo koje tehnologije, uključujući tu i onu za prepoznavanje lica koju nude drugi dobavljači, za masovni nadzor, rasno profi liranje, kršenje osnovnih ljudskih prava i sloboda ili za bilo koju svrhu koja nije u skladu s vrijednostima kompanije i principima povjerenja i transparentnosti. “Vjerujemo da je sada vrijeme da započnemo nacionalni dijalog o tome trebaju li i kako tehnologiju za prepoznavanje lica koristiti domaće agencije za provođenje zakona”, rekao je Krishna. U pismu dalje stoji da dobavljači ove tehnologije, kao i korisnici, imaju za-

jedničku odgovornost da se AI obavezno testira na potencijalnu pristrasnost i to posebno ukoliko se koristi u provođenju zakona te da se takvo testiranje revidira i da se o njemu izvještava. “Nacionalna politika također treba poticati i unaprijediti upotrebu tehnologije koja bi policiji donijela veću transparentnost i odgovornost, kao što su nosive kamere ili moderne tehnike analize podataka”, navodi Krishna. Da ironija bude veća, IBM je upao u probleme pokušavajući istraživačima osigurati veću raznolikost u svojim setovima podataka namijenjenim prepoznavanju lica. Naime, kompanija se našla na meti kritika zbog upotrebe jednog miliona slika dobijenih s Flickra (platforma za razmjenu fotografi ja) do kojih su došli bez pristanka osoba koje su se nalazile na fotografi jama. Fotografi je su bile dio skupa podataka koji nosi naziv Diversity in Faces, a same fotografi je su bile kodirane kako bi opisale fi zičke osobine subjekata kao što su, između ostalog, geometrija lica, ton kože i procijenjena dob i spol. Ovo nije jedini takav slučaj. Dvoje građana Illinoisa podnijeli su tužbe protiv Amazona,

Ubrzan rast upotrebe vještačke inteligencije

Ljudi vjerovatno nisu ni svjesni u kolikoj mjeri se posljednjih godina povećala upotreba vještačke inteligencije u svijetu. Prema podacima koje iznosi vodeća istraživačko-savjetodavna kompanija Gartner, broj preduzeća koja koriste AI porastao je za čak 270% od 2015. do 2019. godine. Prema podacima kompanije za istraživanje tržišta Omdia Tractica, očekuje se da će vrijednost tržišta vještačke inteligencije porasti sa 9,5 milijardi dolara u 2018. na 118,6 milijardi do 2025. Zanimljiv je i Gallupov podatak da je još 2017. godine 85% Amerikanaca koristilo AI u nekom obliku.

Alphabeta (Googleova matična kompanija) i Microsofta navodeći da su njihove slike pribavljene bez njihovog pristanka te da je to u suprotnosti sa državnim statutom o očuvanju privatnosti biometrijskih podataka.

Zabrinjavajući trend

Dosta podataka koji su u novije vrijeme izašli u javnost ukazuje na zabrinjavajući trend da AI i algoritmi za prepoznavanje lica mogu biti predmet nesvjesnih pristrasnosti u pogledu rasne i etničke pripadnosti. Istraživači s MIT-a i Univerziteta Stanford otkrili su da su tri komercijalna programa vodećih tehnoloških kompanija za analizu lica pokazala pristrasnost prema tipu kože i spolu. I dok postotak grešaka u određivanju spola muškaraca svijetle puti ni u jednom slučaju nije bio veći od 0,8 posto, stope pogrešaka porasle su na više od 34 posto kod žena tamnije puti. Najnoviji od nekoliko testova programa za prepoznavanje lica objavio je Nacionalni institut za standarde i tehnologiju u SAD-u u decembru prošle godine. Testirajući gotovo 200 algoritama za prepoznavanje lica od gotovo stotinu developera, utvrđeno je da su lažni pozitivni rezultati – koji imaju mnogo veće razlike nego lažni negativni rezultati – bili najviši među afroameričkom, azijskom i američkom indijskom populacijom. NIST je također preporučio operaterima da istražuju karakteristike algoritama koje koriste tako što će ih redovno testirati, jer je utvrđena velika razlika u tačnosti različitih algoritama. Mnogi smatraju da jedini način da se situacija popravi na ovom polju jeste da se zakonodavnim putem reguliše upotreba ovog softvera, jer mnogi stručnjaci misle da nije dovoljno samo to da developeri ubuduće pripaze na pristrasnost prilikom kreiranja algoritama.