7 minute read

Procesoptimalisatie met kunstmatige intelligentie

INTERVIEW <

Foto: WCM

Advertisement

Procesoptimalisatie met

kunstmatige intelligentie

Door inzet van artifi cial intelligence (AI) bij industriële automatisering valt een forse winst te behalen op het vlak van het optimaliseren van productieprocessen. Hoe werkt dat, wat is de meerwaarde en heeft dat gevolgen voor de onderhoudssector? “Artifi cial Intelligence is een populair paraplubegrip dat snel aanslaat, maar daardoor wel betekenis verliest”.

Nick Schermer is project- en accountmanager bij CoNet, specialist in procesoptimalisatie en system integrator. Kasper Groenbroek werkt als solution architect bij ORTEC, ‘s werelds grootste leverancier van wiskundige optimalisatiesoftware en advanced analytics. Beide bedrijven werken samen aan twee projecten om bovengenoemd doel te bereiken. In Nederland bij een zuivelbedrijf dat eiwitpoeder produceert en in Polen bij een vestiging van een internationale producent van persoonlijke verzorgingsmiddelen.

> Over wat voor projecten gaat het? Schermer; “Bij industriële

automatisering vanuit CoNet krijgen we van klanten twee soorten vragen. Bij het zuivelbedrijf gaat het om procesregelingen die te complex worden om binnen de cyclustijd van een PLC te berekenen, dus moet een andere oplossing worden gevonden. De klant vraagt ons mee te denken over verbetering. We sturen de actuele proceswaardes naar een model, dat voert de berekening uit en geeft de nieuwe setpoints weer terug aan de besturing. Voor de slimme regelaar aan de buitenkant heb ik ORTEC voor het bouwen van die intelligentie. Bij het project in Polen was aan de regeling niets te verbeteren. Daar nemen ze, als het product klaar is, een sample om in het laboratorium te kijken of het aan alles eisen voldoet. Is de viscositeit goed, zijn de kleur en de geur goed, et cetera. Daar laten we nu een model rekenen om met grote nauwkeurigheid te kunnen bepalen of het product binnen specifi catie is en is de laboratoriumcheck daardoor niet meer nodig”.

Groenbroek; “In beide gevallen gaat het dus om bestaande productieprocessen. Samen maken we die processen slimmer door bijvoorbeeld de tijdsduur te verkorten, dat heeft veel waarde voor de proceseigenaren. In Polen ging het om een bepaalde viscositeit. Viscositeit meten is lastig. Laboratoriumanalyse van een deel van het product levert een viscositeitsgetal op. Wij kunnen met allerlei sensoren die in het productieproces zitten (bijvoorbeeld druk, temperatuur en allerlei andere metingen) voorspellen wat de viscositeit is. Een computermodel kan dat veel sneller dan een handmatige aanpak”.

> Dat laboratorium kan opgedoekt? Schermer; “Nee, dat

model berekent ook de kans hoe goed hij de waarde inschat. Ligt dat dicht tegen de marges, kunnen ze evengoed nog beslissen een laboratoriummonster te analyseren. Zitten ze middenin het meetgebied, dan kunnen ze gewoon doorgaan. Daarnaast blijven ze monsters nemen en die invullen in het systeem. Met terugwerkende kracht vindt dan machine learning plaats. Het model weet dan wanneer welke proceswaarden gemeten zijn en wat de uitkomst was van de diverse laboratoriumsamples”. Groenbroek; “En een producent verandert wel eens iets in het proces of introduceert een nieuw product. Daar weet zo’n model dan weinig over. Wil je bewijs dat het model ook goed is voor dat nieuwe product, dan zul je nog steeds laboratoriumwerk moeten doen”.

> Wat brengt AI ons nog meer? Groenbroek; “Artifi cial Intelligence is een populair paraplubegrip dat snel aanslaat, maar daardoor wel betekenis verliest. Het is het vakgebied van wiskundigen, econometristen, van programmeurs en van mensen die AI als studierichting hadden. Zij bouwen rekenmodellen en verpakken dat in een stukje software, om daarmee beslissingen te ondersteunen en processen te optimaliseren. Puzzels oplossen die mensen niet kunnen oplossen. Slim omgaan met onzekerheden. Op die manier heeft het meerwaarde. Dat gaat heel ver. Wij zijn bijvoorbeeld bekend om onze roosterplanningen en routeberekeningen. Bijzonder moeilijke puzzels waarbij AI zeer waardevol is. Binnen manufacturing is ook veel ruimte voor procesverbetering met AI. Samen met CoNet zijn we daar op verkenningstocht. Genoemde voorbeelden zijn inmiddels succesverhalen”.

Schermer; “De industrie heeft het lang afgehouden. Vroeger deden bedrijven wel wat, alleen met bijvoorbeeld ORTEC. Dat leidt wel tot een model, maar dat werkt dan nog niet optimaal omdat het niet feilloos is geïntegreerd in de installaties. Je hebt daarvoor de specifi eke kennis van een system integrator nodig om de interfaces te kunnen bouwen.” Groenbroek; “Klopt, wij hebben gewoon minder domeinkennis. Als je mij naast een operator zet, heb ik minder aansluiting dan iemand van CoNet”.

> Hoe werkt dat ‘zelf leren’ van een model? Groenbroek;

“De meesten kennen wel de trendlijn in Excel. ‘Leren’ is in dit verband die trendlijn kunnen schatten. Om een voorspelling te maken, kies je een getal op de x-as en lees je de bijbehorende hoogte op de y-as. Zodra er nieuwe data bekend zijn, is de trendlijn opnieuw te berekenen. Een systeem waarin die truc geautomatiseerd is, is een zelfl erend systeem. In ons werk gebruiken we niet meer de trendlijn van Excel, maar krachtigere technologieën zoals decision trees en neurale netwerken. Die kunnen beter omgaan met complexe verbanden en grotere hoeveelheden data, maar de basisprincipes zijn hetzelfde. In het voorbeeld van viscositeit heeft het model geleerd van historische data over druk, temperatuur et cetera, en bijbehorende uitkomsten van het laboratorium. Ik geef vervolgens nieuwe data en daarmee kan het model de viscositeit voorspellen. Er zijn heel veel keuzes aan technologieën voor het opzetten van zo’n model, maar >

Nick Schermer Foto: CoNet

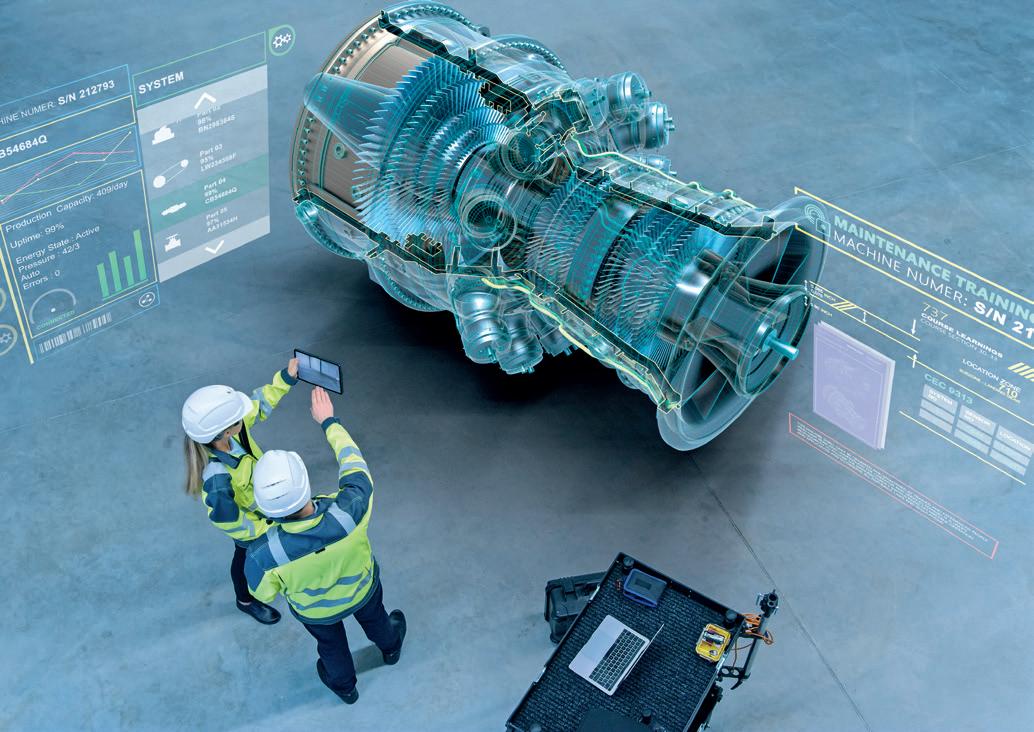

Foto: WCM Maintenance Training Foto: WCM

>

ook voor het valideren. Is het model wel nauwkeurig? We tunen zo’n model ook om het steeds een beetje beter te maken. In theorie zou je dat eindeloos kunnen doen, maar daar gaat de klant uiteraard niet mee akkoord. Het is de kunst om in korte tijd een goed resultaat te behalen”.

> Hoeveel tijd beslaan zulke projecten? Schermer; “Denk

aan 2-3 maanden. Het vergaren van data kost altijd meer tijd dan een klant denkt. Meestal worden de data uit processen wel goed gelogd. Komt daar een parameter bij die toch wel belangrijk is en daar is nog geen goede historie van, dan moet je wachten tot die is opgebouwd. Voor de validatie van een model heb je vaak toch ook wel laboratoriumdata of andere analysedata nodig. Dat loopt vaak in een andere tijd dan de datalogging. En de zoektocht die daaruit voortkomt, kost tijd. Om het model zelf te kunnen laten leren, moet het wel uit een databron kunnen putten. Wij moeten dus zorgen voor centraal beschikbare datastromen. En je moet ook weer controleren of dat zelf leren nog aan de eisen voldoet”.

Groenbroek; “We praten hier over software die deels op maat wordt ontwikkeld. De historie heeft geleerd dat het slim is daarmee klein te beginnen en dat iteratief op te schalen of complexer te maken. Eerst op kleine schaal kijken of je een klant kunt helpen en daarna proberen het nog slimmer te maken, in kleine stapjes dus. Wat Nick omschreef, begint ook een naam te krijgen. Er ontstaan nieuwe vakgebieden. Data beschikbaar maken en dat continu streamen valt tegenwoordig onder Data Engineering. Het in de gaten houden van modellen en bijtrainen voor nieuwe productsoorten, is een taak voor MLOps, Machine Learning Operations”.

> Is dit alleen weggelegd voor hele grote bedrijven?

Schermer; “Misschien, maar kleinere bedrijven kunnen dit natuurlijk ook inzetten, al hangt er natuurlijk wel een prijskaartje aan. Wij werken er niet 3 maanden continu aan, maar in die periode zo’n 300-400 uur. Draait het eenmaal, dan zijn de kosten soms binnen een maand al terugverdiend door de procesoptimalisatie”.

> Wat kan de onderhoudssector hiermee? Groenbroek; “Je

belandt dan snel in de hoek van predictive maintenance. Net als in bestaande productieprocessen, is ook de onderhoudswereld wat terughoudend in het toepassen van dit soort nieuwere technologieën. Onderhoud wordt toch vaak gezien als noodzakelijk kwaad, niet de plek waar geld wordt verdiend. Het is dus makkelijker praten over sneller en slimmer kunnen produceren, dan over predictive maintenance. We zijn daar dus nog niet erg succesvol, hoewel we wel de kennis en de skills hebben om op dit vlak projecten uit te voeren”.

Schermer; “Toch zit het er stiekem al wel een klein beetje in. In Polen bijvoorbeeld rekenen we met pompdruk en motorvermogens. Daarin kunnen we ook bijvoorbeeld pompslijtage meenemen. Dan kan het model dus voorspellen wanneer een pomp vervangen moet. Daarmee zou in de toekomst gewerkt kunnen worden binnen maintenance. Met weer een andere klant, die over de hele wereld machines levert, ben ik daarover wel in gesprek. Die klant wil alle machinedata verzamelen. Wij gaan die terug de cloud in sturen en hebben een systeem bedacht om al die machines onderling te vergelijken. Het idee is om in de toekomst met slimme rekenmodelletjes bij de klant elke seconde de performance van een apparaat te vergelijken met de standaard. Uitgangspunt: met die uitkomsten de spare parts-afdeling optimaliseren”. <