Personalizzazione e cura dell'esperienza del cliente sono le sfide da vincere, anche con l'aiuto dell'AI.

Phishing, ransomware e rischi legati alla supply chain affliggono le aziende. Dall'utopia dell'inviolabilità, il focus si sposta sulla resilienza.

Dalle fabbriche ai magazzini, la"quarta rivoluzione industriale" plasma i processi e anche una nuova mentalità nel manifatturiero.

SPECIALE CIO

Il ruolo dei chief information officer è sempre più complesso: non solo leader dell'innovazione, ma anche mediatori e comunicatori.

N° 62 - APRILE 2024

Periodico mensile registrato

presso il Tribunale di Milano al n° 378 del 09/10/2012

Direttore responsabile:

Emilio Mango

Coordinamento:

Valentina Bernocco

Hanno collaborato:

Roberto Bonino, Stefano Brigaglia, Fabrizio Liberatore, Arianna Perri, Elena Vaciago

Foto e illustrazioni:

123rf.com, Burst, Freepik, Pixabay, Unsplash, Adobe Firefly

Editore e redazione:

Indigo Communication Srl

Via Palermo, 5 - 20121 Milano tel: 02 87285220

www.indigocom.it

Pubblicità:

The Innovation Group Srl tel: 02 87285500

Stampa: Ciscra SpA - Arcore (MB)

© Copyright 2024

The Innovation Group Srl

Tutti i diritti di proprietà letteraria e artistica riservati.

Il Sole 24 Ore non ha partecipato alla realizzazione di questo periodico e non ha responsabilità per il suo contenuto.

Pubblicazione ceduta gratuitamente.

Un mondo nuovo, di valori e tecnologie

La personalizzazione abbraccia le vendite B2B

Tra sfide del presente e promesse del futuro

AI Pc, la spinta che solleverà il mercato

Una strategia sui dati è il punto di partenza

Un mondo di sintesi tra dati, natura e prodotti

Connettività solida, anche a misura di azienda

L’AI è anche questione di infrastrutture

Libertà nel cloud per una “resilienza radicale”

La gestione della crisi è ancora imperfetta

Il “cervello” di Einstein continua a potenziare il Crm

Il cloud distribuito fa proseliti

Il process mining incontra l’AI e migliora la produttività

L’approccio nuovo di Idi Evolution

Al timone del cambiamento

Governance e fiducia per far leva sui dati Strategie per arginare i rischi

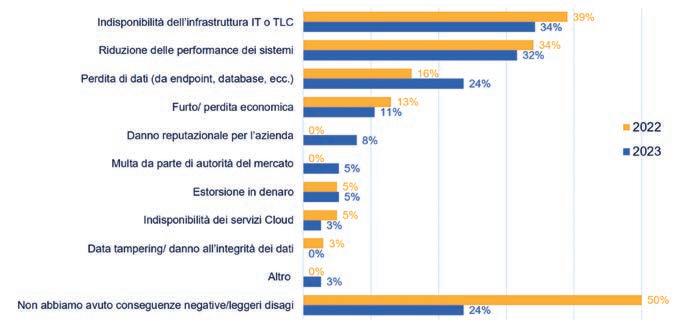

Radiografia del rischio nelle aziende italiane

AI e supercalcolo: l’accoppiata vincente

La via del marketing iper-personalizzato

Esperienze italiane di rivoluzione

Alce Nero - Aruba Enterprise

Vhit - Lenovo

Gruppo Sarni - Avm

Università di Pisa - Vertiv

Le aziende inseguono l’omnicanalità, mentre i confini tra commercio “tradizionale” e “digitale” si sgretolano. Intervista a Roberto Liscia, presidente di Netcomm.

Il mondo del commercio è in continua evoluzione: a trasformarsi sono l’offerta e la domanda, naturalmente, ma anche la struttura delle supply chain, le tecnologie a supporto della vendita e la relazione con i clienti. E si trasformano i clienti stessi, che negli ultimi decenni sono diventati il vero fulcro delle strategie di marketing e di vendita. Omnicanalità, personalizzazione dell’offerta e del messaggio, sosteni-

bilità ed emozionalità dell’esperienza sono i nuovi valori che si affiancano alla tradizionale leva del prezzo, ma resta anche valida (anzi forse lo è più che mai, nella cultura della Generazione Z) la richiesta di comodità e velocità. Questo è, almeno, ciò che in questi anni ci hanno raccontato analisti di mercato, esperti di marketing e sociologi. Che ruolo può avere in tutto questo la tecnologia? Roberto Liscia , presidente di Netcomm,

il Consorzio del Commercio Digitale Italiano, ci ha offerto il suo punto di vista.

Come sta cambiando lo scenario del commercio? Che ricadute hanno le dinamiche dell’economia e della geopolitica?

La contesa geopolitica influenza inevitabilmente le catene del valore. Dal punto di vista dell’offerta, c’è una tendenza a ricreare dazi: questo condiziona i prezzi nelle aree geografiche interessate, come già accaduto con la Brexit, e può portare a un riallineamento delle catene di approvvigionamento, che si modificano

Secondo le stime di eMarketer, nel 2023 i retailer di tutto il mondo hanno venduto via Internet l’equivalente di 5.784 miliardi di dollari di prodotti e servizi (la somma non include la vendita di biglietti per eventi e trasporti, i pagamenti digitali di tasse o ristorazione, i giochi a premio e i trasferimenti di denaro). Il valore segna una crescita dell’8,9% sul 2022. Per il 2024 si prevede un’ulteriore ascesa, fino a un giro d’affari di 6.330 miliardi di dollari. Aumenta anche l’incidenza della componente e-commerce sul totale delle vendite retail, dal 19,5% del 2023 a una quota prevista intorno al 20,3% per quest’anno.

Il colosso cinese Alibaba è attualmente l’operatore retail di commercio elettronico più grande al mondo, con un market share del 23% (nel 2022) in termini di valore monetario totale delle vendite. Amazon segue a distanza con una fetta pari al 12%, ma dall’aggregazione di diverse fonti gli analisti

o si accorciano per ridurre la dipendenza da fornitori provenienti da aree ad alto rischio. C’è poi un secondo tema, quello delle risorse energetiche: viste le incertezze sull’approvvigionamento di materie prime e sui loro costi finali, i Paesi tendono ad aumentare i prezzi e ad appropriarsi preventivamente delle riserve. Infine il tema dei semiconduttori, che influenza soprattutto l’industria informatica e automobilistica e che è dominato dalla contesa tra Stati Uniti e Cina, benché l’Europa con il Chips Act abbia stanziato una cifra importante per incrementare la produzione interna. Naturalmente la geopolitica e l’economia influenzano anche la domanda, perché tutte le dinamiche sopra citate creano incertezza per il consumatore.

Quali evoluzioni osservate in Italia?

Nel 2023 il commercio elettronico business-to-consumer è cresciuto del 13%, arrivando a un giro d’affari di 54 miliardi di euro. I prodotti sono arrivati a valere 35,2 miliardi di euro, con un incremento dell’8% rispetto al 2022,

di Statista hanno stimato che nel 2027 l’e-commerce della società di Seattle potrebbe segnare il sorpasso e raggiungere un volume annuo di vendita di circa 1.200 miliardi di dollari. Sempre a detta di Statista, i social media nei prossimi anni non perderanno rilevanza come canale di marketing e di vendita, e ci si aspetta che nel 2026 il valore annuo veicolato sarà di 2.900 miliardi di dollari circa. Su base geografica il mercato più importante è la Cina, dove WeChat, Taobao, Xiaohongshu e altre piattaforme social veicolano o almeno influenzano le scelte di acquisto di un consumatore su due. E l’Europa? Secondo un sondaggio della Commissione Europea , l’anno scorso il 92% dei cittadini Ue ha utilizzato Internet e il 69% lo ha fatto anche per comprare prodotti e servizi. Abbigliamento e accessori sono stati la categoria merceologica più acquistata (44% del totale dei clienti dell’ecommerce).

principalmente dovuto all’inflazione. I servizi sono invece cresciuti del 22%, con la spinta soprattutto dei settori turismo, ticketing ed eventi. Anche gli acquisti di informatica, abbigliamento e beauty sono cresciuti, mentre è calato il settore del grocery. In questo quadro si nota che il tasso di penetrazione dell’online sul commercio italiano è arrivato al 12% nel 2023, per la precisione all’11% per i prodotti e al 16% per i servizi.

Vediamo tre principali sfide per il 2024:

migliorare l’esperienza del cliente, integrare la logistica per offrire più possibilità di scelta sulle consegne e, in terzo luogo, valorizzare i dati. La nostra previsione per il 2024 è che sarà un anno con un forte orientamento all’omnicanalità.

Quali valori, soprattutto, orientano i consumatori?

Il prezzo resta un concetto chiave ma anche la sostenibilità è entrata prepotentemente tra i valori che orientano le scelte. A parità di prezzo, il consumatore oggi acquista il prodotto più sostenibile. Un terzo fattore rilevante è la reputazione: i brand tendono a puntare sulla totale trasparenza e un qualsiasi passo falso può mettere a repentaglio tutto il valore costruito nel tempo. In sostanza, oggi le aziende non solo devono dichiarare come agiscono ma anche essere coerenti con ciò che hanno dichiarato. Si pensi, ad esempio, alla causa che Amazon ha recentemente vinto in Italia contro un sito che promuoveva la creazione di recensioni false.

Intelligenza artificiale, ma anche automazione, Blockchain, social commerce, extended reality, pagamenti digitali. Sono solo alcuni dei temi al centro della prossima edizione del Netcomm Forum, la diciannovesima, in programma l’8 e il 9 maggio all’Allianz MiCo di Milano. Organizzato da Netcomm, il Consorzio del Commercio Digitale Italiano, con il supporto di TIG Events, l’evento prevede in agenda tre sessioni plenarie, in cui si alterneranno sul palco keynote

Da diversi anni si parla di omnicanalità come strategia necessaria per offrire un’esperienza coerente. A che punto siamo?

L’omnicanalità necessita di investimenti cospicui per creare un’esperienza seamless e user-friendly, indipendentemente dal canale utilizzato. Questo significa garantire coerenza sui vari canali in termini di valori, prezzo, qualità dei prodotti, significato del brand ed esperienza di acquisto. Il consumatore si aspetta dal supermercato sotto casa la stessa esperienza che sperimenta con Amazon (penso per esempio ai servizi di notifica e suggerimenti di acquisto tramite Alexa sui dispositivi Echo, personalizzati sulle abitudini dell’utente). Ma per realizzare tutto ciò è necessario che il customer journey venga gestito attraverso i dati, e per questo sono necessari investimenti molto importanti mirati allo studio del cliente, delle sue scelte di acquisto e dei suoi comportamenti attuali e futuri. La “esperienzialità” personalizzata dev’essere gestita, organizzata e resa coerente con il rispetto della privacy del consumatore, così da poter diventare un servizio e un valore.

Ha ancora senso distinguere tra commercio “tradizionale” e commercio “digitale”?

Molti consumatori, specie i più giovani, ormai non scelgono a priori un canale di

speech, interviste, tavole rotonde e case history. Saranno in scena anche decine di sessioni parallele con eventi a cura della Netcomm Academy e oltre 170 workshop dedicati a strategie e tecnologie per l’innovazione del commercio. Inoltre saranno presentati i risultati dell’osservatorio “Netcomm NetRetail 2024”, della ricerca “Il Venture Capital nel Digital Retail & Services” e dell’ultimo “Delivery Index”, studio condotto da Netcomm in collaborazione con Poste Italiane.

acquisto specifico ma si rivolgono di volta in volta all’opzione più comoda in quel momento. Ed è interessante notare che, secondo i dati del nostro studio “Netcomm NetRetail” del 2023, quasi il 70% degli acquisti in negozio è condizionato da precedenti ricerche fatte online, e la percentuale è anche maggiore per articoli di informatica ed elettrodomestici. Ma vale anche l’opposto: il 24% degli acquisti online è condizionato da una visita in negozio, e la percentuale sale per gli articoli di un certo valore, di cui il consumatore vuole verificare la qualità di persona. Pensiamo che tutto ciò sia un’opportunità per i retailer, che possono quindi ragionare in ottica integrata, sfruttando i canali digitali per promuovere gli acquisti in negozio e viceversa. Digitale e fisico sono sempre più strettamente interrelati.

Avete centrato questa edizione del Netcomm Forum sul tema del commercio “fluido e componibile”. Che cosa significa?

Il commercio elettronico del futuro va incontro a grandi scommesse, che necessitano di poter contare su tecnologie adattabili, flessibili, integrabili e scalabili. Gli operatori del commercio vanno incontro, da un lato, a un cliente sempre più mutevole e, dall’altro, a scenari geopolitici sempre più incerti. Servono quindi piattaforme facili da adottare ma

anche flessibili e scalabili, capaci quindi di supportare improvvisi aumenti della domanda o il lancio di nuovi servizi, anche in risposta a eventi inaspettati.

Come immaginate il commercio del futuro?

Sicuramente sarà integrato, flessibile, spinto dalle nuove tecnologie e soprattutto da consumatori che cambiano continuamente. Tecnologie come l’intelligenza artificiale, l’Internet of Things, il 5G e il metaverso giocheranno un ruolo determinante, ma è importante che le aziende non le considerino una mera aggiunta bensì un elemento abilitante all’interno delle proprie strategie. L’intelligenza artificiale, in particolare, ha tre possibili ricadute sulle aziende del commercio: innanzitutto aumenta l’efficienza e dunque riduce i costi, per esempio quelli del marketing; in secondo luogo, attraverso la personalizzazione, aumenta l’efficacia dei messaggi e il coinvolgimento dei clienti; terzo punto, è in grado di trasformare i modelli di business, aiutando a creare nuovi prodotti e servizi. L’AI, inoltre, potrà contribuire a rendere meno costoso lo sviluppo del metaverso, e dunque a velocizzarne l’adozione anche all’interno del settore del commercio. In sintesi, crediamo che il futuro di questo settore correrà su tre binari: le tecnologie, le persone e le strategie.

Valentina BernoccoAnche nel commercio “business to business” si affermano strategie di focalizzazione sul cliente e di omnicanalità.

Cresce e si trasforma, inseguendo e cavalcando le possibilità della tecnologia: è il commercio “business to business”, un settore che sempre più condivide con il B2C alcune tendenze. Intendendo per commercio B2B l’insieme delle attività di vendita di prodotti e servizi da azienda ad azienda, si può stimare (dai dati di Statista e AgileIntel Research) che la componente e-commerce abbia raggiunto oggi un giro d’affari mondiale di 23,4 miliardi di dollari in termini di valore lordo della merce venduta, ovvero più del doppio rispetto al 2018. E si prevede un’ulteriore crescita del 12% da qui al 2027, oltre la soglia dei 37 miliardi di dollari. L’espansione del mercato, dicevamo, si accompagna alla sua trasformazione: anche nel B2B, come nel B2C, l’innovazione tecnologica è sempre più una leva competitiva. La personalizzazione della customer experience attraverso i dati, con il supporto di analytics e intelligenza artificiale, è per esempio un fenomeno trasversale. L’approccio cliente-centrico, che domina nel B2C,

si ripresenta nel B2B. Così si spiega anche la crescita dei marketplace, un canale ancora secondario sul totale dei volumi, ma che sta guadagnando quota perché offre opzioni di vendita e di acquisto più flessibili, personalizzate e scalabili. La personalizzazione riguarda non solo l’offerta, cioè i prodotti e servizi, bensì anche le modalità di acquisto, i prezzi (con logiche di fidelizzazione e sconti), i metodi di pagamento, il servizio clienti.

E di pari passo con la personalizzazione sta aumentando l’adozione di strategie di omnicanalità, perché molti responsabili degli acquisti aziendali sono ormai soliti confrontare prodotti e offerte su diversi canali di vendita.

“Il comparto del B2B sta assistendo a un processo di costante digitalizzazione, che contribuisce alla crescita dei ricavi del settore in tutto il panorama internazionale”, ha detto Roberto Liscia, presidente di Netcomm. “In questo contesto, l’Europa detiene il 6% del valore globale del B2B Digital Commerce globale, i Paesi dell’Asia Pacifico il 79% e la Cina, da sola, oltre il 40%.

Nel nostro Paese, dove il settore B2B è tradizionalmente guidato da dinamiche commerciali rigide e articolate che prevedono l’intermediazione di rappresentanti di vendita nella gestione delle trattative, è necessaria l’introduzione di strumenti innovativi per rispondere alle nuove esigenze dei buyer che, anche a seguito del cambio generazionale, sono sempre più orientati verso esperienze d’acquisto agili e personalizzate”. A livello europeo, secondo i dati di Statista, il giro d’affari dell’e-commerce B2B è ancora piccolo rispetto al mercato globale, di cui rappresenta il 6%. Ha però una traiettoria di crescita in linea (11%, contro il 12% del mercato totale) e si stima arriverà quest’anno a valere 1,67 miliardi di dollari, contro gli 1,5 miliardi del 2023. In Italia, secondo i dati del Politecnico di Milano, l’e-commerce incide per il 21% sul totale del transato delle vendite B2B. “La flessibilità garantita dalla digitalizzazione gioca un ruolo determinante per lo sviluppo del settore, consentendo agli attori della filiera di gestire le vendite in modo efficiente e di raccogliere dati e informazioni utili all’analisi operativa e alla pianificazione di future strategie finalizzate alla creazione di relazioni a lungo termine con i clienti”, ha sottolineato Liscia. Il consorzio Netcomm indica tra le tendenze da cavalcare anche in Italia l’uso dell’intelligenza artificiale, naturalmente, e poi il cosiddetto headless commerce, cioè la separazione tra front-end e back-end di applicazioni e siti di e-commerce. Anche nel B2B, inoltre, il commercio va ripensato in ottica di tecnologia “componibile”, ovvero creando architetture basate sull’assemblaggio di differenti servizi, che permettono di gestire i processi di vendita in modo più efficiente, disintermediato e autonomo.

Le aziende ritornano imprese: con un’imprescindibile personalizzazione dell’esperienza e dei servizi offerti, con una correlazione lineare tra i valori aziendali e quelli del target, e infine canali conversazionali che supportino il brand dal primo momento di espressione di interesse, fino alla creazione di una loyalty ‘audace’. Quasi superfluo dire che tutti i processi saranno potenziati e resi efficienti dalla rivoluzione dell’intelligenza artificiale. Per il futuro ci aspettiamo una trasformazione attraverso la realtà virtuale e conversazioni più intime, permettendo interazioni istantanee e immediate in cui non si parlerà più di device o canali, né di fisico o digitale. Un prossimo futuro che mira alla completa integrazione tra sistemi e dati, facilitati, ovviamente, dall’AI. Oggi si pongono le basi per nuovi e avanzati standard tecnologici e dispositivi che permetteranno di vivere queste evoluzioni.

AlpeniteIn Amazon Ads pensiamo sempre a come ridurre gli ostacoli dei nostri inserzionisti, per questo abbiamo lanciato la generazione di immagini tramite soluzioni di AI, progettata per consentire ai brand di produrre immagini che possano contribuire a migliorare le performance dei loro annunci. Acquisire nuovi clienti e fidelizzare quelli esistenti è fondamentale, i clienti sono maggiormente propensi ad acquistare più spesso da brand che già conoscono e di cui si fidano. Tramite remarketing possiamo coinvolgere nuovamente i clienti esistenti e tenere aggiornati gli acquirenti sui prodotti e offerte.

Amazon Ads

Oggi per le aziende è diventato imprescindibile adottare modelli di vendita omnicanale, che sappiano garantire ai clienti un’esperienza di acquisto diversificata, fluida e personalizzata, in cui la fase del pagamento sia in grado di massimizzare il tasso di accettazione delle transazioni, grazie all’adozione di strumenti innovativi fondamentali per l’e-commerce del futuro: metodi di pagamento diversificati, tra cui l’account to account e il Buy Now Pay Later, nuovi strumenti come il fast checkout che garantiscono pagamenti in un click, sistemi avanzati di analisi del rischio frodi, per cui sempre più verrà applicata l’intelligenza artificiale.

NexiLe aziende oggi affrontano sfide complesse per conquistare e fidelizzare i clienti in mercati competitivi. Devono distinguersi attraverso esperienze personalizzate, adattarsi velocemente alle mutevoli esigenze dei clienti e sfruttare le tecnologie emergenti. Gestire la reputazione online, offrire un’eccellente esperienza cliente ed essere profondamente riconoscibili sono solo alcuni dei punti cruciali. La chiave è combinare innovazione, investimenti mirati e una profonda comprensione dei clienti per mantenere un vantaggio competitivo. Nel commercio del futuro vedo un ambiente altamente tecnologico e interconnesso. La sinergia delle tecnologie avanzate permetterà la personalizzazione delle esperienze online degli utenti e consentirà di avere una catena di approvvigionamento più efficiente e trasparente. Inoltre, migliorerà l’esperienza di acquisto online garantendo esperienze di acquisto più coinvolgenti e interattive. Tecnologie come AI e VR saranno la chiave di tutto. La blockchain, invece, garantirà la sicurezza delle transazioni. Vedo, dunque, un futuro ricco di possibilità.

Diego Santoro, technical support and e-commerce manager di Connecteed

Quali criticità affrontano le aziende, oggi, per conquistare e fidelizzare i clienti in mercati sempre più competitivi? E che aspetto avrà il commercio del futuro, quali dinamiche e tecnologie lo governeranno? Lo abbiamo chiesto ad alcune delle aziende sponsor di questa edizione di Netcomm Forum.

Uno scenario macroeconomico sempre più complesso, consumatori attenti al prezzo e con elevate aspettative sull’esperienza d’acquisto stanno rendendo il mercato globale sempre più competitivo. Di conseguenza, i retailer dovranno ripensare le proprie strategie, diventando maggiormente agili e proattivi; dovranno anticipare i bisogni del consumatore e proporre messaggi personalizzati, offrendo un’esperienza d’acquisto fluida che superi i confini geografici. L’intelligenza artificiale e il digitale saranno alleati sempre più preziosi per affrontare le sfide del futuro. L’innovazione tecnologica sta ridefinendo le aspettative future dei consumatori nei confronti dei marchi. Osserviamo una crescente attenzione al rapporto che ogni brand crea con i propri clienti, i quali ricercano semplicità d’acquisto e immediatezza di risposta. Laddove il processo e le esperienze d’acquisto si allungano e si complicano nel tempo, serve essere presenti e prospettici: presenze costanti per i propri clienti. L’ intelligenza artificiale avrà un ruolo chiave nel rinnovare il commercio come lo conosciamo, rendendolo sempre più semplice e vicino alle esigenze del singolo consumatore.

Incoraggiare i clienti ad acquistare i tuoi prodotti può contribuire ad aumentare il tasso di crescita della tua attività. Acquisire nuovi clienti e fidelizzare quelli esistenti è fondamentale, dato che i clienti sono maggiormente propensi ad acquistare più spesso da brand che già conoscono e di cui si fidano. Coinvolgere nuovamente i clienti esistenti e tenere aggiornati gli acquirenti sui prodotti e sulle offerte sono due modi per incoraggiare gli acquisti ripetuti. Il remarketing è una parte importante del digital marketing perché il processo d’acquisto del cliente richiede tempo. La maggior parte degli acquirenti non scopre un nuovo marchio, sceglie alcuni dei suoi prodotti e completa l’acquisto in una medesiima sessione. Molti potenziali clienti si prendono del tempo per considerare un marchio o un prodotto, navigando altrove online o leggendo le recensioni dei clienti, prima di prendere una decisione. Durante questo processo, vuoi che i clienti si ricordino del tuo brand, in modo che una volta che decidono di effettuare l’acquisto, il tuo marchio sia al primo posto. Sebbene i professionisti del marketing utilizzino da tempo l’intelligenza artificiale per la modellazione e la misurazione, nell’ultimo anno i nuovi strumenti di AI generativa hanno registrato un aumento di interesse per la loro capacità di contribuire a semplificare lo sviluppo dei contenuti creativi pubblicitari.

Alessio Taglia, head of sales account management di Amazon Ads

Le aziende devono adattarsi a un panorama in continua evoluzione e che richiede esperienze d’acquisto sempre più coinvolgenti e personalizzate. Omnicanalità , integrazione dei canali di vendita, dati di prima parte e AI sono cruciali per mantenere competitività, mentre social commerce, realtà aumentata e virtuale stanno ridefinendo l’interazione con i clienti. Il commercio del futuro sarà caratterizzato da una maggiore immersività e customizzazione: i brand devono adottare un approccio unificato che abbracci tutti i canali di vendita e offra esperienze d’acquisto su misura su tutti i touchpoint

Shopify

Secondo Canalys, le vendite di computer con Npu integrata raddoppieranno nel giro di tre anni.

Gli AI Pc colonizzeranno il mercato dei personal computer, è questione di pochi anni. Saranno, soprattutto, una forza capace di trainare nuovamente le vendite dopo un periodo di calo della domanda che solo negli ultimi mesi ha cominciato a invertire la rotta. Secondo la definizione di Gartner e d i Intel, un AI Pc è un personal computer equipaggiato con componenti Cpu, Gpu ed Npu (Neural Processing Unit) che integrano, ciascuno, capacità di accelerazione. In particolare, la Npu può gestire task di intelligenza artificiale e machine learning direttamente sulla macchina anziché inviare dati in cloud, e può farlo evitando di consumare troppa energia. A detta di Intel, la tecnologia degli AI rappresenta “un

fondamentale cambiamento nel modo in cui i nostri computer funzionano. Non è una soluzione a un problema che in precedenza non esisteva, ma al contrario promette di essere un enorme miglioramento per l’utilizzo quotidiano dei Pc”.

Le ultime previsioni di Canalys indicano che già nel 2025 saranno messi in distribuzione 100 milioni modelli ottimizzati per e con l’intelligenza artificiale, ovvero il 40% del totale dei volumi di Pc commercializzati.

Considerando che la quota prevista per quest’anno da Canalys è 18% (Gartner stima invece un 22%), l’incremento è evidente. Inoltre, a detta di Canalys, si scalerà abbastanza rapidamente fino ai 205 milioni di

AI Pc previsti per il 2028, ovvero tra il 2024 e il 2028 il tasso di crescita annuale composto sarà pari al 44%.

Lo spostamento verso l’AI Pc sarà trasversale ai segmenti desktop e notebook, con quest’ultimi a rappresentare (oggi, così come anche in futuro) la maggiore fetta di mercato. Si tratta, almeno per il momento, di dispositivi collocati in fascia premium, che porteranno significativi incrementi di valore ai vendor, a distributori e rivenditori. “Le potenziate capacità di questa nuova categoria creeranno uno slancio verso la premiumizzazione, in particolare per il segmento aziendale”, ha scritto Kieren Jessop, analista di Canalys. “Nel breve periodo ci aspettiamo sui Pc con capacità di AI un prezzo premium compreso dal 10% al 15% rispetto ad analoghi modelli privi di Npu integrata”. A fine 2025 circa metà dei modelli da 800 euro in su saranno AI Pc, mentre a fine 2028 la quota salirà all’80%. Queste dinamiche aiuteranno il mercato Pc nel suo complesso a g uadagnare valore, dai 225 miliardi di dollari previsti per quest’anno fino ai 270 miliardi del 2028.

Il futuro del mercato si prospetta quindi roseo, al netto naturalmente degli s viluppi non prevedibili dell’economia. Qualche cautela è però d’obbligo, e a tal proposito Gartner ci ricorda che le aziende affronteranno nuovi acquisti, e quindi cicli di aggiornamento del parco Pc in uso, solo in cambio di chiari vantaggi, come incrementi di produttività. Non certo, quindi, solo per dotarsi dell’ultimo gadget tecnologico in circolazione. Soprattutto, ci sarà ancora da lavorare sul fronte dei software ottimizzati per l’intelligenza artificiale “locale”, eseguita direttamente sui Pc anziché in cloud.

Valentina BernoccoSnowflake mette la data strategy alla base degli sviluppi sull’AI, con una piattaforma unificata su cui fa convergere tecnologie e servizi.

Non può esistere una strategia sull’AI se prima non ne è stata definita una sui dati. In questo semplice assunto è contenuto il senso della proposizione di Snowflake, azienda che in poco più di dieci anni di attività si è costruita uno spazio di rilievo nel mondo data-as-aservice. Con la piattaforma unificata Data Cloud, l’azienda permette ai suoi clienti di consolidare i loro dati in quella che può essere definita come una “singola fonte di verità”, per ricavarne insight utili, costruire applicazioni data-driven e condividere informazioni e output.

“Risolviamo l’annoso problema dei silos di dati e della loro governance”, ha detto Michele Tessari, head of sales enginee-

ring di Snowflake Italia. “I nostri clienti possono unificare ed eseguire query sui dati per supportare un’ampia varietà di casi d’uso, sfruttando l’elasticità e le prestazioni del cloud pubblico”.

Sempre più, Data Cloud sta ruotando attorno all’intelligenza artificiale generativa e ai large language model , integrando soluzioni relative allo sviluppo e alle operazioni di machine learning end-to-end , in particolare grazie all’Api (Application Programming Interface) di modellazione Snowpark. Qui si colloca anche il servizio Cortex (frutto di un’acquisizione dello scorso anno), che intende “fornire alle aziende gli elementi di base necessari per utilizzare modelli di

linguaggio e AI senza richiedere specifiche competenze in materia”, ha sottolineato Tessari.

Degli 8.500 clienti acquisiti a livello mondiale, una quota crescente arriva dal mercato italiano. Fra questi c’è Eolo, che a metà del 2022 ha deciso di ridisegnare la propria data platform per poter trattare in modo integrato le informazioni riferite ai clienti, alla propria rete (con un edge computing molto spinto per la copertura del territorio), a ciò che arriva da reti esterne e anche da analisi neutre sulle performance dei concorrenti. “Serviva una piattaforma di Big Data unica, che potesse integrarsi nella nostra infrastruttura di cloud ibrido”, ha ricordato Antonio Carlini, Cio di Eolo. “Erano importanti soprattutto le capacità di condivisione dei dati con fonti esterne, utilizzate dai data scientist per analisi anche con strumenti di AI, ma anche l’integrazione con PowerBI per il supporto agli analisti di business e al customer care”.

Anche Emmelibri ha affrontato un cambiamento di strategia sui dati, nel contesto di un più generale processo di cloud transformation. La società del Gruppo Messaggerie, che si occupa di distribuzione di libri e servizi collegati, ha dovuto porre rimedio a una preesistente situazione di disomogeneità all’interno del gruppo, composto nel 2022 da dieci aziende, con oltre tremila utenti e circa 2.500 dashboard create. “Abbiamo scelto nel 2023 di lavorare con Snowflake per ragioni di prestazioni, compatibilità con l’esistente, costi e anche prospettive di evoluzione”, ha spiegato Luca Paleari, Cio di Emmelibri. “Il progetto è tuttora in corso e dobbiamo terminare entro la fine dell’anno. Stiamo rispettando la tabella di marcia e abbiamo fin qui speso meno di quanto avevamo preventivato”.

Roberto BoninoQuella di Dassault Systèmes è una visione olistica in cui la sfera digitale e quella materiale sempre di più interagiscono tra di loro.

“Il nostro è un uni-verso. Non è un meta-verso e nemmeno un multi-verso. È un mondo di sintesi, di fusione, non è qualcosa che si pone oltre (il prefisso meta) e nemmeno ha pretese di omniscienza o di inclusione totale (omni, multi). Non è un mondo di consumi ma di creazione, collaborazione, innovazione”. A tracciare questa sintesi estrema di un percorso che dura da più di quarant’anni è Olivier Ribet, executive vice President Emea di Dassault Systèmes. Una sintesi necessaria perché soprattutto negli ultimi anni il progresso delle tecnologie digitali ha cambiato rapidamente i connotati di organizzazioni, processi e anche della società stessa, modificandone forma e contenuti (basti pen-

sare, un fenomeno su tutti, alla twin transition di digitale e sostenibilità).

I protagonisti della digitalizzazione come Dassault Systèmes da una parte hanno guidato queste transizioni, dall’altra hanno dovuto loro stessi cambiare pelle rapidamente per svolgere proprio questo ruolo guida. Così l’azienda, come emerso anche dalla recente convention di Dallas, si trova a dover continuare a essere un punto di riferimento per ingegneri e designer, fornendo loro strumenti sempre più efficienti per la progettazione (Solidworks in cloud è di per sé una piccola grande rivoluzione per i team che sviluppano prodotti e processi in tutti i settori di mercato). Allo stesso tempo, si trova a costruire un

proprio posizionamento come fornitore di strumenti per “ridisegnare il mondo”, come Bernard Charles, presidente, e Gian Paolo Bassi, senior vice president, hanno detto a più riprese durante la convention. A Dallas abbiamo intervistato Olivier Ribet. Ecco un estratto dell’interessante conversazione con uno dei più visionari manager che ci sia capitato di incontrare negli ultimi anni.

Ribet, come si conciliano il piano materiale e quello digitale?

Il nostro scopo è fornire alle aziende e alle persone universi virtuali per aiutarli a immaginare e progettare un’innovazione sostenibile, connettendo oggetti, natura e dati. Lo abbiamo scritto nella nostra mission circa 15 anni fa e ora abbiamo l’esperienza e la tecnologia per realizzare questa visione. Le persone che ci circondano sviluppano prodotti per abilitare nuove forme di energia, una nuova agricoltura, dispositivi medici avveniristici, robot, mezzi di trasporto sostenibili. Per questo è importante progettare bene ma anche capire bene il mondo in cui viviamo. I due piani, quindi, non solo sono conciliabili, ma sono strettamente correlati.

Oggi è il momento giusto per “ridisegnare il mondo”?

Il mondo cambia sempre più velocemente. Le città in cui viviamo si devono adeguare. Il sistema sanita-

rio, ad esempio, deve trasformarsi, perché la popolazione invecchia e le cure mediche diventano sempre più efficaci ma anche costose. Il sistema dei trasporti è un altro esempio: la produzione e la distribuzione dell’energia elettrica stanno diventando un tema sempre più importante. Il cibo è un altro punto critico: non ce ne sarà

abbastanza per tutti, ma molto viene ancora sprecato. Insomma, dobbiamo reinventare i processi e dobbiamo reinventare la proprietà intellettuale, questo non è più solo un tema di prodotti e di tecnologie. Tutto deve essere ridisegnato e tutto dev’essere fatto in modo sostenibile. L’unico modo per riuscirci è pensare in modo sistemico non solo ai prodotti, ma alle macchine che li costruiscono, alle strade, ai mezzi di trasporto, alla società. Dassault Systèmes si chiama così proprio perché crede all’approccio sistemico, crede nella modellazione e nella simulazione non solo degli oggetti ma anche dei fenomeni, anche grazie alle nuove possibilità offerte dall’AI.

Riusciremo, grazie alla tecnologia, a costruire gemelli virtuali anche dei comportamenti umani?

Non esattamente, anche perché culture e persone diverse evidenziano comportamenti differenti. Possiamo però simulare fenomeni di massa, come ad esempio il traffico nelle vie di una città, aiutando a ridisegnare infrastrutture e regole nella direzione

di una maggiore efficienza e sostenibilità. Oggi con gli scenari “What-if” che riusciamo a costruire è possibile prevedere i cambiamenti portati dalla realizzazione di un nuovo grattacielo nel microclima e nel traffico del quartiere dove è previsto, in un circolo virtuoso che ci porta dal virtuale al reale e dal reale al virtuale, tenendo sempre sotto controllo l’impatto ambientale di ciò che stiamo realizzando.

Come sta cambiando la società grazie a strumenti di simulazione come i vostri?

Alla fine, le grandi innovazioni sono figlie del genio umano, la tecnologia è solo un aiuto. Adesso tuttavia, grazie alla possibilità di connettere menti e capitali, non sono più solo le grandi aziende a poter creare prodotti innovativi ma anche piccoli team di dieci o venti persone. Come ad esempio è successo con la startup tedesca Arthur, che grazie alle nostre piattaforme è riuscita e progettare e costruire l’autobus più innovativo e sostenibile al mondo.

Emilio MangoL’intelligenza artificiale si fa strada nelle aziende del settore Ict: non solamente nella loro offerta di tecnologie e servizi, ma anche all’interno dei loro stessi processi e abitudini di lavoro.

Lo mostra uno studio realizzato da Cite Research per Dassault Systèmes: su un campione di mille professionisti di società del settore tecnologico statunitensi, italiane, francesi, tedesche e britanniche,

l’84% ha detto che la propria azienda consente l’uso di tecnologie di AI, come chatbot (usati dal 68%), strumenti di progettazione assistita, funzioni di apprendimento automatico e altro ancora.

L’intelligenza artificiale è parte di un più ampio percorso di trasformazione digitale che procede ma che, forse un po’ paradossalmente, anche nelle aziende tecnologiche è costellato di ostacoli. Primo fra tutti, la difficol-

tà a reperire competenze avanzate in materia di cybersicurezza: solo il 40% degli intervistati crede che la propria azienda ne sia dotata. Tali carenze tendono a rallentare i tempi di rilascio di nuovi prodotti e servizi.

Altri ostacoli alla trasformazione digitale sono gli elevati costi di realizzazione dei progetti, un problema che affligge un terzo delle grandi aziende del settore tecnologico.

Avm mira a portare la gamma dei Fritz!Box anche alle Pmi e alle realtà dei settori ospitalità, ristorazione e retail.

Contraddistinti dall’inconfondibile livrea rossa e bianca, i suoi modemrouter sono ben noti al mercato consumer, ma coltivano anche altre ambizioni. Avm negli ultimi anni sta cercando di portare la gamma Fritz!Box e ciò che vi ruota intorno (ripetitori Wi-Fi, telefoni, dispositivi per la domotica) anche al pubblico delle aziende. E se quest’operazione è già riuscita nella natìa Germania, in Italia è invece una strategia in fieri. Una strategia che, appunto, non nasce oggi ma ora può contare

sull’apporto di Luca Venturi, entrato cinque mesi fa in Avm con il ruolo di B2B sales manager. Esperto di telecomunicazioni, con alle spalle esperienze di lavoro in Tim, Fastweb e dieci anni in Vodafone, ora in Avm ha la responsabilità di guidare il mercato B2B in Italia ma anche i rapporti con il mercato delle telco. “Avm è quella che io definisco la ‘Audi del networking’, un’azienda che propone prodotti estremamente performanti e affidabili”, ha raccontato Venturi alla stampa. “L’Italia è il secondo mercato in termini di fatturato dopo la Germania e anche da noi il marchio Fritz! è molto conosciuto, perché siamo un vendor che lavora molto sull’innovazione dei prodotti sviluppando (in Germania) hardware e software in modo integrato. A differenza di nostri competitor, lavoriamo avendo già in mente il cliente finale, l’utente, anziché il provider”. Questo, a detta del manager italiano, è un elemento distintivo, che si riflette sulla strategia di go-to-market. “Spesso”, ha proseguito Venturi, “non siamo i primi a portare sul mercato alcune innovazioni tecnologiche, come il Wi-Fi 7: le portiamo quando il cliente è pronto a recepirle. Avendo pieno controllo su hardware e software, l’altro elemento di differenziazione per noi è la customer experience, che si traduce in quattro elementi: prestazioni, banda, sicurezza, affidabilità”. Caratteristiche che, tipicamente, vengono associate

alle tecnologie rivolte alle aziende, più che a quelle consumer. L’offerta di Avm è quindi sostanzialmente già “pronta” per soddisfare le esigenze delle piccole e medie imprese, mentre per stessa ammissione di Venturi si dovrà lavorare ancora sul piano della comunicazione per far passare questo messaggio. I casi di medie e grandi aziende clienti di Avm, d’altro canto, non mancano: in Germania ci sono catene del retail come Edeka e Dm, mentre in Italia spiccano i progetti in corso con Gruppo Sarni (ne parliamo a pagina 48) e con alcuni alberghi di lusso, come e il Metropolitan Suite e il il The City Hotel di Ancona, il View Place di Numana e il Foro Appio Mansio Hotel di Latina.

“Per il 2024”, ha rimarcato Venturi, “l’obiettivo è di salire la scala, lavorando sulla parte di mercato che intercetta i grossi system integrator, tramite cui potremo arrivare a clienti di maggiore dimensione. Tipicamente il marchio Avm non è associato alle grandi aziende e alle architetture di rete complesse, e d’altra parte non siamo dei competitor di Cisco. Ma clienti come le catene del retail, i franchising e il settore dell’ospitalità sono per noi un obiettivo per il 2024”. Avm ha già pianificato di lanciare in Italia entro la fine dell’anno un modello Fritz!Box rugged , adatto alle installazioni all’aperto. “I nuovi prodotti presentati al Mobile World Congress”, ha aggiunto Venturi, “integreranno non solo la parte di networking ma anche quella di smart home o connected office, cioè gli oggetti connessi della domotica di terze parti. Riteniamo che sia il momento giusto per approcciare questo tipo di servizi”.

Valentina BernoccoOn-premise, ambienti ibridi ed edge avranno un ruolo importante nel futuro dell’intelligenza artificiale. Lo svela una ricerca di Lenovo.

Adottare l’intelligenza artificiale in azienda significa fare delle scelte sui fornitori di software e servizi, sui large language model a cui affidarsi, sulla base di dati da utilizzare per il training o il fine-tuning dei modelli. Se questo è noto, è forse meno immediato pensare che l’AI comporti anche delle scelte di infrastruttura. Dove reperire la capacità di calcolo necessarie? In cloud o dentro i confini dell’azienda, o un mix delle due cose?

Idc lo ha chiesto a decisori IT di aziende dell’area Emea, tra cui una cinquantina di italiani, nell’ambito di un’indagine commissionata da Lenovo e condotta nel mese di febbraio. Solo il 10% delle organizzazioni la vede come qualcosa di non rilevante, come una distrazione, mentre il restante 90% oscilla tra il considerarla un “fatto di igiene”, cioè qualcosa di necessario per restare competitivi (50% degli intervistati) o addirittura un vero punto di svolta per il business, un “game changer” (40%). Il

57% ha già investito in AI e un ulteriore 40% prevede di farlo nel corso dell’anno, mentre appena il 3% non ha intenzione di attivare alcun progetto. In media, la spesa delle aziende Emea in AI dovrebbe crescere del 61% quest’anno rispetto ai livelli del 2023. Gli investimenti saranno distribuiti in modo quasi equanime tra AI Generativa (24,7%), altre forme di machine learning (24,9%), deep learning per applicazioni di AI interpretativa (25,4%) e robotica (25%).

“Ci ritorna un’immagine delle aziende Emea di fortissima attenzione all’AI”, ha dichiarato alla stampa Alessandro De Bartolo, country general manager dell’Infrastructure Solutions Group di Lenovo, commentando i risultati dell’indagine. “Interessante è che il 45% degli intervistati abbia detto che l’IT ha qualche difficoltà ad accontentare la richiesta. Questo ci dice innanzitutto che l’AI non è patrimonio solo dell’IT ma è una richiesta trasversale, che giunge anzi spesso dal business.

Quindi il dipartimento IT è spesso sotto pressione di fronte alla richiesta di implementare l’intelligenza artificiale”. In Italia, peraltro, la quota dei decisori IT non interessati scende al 2%, uno tra i dati più bassi in Emea. Lenovo, naturalmente, si inserisce in quest’onda di trasformazione soprattutto come player di infrastruttura e l’indagine commissionata a Idc in parte sfata il mito secondo cui l’AI debba poggiare solo sul cloud. Questo è vero in parte, per alcune aziende, applicazioni e carichi di lavoro, ma non del tutto. “L’implementazione dell’AI in azienda rappresenterà sempre di più una spinta a ripensare l’adozione del cloud”, ha commentato De Bartolo.

“Solo il 17% dei rispondenti pensa che i progetti di AI saranno implementati in un cloud pubblico, il 48% predilige il cloud ibrido e il 24% il private cloud. Questo accade, probabilmente, perché c’è un riconoscimento del fatto che realizzare un progetto di AI non significhi solo mettere dei dati in cloud ma anche metterci di Kpi e la logica aziendale”.

Secondo l’indagine, le aziende Emea quest’anno aumenteranno del 38% gli investimenti in tecnologie e servizi di calcolo edge, e la tendenza sarà forte specie nei settori retail, manifatturiero e automobilistico. “Anche in Italia per noi di Lenovo il business dell’edge computing è in forte crescita”, ha detto De Bartolo. “L’AI sempre di più sta intorno a noi, è vicina, gli algoritmi non vengono elaborati solo all’interno delle mura dei data center ma anche ai bordi delle infrastrutture, nei dispositivi degli utenti e nell’IoT: la loro distribuzione richiede che la capacità di elaborare sia molto più vicina ai luoghi in cui i dati vengono creati”.

Valentina BernoccoVeeam Software rimarca la propria visione di una protezione dei dati estesa e flessibile, anche erogata come as-a-Service.

“Solitamente si pensa che il backup sia una tecnologia molto matura, ma mi sono stupito di riscontrare quanto sia forte la domanda tra le aziende italiane”: parole di Stefano Cancian, country manager di Veeam Software in Italia, in carica dallo scorso giugno. “Gli attacchi informatici anche in Italia sono la prima causa di interruzione del servizio IT e sono un limite alla digital transformation. I budget IT delle aziende stanno aumentando nell’ottica della protezione del dato e del potenziamento della sicurezza. Anche in Italia un elemento importante è quello dell’integrazione delle soluzioni di data protection e di sicurezza, sempre più richiesta nel mercato”. Questa crescita di domanda non è casuale: le minacce informatiche tese a compromettere, distruggere o rubare dati sono in continua ascesa. Dall’ultimo report di Veeam si apprende che il 76% delle aziende ha subìto almeno un attac-

co ransomware nel 2023 e che solo il 32% crede di potersi riprendere da un incidente di impatto limitato nel giro di una settimana. “Veeam risponde a questi problemi con un messaggio di resilienza radicale”, ha spiegato Cancian nel corso di un recente incontro con la stampa. “Che cosa significa? Una soluzione moderna che permette non solo di affrontare la situazione di crisi dopo un attacco, ma di poter andare oltre, utilizzando la resilienza come elemento di vantaggio competitivo e di differenziazione nei confronti della concorrenza”. Il messaggio di resilienza radicale di Veeam abbraccia anche il cloud, e lo fa anche con soluzioni specifiche per determinati workload. “Molte aziende si sono rese conto di essere a buon punto nel processo di modernizzazione ma di non avere una soluzione per proteggere gli ambienti container”, ha testimoniato Cancian. Veeam propone, quindi, anche soluzioni specifiche per Kuber-

netes e, considerando la prevalenza del modello multi-cloud nelle aziende, non impone vincoli di scelta di un particolare fornitore. Nonostante il forte legame con il mondo Microsoft e con il cloud di Azure, la piattaforma è “agnostica”, come si suol dire, cioè funziona similmente su qualsiasi infrastruttura. Recentemente l’azienda ha fatto un ulteriore passo dentro al cloud, inteso non più solo come ambiente da proteggere ma anche come modalità di erogazione del software. Con le nuova soluzioni Veeam Data Cloud per Microsoft 365 e per Azure è possibile attivare un servizio di backup e recovery sui dati di Microsoft Exchange Online, SharePoint Online, OneDrive for Business e Teams (con costi calcolati in base al numero di utenti), nonché su macchine virtuali di Azure, Azure SQL e Azure Files.

Guardando all’ultimo report di Veeam, sembra già esserci terreno fertile per questa nuova proposta commerciale: l’88% degli intervistati ha detto di aver adottato o essere in procinto di adottare soluzioni as-a-Service di backup e disaster recovery almeno per alcuni carichi di lavoro. “Le aziende ricercano sempre più offerte as-a-Service, basti pensare ad applicazioni cloud come quelle di Microsoft, Salesforce e ServiceNow”, ha illustrato Alessio Di Benedetto, technical sales director Southern Emea di Veeam. “Anche la protezione dei carichi applicativi inizia a seguire questa logica”. Veeam ha cominciato questo percorso con gli ambienti Microsoft 365 e Azure, ma l’idea è di allargarsi prossimamente anche ad Aws. “La spinta all’as-a-Service sarà velocissima”, ha assicurato Di Benedetto. “In futuro daremo la possibilità di fare tramite asa-Service tutto ciò che attualmente offriamo in modalità tradizionale”.

Valentina Bernocco

Il ruolo dei managed service provider a supporto delle urgenze delle aziende, analizzato da Prakash Panjwani, Ceo di WatchGuard Technologies.

Il panorama della sicurezza informatica è profondamente cambiato negli ultimi anni. Chi deve difendere le aziende si trova di fronte a un perimetro che è diventato più complesso a causa del lavoro ibrido. La carenza di professionisti della security aggiunge ulteriore complessità e l’evoluzione delle minacce, resa ancora più veloce dall’intelligenza artificiale, disegna uno scenario in cui le aziende devono cercare aiuto nei managedservice provider (Msp), fornitori di servizi gestiti, per compensare le scarse risorse a disposizione. Abbiamo intervistato Prakash Panjwani, Ceo di WatchGuard Technologies, multinazionale che ha creato l’approccio Unified Security Platform per gli Msp, allo scopo di difendere con successo le aziende con le minacce odierne.

Qual è la sfida più difficile che le aziende dovranno affrontare nel 2024?

Una delle sfide più urgenti, e anche di più difficile risoluzione in tempi celeri, è la mancanza di professionisti qualificati in cybersecurity. Le aziende si trovano costrette a trovare una soluzione alternativa e una di queste è affidare la gestione della sicurezza informatica a un fornitore esterno. A propria volta gli Msp devono superare un’altra sfida, ovvero trovare un fornitore di security in grado di garantire la sicurezza degli ambienti IT ibridi con soluzioni che proteggano aziende e utenti in una varietà di scenari, sia all’interno sia all’esterno del perimetro aziendale, riducendo la complessità.

Come rispondere alla richiesta di sicurezza “gestita”?

WatchGuard ha lanciato recentemente il nuovo servizio Mdr (Managed Detection and Response), mirato esclusivamente ad aiutare gli Msp a offrire servizi gestiti di rilevamento e risposta alle minacce ai propri clienti. WatchGuard Mdr è pensato per garantire agli Msp un servizio di monitoraggio “24/7” delle reti dei clienti, senza dover investire in ulteriori risorse o in un Soc proprietario, a un costo che lo rende accessibile a tutte le aziende. Con Mdr, i fornitori di servizi gestiti possono contare sul lavoro dei nostri analisti di sicurezza, che operano come un’estensione del team dell’Msp e sulla nostra piattaforma di sicurezza unificata – che include prodotti e servizi per la protezione degli endpoint , l’autenticazione a più fattori, il Wi-Fi sicuro e la sicurezza di rete – gestita da un’interfaccia centralizzata di reporting e visibilità, continuamente aggiornata con funzio -

nalità di Xdr (Extended Detection and Response), di identità Zero Trust e reporting avanzato. Per i clienti degli Msp, i vantaggi si traducono in un servizio scalabile, flessibile e in grado di garantire la conformità alle normative vigenti.

Che impatto avrà l’AI sulle attività vostre e dei partner di canale?

L’intelligenza artificiale sarà sempre più usata dai criminali informatici per aumentare il volume e la sofisticatezza delle minacce. Per quanto ci riguarda, l’intelligenza artificiale è già alla base di soluzioni di sicurezza come Xdr, che la impiega per rilevare le minacce e automatizzare le risposte. Crediamo che potrà essere utilizzata per comprendere meglio le sfide dei nostri clienti e sfruttare tali informazioni per migliorare i nostri servizi.

Le strategie di resilienza delle aziende spesso sottovalutano alcuni aspetti importanti. Ne parliamo con Everbridge.

La parola “resilienza” è diventata un tormentone nel dopo pandemia. A che punto sono le aziende in questo percorso? Ne abbiamo parlato con Lorenzo Marchetti, head of global public affairs di Everbridge, società che sviluppa soluzioni software di critical event management (Cem) e allerta pubblica nazionale.

Qual è oggi la consapevolezza delle aziende sul tema della resilienza del business?

La pandemia ha cambiato il modo di pensare al lavoro. La diffusione dello smart working, per esempio, ha cambiato il modo di concepire la sicurezza dei dipendenti. Anche le trasferte dei lavoratori oggi richiedono un supporto aziendale più sofisticato rispetto al pre pandemia. Oggi la resilienza delle aziende necessita di una strategia olistica che tenga conto di questa nuova fluidità lavorativa e delle sue sfide e si applichi con nuove procedure e piattaforme tecnologiche pronte a supportarle. Negli

ultimi anni, abbiamo visto un numero maggiore di aziende investire nella propria resilienza e prendere sul serio gli aspetti di security e business continuity. Bisogna tuttavia pensare che, nel medio periodo, tutte le aziende dovranno fornirsi di procedure e sistemi all’altezza delle sfide che ci sono e ci saranno.

Ci sono aspetti che rendono le aziende, ancora oggi, poco resilienti?

Le aziende investono fortemente in strategie per incrementare il loro fatturato, però spesso non considerano tra queste una gestione proattiva della crisi. Questo atteggiamento mina sicuramente le fondamenta della resilienza aziendale perché sposta i costi della prevenzione e della preparazione sulle conseguenze della crisi. Eppure studi indipendenti, come quello prodotto dall’americana Forrester, sottolineano il ritorno sull’investimento per quelle aziende che sviluppano sistemi di gestione della crisi efficaci ed efficienti. Per esempio, in Europa sappiamo che la resilienza impatta il fatturato, con le aziende più resilienti (top performer) che perdono ricavi di vendita fino a venti volte in meno delle low-performer. Per arrivare a questi risultati, le aziende devono costruire un sistema di gestione delle crisi che sia basato su intelligence attendibile e contempli una chiara divisione di responsabilità durante la crisi e un sistema di comunicazione dedicato alla crisi stessa chiaro e puntuale. Tutti questi aspetti possono essere gestiti da una piattafor-

ma digitale che permetta all’azienda di avere il controllo della crisi dal punto di vista sia della prevenzione e preparazione sia della risposta. Tutto questo in maniera lineare e automatica. Solo così un’azienda può sviluppare una vera resilienza adattabile a tutte le circostanze.

Come funziona una piattaforma di Critical Event Management come la vostra?

Trattandosi di una soluzione su base cloud, una piattaforma Cem si integra perfettamente con i sistemi di gestione interni all’azienda. Inoltre, proprio data la sua natura di cloud-system, la piattaforma risulta difficilmente penetrabile da attacchi cyber perché, oltre alle autenticazioni a due fattori richieste per accedere alla piattaforma stessa, i server che la supportano hanno sempre altri server di backup in tutto il mondo, pronti a entrare in uso all’insorgere di una qualsiasi problematica. Dal punto di vista integrativo, invece, si tende a cercare di soddisfare le necessità dei nostri clienti, tenendo sempre il focus sull’accorciare i tempi della crisi grazie all’automazione. Per la gestione della risposta alla crisi, dal lato comunicazione, certe aziende richiedono l’integrazione dei contatti telefonici, altre l’integrazione con Whatsapp. Le soluzioni sono virtualmente infinite, ma noi ci impegniamo ad ascoltare e, vista la nostra ventennale esperienza, a supportare i nostri partner nello scegliere la soluzione più consona per aumentare la loro resilienza. V.B.

Salesforce punta sugli sviluppi del motore di intelligenza artificiale proprietario e sul cloud.

Solida, scalabile, costruita su casi d’uso ed etica: queste le caratteristiche che l’intelligenza artificiale dovrebbe avere per entrare a pieno titolo nelle aziende. Ad affermarlo con convinzione è Salesforce, azienda che ha avviato un percorso di ridisegno dell’offerta teso a integrare le potenzialità dell’AI nella propria piattaforma Data Cloud. In questo contesto si colloca la recente novità di Einstein Copilot, un assistente AI conversazionale, personalizzabile e generativo per la gestione delle relazioni con i clienti. Lo strumento produce risposte utilizzando i dati e metadati già presenti in azienda, potendo così fornire supporto nelle attività di marketing, nelle strategie di vendita, nel servizio clienti e nell’IT. È in grado di dare risposte, riassumere e generare contenuti, interpretare dialoghi complessi e automatizzare varie attività, il tutto all’interno di un’inter-

faccia utente unificata e direttamente integrata nelle soluzioni Salesforce AI Crm. Questa unitarietà è resa possibile attraverso la fusione di un’interfaccia conversazionale, un modello linguistico avanzato e dati aziendali verificati.

Non è un caso che Einstein Copilot introduca funzionalità come l’aggancio senza replica dei dati alla piattaforma Data Cloud. “Si tratta solo di uno dei modi per esplicitare come il nostro sia uno strumento unico per tutti gli elementi che compongono la nostra offerta”, ha sottolineato Nicola Lalla, vicepresidente solution engineering di Salesforce Italia. “Nel nostro ambiente Customer 360 è possibile far convogliare dati provenienti dalle fonti più disparate, lavorarli e restituire quanto necessario a supportare l’operato di tutti coloro che hanno a che fare con il marketing, le vendite o le strategie di business, senza dispersioni e con l’automazione”.

ll motore di ragionamento di Einstein Copilot può interpretare le intenzioni degli utenti e selezionare le azioni più appropriate. Combinando un’elaborazione analitica approfondita con le capacità di un large language model, questo assistente virtuale può generare risposte e azioni aggiornate su più sistemi attraverso l’integrazione di MuleSoft e Salesforce Flow. L’affidabilità delle interazioni AI, secondo Lalla, è garantita da Einstein Trust Layer, che integra misure di sicurezza e riservatezza, tra cui la protezione dei dati personali, la verifica della “non tossici-

tà” dei contenuti generati e la prevenzione contro accessi non autorizzati e violazioni dei dati. Einstein Copilot, attualmente in versione beta e prossimamente disponibile in italiano, si accompagna a Einstein 1 Studio, un insieme di strumenti low-code che consente ad amministratori e sviluppatori di personalizzare l’assistente virtuale. Tali novità si inseriscono in quella “rivoluzione dei dati”, che Salesforce vorrebbe cavalcare con tecnologie che permettono di raccogliere, archiviare e analizzare immensi volumi di dati per estrarre informazioni. Le attività di training e inferenza richiedono un accesso ampio e approfondito ai dati per alimentare gli algoritmi e generare insight rilevanti, previsioni accurate e automatizzare in modo intelligente i processi. Il potenziale di questo passaggio appare chiaro ma implica pericoli legati alla sicurezza e al trattamento dei dati, ed è per questo che Salesforce si preoccupa di portare avanti una strategia tesa all’utilizzo responsabile.“Abbiamo rilevato con una nostra ricerca come in Italia il 17% dei lavoratori già faccia uso dell’AI generativa in azienda, ma in una buona metà dei casi senza aver chiesto un’autorizzazione”, ha indicato Vanessa Fortarezza, country leader di Salesforce Italia. “Solo il 15% delle realtà possiede linee guida su questo fronte e solo il 23% degli utenti ha ricevuto una formazione specifica. Per questo stiamo lavorando non solo a livello globale, ma anche con istituzioni del nostro Paese per contribuire a definire le regole più corrette. Nella Pubblica Amministrazione, per esempio, abbiamo istituito con The European House Ambrosetti un gruppo di lavoro permanente, che coinvolge 40 vertici della Pa centrale e locale”.

Roberto BoninoUn approccio olistico, che consideri anche la sicurezza, è necessario per gestire sistemi digitali sempre più complessi.

La crescente complessità dei sistemi digitali, spesso dotati di applicazioni basate su intelligenza artificiale o machine learning, in contesti cloud/ edge computing e con requisiti di sicurezza “by design”, rende necessario approcciare il disegno della componente network adottando una “visione integrata”. Vale a dire un approccio olistico, per il quale tutti gli elementi del sistema risultino integrati per formare un’unica entità, rispettando prestazioni e Kpi e garantendo la gestione automatizzata. Seguendo tale approccio, il sistema si configura come un insieme di dispositivi fisici, digitali e applicazioni che dialogano tra loro attraverso la rete, scambiandosi input e rispondendo con output adeguati alle esigenze dell’utente. Il network, pertanto, diventa capace di lavorare autonomamente riducendo al minimo l’intervento operativo umano che potrà essere dedicato, invece, all’aspetto strategico e decisionale.

La definizione di un sistema integrato richiede, naturalmente, l’intervento di competenze specifiche per progettarlo, installarlo, integrarlo e manutenerlo. Per questo motivo, le imprese si rivolgono a un system integrator capace di modulare le connessioni tra i device e gli applicativi del sistema con un approccio end-to-end.Adottando una visione integrata della rete, Sirti Digital Solutions ha sfruttato negli anni la propria esperienza di integratore di sistemi per realizzare (in co-creazione con i propri clienti, partner tecnologici) le soluzioni IoT, data center e cybersecurity del business di riferimento. In ambito IoT, ad esempio, l’azienda si occupa della progettazione e implementazione di sistemi di monitoraggio sia statico sia dinamico, fornendo, contestualmente, software di interrogazione della sensoristica, di acquisizione e di archiviazione dei dati, installandoli e manutenendoli. Per essere efficaci, sistemi così complessi hanno bisogno di data center capaci di elaborare i dati e comunicare con tutte le componenti del sistema per facilitare il processo decisionale. Sirti Digital Solutions è sempre più chiamata a sviluppare progetti di networkdesignal fianco dei propri clienti, per definire la struttura di rete e implementare le connessioni tra tutti i device e le applicazioni, gestendone anche la manutenzione.

Al contempo, tali operazioni necessitano una particolare attenzione alla sicurezza del network. Attenendosi alla visione integrata di rete, Sirti Digital Solutions ha sempre scelto un approccio di security by design , per disegnare soluzioni su misura alle esigenze delle aziende, sfruttando il machine learning per sviluppare modelli di Behaviour Analysis. È chiaro quindi che un sistema integrato permette di ottimizzare tempo e risorse, verificare

anomalie e risolverle in autonomia con il risultato di rendere l’esperienza dell’utente più agevole e sicura. Ciò dimostra quanto una visione integrata della rete sia centrale per l’efficientamento dei servizi, ormai fondamentali alla vita quotidiana delle persone, che fanno parte di una nuova era digitale in continua evoluzione.

Noi di Sirti Digital Solutions conosciamo le complessità di questo scenario tecnologico. Nel nostro lavoro di supporto alle aziende e alla società cerchiamo di massimizzare i vantaggi della transizione tecnologica, affiancandole nelle sfide che la stessa presenta. A tal proposito realizziamo progetti complessi in modalità end-to-end , dalla progettazione alla manutenzione predittiva, con un design iniziale bysecurity . La nostra ampia valuepropositionci consente di rispondere alle esigenze del settore pubblico e privato nella trasformazione in atto valorizzando gli investimenti in una logica di sostenibilità, uniformemente agli obiettivi dell’Agenda 2030 per lo Sviluppo Sostenibile.

LucaRubaga,ManagingDirectordiSirtiDigitalSolutions

I servizi di infrastruttura di Oracle si radicano in Italia, dal settore finanziario al progetto del Polo Strategico Nazionale, che coinvolge gli enti pubblici.

Parlare di gestione dei dati o di intelligenza artificiale è oggi di moda, ma alla base di tutto occorre avere un’infrastruttura tecnologica adeguata alle sfide attuali e future. Oracle ha riportato questo concetto al centro delle discussioni e testimonianze sul palco dell’evento CloudWorld, svoltosi per la prima volta in Italia, a Milano, lo scorso marzo. Il colosso americano ha adottato da tempo una strategia articolata su questo fronte, per affiancare le aziende in un processo di migrazione che deve tener conto non solo delle esigenze di innovazione, ma anche di quanto installato e costruito negli anni. La Oracle Cloud Infrastructure (Oci) integra tutti i servizi, oltre un centinaio, che il vendor propone non solo erogandoli in logica public cloud dai propri data center (ormai sempre più distribuiti geograficamente, dallo scorso anno anche in Italia), ma anche portandoli a casa del cliente con le Dedicated Region, appoggiandosi a hyperscaler come Microsoft o con-

sentendo a partner e Msp di rivendere infrastruttura e servizi sui mercati. Quest’ultima opzione prende il nome di Alloy e una delle novità più rilevanti uscite da CloudWorld riguarda l’annuncio fatto da Paolo Trevisan, chief technology & information officer di Polo Strategico Nazionale (Psn). Sull’infrastruttura di Oracle il Psn si accinge ad aprire la propria region per proporre Psn Managed, ovvero il servizio di cloud gestito indirizzato alla modernizzazione delle Pubbliche Amministrazioni. “Un’infrastruttura cloud situata in Italia, segregata, dedicata e gestita interamente da noi all’interno dei nostri datacenter, ci garantisce gli elevati livelli di sicurezza e controllo necessari per la gestione dei dati strategici e, al contempo, la flessibilità e l’innovazione tipica di un hyperscaler ”, ha spiegato Trevisan.

Il tema della sovranità è fra quelli che maggiormente alimenta l’interesse delle aziende nei processi di trasfor-

mazione, soprattutto di quelle che operano in mercati regolamentati, come il mondo finanziario. Una conferma è arrivata da Marco Barioni, group chief information technology officer di Reale Group: “Siamo in piena fase di transizione verso una logica infrastrutturale full cloud , ma operiamo in un settore dove occorre allinearsi a numerose normative, dal Gdpr a Dora. La sicurezza dei dati è un elemento di primaria rilevanza e per i nostri clienti, che sono anche soci, poter far leva su una region locale rappresenta un valore”. Anche Bper ha intrapreso un percorso di trasformazione legato non solo alle acquisizioni effettuate (da Carige alle filiali della ex Ubi Banca), ma anche alla multicanalità e allo sviluppo di servizi digitali. “Stiamo evolvendo in modo graduale e in linea con le esigenze del business, senza trascurare il capitale umano, sempre al centro dei processi anche laddove già si faccia uso dell’intelligenza artificiale”, ha raccontato il group Cdo, Giuseppe Maifredi

Anche l’AI generativa ha tenuto banco al CloudWorld: le aziende stanno ora cercando di tramutare l’ hype che ha caratterizzato soprattutto lo scorso anno in progetti concreti, costruiti su dati e modelli affidabili. “Abbiamo messo a punto una cinquantina di use case legati all’intelligenza artificiale”, ha indicato Michele Porcu, vicepresidente business strategy Emea di Oracle. “Possiamo supportare, con l’aiuto dei nostri partner specializzati, workload specifici di AI generativa, poggiando su un’infrastruttura come Oci e il lavoro congiunto con Nvidia per garantire performance e attenzione ai consumi energetici”.

Roberto BoninoServicenow continua a far evolvere la propria piattaforma di gestione dei flussi di lavoro. Intanto aumenta, per l’azienda, il peso del mercato italiano.

AI generativa e capacità di automazione sono gli elementi su cui Servicenow è intervenuta maggiormente con la nuova release “Washington” della propria piattaforma di gestione dei workflow, la Now Platform.

Il nuovo aggiornamento, arrivato puntuale come ogni semestre, si concentra sul potenziamento delle funzioni già esistenti nell’agente virtuale, migliorando la capacità di indirizzare le richieste verso soluzioni automatizzate. A questo contribuisce anche l’introduzione di Workflow Studio, che dovrebbe migliorare la produttività, consentendo ai dipendenti di concentrarsi su attività più complesse anziché su quelle manuali.

In parallelo con l’annuncio ufficiale, ci siamo intrattenuti con Filippo

Giannelli, area vicepresident Italy & Israel, per capire soprattutto quale sia l’andamento di Servicenow nel nostro Paese e quale sia stato l’impatto degli aggiornamenti annunciati lo scorso anno. “Sottolineerei che siamo stati gli unici fra i big del settore a non effettuare tagli di personale nel 2023”, ha rilevato il manager. “Ed è un dato non trascurabile, visto che ormai siamo una realtà da 8,7 miliardi di fatturato e oltre 2.700 dipendenti. L’Italia si è allineata alla crescita complessiva della componente corporate, ma abbiamo prestato attenzione soprattutto al settore pubblico, dove abbiamo raddoppiato il numero di risorse dedicate, di tipo sia commerciale sia tecnico. Si tratta di una strategia di rafforzamento strutturale e non legata semplicemente alle opportunità correlate al Pnrr”.

Anche se l’AI generativa è al centro degli sviluppi di “Washington”, il terreno era stato preparato da Servicenow già lo scorso anno, a partire dalla partnership con Accenture e Nvidia, imperniata sul lancio di AI Lighthouse, un programma pensato per accelerare lo sviluppo e l’adozione di capacità di GenAI nelle aziende. A questo s’è aggiunta la disponibilità di NowAssist, sottomarchio introdotto per enfatizzare le funzionalità di GenAI nell’IT Service Management (Itsm), nella gestione del servizio clienti, nella fornitura di servizi

HR e nel field service management:

“La prima release ha rappresentato Il prodotto nuovo di maggior successo della nostra storia e questo vale anche per l’Italia”, ha indicato Giannelli. L’interrogativo che tutti si pongono riguarda l’effettivo attecchimento sul campo degli investimenti e dei progetti che i vendor hanno messo a punto su questo fronte. “I nostri business partner sono già certificati sugli sviluppi più recenti della piattaforma e abbiamo sviluppato large language model già verticalizzati”, ha puntualizzato il manager di Servicenow. “La nostra prerogativa è l’offerta di una piattaforma unica con modello di dati altrettanto unico, e questo è fondamentale per poter integrare process mining, AI classica e generativa. Per noi lo switch per accendere l’AI è già a disposizione”. Il 2024 dovrebbe essere un anno in cui il peso dell’Italia nelle strategie complessive di Servicenow sarà destinato ad aumentare. “Il programma RiseUp è stato declinato anche da noi e abbiamo così contribuito alla formazione di un milione di consulenti a livello globale”, ha specificato Giannelli. “Ora stiamo definendo accordi con le università per dare maggior corpo al programma. Certamente intendiamo radicarci ancor più sul territorio e saranno varate nuove importanti iniziative in tal senso nel corso dell’anno”.

Roberto BoninoUn approccio pervasivo per divenire creatori di valore nell’universo dell’intelligenza artificiale.

Nel panorama in rapida evoluzione dell’intelligenza artificiale, emergono interrogativi fondamentali sul suo impatto sul tessuto economico e sociale. Ne parliamo con Giuseppe Di Franco, Ceo di Gruppo Lutech, azienda impegnata in prima linea nello sviluppo e nell’integrazione di tecnologie innovative.

Che occasione rappresenta l’AI per le aziende?

La missione di essere non solo partecipanti ma anche leader nell’era AI-first pone sfide e opportunità uniche. Ottimizzare la produttività, valorizzare le competenze umane e gestire l’incertezza informativa “anticipando” servizi a valore sono già oggi i fattori chiave per il successo dei processi di innovazione e crescita: l’AI non è più, quindi, solo la tecnologia alla base dello sviluppo di soluzioni specifiche, ma un approccio olistico e pervasivo che deve impattare su ogni livello e processo aziendale.

Come affrontare questo percorso?

Nel contesto di questa rivoluzione tecnologica, emerge l’importanza di approcci olistici e trasversali all’interno delle organizzazioni. Ciò sottolinea il ruolo essenziale di un Digital Integrator come Lutech, che agisce come trusted advisor e orchestratore di soluzioni AI. Possiamo integrare efficacemente l’AI nell’ambiente aziendale e guidare i clienti nel percorso che li porterà a essere non solo utenti di questa tecnologia, ma veri e propri creatori di valore. Alla base di questo approccio vi è un ecosistema per l’AI che ruota intorno al Lutech Campus, Open Innovation Hub del Gruppo, dove le esigenze di innovazione delle aziende trovano risposta nell’incontro di competenze ed expertisedi startup affiliate, istituzioni, università, R&D e partecipazione attiva a iniziative strategiche a livello europeo. A corollario di questo scenario c’è uno dei supercomputer Hpc più potenti al mondo, “Leonardo” (una referenza di Lutech per il Cineca), la cui potenza di calcolo, insieme all’esperienza di iGenius, sta dando vita a “Modello Italia”, la risposta italiana a ChatGPT, progettato e addestrato esclusivamente in italiano con fonti affidabili e certificate.

Qual è la posizione di Lutech sugli aspetti etici e regolamentatori dell’AI?

Garantire equità, trasparenza e conformità alle normative per costruire fiducia con utenti e stakeholder, affrontando proattivamente questioni etiche e regolamentari, è un obbligo propedeutico all’adozione dell’AI, ma il rischio che stiamo correndo a livello europeo è di concentrarci troppo rigi-

damente su questi aspetti e non saper competere con Usa e Cina in termini di investimenti. Dobbiamo infatti renderci conto che l’Artificial Intelligence cambia la nostra relazione con la tecnologia, con l’innovazione e con lo stesso concetto di “conoscenza” e che per la prima volta non dobbiamo rinunciare a nulla: la forza dell’AI sta proprio nel superare i tradizionali tradeoff tra economia, sostenibilità e valori sociali, una trasformazione sinergica che permette di armonizzare inclusività, etica ed efficienza.

Che impatto avrà l’AI sul mondo del lavoro?

L’Artificial Intelligence ha maggiore impatto quando è sviluppata all’interno di team interfunzionali e interdisciplinari, che hanno un raggio diversificato di prospettive e competenze da attivare per garantire che siano affrontate le priorità più ampie nel panorama aziendale, per soluzioni di AI più complete ed efficaci, che tengano conto di tutti gli aspetti di backend e dell’intero ciclo di vita del cliente. Una riuscita implementazione dell’AI richiede quindi un approccio strategico che vada oltre gli investimenti tecnologici e sappia coinvolgere tutti gli attori in gioco. Perché se esiste il tema critico della competizione essere umano-macchina, ci sono anche i germogli per prospettare maggiore collaborazione e scambio tra le persone: una rinnovata alleanza essere umano-essere umano per sfruttare al meglio le potenzialità della tecnologia restando protagonisti di questa rivoluzione senza precedenti.

L’azienda lombarda ha sviluppato un sistema che virtualizza i pazienti dei dentisti per facilitare lo scambio di dati necessario per realizzare gli impianti.

C’è un momento chiave nella storia di Idi Evolution , che coincide, nel 2002, con l’aggiunta del secondo termine dell’attuale ragione sociale a quella che era nata, tredici anni prima, semplicemente come Idi (Implantologia Dentale Innovativa). La modifica sancisce anche semanticamente il cammino che l’azienda lombarda aveva già intrapreso, ma ha in seguito accelerato in direzione della ricerca e dell’apporto tecnologico alla realizzazione delle protesi dentali, suo core business, con una produzione annua di circa cinquantamila impianti. Nella prima parte del nuovo millennio, in effetti, Idi Evolution ha messo a punto un motore implantologico, arrivato oggi alla terza generazione (Tmm3). “Nello stesso periodo

abbiamo introdotto strumenti Cad e Cam per dare una forte impulso alla produzione”, ricorda Andrea Piantoni , fresco di nomina alla carica di Ceo della società, dopo aver ricoperto per diverso tempo il ruolo di chief innovation officer. “Ma il vero salto di qualità, partito allora, ha riguardato la mutazione da realtà molto industriale, che realizzava pezzi prodotti in serie, verso la fornitura di un servizio su misura ai nostri clienti, ovvero gli studi dentistici”.

Un metodo strutturato

Per molto tempo il settore odontoiatrico si è basato quasi esclusivamente su dati empirici per la cura dei pazienti, mentre Idi Evolution è stata fra le realtà che in Italia hanno avviato una rivoluzione, tuttora in atto, basata sull’utilizzo

strutturato di tecnologie informatiche e analisi dei dati. L’azienda poggia oggi la propria attività sull’utilizzo della piattaforma Km Zero, che integra le varie fasi del workflow clinico necessario per andare dalla rilevazione del problema dentale sul paziente alla consegna della protesi personalizzata. Al centro della piattaforma c’è il motore Alfred, ovvero il software che gestisce tutti i processi clinici ed extraclinici degli studi odontoiatrici e che costituisce il principale valore tecnologico sviluppato e messo a punto da Idi Evolution. Questa è la vera e propria interfaccia tra lo studio dentistico e i pazienti: “La sua funzione principale è integrare tutti i dati che arrivano dalle varie componenti di quello che si configura come un vero e proprio processo di virtualizzazione del paziente e consentire ai dentisti di disporre di una gestione personalizzata dello studio, con tutte le informazioni cliniche di ogni soggetto e la possibilità di instaurare una comunicazione trasparente tra medico e paziente”, illustra Piantoni.

Per arrivare a produrre una protesi realizzando un prototipo virtuale, l’azienda oggi lavora con tre diversi tipi di scansione: intra-orale, di movimento e facciale. Prima questi passaggi avvenivano in un tempo molto più lungo, solo attraverso i calchi e con minor precisione. Idi Evolution ha selezionato una serie di tecnologie e strumenti che consentono di coprire integralmente questo workflow clinico, fornendo allo studio dentistico in comodato d’uso le macchine che servono ad avviare il lavoro e il software che l’azienda stessa ha sviluppato, mantenendo poi (attraverso la stessa piattaforma) il dialogo aperto con il professionista e la condivisione dei dati. “Avere tutti i dati all'interno di un unico sistema centrale consente di effettuare anche analisi per migliorare la qualità del lavoro degli studi e le relative pratiche cliniche e qui facciamo già leva sull’impiego dell’intelligenza artificiale”, chiarisce Piantoni.

“Abbiamo iniziato a sviluppare Alfred circa quattro anni fa, estendendone progressivamente il raggio d’azione a tutto il range delle pratiche odontoiatriche”.

Dal punto di vista dell’infrastruttura tecnologica, l’azienda ha fatto scelte precise, decidendo di mantenere all’interno tutta la parte di produzione degli impianti e delle protesi, mentre la componente informatica è in cloud su Microsoft Azu-