EDITORIAL

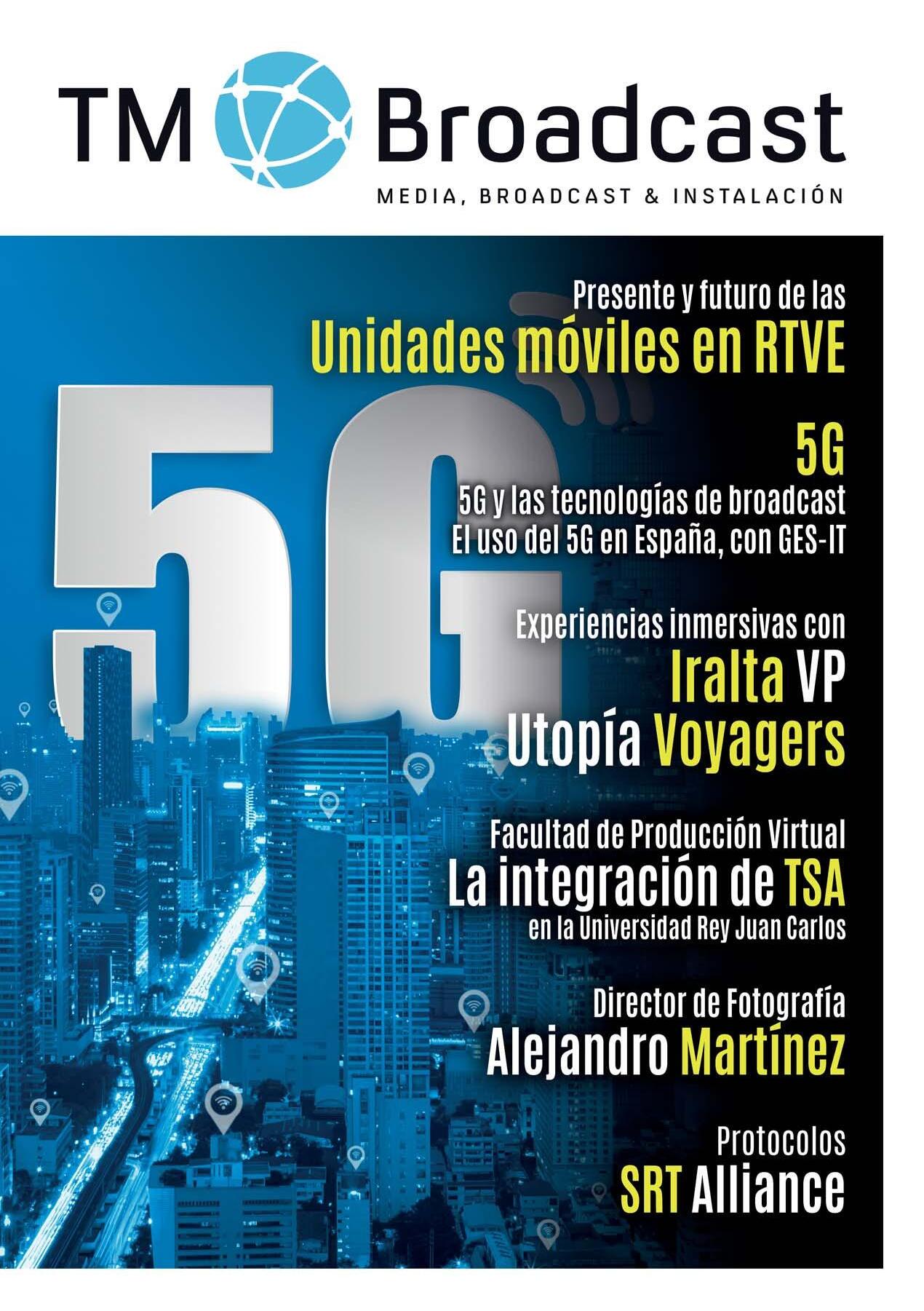

Televisión Española se encuentra inmersa en muchos procesos de renovación tecnológica. A lo largo de nuestras numerosas ediciones los hemos ido desgranando para vosotros. Hoy abordamos uno de los más interesantes.

El ente público se encuentra actualizando sus recursos de unidades móviles. Los efectivos se han quedado escuetos para las necesidades del broadcaster público. El objetivo, que se alcanzará a finales de 2023, es conseguir todas las capacidades que le harán estar preparado para el futuro.

Uno de los puntos más interesantes de este reportaje se basa en conocer todos los detalles de una de las unidades móviles más punteras de RTVE. Se trata de la unidad H1, la unidad móvil capacitada para la producción de contenido en UHD, HDR y preparada para el IP.

Además de este reportaje en exclusiva, TM Broadcast se ha centrado en dos de las tendencias más actuales de nuestra industria. Pero, como acostumbramos a hacer en nuestra revista, los hemos abordado desde la practicidad. Está muy bien que la industria teorice sobre las posibilidades que nos brindarán desarrollos como el metaverso y las realidades inmersivas o el 5G, pero queríamos conocer qué casos prácticos se desarrollan a día de hoy.

Respecto a las tecnologías inmersivas, el desarrollo aún es temprano pero ya existen casos prácticos, como el de la empresa Iralta VP y el personaje de Mapi, donde todas las herramientas de producción de contenidos

inmersivos se pusieron a disposición de un personaje virtual integrado en tiempo real en una emisión profesional.

El 5G es extremadamente prometedor para nuestra industria. Las posibilidades son apabullantes. No obstante, los desarrollos aún no han llegado a su cénit. Para conocer los últimos avances en esta tecnología, os ofrecemos la experiencia de David Gómez-Barquero, investigador de la Universitat Politècnica de Valéncia. Por otro lado, no podíamos dejar de observar el estado actual y la aplicación práctica. Para profundizar en este aspecto, hablamos con GES-IT, una de las empresas más especializadas en la transmisión por redes móviles.

Además, nos hemos acercado a la Universidad Rey Juan Carlos de Madrid para mostrar en primicia cómo han adaptado sus controles, platós y recursos broadcast a una industria que no para de crecer. De la mano de responsables de la propia universidad y de su integrador, Telefónica Servicios Audiovisuales, obtendrán los detalles de unos estudios profesionales centrados en la producción virtual a disposición de los estudiantes.

Y para finalizar, les ofrecemos también la experiencia de Alejandro Martínez, director de Fotografía mexicano que aportó su conocimiento al rodaje de “La casa del dragón”, y un artículo especializado sobre la implantación del protocolo SRT en el mundo y las acciones que promueve la SRT Alliance para seguir creciendo.

Editorial EDITORIAL TM Broadcast 3

EDITOR

Javier de Martín editor@daromediagroup.com

DIRECCIÓN DE CONTENIDOS

Mercedes González mercedes.gonzalez@tmbroadcast.es

DIRECCIÓN ADMINISTRACIÓN

Laura de Diego laura.dediego@daromediagroup.com

DIRECCIÓN COMERCIAL

Javier M. Gutiérrez jmg@tmbroadcast.es

PUBLICIDAD

Sergio Castaño sergio.castano@tmbroadcast.es

Susana Sampedro ssa@tmbroadcast.com

REDACCIÓN redaccion@tmbroadcast.es

MAQUETACIÓN

Sorex Media

COLABORADORES

Yeray Alfageme

Carlos Medina

Luis Pavía

Carlos Alberto Martín

Javier Guerra

Luis Sanz

Alfonso Redondo

José Luis Cordero

Carlos González

Fernando Suárez

SUSCRIPCIONES suscripciones@tmbroadcast.es

Imprime: V. A. Impresores S.A.

Dep. legal: M-11254-2008

ISSN: 1888-6965

Impreso en España en febrero de 2023

TM Broadcast no se hace responsable de las opiniones vertidas en los reportajes e informaciones firmadas. Todos los derechos reservados. Esta publicación no puede ser reproducida ni en todo ni en parte en ningún medio impreso ni electrónico, ni registrada en, ni transmitida por cualquier sistema sin permiso previo por escrito de la editorial.

TM Broadcast es una publicación de Daró Media Group S.L. Centro Empresarial Tartessos

Calle Pollensa 2, Oficina 14 28290 Las Rozas, Madrid.

Tf: 91 640 46 43

6

Actualidad

The Viewfinder, por Yeray Alfageme

14

13 Presente y futuro de las unidades móviles en RTVE RTVE se encuentra inmerso en un proyecto de renovación de sus unidades móviles. El proyecto, a cuatro años, tiene como fecha límite el final de 2023. El objetivo es proporcionar a RTVE de todos los recursos necesarios para abordar sus proyectos en el exterior. Hemos hablado con Francisco José Collado, subdirector de Ingeniería y Soporte de Estudios y Unidades Móviles de TVE, para conocer el estado actual de la renovación, los detalles de la infraestructura y las proyecciones que el ente público tiene sobre las tendencias que agitan nuestro mercado.

22

4 SUMARIO SUMARIO

5G y las tecnologías de broadcast

El uso del 5G en España, con GES-IT 28

34

Experiencias inmersivas con Iralta VP

Utopía Voyagers

Facultad de Producción Virtual La integración de TSA en la Universidad Rey Juan

Carlos

Telefónica Servicios Audiovisuales ha desarrollado la renovación de los estudios broadcast para estudiantes de la Universidad Rey Juan Carlos, una de las universidades públicas españolas más atentas a los desarrollos tecnológicos industriales asociados a las carreras de Comunicación. Tanto es así que, en sus dos campus —Vicálvaro y Fuenlabrada—, han decidido implementar infraestructuras que podríamos encontrar en cualquier broadcaster de prestigio nacional e internacional. Por supuesto, siempre adaptado al entorno educativo.

Entrevista con Alejandro Martínez

De familia cineasta y nacido en la Ciudad de México, Alejandro Martínez ha creado su propio camino como director de fotografía. Este reconocido director de fotografía nos cuenta sus impresiones sobre el oficio y cómo fue trabajar en la producción de “House of the Dragons”.

Protocolos SRT Alliance 62

SUMARIO TM Broadcast 5

54

48

SVOD Tracker analiza el posicionamiento de contenidos en España

A través de la herramienta SVOD Tracker se han anunciado los resultados de 2022 en cuanto al posicionamiento de contenidos en servicios bajo demanda de plataformas y operadores de streaming.

Lanzada en 2017, la herramienta ya ha recopilado más de 40 millones de registros de datos. Las empresas objeto de seguimiento son las que cuentan con mayor número de abonados según el EGM (Estudio General de Medios de España): los operadores españoles Movistar Plus+, Vodafone TV, Orange TV y Euskaltel, y los servicios OTT en España Netflix, Prime Video, HBO Max y Disney+.

Los contenidos de terceros dominan entre los operadores de telecomunicaciones en España, a excepción de Movistar Plus+, que dio el primer puesto a uno de sus programas originales, Martínez y

Hermanos. Además, la totalidad de los 25 títulos mejor posicionados en la plataforma están asociados a su marca (75% producciones propias y 25% adquisiciones).

Los 25 títulos mejor situados en Euskaltel son todos series de canales de terceros, mientras que en Orange TV casi todos son películas de Videoclub by Rakuten (pago por visión). Vodafone TV también cede sus primeros puestos a las suscripciones adicionales incluidas en su servicio y a contenidos de terceros.

En el caso de las plataformas de streaming en España, los títulos mejor posicionados son siempre de producción propia. El 100% de los 25 títulos más vistos en HBO Max y Disney+ son contenidos originales, mientras que Netflix y Prime Video incluyen contenidos que no han producido ellos mismos (en el caso de Netflix, series producidas por terce-

ros, y en Prime Video, contenidos de pago por visión o de suscripción adicional como Prime Video Channels).

«Los hábitos de visionado de los usuarios se guían por cómo las plataformas promocionan y posicionan sus contenidos», asegura Fernando Hernáiz, director de Investigación de AMC Networks International Southern Europe (AMCNISE).»Las opciones de visualización se hacen más complejas por el elevado número de carruseles en la página de inicio. Las plataformas deben seguir trabajando en el diseño de interfaces de usuario más sencillas para facilitar a los usuarios el acceso a todo tipo de contenidos y mitigar los efectos de la fatiga de decisión en los espectadores».

Actualidad 6 NOTICIAS TM Broadcast SVOD TRACKER

AEQ suministra

su intercom

Xpeak a Terrassa TV

AEQ ha anunciado que Terrasa TV ha confiado en sus sistemas para la coordinación de sus operaciones de televisión, radio y exteriores con el sistema de intercomunicación AEQ Xpeak.

Se trata de un sistema sin matriz, basado en tecnología de audio sobre IP, diseñado para producción de TV, y optimizado para producciones remotas.

Se ha instalado un terminal en formato rack Xpeak_R en el Control de Realización del estudio de Televisión y otro en el Control de Emisión de la Radio.

Por otra parte, se han instalado dos Beltpacks cableados Xpeak_BP para coordinar a los cámaras en el Plató de Televisión y dos beltpacks inalámbricos con tecnología WiFi Xplorer garantizan la comunicación de los productores que se mueven

por el plató y por todo el Centro de producción.

Para la coordinación exterior, un interfaz Xpeak_IF permite incorporar hasta 4 circuitos externos, analógicos, USB o Dante. Dos de estos circuitos se conectan a un híbrido telefónico TH02, que permite por telefonía convencional, acceder a los

microauriculares manos libres del personal de la unidad móvil o equipos de ENG.

El sistema puede crecer hasta 28 terminales y el proyecto ha sido coordinado por Nacho Olivella, responsable comercial de la compañía para Cataluña.

Ateme suministró sus soluciones a Movistar Plus+ para la Copa del Mundo 2022

Ateme ha anunciado que Movistar Plus+ ha utilizado sus soluciones de contribución para ofrecer contenidos Premium UHD/HDR y Dolby Atmos de la Copa del Mundo para su emisión en todo el país durante el torneo de la Copa del Mundo de 2022.

Este servicio ha sido impulsado por Telefónica Servicios Audiovisuales (TSA) que ha ayudado a Movistar Plus+ con el despliegue de esta solución técnica para la codificación y transporte de señales.

Se han utilizado los codificadores y decodificadores TITAN Edge de software completo de Ateme, con características de inmersión de audio.

«La Copa del Mundo es uno de los eventos en directo más importantes y emblemáticos, en el que el rendimiento, la calidad y la fiabilidad son fundamentales», comentó Manuela Martínez, directora de Ingeniería. «Estamos satisfechos con las soluciones de Ateme, que dieron soporte a las retransmisiones en directo más vistas del mundo y garantizaron a los consumidores la mejor experiencia de visionado».

Actualidad NOTICIAS TM Broadcast AEQ - ATEME 8

Asociación entre Kalicon Media y Toboggan para el desarrollo de proyectos audiovisuales

Kalicon Media y Toboggan han anunciado un acuerdo de colaboración estableciendo una relación de partnership para el desarrollo de proyectos audiovisuales.

La alianza entre las dos empresas establece una relación de prestación de servicios de producción y posproducción, comercialización para la captación de proyectos, ya sean propios o de terceros, así como gestión y captación de Inversores interesados en financiarlos.

Todo ello, dentro del territorio foral de Bizkaia. Posicionado desde el uno de enero de 2023, como un hub de producción local e internacional gracias a la nueva reforma fiscal para la inversión y apoyo a la industria audiovisual, impulsada por la Diputación y Hacienda del territorio.

Kalicon Media, es una productora fundada en abril de 2022 por profesionales del sector audiovisual con más de 22 años de experiencia en la creación, producción y gestión de

contenidos líderes de audiencia. Toboggan, es una compañía que se encarga de gestionar estudios de grabación, aportando los medios técnicos de producción y postproducción más avanzados para cubrir las necesidades de sus clientes tanto en ficción, cine y publicidad.

Ambas compañías comienzan así su colaboración para la generación de nuevos proyectos audiovisuales en Bizkaia y para dar soporte a la industria y a otras productoras interesadas en la gran oferta de servicios que ofrece esta alianza.

KALICON MEDIA - TOBOGGAN

Actualidad

La primera red móvil comercial 5G mmWave de mano de Telefónica, Ericsson y Qualcomm

Ericsson, Telefónica y Qualcomm han anunciado el lanzamiento de la primera red móvil comercial 5G milimétrica en España, que tendrá lugar en el MWC 2023 en Barcelona.

El despliegue de 5G mmWave cubrirá el Hall 3 del evento utilizando un amplio ancho de banda de espectro mmWave asegurado por Telefónica. Ericsson proporciona su radio mmWave AIR 5322 y el procesador RAN de alta capacidad 6651 para permitir la cobertura milimétrica de 5G. El equipo de red de acceso por radio está alimentado por el chipset Ericsson Silicon.

Qualcomm mostrará dispositivos 5G mmWave con tecnología Snapdragon, incluidos teléfonos inteligentes comerciales premium, PC, CPE y puntos de acceso, entre otros.

Con esta implementación de 5G mmWave, basado en su alta capacidad de red y el aumento de rendimiento, se busca la mejor experien-

cia de usuario de 5G para los visitantes del MWC, permitiendo una conectividad móvil ultrarrápida con latencias más bajas.

Gerardo Rovira, director de Radio Acceso Telefónica España, afirma: «Este primer despliegue comercial de servicios 5G mmWave que estamos lanzando junto con Ericsson y Qualcomm, junto con el espectro masivo que Telefónica ha obtenido en la última subasta, es el último hito en un serie de proyectos 5G a largo plazo que Telefónica ha venido desarrollando en colaboración con empresas e instituciones en los últimos 3 años, y demuestra en gran medida el compromiso que tiene Telefónica en el desarrollo y liderazgo de un ecosistema 5G fuerte que será un factor clave para brindar servicios atractivos tanto para el sector público como para el privado».

«Nuestra colaboración con Telefónica y Qualcomm para lograr este salto tecnológico 5G mmWave en España cambiará drásticamente

la experiencia de conectividad móvil para consumidores y empresas, haciéndola más rápida, más accesible y más confiable. La banda milimétrica abre un nuevo paradigma en el despliegue de la tecnología 5G, que brindará a los operadores una poderosa herramienta para complementar la estrategia de despliegue de red existente para aumentar el rendimiento y la capacidad con diferentes necesidades», ha añadido Somaya El-Marrakchi, directora de Redes de Ericsson Iberia.

Dino Flore, vicepresidente de tecnología de Qualcomm Europa, ha comentado: «Estamos orgullosos de continuar trabajando con socios de la industria como Telefónica y Ericsson para ampliar los límites de la conectividad y permitir experiencias de consumo sólidas. Poder mostrar el primer despliegue comercial de servicios comerciales 5G mmWave en el MWC 2023 Barcelona es un ejemplo de otro hito importante para 5G mmWave en Europa».

Actualidad TELEFÓNICA - ERICSSON - QUALCOMM

NOTICIAS TM Broadcast 10

Asociación entre LaLiga y Banijay para el lanzamiento de LaLiga Studios

LaLiga y Banijay Iberia se han asociado para lanzar una nueva compañía de producción, LaLiga Studios, con contenidos relacionados con el deporte.

LaLiga Studios, que aglutina la producción de contenidos audiovisuales de LaLiga, clubes, patrocinadores y broadcasters colaborará con plataformas y marcas a nivel internacional en el desarrollo, producción y distribución de contenidos de entretenimiento, documental, ficción y animación.

La nueva sociedad ha designado como Managing Director & EP a Chalo Bonifacino Cooke encargado de coordinar su crecimiento internacional, que se verá impulsado gracias a la presencia de ambas compañías en múltiples mercados. El acuerdo se hará efectivo en las próximas semanas.

«Tenemos un plan ambicioso para LaLiga Studios, queremos trabajar con las mejores marcas y para ello necesitamos contar con el mejor socio. Salir al mercado con el aval de la calidad y la experiencia de

Banijay Iberia es para nosotros el mejor de los comienzos», ha comentado Óscar Mayo, director general Corporativo de LaLiga.

«Estamos muy orgullosos de anunciar esta asociación con LaLiga, grandes generadores de narrativas alrededor del deporte y sus valores. Ponemos a su disposición nuestra experiencia en la producción y creación de contenido premium para que estas historias se cuenten, con los más altos estándares de calidad, y se conozcan en todo el mundo», ha apuntado Pilar Blasco, CEO de Banijay Iberia.

Actualidad LALIGA - BANIJAY

La película “Sin novedad en el frente” confía en los productos de Blackmagic

Blackmagic ha anunciado que la película “Sin novedad en el frente”, nominada a los Óscar en la categoría de mejor película internacional, y gran triunfadora de los premios BAFTA de este año, se etalonó y finalizó con DaVinci Resolve.

La primera adaptación al alemán de esta película fue producida por Amusement Park para Netflix. Su dirección de fotografía estuvo a cargo de James Friend, ASC, BSC, mientras que, Universal Production Partners (UPP) finalizó la posproducción con el apoyo del colorista principal Andrew Daniel, de Goldcrest Post.

UPP implementó una dinámica de trabajo basada en la gestión cromática de ACES, a fin de garantizar una transición fluida entre el conformado, el etalonaje y la finalización del material. A su vez, el procesamiento de las imágenes y la corrección cromática de los copiones en el set se

llevaron a cabo con DaVinci Resolve Studio.

El largometraje, basado en el libro homónimo de Erich Maria Remarque, de producción alemana y dirigida por Edward Berger, narra la vida del soldado alemán Paul Bäumer, quien, después de enlistarse en el Ejército alemán con sus amigos, se encuentra ante los riesgos de la guerra, los cuales destruyen sus esperanzas iniciales de convertirse en héroes.

Andrew Daniel diseñó una serie de tablas de conversión de transformación antes de comenzar con la fotografía principal para emplearlas durante el procesamiento de los copiones en el set. «Es un proyecto con cierto legado, tanto en términos literarios como cinematográficos», observó Daniel. «Como tal, nos gustó la idea de alejarnos de la estética familiar que comparten las producciones similares al aumentar la satu-

ración y el contraste. Además, aplicamos una granulosidad sutil en todas las imágenes».

«Cada película es un proceso de exploración», expresó James Friend. «Al inicio de la producción, no tengo muy claro cómo quiero que sea la apariencia de las imágenes. Cuando empiezan a llegar los copiones, de a poco voy implementando cambios que reflejan la integridad de la historia. Con “All Quiet on the Western Front”, quería lograr cierto naturalismo y una sensación de franqueza, fieles al entorno y el contexto histórico».

Asimismo, Daniel y Friend trabajaron con el supervisor de efectos visuales Frank Petzold durante el etalonaje. Con más de 460 tomas con efectos visuales, Petzold descubrió rápidamente que podía finalizar muchos de dichos efectos de último momento en DaVinci Resolve Studio.

NOTICIAS 12 TM Broadcast Actualidad BLACKMAGIC DESIGN

El big data no lo es todo

En la era digital en la que vivimos, el streaming se ha convertido en una parte integral de la vida cotidiana. Con la creciente popularidad de los servicios de streaming como Netflix, Amazon Prime y Disney+, los datos de analíticas de visionado se han convertido en una herramienta crucial para nuestra querida industria del broadcast.

Las analíticas de visionado permiten a las plataformas de streaming analizar el comportamiento del usuario mientras ve una película o un programa de televisión. Estos datos incluyen información como el tiempo que se pasa viendo un programa, el número de veces que se detiene o rebobina una escena y la frecuencia con la que se omite una introducción.

En la actualidad, las analíticas se utilizan ampliamente para determinar qué contenido se debe producir y qué programas se deben cancelar. Los datos obtenidos de estas analíticas pueden revelar qué programas son más populares y cuáles tienen una mayor tasa de abandono. También pueden ayudar a los productores a determinar qué géneros o tipos de programas son más populares en diferentes regiones del mundo.

Aunque algunos pueden argumentar que el uso de las analíticas es invasivo y puede ser utilizado para espiar a los espectadores, la verdad es que estos datos son recopilados de manera anónima y se utilizan para mejorar la experiencia de visualización. Los productores pueden utilizar los datos para ajustar la duración de los episodios y las temporadas, para eliminar los puntos de la trama que no funcionan y para ajustar la frecuencia con la que se presentan los anuncios.

Sin embargo, algunos críticos argumentan que el uso de estas analíticas puede tener un impacto negativo en la creatividad. Algunos pueden argumentar que el énfa-

sis en los datos de los espectadores puede limitar la creatividad y la originalidad de los programas. Por ejemplo, los productores pueden optar por producir programas que sean similares a los que ya han tenido éxito, en lugar de correr el riesgo de producir algo nuevo y emocionante.

A pesar de estas preocupaciones, creo que el uso de las analíticas de visionado en streaming es beneficioso para nuestra industria. Los datos de los espectadores pueden ayudar a los productores a tomar decisiones informadas sobre qué contenido producir y cómo presentarlo a los espectadores. También pueden ayudar a las plataformas a mejorar la experiencia de visualización del usuario al ajustar la calidad de transmisión y la frecuencia de los anuncios.

Además, creo que el uso de las analíticas no tiene por qué limitar la creatividad de la industria. En cambio, los productores pueden utilizar estos datos para informar y mejorar su proceso creativo. Por ejemplo, los datos pueden ayudar a los productores a identificar los puntos de la trama que no funcionan y a ajustarlos para crear una experiencia más satisfactoria para los espectadores.

En resumen, creo que el uso de las analíticas de visionado en streaming es una herramienta valiosa para este nuestro querido broadcast. Si se utiliza de manera ética y en combinación con otros factores, puede mejorar la calidad del contenido y la experiencia de visualización de nuestros espectadores. Si bien es importante tener en cuenta las preocupaciones sobre la privacidad y la creatividad, creo que los beneficios de las analíticas de visionado superan con creces los riesgos.

@yerayalfa www.linkedin.com/yerayalfa

THE VIEWFINDER The Viewfinder TM Broadcast 13

Por Yeray Alfageme, Business Development Manager en Optiva Media an EPAM company

Presente y futuro de las unidades móviles en RTVE

14 UNIDADES MÓVILES TM Broadcast RTVE

RTVE se encuentra inmerso en un proyecto de renovación de sus unidades móviles. El proyecto, a cuatro años, tiene como fecha límite el final de 2023. El objetivo es proporcionar a RTVE de todos los recursos necesarios para abordar sus proyectos en el exterior. Hemos hablado con Francisco José Collado, subdirector de Ingeniería y Soporte de Estudios y Unidades Móviles de TVE, para conocer el estado actual de la renovación, los detalles de la infraestructura y las proyecciones que el ente público tiene sobre las tendencias que agitan nuestro mercado.

“El futuro de las unidades móviles es convertirse en camiones de cámaras conectados en IP”. Con esta afirmación, Francisco José, alude a la influencia que soluciones tecnológicas como los servicios de software, la remotización, la nube, la virtualización de recursos de hardware o el IP tienen sobre los flujos de trabajo fuera de los centros de producción. En este reportaje encontrarán tanto los detalles de esta renovación como el modelo de unidad móvil que RTVE plantea para el futuro.

¿Cuáles son las unidades móviles con las que cuenta RTVE? ¿Cómo serán cuando acabe el plan de renovación?

RTVE está inmerso en un proyecto de renovación de sus unidades móviles desde hace unos cuatro años. Los recursos en los que el ente público está trabajando son diversos. La cantidad de formatos que esta televisión produce exigen distintos medios de producción. Para abarcar todos estos contenidos RTVE contaba con unidades móviles de tipo pequeño en SD, en proceso de desaparición, varias unidades Tipo PEL, que trabajan en HD y en SD, dos unidades tipo G que pueden trabajar en SD y en HD y albergar entre 8 y 10 cámaras, otras dos unidades tipo F que trabajan en HD y dan cobertura a producciones que necesitan entre 16 y 20 cámaras, una unidad de sonido y otra de gra-

bación. En su momento, estas capacidades no eran suficientes.

Por ello, se emprendió un proyecto de renovación sobre todos estos recursos. El objetivo para 2023 afecta a varios de ellos. Asimismo, el cuerpo de recursos broadcast para exterior del que dispondrá RTVE también será ampliado. En concreto, se han fabricado 4 unidades tipo PEL en HD, que se han repartido entre los distintos centros de producción (Canarias, Cataluña, Torrespaña y Prado del Rey), se ha creado una unidad móvil específica a la que se ha denominado Tipo B —que trabajará en Cataluña y se encontrará a medio camino entre la Tipo PEL y la Tipo G, por lo tanto podrá trabajar multicámara entre 6 y 8—; y finalmente, se desarrollará la nueva unidad 4K-UHD de la que todo el mundo está hablando. Esta nueva

herramienta se desarrollará sobre una de las unidades móviles Tipo F, ampliándose para poder trabajar con hasta 12 cámaras y hasta en UHD, pasándose a llamar Tipo H, cuando esté finalizada. Podrá trabajar tanto en HD y 3G como en 4K y 12G, además de HDR y SDR.

¿Por qué 12G?

En 4K se pueden dar dos tipos de instalaciones: 12 G, que es un único cable y la instalación es similar al HD; o bien, con cuatro componentes de 3 G para formar la señal 4K. Esta segunda opción se denomina habitualmente “quad” y normalmente conlleva que la instalación sea más complicada. Aparte, el punto que ha alcanzado la tecnología actualmente permite que se pueda trabajar en 12 G ya que la mayoría de los equipos están actualmente preparados.

15 TM Broadcast RTVE UNIDADES MÓVILES

UNIDADES MÓVILES

Por estas razones hemos desarrollado esta posibilidad, la tecnología lo permite y la instalación es más sencilla. Además, otra de las razones ha sido que nos permite trabajar en 4K de la misma manera que lo haríamos en HD. Es decir, con este sistema si trabajamos en HD y queremos hacer un programa en 4K, lo único que tenemos que hacer es cargar la configuración. Automáticamente, todas las conexiones físicas pasarán de trabajar en 3 G a hacerlo en 12 G.

¿Se envían las dos señales al tiempo y el operador elige?

El operador elige entre HD o 4K. O incluso, de forma simultánea en ambos formatos. No obstante, sí que es cierto que debemos integrar equipos que tengan varias salidas configurables de forma independiente, es decir, una en 3 G y otra en 12 G.

Sin embargo, su uso depende mucho de la producción. Lo más

lógico es que si trabajas en 4K-UHD y quieres un resultado en HD, al final de la cadena hagas una conversión hacia abajo. Por otro lado, existen determinados contenidos que te exigen trabajar en ambos formatos de forma simultánea. Por ejemplo en una realización diferenciada en UHD y en HD. En ese caso habría que considerar diferentes alternativas. Puede ser que sea necesario tener un segundo mezclador haciendo una parte diferenciada en HD, por lo

16 RTVE TM Broadcast

tanto deberías de configurar ciertas salidas del mezclador para HD únicamente. Otra opción sería que siempre se usara la salida en 4K para llevar esa señal a un mezclaefectos, por ejemplo, o a una salida auxiliar y sobre esa salida auxiliar que otro operador actuase por si hay algo diferenciado de la señal de 4K que tenga que lanzarse en el formato de HD. Hemos considerado todas estas opciones en la instalación. A lo mejor hay mayor cableado de lo que se requiere para una única producción, pero siempre se puede usar cuando sea necesario.

Por ponerlo en negro sobre blanco, ¿sobre qué tipo de proyectos crees que se podría usar esta unidad móvil?

Por ejemplo, si estás realizando un evento deportivo, entonces

estás produciendo en 4K y luego la emisión la haces en HD. No obstante puede que el 4K sí que lo estemos grabando, por ejemplo para archivo. También se puede hacer al contrario. Puedes estar haciendo toda la realización para HD, pero tienes algún tipo de realización diferenciada. Por ejemplo, para tener más recursos de grabación.

A lo mejor también para realizar contenidos específicos para entornos digitales, ¿verdad?

Sí es cierto. Esas realizaciones diferenciadas también tienen sentido en la web. Ahora, han sido los Goya. En ese caso se puede hacer una realización principal en 4K. En los momentos en los que entra publicidad en la emisión, en la plataforma se sigue emitiendo. En esos casos se puede hacer una realización alternativa en HD.

TM Broadcast

17

Yendo al apartado más técnico, ¿qué es necesario para que la realización simultánea se pueda realizar?

Principalmente, la capacidad se basa en los equipos. Necesitamos equipamiento que tenga bastantes salidas por cada equipo y que sean configurables. Esto es lo más importante. Porque nosotros tenemos una matriz general en la que conectaremos todas las señales. Entonces, si los equipos de origen y destino nos permiten que sus entradas y salidas

sean configurables obtenemos una gran flexibilidad porque dotamos a estas unidades móviles de un sistema de gestión broadcast. A ese controlador podemos configurarle diferentes parámetros con la capacidad de actuar sobre todos los equipos. Entonces podemos crear diferentes escenas y situaciones. La gran ventaja que tiene esto es que resulta transparente para el operador.

El trabajo en HDR y SDR simultáneo, ¿funciona de la misma manera?

Puede trabajar en HDR y SDR simultáneamente, pero es verdad que tenemos que centrar qué flujo de trabajo queremos introducir en esta unidad móvil. Porque según hemos observado, en producción hay diferentes formas de trabajar para estos formatos. Debemos cuidar que si haces un trabajo en HDR, también se vea bien en SDR. Ahora mismo, en el parque de televisiones españolas encuentras televisiones de los dos tipos, sobre todo SDR, por lo tanto debe quedar bien la imagen en ambos formatos.

UNIDADES MÓVILES 18 RTVE TM Broadcast

Lo cierto es que esto suele depender del fabricante de cámaras. Sony tiene una forma de trabajar, Ikegami tiene otra. En el segundo se puede ajustar al mismo tiempo el SDR y el HDR, pero claro, el broadcaster tiene un solo operador. Si se preocupa de ajustar para el HDR, no puede preocuparse en ajustar también el SDR. Digamos que eso debemos definirlo con el fabricante en la fase de implantación. El objetivo es que nos transmita su forma de entender este proceso y que nosotros veamos cuál es la mejor forma de proceder. Porque a lo mejor entendemos que lo lógico es que el control de imagen haga su ajuste y, al final de la cadena, sea el técnico de imagen el que haga sus ajustes para el SDR sobre la emisión.

Abundando en vuestro parque de recursos para broadcast en exteriores. ¿Quién ha hecho la integración de las unidades?

El diseño de ingeniería, la redacción de pliegos y lista de características necesarias se ha hecho desde el departamento de Ingeniería de la Televisión. A licitación se ha llevado el suministro de ese equipamiento y la integración. En el caso de las PEL y la unidad móvil B queríamos que el integrador se encargase de todo. Las unidades tipo PEL las desarrolló enteras Unitecnic.

¿Por qué se optó por hacerlo de este modo tan concreto?

Por facilitar la instalación de estas unidades y también por

homogeneizar. Son cuatro las que hicimos y debían de ser iguales ya que van a diferentes destinos. Solo lo asegurábamos si la instalación y el equipamiento era brindado por la misma empresa.

Punto por punto, ¿cuáles son los equipos que se han integrado en las unidades PEL?

Las cámaras son Grass Valley. El mezclador de vídeo es el modelo Kula de Grass Valley. La mesa de sonido es el modelo Brio de Calrec. La matriz y multipantallas es Mediornet de Riedel. El generador de sincronismos de Albalá. El equipamiento de distribución también fue de Albalá. Equipos de medida de Tektronics. Otras marcas que han salido ha sido AEQ o Leader.

Pero la unidad 4K, tanto el proyecto como la instalación, tiene unas características distintas. ¿Cómo ha sido este proyecto?

En la UHD es algo diferente. Para este caso concreto, por presupuestos y para buscar en el equipamiento nuclear la mayor calidad y opción óptima, hemos ido al modelo clásico. Hemos lanzado licitaciones por lotes. Por un lado ha ido la mesa de sonido, el sistema de matriz y multipantallas por otro, más adelante sacaremos también las cámaras y el mezclador. El resto del equipamiento lo vamos a aglutinar en un único lote y será el integrador quien se encargue del suministro de todo ese equi-

TM Broadcast

19

pamiento y de la instalación. Sí que es cierto que el integrador va a tener un papel muy importante.

Puede que este modelo sea más económico, pero, ¿no genera algún tipo de complejidad en la integración?

En teoría no. En el caso de las PEL, como eran cuatro, sí se podía haber creado algún tipo de dificultad en la integración a este respecto. Sin embargo, esta es una única unidad y el integrador se va a encargar de toda la instalación y de la puesta en marcha. De hecho, este sistema favorece también la concurrencia, es decir, que se puedan presentar más empresas.

¿Por qué no habéis optado por tecnología IP?

No hemos optado por tecnología IP porque el proyecto no estaba desarrollado de esa manera. Hemos optado por fundamentarnos en cableado clásico porque también queríamos dar un paso intermedio de desarrollo y no aventurarnos directamente al IP. Lo cierto es que el paso a 4K ha implicado también la llegada del HDR que también lo implementaremos en esta unidad móvil. Entonces, si a todo este cocktail de nueva información le añades el IP, iba a resultar mucho avance para una sola unidad móvil.

En esta unidad móvil, la matriz y el multipantallas es un sistema Mediornet de Riedel. Se implementó en las PEL. Se ha implementado también en las unidades móviles F. Hemos tenido en cuenta la continuidad de esta solución y hemos imple-

mentado una solución similar en la unidad H. Con ello, conseguimos conectar unidades móviles. Esta es otra de las razones por las que no hemos integrado soluciones IP.

RTVE ha apostado por ser continuista con sus unidades móviles. No obstante, el ente público ya ha emprendido varios proyectos IP. ¿No se ha tenido en cuenta esta renovación de unidades móviles para el futuro conectado de la televisión?

Con esto completamos el parque de unidades móviles que necesitábamos en Televisión Española. Ya veremos en un futuro si merece la pena conectarlas a IP. Tenemos los estudios de Sant Cugat en IP, que es lo que lo primero que hemos hecho. Próximamente, renovaremos un pequeño estudio de Torrespaña adaptándolo a IP. Más adelante emprenderemos la transición de las matrices de Torrespaña y de Prado del Rey a IP.

No obstante, sí que hemos tenido en cuenta la reciente evolución tec-

nológica en la renovación IP de las unidades móviles. Otro de los rasgos de la unidad H es que tiene la capacidad de que se pueda adaptar a IP fácilmente y con un coste razonable en un futuro. Una gran parte del equipamiento que tiene la unidad móvil es híbrido. El equipo de sonido, no tiene mucho misterio, porque la tecnología de la mesa puede ser IP nativa o no, pero la adaptación de los cofres de entrada y salida es sencilla. Es muy parecido con los equipos de vídeo, algunos ya están adaptados, para los otros simplemente sería sustituir la placa de SDI por la placa de fibra. Si deseáramos adaptar todo el equipo, estaríamos listos.

¿Una unidad móvil IP igual no es lo más deseable?

Estamos empezando a observar un cambio en las tornas. Más que una unidad IP completa, quizás llegue a ser más útil una unidad móvil más pequeña llena de cámaras conectadas a IP, como un camión de cámaras, que sean controladas remotamente desde los estudios.

UNIDADES MÓVILES

20 RTVE TM Broadcast

¿Qué futuro tiene la nube y la virtualización de los equipos? ¿Es un paso más?

Pues el futuro que promete es bueno. Observamos una tendencia por parte de algunas empresas de virtualizar su equipamiento, es decir, desplegarlo en la nube. Si en lugar de tener el hardware físico en un estudio, dispones de las prestaciones que te aporta sin la necesidad que esté anclado a un espacio físico, — las obtienen a partir de software—, puedes escalar tus proyectos en función de lo que necesites alquilando procesamiento en la nube.

La idea de la nube sería que con tus cámaras en un sitio determinado, llevas esas señales a la nube y en tu centro de producción, sea cual sea, cuentas con los remotos del mezclador, de la mesa, sonido, etc., es decir, de todo lo necesario para un estudio. Esas señales de las cámaras están en la nube y allí se mezclan y se hace todo el procesado para que luego tú obtengas la señal de programa. Eso otorga mucha flexibilidad, no necesitas hardware, no tienes que amortizarlo, son más bien servicios que adquieres cuando los necesitas.

Yo creo que todavía está muy poco desarrollado como para hacer producciones importantes, no sirve para producciones importantes, tampoco sirve para producciones continuas como un telediario, porque realmente no compensa el gasto. Pero si para un proyecto que quieres hacer una realización diferenciada para la página web. Con esta capacidad no consumes recursos propios de la unidad móvil que está haciendo la emisión, pero puedes obtener un resultado extra. Pongamos un ejemplo como el pasado Mundial. A lo mejor, puedes querer hacer resúmenes de los partidos rápidamente. Puedes hacer dos cosas. La primera es que puedes desplazar un equipo de grabación en disco duro. La segunda es que puedes grabar las señales en la nube, las mismas que obtienes de un host broadcaster, y mezclarlas allí en remoto desde cualquier lugar. Ese operador, según se está grabando el partido, va haciendo los resúmenes y los envía al terminar.

Es decir, de momento lo vemos útil para funcionalidades auxiliares. Habrá que ver que opciones brindará en el futuro cuando aumente la capacidad de computación.

Para los eventos que requieren una gran cantidad de cámaras, resultaría más rentable enviar cámaras y operadores que una unidad móvil completa. Podríamos controlar esas cámaras desde el Centro de Producción de Sant Cugat. Nos permitiría mover recursos más asequibles en un breve espacio de tiempo obteniendo la misma calidad en el contenido. Creemos que ese es el gran futuro del IP, donde de verdad podemos explotar sus capacidades.

¿Tiene Televisión Española algún proyecto de virtualización entre manos?

No, de momento no. Pero sí tenemos interés en probar y comprobar el estado actual de esa tecnología.

Aparte de finalizar estos proyectos, ¿cuáles son los siguientes pasos que vais a dar al respecto de las unidades móviles?

Con la finalización de la unidad móvil H, y la remodelación de las F, quizás nos quedaría renovar la parte de audio de la unidad móvil G, un proyecto que emprenderemos en breve. Con ello, ya dispondríamos del parque de unidades móviles necesarias para TVE y habrá concluido el proyecto de renovación de unidades móviles que nos planteamos ya hace cuatro años.

RTVE

UNIDADES MÓVILES TM Broadcast 21

22 5G TM Broadcast 5G Y LAS TECNOLOGÍAS DE BROADCAST

5G y las tecnologías de broadcast

Por David Gómez-Barquero, profesor del Departamento de Comunicaciones y sub-director de investigación del Instituto de Telecomunicaciones y Aplicaciones Multimedia (iTEAM) de la Universitat Politècnica de València (UPV).

Las tecnologías de radiodifusión parecen evolucionar a la misma velocidad que las tecnologías que nos rodean. En España todavía estamos utilizando la tecnología de Televisión Digital Terrestre (TDT) de primera generación DVB-T (Digital Video Broadcasting – Terrestrial), y tenemos pendiente la migración a la tecnología DVB-T2 ( Digital Video Broadcasting – Terrestrial 2nd Generation), que lleva más de 10 años en el mercado. El cambio a la tecnología DVB-T2 permitirá aumentar la eficiencia espectral de las redes de TDT en más de un 50%. Esto es, aumentar la capacidad de transmitir información en más de un 50%, lo cual se traducirá en aumento de la calidad de los contenidos transmitidos. Por ejemplo, más contenido en alta definición y ultra alta definición.

Desde la introducción de la TDT a finales del siglo pasado, hemos pasado por los estándares de telefonía móvil 2G (telefonía digital y mensajería de texto SMS), 3G (comienzos

del internet móvil y la llegada del primer iPhone), 4G (banda ancha móvil y popularización de las Apps y las redes sociales) y la llegada del 5G, la cual es mucho más que una nueva generación de comunicaciones móviles con velocidades de conexión más altas. La ambición del 5G es proporcionar conectividad inalámbrica en la transformación digital de muchos sectores industriales. El 5G también ofrece nuevas posibilidades para la industria broadcast.

Por un lado, la tecnología 5G puede facilitar la convergencia de las redes móviles, fijas y la TDT, pudiendo llegar a teléfonos inteligentes (smartphones) y tablets, lo cual no ha sido posible por ninguna tecnología de TDT. De hecho, el organismo internacional de estandarización europeo de televisión digital DVB (Digital Video Broadcasting) declaró que no habría nuevo estándar de TDT, y que un posible nuevo estándar de radiodifusión tendría que venir del foro de estandariza-

ción 3GPP, encargado de la estandarización de tecnologías móviles.

Por otro lado, el sector de producción audiovisual utiliza hoy en día diferentes tecnologías inalámbricas y, por tanto, será uno de los primeros en aprovechar las ventajas del 5G. Gracias a la compatibilidad inherente de 5G con el protocolo IP (Internet Protocol) y el uso de recursos de computación en la nube (en inglés, cloud computing), podría además actuar como un catalizador para mejorar los flujos de trabajo existentes o habilitar nuevos en varios escenarios.

El Instituto de Telecomunicaciones y Aplicaciones Multimedia (iTEAM) de la Universitat Politècnica de València (UPV) en España es uno de los centros de investigación de referencia en la aplicación de la tecnología 5G a tecnologías broadcast, tanto para la parte de distribución como para la parte de contribución (producción de contenidos). Desde el

23 TM Broadcast 5G Y LAS TECNOLOGÍAS DE BROADCAST 5G

grupo de comunicaciones móviles del iTEAM-UPV, hemos participado activamente en procesos de estandarización de tecnologías de radiodifusión, como DVB-T2 (y su perfil móvil T2-Lite), DVB-NGH ( Next Generation Handheld) y ATSC 3.0, así como en la optimización de las tecnologías de radiodifusión de telefonía móvil 3G (MBMS, Multimedia Braoadcast Multicast Service) y 4G (eMBMS, enhanced MBMS).

Gran parte del trabajo en 5G y televisión se ha realizado en proyectos de investigación del programa Horizonte 2020 de la Unión Europea de la asociación para la colaboración público-privada en 5G 5G-PPP (5G Infrastructure Public Private Partnership , www.5g-ppp.eu). En concreto, en los proyectos 5G-Xcast, 5G-TOURS, 5G-RECORDS y FUDGE5G, tres de los cuales han sido coordinados por el iTEAM-UPV (5G-Xcast, 5G-RECORDS y FUDGE-5G). A nivel

nacional, también cabe destacar el proyecto 5G Castilla La Mancha del plan nacional de pilotos 5G de Red.Es, así como la colaboración con Radiotelevisión Española (RTVE) en el marco del evento Global 5G 2019, en la que se realizó el primer directo para televisión utilizando exclusivamente tecnología 5G en España. Fue, además, la primera retransmisión en todo el mundo llevada a cabo con una red 5G nativa/pura (en inglés, Stand-Alone SA).

A continuación, paso a explicar brevemente las principales innovaciones de los dos principales proyectos: 5G-Xcast para radiodifusión de contenidos 5G y 5G-RECORDS para producción de contenidos 5G, así como resaltar los principales resultados del resto de proyectos.

5G-Xcast

El proyecto 5G-Xcast: Broadcast and Multicast Communication

Enablers for the Fifth-Generation of Wireless Systems (8 M€ de presupuesto, 18 socios de 10 países, periodo de ejecución junio 2017 a julio 2019, www.5g-xcast.eu) fue el primer proyecto de investigación internacional sobre 5G Broadcast, y se convirtió en el proyecto insignia sobre la radiodifusión de contenidos en 5G en todo el mundo. Desde el proyecto se participó activamente en la definición y análisis de la tecnología conocida popularmente como 5G Broadcast, y también en el diseño de una solución 5G nativa para broadcast.

La tecnología, conocida como 5G Broadcast, permite transmitir servicios broadcast a dispositivos 3GPP, y en algunos ámbitos se ha llegado a considerar como posible sustituto de la Televisión Digital Terrestre. Esta tecnología cumple con requisitos esenciales de la TDT, entre los que podemos destacar:

24 5G Y LAS TECNOLOGÍAS DE BROADCAST TM Broadcast

5G

•Modo de solo recepción (en inglés, Receive-OnlyMode), en el cual no es necesario tener una tarjeta SIM para recibir el servicio. Esto permite transmisiones abiertas (en inglés, Free-to-Air) como las utilizadas en la TDT tradicional.

•Modo de transmisión en el que todos los recursos radio (espectro) se dedican a la transmisión broadcast.

•Posibilidad de crear redes de frecuencia única (en inglés, Single Frequency Networks), en los que varios transmisores transmiten el mismo contenido en la misma frecuencia de manera sincronizada.

A pesar de que la tecnología se conoce como 5G Broadcast, está basada en la tecnología 4G de telefonía móvil denominada como LTE (Long Term Evolution). De hecho, el nombre técnico de la tecnología en inglés no es otro que LTE-based 5G Terrestrial Broadcast. El juego de marketing del 3GPP esconde que 5G Broadcast no dispone de los avances tecnológicos de la tecnología 5G (que explicaremos a continuación). El proyecto 5G-Xcast fue el primero en demostrar que la tecnología 5G Broadcast tendría una eficiencia espectral considerablemente menor que las tecnologías de TDT de segunda generación (como DVB-T2 y ATSC 3.0). Este trabajo* tuvo el reco-

nocimiento del premio al mejor artículo publicado en el año 2020 en la revista especializada IEEE Transactions on Broadcasting.

A pesar de sus limitaciones, la tecnología 5G Broadcast supone un hito en el mundo de la radiodifusión, al ser la primera tecnología broadcast 3GPP con un alto potencial de llegar a todos los smartphones y tablets. Aunque ya se han realizado numerosos pilotos en todo el mundo, todavía no hay ningún despliegue comercial de 5G Broadcast. Pero no debe olvidarse el hecho de que 5G Broadcast fue diseñada para un propósito diferente al de los estándares de TDT. Mientras que, por ejemplo, DVB-T2 está altamente optimizado para la distribución de servicios de televisión lineal para recepción fija en tejados, 5G Broadcast tiene la posibilidad de llegar a dispositivos 3GPP portátiles y móviles, y tiene una gran herencia de la tecnología 4G LTE. Además, 3GPP ha incluido recientemente en la Release-17 la posibilidad de utilizar 5G Broadcast en los anchos de banda utilizados tradicionalmente por la TDT (6, 7 y 8 MHz). Sin hacer pronósticos sobre lo que pueda pasar en la conferencia mundial de radiocomunicaciones (WRC) en cuanto al espectro actualmente dedicado para tecnologías de radiodifusión, seguro que la tecnología 5G Broadcast tendrá un papel importante en dicha conferencia.

5G Castilla-La Mancha

En el proyecto 5G Castilla La Mancha (presupuesto 1.2 M€, 6 empresas colaboradoras en el caso de uso de radiodifusión, duración julio 2020 a enero 2023, el iTEAM-

UPV ha desarrollado una solución 5G Broadcast utilizando una plataforma de radio definida por software de código abierto y procesadores de propósito general. En colaboración con Telecom CLM y el fabricante de equipos de broadcast BTESA, se ha realizado un piloto en una red con infraestructura de alta potencia en la ciudad de Toledo, con suficiente potencia de radiofrecuencia para cubrir toda la ciudad. Este, ha sido el primer piloto utilizando una plataforma SDR (Software Defined Radio) tanto para el transmisor como el receptor en una infraestructura como las utilizadas tradicionalmente para la difusión de TDT. Las soluciones SDR no solo permiten probar rápido nuevas funcionalidades de los estándares, sino que también permiten una mayor flexibilidad para actualizaciones mediante software y reducir costes. Los principales fabricantes de equipos de TDT ya tienen soluciones basadas en software. Este trabajo ha tenido mucha repercusión en la asociación industrial 5G-MAG ( 5G Media Action Group), donde se ha colaborado con otros socios en el desarrollo y validación de la plataforma SDR y se ha proporcionado una versión del código en abierto (opensource).

Por otro lado, el proyecto 5GXcast fue pionero en definir componentes punto a multipunto (multicast/broadcast) para las redes 5G nativas, basadas en las nuevas tecnologías NR (New Radio) y 5GC (5G Core), que proporcionan una mayor eficiencia y flexibilidad con respecto a LTE tanto a nivel radio como a nivel de arquitectura de sistema.

El proyecto 5G-Xcast propuso un cambio de paradigma en cuanto a

5G TM Broadcast

25 5G Y LAS TECNOLOGÍAS DE BROADCAST

* Manuel Fuentes, De Mi, Hongzhi Chen, Eduardo Garro, Jose Luis Carcel, David Vargas, Belkacem Mouhouche, and David Gomez Barquero, "Physical Layer Performance Evaluation of LTE-Advanced Pro Broadcast and ASTC 3.0 Systems", IEEE Transactions on Broadcasting, vol. 65, no. 3, pp. 477-488, 2020.

las transmisiones punto a multipunto en 4G LTE (recuerden que la tecnología 5G Broadcast está basada en LTE), donde las transmisiones punto a multipunto se concibieron inicialmente como un servicio complementario y con una configuración estática predefinida. La solución propuesta en 5G-Xcast integra las transmisiones punto a multipunto en la arquitectura general del sistema como una herramienta interna de la red para optimizar la transmisión cuando varios dispositivos consumen el mismo contenido en una misma celda. Esto permite un uso dinámico y flexible de las transmisiones punto a multipunto por parte de la red de manera transparente al usuario, con el fin de maximizar la eficiencia de los recursos de la red. Los componentes multicast/broadcast se diseñaron con la premisa de maximizar la compatibilidad y la interoperabilidad con las transmisiones punto a punto (unicast), para permitir la conmutación dinámica entre los diferentes modos de operación, así como su posible uso en paralelo. Este enfoque conduce a un diseño de servicio simplificado y unificado a través de las redes de acce-

so. Además, no solo permite el despliegue de redes 5G independientes para la distribución de servicios de radio y televisión, sino que también fomenta que todos los equipos de red y todos los dispositivos soporten las transmisiones punto a multipunto. El hecho de que 5G Broadcast requiera equipos específicos que soporten la tecnología a nivel de red y, principalmente, a nivel de terminales, es probablemente la principal barrera que ha frenado la inversión en la tecnología, y que nos pone en el problema del huevo o la gallina que tuvieron las primeras tecnologías de radiodifusión móvil (DVB-H, MediaFLO, etc.).

En 5G-Xcast se diseñaron componentes punto a multipunto para la interfaz radio, la red de acceso radio (Radio Access Network, RAN) y el núcleo de red (5GC). El trabajo del 5G-Xcast ha tenido una importante repercusión en el 3GPP en la tercera versión del estándar 5G (Release-17), donde se ha especificado 5G-MBS (Multicast Broadcast Services) con componentes multicast/broadcast para NR y 5GC. Sin embargo, no se están teniendo en cuenta requisitos

de los servicios de TDT. El problema es que las dos primeras versiones de 5G no soportan transmisiones punto a multipunto, y por tanto se perdió la oportunidad de incluir esta funcionalidad desde el inicio del estándar de forma que todos los dispositivos la soportaran. El soporte de la tecnología 5G-MBS será opcional, y está por ver el grado de implantación en los futuros dispositivos cuando llegue la Release-17 al mercado (actualmente están empezando a llegar dispositivos con la segunda versión del estándar 5G, Release-16).

5G-RECORDS

El proyecto 5G-RECORDS: 5G key technology enableRs for Emerging media COntent pRoDuction Services (presupuesto 7.5M€, 18 socios de 11 países, duración septiembre 2020 a octubre 2022, www.5g-records.eu) abordó el diseño, desarrollo, integración, validación y demostración de componentes 5G para la producción profesional de contenidos multimedia. El proyecto se estructuró alrededor de tres casos de uso reales de producción de contenidos: producción de audio en vivo, estudio inalámbrico con múltiples cámaras y producción de contenidos inmersi-

5G 26 5G Y LAS TECNOLOGÍAS DE BROADCAST TM Broadcast

vos, cada uno con una serie de tecnologías 5G habilitadoras y componentes multimedia innovadores.

Además, el proyecto se centró en el uso de redes 5G privadas, similares a una red WiFi pero con la diferencia de que no se comparte el espectro con ninguna otra red, lo que garantiza mayores prestaciones sin depender de la red pública de un operador de telecomunicaciones. Otra de las ventajas reside en la privacidad, ya que toda la información que circule por estas redes solo es accesible para sus propietarios. Estas redes 5G a la carta, o redes “súper WiFi” privadas con prestaciones revolucionarias para la industria tienen mucho sentido para entornos de producción profesional remota de contenidos con mayor fiabilidad, menor latencia y la posibilidad de sincronizar diferentes dispositivos. El proyecto desarrolló un sistema completo de producción multicámara 5G que fue utilizado en una retransmisión del arranque del Tour de Francia de 2022 en la ciudad Copenhague (Dinamarca), que fue un éxito total y tuvo una gran repercusión mediática.

El caso de uso de producción de contenidos inmersivos se centró en el uso de las bandas milimétricas de 5G (26 GHz), que posibilita anchos de banda de cientos de MHz y velocidades de Gigabits por segundo equiparables a la fibra óptica en sentido descendente o de descarga. En sentido ascendente, los terminales actuales tienen limitaciones para alcanzar esas velocidades. A pesar de estas limitaciones, el proyecto organizó un concierto en vivo que fue capturado con múltiples perspectivas y planos en los que el realizador podía mover el punto de vista de la imagen libremente. Y con un despliegue de edge computing para garantizar baja latencia, fue posible reproducir contenido tanto en vivo como en repeticiones.

Por último, el caso de uso de producción de audio se centró en las comunicaciones 5G de ultra baja latencia y alta fiabilidad (en inglés, Ultra Reliable Low-Latency Communicacions URLLC), ya que la producción profesional de audio en directo tiene unos requisitos muy exigentes en cuanto a tiempo de respuesta, disponibilidad, y sincroniza-

ción. Este caso de uso no llegó a demostrarse en un piloto, pero los avances que se hicieron en el testeo y validación de la tecnología URLLC de 5G han supuesto un gran avance del estado del arte, y han interesado a alguno principales fabricantes de chips 5G.

No me gustaría terminar este artículo sin mencionar la primera orquesta itinerante 5G que se realizó en el proyecto 5G-TOURS (www.5gtours.eu), liderada por la RAI y en colaboración con LiveU, que fusionó música y producción distribuida de contenidos con 5G en las calles de Turín en diciembre de 2020.

Con todos estos avances se puede afirmar que, a diferencia de la distribución de contenidos, donde todavía hay dudas razonables sobre el uso de 5G para servicios de radiodifusión … ¡y puede que sea necesario una futura nueva tecnología 6G Broadcast!, el 5G será ampliamente utilizado para producción de contenidos en un futuro no muy lejano.

5G Y LAS TECNOLOGÍAS DE BROADCAST 5G TM Broadcast

27

El uso del 5G en España La experiencia de GES-IT

David de No, director Comercial de GES-IT, ha compartido con TM Broadcast su experiencia en la transmisión de eventos deportivos sobre las redes 5G. Según nuestro entrevistado, aunque aún en una fase de despliegue, la tecnología de transmisión nos puede llegar a otorgar muchos beneficios industriales. De hecho, la unión de estas capacidades y la fusión con la virtualización llegará a marcar el futuro de esta industria. En esta entrevista comprenderán en qué punto se encuentra la tecnología y qué uso le está dando una de las principales compañías de servicios de producción de nuestro país.

¿Cuál es el estado actual de la transmisión 4G y 5G en España?

La pandemia ha traído un cambio de modelo. Han vuelto las producciones de eventos, pero se están realizando de forma distinta y acarrean diferentes perspectivas. Hoy día, ya son comunes las producciones en remoto, también las soluciones por software a través de plataformas de streaming.

Precisamente fue la pandemia la que nos proporcionó ese conocimiento. Esas herramientas, como decíamos, son prioritarias

ahora. De hecho, siempre lo digo, el mejor ejemplo de ello es que en los informativos de cualquier cadena introduce conexiones con plataformas de comunicación online de forma habitual.

En el mercado ya hay soluciones adaptadas a este nuevo mundo. Desde la perspectiva de GES-IT, en espacio tienen perfecta cabida nuestras soluciones. Contribuyen a la evolución de este modelo.

¿Cuáles son las experiencias de GES -IT en 5G?

28 5G TM Broadcast GES-IT

Las experiencias que tenemos sobre la transmisión en 5G vienen dadas por la experiencia previa que tenía la marca Mobile Viewpoint sobre las redes de Ericsson en Holanda, los trabajos que han realizado para la BBC en Inglaterra y las transmisiones que se hicieron en directo ya hace unos años en Corea sobre una red de 5G real.

En España nosotros hicimos el primer directo 5G para la TVGA (Televisión de Galicia) sobre la red de Telefónica. Se hizo en el Monte del Gozo para el programa “Telexornal” de mediodía. Fue un hito porque conseguimos transmitir una señal en directo para un programa informativo a través de la red de Telefónica. Por otro lado, realizamos el primer directo de televisión sobre la banda de 700 Megas para Castilla La Mancha, también a través de Telefónica I+D. Esto se hizo en Alcázar de San Juan en directo. Ya había experiencias previas de Televisión Española sobre el 5G, pero siempre sobre una red propietaria o un nódulo más pequeño. En este caso era una solución real.

También hemos hecho transmisiones para comprobar cómo era la estabilidad de la señal sobre dos módems de 5G para transmitir con una mochila con el banco de pruebas de I+D de Telefónica. La prueba ha sido un éxito.

Tenemos ya equipos de 5G en el mercado ahora mismo trabajando en el campo. En el caso de eventos deportivos destacaría que lo que hemos empleado, fundamentalmente, son las mochilas como medios de transmisión y un equipo receptor instalado en la unidad móvil a través de una fibra dedicada.

Por citar algunos ejemplos, en el maratón de Valencia hemos empleado 3 motos de carrera, una cámara car que estaba transfiriendo planos espectaculares en directo y también una cámara giro bike que va en una moto y ofrece una señal fantástica y estabilizada. Estas soluciones hacen evolucionar el lenguaje audiovisual del directo, aporta factor de calidad y un valor añadido a esas producciones.

En el maratón de Sevilla hemos puesto de cuatro motos, hemos desplegado un practicable y hemos creado una novedad: un punto de giro con un dron en directo. Esta solución ya se está implementando en las producciones deportivas, es más, LaLiga ya lo está usando. En redes de transmisión 5G tiene cabida perfecta.

También hemos hecho este año la San Silvestre para Telemadrid, a través de Telefónica. Para esta infraestructura hemos desplegado 3 motos, hemos puesto también un dron de señal en directo en la Puerta de Alcalá y una Cámara autónoma para hacer un evento publicitario.

Hemos realizado también en Málaga la carrera ASICS en la que hemos ido con 3 motos y un dron. Este dron cubría parte del recorrido. Era como una cámara de apoyo, pero realizada siempre con un dron que da una imagen un poquito más espectacular.

Otro evento que también ha marcado este año ha sido la Champions League en París, para Telemadrid a través de FORTA. Hemos hecho una transmisión de cuatro equipos autónomos para cubrir todo el evento

29 TM Broadcast GES-IT 5G

completo desde la zona entrenamiento del Real Madrid, campo de fútbol, zonas mixtas, previas, entrevistas y demás. Se ha realizado una cobertura completa con estos equipos autónomos con recepción directa en Telemadrid.

En todos estos casos de uso, en la medida en la que podemos usar la banda 5G, transmitimos en 5G. Teniendo en cuenta que el 5G no está maduro. Es un sistema de 5G sobre nódulos 4G pero bueno, se puede decir que estamos empezando a dar esos pasos y que las mochilas de nuestra marca ya están habilitadas.

¿Qué habéis empleado como flujo de trabajo para estos proyectos?

Hemos pasado por diferentes estadios. Partimos desde la captura de la cámara en una moto, la transmisión directa a la mochila y una recepción en la unidad móvil para entregarla; hasta la producción completa con contribuciones a través de tramas RTSP que son ingestadas en herramientas de producción en streaming. Este último modelo, por ejemplo, lo hemos realizado habitualmente en temas corporativos.

¿Qué retos habéis encontrado en la trasmisión de estos eventos?

Pues hemos encontrado que la cobertura en algunos puntos es compleja que propiciaba dificultad de transmisión. Para solucionarlos, hemos trabajado previamente en desplegar antenas de alta ganancia, muy características de nuestra marca, que instaladas en la moto nos facilitan que la transmisión sea

30 GES-IT TM Broadcast

5G

más estable y, de ese modo, reducimos los riesgos que tienen esos puntos complejos de transmisión.

Por supuesto, hacer test de cobertura previa para conocer bien cómo será el recorrido. Por ejemplo, respecto a los maratones recorremos el circuito el día anterior para obtener seguridad, conocimiento y una capacidad de minimizar los errores.

Otra de las soluciones que hemos implementado es utilizar equipos con un mayor número de módems. Siempre estamos utilizando 8 módems, como mínimo 6, sabemos que hay soluciones en el mercado con menos módems. Pero no las recomendamos para este tipo de producciones porque al final tienes que tener más capacidad, tienes que tener más proveedores y tienes que tener más más datos para garantizar el servicio.

Otra de nuestras capacidades es garantizar una gestión inteligente del ancho de banda y de los delays. Es decir, qué ancho de banda asignamos a una transmisión de vídeo, cómo la gestionamos, si tenemos posibilidad de aumentar el delay para hacer un poco más de buffer y reducir los problemas posibles de pixelado.

En definitiva, para transmitir de este modo hay que hacer un uso inteligente de la tecnología y con nuestro conocimiento a lo largo de estos años, ya tenemos ese modelo bastante estudiado y bastante evolucionado.

Todo esto se trabaja sobre la red 4G ahora mismo porque 5G no está tan expandido, ¿verdad?

Aparece como 5G, pero no es real. ¿Y por qué se da esa circunstancia?

Ahora mismo no hay instalada una infraestructura de red 5G. Esta red funciona sobre una frecuencia que va a necesitar muchos más repetidores. Va a tener que implementarse nueva. Ahora mismo el 5G es como cuando empezó el 4G y todo el mundo decía que tenía 4G y en realidad estaba usando las redes 3G.

Pues ahora mismo no hay un desarrollo en las ciudades, no hay un desarrollo global del 5G. Las torres hay que cambiarlas todas y se debe introducir nueva infraestructura en interiores. Entonces no hay 5G real, por lo tanto no están dando esos anchos de banda y no está funcionando.

Se trata del ya conocido 4,5G, ¿verdad?

Efectivamente, es un desarrollo en el que las redes se identifican como 5G, emites sobre 5G, pero las señales se están repartiendo sobre la tarta 4G actual. Los transpondedores son 4G y sí, te puede llegar a aportar algo más, pero porque estás trabajando sobre la red actual, una red que está muy lejos de estar completa. Por ello, lo que te aporta, poco tiene que ver con lo que podría llegar a aportar.

Entonces, ¿cuáles son los casos de uso que se están dando sobre la red 5G real?

Nosotros hemos experimentado de forma práctica la transmisión 5G

5G TM Broadcast 31 GES-IT

con I+D de Telefónica sobre las dos únicas redes 5G que hay ahora mismo en España, Ericsson y Nokia. Estos son los casos que mencionábamos al principio. La cuestión es que en una de ellas se ha hecho la transmisión sobre estas redes de “5G falso”. No obstante, la segunda prueba que hicimos se hizo sobre la red 5G real. Fíjate que, de hecho, se apagó el TDT de Alcázar de San Juan durante los siete minutos que duró el evento. Se hizo así porque es la red de 700 la que ocupa la frecuencia del 5G, donde va todo el TDT también.

Como integrador, ¿cómo debe evolucionar esta tecnología para que se extienda su uso y se convierta en un estándar?

Debemos apostar por esta tecnología. Y el camino para hacerlo es

seguir haciendo producciones mixtas. Nosotros ya lo estamos haciendo: en una realización estándar usamos la unidad móvil de toda la vida donde incluimos las cámaras a las que estamos acostumbrados y los enlaces de siempre, pero introducimos una mochila. Por lo tanto ya son modelos de producción que incluyen la transmisión mediante redes de telecomunicación. Se está cambiando el helicóptero por el dron, se están cambiando los enlaces RF por las mochilas, etc. En definitiva, se transforman los modelos.

Adicionalmente, se está empezando a trabajar en la nube. El desarrollo comenzó hace dos años y con la pandemia se ha agilizado. Ahora hay muchas producciones que se hacen en la nube. Esto promueve una simplificación de los procesos y la creación de sinergias entre fabricantes

de equipos que desarrollan soluciones para hacer en la nube una realización completa, gráficos, sonido, en remoto, etc.

No obstante, a la gente le sigue proporcionando comodidad y seguridad tenerlo todo centralizado. El modelo clásico es más conocido para el realizador. Y el cambio puede llegar a provocar vértigo. La industria no puede descuidar ese campo.

5G 32 GES-IT TM Broadcast

¿Cómo evolucionará el negocio de GES-IT respecto al 5G?

Como decíamos, no está listo. La implementación aún va a tardar uno o dos años. El hándicap radica en que hay que hacer un desarrollo completo de la red y de las infraestructuras.

Mientras tanto, se debe respetar el modelo de 4G, para quien quiera seguir trabajando en esa banda.

¿Tú crees que pueden convivir?

Sí, sí pueden convivir. De hecho, son complementarios. Tal y como ha

pasado con el 3G y el 2G. Todo el mundo va a querer conseguir todo lo que ofrece el 5G. El 6G sigue siendo ciencia ficción. Pero cuando llegue, traerá unas capacidades increíbles: se podrán hacer transmisiones a 8K, latencias mínimas o transmitir flujos de alta capacidad de datos con comodidad. El futuro va a estar en esas grandes producciones en remoto con esta tecnología de alta capacidad. Yo creo que las principales cadenas lo tienen claro y empresas que se dediquen a este tipo de producciones, en la unión entre la transmisión mediante estas redes y en la nube.

¿GES-IT se subirá a esa ola?

Nosotros consideramos que va a quedar una gran oportunidad para poder seguir trabajando en el formato actual. De hecho quedará parte de ese tráfico liberado. De hecho, estamos haciendo transmisiones en HD sin ningún tipo de problema y con las latencias muy bajas. Entendemos que en el directo todo tiene que estar listo en menos de un segundo. Lo bueno que tiene nuestra tecnología es que el sistema de codificación y de envío es muy inteligente en su gestión desde la parte de la red. Con eso garantizamos que los anchos de banda que sacamos son datos reales y podemos trabajar perfectamente en HD en esas latencias. Es aquí donde está nuestro valor añadido.

GES-IT 5G TM Broadcast

33

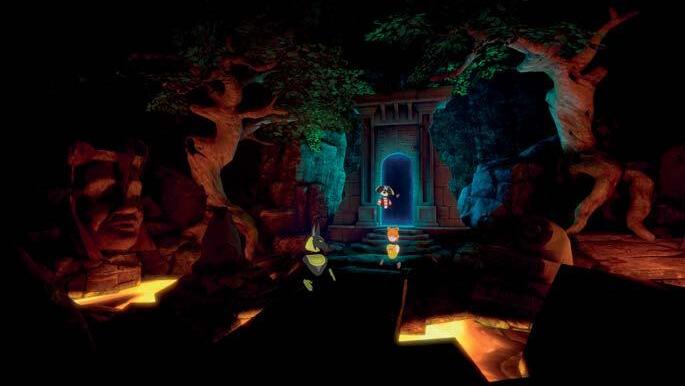

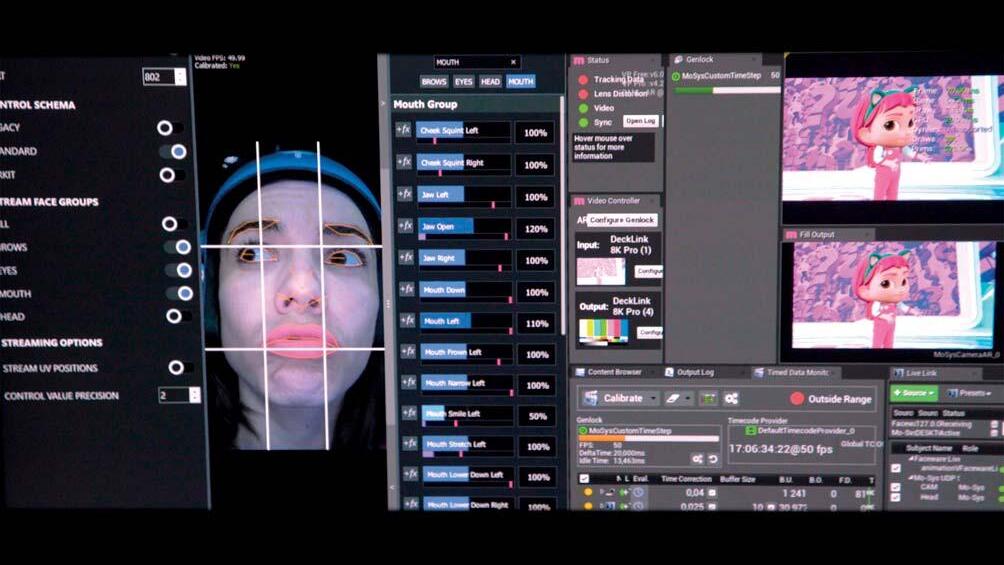

Iralta VP El camino hacia las experiencias inmersivas

La forma de comunicarnos y generar contenidos está en una evolución constante y es indudable que las experiencias inmersivas captan la atención de los consumidores. Desde Iralta VP tienen esto muy en cuenta y hemos tenido la oportunidad de hablar con César Urbina, fundador y director creativo de la compañía, para conocer en qué punto nos encontramos ahora, qué podemos esperar de un futuro cada vez más tecnológico y cómo se están preparando para ello.

¿Qué es Iralta VP y cómo nace?

Iralta Virtual Productions nace de la unión de Iralta Films, que es la compañía matriz, y el Píxel Redondo, con la idea de crear contenidos y servicios enfocados en la producción virtual. David Burton, VFX supervisor con muchísima experiencia en la posproducción de películas y series, es quien está detrás del Píxel Redondo. Controla todo lo que tiene que ver con producción virtual y nosotros, en Iralta Films, estamos especializados en producción en realidad virtual y en motores de videojuegos para realidad virtual. La unión entre ambas empresas, que además llevamos trabajando durante cinco años en proyectos, ha hecho que el año pasado creásemos una empresa conjunta.

Nosotros llevamos produciendo contenidos de realidad virtual desde hace más de diez años. Mi hermano Ángel y yo creamos la empresa hace dieciocho años en la que hemos innovado y nos hemos ido diferenciando a la hora de meter interactivi-

dad, programación y nuevos formatos que no son vídeos al uso, sino vídeos en los que hay interactividad.

Cuando un cliente nos encargó, hace 12 años, producir un contenido para un domo descubrimos lo que era el vídeo 360. En ese momento, no había casi nadie en España que hiciera ese tipo de proyectos. Vimos que era un sector que tenía futuro y nos lanzamos. Vimos que éramos una empresa pionera y decidimos apostarlo todo por contar historias inmersivas.

Entonces, solicitamos unas ayudas al Ministerio de Cultura para la creación de contenidos culturales e innovación y creamos la primera experiencia de realidad virtual y vídeo 360. Fue enfocada al turismo, llama-

34 EXPERIENCIAS INMERSIVAS TM Broadcast IRALTA VP

César Urbina, fundador y director creativo de Iralta Virtual Productions

da Camino de Santiago 360. Este proyecto supuso un antes y un después para la compañía. Fue un proyecto muy ambicioso. Aún está disponible en iOS y Android y ganó en Fitur el premio a la mejor experiencia de turismo usando la realidad virtual.

¿En qué consistió ese proyecto?

Se trató de una aplicación en la que te puedes visionar en 360 grados en el camino de Santiago. Puedes visualizar todo, desplazarte a través de los giroscopios o con los dedos y moverte por las diferentes escenas que hay a lo largo de nueve capítulos visitando catedrales, castillos, bosques y todo el camino.

Esto fue hace diez años y era tan novedoso que nos empezaron a lle-

gar muchos encargos de diferentes destinos turísticos o instituciones como el Banco Interamericano de Desarrollo o el Banco Europeo de Inversiones. Hemos realizado vídeos 360 para muchas marcas como Coca Cola, Renault, Telefónica o Cepsa, siempre buscando la manera de innovar a la hora de contar historias. Los contenidos inmersivos cambian la manera de contar esas historias. Necesitas conocer muy bien cómo funciona la tecnología para que sepas realmente sacar el partido a las historias que puedes contar.

¿Cuál es vuestra forma de trabajar y en qué tecnologías os apoyáis?

Es fundamental tener un trabajo previo con los creadores. Nos reunimos con la productora o los creado-

res del formato y proponemos cómo utilizar las diferentes tecnologías de producción virtual.

Una vez decidido que tecnología es la ideal, se hacen pruebas de los flujos de trabajo. Todo está sincronizado con sistemas de tracking espacial, para ello necesitas visualizar el espacio. Hay todo un trabajo previo para, por ejemplo, virtualizar el plató y que las diferentes tecnologías que se usan, desde los motores, las pantallas y los sistemas de tracking, funcionen a la perfección.

Es una nueva metodología de trabajo. La posproducción siempre estaba al final, pero ahora podríamos decir que es un flujo circular, en el que la posproducción está desde el principio y va trabajando con el

35 TM Broadcast IRALTA VP EXPERIENCIAS INMERSIVAS

director de arte, con el director de vestuario, de fotografía… Van de la mano para que luego la parte de producción sea más corta y todo se haga en tiempo real.

¿Con qué herramientas y software trabajáis?

La base de todo lo que estamos usando para la producción virtual es Unreal. Dentro de Unreal, hay un ecosistema de herramientas como Capture Reality, que sirve para capturar y fotogrametriar lugares, crear los metahuman, generar actores virtuales. También utilizamos Sketchfab, un ecosistema de todo lo que es el motor de videojuegos.

Luego, utilizas otros softwares de 3D como pueden ser Maya o Blender, para modelar y animar. Y por otra parte, estamos usando el Faceware, un software de captura facial. Además de trajes de captura de movimiento para capturar todos los movimientos de los personajes.

También estamos usando una Sony FX9 para hacer pruebas con kits de ópticas fijas para producción virtual sin zoom, para poder hacer más fácil la virtualización del plató.

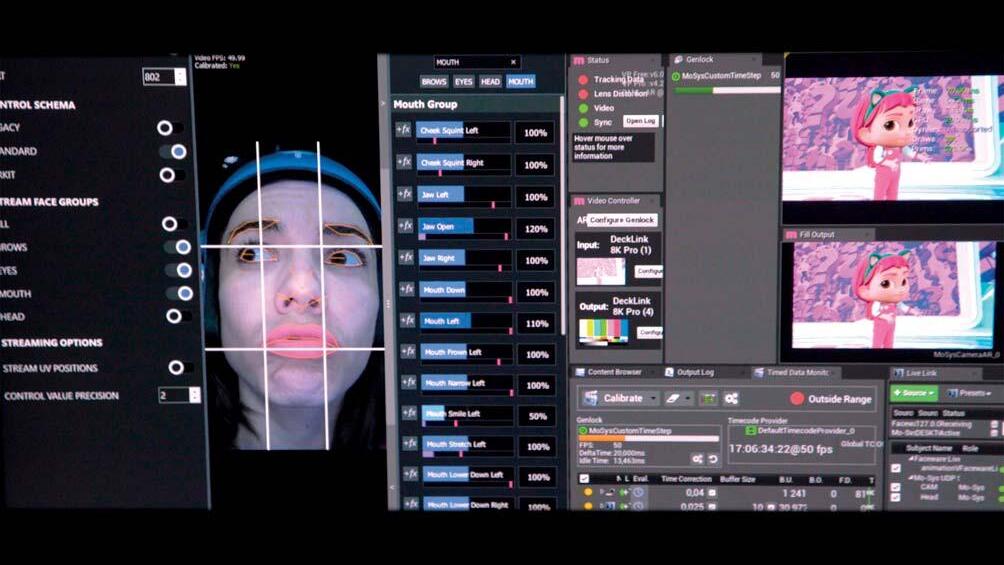

Por último, trabajamos con MoSys, un sistema de tracking espacial, que adquirimos para Mapi. Mo-Sys te permite virtualizar un plató y que al mover la cámara dentro de ese espacio, se transmita ese movimiento físico al mundo virtual. Mueves la cámara y la cámara virtual también se mueve.

¿En qué punto se encuentra ahora la compañía?

Hemos tenido un año 2022 fantástico, porque hemos hecho el primer proyecto de producción virtual de realidad aumentada que se ha hecho en España y de los primeros del mundo. Hablo de Mapi. Las propias compañías que nos han vendido y ayudado con el hardware y el software, como son Faceware o Mo-Sys, han publicitado el proyecto dentro de su portfolio de casos de éxito. Es un ejemplo muy innovador de cómo se puede llegar a usar la producción virtual y la realidad aumentada en televisión.

Mapi es uno de los proyectos más innovadores que ha desarrollado Iralta VP. Radio Televisión Española quiso crear un programa para todos los públicos y se basó en el formato del programa Chiko’s Challenge, de la televisión pública japonesa. La idea era crear un programa cuya protagonista sería Mapi, una niña virtual que se encargaría de realizar preguntas, a los famosos que iban, que cualquier niña o niño pequeño se haría y que plantean cierta dificultad.

Iralta VP quiso ir un paso más allá de lo que ya estaba creado y propuso utilizar la producción virtual para que Mapi pudiera existir en tiempo de emisión real.

¿En qué ha consistido el proyecto de Mapi?

La idea de Mapi viene originalmente de Chiko's Challenge, programa de la televisión japonesa pública que lleva en antena más de ocho años y que se hace a la manera tradicional. Se graba a un actor con

unas marcas de tracking y luego esto se posproduce.

Cuando Mediacrest, la productora que está detrás de Mapi, firmó el acuerdo con Televisión Española para hacer este programa, nosotros ya habíamos propuesto hacerlo usando producción virtual porque ahorraba, sobre todo, tiempo en posproducción. Eso también significa ahorro en presupuesto. Ahorraba costes, hacía un calendario mucho más asequible y permitió que Mapi naciera en Televisión Española. Se concibió en el mes de abril y a finales de julio ya estaba en antena. Pero lo que hay que saber para hacer pro-

36 IRALTA VP TM Broadcast

EXPERIENCIAS INMERSIVAS

Equipo Mapi.

ducción virtual es que debes realizar una preproducción muy buena para que todo funcione perfectamente.

Se rodaron 60 capítulos. El plató de Televisión Española se virtualizó antes de Mapi. Ayudamos y asesoramos a virtualizar el plató, junto al equipo de Mo-Sys. Todo esto se realiza en un falso directo, pero lo que se grababa era básicamente lo que luego se emitía. Nosotros habíamos previsto semanas de posproducción para posibles retoques o fallos de oclusiones, pero realmente al principio hicimos algunas correcciones y, en cuanto a la parte del 3D, lo que se grabó se emitió. Luego ya entraba en

juego el montaje, sonorización, etc, pero la generación de contenidos 3D fue directa. Esto es un salto tecnológico muy grande a nivel cualitativo.

Cada programa duraba unos 35 minutos y Mapi estaba 30 minutos en pantalla. De esos 30 minutos había tres cámaras de televisión para tres planos diferentes: un plano general, uno frontal y uno en escorzo. En los tres estaba Mapi en tiempo real. El realizador solo tenía que elegir qué cámara quería y ahí estaba Mapi funcionando. Teníamos 90 minutos de 3D por programa, una locura.

¿Ha sido Mapi vuestro proyecto más desafiante?

Sí, porque ha sido un proyecto que se ha hecho en muy poco tiempo. Ha sido un proyecto arriesgado, ya que cuando te embarcas en algo que nadie ha hecho no tienes referencias. Nos hubiera gustado tener más tiempo antes para probar y hubo cosas que se fueron mejorando y optimizando durante la emisión. Si hubiera habido temporada dos no sabemos dónde habríamos llegado.

¿Qué retos y qué limitaciones ha supuesto Mapi?

EXPERIENCIAS INMERSIVAS TM Broadcast

37 IRALTA VP

El reto ha consistido en ser capaces de producir tres programas con 90 minutos de 3D en tiempo real. Es una locura hacer eso. Los japoneses nos dijeron que no se podía hacer, que estábamos locos y luego nos han felicitado por ello. Es una tecnología que tiene mucha versatilidad para que el directo pueda crear nuevos contenidos y que los actores y el público puedan interactuar en tiempo real.